一种基于多智能体的时空路径规划方法

文献发布时间:2023-06-19 10:38:35

技术领域

本发明涉及机器人路径规划技术领域,尤其涉及一种基于多智能体的时空路径规划方法。

背景技术

智能体是在某一环境下,能够持续自主的发挥作用,如扫地机器人、物流运输机器人等,对这些智能体进行路径规划,是一个复杂的计算过程,即需要规避环境中的静态障碍物,又需要规避环境中随时出现的动态障碍物。现有技术中在对静态障碍物和动态障碍物进行规避时,受变化的复杂外界环境的影响无法快速的构建机器人的路径。不能直观的判断出机器人是否发生碰撞,不便于机器人调整避障。并且在进行路径规划时,同时考虑规避静态障碍物和动态障碍物,路径规划的效率较低。

发明内容

本发明主要解决的技术问题是提供一种基于多智能体的时空路径规划方法,解决受变化的复杂外界环境的影响无法快速的构建机器人的路径,不能直观判断是否发生碰撞,路径规划效率较低的问题。

为解决上述技术问题,本发明采用的一个技术方案是提供一种基于多智能体的时空路径规划方法,包括步骤:

构建二维行走路径,设定机器人的起点和终点,规划机器人从起点到终点的二维行走路径;构建三维时空路径,随机设定机器人的行走速度,确定在二维行走路径的行走时刻,由行走时刻结合二维行走路径构建机器人的三维时空路径;基于三维时空路径避障,使用上述步骤构建动态障碍物的三维时空路径,若机器人的三维时空路径与动态障碍物的三维时空路径相交具有交点,则机器人与动态障碍物发生碰撞,交点即为碰撞点,设定机器人到达碰撞点前的一段时间为安全时间,在安全时间前通过路径调整算法调整机器人的行走速度,规避与动态障碍物的碰撞。

优选的,构建二维行走路径步骤中,机器人设置有多个,同时对多个机器人并行规划二维行走路径。

优选的,构建二维行走路径步骤中,构建机器人从起点到终点的二维行走路径为:

式中,a

优选的,构建三维时空路径步骤中,随机设定机器人R

式中,a

优选的,构建三维时空路径步骤中,由三维时空坐标a

式中,a″

优选的,构建三维时空路径步骤中,由行走时刻和二维行走路径的坐标轴构建三维时空坐标轴,三维时空坐标轴的横向坐标轴对应为二维行走路径的二维坐标轴的横向坐标轴,三维时空坐标轴的纵向坐标轴对应二维行走路径坐标轴的纵向坐标轴,三维时空坐标轴的竖向坐标轴为行走时刻,三维时空路径对应标识在三维时空坐标轴内,进而在三维时空坐标轴内显示碰撞点。

优选的,基于三维时空路径避障步骤中,由机器人的三维时空路径计算机器人之间的距离,

由上式中的

机器人R

与机器人R

对应的,另一机器人R

式中,x

与机器人R

式中,y

可得机器人R

由机器人R

优选的,基于三维时空路径避障步骤中,设定机器人的观测范围,动态障碍物进入到机器人的观测范围内,机器人通过路径调整算法调整行走速度,规避动态障碍物。

优选的,基于三维时空路径避障步骤中,获取机器人的观测值和环境状态值,根据观测值通过路径调整算法输出动作值,根据动作值调整机器人的行走速度,并获得该行走速度的奖励值,由观测值、环境状态值、动作值和奖励值输入到路径调整算法进行优化行走速度。

优选的,基于三维时空路径避障步骤中,奖励值包括有距离差奖励值,目标距离奖励值,障碍数奖励值,碰撞奖励值以及到达目的地奖励值。

本发明的有益效果是:本发明首先构建机器人的二维行走路径,可以不考虑变化的复杂外界环境的影响,能够快速准确的获得机器人的二维行走路径,通过构建的三维时空路径,能够直观的判断出机器人是否发生碰撞,便于机器人的快速调整,通过路径调整算法能够实时根据三维时空路径的变化调整机器人的行走速度,进行规避动态障碍物,从而通过不同的方法分别规避静态障碍物和动态障碍物,能够极大的提高路径规划的效率。在规避静态障碍物得到的二维行走路径的基础上构建三维时空路径,再基于三维时空路径规避动态障碍物,规避静态障碍物和动态障碍物之间具有紧密的联系。

附图说明

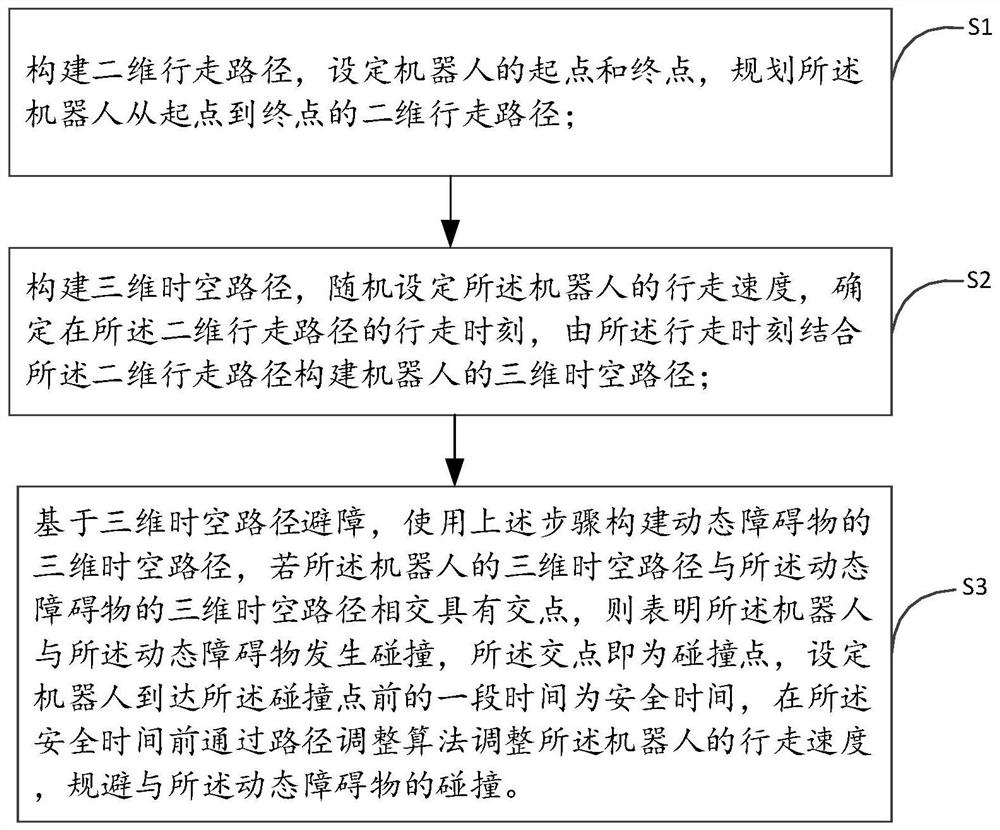

图1是根据本发明基于多智能体的时空路径规划方法一实施例的流程图;

图2是根据本发明基于多智能体的时空路径规划方法一实施例的三维时空路径示意图。

具体实施方式

为了便于理解本发明,下面结合附图和具体实施例,对本发明进行更详细的说明。附图中给出了本发明的较佳的实施例。但是,本发明可以以许多不同的形式来实现,并不限于本说明书所描述的实施例。相反地,提供这些实施例的目的是使对本发明的公开内容的理解更加透彻全面。

需要说明的是,除非另有定义,本说明书所使用的所有的技术和科学术语与属于本发明的技术领域的技术人员通常理解的含义相同。在本发明的说明书中所使用的术语只是为了描述具体的实施例的目的,不是用于限值本发明。本说明书所使用的术语“和/或”包括一个或多个相关的所列项目的任意的和所有的组合。

图1显示了本发明基于多智能体的时空路径规划方法的实施例,包括:

步骤S1:构建二维行走路径,设定机器人的起点和终点,规划机器人从起点到终点的二维行走路径。

步骤S2:构建三维时空路径,随机设定机器人的行走速度,确定在二维行走路径的行走时刻,由行走时刻结合二维行走路径构建机器人的三维时空路径。

步骤S3:基于三维时空路径避障,使用上述步骤构建动态障碍物的三维时空路径,若机器人的三维时空路径与动态障碍物的三维时空路径相交具有交点,则机器人与动态障碍物发生碰撞,交点即为碰撞点,设定机器人到达碰撞点前的一段时间为安全时间,在安全时间前通过路径调整算法调整机器人的行走速度,规避与动态障碍物的碰撞。

本发明在构建机器人的二维行走路径中,可以不考虑复杂变化的外界环境的影响,能够快速准确的获得机器人的二维行走路径,通过构建的三维时空路径,能够直观的判断出机器人是否发生碰撞,便于机器人的快速调整,通过路径调整算法能够实时根据三维时空路径的变化调整机器人的行走速度,进行规避动态障碍物,从而通过不同的方法分别规避静态障碍物和动态障碍物,能够极大的提高路径规划的效率。在规避静态障碍物得到的二维行走路径的基础上构建三维时空路径,再基于三维时空路径规避动态障碍物,规避静态障碍物和动态障碍物之间具有紧密的联系。

进一步的,构建二维行走路径步骤中,机器人设置有多个,同时对多个机器人并行规划二维行走路径。

s个机器人同时进行并行规划路径,即s个机器人中,每个机器人独立使用进行路径规划,即包括有s个线程的路径规划,并行进行规划不同机器人的二维行走路径。能够有效的节省计算时间,提高二维行走路径规划效率。

对于多个机器人的二维行走路径,根据计算机的硬件配置,例如计算机是8核的计算机,每个机器人开启一个进程,每个机器人实现并行的路径规划,在每个机器人内部开启多个线程,实现每个机器人并行路径规划计算。并行路径规划计算可以有效的利用多个CPU,节省计算时间,并行计算可以使CPU和各种硬件并行使用,从而也节省了计算时间。

进一步的,机器人的数量为s,可以表示为:

R1,...,R

将二维行走路径在二维坐标轴中表示,在二维行走路径的二维坐标轴中,上述机器人对应的起点分别表示为:

(x

对s个机器人并行构建机器人从起点到终点的二维行走路径为:

式中,a

优选的,随机设定机器人R

式中,a

进一步的,由三维时空坐标a

式中,a″

进一步的,当检测任一机器人是否发生碰撞时,其他所有机器人均作为动态障碍物。

以机器人R

进一步的,由机器人的三维时空路径计算机器人之间的距离。

由上式中的

所述机器人R

与所述机器人R

对应的,另一机器人R

式中,x

式中,y

由所述机器人R

优选的,以机器人R

由

机器人R

机器人R

机器人R

机器人R

由此可知,机器人R

当D

当D

同理,使用同样的方法可以检测其他机器人之间是否发生碰撞。

进一步的,预设更新时间点,在更新时间点时更新三维时空路径,由最新一次更新的三维时空路径检测是否发生碰撞。

优选的,更新时间点预设为1秒,即每隔1秒更新三维时空路径,根据更新的三维时空路径检测是否发生碰撞。

进一步的,由行走时刻和二维行走路径的坐标轴构建三维时空坐标轴,三维时空坐标轴的横向坐标轴对应为二维行走路径的二维坐标轴的横向坐标轴,三维时空坐标轴的纵向坐标轴对应二维行走路径坐标轴的纵向坐标轴,三维时空坐标轴的竖向坐标轴为行走时刻轴。

优选的,结合图2所示,图中的X方向为三维时空坐标轴的横向坐标轴,图中的Y方向为三维时空坐标轴的纵向坐标轴,图中的T方向为三维时空坐标轴的竖向坐标轴,即行走时刻。

进一步的,当机器人发生碰撞时,在三维时空坐标轴中显示出来,在三维时空坐标轴中,不同的机器人具有不同的三维时空路径,一机器人的三维时空路径与另一机器人的三维时空路径相交的交点即为该机器人与另一机器人的碰撞点。

以4个机器人,每个机器人均有5个三维时空坐标为例,如图2中所示,图2中的点分别表示不同机器人的不同的三维时空坐标,在次不在累述。机器人R

当检测到机器人将要发生碰撞时,在碰撞点之前的安全时间前通过路径调整算法调整机器人的行走速度。

优选的,安全时间为2秒,即在碰撞点的前2秒时,通过路径调整算法调整机器人的行走速度,使该机器人变道避免碰撞。

进一步的,设定机器人的观测范围,当动态障碍物进入到该机器人的观测范围内,机器人通过路径调整算法调整行走速度,规避动态障碍物。

优选的,设定机器人的观测范围为以2r+2d为半径的圆,r为机器人的半径,d为安全距离。

进一步的,在避障时,获取机器人的观测值和环境状态值,根据观测值通过路径调整算法输出动作值,根据动作值调整机器人的行走速度,并获得该行走速度的奖励值,由观测值、环境状态值、动作值和奖励值输入到路径调整算法进行优化行走速度。

优选的,观测值o

式中:

进一步的,设定环境状态值,环境状态值为所有机器人的观测值。

优选的,环境状态值S

式中:

进一步的,动作值包括标准值、加速度值和角速度值。

优选的,动作值a

式中:

优选的,标准值的取值为:0或1。

优选的,角速度值的取值范围为:-1.5rand/s~1.5rand/s。

优选的,加速度值的取值范围为:-5m/s

进一步的,奖励值包括有距离差奖励值、目标距离奖励值、障碍数奖励值、碰撞奖励值、到达目的地奖励值。

进一步的,根据三维时空路径可知任一行走时刻的机器人与动态障碍物之间的距离,获取该行走时刻机器人与动态障碍物的之间的距离,作为当前距离,获取该行走时刻的下一行走时刻机器人与动态障碍物的之间的距离,作为下一距离,当前距离与下一距离的差值为距离差,预设距离差的距离差门限值,由距离差门限值确定距离差奖励值。

进一步的,距离差大于零时,距离差的值大于或等于距离差门限值的上限值时,距离差奖励值为距离差门限值的上限值;距离差的值大于距离差门限值的下限值时小于距离差门限值的上限值时,距离差奖励值为距离差;距离差的值小于或等于距离差门限值的下限值时,距离差奖励值为距离差门限值的下限值。

距离差奖励值可以表示为:

式中,Rvj表示距离差奖励值,

当

进一步的,距离差小于零时,距离差的值大于或等于负的距离差门限值的下限值时,距离差奖励值为负的距离差门限值的下限值;距离差的值大于负的距离差门限值的上限值小于负的距离差门限值的下限值时,距离差奖励值为距离差;距离差的值小于或等于负的距离差门限值的上限值时,距离差奖励值为负的距离差门限值的上限值。

距离差奖励值可以表示为:

式中,Rvj表示距离差奖励值,

当

进一步的,根据三维时空路径可知任一行走时刻的机器人与目标点之间的距离,获取该行走时刻机器人与目标点之间的距离,作为目标距离,获取该行走时刻的下一行走时刻机器人与目标点的距离,作为目标下一距离,目标距离与目标下一距离的差值为目标距离差,预设目标距离差的目标门限值,由目标门限值确定目标距离奖励值。

进一步的,目标距离差大于零时,目标距离差的值大于或等于目标门限值的上限值时,目标距离奖励值为目标门限值的上限值;目标距离差的值大于目标门限值的下限值时小于目标门限值的上限值时,目标距离奖励值为目标距离差;目标距离差的值小于或等于目标门限值的下限值时,目标距离奖励值为目标门限值的下限值。

目标距离奖励值可以表示为:

式中,Rvm表示目标距离奖励值,

当

进一步的,目标距离差小于零时,目标距离差的值大于或等于负的目标门限值的下限值时,目标距离奖励值为负的目标门限值的下限值;目标距离差的值大于负的目标门限值的上限值小于负的目标门限值的下限值时,目标距离奖励值为目标距离差;目标距离差的值小于或等于负的目标门限值的上限值时,目标距离奖励值为负的目标门限值的上限值。

目标距离奖励值可以表示为:

式中,Rvm表示目标距离奖励值,

当

进一步的,障碍数奖励值为障碍数增减值的倍数。

优选的,障碍物增减值的倍数为10倍。

障碍数奖励值可以表示为:

Rvz=Rvz'+u*10

式中:Rvz表示障碍数奖励值,u表示表示在第i个机器的可观测范围内减少或增减的障碍数,即障碍数增减值,

进一步的,碰撞奖励值为预设的碰撞数值。

优选的,预设碰撞数值为100。

碰撞奖励值可以表示为:

Rvp=-100

式中:Rvp为碰撞奖励值。

进一步的,到达目的地奖励值为预设目的地数值。

优选的,预设目的地数值为100。

到达目的地奖励值可以表示为:

Rvd=100

式中:Rvd为到达目的地奖励值。

进一步的,奖励值为距离差奖励值、目标距离奖励值、障碍数奖励值、碰撞奖励值、到达目的地奖励值中的一个或多个的累加。

结合上述内容,奖励值Rv

Rv

将观测值、环境状态值、动作值以及奖励值输入到路径调整算法中,通过路径调整算法调整行走速度。

进一步的,路径调整算法包括有DDPG算法、MADDPG算法,优选MADDPG算法。

进一步的,路径调整算法包括有策略网络和评估网络,策略网络包括有策略评价网络和策略目标网络,评估网络包括有评估评价网络和评估目标网络。

进一步的,将机器人的观测值输入到路径调整算法中,输出机器人的行走速度,即当前行走时刻当前状态的所执行的动作值。机器人执行完动作后,环境的状态发生变化,获得下一行走时刻的环境状态值,和下一行走时刻的观测值,同时根据路径调整算法的奖励机制获得奖励值。将环境的环境状态值、动作值、奖励值和下一行走时刻的环境状态值存储在经验池中,路径调整算法根据环境的状态值、动作值、奖励值和下一行走时刻的环境状态值更新路径调整算法。

优选的,由上述可知,观测值为o

将观测值o

将{s

机器人执行动作a

利用评估评价网络输出的Q值,在路径调整算法中,进行对策略评价网络进行策略梯度更新。评价网络更新后每隔一定的步数将更新的参数值复制给策略目标网络使策略目标网络更新。

利用评估评价网络输出的Q值和评估目标网络输出的Q'值,计算路径调整算法中的loss函数。使用loss函数更新评估评价网络。评估评价网络更新后每隔一定的步数评估目标网络将更新的参数值复制给评估目标网络使评估目标网络更新。

从而通过更新后的路径调整算法进行调整机器人的行走速度,从而规避动态障碍物。

由此可见,本发明公开了一种基于多智能体的时空路径规划方法。该方法通过规划机器人的二维行走路径,避开静态障碍物,赋予机器人行走速度,获取机器人的行走时刻,由行走时刻和二维行走路径构建机器人的三维时空路径,由三维时空路径直观的判断机器人是否发生碰撞,检测到发生碰撞后,设定安全时间,在安全时间前通过路径调整算法调整机器人的行走速度,从而规避动态障碍物。本发明具有路径规划速度快,碰撞点便于观察,避障路径规划效率高的优点。

以上仅为本发明的实施例,并非因此限值本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

- 一种基于多智能体的时空路径规划方法

- 一种基于灵活时空网络模型的AGV路径规划方法