商品动态演示方法、装置及存储介质

文献发布时间:2023-06-19 11:35:49

技术领域

本发明涉及互联网技术领域,特别涉及互联网视频技术领域,具体是指一种商品动态演示方法、装置及存储介质。

背景技术

网络视频是目前非常受欢迎的互联网业态。随着移动互联网的不断发展,网络视频资源也越来越丰富,使之成为互联网应用的重要一部分。

随之而来的是,越来越多的电商平台开始利用网络视频进行产品销售,首先是产品演示视频,并发展到类似于电视销售的产品介绍直播视频。产品介绍直播视频受益于网络视频技术,其观众的参与度大幅增加。观众可以在观看直播视频了解产品信息的同时,与主播互动,就关心的问题提问。主播回答相关问题,进而进行适当的产品演示,可以使其产品演示更符合观众的需求,满足观众对商品的了解。由此,视频直播成为一种非常重要的商品销售渠道。

然而,现有技术的缺点在于,观众仅能通过主播提供的画面了解到商品信息,无法在该平台上实现试穿试戴的演示,从而无法了解自己在穿戴相关产品后的效果。

因此,如何提供一种能够克服上述缺点的商品动态演示方法成为本领域亟待解决的问题。

发明内容

本发明的目的是克服了上述现有技术中的缺点,提供一种基于人体识别技术,在播放商品介绍视频的同时,演示与观众结合的商品试穿试戴效果,从而让观众能够能直观地看到自己穿戴商品后的样子的商品动态演示方法、装置及存储介质。

为了实现上述的目的,本发明的商品动态演示方法包括以下步骤:

播放第一视频,该第一视频关联到商品信息;

拍摄观众视频,并播放;

识别所述的观众视频中的人物图像,获得识别结果;

根据所述的识别结果,在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果。

该商品动态演示方法中,所述的商品信息包括商品图像和穿戴部位;

所述的识别所述的观众视频中的人物图像,获得识别结果,具体为:

在所述的观众视频中识别出人物图像,并在该人物图像中辨别出各人体部位。

所述的根据所述的识别结果,在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果,具体为:

判断所述的各人体部位中是否包括所述的穿戴部位,若包括,则利用所述的商品图像生成所述的穿戴效果,并在所述的观众视频中演示该穿戴效果。

该商品动态演示方法中,所述的商品信息包括多角度的商品图像;

所述的判断所述的各人体部位是否包括所述的穿戴部位,若包括,则利用所述的商品图像生成所述的穿戴效果,具体为:

判断所述的各人体部位中是否包括所述的穿戴部位,若包括,则确定在所述观众视频中该穿戴部位的姿态,在所述的多角度的商品图像中选择与所述姿态吻合的商品图像生成所述的穿戴效果。

该商品动态演示方法中,所述的第一视频关联到两个以上的商品信息,

所述的第一视频或所述的观众视频播放界面上包括商品选择界面,观众通过该商品选择界面选中一个商品,

在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果,具体为:

在所述的观众视频中演示选中商品结合所述人物图像的穿戴效果。

该商品动态演示方法中,所述的播放第一视频,具体为:

播放第一视频,并识别该第一视频中是否有商品,若有,则根据识别到的商品确定该第一视频关联的商品信息。

该商品动态演示方法还包括以下步骤:

识别所述的观众视频中的人物动作,根据识别到的人物动作显示与所述商品关联的销售界面。

该商品动态演示方法中,所述的第一视频为直播视频。

本发明还提供一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时,实现上述的商品动态演示方法。

本发明还提供一种商品动态演示装置,其包括处理器、存储器、显示器和摄像头,所述的存储器上存储有计算机程序,该计算机程序被所述的处理器执行时,实现上述的商品动态演示方法。

该商品动态演示装置中,所述的第一视频和所述的观众视频同时显示于同一个显示器上。

采用了该发明的商品动态演示方法、装置及存储介质,其方法中首先播放第一视频,该第一视频关联到商品信息;同时拍摄并播放观众视频;而后可以识别观众视频中的人物图像,进而根据识别结果在观众视频中演示商品结合人物图像的穿戴效果,从而能让观众直观地看到自己穿戴了视频中所销售的商品后的样子,更容易判断商品是否合适自己,并决定是否购买。本发明的商品动态演示方法大幅提升了观众在观看商品展示视频时的主动性和参与度,能够为观众是否购买商品提供重要参考,同时有利于商品的销售,且本发明的商品动态演示装置及存储介质的实现方式简便,实现成本低廉,应用范围也十分广泛。

附图说明

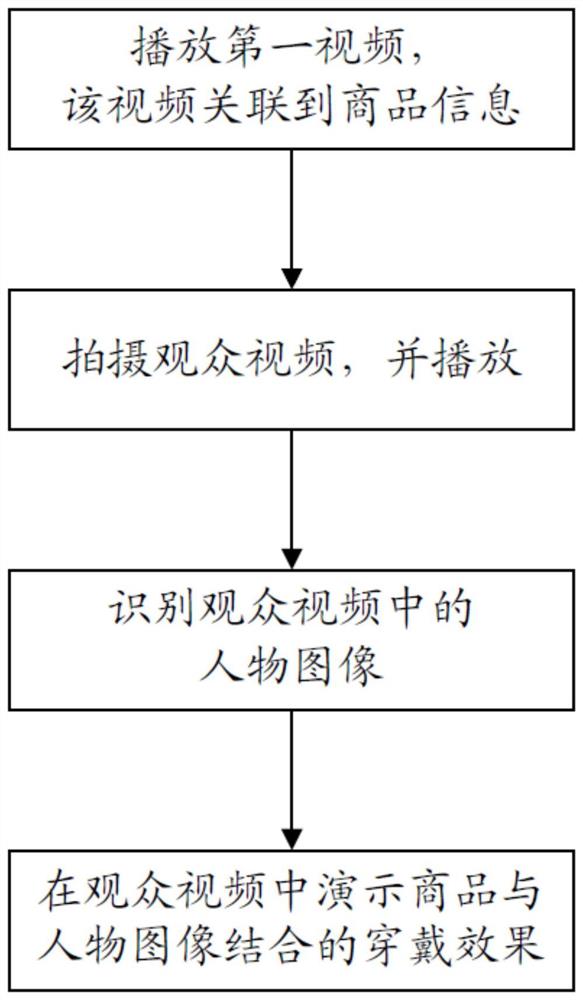

图1为本发明的商品动态演示方法的步骤流程图。

图2利用本发明的商品动态演示方法实现假发动态演示的界面示意图。

图3利用本发明的商品动态演示方法实现隐形眼镜动态演示的界面示意图。

具体实施方式

为了能够更清楚地理解本发明的技术内容,特举以下实施例详细说明。

请参阅图1所示,为本发明的商品动态演示方法的步骤流程图。

在一种实施方式中,该商品动态演示方法包括以下步骤:

播放第一视频,该第一视频关联到商品信息,该第一视频可以为直播视频或录播视频,优选为直播视频;

拍摄观众视频,并播放;

识别所述的观众视频中的人物图像,获得识别结果;

根据所述的识别结果,在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果。

其中,所述的商品信息包括商品图像和穿戴部位;

所述的识别所述的观众视频中的人物图像,获得识别结果,具体为:

在所述的观众视频中识别出人物图像,并在该人物图像中辨别出各人体部位。

所述的根据所述的识别结果,在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果,具体为:

判断所述的各人体部位中是否包括所述的穿戴部位,若包括,则利用所述的商品图像生成所述的穿戴效果,并在所述的观众视频中演示该穿戴效果。

在一种较优选的实施方式中,所述的商品信息包括多角度的商品图像;

所述的判断所述的各人体部位是否包括所述的穿戴部位,若包括,则利用所述的商品图像生成所述的穿戴效果,具体为:

判断所述的各人体部位中是否包括所述的穿戴部位,若包括,则确定在所述观众视频中该穿戴部位的姿态,在所述的多角度的商品图像中选择与所述姿态吻合的商品图像生成所述的穿戴效果。

在另一种较优选的实施方式中,所述的第一视频关联到两个以上的商品信息,

所述的第一视频或所述的观众视频播放界面上包括商品选择界面,观众通过该商品选择界面选中一个商品,

在所述的观众视频中演示所述商品与所述人物图像结合的穿戴效果,具体为:

在所述的观众视频中演示选中商品结合所述人物图像的穿戴效果。

在又一种较优选的实施方式中,所述的播放第一视频,具体为:

播放第一视频,并识别该第一视频中是否有商品,若有,则根据识别到的商品确定该第一视频关联的商品信息。

在进一步优选的实施方式中,该商品动态演示方法还包括以下步骤:

识别所述的观众视频中的人物动作,根据识别到的人物动作显示与所述商品关联的销售界面。

本发明还提供一种商品动态演示装置及一种计算机可读存储介质。该商品动态演示装置包括处理器、存储器、显示器和摄像头,所述的存储器即为所述的计算机可读存储介质,其上存储有计算机程序。该计算机程序被所述的处理器执行时,实现上述各实施方式所述的商品动态演示方法。在该商品动态演示装置中,所述的第一视频和所述的观众视频同时显示于同一个显示器上。

以下通过数个实施例说明本发明的商品动态演示方法在实际应用中的实现方式。

实施例1

以观看假发销售视频为例。

观众首先利用手机或平板等设备打开假发销售直播视频界面(第一视频),该该第一视频关联到至少一个假发信息。所述的假发信息包括一个假发的多角度图像信息以及该假发的穿戴部位,即头部的头顶位置;

同时,设备的前置摄像头开始对观众进行拍摄,并在设备上同时播放该自拍视频(观众视频),其界面如图2所示。

设备进一步对观众视频中的人物图像,产生识别结果;具体而言,是观众视频中识别出人物图像,并在该人物图像中辨别出各人体部位,在该实施例中即识别人物图像是否包括头部。若包括,则确定在观众视频中该穿戴部位的姿态,也就是确定头部的姿态,进而在该假发的多角度图像信息中选择与所述姿态吻合的假发图像生成穿戴效果。并在观众视频中演示该穿戴效果。需要说明的是,上述拍摄观众视频、识别、生成穿戴效果并演示的过程是一个实时动态的过程,即利用该实施方式可以在观众视频中展示观众带上假发后的动态效果。

在人体部位识别的实际实现方法上,可以利用开源人体姿态识别项目OpenPose或其它类似的方法实现。OpenPose人体姿态识别项目是基于卷积神经网络和监督学习并以caffe为框架开发的开源库。可以实现人体动作、面部表情、手指运动等姿态估计。相关的人体姿态估计技术可以很好地适用于体育健身、动作采集、3D试衣等领域。

利用该实施例的方法,观众在观看假发销售直播视频的同时,可以清楚地看到自己戴上这款假发后的样子,从而对于这款假发是否适合自己有更直观的判断,用户体验更佳。

上述内容仅以假发为商品进行举例,相类似的穿戴商品,如墨镜、鞋子等等,均可再替换适合的商品信息后适用。

实施例2

以观看隐性眼镜销售视频为例。

与实施例1相似的是,观众首先利用手机或平板等设备打开隐性眼镜销售直播视频界面(第一视频),该该第一视频关联到至少一个隐性眼镜信息。所述的隐性眼镜信息包括一个隐性眼镜的多角度图像信息以及该隐性眼镜的穿戴部位,即眼部的瞳孔位置;

同时,设备的前置摄像头开始对观众进行拍摄,并在设备上同时播放该自拍视频(观众视频),其界面如图3所示。

与实施例1的区别之处在于,设备进一步对观众视频中的人物图像,产生识别结果;具体而言,是观众视频中识别出人物图像,并在该人物图像中辨别出各人体部位,在该实施例中即识别人物图像是否包括头部。若包括,则需要进一步对人物面部表情进行识别,以识别出双眼的瞳孔图像和位置。而后在该隐形眼镜的多角度图像信息中选择与瞳孔图像、大小、姿态等吻合的隐形眼镜图像生成穿戴效果。并在观众视频中演示该穿戴效果。

在人体部位识别的实际实现方法上,可以如实施例1所述的,利用开源人体姿态识别项目OpenPose或其它类似的方法实现。

在面部表情识别的实际实现方法上,可以利用EmoPy项目或其它相似的识别技术。EmoPy专注于面部表情识别(FER),利用其所提供的工具包,开发者可以根据面部图像识别面部中的瞳孔等信息,进而判断图像中人物的情绪。

实施例3

与上述实施例1和2的区别在于,商品销售直播视频(第一视频)可以关联到两个以上的商品信息,例如,在一个视频中销售多款戒指。

此时,第一视频或所述的观众视频播放界面上可以包括商品选择界面,观众可以通过该商品选择界面选中一个商品,即观众可以选中一款戒指。

而后,与上述实施例同样的,当在观众视频中识别出手指图像时,即可演示观众戴上选中戒指后的穿戴效果。

另外,也可以通过在商品销售直播视频(第一视频)中识别商品,确定当前的演示商品,供观众试穿或试戴。同样以戒指为例,当戒指销售直播视频的主播戴着或展示某一款戒指时,该款戒指即为演示商品,相当于观众选中的商品,观众视频中可演示观众戴上直播视频中同款戒指的穿戴效果。

实施例4

与上述各实施例的区别在于,该方法还可以进一步识别所述的观众视频中的人物动作,特别是手势,并根据识别到的人物动作或手势显示与所述商品关联的销售界面。同样以戒指为例,当观众视频中展示了一款戒指的穿戴效果的同时,或展示之后,观众作出OK的手势,设备马上可以展示出该款戒指的销售界面,供观众进行购买操作。

在手势识别的实际实现方法上,可以采用LibHand或其它类似功能的软件实现。LibHand是一个用于呈现和识别人的手势的开源代码库。并提供简单的编程接口,以获取并分析手势图像。

该实施例提供了从商品销售直播视频到试穿试戴效果演示,再到购买的便捷切换方式,以提供用户更好的消费体验。

采用了该发明的商品动态演示方法、装置及存储介质,其方法中首先播放第一视频,该第一视频关联到商品信息;同时拍摄并播放观众视频;而后可以识别观众视频中的人物图像,进而根据识别结果在观众视频中演示商品结合人物图像的穿戴效果,从而能让观众直观地看到自己穿戴了视频中所销售的商品后的样子,更容易判断商品是否合适自己,并决定是否购买。本发明的商品动态演示方法大幅提升了观众在观看商品展示视频时的主动性和参与度,能够为观众是否购买商品提供重要参考,同时有利于商品的销售,且本发明的商品动态演示装置及存储介质的实现方式简便,实现成本低廉,应用范围也十分广泛。

在此说明书中,本发明已参照其特定的实施例作了描述。但是,很显然仍可以作出各种修改和变换而不背离本发明的精神和范围。因此,说明书和附图应被认为是说明性的而非限制性的。

- 商品动态演示方法、装置及存储介质

- 一种动态社交网络中商品传播最大化方法、系统、装置及存储介质