基于自适应正则特征联合时间关联的相关滤波跟踪方法

文献发布时间:2023-06-19 11:02:01

技术领域

本发明属于机器视觉中的视频图像跟踪技术领域,涉及一种基于自适应正则特征联合时间关联的相关滤波跟踪方法。

背景技术

随着计算机技术的飞速发展,目标跟踪成为了计算机视觉研究的热门课题之一。视觉目标跟踪,视觉目标跟踪就是在视频序列的每帧图像中通过一些算法不断标记被跟踪目标的位置,从而获得目标的运动参数,如位置、速度、加速度等,从而进行进一步的处理分析,实现对目标的行为理解,以完成更高级的任务。其作为计算机视觉领域的一个重要分支,在科学技术、国防建设、航空航天、医药卫生以及国民经济的各个领域有各种各样的应用,例如智能视频监控、人机交互、机器人和自动驾驶等。相关滤波目标跟踪方法具有处理速度快、跟踪精度高等优点。

在相关滤波中,提取目标区域的样本特征非常重要,对于提取的特征有以下两种:(1)传统特征,传统特征是人为设定的特征如图像颜色直方图特征、方向梯度直方图特征(HOG)、局部二值模式特征(LBP);(2)卷积特征,卷积特征是使用深度卷积网络(CNN)提取出的特征,CNN靠后卷积层输出的特征图(称之为深层特征)具有较高的语义信息与平移不变性,对于目标变化来说具有很好的鲁棒性,但对于需要精确定位目标位置的目标跟踪来说,只有深层特征是不够的,因为其空间解析度太低而无法对跟踪目标进行准确定位,而CNN靠前卷基层输出的特征图(称之为浅层特征)具有高空间细节的特点,很有利于目标定位,然而这种特征对于目标外观变化不具有鲁棒性,不利于目标的精确定位。

现有的相关滤波跟踪方法提取第一帧目标周围矩形区域的特征,基于该特征通过岭回归训练出相关滤波器,对滤波器与特征更新后在后续帧中使用更新过得滤波器与特征对待跟踪帧搜索区域特征进行相关操作,相关操作后会得到响应图,响应图中最大响应值点位置即为目标位置。基于CNN特征的相关滤波则将传统特征替换为多层卷积特征,得到多层相关滤波响应后使用加权融合的方法推断目标位置。

(1)现有技术方法并没有考虑到目标尺度发生变化时,原始加窗会导致滤波器学习到的目标不完整或者背景信息过多,这种滤波器鲁棒性差,跟踪精度低,且可能最终导致跟踪失败。

(2)现有方法对于使用卷积特征的相关滤波目标跟踪方法时,使用对多层相关滤波响应使用加权融合的方法推断目标位置,但其权值每一帧都是固定的,并非自适应权值,这样不能满足跟踪器的需求会降低跟踪器的鲁棒性和精度。

发明内容

本发明的目的是提供一种基于自适应正则特征联合时间关联的相关滤波跟踪方法,解决了目标在尺度发生变化时,原始加窗会导致滤波器学习到的目标不完整或者背景信息过多的问题。

本发明所采用的技术方案是,基于自适应正则特征联合时间关联的相关滤波跟踪方法,具体包括如下步骤:

步骤1,选取待跟踪视频序列,并初始化该视频序列的第一帧;

步骤2,确定目标在跟踪视频序列第二帧的中心位置,并对第二帧中的目标尺度进行估计;

步骤3,确定目标在跟踪视频序列第t帧的位置,并对第t帧中的目标尺度进行估计,其中t>2。

本发明的特点还在于:

步骤1的具体过程为:

步骤1.1,人为框定待跟踪视频序列第一帧中的目标区域,得到目标中心位置坐标p

步骤1.2,根据视频序列第一帧中目标中心位置p

步骤1.3,使用卷积神经网络提取视频序列第一帧训练搜索区域I

步骤1.4,根据目标区域大小与第一帧训练搜索区域I

步骤1.5,根据步骤1.4加窗后的卷积特征

步骤1.4中加窗的具体过程为:加窗后的总窗函数为余弦窗与高斯窗两种窗函数的叠加,其中:

余弦窗由第一帧训练搜索区域中卷积特征的尺寸

第一帧训练搜索区域高斯窗由如下公式(1)确定:

其中,

加窗后的总窗函数如下公式(2)所示:

步骤1.5的具体过程如下:

令

公式(3)中,*表示卷积操作,y是大小为h

其中,

步骤2的具体过程如下:

步骤2.1,确定第二帧的检测搜索区域Z

步骤2.2,提取第二帧检测搜索区域Z

步骤2.3,对第二帧的检测搜索区域特征

步骤2.4,通过如下公式(6)计算相关滤波器α

其中,∧为离散傅里叶变换,

步骤2.5,采用如下公式(7)对第二帧的目标中心位置p

其中,

步骤2.6,根据步骤2.5获得的跟踪视频序列第二帧目标的中心位置p

步骤2.7,由目标在第二帧图像中的中心位置p

步骤3的具体过程如下:

步骤3.1,由上一帧中的目标中心位置p

步骤3.2,提取t-1帧训练搜索区域I

步骤3.3,对t-1帧训练搜索区域特征

其中,

步骤3.4,根据加窗后的卷积特征

为了加速运算,将公式(9)变换到频域得到如下公式(10):

其中,

步骤3.5,确定第t帧的检测搜索区域Z

步骤3.6,提取第t帧检测搜索区域Z

步骤3.7,对第t帧的检测搜索区域卷积特征

步骤3.8,通过如下公式(12)计算相关滤波器

其中,∧为离散傅里叶变换,

步骤3.9,采用如下公式(13)对第t帧中目标中心位置p

其中,

步骤3.10,根据步骤3.9获得的跟踪视频序列第t帧目标的中心位置p

步骤3.11,由目标在第t帧图像中的中心位置p

步骤3.12,重复步骤3.1-3.11,直至跟踪结束。

本发明的有益效果是,提高了跟踪过程中发生尺度变化时目标特征被学习的不完整或者背景被学习过多情况下的跟踪精度和鲁棒性,并且实现了响应图间权值的自适应分配,提高了跟踪器的精度和鲁棒性。

附图说明

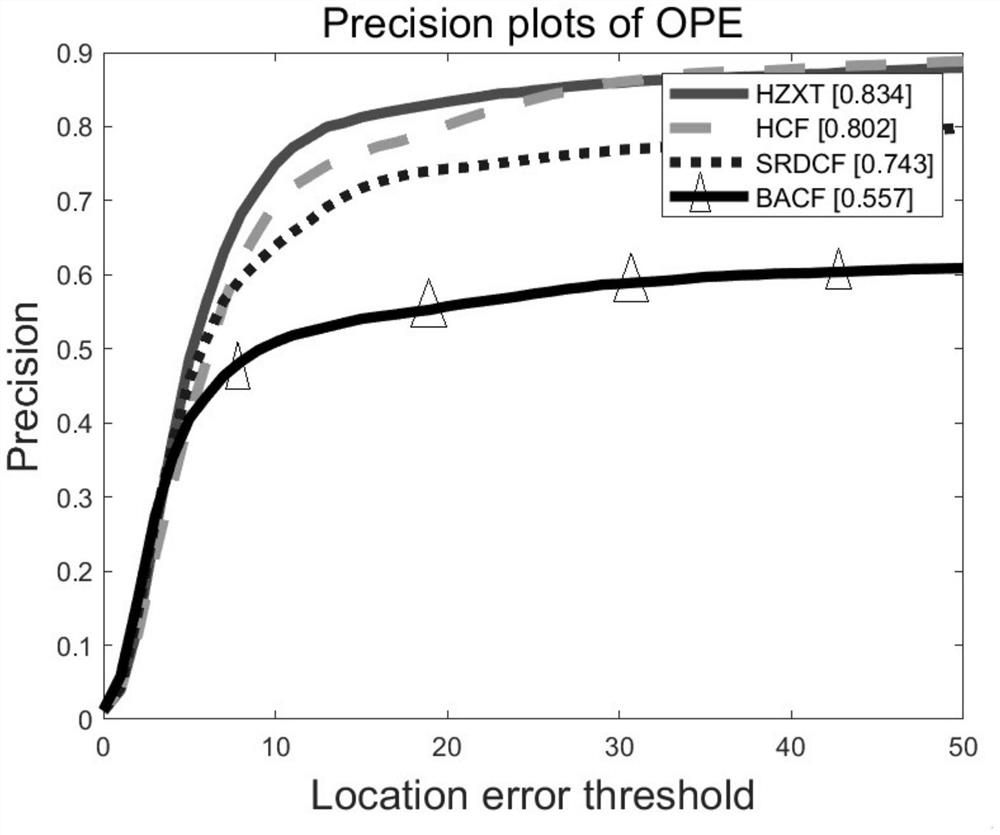

图1是本发明基于自适应正则特征联合时间关联的相关滤波跟踪方法与现有跟踪算法关于精确率的比对图;

图2是本发明基于自适应正则特征联合时间关联的相关滤波跟踪方法与现有跟踪算法关于成功率的比对图。

具体实施方式

下面结合附图和具体实施方式对本发明进行详细说明。

本发明基于自适应正则特征联合时间关联的相关滤波跟踪方法,具体包括如下步骤:

步骤1,选取待跟踪视频序列,并初始化该序列的第一帧;

步骤1.1,人为框定第一帧目标区域得到目标中心位置坐标p

步骤1.2,由第一帧中目标中心位置p

在第一帧所获取得图像中以p

步骤1.3,使用VGG-19卷积神经网络提取第一帧训练搜索区域I

步骤1.4,根据目标大小与第一帧训练搜索区域大小对特征进行加窗,最后总的窗函数由余弦窗与高斯窗两种窗函数叠加而成,称其为自适应正则特征窗,具体的:

余弦窗由第一帧训练搜索区域特征的尺寸,即由f

第一帧训练搜索区域高斯窗由第一帧训练搜索区域的尺寸与第一帧目标尺度决定,

将最终加窗特征

步骤1.5,根据提取的特征训练相关滤波器α

令f

公式(1)中,*表示卷积操作,y是一大小为h

其中,

步骤2,确定目标在视频图像第二帧的中心位置p

步骤2.1,确定第二帧的检测搜索区域Z

步骤2.2,提取第二帧检测搜索区域的卷积特征,并使用双线性插值法使特征图的尺寸和输入一致,插值后的特征为

步骤2.3,对第二帧的检测搜索区域特征

余弦窗由第二帧检测搜索区域特征的尺寸,即由

第二帧检测搜索区域高斯窗由第二帧检测搜索区域的尺寸与第一帧目标尺度决定,

步骤2.4,通过(3)计算相关滤波器

其中,∧为离散傅里叶变换。

步骤2.5,对第二帧的目标中心位置p

其中,

在得到

步骤2.6,尺度估计

在获得视频序列第二帧图像中目标的中心位置p

步骤2.7,相关滤波器α

由目标新的中心位置p

在第二帧所获取得图像中以p

对上述特征

余弦窗由第二帧训练搜索区域特征的尺寸,即由

第二帧训练搜索区域高斯窗由第二帧训练搜索区域的尺寸与第二帧目标尺度决定,

其中,η为学习率,c为特征通道数。

步骤3,确定第t(t>2)帧的目标位置p

步骤3.1,由上一帧目标中心位置p

在第t-1帧所获取得图像中以p

步骤3.2,提取t-1帧训练搜索区域的卷积特征并使用双线性插值法使特征图的尺寸和输入一致得到

步骤3.3,对t-1帧训练搜索区域特征

余弦窗由第t-1帧训练搜索区域特征的尺寸,即由

第t-1帧训练搜索区域高斯窗由第t-1帧训练搜索区域的尺寸与第t-1帧目标尺度决定,

步骤3.4,根据提取的特征

令

公式(7)中,*表示卷积操作,y是一大小为h×w的矩阵,其矩阵第m行n列的元素y

其中,

步骤3.5,确定第t帧的检测搜索区域Z

步骤3.6,提取第t帧检测搜索区域Z

步骤3.7,对第t帧的检测搜索区域特征

余弦窗由第t帧检测搜索区域特征的尺寸,即由

第t帧检测搜索区域高斯窗由第t帧检测搜索区域的尺寸与第t-1帧目标尺度决定,

步骤3.8,通过(9)计算相关滤波器

其中,∧为离散傅里叶变换。

步骤3.9,对目标中心位置p

其中,

其中,t-1表示上一帧。

其中,t表示待跟踪帧。

由于视频序列并非单张图像,其存在一定的时间关联,相邻帧目标位置变化并非很明显,利用这一特点,可以根据公式(14)确定出μ

步骤3.10,尺度估计;

在获得视频序列第二帧图像中目标的中心位置p

步骤3.11,相关滤波器

由目标在第t帧中新的中心位置p

在第t帧所获取得图像中以p

对上述特征

余弦窗由第t帧训练搜索区域特征的尺寸,即由

第t帧训练搜索区域高斯窗由第t帧训练搜索区域的尺寸与第t帧目标尺度决定,

其中,η为学习率,c为特征通道数。

步骤3.12,在视频序列新一帧到来时,重复步骤3.1-3.10,直至跟踪结束。

实施例

本算法采用OTB-100数据集来进行评估,算法开发环境为Matlab R2018b以及深度学习库MatConvNet-Gpu,处理器为AMD Ryzen 7 1700Eight-Core Processor,GPU选择GTX-1060。实验中算法对测试视频采用相同的参数,具体设置为:正则化参数λ=10

本发明中的算法为HZXT,通过与3个具有代表性的跟踪器进行比较来评估所提出的算法,分别为基于相关滤波的SRDCF、BACF、以及基于深度学习的HCF。首先绘制跟踪算法在成功率和精确率方面的对比图,如图1,2所示。本发明算法与其他算法相比,在精确率与成功率方面取得了较为优异的成果。图1中,本算法精确率达到了0.834,高于其他算法;在图2中,本发明算法也优于其他算法。由表1的实验结果可知,在面临11种不同情形的挑战时,本发明算法的成功率均为最优值或次优值,尤其在快速运动(Fast Motion,FM)、运动模糊(Motion Blur,MB)、目标形变(Deformation,DEF)、遮挡(Occlusion,OCC)等情况下,算法成功率要优于目前最流行的其他相关滤波算法,证明了提出的算法够进一步增强跟踪算法的鲁棒性。

表1

- 基于自适应正则特征联合时间关联的相关滤波跟踪方法

- 基于外观自适应空间正则化相关滤波器的目标跟踪方法