一种LSTM与CNN相结合的跨视角步态识别方法

文献发布时间:2023-06-19 09:35:27

技术领域

本发明属于机器视觉领域,涉及一种LSTM与CNN相结合的跨视角步态识别方法。

背景技术

生物特征识别在安全监控、行人跟踪、身份识别等领域有着广泛的应用。目前,公共场所都安装有大量的摄像监控设备,采集的监控数据多用于事后取证,较少对特定目标行人在无感知、远距离、非受控的情况下进行身份验证,以支持安全预警和报警。步态是人在行进过程中走路姿态的表现,具有非接触、非侵入性、难以隐藏和伪造的特点,是唯一可以在远距离、非受控的状态下获得的生物特征,可支持远距离身份识别,因此,步态识别有着广阔的应用前景。

步态在一组运动周期中才能表现出显著性特征,易受外在环境(视角、路面、遮挡等)和自身因素(携带物、着装等)的干扰,加之人体的非刚性运动,使观察视角的变化对行人步态的类内特征影响较大。现有基于表观建模的跨视角步态识别方法采用类能量图建模,容易丢失步态的时空信息,易受行人衣着、携带物及形体变化影响,识别性能有限,只适用于视角变化范围有限或较小的情形。由于步态信息本质的三维性,在3D空间中,人体关节的运动变化可以更准确描述步态特征。但是,传统3D步态模型中人体关节点跟踪是一个难点,而使用3D设备或多摄像机协作重构3D步态模型,需要复杂的摄像机参数调整及建模计算,其应用场景又受到限制。

发明内容

本发明的目的在于克服上述现有技术的缺点,提供了一种LSTM与CNN相结合的跨视角步态识别方法,该方法能够实现跨视角步态识别,且省略行人检测跟踪的预处理步骤。

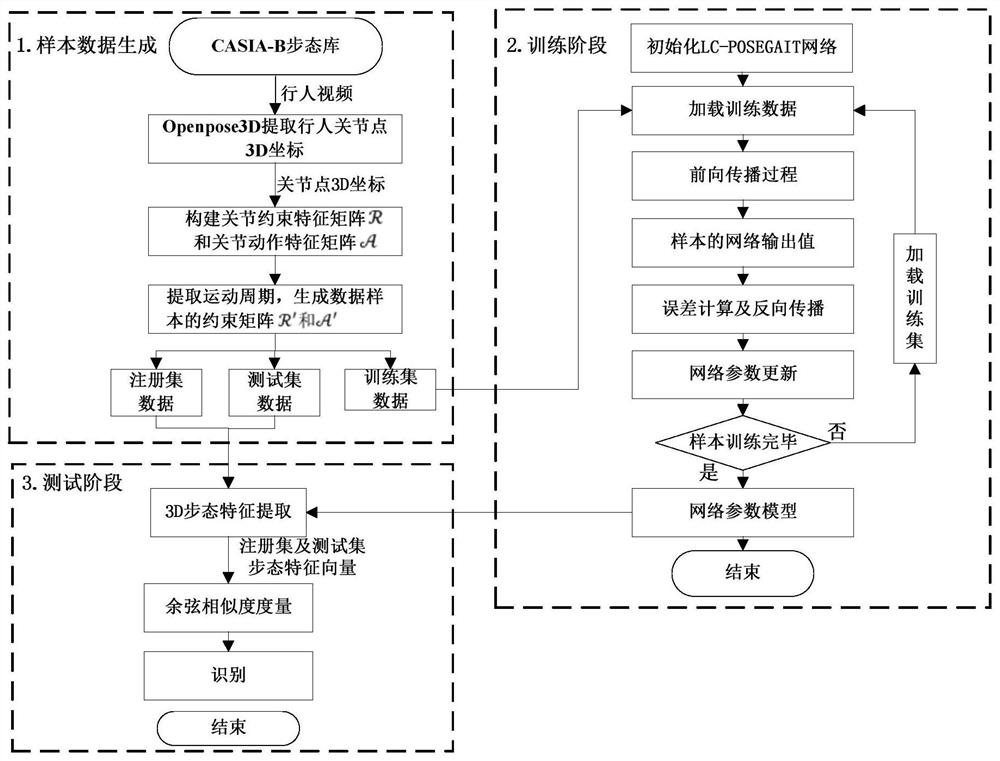

为达到上述目的,本发明所述的LSTM与CNN相结合的跨视角步态识别方法包括以下步骤:

1)从CASIA-B步态视频数据集中,采用OpenPose3D提取视频中行人的3D姿态数据;

2)从步骤1)中获取的3D姿态数据中提取视频行人关节点的运动约束数据及关节动作数据,构建行人运动约束矩阵并以此建立样本集;

3)构建LSTM与CNN并行组合的3D步态识别网络LC-POSEGAIT;

4)利用步骤2)得到的训练集样本对3D步态识别网络LC-POSEGAIT进行训练;

5)利用训练后的3D步态识别网络LC-POSEGAIT提取视频行人的步态特征向量,并对步态特征向量进行度量,实现跨视角步态识别。步骤1)的具体操作为:从CASIA-B步态视频数据集中,采用OpenPose3D提取视频中行人的3D姿态数据

步骤2)的具体操作为:

21)根据视频行人的关节点姿态数据,分别计算关节夹角约束R

22)根据视频行人的关节点姿态数据,设定用关节点在时间序列m上的位移矢量序列

23)设定步态分割周期,以视频行人左脚在前与地面第一次接触,到左脚再次与地面接触的过程确定为一个步态分割周期;

24)从行人关节约束特征矩阵及关节动作特征矩阵中提取两个步态分割周期的数据,并以此构建样本集

步骤3)的具体操作为:

采用LSTM网络和CNN网络并行组合的方式建立3D步态识别网络LC-POSEGAIT,其中,LSTM网络用于提取视频行人关节约束特征矩阵

3D步态识别网络LC-POSEGAIT采用Softmax损失函数L

步骤5)的具体操作为:

51)将3D步态识别网络LC-POSEGAIT的全连接层向量作为行人3D步态特征向量,分别提取测试集和注册集样本的3D步态特征向量,其中,测试集的特征向量集

52)在测试集中,选取行人i在视角θ下的3D步态特征向量

步骤21)中关节约束特征矩阵

利用OpenPose3D获取视频中行人的关节点姿态数据,计算并建立关节约束特征矩阵

其中,关节点向量

得到视频行人运动的3D关节约束特征矩阵

步骤22)中关节动作特征矩阵

利用OpenPose3D获取行人视频中的关节点姿态数据,建立关节点i在时间序列m上的位移矢量序列

其中,Δt表示连续两帧之间的时间间隔,

得关节动作特征矩阵

3D步态识别网络LC-POSEGAIT的损失函数为:

其中,

本发明具有以下有益效果:

本发明所述的LSTM与CNN相结合的跨视角步态识别方法在具体操作时,直接从CASIA-B步态视频数据集中,采用OpenPose3D提取视频中行人的3D姿态数据,并以此对3D步态识别网络LC-POSEGAIT进行训练,不但简化了视频中行人检测、跟踪的预处理步骤,直接获得关节点的空间三维坐标,避免建立3D步态模型需要在3D成像设备或多摄像机协作环境下的重构,使得步态识别的应用场景更加广泛。另外,本发明采用3D步态识别网络LC-POSEGAIT进行识别,其中,LSTM分支从关节约束特征矩阵中学习关节运动约束的时序特征,CNN分支捕捉动作特征矩阵中行人关节的空间运动特征,以充分挖掘3D步态运动的时空特征,可在跨视角步态识别下取得较好的效果。

附图说明

图1为本发明的流程图;

图2为人体关节点的标注图;

图3为行人关节约束特征向量矩阵构建的流程图;

图4为3D步态识别网络LC-POSEGAIT的结构图;

图5为SPAE、GaitGANv2、PoseGait方法与本发明的平均识别率对比图。

具体实施方式

下面结合附图对本发明做进一步详细描述:

参考图1,本发明所述的LSTM与CNN相结合的跨视角步态识别方法包括以下步骤:

1)从CASIA-B步态视频数据集中,采用OpenPose3D提取视频中行人的3D姿态数据;

从中科院自动化所公开的CASIA-B步态视频数据集中,采集OpenPose3D提取视频中124个行人的3D姿态数据

2)从步骤1)中获取的3D姿态数据中提取视频行人关节点的运动约束数据及关节动作数据,并以此构建训练集样本;

步骤2)的具体操作为:

21)根据视频行人的关节点姿态数据,分别计算关节夹角约束R

步骤21)中关节约束特征矩阵

利用OpenPose3D获取视频中行人的关节点姿态数据,计算并建立关节约束特征矩阵

其中,关节点向量

得到视频行人运动的3D关节约束特征矩阵

22)根据视频行人的关节点姿态数据,设定用关节点在时间序列m上的位移矢量序列

步骤22)中关节动作特征矩阵

利用OpenPose3D获取行人视频中的关节点姿态数据,建立关节点i在时间序列m上的位移矢量序列

其中,Δt表示相邻两帧之间的时间间隔,

得行人的关节动作特征矩阵

23)以视频行人左脚在前与地面第一次接触,到左脚再次与地面接触的过程确定为一个步态分割周期,其中,一个步态分割周期内的所有视频帧为该步态分割周期内的视频帧;

24)从行人关节动作特征矩阵及视频行人运动的3D关节约束特征矩阵中提取两个步态分割周期的数据,并以此构建训练集样本

具体的,将视频行人左脚在前与地面第一次接触到左脚再次与地面接触的过程确定为一个步态分割周期,具体为,当左脚在前时,左右踝关节(图2中节点13和节点10)与XOY平面(地平面)的距离都是最短时所在的视频帧为一个步态分割周期的开始帧,若某一帧满足条件

经历“(左脚前右脚后一起着地)→(左脚着地,右脚抬起)→(右脚前左脚后一起着地)→(右脚着地,左脚抬起)→(左脚前右脚后一起着地)”的过程,分别计算每帧行人左右踝关节与XOY平面的距离z

从关节约束特征矩阵

将步态标准样本分为训练集、注册集和测试集,用于训练LC-POSEGAIT网络和跨视角步态识别。样本集划分如表1所示。

表1

3)构建3D步态识别网络LC-POSEGAIT;

步骤3)的具体过程为:

31)3D步态识别网络LC-POSEGAIT构建:采用LSTM与CNN并行组合的方式建立3D步态识别网络LC-POSEGAIT,如图4所示,其中,LSTM网络一共有2层,用于提取行人关节约束特征矩阵

CNN网络由2个卷积层、2个池化层构成和一个全连接层,用于提取关节动作特征矩阵

表2

两个网络提取的特征在全连接层融合。

采用Softmax损失函数L

其中,

32)3D步态识别网络LC-POSEGAIT的初始化:

选用Adam方法优化网络,在训练过程中以自适应方式调节各参数的学习率,使网络尽快收敛,同时,为了使网络反向传播计算的收敛速度更快,选择激活函数ReLU,其公式为

4)利用步骤2)得到的训练集样本对3D步态识别网络LC-POSEGAIT进行训练;

具体过程为:将训练集数据(001#-074#)的关节约束特征矩阵

5)利用训练后的3D步态识别网络LC-POSEGAIT提取视频行人的步态特征向量,完成LSTM与CNN相结合的跨视角步态识别。

步骤5)的具体操作为:

51)将3D步态识别网络LC-POSEGAIT的全连接层向量作为行人3D步态特征向量,分别提取测试集和注册集样本的3D步态特征向量,其中,测试集的特征向量集

52)在测试集中,选取行人i在视角θ下的3D步态特征向量

为了验证发明方法的有效性,在CASIA-B数据集上进行正常行走、衣着不变化、背包行走下的同状态跨视角实验,识别率取测试集在各视角识别率的平均值,实验结果如表3所示。

表3

为和SPAE、GaitGANv2表观方法以及姿态估计的PoseGait方法识别结果进行对比,调整测试集中注册集的行走状态为nm01-04,测试数据集为nm05-06、bg01-02、cl01-02,跨视角的平均识别率如图5所示。

- 一种LSTM与CNN相结合的跨视角步态识别方法

- 一种结合自编码器与视角变换模型的跨视角步态识别方法