视障用户实时辨识系统及方法

文献发布时间:2023-06-19 09:57:26

技术领域

本发明涉及视觉协助技术领域,尤其涉及一种视障用户实时辨识系统及方法。

背景技术

通常,视障人士需要通过盲文,广播,有声读物和某些只能为其读取特定信息的应用程序来接收其信息。在辨认图像方面,也有一些移动应用程序纯粹透过人工智能来辨认图像。但是人工智能在解决视觉问题上并不通用。人类可以轻松识别信件中的关键信息,而人工智能一般只会读出所有内容。又或者,我们将需要使用许多具有相同格式的图片来训练人工智能,以便能够以这种特定格式提取关键信息。这使到用人工智能来提供视力协助在实际使用上效果并不理想。另一个原因是人的互动对于解决复杂的问题至关重要。

发明内容

本发明实施例所要解决的技术问题在于,提供一种视障用户实时辨识系统及方法,以协助视障人士辨认图像。

为了解决上述技术问题,本发明实施例提出了一种视障用户实时辨识系统,包括:

辨识终端:将采集的视障用户面前的图像实时进行预处理,将预处理结果连续与数字化目标默认值进行对比,当相似度达到阈值时,以语音形式输出;若未比对到相似度达到阈值时或用户选择进入人工模式时,则将当前的图像上传至服务器;

服务器:将辨识终端上传的图像分配至服务终端,将服务终端上传的识别结果发送至对应的辨识终端;或通过网络实时连接辨识终端和服务终端;

服务终端:对应的志愿者通过服务终端接收辨识终端上传的图像,再将志愿者人工识别结果发送至服务器;或与辨识终端连接,使志愿者与视障用户直接实时通讯,实时为视障用户提供人工帮助。

进一步地,辨识终端中采用卷积神经网络模型对图像进行预处理,所述图像数据依次进入卷积神经网络模型的第一个卷积层、第二个卷积层、池化层、第一个完全连接层以及第二个完全连接层后输出结果。

进一步地,辨识终端还包括文字识别模块:识别图像中的文字,并以语音的形式输出。

相应地,本发明实施例还提供了一种视障用户实时辨识方法,包括:

步骤1:辨识终端将采集的视障用户面前的图像实时进行预处理,将预处理结果连续与数字化目标默认值进行对比,当相似度达到阈值时,以语音形式输出;若未比对到相似度达到阈值时或用户选择进入人工模式时,则将当前的图像上传至服务器;

步骤2:服务器将辨识终端上传的图像分配至服务终端,将服务终端上传的识别结果发送至对应的辨识终端;或通过网络实时连接辨识终端和服务终端;

步骤3:对应的志愿者通过服务终端接收辨识终端上传的图像,再将志愿者人工识别结果发送至服务器;或与辨识终端连接,使志愿者与视障用户直接实时通讯,实时为视障用户提供人工帮助。

进一步地,步骤1中采用卷积神经网络模型对图像进行预处理,所述图像数据依次进入卷积神经网络模型的第一个卷积层、第二个卷积层、池化层、第一个完全连接层以及第二个完全连接层后输出结果。

进一步地,步骤1还包括:

文字识别子步骤:识别图像中的文字,并以语音的形式输出。

本发明的有益效果为:本发明既可智能辨识视障用户所拍摄的图像,又可将图像上传分配至相应的志愿者,志愿者再将识别信息发送至视障用户,能够实时地、全方位地协助视障用户辨别景物和对象。

附图说明

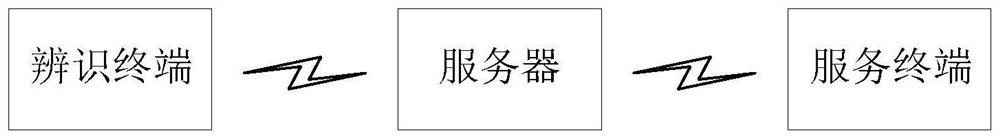

图1是本发明实施例的视障用户实时辨识系统的结构示意图。

图2是本发明实施例的传输示意图。

图3是本发明实施例的视障用户实时辨识方法的流程示意图。

图4是本发明实施例采用的卷积神经网络模型的模型图。

图5是本发明实施例采用的卷积神经网络模型的结构图。

具体实施方式

需要说明的是,在不冲突的情况下,本申请中的实施例及实施例中的特征可以相互结合,下面结合附图和具体实施例对本发明作进一步详细说明。

本发明实施例中若有方向性指示(诸如上、下、左、右、前、后……)仅用于解释在某一特定姿态(如附图所示)下各部件之间的相对位置关系、运动情况等,如果该特定姿态发生改变时,则该方向性指示也相应地随之改变。

另外,在本发明中若涉及“第一”、“第二”等的描述仅用于描述目的,而不能理解为指示或暗示其相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”的特征可以明示或者隐含地包括至少一个该特征。

请参照图1,本发明实施例的视障用户实时辨识系统包括辨识终端、服务器及服务终端。

辨识终端:将采集的视障用户面前的图像实时进行预处理,将预处理结果连续与数字化目标默认值进行对比,当相似度达到阈值时,以语音形式输出;若未比对到相似度达到阈值时或用户选择进入人工模式时,则将当前的图像上传至服务器。例如人类(男/女性、老人/小童/预设的亲友)、家居物品(门/窗/枱/椅/电视/沙化/煲/杯 )、户外(车/巴士,楼梯/电梯)或较大的路标示等。本发明实施例的数据集可通过会不断更新和自我学习和修订以提高准确性。

服务器:将辨识终端上传的图像分配至服务终端,将服务终端上传的识别结果发送至对应的辨识终端;或通过网络实时连接辨识终端和服务终端。

服务终端:对应的志愿者通过服务终端接收辨识终端上传的图像,再将志愿者人工识别结果发送至服务器;或与辨识终端连接,使志愿者与视障用户直接实时通讯,实时为视障用户提供人工帮助。

本发明使到视力有问题的用户可以实时或在最短时间内得到协助,自动识别视障用户所拍摄的图像。请参照图2,本发明实施例的辨识终端安装于视障用户的手机端,服务终端安装于志愿者(义工)的手机端。此外,透过一个志愿者(义工)社群,本发明所提供的服务可以在全日二十四小时都能运作,全世界的人士都可以下载此程序并成为志愿者(义工)。每当视障用户需要帮助的时候,它可以把景物或对象拍摄下来并实时发送给志愿者(义工),安装了服务终端的志愿者(义工)将会收到通知,志愿者(义工)可以选择是否响应,有时间的志愿者(义工)就会用语音或文字讯息描述照片给视障用户。

另外,为了提供实时的协助,本发明实施例也允许视障用户发出实时支持请求,有时间的志愿者(义工)透过类似视像会议的形式和视障用户联系并且可以志愿者(义工)可以看到视障用户眼前的景物并且通过语音实时协助视障用户。

本发明在接收信息方面有更大的灵活性。对于视力障碍的用户,本发明可以联系自愿提供视觉说明的志愿者,他们愿意提供帮助为有视力障碍的用户的日常生活提供便利。对于志愿者,本发明在随时随地帮助人们的同时积累志愿者时数的机会。对于广告客户,本发明提供了广泛的受众群体,以便他们的信息可以被各地的不同人士接收。

作为一种实施方式,辨识终端中采用卷积神经网络模型对图像进行预处理,所述图像数据依次进入卷积神经网络模型的第一个卷积层、第二个卷积层、池化层、第一个完全连接层以及第二个完全连接层后输出结果。

请参照图4~图5,图像数据在卷积神经网络模型(CNN)中被分解成不同像素大小的层,卷积神经网络模型从输入的图像数据中学习输入与输出之间的映像关系,而不需要人为干预特征的精确表达过程。输入层是由图像素转化而来的数组;卷积神经网络模型包括多个卷积层( convolution layer )、池化层,都称采样层( pooling layer )全连接层(fully connected layer )等等,可看作由相连的神经元组成的神经网络;而输出层则为判别结果。输入层,由三组卷积池化层组成的隐藏层和全连接层。进入输入层的数据是由二维彩图(RGB色彩模式)转化而成的数组,其大小由图像的分辨率乘以RGB位数决定(宽×高×3)。来自输入层的数据首先进入第一个卷积层。卷积层带有与之对应的过滤器(filter),它是一个数字矩阵。在卷积层,输入矩阵与过滤器矩阵卷积相乘得到一个新的矩阵,即特征图(feature map)。

卷积层,根据实际应用调节过滤器大小、步长及填充方式,其中过滤器的选择决定每次取样的范围,步长决定每次取样移动的像素个数,填充方式有零填充和抛弃填充(用于处理过滤器大小与图像大小不符的情况)。卷积运算的性质使特征图保留了原图中像素与像素间的关系。特征图在池化层被降维处理,进入第二个卷积层,然后再次被池化。在保留图像像素间关系的同时对图像数据进行压缩,有最大池化(max pooling)、均值池化(average pooling)和池化(sum pooling)三种方式。

激活层,选择不同的函数对数据进行非性线处理,较为常用的是修正线性单元(ReLU: Rectified Liner Unit)。带有不同过滤器的卷积层实现了对图像的多种操作,例如边缘检测、轮廓检测、模糊化、锐化等等。

全连接层,经过多次卷积与池化后,数据抵达全连接层。通过激励函数(如带损耗的逻辑回归函数)对图像数据进行分类,最终输出结果以概率表示输入图像属于某个类别的可能性大小。

评估时,判断模型是否过度拟合可以通过分别比较训练样本与验证样本的准确率和损失值之间的差值。如果训练与验证阶段的准确率数值差异较大,意味着模型过度拟合;而训练和验证阶段的准确率越低,则意味着图像判别效果未达到令人满意的程度。模型使用二元交叉熵(binary cross entropy)为目标函数,让模型以达到损失值最小化为目标进行更新迭代。因此损失值越小意味着训练出的模型对数据拟合得就越好。在本发明中的训练及验证结果纪录在后台数据库中,测试结果则体现在以下各模型的可视化分析图中。

例如,还可采用MS COCO 数据集。MS COCO数据集由微软团队于2014年发布,共收集了8万多张训练用影像,其中标记了生活上常见的80种对象,例如:猫、狗、飞机、桌子、汽车…等等,并提供了约4万张的测试影像。而在2019年再度更新此数据集,虽然没有新增不同的对象种类,但影像数量则增加至30万张影像。该数据集提供了一个完全开放的内容,透过相同的数据集做为基准,各家提出的演算模型才能有客观的比较依据。

作为一种实施方式,辨识终端还包括文字识别模块:识别图像中的文字,并以语音的形式输出。

视障用户也可以用本发明的文字识别模块,发挥自助的能力,如需要辨认文字例如是信件或者大厦通告他就可以自己一只手拿着手机一只手拿着对象来拍照并且用文字辨识功能便释出文字,文字识别模块也会把已经变色出来的文字转化为声音读及视障用户听。

这些义工支持功能和人工智能文字辨识功能是互补不足的,在辨认简单的在进行简单的文字辨识工作时,视障用户可以自行选择不倚赖义工来解决简单的问题,但对于面形较为复杂的对象或附近的环境视像使用者就需要把照片发送给义工或者透过视像实时功能内乱来联络义工并得到实时的协助。

请参照图3,本发明实施例的视障用户实时辨识方法,包括:

步骤1:辨识终端将采集的视障用户面前的图像实时进行预处理,将预处理结果连续与数字化目标默认值进行对比,当相似度达到阈值时,以语音形式输出;若未比对到相似度达到阈值时或用户选择进入人工模式时,则将当前的图像上传至服务器;

步骤2:服务器将辨识终端上传的图像分配至服务终端,将服务终端上传的识别结果发送至对应的辨识终端;或通过网络实时连接辨识终端和服务终端;

步骤3:对应的志愿者通过服务终端接收辨识终端上传的图像,再将志愿者人工识别结果发送至服务器;或与辨识终端连接,使志愿者与视障用户直接实时通讯,实时为视障用户提供人工帮助。

作为一种实施方式,步骤1中采用卷积神经网络模型对图像进行预处理,所述图像数据依次进入卷积神经网络模型的第一个卷积层、第二个卷积层、池化层、第一个完全连接层以及第二个完全连接层后输出结果。

作为一种实施方式,步骤1还包括:

文字识别子步骤:识别图像中的文字,并以语音的形式输出。

本发明实施例为视障用户提供三种协助方法:(1)视障用户可以拍摄面前的图像,并且本发明将图像的分析结果以语音形式输出以便视障人士理解图像;(2)对于诸如街道环境的复杂情况,视障用户可以拍照并将其发送给一个志愿者,有时间的志愿者可以向用户描述图片;(3)视障用户也可以选择和志愿者以视像方式来联系,有时间的志愿者可以为用户提供实时沟通的视力协助;(4)视障用户可以拍摄面前的图像,本发明识别其中的文字,以语音形式输出以便视障人士识别。

本发明的4个功能是互补的,人工智能文字辨识是直截了当的、不需要志愿者的功能,视障用户可以发挥其自助的能力。而志愿者描述图片和志愿者以视像方式来联系视障用户的功能则更适合复杂的情况。本发明将视障人士与关怀志愿者联系起来,对社会的公益事业做出贡献。本发明使志愿者可以透过声音或文字直接指示视障人士,视障人士也可以更方便的接收文字和图像信息。

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同范围限定。

- 视障用户实时辨识系统及方法

- 辨识用户身分的系统及辨识用户身分的方法