一种基于可微图学习的行人重识别模型的弱监督训练方法

文献发布时间:2023-06-19 09:58:59

技术领域

本发明涉及机器视觉技术领域,更具体地,涉及一种基于可微图学习的行人重识别模型的弱监督训练方法。

背景技术

目前,行人重识别问题主要有三种实现方法:(1)提取判别特征;(2)学习一个稳定的度量或子空间进行匹配;(3)联合上述两种方法。然而,大部分实现方法需要强监督训练标签,即需要人工标注数据集每张图片。此外有不需要人工标注的基于无监督学习的行人重识别方法,使用局部显著性匹配或聚类模型,但很难建模跨摄像机视图的显著差异,因此很难达到高精度。相比之下,本发明提出的弱监督行人重识别方法是一种优秀的训练方法,不需要昂贵的人工标注成本也能达到较高的精度。

弱监督学习:尽管用弱监督方法训练深度神经网络是一个挑战性问题,其已被少量研究用于解决某些任务,如图片分类、语义分割和目标检测。类似这些研究,本发明也基于伪标签的生成,但弱监督行人重识别任务有两个的特点:(1)无法找到每个行人个体的代表性图像,因为人们会在短时间内更换衣服,因此标签不明确;(2)熵比其他任务大,例如弱监督语义分割任务中图像的像素有一定的稳定性,而行人重识别任务中的行人更加无序和不规则。上述两个特点提高了弱监督行人重识别的难度。

不确切标签学习:其中单样本行人重识别与本发明最相关,但有两个不同:(1)单样本行人重识别的每个行人类别都需要至少一张图片实例,而本方法的数据集不需要准确的行人类别标签;(2)本发明引入袋类别标签作为限制引导伪行人类别标签的估计,确保比单样本行人重识别生成更可靠的伪标签。

行人搜索:结合行人检测和行人重识别的过程。本发明与其有两个主要区别:(1)本发明仅关注视觉特征匹配,因为目前的人物检测器的能力足够胜任;(2)本发明得益于代价低廉的弱标注,而行人搜索的每张训练图片依然需要强标注。

申请号为201710487019.7公开了一种使用深度生成机器学习模型的图像质量评分方法,该方法对于对来自医学扫描仪的图像进行图像质量评分,可使用深度机器学习来创建预期好质量图像的生成模型。输入图像离生成模型的偏差被用作对于判别模型的输入特征向量;判别模型还可以对从输入图像导出的另输入特征向量进行操作。基于这些。然而,该专利无法实现直接将图学习表示成一个对网络参数可微的损失函数,使其能用随机梯度下降的方法优化,实现图模型和行人重识别模型的一体训练。

发明内容

本发明提供一种基于可微图学习的行人重识别模型的弱监督训练方法,该方法实现为行人重识别深度神经网络加入自动生成训练标签的模块并与其一体训练,降低了算法复杂程度。

为了达到上述技术效果,本发明的技术方案如下:

一种基于可微图学习的行人重识别模型的弱监督训练方法,包括以下步骤:

S1:将行人图片按拍摄时间段分组成袋并分配袋类别标签;

S2:捕获每一个袋中所有图片之间的依赖关系,来为该类别的袋中每张图片生成可靠的伪行人类别标签,作为行人重识别模型训练的监督信息;

S3:进行行人重识别模型和图模型的一体训练;

S4:将图模型损失和重识别损失的线性组合作为总损失函数,利用反向传播算法更新网络所有层的参数。

进一步地,所述步骤S1的具体过程是:

用b表示包含p张图片的一个袋,即b=x

进一步地,其特征在于,所述步骤S2的过程是:

若弱监督行人重识别只有袋类别标签l可用,需要先为每张图片估计一个伪行人类别标签,用一个概率向量Y表示;假设l类别标签下的袋中包含n个行人类别,整个训练集共有m个行人类别,用袋类别标签限制Y,则每张图片x

进一步地,所述步骤S3的过程是:

定义一个有向图,每个节点代表一个袋中的一张图片x

其中U和V分别表示节点和边,Φ(y

公式(2)中的一元项定义为:

Φ(y

其中P

由于不同图片的一元项输出相互独立,一元项不稳定,需要用成对项平滑:

其中用一个基于RGB颜色的高斯核计算外表相似度,超参数σ控制高斯核的尺寸,限制外表相似的图片有相同的标签;标签兼容度ζ(y

进一步地,袋类别标签含有额外信息改善伪标签的生成:将估计的伪标签纠正为袋中预测分数最高的行人分类;促使部分图片被分配到没有被预测的行人类别;通过最小化公式(2)可以得到每张图片的伪行人类别标签:

其中{1,2,3,…,m}表示训练集中所有的行人类别。

进一步地,步骤S3中,在进行行人重识别模型和图模型的一体训练之前,需要进行图模型可微化,具体过程是:

用一个外部图模型得到伪行人类别标签,用于监督行人重识别深度神经网络的训练,最小化公式(2)得到伪标签的计算是不可微的,使得该图模型与深度神经网络不兼容,因此需要松弛公式(2)为:

将离散的Φ和Ψ连续化:

公式(8)和公式(3)的区别是,在不可微图模型中,需要给能量函数输入所有可能的y,将能量最低的y作为最优解;在可微图模型中,直接将图片x输入深度神经网络得到y的预测;公式(9)和公式(4)的区别是,用交叉熵项-(Y

进一步地,所述步骤S4中,图模型损失L

其中

其中m表示训练集的行人类别数量,总损失函数L是这两个损失函数的线性组合:

L=w

其中w

与现有技术相比,本发明技术方案的有益效果是:

本发明结合可微图学习方法和弱监督学习方法,为行人重识别深度神经网络加入自动生成训练标签的模块并与其一体训练,相比普通的行人重识别方法,该方法不需要繁重的人工标注成本、几乎不增加计算复杂度也能达到领先的模型性能。

附图说明

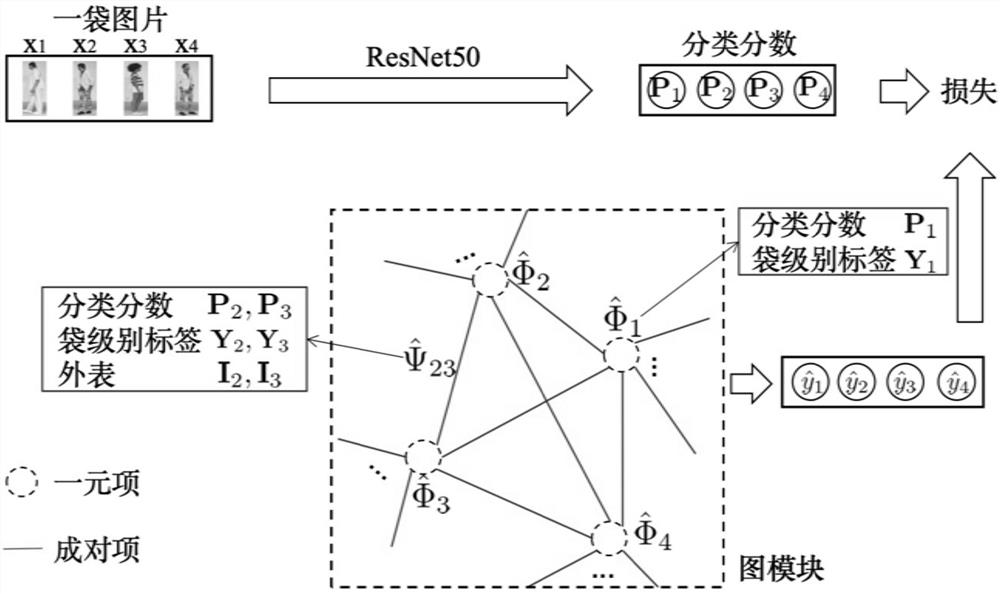

图1为一袋图片生成伪行人类别标签的图模型;

图2本发明的训练流程图。

具体实施方式

附图仅用于示例性说明,不能理解为对本专利的限制;

为了更好说明本实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;

对于本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

下面结合附图和实施例对本发明的技术方案做进一步的说明。

一种基于可微图学习的行人重识别模型的弱监督训练方法,包括以下步骤:

1.从有监督行人重识别到弱监督行人重识别

用b表示包含p张图片的一个袋,即b=x

2.基于可微图学习的弱监督行人重识别

图模型行人重识别

如图1所示,定义一个有向图,每个节点代表一个袋中的一张图片x

其中U和V分别表示节点和边,Φ(y

一元项

公式(2)中的一元项定义为:

Φ(y

其中P

成对项

由于不同图片的一元项输出相互独立,一元项不稳定,需要用成对项平滑:

其中用一个基于RGB颜色的高斯核计算外表相似度,超参数σ控制高斯核的尺寸,限制外表相似的图片有相同的标签;标签兼容度ζ(y

袋限制

实际上,袋类别标签含有额外信息改善伪标签的生成:将估计的伪标签纠正为袋中预测分数最高的行人分类;促使部分图片被分配到没有被预测的行人类别。

伪行人类别标签的推理

通过最小化公式(2)可以得到每张图片的伪行人类别标签:

其中{1,2,3,…,m}表示训练集中所有的行人类别。

图学习可微化

上述弱监督行人重识方法不是一体训练的,因为首先需要用一个外部图模型得到伪行人类别标签,用于监督行人重识别深度神经网络的训练。最小化公式(2)得到伪标签的计算是不可微的,使得该图模型与深度神经网络不兼容,因此需要松弛公式(2)为:

将离散的Φ和Ψ连续化:

公式(8)和公式(3)的区别是,在不可微图模型中,需要给能量函数输入所有可能的y,将能量最低的y作为最优解;在可微图模型中,直接将图片x输入深度神经网络得到y的预测。公式(9)和公式(4)的区别是,用交叉熵项-(Y

3.整体神经网络结构

图2为训练和推理的网络结构,虚线表示训练数据流,实线表示推理数据流,其中图模型只参与训练阶段。整体结构包含三个主要模块:

特征提取模块

如图2(a),运用ResNet-50作为骨干网络,去掉原始ResNet-50的最后一层,换成一个输出为512维的全连接层、一个批规范化、一个带泄露线性整流函数和一个dropout。

粗糙行人重识别模块

如图2(b),在特征提取模块的顶部再加一个输出维度与行人类别数量相同的全连接层,再使用归一化指数交叉熵作为损失函数。行人类别预测分数

精炼行人重识别模块

如图2(c),按照公式(8)和(9)将粗糙行人重识别分数、外表和袋限制输入图模型,图模型生成的伪标签就能像人工标注的真实标签一样被用来更新网络参数。

4.优化

得到伪行人类别标签就能计算整体损失值对于深度神经网络参数的梯度,利用反向传播算法,将梯度回传给网络的所有层,实现该弱监督模型的所有参数的一体训练。

损失函数

本方法的优化目标包含图模型损失L

其中

其中m表示训练集的行人类别数量。

总损失函数L是这两个损失函数的线性组合:

L=w

其中w

相同或相似的标号对应相同或相似的部件;

附图中描述位置关系的用于仅用于示例性说明,不能理解为对本专利的限制;

显然,本发明的上述实施例仅仅是为清楚地说明本发明所作的举例,而并非是对本发明的实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明权利要求的保护范围之内。

- 一种基于可微图学习的行人重识别模型的弱监督训练方法

- 一种基于主动学习的行人重识别模型训练方法及装置