一种文本生成方法、装置及存储介质

文献发布时间:2023-06-19 10:29:05

技术领域

本发明主要涉及语言处理技术领域,具体涉及一种文本生成方法、装置及存储介质。

背景技术

数据到文本生成是自然语言生成中的一项重要且富有挑战的任务,旨在从非语言输入转换成文本输出,可以应用于现实中许多的自然语言生成场景,例如根据数据自动编写体育赛事报道、天气预报等方面。但现有的编码-解码生成模型在生成文本的过程中存在着生成的文本精确率不高且存在冗余的问题。

发明内容

本发明所要解决的技术问题是针对现有技术的不足,提供一种文本生成方法、装置及存储介质。

本发明解决上述技术问题的技术方案如下:一种文本生成方法,包括如下步骤:

导入多个数据集,并分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量;

构建训练模型,根据多个所述数据集嵌入向量和多个所述数据集对所述训练模型进行参数更新,得到更新后的训练模型;

根据所述更新后的训练模型对待训练文本进行训练,得到生成文本。

本发明解决上述技术问题的另一技术方案如下:一种文本生成装置,包括:

拼接计算模块,用于导入多个数据集,并用于分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量;

参数更新模块,用于构建训练模型,根据多个所述数据集嵌入向量和多个所述数据集对所述训练模型进行参数更新,得到更新后的训练模型;

生成文本获得模块,用于根据所述更新后的训练模型对待训练文本进行训练,得到生成文本。

本发明的有益效果是:通过分别对各个数据集的拼接计算得到与各个数据集对应的数据集嵌入向量,根据多个数据集嵌入向量和多个数据集对训练模型的参数更新得到更新后的训练模型,根据更新后的训练模型对待训练文本的训练得到生成文本,本发明能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

附图说明

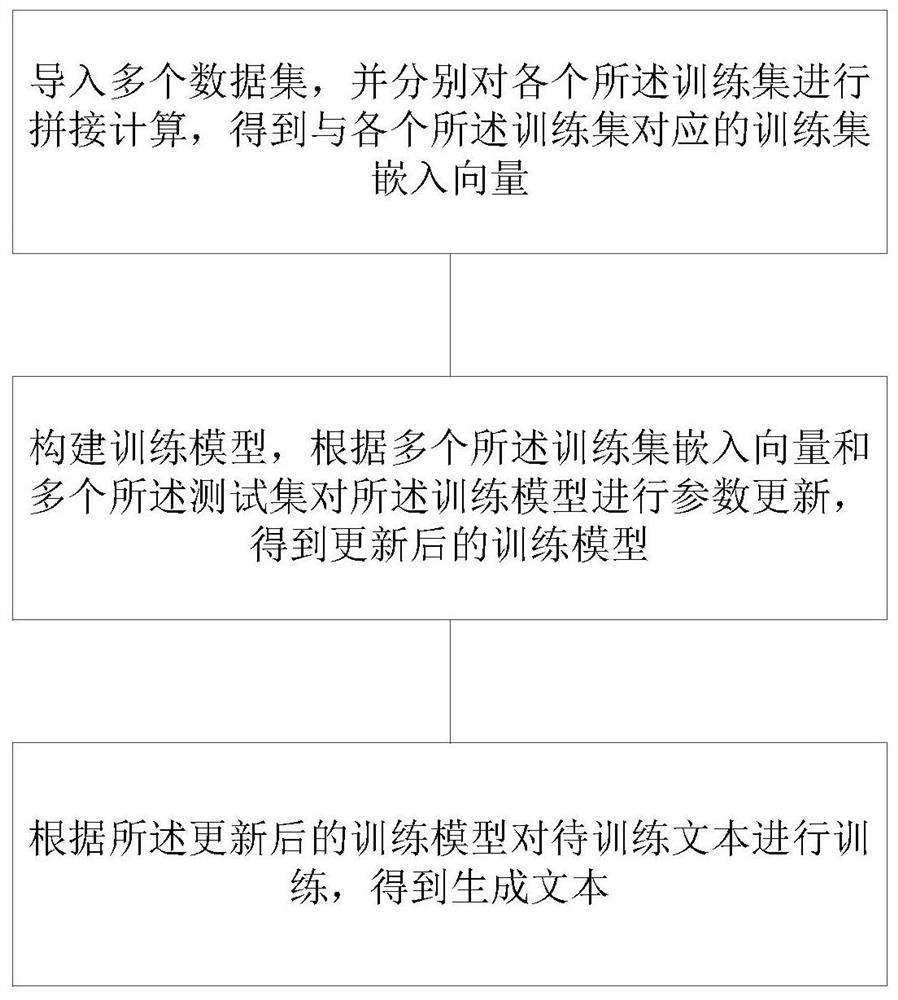

图1为本发明实施例提供的文本生成方法的流程示意图;

图2为本发明实施例提供的文本生成装置的模块框图。

具体实施方式

以下结合附图对本发明的原理和特征进行描述,所举实例只用于解释本发明,并非用于限定本发明的范围。

图1为本发明实施例提供的文本生成方法的流程示意图。

如图1所示,一种文本生成方法,包括如下步骤:

导入多个数据集,并分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量;

构建训练模型,根据多个所述数据集嵌入向量和多个所述数据集对所述训练模型进行参数更新,得到更新后的训练模型;

根据所述更新后的训练模型对待训练文本进行训练,得到生成文本。

应理解地,所述数据集可以为事件记录表。

上述实施例中,通过分别对各个数据集的拼接计算得到与各个数据集对应的数据集嵌入向量,根据多个数据集嵌入向量和多个数据集对训练模型的参数更新得到更新后的训练模型,根据更新后的训练模型对待训练文本的训练得到生成文本,本发明能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量的过程包括:

通过第一式分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量,所述第一式为:

r

其中,r

应理解地,所述数据集中的数据可以为记录中的各类属性。

应理解地,将所述数据集中的所有数据通过嵌入的方法并拼接,得到记录的嵌入表示,即所述数据集嵌入向量。

上述实施例中,通过第一式分别对各个数据集的拼接计算得到与各个数据集对应的数据集嵌入向量,为后续处理过程提供数据支撑,能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述构建训练模型,根据多个所述数据集嵌入向量和多个所述数据集对所述训练模型进行参数更新,得到更新后的训练模型的过程包括:

基于OpenNMT-py编解码模型构建训练模型,所述训练模型包括编码层和解码层;

分别将各个所述数据集嵌入向量输入至所述编码层中,通过所述编码层分别对各个所述数据集嵌入向量进行编码分析,得到多个数据集更新向量;

将多个所述数据集更新向量输入至所述解码层中,通过所述解码层对多个所述数据集更新向量进行最终文本的计算,得到最终文本和多个文本原始概率;

根据所述最终文本对多个所述文本原始概率进行损失计算,得到更新损失函数;

根据所述更新损失函数对所述训练模型进行训练,得到更新后的训练模型。

应理解地,OpenNMT-py是OpenNMT的Pytorch版本,广泛的用于机器翻译,自动摘要,文本生成,语言形态学和许多其他领域。OpenNMT-py是一个编码-解码框架,其内部定义好了编码解码路线和损失反馈方法,用户只需指定需要的编码器和解码器和损失计算方法,即可开始训练自己的模型。

上述实施例中,构建训练模型,根据多个数据集嵌入向量和多个数据集对训练模型的参数更新得到更新后的训练模型,能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述通过所述编码层分别对各个所述数据集嵌入向量进行编码分析,得到多个数据集更新向量的过程包括:

分别将各个所述数据集嵌入向量输入至隐藏层中,通过所述预建隐藏层分别对各个所述数据集嵌入向量进行编码处理,得到多个数据集编码向量和与所述数据集编码向量对应的隐藏层输出向量;

分别对各个所述数据集编码向量和与所述数据集编码向量对应的隐藏层输出向量进行内容筛选的计算,得到多个数据集更新向量。

上述实施例中,通过编码层分别对各个数据集嵌入向量的编码分析得到多个数据集更新向量,能够过滤次要信息,准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述分别将各个所述数据集嵌入向量输入至隐藏层中,通过所述预建隐藏层分别对各个所述数据集嵌入向量进行编码处理,得到多个数据集编码向量和与所述数据集编码向量对应的隐藏层输出向量的过程包括:

通过第二式分别对各个所述数据集嵌入向量进行均值池化编码,得到多个数据集编码向量,所述第二式为:

其中,r

分别对各个所述数据集嵌入向量进行隐藏信息提取,得到与所述数据集编码向量对应的隐藏层输出向量。

应理解地,对记录的嵌入表示进行均值池化编码,得到记录的向量表示,即所述数据集编码向量。

上述实施例中,通过第二式分别对各个数据集嵌入向量的均值池化编码得到多个数据集编码向量,分别对各个数据集嵌入向量的隐藏信息提取得到与数据集编码向量对应的隐藏层输出向量,能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述分别对多个所述数据集编码向量和与所述数据集编码向量对应的隐藏层输出向量进行内容筛选的计算,得到多个数据集更新向量的过程包括:

通过第三式分别对多个所述数据集编码向量和与所述数据集编码向量对应的隐藏层输出向量进行内容筛选的计算,得到多个数据集更新向量,所述第三式为:

其中,

其中,h

应理解地,对编码层记录向量即所述数据集编码向量进行内容筛选,过滤记录中的次要信息,更新记录的向量表示即所述数据集更新向量。

上述实施例中,通过第三式分别对多个数据集编码向量和与数据集编码向量对应的隐藏层输出向量的内容筛选计算得到多个数据集更新向量,能够过滤次要信息,准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述通过所述解码层对多个所述数据集更新向量进行最终文本的计算,得到最终文本和多个文本原始概率的过程包括:

对多个所述数据集更新向量进行内容向量的计算,得到内容向量;

通过第四式分别对所述内容向量和各个所述数据集进行计算,得到多个文本原始概率,所述第四式为:

其中,r为数据集,y

通过第五式对多个所述文本原始概率进行计算,得到最终文本,所述第五式为:

其中,p(y′|r)为文本原始概率,

应理解地,所述文本原始概率用于根据所述内容向量和所述数据集从而获得正确文本的概率。

具体地,计算在输入所述数据集r下,输出文本y

其中p(y

应理解地,选择出概率最大的所述文本原始概率作为我们的生成的所述最终文本,如下式:

其中y′表示从文本原始概率对应的输出文本。

上述实施例中,通过解码层对多个数据集更新向量的最终文本的计算得到最终文本和多个文本原始概率,能够过滤次要信息,准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述对多个所述数据集更新向量进行内容向量的计算,得到内容向量的过程包括:

利用LSTM解码器对多个所述数据集更新向量进行内容向量的计算,得到内容向量,具体为:

通过第六式对多个所述数据集更新向量进行计算,得到内容向量,所述第六式为:

其中,q

其中,

其中,d

应理解地,所述内容向量用于生成一段连贯文本前的所有内容。

应理解地,解码端通过注意力机制抓取记录中最重要的信息参与文本生成。

具体地,使用LSTM解码器基于所述数据集更新向量e

设d

上述实施例中,通过第四式对多个数据集更新向量的内容向量计算得到内容向量,抓取了最重要的信息参与文本生成过程,能准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

可选地,作为本发明的一个实施例,所述根据所述最终文本对多个所述文本原始概率进行损失计算,得到更新损失函数的过程包括:

通过第七式对所述最终文本和多个所述文本原始概率进行计算,得到更新损失函数,所述第七式为:

L=L

其中,

其中,L为更新损失函数,L

应理解地,计算解码输出的所述最终文本与所给标准文本之间的文本相似度,进行损失分析,更新迭代,最终生成优质文本。

具体地,首先计算负对数似然损失函数L

其中,G为数据集总数,D为数据集r与输出文本y的集合,p(y|r)是指在以数据集r为条件下输出文本y

其次计算生成内容与真实值之间的余弦距离L

L

其中V

最后将两个损失函数融合,如下式:

其中λ是L

上述实施例中,通过第七式对最终文本和多个文本原始概率的计算得到更新损失函数,能够进行更新迭代,准确选出记录中的重要内容生成文本,并通过文本相似度进行更新迭代,优化文本生成质量,相对现有技术,能够体提升生成文本的准确性和流畅性,解决了生成的文本精确率不高且存在冗余的问题。

图2为本发明实施例提供的文本生成装置的模块框图。

可选地,作为本发明的另一个实施例,如图2所示,一种文本生成装置,包括:

拼接计算模块,用于导入多个数据集,并用于分别对各个所述数据集进行拼接计算,得到与各个所述数据集对应的数据集嵌入向量;

参数更新模块,用于构建训练模型,根据多个所述数据集嵌入向量和多个所述数据集对所述训练模型进行参数更新,得到更新后的训练模型;

生成文本获得模块,用于根据所述更新后的训练模型对待训练文本进行训练,得到生成文本。

可选地,本发明的另一个实施例提供一种文本生成装置,包括存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,当所述处理器执行所述计算机程序时,实现如上所述的文本生成方法。该装置可为计算机等装置。

可选地,本发明的另一个实施例提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,当所述计算机程序被处理器执行时,实现如上所述的文本生成方法。

所属领域的技术人员可以清楚地了解到,为了描述的方便和简洁,上述描述的装置和单元的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

在本申请所提供的几个实施例中,应该理解到,所揭露的装置和方法,可以通过其它的方式实现。例如,以上所描述的装置实施例仅仅是示意性的,例如,单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。

作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本发明实施例方案的目的。

另外,在本发明各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以是两个或两个以上单元集成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。用于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分,或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本发明各个实施例方法的全部或部分步骤。而前述的存储介质包括:U盘、移动硬盘、只读存储器(ROM,Read-Only Memory)、随机存取存储器(RAM,Random Access Memory)、磁碟或者光盘等各种可以存储程序代码的介质。

以上,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到各种等效的修改或替换,这些修改或替换都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。

- 文本生成方法、文本生成装置、电子设备及存储介质

- 文本生成方法、文本生成装置及计算机可读存储介质