一种基于特征分离和对齐的域自适应无监督目标检测方法

文献发布时间:2023-06-19 10:11:51

技术领域

本发明属于深度学习和目标检测技术领域,特别涉及一种基于特征分离和对齐的域自适应无监督目标检测方法。

背景技术

目标检测是计算机视觉的一个基本问题,它的任务是找出图像上的感兴趣目标,确定它们的位置和类别。在深度卷积网络的推动下,许多基于深度学习的方法被提出来,使得目标检测模型在一些基准自然图像数据集上有很好的性能;但在真实环境中,由于目标的风格、背景等差异,测试集与训练集存在着巨大的领域分布差异,会导致模型在新的领域的泛化能力显著降低。同时,在一些新的领域,如艺术图像等,现有的公开数据集较少,不足以充分训练一个深度目标检测模型。如何提高真实场景和新领域的目标检测模型成为新的挑战,若重新标注新数据集,会耗费大量的人力物力,导致模型成本较高,尤其是目标检测或者分割问题。因此许多无监督域自适应目标检测方法被提出来,用于解决数据分布偏移问题。大多数无监督域自适应目标检测方法是在先进的目标检测框架上,如Faster R-CNN,嵌套对抗训练模块,通过最小化不同层次上的特征图的领域差异,实现源域和目标域的高维特征图分布的对齐,以提高模型在目标域上的泛化能力;例如,图像和实例水平上的对齐(image-level instance-level alignment),强局部和弱全局(Strong-Local&Weak-Global)对齐和局部区域(Local-Region)对齐,上下文感知的实例(Context-AwareInstance-Level)对齐。此外,某些方法还会利用风格迁移方法,如Cycle-GAN,实现像素级别的对齐(pixel-level alignment via style transfer or CycleGAN)。它们提出了域自适应目标检测需要关注图像级别,实例级别,像素级别和局部区域级别的对齐。

上述公开的方法只关注了源域和目标域的映射,并没有充分考虑其它不需要对齐的差异化信息,如背景信息等;在该问题上,应找到图像上需要对齐的目标所在区域,忽略其它与检测无关的背景信息。然而,现有的区域对齐方法存在缺陷,其并没有考虑到图像的目标区域个数不一致问题;其次,对于实例级别,由于目标域数据不存在标签,难以从目标域图像中提取出需要对齐的目标区域特征,候选区域提议网络得到的候选区域可能存在冗余,此外还可能受到背景的影响,以至模型性能不理想。

发明内容

本发明的目的在于提供一种基于特征分离和对齐的域自适应无监督目标检测方法,以解决上述存在的一个或多个技术问题。

为达到上述目的,本发明采用以下技术方案:

本发明的一种基于特征分离和对齐的域自适应无监督目标检测方法,包括以下步骤:

将成对的源域和目标域RGB样本输入到两阶段的目标检测框架中,通过源域的标签计算检测损失,训练目标检测框架,获得学习好的目标检测模型;基于所述学习好的目标检测模型完成目标检测;

其中,在训练过程中,通过目标检测框架中的特征提取网络得到多级别的高维特征,并将多级别的高维特征进行对齐;通过目标检测框架中的区域提议网络,得到候选区域的预测边界框,对得到的预测边界框进行聚类实现区域分组,对每组的区域实例特征进行对齐;

其中,在训练过程中,将所述成对的源域和目标域RGB样本灰度化并进行特征分离,分离出与检测有关的高维特征及与检测无关的扰乱特征;将分离出的两特征合并,进行图像重构,得到源域和目标域的重构灰度图像,使得分离出的特征不偏移原图像本身。

本发明的进一步改进在于,所述将所述成对的源域和目标域RGB样本灰度化并进行特征分离,分离出与检测有关的高维特征及与检测无关的扰乱特征;将分离出的两特征合并,进行图像重构,得到源域和目标域的重构灰度图像,使得分离出的特征不偏移原图像本身的步骤具体包括:

将灰度化后的源域和目标域样本,分别输入到私有编码器E

将两域的高维特征与目标检测框架的特征提取网络得到的高维特征合并,得到两域的融合特征;

将两域的融合特征输入到共享解码器S

本发明的进一步改进在于,所述将灰度化后的源域和目标域样本,分别输入到私有编码器E

其中,

本发明的进一步改进在于,将两域的融合特征输入到共享解码器S

其中,

本发明的进一步改进在于,通过目标检测框架中的区域提议网络,得到候选区域的预测边界框,对得到的预测边界框的中心坐标进行聚类实现区域分组,对每组的区域实例特征进行对齐的步骤具体包括:

通过目标检测框架的区域提议网络,得到候选区域的实例特征和其对应的预测边界框;将预测边界框的中心坐标输入到尺度空间滤波聚类,实现区域分组;

将每组的候选区域对应的上下文感应的实例特征进行精炼,得到精炼的实例特征,并将其输入到域分类器中,输出域标签,实现区域实例特征对齐。

本发明的进一步改进在于,将预测边界框的中心坐标输入到尺度空间滤波聚类,实现区域分组的步骤具体包括:

利用尺度空间滤波计算出来的生命周期“Lifetime”,确定聚类个数和每一类的聚类中心,得到合理区域;通过合理区域去除异常候选区域;通过聚类中心得到每一组的候选区域。

本发明的进一步改进在于,通过源域的标签计算检测损失,训练目标检测框架时的总体目标函数为:

式中,

其中,F,E,S,D分别为目标检测框架、私有编码器、共享解码器以及域分类器,D

本发明的进一步改进在于,所述两阶段的目标检测框架为Faster R-CNN目标检测框架、Mask R-CNN目标检测框架、RetinaNet目标检测框架。

与现有技术相比,本发明具有以下有益效果:

本发明提供了一种基于特征分离和对齐的无监督域自适应目标检测方法,可有效地解决域自适应目标检测中背景信息噪声和候选区域冗余问题,能够提高模型的可迁移性和自适应性,在多个基准数据上获得了很好的效果,其水平达到业界最高水平。具体地,本发明采用了灰度特征分离,能够充分分解出与目标检测无关的扰乱信息,提高特征对齐模块的性能;使用灰度图像进行特征分离,让网络分离的信息更接近于目标特征,而不是色彩信息上,同时降低了重构图像的难度,让网络能更关注于目标检测上。本发明通过局部实例对齐,解决了候选区域冗余和背景噪声问题,提高了实例对齐的有效性。

进一步地,在局部实例对齐中,本发明提供了一种自适应区域搜索的实例对齐方法,通过尺度空间滤波聚类,可以自适应地获取图像上需要特征对齐的目标区域,避免了其它区域实例对齐方法需要手动设定区域个数的问题,提高了区域搜索的准确性。

进一步地,在获取目标区域后,本发明采用全局池化方法,对同一类别的区域特征进行精炼,降低了候选区域冗余问题的负面影响。

附图说明

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面对实施例或现有技术描述中所需要使用的附图做简单的介绍;显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来说,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

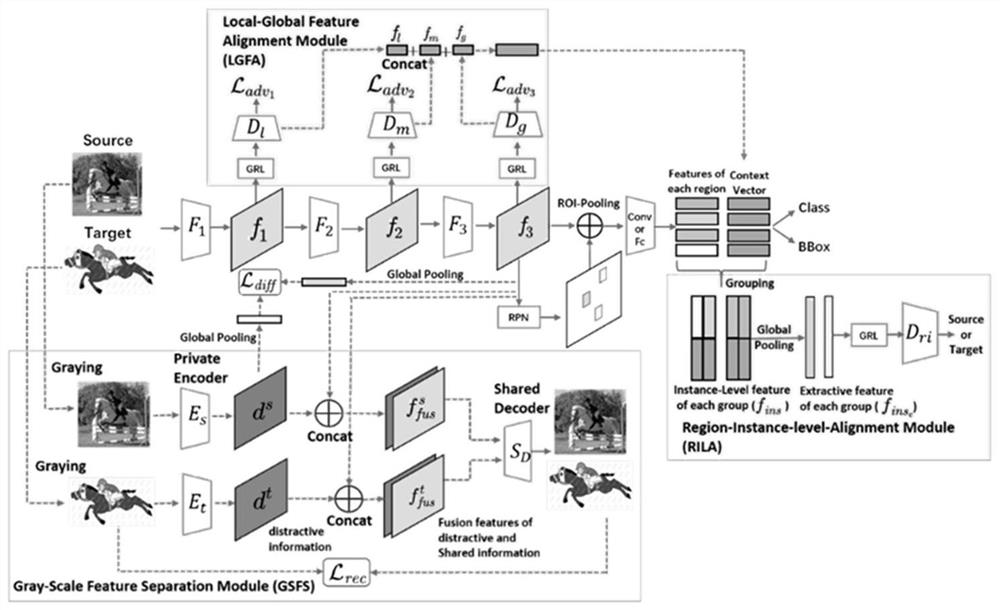

图1是本发明实施例的一种基于特征分离和对齐的域自适应无监督目标检测方法的网络框架示意图;

图2是本发明实施例中,区域实例对齐模块的实现示意图;

图3是本发明实施例中,目标检测框架的骨干网络使用ResNet-101时的灰度特征分离模块网络结构示意图;

图4是本发明实施例中,目标检测框架的骨干网络使用VGG-16时的灰度特征分离模块网络结构示意图;

图5是本发明实施例中,域分类器D

具体实施方式

为使本发明实施例的目的、技术效果及技术方案更加清楚,下面结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述;显然,所描述的实施例是本发明一部分实施例。基于本发明公开的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所获得的其它实施例,都应属于本发明保护的范围。

请参阅图1,本发明实施例的一种基于特征分离和对齐的域自适应无监督目标检测系统,包括:两阶段目标检测框架、灰度特征分离网络GSFS、局部全局特征对齐模块LGFA、区域实例对齐模块RILA;其中,两阶段目标检测框架包括:区域提议网络、检测网络;其具体的技术实现包含以下步骤:

将成对的源域和目标域RGB样本输入到目标检测框架中,通过源域的标签计算检测损失,训练目标检测框架;训练过程中,通过目标检测框架的特征提取网络F

本发明一实施例中,为了简便,将有标签数据的源域数据集记为

本发明一实施例的灰度特征分离网络中,通过私有编码器E

本发明利用局部全局特征模块的对齐损失和目标检测模块损失,使得特征提取网络提取与目标检测相有用的公有信息。而E

本发明一实施例中,为了更好的完成特征分离,使用了差异化损失,限制特征提取器和私有编码器的高维特征,进而分离出与目标检测无关的差异化信息,其定义为:

其中,

本发明实施例中,通过图像重构,可以让网络提取的特征,不偏离图像本身,更好地指导私有编码器提取差异化信息。灰度图像的重构损失函数采用l

其中,

本发明一实施例中,局域实例对齐模块由分组组件(Grouping)和基于上下文感知的区域实例对齐(Context-Aware RILA)组件组成。

其中,通过目标检测框架的区域提议网络,得到候选区域的实例特征和其对应的预测边界框。将预测边界框的中心坐标输入到尺度空间滤波聚类,实现区域分组。这里,利用尺度空间滤波计算出来的生命周期“Lifetime”,确定聚类个数和每一类的聚类中心,同时得到合理区域。通过合理区域,可以去除异常候选区域,并通过聚类中心,得到每一组的候选区域;将每组的候选区域对应的上下文感应的实例特征进行精炼,得到精炼的实例特征,并将其输入到域分类器D_ri中,输出域标签,从而实现区域实例特征对齐。

分组模块中,源域上存在标签而目标域上不存在,RPN的优化主要由源域的标签数据指导,无法确保在目标域上的候选区域含有目标,其很有可能包含大量背景噪声。此外,一个目标一般会被多个候选区域检测到,意味着某些候选区域是冗余的。应该对最有可能存在目标的候选区域对应的实例特征进行特征对齐,而不是对所有特征。很自然的想法是将候选区域进行分类,将含有同一类别的候选区域分到一起。一个可靠的模型预测的包含同一个目标的候选区域在图中的位置应该是相近的,因此可以利用其位置信息将疑似含有同一目标的候选区域聚类。

本发明优选的,使用RPN得到候选区的预测边界框

其中,基于尺度空间滤波算法的自适应区域搜索在本发明的实现步骤包括:

(1)聚类中心迭代:SSF是一个自适应聚类类别数目的聚类方法,并不需要设置聚类个数K,因此非常适合解决分组模块中目标域不存在无标签的问题。因此本发明选用SSF算法用于分组模块的聚类操作,而不是使用传统的聚类方法,如K-Means。通过RPN,可以得到N个预测边界框的中心点坐标集。然后通过SSF算法,将其聚类,直至聚成一类为止。

(2)自适应区域个数选择:根据SSF算法定义的聚类生命周期“Lifetime”,选择出最优的聚类个数K,以及其对应的聚类中心

(3)移除异常值:对于每一个边界框的中心坐标b

基于上下文感知的区域实例对齐模块中,将候选区域分类后,需要提炼每一类的实例特征,用于实例对齐。最简单的,可以将分为同一类的实例特征重构成一个特征图,作为域分类器的输入,但这并没有从根本上解决冗余的或噪声的候选区域影响。因此,本发明使用全局池化的方法,精炼同一类别下的实例特征。假设尺度空间滤波得到的第k类的实例特征为

其中,

本发明一实施例的局部全局特征对齐模块中,采用HTCN网络的Local FeatureMasks和IWAT-I框架,其对应的损失函数

而目标检测的损失包括源域上的分类损失L

综上,本发明的总体目标函数为:

其中,β和λ用于权衡检测损失,对抗损失和重构损失。梯度符号通过梯度反转层进行翻转。

本发明以Faster R-CNN框架,提出了基于特征分离和对齐的无监督域自适应目标检测系统(FSANet),系统网络包括特征分离网络、局部全局特征对齐模块和区域实例对齐模块。其中,特征分离网络通过差异化损失,分离出不需要对齐的差异化信息和与目标检测相关的信息,能够让特征对齐模块可以更加关注于目标区域信息。局部全局特征对齐和区域实例对齐为领域自适应模块,它们通过减少多个级别上高维特征的分布差异来减少领域偏移。具体地,本发明将贡献分为以下几点:

(1)在本发明的网络框架中,设计了基于自编码器的灰度特征分离双流网络,它通过私有编码器分离图像的差异信息,而目标检测框架作为共享权值的公有信息提取器,提取对检测有用的公有信息;该结构有效地分离源域和目标域的公有信息和差异信息。在高维特征对齐时,本发明使用目标检测的网络框架中提取的公有信息,可降低与检测无关的差异化信息影响,以提升领域适应性和迁移性。为了降低不同图像的色彩差异和重构难度的影响,本发明利用灰度化图像提取领域的差异化特征,可以使得私有编码器在提取差异化信息时更关注于目标的其它信息而不是图像色彩,也能简化重构任务,让模型更加关注于目标检测。

(2)结合区域对齐和实例对齐方法,本发明设计了区域实例对齐模块,其能够有效地解决因候选区域的冗余和背景产生的负面影响问题;该模块是借助聚类算法,将RPN得到的候选区域利用分组,然后提取每组的特征向量,最后通过梯度反向层和域分类器进行实例级别的特征对齐。

(3)考虑到图像目标个数的不确定性和背景的影响,本发明采用尺度空间滤波聚类,而不是K-Means聚类。通过区域实例对齐模块,本发明实现了在不同图像中,自适应地提取不同个数的目标区域,解决因使用K-Means聚类而固定目标区域个数的问题。

(4)在聚类时,本发明进行了异常值判断,减少疑似背景的候选区域特征的影响。

请参阅图1,本发明实施例的网络框架除Faster R-CNN目标检测框架外,包含了局部全局特征对齐模块(LGFA),灰度特征分离模块(GSFS)和区域实例对齐模块(RILA)三个自适应组件。训练过程包括以下步骤:

步骤1:训练时,成对的RGB图像(一张源域图像和一张目标域图像)输入到目标检测框架,并通过LGFA模块的梯度反转层GRL和域分类器(D

步骤2:将融合特征输入到区域实例对齐模块RILA模块,实现检测和区域实例特征对齐。其中,RILA模块的实现流程如图2所示。首先,本发明利用RPN得到的预测边界框的中心坐标,进行尺度空间滤波聚类,并通过“Lifetime”,选择出“Lifetime”最长的聚类个数,实现自适应目标区域选择。其次,根据合理区域,移除异常值。最后将每个区域类别的融合实例特征f

步骤3:与此同时,输入样本的灰度化图像输入到灰度特征分离模块GSFS中,通过双流网络,分离出对检测无用的扰乱特征。首先,将RGB图像通过加权平均法,转化为灰度图像,其计算公式如下:

G=0.299R+0.578G+0.114B,

其中,R,G,B分别为RGB三通道上的值。然后,将源域和目标域的灰度化样本分别输入到私有编码器E

联合上述三个步骤,可以对网络进行训练,得到一个域自适应的目标检测模型。特别地,测试时,只需要将测试图像输入到目标检测框架中,这与Faster R-CNN的测试过程一致。

为了验证本发明方法的有效性,进行如下仿真实验。

本发明在真实场景到艺术场景,正常场景到雾噪声两组域自适应目标检测实验,说明发明方法的有效性。其中,真实场景到艺术场景使用PASCAL—>Clipart1k数据集。PASCAL VOC数据集作为真实场景下的源域,Clipart1k作为艺术场景下的目标域。PASCAL数据集包含有20个类别以及它们的边界框。在这组实验中,PASCAL VOC 2007和2012的训练集和测试集分割被用于训练,大约有15K张图像。而Clipart1k数据集共有1K张图像,且目标类别与PASCAL相同,其所有图像被用于训练(不包含目标)以及测试。而正常场景到雾噪声使用Cityscape—>Foggy-Cityscapes。Cityscape作为正常场景源域,Foggy-Cityscapes作为雾噪声目标域。Cityscapes数据集包含了由车载摄像机拍摄的不同城市在正常天气条件下的街道场景,共有2975张训练集图像,500张测试集图像。它的标签数据根据DA-Faster的方法获取。而Foggy-Cityscapes是在Cityscape图像上添加雾噪声获取,其标签数据与Cityscape相同。该实验将Cityscape和Foggy-Cityscapes的训练集数据用于训练,Foggy-Cityscapes的测试集数据用于测试。

实验细节:在所有实验中,与现阶段先进方法的设置保持基本一致,目标检测模型采用基于ROI-Align的Faster R-CNN,其输入图像的最短边设置为600。对于PASCAL—>Clipart1k实验,骨干网络选用ResNet-101,而Cityscape—>Foggy-Cityscapes选用VGG-16,骨干网络的权值初始化采用ImageNet的预训练权重。优化方法使用随机梯度下降SGD,其动量参数设置为0.9,初始化学习率设置为0.001,迭代训练50K次后,衰减为0.0001。训练70K次后,计算在IoU阈值为0.5下的测试集平均精度mAP。另外总体目标函数中的λ设置为1,β设置为0.1,Focal Loss的γ设置为5.0。所有实验基于Pytorch设计的。使用的训练硬件平台为:Intel CPU i7-9700,内存为32GB,显卡为NVIDIA GTX-1080Ti。

表1和表2分别列出了现有先进方法和本发明方法的结果对比,其中Source Only为只使用源域数据集训练的Faster R-CNN的结果,其它先进方法引用其原文上的实验结果。可以看到,本发明结果能有效地提高基于对抗式的域自适应无监督目标检测方法的精度,在这两组实验中,mAP均有提升,其中PASCAL—>Clipart1k实验的目标域测试集mAP达42.7%,提升了0.6%(从42.1%到42.7%),而Cityscape—>Foggy-Cityscapes的目标域测试集mAP达40.0%,接近上界,这充分说明本发明能够提升域自适应目标检测的可迁移性和自适应性。

表1域自适应实验PASCAL—>Clipart1k的实验结果

表2域自适应实验Cityscape—>Foggy-Cityscapes的实验结果

以上实施例仅用以说明本发明的技术方案而非对其限制,尽管参照上述实施例对本发明进行了详细的说明,所属领域的普通技术人员依然可以对本发明的具体实施方式进行修改或者等同替换,这些未脱离本发明精神和范围的任何修改或者等同替换,均在申请待批的本发明的权利要求保护范围之内。

- 一种基于特征分离和对齐的域自适应无监督目标检测方法

- 基于加权最优传输的无监督域自适应视觉目标检测方法、系统及存储介质