基于知识蒸馏的营销活动预测模型结构和预测方法

文献发布时间:2023-06-19 11:26:00

技术领域

本发明涉及人工智能在互联网营销的技术领域,更具体地,涉及一种基基于知识蒸馏的营销活动预测模型结构和预测方法。

背景技术

随着深度学习算法的快速发展以及在许多领域的成功应用,例如,计算机视觉(Computer Vision,简称CV)领域中使用残差神经网络(ResNet)较好地解决了训练过程中的梯度消失问题,自然语言处理(Natural Language Processing,简称NLP)领域中Transformer模型以及Bert模型实现了对文本数据的超强处理能力等。上述革命性的技术使得深度学习算法在不同领域的应用效果快速提升,也加快了其落地。然而,随着训练数据的增大,网络模型越来越复杂,参数也呈现快速增长的趋势,甚至达到了上亿级别。

以计算广告和推荐系统算法为例,在其实际应用中存在着如下的问题:

①、计算广告和推荐系统实际面临的业务量往往会非常大,并且推荐系统往往需要具有较强的时效性。这意味着,深度学习模型做线下的测试虽然可以依赖于硬件(如GPU加速)等,但对于线上的部署,若深度学习模型过于复杂、参数过多,则会造成模型的相应速度过慢,尤其是针对具体业务场景当流量大的时候,则会无法满足及时推送的需求。

②、在一般情况下,不会刻意区分线下训练模型和线上的部署模型,即一般直接将线下训练效果较好的模型直接移至线上进行相应的部署;然而,本领域技术人员清楚,训练模型和部署模型之间存在着一些不一致性。例如:在训练中得到的效果好的模型要么规模复杂,要么通过集成学习(ensemble learning)的思想,只能由多个相对简单的模型集成实现。在计算广告和推荐算法领域,这些简单模型包括了逻辑回归(logistic regression,简称LR)、因式分解机(factorization machine,简称FM))和简单的深度神经网络(deep-learning neural network,简称DNN)等。再加上,大模型对部署资源要求高(内存和显存等);同时,在部署时我们对延迟以及计算资源都有着严格的限制;因此,大模型一般不方便直接部署到服务中去。

③、推荐系统在实际线上工作时,可能会面临着特征等数据结构的调整和改变,而复杂的大模型一般在调整等方面相对于小模型显得不够灵活,增加额外的计算开销。

④、网络模型的参数量和其从数据中所能捕获或者学习到的“知识“量之间并非稳定的线性关系,而是接近边际收益逐渐减少的一种增长曲线。另外,完全相同的模型架构和模型参数量,使用完全相同的训练数据,能捕获或学习到的“知识”量并不一定完全相同。也就是说,合适的训练方法才可以使得在模型参数总量比较小时,尽可能地获取到更多的“知识”。

基于上述问题,业界急需解决在保证性能的前提下减少模型的参数量,即模型压缩,来探索计算广告和推荐算法在线上部署环节实际应用的有效落地方法。

发明内容

本发明的目的在于克服现有技术存在的上述缺陷,提供一种基于知识蒸馏的营销活动预测方法。为实现上述目的,本发明的技术方案如下:

一种基于知识蒸馏的营销活动预测方法,一种基于知识蒸馏的营销活动预测方法,其包括数据预处理步骤S1、教师模型的数据集划分及网络训练框架形成步骤S2、学生模型的数据集划分和网络训练框架形成步骤S3和预测模型建立步骤S4;所述数据预处理步骤S1包括如下步骤:

步骤S11:获取N个用户的原始信息,并从每一个所述用户的原始信息提取原始特征信息;其中,所述原始特征信息包括用户ID、用户手机号码归属地、任务批次号、用户访问DPI、用户访问DPI频次、访问时间、访问时长特征和/或用户是否点击的数字标签;其中,所述任务批次号表示一个日期时间段中用户的原始信息,所述用户访问DPI和用户访问DPI频次为每一个任务批次号为计量单位;

步骤S12:依次处理具有所述任务批次号的所有批次中的所述原始特征信息,对所述用户手机号码归属地特征进行One-hot编码处理;其中,所述One-hot编码处理包括:

依次按所述任务批次号将所有不同的用户访问DPI作为单独的特征展开,以及在所述任务批次号中将DPI访问频次也按照所有不同的用户访问DPI展开为DPI与用户访问DPI的频次的关系特征;

所述教师模型的数据集划分及网络训练框架形成步骤S2是采用分层采样结合k-折交叉验证的混合方法;具体包括:

S21:预处理之后,选择所述任务批次号中所有的数据等分成k+1个集合;其中,1个集合作为测试集,剩余集合的数据作为训练集;

S22:从所述训练集中计算得到点击与不点击两类样本中每类样本的总体占比,然后,假设所述训练集被分为k个集合,且要求满足每一个集合所得到的样本中,点击与不点击两类样本的比例与总体占比一致;

S23:依次选择所述K个集合中的一份作为验证集,剩余的K-1集合为训练集,形成K组验证集和训练集对;依次用K组验证集和训练集对,对初始化后的教师模型进行训练,并用相应的验证集将对训练结果进行验证后,再经过测试集进行测试,得K组测试结果;其中,所述教师模型为残差神经网络;

S24:将所述K组测试结果进行平均,得到所述K组测试结果的平均值;

所述学生模型的数据集划分和网络训练框架形成步骤S3包括:

S31:选择所述任务批次号中所有的数据等分成K+1个集合;其中,1个集合作为验证集,剩余的数据作为训练集;

S32:采用神经网络作为学生模型Net-S,所述学生模型Net-S包括输入层、M个全连接的隐藏层和输出层;

所述预测模型建立步骤S4包括如下步骤:

步骤S41:提供初始化的基于知识蒸馏的训练模型,其中,所述训练模型包括教师模型Net-T训练通道、学生模型Net-S训练通道和输出模块;

步骤S42:根据所述教师模型的数据集划分及网络训练框架,采用所述数据集训练所述教师模型Net-T,将K折交叉验证结果的平均作为最终分类器,并得到软标签softlabel;

步骤S43:根据所述学生模型Net-S的数据集划分及网络训练框架,采用所述数据集训练所述学生模型Net-S,在较低温t下训练得到硬预测,并与真实标签hard label组成硬损失函数L

步骤S44:在较高温T下,蒸馏所述教师模型Net-T的知识到所述学生模型Net-S,即在高温T下训练得到软预测并与软标签soft label组成软损失函数L

步骤S45:将软损失函数与硬损失函数加权得到总损失函数Loss,即

Loss=αL

步骤S46:用所述总损失函数作为实际部署时所述学生模型Net-S的目标函数,从而训练得到参数优化后的所述学生模型Net-S,将最终优化后的所述学生模型Net-S作为基于知识蒸馏的营销活动预测模型。

进一步地,所述教师模型训练通道中的教师模型Net-T网络整体架构包括:

输入层,用于输入所述教师模型Net-T的数据集划分后的数据;

嵌入层,用于对从所述输入层输入的数据特征进行信息抽提和降维;

乘积层,对经过所述嵌入层处理后的特征分别进行外积和内积的特征交互;

因式分解层,将特征交互后权重矩阵做因式分解;

全连接层,其包括N个隐藏层,所述隐藏层被设计成如下四种的网络形态,即递增型increasing、不变型constant、钻石型diamond或递减型decreasing;其中,N大于M;

输出层,采用sigmoid函数输出预测的概率,并通过划定阈值形成为点击或不点击的二分类问题,即划分为正标签或负标签的输出结果。

进一步地,所述学生模型Net-S中包括两个或三个全连接的隐藏层。

进一步地,在知识蒸馏中,所述教师模型Net-T的输出层的激活函数使用广义的归一化指数函数,即softmax函数,

进一步地,在知识蒸馏过程中,高温T的选择和所述学生模型Net-S的参数量大小有关,所述学生模型Net-S的参数量较小时,高温T选取较低的温度,反之,所述学生模型Net-S的参数量较大时,高温T选取较高的温度。

进一步地,所述的基于知识蒸馏的营销活动预测方法,其还包括营销活动预测步骤S5,所述步骤S5具体包括:

步骤S51:获取拟互联网产品营销的用户群体和所述用户群体的用户原始信息,并从所述用户原始信息提取原始特征信息;所述任务批次号表示一个日期时间段中用户的原始信息,所述用户访问DPI和用户访问DPI频次为每一个任务批次号为计量单位;

步骤S52:对所述任务批次号的所述原始特征信息,按所述用户手机号码归属地特征进行One-hot编码处理;其中,所述One-hot编码处理包括:

按所述任务批次号将所有不同的用户访问DPI作为单独的特征展开,以及在所述任务批次号中将DPI访问频次也按照所有不同的用户访问DPI展开为DPI与用户访问DPI的频次的关系特征;

步骤S53:提供建立好的所述基于知识蒸馏的营销活动预测模型;其中,使用sigmoid函数将预测值的概率范围限定在0和1之间,并通过划定阈值形成为点击或不点击的二分类问题,即所述基于知识蒸馏的营销活动预测模型的预测值为所述用户的点击意愿度。

进一步地,所述的基于知识蒸馏的营销活动预测方法,所述模型预测步骤S5还包括:

步骤S54:根据实际投放需求,选择全部或部分所述用户的模型预测值集中点击意愿度为1的用户进行精准营销的任务。

进一步地,在步骤S11后,还包括对所述用户的原始信息进行异常检测与处理步骤、连续特征处理步骤和/或降维步骤;所述连续特征处理步骤利用RankGauss方法对于连续特征调整数据分布,所述降维步骤采用主成分分析法对髙维特征进行降维处理。

进一步地,所述的基于知识蒸馏的营销活动预测方法,其还包括步骤S47,对所述基于知识蒸馏的营销活动预测模型进行模型评价指标处理和调优处理;所述模型评价指标包括AUC值、Log loss值和相对信息增益RIG值。

进一步地,所述模型调优处理包括如下一种或几种:

增加批归一化,解决数据的内部协变量偏移问题;

在网络中增加让部分神经元在训练过程中处于休眠状态的功能;

调整学习率,一般会通过指数式衰减等策略调整训练过程中的学习率;

设置多种子训练取平均,以更好的提高由于数据方差较大引起的泛化能力不足的问题;

增加L1或者L2正则化,对损失函数施加惩罚,以降低过拟合风险;

对超参数的优化方法。

从上述技术方案可以看出,本发明首先构建一个以残差神经网络为核心的较为复杂的教师模型Net-T,然后,构建一个由简单神经网络构成的学生模型Net-S。通过由教师模型Net-T在高温下训练得到的软标签soft label以及学生模型Net-S在同样温度下训练得到的硬标签hard label加权得到知识蒸馏的总损失函数;用该总损失函数作为实际部署时学生模型Net-S的目标函数,训练得到最终的得到神经网络模型,并做出预测。

通过本发明的方法,可以有效利用贝叶斯推断,在神经网络中引入预测的不确定性,使模型具有更强的鲁棒性。通过内/外积结合的方法,对特征进行了交叉来提取高维隐性特征。该混合模型可以有效扩展深度学习对于计算广告和推荐系统算法问题的应用,显著提升对用户点击行为预测的准确性,且本发明可以将大量的低意愿用户直接从投放目标中筛出,从而节省大量的营销成本,实现利润率的增加。

附图说明

图1所示为本发明实施例中基于知识蒸馏的营销活动预测方法的流程示意图

图2所示为本发明实施例中原始数据和经过RankGauss后得到的数据的示意图

图3所示为本发明实施例中教师模型的数据集划分及网络训练框架的示意图

图4所示为本发明实施例中教师模型的示意图

图5所示为本发明实施例中学生模型的示意图

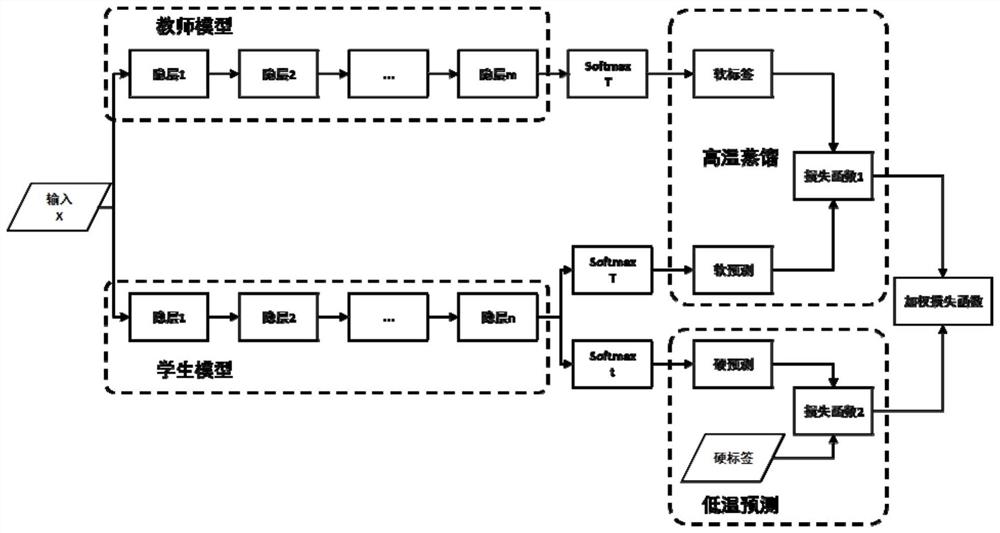

图6所示为本发明实施例中基于知识蒸馏的营销活动预测模型的示意图

具体实施方式

下面结合附图,对本发明的具体实施方式作进一步的详细说明。

在下述的具体实施方式中,在详述本发明的实施方式时,为了清楚地表示本发明的结构以便于说明,特对附图中的结构不依照一般比例绘图,并进行了局部放大、变形及简化处理,因此,应避免以此作为对本发明的限定来加以理解。

请参阅图1,图1所示为本发明实施例中基于知识蒸馏的营销活动预测方法的流程示意图。如图1所示,基于知识蒸馏的营销活动预测方法,其包括数据预处理步骤S1、教师模型的数据集划分及网络训练框架形成步骤S2、学生模型的数据集划分和网络训练框架形成步骤S3和预测模型建立步骤S4。

在本发明的实施例中,数据预处理步骤非常重要,所述数据预处理步骤S1包括如下步骤:

步骤S11:获取N个用户的原始信息,并从所述用户的原始信息提取原始特征信息;其中,所述原始特征信息包括用户ID(id)、用户手机号码归属地(location)、任务批次号(batch number)、用户访问DPI(dpi)和用户访问DPI频次(dpi frequency),访问时间、访问时长特征和/或用户是否点击等特征的数字标签;其中,所述任务批次号表示一个日期时间段中用户的原始信息,所述用户访问DPI、用户访问DPI频次、用户访问时间和/或用户访问时长为每一个任务批次号为计量单位,所述用户当日访问DPI和用户的手机号码归属地特征为类别特征。

请参阅下表1,表1为预处理之前的原始数据的表格描述,以同一批次的数据为例,预处理之前的原始数据形式如下表1所示:

在本发明的实施例中,上述的原始数据还需要经过异常检测与处理、类别特征处理、连续特征处理和降维处理等步骤。

异常检测与处理:在结合业务要求的过程中,对于原始数据中的缺失值、过大值等需要进行删除、填充等处理。在数据的采集过程中,由于一般用户量为百万级别,因此,采集过程中可能出现缺失情况;若缺失量较小,一般可直接进行剔除;若无法判断缺失数据是否会影响最终的模型训练效果,则一般可根据取平均数、众数、中位数等方法来填补缺失值。

另外,在数据采集中,可能还会遇到过大值的问题,比如某用户在一天之内访问了DPI上万次,这种情况一般在实际建模过程中对于提升模型的泛化能力并无特别帮助,因此,也可以采用剔除的处理,或者采用填补的方法进行相应的处理。

进一步地,在本发明的实施例中,还可以对连续特征进行处理,即将不同维度的访问时间和访问时长数据映射到一个统一区间。具体地,对于访问时间和访问时长等特征,例如,可以利用RankGauss方法,调整数据分布。RankGauss与常规的标准化或归一化方法类似,其基本功能都是将不同维度的数据映射到一个统一区间,如一般映射到0-1或-1到1之间。这对于基于梯度的算法,如深度学习是非常重要的。RankGauss在此基础上,进一步利用了误差函数的倒数,使得经过标准化后的数据呈现近似高斯分布。请参阅图2,图2所示为本发明实施例中原始数据和经过RankGauss后得到的数据的示意图。其中,图(a)为原始数据,图(b)为经过RankGauss后得到的数据。

在本发明的实施例中,还可以采用主成分分析(PCA)对髙维特征进行降维处理。由上述对于类别特征的处理可知,一般经过独热编码后,会形成高维稀疏矩阵,对于神经网络的训练而言,这意味着在误差反向传播时,很多地方没有办法求导,这显然是不利于网络训练的。同时,高维度特征,也增加了计算开销。因此有必要对于高维特征先进行降维处理。PCA通过求解原始数据在某投影方向的方差最大,实现降维目的;在减少特征维度的同时,尽量减少原始特征包含信息的损失,以达到可以对所收集的数据进行全面分析的目的。

步骤S12:对类别特征进行处理;即对所述用户手机号码归属地特征和用户访问DPI进行One-hot编码处理;其中,所述One-hot编码处理包括依次按所述任务批次号将所有不同的用户访问DPI作为单独的特征展开,以及在所述任务批次号中将DPI访问频次也按照所有不同的用户访问DPI展开为DPI与用户访问DPI的频次的关系特征。

具体地,首先,可以对用户当日访问DPI、用户的手机号码归属地特征进行One-hot独热编码,将其展开。以用户访问DPI为例,若某个用户访问了某DPI,则记录该DPI为1,其余DPI为0;因此,若总共有10个不同的DPI,则最后会形成10列特征,并且,每一列特征中只有一个对应用户为1,其余都为0。

经过预处理后,数据形式为下表2:

经过上述数据处理步骤后,就可以执行所述教师模型的数据集划分及网络训练框架形成步骤S2,所述步骤S2是采用分层采样结合k-折交叉验证的混合方法;具体包括如下步骤:

S21:预处理之后,选择所述任务批次号中所有的数据等分成k+1个集合;其中,1个集合作为测试集,剩余集合的数据作为训练集;

S22:从所述训练集中计算得到点击与不点击两类样本中每类样本的总体占比,然后,假设所述训练集被分为k个集合,且要求满足每一个集合所得到的样本中,点击与不点击两类样本的比例与总体占比一致;

S23:依次选择所述K个集合中的一份作为验证集,剩余的K-1集合为训练集,形成K组验证集和训练集对;依次用K组验证集和训练集对,对初始化后的教师模型进行训练,并用相应的验证集将对训练结果进行验证后,再经过测试集进行测试,得K组测试结果;其中,所述教师模型为残差神经网络;

S24:将所述K组测试结果进行平均,得到所述K组测试结果的平均值作为最终分类器;其中,该使用K折交互验证上述教师模型的网络训练框架最后平均所产生的误差也可以称为袋外(out-of-bag,oob)误差。

请参阅图3,图3所示为本发明实施例中教师模型的数据集划分及网络训练框架的示意图。如图3所示,采用分层采样(stratified sampling)结合k-折交叉验证(k-foldcross-validation)的混合方法,进行数据集划分及网络训练框架,可以使教师模型更加精准。

分层采样是一种保留类别比例的采样方式。具体来说,先将总体的样本按某种特征分为若干层,然后再从每一层内进行单纯随机抽样,组成一个样本。具体地,首先可以从训练集中计算得到点击与不点击两类样本中每类样本的占比,然后假设训练集被分为k层,且在每一层采样,要求满足每一层所得到的样本中,两类样本的比例与总体基本一致。

在本发明的实施例中,采用5折交叉验证为例进行说明,即对80%的训练集,再分为5份,每次选择1份作为验证集,其余4份作为训练集。这样,可以对模型进行5次训练,并在每次训练时,再用20%的测试集进行测试,得到模型的评价指标,将5折交叉验证结果的平均作为最终分类器。这样,虽然上述训练过程比较繁重,但该使用K折交互验证上述教师模型的网络训练框架最后平均所产生的误差是非常小的。

在本发明的实施例中,教师模型一般要求较为复杂,能对数据中的特征具有较强的表达能力。请参阅图4,图4所示为本发明实施例中教师模型的示意图。如图4所示,所述教师模型训练通道中的教师模型Net-T网络整体架构包括:

输入层(Input layer),用于输入所述教师模型Net-T的数据集划分后的数据;其可以根据不同特征(如DPI时长,性别,年龄分布等信息)将特征分为一个个域(field),并对类别特征做独热编码(One-hot encoding);

嵌入层(Embedding layer),用于对从所述输入层输入的数据特征进行信息抽提和降维;

乘积层(Product layer),对经过所述嵌入层处理后的特征分别进行外积和内积的特征交互;

因式分解层(Factorization layer),将特征交互后权重矩阵做因式分解;即为降低计算量,按照图3所示将权重矩阵做因式分解;

全连接层(Fully-connected layer),其包括N个隐藏层,所述隐藏层被设计成如下四种的网络形态,即递增型increasing、不变型constant、钻石型diamond或递减型decreasing;其中,N大于M;

输出层,采用sigmoid函数输出预测的概率,并通过划定阈值形成为点击或不点击的二分类问题,即划分为正标签或负标签的输出结果。

接下来,执行所述学生模型的数据集划分和网络训练框架形成步骤S3,所述S3包括:

S31:选择所述任务批次号中所有的数据等分成K+1个集合;其中,1个集合作为验证集,剩余的数据作为训练集;

S32:采用神经网络作为学生模型Net-S,所述学生模型Net-S包括输入层、M个全连接的隐藏层和输出层。

在本发明的实施例中,学生模型考虑到模型部署时灵活、对计算资源消耗小等方面,可以建立简单的深层神经网络,例如,所述学生模型Net-S中可以包括全连接的两个或三个隐藏层。请参阅图5,图5所示为本发明实施例中学生模型的示意图。如图5所示,学生模型在输入层(Iutput)和输出层(Output)之间只包含了三个全连接的隐藏层(Fully-connected layer),相比于教师模型,其网络参数量大大减小。

上述模型建立后,就可以执行所述预测模型建立步骤S4。在本发明的实施例中,所述预测模型是基于知识蒸馏的整体框架的。请参阅图6,图6所示为本发明实施例中基于知识蒸馏的营销活动预测模型的示意图。下面结合图6对基于知识蒸馏的营销活动预测模型建立步骤进行说明。

所述预测模型建立步骤S4包括如下步骤:

步骤S41:提供初始化的基于知识蒸馏的训练模型,其中,所述训练模型包括教师模型Net-T训练通道、学生模型Net-S训练通道和输出模块;

步骤S42:根据所述教师模型的数据集划分及网络训练框架,采用所述数据集训练所述教师模型Net-T,将K折交叉验证结果的平均作为最终分类器,并得到软标签softlabel;

步骤S43:根据所述学生模型Net-S的数据集划分及网络训练框架,采用所述数据集训练所述学生模型Net-S,在较低温t下训练得到硬预测,并与真实标签hard label组成硬损失函数L

步骤S44:在较高温T下,蒸馏所述教师模型Net-T的知识到所述学生模型Net-S,即在高温T下训练得到软预测并与软标签soft label组成软损失函数L

步骤S45:将软损失函数与硬损失函数加权得到总损失函数Loss,即

Loss=αL

步骤S46:用所述总损失函数作为实际部署时所述学生模型Net-S的目标函数,从而训练得到参数优化后的所述学生模型Net-S,将最终优化后的所述学生模型Net-S作为基于知识蒸馏的营销活动预测模型。

在这里需要注意的是,对于多分类问题来说,一般输出层的激活函数使用归一化指数函数即softmax函数,在知识蒸馏中,为了引入温度的概念,将其修改为广义的softmax函数。即所述教师模型Net-T的输出层的激活函数使用广义的归一化指数函数,即softmax函数,

另外,在知识蒸馏过程中,高温T的选择和所述学生模型Net-S的参数量大小有关,所述学生模型Net-S的参数量较小时,高温T选取较低的温度,反之,所述学生模型Net-S的参数量较大时,高温T选取较高的温度。

也就是说,在知识蒸馏过程中,需要选取合适的温度就行特征知识的提取。一般来说,高温T的高低改变的是学生模型Net-S训练过程中对负标签(负标签在点击率中就是指不点击,即标签为0)的关注程度。当温度较低时,对负标签的关注,尤其是那些显著低于平均值的负标签的关注较少;而当温度较高时,负标签相关的值会相对增大,学生模型Net-S会相对多地关注到负标签。总的来说,高温T的选择和学生模型Net-S的大小有关,学生模型Net-S参数量比较小的时候,高温T选择相对比较低的温度就可以了。

具体地,通过上述训练后,最后就可以通过最终优化后的所述学生模型Net-S作为基于知识蒸馏的营销活动预测模型,输出的预测用户“点击”与“不点击”这一二分类问题,因此网络结构最后添加一个输出层神经元。

上述模型训练完成后,还包括步骤S47,对所述基于知识蒸馏的营销活动预测模型进行模型评价指标处理和调优处理;所述模型评价指标包括AUC(Area Under Curve)值、Log loss值和相对信息增益RIG(Relative Information Gain)值。一般来说,AUC值越接近1,则模型分类效果越好。Log loss值越小,说明点击率预估的准确度越高;相对信息增益值越大模型效果越好。

例如,在对数据按照上述步骤处理并通过模型训练后,通过本地验证的AUC值,可以判断该模型的训练效果;若效果较差,一般需要对模型进行调优,对于深度学习算法,一般可从如下几方面进行优化:

①、增加批归一化(Batch Normalization),解决数据的内部协变量偏移问题(Internal Covariate Shift)。

②、在网络中增加Dropout,即让部分神经元在训练过程中处于休眠状态。

③、调整学习率,一般会通过指数式衰减等策略调整训练过程中的学习率。

④、设置多种子训练取平均,降低训练过程中的过拟合风险。

⑤、增加L1或者L2正则化,对损失函数施加惩罚,以降低过拟合风险。

⑥、超参数的优化。

在对超参数的优化方法上,一般可以采用网格搜索(Grid Search)或者随机搜索(Random Search);但上述两种方法对于计算资源的消耗较大,且效率不高。在本发明的实施例中,采用贝叶斯优化(Bayesian Optimization)策略。贝叶斯优化通过高斯过程回归计算前面n个数据点的后验概率分布,得到每一个超参数在每一个取值点的均值和方差;贝叶斯优化通过均衡均值和方差,根据超参数间的联合概率分布,最终选择一组较好的超参数。

上述所有处理步骤完成后,就可以通过将上述特征带入用户预测模型,能够提前在广告投放之前就筛选出意愿较高的部分用户,并对这些用户进行营销广告的精准投放。

即本发明还可以还包括营销活动预测步骤S5,所述步骤S5具体包括:

步骤S51:获取拟互联网产品营销的用户群体和所述用户群体的用户原始信息,并从所述用户原始信息提取原始特征信息;所述任务批次号表示一个日期时间段中用户的原始信息,所述用户访问DPI和用户访问DPI频次为每一个任务批次号为计量单位;

步骤S52:对所述任务批次号的所述原始特征信息,按所述用户手机号码归属地特征进行One-hot编码处理;其中,所述One-hot编码处理包括:

按所述任务批次号将所有不同的用户访问DPI作为单独的特征展开,以及在所述任务批次号中将DPI访问频次也按照所有不同的用户访问DPI展开为DPI与用户访问DPI的频次的关系特征;

步骤S53:提供建立好的所述基于知识蒸馏的营销活动预测模型;其中,使用sigmoid函数将预测值的概率范围限定在0和1之间,并通过划定阈值形成为点击或不点击的二分类问题,即所述基于知识蒸馏的营销活动预测模型的预测值为所述用户的点击意愿度;

步骤S54:根据实际投放需求,选择全部或部分所述用户的模型预测值集中点击意愿度为1的用户进行精准营销的任务。

结果表明,通过本发明的方法,可以有效利用贝叶斯推断,在神经网络中引入预测的不确定性,使模型具有更强的鲁棒性。通过内/外积结合的方法,对特征进行了交叉来提取高维隐性特征。该混合模型可以有效扩展深度学习对于计算广告和推荐系统算法问题的应用,并显著提升对用户点击行为预测的准确性,从而节省大量的营销成本,实现利润率的增加。

以上所述的仅为本发明的优选实施例,所述实施例并非用以限制本发明的专利保护范围,因此凡是运用本发明的说明书及附图内容所作的等同结构变化,同理均应包含在本发明的保护范围内。

- 基于知识蒸馏的营销活动预测模型结构和预测方法

- 基于深度因子分解机的营销活动预测模型结构和预测方法