数据处理方法、装置、电子设备、存储介质及程序产品

文献发布时间:2023-06-19 11:29:13

技术领域

本公开实施例涉及计算机技术领域,具体涉及一种数据处理方法、装置、电子设备、存储介质及程序产品。

背景技术

Spark SQL从Shark发展而来,Shark为了实现Hive兼容,在HQL方面重用了Hive中HQL的解析、逻辑执行计划翻译、执行计划优化等逻辑,可以近似认为仅将物理执行计划从MR作业替换成了Spark作业;同时还依赖Hive Metastore和Hive SerDe(用于兼容现有的各种Hive存储格式)。而Spark SQL在Hive兼容层面仅依赖HQL parser、Hive Metastore和Hive SerDe。也就是说,从HQL被解析成抽象语法树(AST)起,就全部由Spark SQL接管了。Spark SQL中执行计划生成和优化都由Catalyst负责,并通过借助Scala的模式匹配等函数式语言特性,利用Catalyst开发执行计划优化策略比Hive简洁很多。在实际执行Spark SQL语句时,中间可以由多次Shuffle阶段。已有技术中,由于Spark参数需统一配置,因此每个Shuffle阶段所使用的Spark参数都是统一参数,无法实现对每个Shuffle阶段定制不同的参数,因此影响了Shuffle阶段的运行效率。因此,如何实现Spark SQL语句执行过程中为多次Shuffle分别定制Spark参数是当前需要解决的技术问题之一。

发明内容

本公开实施例提供一种数据处理方法、装置、电子设备、存储介质及程序产品。

第一方面,本公开实施例中提供了一种数据处理方法,包括:接收Spark SQL语句;解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

进一步地,基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句,包括:基于所述解析结果确定逻辑计划;优化所述逻辑计划;基于所述Spark参数以及优化后的所述逻辑计划生成物理计划;执行所述物理计划。

进一步地,基于所述Spark参数以及优化后的所述逻辑计划生成物理计划,包括:将所述逻辑计划中的逻辑算子映射至对应的物理算子;针对映射后的所述物理算子,根据分区策略和数据分布情况确定是否添加shuffle操作;在需要添加shuffle操作时,确定与所述物理算子对应的所述Spark参数,以及利用所述Spark参数配置所述shuffle操作。

进一步地,执行所述物理计划,包括:在执行所述物理计划中的shuffle操作时,基于对应的所述Spark参数中的分区参数启动至少一个数据读任务,以便由所述数据读任务将待处理数据读出到根据所述分区参数指定的多个分区中,以及启动多个数据处理任务,以便由所述多个数据处理任务处理所述分区中的数据。

进一步地,解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果,包括:确定所述Spark SQL语句中注解信息;从所述注解信息获得所述解析结果中的所述Spark参数配置信息。

进一步地,确定所述Spark SQL语句中注解信息,包括:将预设关键词与所述SparkSQL语句进行匹配;从所述Spark SQL语句中相匹配的内容确定所述注解信息。

第二方面,本公开实施例中提供了一种参数配置方法,其中,包括:响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述SparkSQL语句的目标配置位置处;将所述Spark SQL语句提交至Spark处理节点,以便执行所述Spark SQL语句。

进一步地,所述响应于Spark参数配置的请求,展示参数配置界面,包括:接收到Spark参数配置的请求后,确定所述请求所针对的所述Spark SQL语句中候选配置位置;将所述候选配置位置以及对应于所述候选配置位置处的所述可配置参数选项展示在所述参数配置界面上。

第三方面,本公开实施例中提供了一种数据处理方法,包括:Spark客户端响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;Spark客户端接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;Spark客户端将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述Spark SQL语句的目标配置位置处;Spark客户端将所述Spark SQL语句提交至Spark处理节点;Spark处理节点接收所述Spark SQL语句;所述Spark处理节点解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;Spark处理节点在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;Spark处理节点基于配置后的所述Spark参数以及所述解析结果执行所述SparkSQL语句。

进一步地,所述Spark客户端响应于Spark参数配置的请求,展示参数配置界面,包括:所述Spark客户端接收到Spark参数配置的请求后,确定所述请求所针对的所述SparkSQL语句中候选配置位置;所述Spark客户端将所述候选配置位置以及对应于所述候选配置位置处的所述可配置参数选项展示在所述参数配置界面上。

进一步地,所述Spark处理节点基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句,包括:所述Spark处理节点基于所述解析结果确定逻辑计划;所述Spark处理节点优化所述逻辑计划;所述Spark处理节点基于所述Spark参数以及优化后的所述逻辑计划生成物理计划;所述Spark处理节点执行所述物理计划。

进一步地,所述Spark处理节点基于所述Spark参数以及优化后的所述逻辑计划生成物理计划,包括:所述Spark处理节点将所述逻辑计划中的逻辑算子映射至对应的物理算子;所述Spark处理节点针对映射后的所述物理算子,根据分区策略和数据分布情况确定是否添加shuffle操作;所述Spark处理节点在需要添加shuffle操作时,确定与所述物理算子对应的所述Spark参数,以及利用所述Spark参数配置所述shuffle操作。

进一步地,所述Spark处理节点执行所述物理计划,包括:所述Spark处理节点在执行所述物理计划中的shuffle操作时,基于对应的所述Spark参数中的分区参数启动至少一个数据读任务,以便由所述数据读任务将待处理数据读出到根据所述分区参数指定的多个分区中,以及启动多个数据处理任务,以便由所述多个数据处理任务处理所述分区中的数据。

进一步地,所述Spark处理节点解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果,包括:所述Spark处理节点确定所述Spark SQL语句中注解信息;所述Spark处理节点从所述注解信息获得所述解析结果中的所述Spark参数配置信息。

进一步地,所述Spark处理节点确定所述Spark SQL语句中注解信息,包括:所述Spark处理节点将预设关键词与所述Spark SQL语句进行匹配;所述Spark处理节点从所述Spark SQL语句中相匹配的内容确定所述注解信息。

第四方面,本公开实施例中提供了一种数据处理装置,包括:第一接收模块,被配置为接收Spark SQL语句;解析模块,被配置为解析所述Spark SQL语句,获得所述SparkSQL语句的解析结果;配置模块,被配置为在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;执行模块,被配置为基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

第五方面,本公开实施例中提供了一种参数配置装置,其中,包括:

展示模块,被配置为响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;第二接收模块,被配置为接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;添加模块,被配置为将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述Spark SQL语句的目标配置位置处;提交模块,被配置为将所述Spark SQL语句提交至Spark处理节点,以便执行所述Spark SQL语句。

所述功能可以通过硬件实现,也可以通过硬件执行相应的软件实现。所述硬件或软件包括一个或多个与上述功能相对应的模块。

在一个可能的设计中,上述装置的结构中包括存储器和处理器,所述存储器用于存储一条或多条支持上述装置执行上述对应方法的计算机指令,所述处理器被配置为用于执行所述存储器中存储的计算机指令。上述装置还可以包括通信接口,用于上述装置与其他设备或通信网络通信。

第六方面,本公开实施例中提供了一种数据处理系统,包括Spark客户端和Spark处理节点;其中,所述Spark客户端响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;所述Spark客户端接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;所述Spark客户端将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述SparkSQL语句的目标配置位置处;所述Spark客户端将所述Spark SQL语句提交至所述Spark处理节点;所述Spark处理节点接收所述Spark SQL语句;所述Spark处理节点解析所述SparkSQL语句,获得所述Spark SQL语句的解析结果;Spark处理节点在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;Spark处理节点基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

第七方面,本公开实施例提供了一种电子设备,包括存储器和处理器,所述存储器用于存储一条或多条支持上述任一装置执行上述对应方法的计算机指令,所述处理器被配置为用于执行所述存储器中存储的计算机指令。上述任一装置还可以包括通信接口,用于与其他设备或通信网络通信。

第八方面,本公开实施例提供了一种计算机可读存储介质,用于存储上述任一装置所用的计算机指令,其包含用于执行上述任一方法所涉及的计算机指令。

第九方面,本公开实施例提供了一种计算机程序产品,其包含计算机指令,该计算机指令被处理器执行时用于实现上述任一方面所述方法的步骤。

本公开实施例提供的技术方案可包括以下有益效果:

本公开实施例提供的技术方案在用户提交Spark SQL语句时可以根据实际需要在Spark SQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的Spark SQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开实施例。

附图说明

结合附图,通过以下非限制性实施方式的详细描述,本公开实施例的其它特征、目的和优点将变得更加明显。在附图中:

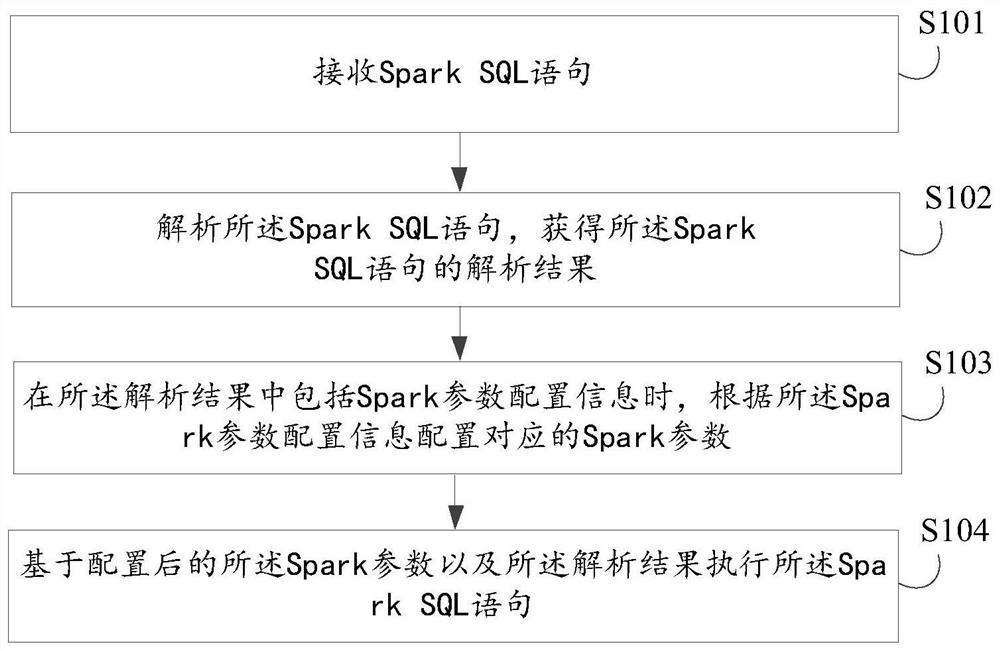

图1示出根据本公开一实施方式的数据处理方法的流程图;

图2示出根据本公开一实施方式的参数配置方法的流程图;

图3示出根据本公开另一实施方式的数据处理方法的流程图;

图4示出根据本公开一实施方式的数据处理方法的应用场景示意图;

图5示出根据本公开一实施方式的数据处理方法的整体流程图;

图6示出根据本公开一实施方式的数据处理装置的结构框图;

图7示出根据本公开一实施方式的参数配置装置的结构框图;

图8示出根据本公开一实施方式的数据处理系统的结构框图;

图9是适于用来实现根据本公开一实施方式的数据处理方法的计算机系统的结构示意图。

具体实施方式

下文中,将参考附图详细描述本公开实施例的示例性实施方式,以使本领域技术人员可容易地实现它们。此外,为了清楚起见,在附图中省略了与描述示例性实施方式无关的部分。

在本公开实施例中,应理解,诸如“包括”或“具有”等的术语旨在指示本说明书中所公开的特征、数字、步骤、行为、部件、部分或其组合的存在,并且不欲排除一个或多个其他特征、数字、步骤、行为、部件、部分或其组合存在或被添加的可能性。

另外还需要说明的是,在不冲突的情况下,本公开中的实施例及实施例中的特征可以相互组合。下面将参考附图并结合实施例来详细说明本公开实施例。

本公开实施例提供的技术方案在接收到用户编写的Spark SQL语句或者包含由Spark SQL语句的程序片段之后,还可以基于用户的请求为Spark SQL语句配置Spark参数;在接收到用户的参数配置请求之后,可以展示参数配置界面,并且在界面上可以显示可配置的参数选项,供用户选择配置使用;在接收到用户配置的Spark参数之后,可以根据用户指定的位置将Spark参数以注解的形式添加到Spark SQL语句中,并将该Spark SQL语句提交至Spark处理节点,由Spark处理节点执行。Spark处理节点接收到带有Spark参数的SparkSQL语句之后,在解析该Spark SQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及Spark SQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在Spark SQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的Spark SQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

图1示出根据本公开一实施方式的数据处理方法的流程图,如图1所示,所述数据处理方法包括以下步骤S101-S103:

在步骤S101中,接收Spark SQL语句;

在步骤S102中,解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;

在步骤S103中,在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;

在步骤S104中,基于配置后的所述Spark参数以及所述解析结果执行所述SparkSQL语句。

上文提及,Spark SQL从Shark发展而来,Shark为了实现Hive兼容,在HQL方面重用了Hive中HQL的解析、逻辑执行计划翻译、执行计划优化等逻辑,可以近似认为仅将物理执行计划从MR作业替换成了Spark作业;同时还依赖Hive Metastore和Hive SerDe(用于兼容现有的各种Hive存储格式)。而Spark SQL在Hive兼容层面仅依赖HQL parser、HiveMetastore和Hive SerDe。也就是说,从HQL被解析成抽象语法树(AST)起,就全部由SparkSQL接管了。Spark SQL中执行计划生成和优化都由Catalyst负责,并通过借助Scala的模式匹配等函数式语言特性,利用Catalyst开发执行计划优化策略比Hive简洁很多。在实际执行Spark SQL语句时,中间可以由多次Shuffle阶段。已有技术中,由于Spark参数需统一配置,因此每个Shuffle阶段所使用的Spark参数都是统一参数,无法实现对每个Shuffle阶段定制不同的参数,因此影响了Shuffle阶段的运行效率。

考虑到上述问题,在该实施方式中,提出一种数据处理方法,该方法在接收到用户编写的Spark SQL语句或者包含由Spark SQL语句的程序片段之后,还可以基于用户的请求为Spark SQL语句配置Spark参数;在接收到用户的参数配置请求之后,可以展示参数配置界面,并且在界面上可以显示可配置的参数选项,供用户选择配置使用;在接收到用户配置的Spark参数之后,可以根据用户指定的位置将Spark参数以注解的形式添加到Spark SQL语句中,并将该Spark SQL语句提交至Spark处理节点,由Spark处理节点执行。Spark处理节点接收到带有Spark参数的Spark SQL语句之后,在解析该Spark SQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及Spark SQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在SparkSQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的SparkSQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

在本公开一实施方式中,该数据处理方法可适用于在Spark处理节点,Spark处理节点为Spark语句的实际处理执行体,可以与Spark客户端位于同一物理设备,也可以位于不同物理设备。

在本公开一实施方式中,用户可以通过Spark客户端提供Spark SQL语句,例如用户可以通过Spark-SQL Shell客户端输入纯SQL文本等。

Spark SQL的总体执行流程包括:从提供的纯SQL文本、DatasetAPI和/或DataframeAPI开始,依次经过未解析的逻辑计划、解析的逻辑计划、优化的逻辑计划和物理计划,然后根据代价优化从候选物理计划中选取一条物理计划执行。

在已有技术中,用户通过Spark客户端提供的接口输入SQL文本、DatasetAPI和/或DataframeAPI等时,可以在其中自定义Spark参数,如果用户未自定义Spark参数,则以默认参数执行Spark SQL语句。本公开实施例中涉及的Spark参数可以包括执行Spark SQL对应的物理计划中所涉及的任意可自定义参数,例如minPartitions和use_unicode等,minPartitions表示在执行Spark SQL对应的物理计划时,Shuffle阶段的最少分区数目,use_unicode表示文件使用的编码参数。上述仅举例说明,本公开中Spark参数不限于minPartitions和use_unicode,还包括其他参数,例如可以包括Shuffle阶段所涉及并且可自定义的参数。

在本公开一实施方式中,解析Spark SQL语句的过程中,可以通过大数据,获得该Spark SQL语句针对的元数据,例如hive metastore,获取所涉及的表信息、列信息等,如果还涉及视图表,则还可以展开视图的逻辑,并做进一步的解析。

在本公开一实施方式中,除了上述解析步骤之外,还需要解析Spark SQL语句中的Spark参数配置信息,该Spark参数配置信息可以以注解信息的形式添加在Spark SQL语句中,因此在解析过程中,可以通过确定Spark SQL语句中是否包括注解信息即可获取Spark参数配置信息。

在本公开一实施方式中,针对Spark SQL语句的解析结果可以包括但不限于SparkSQL语句中解析得到的数据源、表、列等信息,还可以包括Spark参数配置信息。Spark参数配置信息中可以包括用户配置的一个或多个Spark参数以及该Spark参数的配置位置。需要说明的是,Spark参数在Spark SQL语句中的配置位置不同,其在执行Spark SQL语句的物理计划中的作用不同。例如,Spark SQL语句在执行时两处涉及shuffle操作,而用户在这两处分别配置了最大分区数量参数,并且这两处配置的最大分区数量不同,那么在物理计划中在执行第一处shuffle操作时,最大分区数量以在第一处所配置的Spark参数为为准,而在执行第二处shuffle操作时,最大分区数量以在第二处所配置的Spark参数为为准。通过这种方式可以实现同一Spark SQL语句中,不同阶段可以使用不同的配置参数执行Spark SQL语句。

在本公开一实施方式中,生成Spark SQL语句的物理计划时,采用Spark参数配置信息配置执行过程中所使用的Spark参数,并在执行该Spark SQL语句时,基于所配置的Spark参数以及Spark SQL语句的其他解析结果执行。

本公开实施方式接收到带有Spark参数的Spark SQL语句之后,在解析该SparkSQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及SparkSQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在Spark SQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的Spark SQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

在本公开一实施方式中,步骤S104,即基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句的步骤,进一步可以包括以下步骤:基于所述解析结果确定逻辑计划;优化所述逻辑计划;基于所述Spark参数以及优化后的所述逻辑计划生成物理计划;执行所述物理计划。

该实施方式中,获得Spark SQL语句的解析结果之后,可以根据解析结果制定逻辑计划,并对该逻辑计划进行优。SQL是一种结构化查询语言,用于访问数据库系统。对数据库的访问操作可以包括:插入、查询、更新和和删除等,Spark驱动器需要根据SQL语句生成逻辑计划树,该逻辑计划树表明了如何完成所述访问任务,Spark执行节点执行该逻辑计划树对应的物理计划树,从而实现访问任务。

对Spark SQL语句的处理过程中,Spark驱动器首先对Spark SQL语句进行解析(包括词法解析和语法解析),形成一棵逻辑计划树,在后续的优化处理过程中对该逻辑计划树进行操作。操作的方法包括采用规则(rule)对逻辑计划树进行匹配,从而对逻辑计划树中不同类型的节点采用不同的操作,例如对查询(select)节点、过滤(filter)节点、连接(join)节点等节点采用不同的操作。整个SQL语句的处理过程中逻辑计划树和规则相互配合,完成了解析、分析和优化等过程,最终生成可执行的物理计划,该物理计划则为可执行的任务,通过执行物理计划完成对Spark SQL语句的执行。在一些实施例中,物理计划会被分配至集群中的一个或多个Spark执行节点上执行。

逻辑计划树的每个节点都是一个逻辑计划,对应于一个SQL操作,各节点中保存了各对应SQL操作的详细信息,例如过滤器(Filter)节点是一个典型的逻辑计划,该节点对应于过滤操作,该节点中保存了过滤条件以及子逻辑计划等。

在本公开一实施方式中,基于Spark参数以及优化后的逻辑计划生成物理计划。在对逻辑计划映射至物理计划的过程中,如果在Spark SQL语句中配置了Spark参数,则以用户配置的Spark参数为准。例如,在Spark SQL语句对应的逻辑计划中包括join算子,并且该join算子是二元算子,在映射至物理计划时,可以考虑添加shuffle操作,而该shuffle操作涉及的Spark参数比如最小分区数目,如果在原始的Spark SQL语句的相应位置处对应有Spark参数配置信息,则以该Spark参数配置信息中的最小分区数目为准,而不是以默认的或者其他方式配置的最小分区数目为准。

在本公开一实施方式中,所述基于所述Spark参数以及优化后的所述逻辑计划生成物理计划的步骤,进一步可以包括以下步骤:将所述逻辑计划中的逻辑算子映射至对应的物理算子;针对映射后的所述物理算子,根据分区策略和数据分布情况确定是否添加shuffle操作;在需要添加shuffle操作时,确定与所述物理算子对应的所述Spark参数,以及利用所述Spark参数配置所述shuffle操作。

该实施方式中,根据Spark SQL语句的解析结果生成逻辑计划,并对其优化后,利用优化后的逻辑计划生成物理计划。在生成物理计划的过程中,将逻辑计划中的逻辑算子映射成物理算子,由于Spark SQL语句的执行时在分布式系统上执行,因此针对物理算子,可以根据分区测量和数据分布情况等确定是否需要添加shuffle操作,在需要添加shuffle操作时,可以从解析结果中Spark参数配置信息中找到与该所要添加的shuffle操作对应的Spark参数,例如最小分区数目参数等,进而再利用该Spark参数配置shuffle操作。所配置的shuffle操作在执行物理计划时,会被分配至相应的执行节点去执行。

在本公开一实施方式中,所述执行所述物理计划的步骤,进一步可以包括以下步骤:

在执行所述物理计划中的shuffle操作时,基于对应的所述Spark参数中的分区参数启动至少一个数据读任务,以便由所述数据读任务将待处理数据读出到根据所述分区参数指定的多个分区中,以及启动多个数据处理任务,以便由所述多个数据处理任务处理所述分区中的数据。

该实施方式中,如果物理计划中存在shuffle操作,则针对shuffle操作可以基于用户所配置的Spark参数中的分区参数启动至少一个数据读任务,分区参数可以用于指定最小分区数目,Spark执行节点可以根据该分区参数启动对应的多个数据读任务(maptask),以便由该数据读任务将待处理数据从数据库中读出到多个分区中,分区的数目与分区参数相关,并且还可以启动多个数据处理任务(reduce task)对该多个分区中的数据进行处理,数据处理任务的数量与分区的数量相同。在一些实施例中,Spark处理节点可以是集群中的其中一个Spark执行节点,并且数据读任务和数据处理任务可以在本地启动,也即该Spark执行节点上启动。

在本公开一实施方式中,步骤S102,即解析所述Spark SQL语句,获得所述SparkSQL语句的解析结果的步骤,进一步可以包括以下步骤:确定所述Spark SQL语句中注解信息;从所述注解信息获得所述解析结果中的所述Spark参数配置信息。

该实施方式中,用户配置的Spark参数可以以注解的形式添加在Spark SQL语句中,因此,在解析Spark SQL语句时,可以通过匹配Spark SQL语句中有无相匹配的注解信息即可确定用户是否配置了Spark参数。在一些实施方式中,可以通过关键词匹配方式,从Spark SQL语句中确定注解信息。在一实施方式中,注解信息可以以第一预设关键词开始、而以第二预设关键词结束的形式添加在SQL语句中,第一预设关键词和第二预设关键词之间可以配置对应的Spark参数,包括Spark参数标识以及相应的值。

例如,Spark.sql(select/*minPartitions=200*/key1 and key2 from table_2join table_1”),第一预设关键词可以是“/*”,第二预设关键词可以是“*/”,Spark参数的标识为“minPartitions”,其值为200。

在本公开一实施方式中,确定所述Spark SQL语句中注解信息的步骤,进一步可以包括以下步骤:将预设关键词与所述Spark SQL语句进行匹配;

从所述Spark SQL语句中相匹配的内容确定所述注解信息。

该实施方式中,可以预先设置对应于注解信息的预设关键词,例如可以设置第一预设关键词和第二预设关键词,第一预设关键词和的第二预设关键词可以不同,用户配置的Spark参数添加在第一预设关键词和第二预设关键词之间。Spark处理节点可以先使用第一预设关键词对Spark SQL语句进行匹配,在匹配到第一预设关键词之后,再利用第二预设关键词向后继续匹配,直到找到第二预设关键词,将第一预设关键词和第二预设关键词之间的信息确定为注解信息。

图2示出根据本公开一实施方式的参数配置方法的流程图,如图2所示,所述参数配置方法包括以下步骤S201-S203:

在步骤S201中,响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;

在步骤S202中,接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;

在步骤S203中,将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述Spark SQL语句的目标配置位置处;

在步骤S204中,将所述Spark SQL语句提交至Spark处理节点,以便执行所述SparkSQL语句。

上文提及,Spark SQL从Shark发展而来,Shark为了实现Hive兼容,在HQL方面重用了Hive中HQL的解析、逻辑执行计划翻译、执行计划优化等逻辑,可以近似认为仅将物理执行计划从MR作业替换成了Spark作业;同时还依赖Hive Metastore和Hive SerDe(用于兼容现有的各种Hive存储格式)。而Spark SQL在Hive兼容层面仅依赖HQL parser、HiveMetastore和Hive SerDe。也就是说,从HQL被解析成抽象语法树(AST)起,就全部由SparkSQL接管了。Spark SQL中执行计划生成和优化都由Catalyst负责,并通过借助Scala的模式匹配等函数式语言特性,利用Catalyst开发执行计划优化策略比Hive简洁很多。在实际执行Spark SQL语句时,中间可以由多次Shuffle阶段。已有技术中,由于Spark参数需统一配置,因此每个Shuffle阶段所使用的Spark参数都是统一参数,无法实现对每个Shuffle阶段定制不同的参数,因此影响了Shuffle阶段的运行效率。

考虑到上述问题,在该实施方式中,提出一种参数配置方法,该方法在接收到用户编写的Spark SQL语句或者包含由Spark SQL语句的程序片段之后,还可以基于用户的请求为Spark SQL语句配置Spark参数;在接收到用户的参数配置请求之后,可以展示参数配置界面,并且在界面上可以显示可配置的参数选项,供用户选择配置使用;在接收到用户配置的Spark参数之后,可以根据用户指定的位置将Spark参数以注解的形式添加到Spark SQL语句中,并将该Spark SQL语句提交至Spark处理节点,由Spark处理节点执行。Spark处理节点接收到带有Spark参数的Spark SQL语句之后,在解析该Spark SQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及Spark SQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在SparkSQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的SparkSQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

在本公开一实施方式中,所述参数配置方法可适用于在Spark客户端上配置用户指定的Spark参数。

在本公开一实施方式中,用户在Spark客户端提供的接口提交Spark SQL语句之后,可以请求Spark客户端对执行该SQL语句所涉及的Spark参数进行设置的请求。Spark客户端接收到参数配置请求之后,可以在显示屏上展示参数配置界面,并在该参数配置界面上显示Spark SQL语句,以及针对该Spark SQL语句用户可以进行配置的可配置参数选项,该可配置参数选项包括可配置参数的标识、参数值输入接口、Spark SQL语句中添加配置信息的选择接口等。用户如果需要配置Spark参数,可以从可配置参数选项中选择待配置的Spark参数标识、输入参数值以及指定在Spark SQL语句中的目标配置位置等。

客户端接收到用户配置的Spark参数以及指定的目标配置位置后,可以将该Spark参数以注解信息的形式添加至Spark SQL语句的目标配置位置处,之后将该添加有注解信息的Spark SQL语句提交至Spark处理节点,以便由Spark处理节点对该Spark SQL语句进行解析、生成逻辑计划、优化逻辑计划、生成物理计划等一系列操作。

在本公开一实施方式中,步骤S201,即所述响应于Spark参数配置的请求,展示参数配置界面的步骤,进一步包括以下步骤:接收到Spark参数配置的请求后,确定所述请求所针对的所述Spark SQL语句中候选配置位置;将所述候选配置位置以及对应于所述候选配置位置处的所述可配置参数选项展示在所述参数配置界面上。

该实施方式中,Spark客户端接收到用户的Spark参数配置的请求之后,还可以预先分析一下该Spark SQL语句,判断该Spark SQL语句的哪些位置会涉及到用户的可配置参数,并且将这些位置确定为候选配置位置,以及在参数配置界面上展示该候选配置位置,并且还可以针对每个候选配置位置展示对应的可配置参数选项。可以理解的是,不同位置处的可配置参数选项可以相同,也可以不同。

图2所示及相关实施方式中涉及的技术术语和技术特征与图1所示及相关实施方式中提及的技术术语和技术特征相同或相似,对于图2所示及相关实施方式中涉及的技术术语和技术特征的解释和说明可参考上述对于图1所示及相关实施方式的解释的说明,此处不再赘述。

图3示出根据本公开另一实施方式的数据处理方法的流程图,如图3所示,所述数据处理方法包括以下步骤S301-S303:

在步骤S301中,Spark客户端响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;

在步骤S302中,Spark客户端接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;

在步骤S303中,Spark客户端将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述Spark SQL语句的目标配置位置处;

在步骤S304中,Spark客户端将所述Spark SQL语句提交至Spark处理节点;

在步骤S305中,Spark处理节点接收所述Spark SQL语句;

在步骤S306中,所述Spark处理节点解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;

在步骤S307中,Spark处理节点在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;

在步骤S308中,Spark处理节点基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

上文提及,Spark SQL从Shark发展而来,Shark为了实现Hive兼容,在HQL方面重用了Hive中HQL的解析、逻辑执行计划翻译、执行计划优化等逻辑,可以近似认为仅将物理执行计划从MR作业替换成了Spark作业;同时还依赖Hive Metastore和Hive SerDe(用于兼容现有的各种Hive存储格式)。而Spark SQL在Hive兼容层面仅依赖HQL parser、HiveMetastore和Hive SerDe。也就是说,从HQL被解析成抽象语法树(AST)起,就全部由SparkSQL接管了。Spark SQL中执行计划生成和优化都由Catalyst负责,并通过借助Scala的模式匹配等函数式语言特性,利用Catalyst开发执行计划优化策略比Hive简洁很多。在实际执行Spark SQL语句时,中间可以由多次Shuffle阶段。已有技术中,由于Spark参数需统一配置,因此每个Shuffle阶段所使用的Spark参数都是统一参数,无法实现对每个Shuffle阶段定制不同的参数,因此影响了Shuffle阶段的运行效率。

考虑到上述问题,在该实施方式中,提出一种数据处理方法,该方法在接收到用户编写的Spark SQL语句或者包含由Spark SQL语句的程序片段之后,还可以基于用户的请求为Spark SQL语句配置Spark参数;在接收到用户的参数配置请求之后,可以展示参数配置界面,并且在界面上可以显示可配置的参数选项,供用户选择配置使用;在接收到用户配置的Spark参数之后,可以根据用户指定的位置将Spark参数以注解的形式添加到Spark SQL语句中,并将该Spark SQL语句提交至Spark处理节点,由Spark处理节点执行。Spark处理节点接收到带有Spark参数的Spark SQL语句之后,在解析该Spark SQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及Spark SQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在SparkSQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的SparkSQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

在本公开一实施方式中,该数据处理方法可适用于Spark系统中执行,该Spark系统可以包括Spark客户端以及Spark处理节点,Spark客户端以及Spark处理节点可以位于同一物理设备,也可以位于不同物理设备。

在本公开一实施方式中,用户可以通过Spark客户端提供Spark SQL语句,例如用户可以通过Thriftserver或Spark-SQL Shell客户端输入纯SQL文本等。

Spark SQL的总体执行流程包括:从提供的纯SQL文本、DatasetAPI和/或DataframeAPI开始,依次经过未解析的逻辑计划、解析的逻辑计划、优化的逻辑计划和物理计划,然后根据代价优化从候选物理计划中选取一条物理计划执行。

在已有技术中,用户通过Spark客户端提供的接口输入SQL文本、DatasetAPI和/或DataframeAPI等时,可以在其中自定义Spark参数,如果用户未自定义Spark参数,则以默认参数执行Spark SQL语句。本公开实施例中涉及的Spark参数可以包括执行Spark SQL对应的物理计划中所涉及的任意可自定义参数,例如minPartitions和use_unicode等,minPartitions表示在执行Spark SQL对应的物理计划时,Shuffle阶段的最少分区数目,use_unicode表示文件使用的编码参数。上述仅举例说明,本公开中Spark参数不限于minPartitions和use_unicode,还包括其他参数,例如可以包括Shuffle阶段所涉及并且可自定义的参数。

在本公开一实施方式中,用户在Spark客户端提供的接口提交Spark SQL语句之后,可以请求Spark客户端对执行该SQL语句所涉及的Spark参数进行设置的请求。Spark客户端接收到参数配置请求之后,可以在显示屏上展示参数配置界面,并在该参数配置界面上显示Spark SQL语句,以及针对该Spark SQL语句用户可以进行配置的可配置参数选项,该可配置参数选项包括可配置参数的标识、参数值输入接口、Spark SQL语句中添加配置信息的选择接口等。用户如果需要配置Spark参数,可以从可配置参数选项中选择待配置的Spark参数标识、输入参数值以及指定在Spark SQL语句中的目标配置位置等。

客户端接收到用户配置的Spark参数以及指定的目标配置位置后,可以将该Spark参数以注解信息的形式添加至Spark SQL语句的目标配置位置处,之后将该添加有注解信息的Spark SQL语句提交至Spark处理节点,以便由Spark处理节点对该Spark SQL语句进行解析、生成逻辑计划、优化逻辑计划、生成物理计划等一系列操作。

在本公开一实施方式中,解析Spark SQL语句的过程中,可以通过大数据,获得该Spark SQL语句针对的元数据,例如hive metastore,获取所涉及的表信息、列信息等,如果还涉及视图表,则还可以展开视图的逻辑,并做进一步的解析。

在本公开一实施方式中,除了上述解析步骤之外,还需要解析Spark SQL语句中的Spark参数配置信息,该Spark参数配置信息可以以注解信息的形式添加在Spark SQL语句中,因此在解析过程中,可以通过确定Spark SQL语句中是否包括注解信息即可获取Spark参数配置信息。

在本公开一实施方式中,针对Spark SQL语句的解析结果可以包括但不限于SparkSQL语句中解析得到的数据源、表、列等信息,还可以包括Spark参数配置信息。Spark参数配置信息中可以包括用户配置的一个或多个Spark参数以及该Spark参数的配置位置。需要说明的是,Spark参数在Spark SQL语句中的配置位置不同,其在执行Spark SQL语句的物理计划中的作用不同。例如,Spark SQL语句在执行时两处涉及shuffle操作,而用户在这两处分别配置了最大分区数量参数,并且这两处配置的最大分区数量不同,那么在物理计划中在执行第一处shuffle操作时,最大分区数量以在第一处所配置的Spark参数为为准,而在执行第二处shuffle操作时,最大分区数量以在第二处所配置的Spark参数为为准。通过这种方式可以实现同一Spark SQL语句中,不同阶段可以使用不同的配置参数执行Spark SQL语句。

在本公开一实施方式中,生成Spark SQL语句的物理计划时,采用Spark参数配置信息配置执行过程中所使用的Spark参数,并在执行该Spark SQL语句时,基于所配置的Spark参数以及Spark SQL语句的其他解析结果执行。

本公开实施方式接收到带有Spark参数的Spark SQL语句之后,在解析该SparkSQL语句后,确定解析结果中是否包含Spark参数配置信息,如果包含Spark参数配置信息,则根据该Spark参数配置信息配置对应的Spark参数,并基于该配置的Spark参数以及SparkSQL语句的解析结果执行该Spark SQL语句。通过这种方式,用户提交Spark SQL语句时可以根据实际需要在Spark SQL语句的适当位置配置相应的Spark参数,以便在执行Spark SQL时,不同位置处的Spark SQL语句对应的物理计划可以使用所配置的不同Spark参数,避免了任何阶段都只能使用统一参数而导致Spark SQL执行效率低下的缺陷。

在本公开一实施方式中,步骤S301,即所述Spark客户端响应于Spark参数配置的请求,展示参数配置界面的步骤,进一步包括以下步骤:所述Spark客户端接收到Spark参数配置的请求后,确定所述请求所针对的所述Spark SQL语句中候选配置位置;所述Spark客户端将所述候选配置位置以及对应于所述候选配置位置处的所述可配置参数选项展示在所述参数配置界面上。

该实施方式中,Spark客户端接收到用户的Spark参数配置的请求之后,还可以预先分析一下该Spark SQL语句,判断该Spark SQL语句的哪些位置会涉及到用户的可配置参数,并且将这些位置确定为候选配置位置,以及在参数配置界面上展示该候选配置位置,并且还可以针对每个候选配置位置展示对应的可配置参数选项。可以理解的是,不同位置处的可配置参数选项可以相同,也可以不同。

在本公开一实施方式中,步骤S308,即所述Spark处理节点基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句的步骤,进一步可以包括以下步骤:所述Spark处理节点基于所述解析结果确定逻辑计划;所述Spark处理节点优化所述逻辑计划;所述Spark处理节点基于所述Spark参数以及优化后的所述逻辑计划生成物理计划;所述Spark处理节点执行所述物理计划。

该实施方式中,Spark处理节点获得Spark SQL语句的解析结果之后,可以根据解析结果制定逻辑计划,并对该逻辑计划进行优。SQL是一种结构化查询语言,用于访问数据库系统。对数据库的访问操作可以包括:插入、查询、更新和和删除等。Spark处理节点可以包括Spark驱动器。Spark驱动器需要根据SQL语句生成逻辑计划树,该逻辑计划树表明了如何完成所述访问任务,Spark执行节点执行该逻辑计划树对应的物理计划树,从而实现访问任务。

对Spark SQL语句的处理过程中,Spark驱动器首先对Spark SQL语句进行解析(包括词法解析和语法解析),形成一棵逻辑计划树,在后续的优化处理过程中对该逻辑计划树进行操作。操作的方法包括采用规则(rule)对逻辑计划树进行匹配,从而对逻辑计划树中不同类型的节点采用不同的操作,例如对查询(select)节点、过滤(filter)节点、连接(join)节点等节点采用不同的操作。整个SQL语句的处理过程中逻辑计划树和规则相互配合,完成了解析、分析和优化等过程,最终生成可执行的物理计划,该物理计划则为可执行的任务,通过执行物理计划完成对Spark SQL语句的执行。

逻辑计划树的每个节点都是一个逻辑计划,对应于一个SQL操作,各节点中保存了各对应SQL操作的详细信息,例如过滤器(Filter)节点是一个典型的逻辑计划,该节点对应于过滤操作,该节点中保存了过滤条件以及子逻辑计划等。

在本公开一实施方式中,基于Spark参数以及优化后的逻辑计划生成物理计划。在对逻辑计划映射至物理计划的过程中,如果在Spark SQL语句中配置了Spark参数,则以用户配置的Spark参数为准。例如,在Spark SQL语句对应的逻辑计划中包括join算子,并且该join算子是二元算子,在映射至物理计划时,可以考虑添加shuffle操作,而该shuffle操作涉及的Spark参数比如最小分区数目,如果在原始的Spark SQL语句的相应位置处对应有Spark参数配置信息,则以该Spark参数配置信息中的最小分区数目为准,而不是以默认的或者其他方式配置的最小分区数目为准。

在本公开一实施方式中,所述Spark处理节点基于所述Spark参数以及优化后的所述逻辑计划生成物理计划的步骤,进一步可以包括以下步骤:所述Spark处理节点将所述逻辑计划中的逻辑算子映射至对应的物理算子;所述Spark处理节点针对映射后的所述物理算子,根据分区策略和数据分布情况确定是否添加shuffle操作;所述Spark处理节点在需要添加shuffle操作时,确定与所述物理算子对应的所述Spark参数,以及利用所述Spark参数配置所述shuffle操作。

该实施方式中,Spark处理节点根据Spark SQL语句的解析结果生成逻辑计划,并对其优化后,利用优化后的逻辑计划生成物理计划。在生成物理计划的过程中,Spark处理节点将逻辑计划中的逻辑算子映射成物理算子,由于Spark SQL语句的执行时在分布式系统上执行,因此针对物理算子,可以根据分区测量和数据分布情况等确定是否需要添加shuffle操作,在需要添加shuffle操作时,可以从解析结果中Spark参数配置信息中找到与该所要添加的shuffle操作对应的Spark参数,例如最小分区数目参数等,进而再利用该Spark参数配置shuffle操作。所配置的shuffle操作在执行物理计划时,会被分配至相应的执行节点去执行。

在本公开一实施方式中,所述Spark处理节点执行所述物理计划的步骤,进一步可以包括以下步骤:

所述Spark处理节点在执行所述物理计划中的shuffle操作时,基于对应的所述Spark参数中的分区参数启动至少一个数据读任务,以便由所述数据读任务将待处理数据读出到根据所述分区参数指定的多个分区中,以及启动多个数据处理任务,以便由所述多个数据处理任务处理所述分区中的数据。

该实施方式中,如果物理计划中存在shuffle操作,则针对shuffle操作可以基于用户所配置的Spark参数中的分区参数启动至少一个数据读任务,分区参数可以用于指定最小分区数目,Spark执行节点可以根据该分区参数启动对应的多个数据读任务(maptask),以便由该数据读任务将待处理数据从数据库中读出到多个分区中,分区的数目与分区参数相关,并且还可以启动多个数据处理任务(reduce task)对该多个分区中的数据进行处理,数据处理任务的数量与分区的数量相同。

在本公开一实施方式中,步骤S306,即所述Spark处理节点解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果的步骤,进一步可以包括以下步骤:确定所述SparkSQL语句中注解信息;从所述注解信息获得所述解析结果中的所述Spark参数配置信息。

该实施方式中,用户配置的Spark参数可以以注解的形式添加在Spark SQL语句中,因此,在解析Spark SQL语句时,可以通过匹配Spark SQL语句中有无相匹配的注解信息即可确定用户是否配置了Spark参数。在一些实施方式中,可以通过关键词匹配方式,从Spark SQL语句中确定注解信息。在一实施方式中,注解信息可以以第一预设关键词开始、而以第二预设关键词结束的形式添加在SQL语句中,第一预设关键词和第二预设关键词之间可以配置对应的Spark参数,包括Spark参数标识以及相应的值。

例如,Spark.sql(select/*minPartitions=200*/key1 and key2 from table_2join table_1”),第一预设关键词可以是“/*”,第二预设关键词可以是“*/”,Spark参数的标识为“minPartitions”,其值为200。

在本公开一实施方式中,所述Spark处理节点确定所述Spark SQL语句中注解信息的步骤,进一步可以包括以下步骤:所述Spark处理节点将预设关键词与所述Spark SQL语句进行匹配;所述Spark处理节点从所述Spark SQL语句中相匹配的内容确定所述注解信息。

该实施方式中,可以预先设置对应于注解信息的预设关键词,例如可以设置第一预设关键词和第二预设关键词,第一预设关键词和的第二预设关键词可以不同,用户配置的Spark参数添加在第一预设关键词和第二预设关键词之间。Spark处理节点可以先使用第一预设关键词对Spark SQL语句进行匹配,在匹配到第一预设关键词之后,再利用第二预设关键词向后继续匹配,直到找到第二预设关键词,将第一预设关键词和第二预设关键词之间的信息确定为注解信息。

图4示出根据本公开一实施方式的数据处理方法的应用场景示意图。图5示出根据本公开一实施方式的数据处理方法的整体流程图。如图4和5所示,用户通过Spark客户端编写Spark SQL语句,以及该Spark SQL语句中配置有Spark参数。Spark客户端将接收到的Spark SQL语句提交至Spark处理节点,Spark处理节点可以是集群中的其中一个节点,Spark处理节点通过如图5所示的流程处理Spark SQL语句,并将得到的物理计划分配至集群中的一个或多个执行节点去执行。

如图5所示,Spark处理节点解析Spark SQL语句,获得解析结果,根据该解析结果得到未经优化的逻辑计划树,之后再利用规则优化器对逻辑计划树进行优化,得到优化后的逻辑计划树;再利用规则匹配将逻辑计划树映射至物理计划,将物理计划分配至一个或多个Spark执行节点上去执行。

下述为本公开装置实施例,可以用于执行本公开方法实施例。

图6示出根据本公开一实施方式的数据处理装置的结构框图,该装置可以通过软件、硬件或者两者的结合实现成为电子设备的部分或者全部。如图6所示,所述数据处理装置包括:

第一接收模块601,被配置为接收Spark SQL语句;

解析模块602,被配置为解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;

配置模块603,被配置为在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;

执行模块604,被配置为基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

在本公开一实施方式中,该数据处理装置可适用于在Spark处理节点,Spark处理节点为Spark语句的实际处理执行体,可以与Spark客户端位于同一物理设备,也可以位于不同物理设备。

图7示出根据本公开一实施方式的参数配置装置的结构框图,该装置可以通过软件、硬件或者两者的结合实现成为电子设备的部分或者全部。如图7所示,所述参数配置装置包括:

展示模块701,被配置为响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;

第二接收模块702,被配置为接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;

添加模块703,被配置为将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述Spark SQL语句的目标配置位置处;

提交模块704,被配置为将所述Spark SQL语句提交至Spark处理节点,以便执行所述Spark SQL语句。

在本公开一实施方式中,所述参数配置装置可适用于在Spark客户端上配置用户指定的Spark参数。

图8示出根据本公开一实施方式的数据处理系统的结构框图,该系统可以通过软件、硬件或者两者的结合实现成为电子设备的部分或者全部。如图8所示,所述数据处理系统包括:Spark客户端801和Spark处理节点802;其中,

所述Spark客户端801响应于Spark参数配置的请求,展示参数配置界面,所述参数配置界面包括参数配置所针对的Spark SQL语句以及可配置参数选项;所述Spark客户端801接收配置的Spark参数以及对应于所述Spark SQL中的目标配置位置;所述Spark客户端801将所选择的可配置参数选项对应的所述Spark参数以注解信息的形式添加至所述SparkSQL语句的目标配置位置处;所述Spark客户端801将所述Spark SQL语句提交至所述Spark处理节点802;

所述Spark处理节点802接收所述Spark SQL语句;所述Spark处理节点802解析所述Spark SQL语句,获得所述Spark SQL语句的解析结果;Spark处理节点802在所述解析结果中包括Spark参数配置信息时,根据所述Spark参数配置信息配置对应的Spark参数;Spark处理节点802基于配置后的所述Spark参数以及所述解析结果执行所述Spark SQL语句。

在本公开一实施方式中,该数据处理系统可适用于在Spark系统中处理Spark SQL语句。

上述装置实施例所涉及的技术特征及其对应的解释和说明与上文所描述的方法实施例所涉及的技术特征及其对应的解释和说明相同、相应或相似,对于上述装置实施例所涉及的技术特征及其对应的解释和说明可参考上述方法实施例所涉及的技术特征及其对应的解释和说明,本公开在此不再赘述。

本公开实施例还公开了一种电子设备,所述电子设备包括存储器和处理器;其中,

所述存储器用于存储一条或多条计算机指令,其中,所述一条或多条计算机指令被所述处理器执行以实现上述任一方法步骤。

图9是适于用来实现根据本公开一实施方式的数据处理方法或参数配置方法的计算机系统的结构示意图。

如图9所示,计算机系统900包括处理单元901,其可以根据存储在只读存储器(ROM)902中的程序或者从存储部分908加载到随机访问存储器(RAM)903中的程序而执行上述实施方式中的各种处理。在RAM903中,还存储有计算机系统900操作所需的各种程序和数据。处理单元901、ROM902以及RAM903通过总线904彼此相连。输入/输出(I/O)接口905也连接至总线904。

以下部件连接至I/O接口905:包括键盘、鼠标等的输入部分906;包括诸如阴极射线管(CRT)、液晶显示器(LCD)等以及扬声器等的输出部分907;包括硬盘等的存储部分908;以及包括诸如LAN卡、调制解调器等的网络接口卡的通信部分909。通信部分909经由诸如因特网的网络执行通信处理。驱动器910也根据需要连接至I/O接口905。可拆卸介质911,诸如磁盘、光盘、磁光盘、半导体存储器等等,根据需要安装在驱动器910上,以便于从其上读出的计算机程序根据需要被安装入存储部分908。其中,所述处理单元901可实现为CPU、GPU、TPU、FPGA、NPU等处理单元。

特别地,根据本公开的实施方式,上文描述的方法可以被实现为计算机软件程序。例如,本公开的实施方式包括一种计算机程序产品,其包括有形地包含在机器可读介质上的计算机程序,所述计算机程序包含用于执行所述数据传输方法的程序代码。在这样的实施方式中,该计算机程序可以通过通信部分909从网络上被下载和安装,和/或从可拆卸介质911被安装。

本公开实施例还公开了一种计算机程序产品,所述计算机程序产品包括计算机程序/指令,该计算机程序/指令被处理器执行时实现上述任一方法步骤。

附图中的流程图和框图,图示了按照本公开各种实施方式的系统、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,路程图或框图中的每个方框可以代表一个模块、程序段或代码的一部分,所述模块、程序段或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现中,方框中所标注的功能也可以以不同于附图中所标注的顺序发生。例如,两个接连地表示的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,这依所涉及的功能而定。也要注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或操作的专用的基于硬件的系统来实现,或者可以用专用硬件与计算机指令的组合来实现。

描述于本公开实施方式中所涉及到的单元或模块可以通过软件的方式实现,也可以通过硬件的方式来实现。所描述的单元或模块也可以设置在处理器中,这些单元或模块的名称在某种情况下并不构成对该单元或模块本身的限定。

作为另一方面,本公开实施例还提供了一种计算机可读存储介质,该计算机可读存储介质可以是上述实施方式中所述装置中所包含的计算机可读存储介质;也可以是单独存在,未装配入设备中的计算机可读存储介质。计算机可读存储介质存储有一个或者一个以上程序,所述程序被一个或者一个以上的处理器用来执行描述于本公开实施例的方法。

以上描述仅为本公开的较佳实施例以及对所运用技术原理的说明。本领域技术人员应当理解,本公开实施例中所涉及的发明范围,并不限于上述技术特征的特定组合而成的技术方案,同时也应涵盖在不脱离所述发明构思的情况下,由上述技术特征或其等同特征进行任意组合而形成的其它技术方案。例如上述特征与本公开实施例中公开的(但不限于)具有类似功能的技术特征进行互相替换而形成的技术方案。

- 数据处理方法、装置、电子设备、存储介质及程序产品

- 数据处理方法、装置、电子设备、存储介质以及程序产品