抗人体姿态干扰的室内无人值守快速检测方法

文献发布时间:2023-06-19 09:57:26

技术领域

本发明涉及计算机智能安全监控领域,具体涉及抗人体姿态干扰的室内无人值守快速检测方法。

背景技术

随着大数据、智能化时代的来临,监控视频作为智能监控系统的核心部分,一直受到广泛的关注。视频画面中的海量数据可以借助计算机处理器强大的计算能力进行高速分析与检索,并根据需求提取视频中的关键信息,进行标记和处理,然后根据处理结果,形成相应事件和告警信息。在视频分析技术出现之前,针对大量的视频的处理,仍然主要通过人工方式进行筛选和检查,其效率相对低下(A.Kolarow et al.,"APFel:The intelligentvideo analysis and surveillance system for assisting human operators,"201310th IEEE International Conference on Advanced Video and Signal BasedSurveillance,Krakow,2013,pp.195-201.)。人为监控系统存在着许多问题,响应速度慢、漏报率高、可行性低等。因此充分发挥了视频监控的自动化和实时性,解放人工劳动力,这对安防领域乃至人们生活水平的提高有着至关重要的作用(Li-Qun Xu,"Issues in videoanalytics and surveillance systems:Research/prototyping vs.applications/userrequirements,"2007IEEE Conference on Advanced Video and Signal BasedSurveillance,London,2007,pp.10-14.)。为了满足辅助甚至是自动检索或监控视频摄像的需求,很多自动/半自动算法应运而生。

在传统的人体检测领域,通常使用经典监督机器学习方法,这种方法需要人工设计特征提取的方式,包括加速分段测试(FAST)(Rosten,Edward,and Tom Drummond."Machine learning for high-speed corner detection."European conference oncomputer vision.Springer,Berlin,Heidelberg,2006.),尺度不变特征变换(SIFT)(Lowe,David G."Distinctive image features from scale-invariant keypoints."International journal of computer vision 60.2(2004):91-110.),有效特征外观模型(AAMs)(Matthews,Iain,and Simon Baker."Active appearance models revisited."International journal of computer vision 60.2(2004):135-164.Tzimiropoulos,Georgios,and Maja Pantic."Optimization problems for fast aam fitting in-the-wild."Proceedings of the IEEE international conference on computervision.2013.)和Harris算法(Harris,Christopher G.,and Mike Stephens."A combinedcorner and edge detector."Alvey vision conference.Vol.15.No.50.1988.)等。这些方式受限于特定的应用场景,不具有很好的泛化性,而且检测速度慢,不适用于实时检测的安防监控场景。

而现有的基于卷积神经网络(Krizhevsky,Alex,Ilya Sutskever,and GeoffreyE.Hinton."Imagenet classification with deep convolutional neural networks."Communications of the ACM 60.6(2017):84-90.)的人体检测算法,并没有很好针对安保区域值班室值班人员离岗预警的场景,其往往不能有效地解决人体姿态干扰如侧身或卧趟,画面模糊、遮挡、目标过小,亦或是检测速度过慢等问题。

发明内容

本发明针对现有人体检测算法的不足,提供了抗人体姿态干扰的室内无人值守快速检测方法。本发明的目的在于有效地克服人体姿态干扰如侧身或卧趟、画面模糊,遮挡,目标过小,亦或是检测速度过慢等问题,而采用深度卷积神经网络进行检测,提供兼容现有交通监控设备并且能自动化高准确率地实现无人值守检测的方法,且能达到实时的效果,能为智能安全监控系统提供可靠的值班人员离岗预警,避免可能出现的安全事故。

本发明的目的至少通过如下技术方案之一实现。

抗人体姿态干扰的室内无人值守快速检测方法,包括以下步骤:

S1、数据收集阶段:收集图像并进行标定,生成原始训练集;

S2、数据预处理阶段:对步骤S1中收集到的图像进行预处理,实现数据扩充,生成综合扩增训练集;

S3、预训练阶段:随机选取类别数为n的非人体普通物体的图片作为数据来预训练一个物体检测的多分类模型,获得模型参数初始化值;

S4、训练阶段:将步骤S3中预训练得到的模型参数来以迁移学习的方式初始化人体检测模型的部分参数,并将人体检测模型的分类结构改为二分类;

S5、训练阶段:将步骤S2中的得到的综合扩增训练集作为输入训练集,对步骤S4中改变分类结构后的人体检测模型进行训练;

S6、测试阶段:获取待检测图像,对待检测图像进行预处理并输入步骤S5中训练完成的人体检测模型,完成抗人体姿态干扰的室内无人值守快速检测。

进一步地,步骤S1中,从实际场景的监控视频中收集大量室内值班人员值守的图像,使用矩形框对图像中的人体进行标定,要求矩形框能完全且准确地框住人体;同时记录矩形框的左上角点在图像中的位置坐标(x

进一步地,步骤S2包括以下步骤:

S2.1、对步骤S1中标定的图片随机进行缩放、平移、旋转或镜面对称的变换操作;

S2.2、对进行变换操作后的图片继续进行高斯滤波,得到扩增训练集;

S2.3、对变换前后的所有数据进行整合,最终得到综合扩增训练集。扩增的方式都是随机的改变,保证了数据来源的随机性,更符合数据的真实分布情况,训练也会更加有效,模型的泛化能力会更好,降低过拟合的风险。

进一步地,步骤S3中,使用大型公开数据集MS COCO,随机选择类别数为n的非人体普通物体的图片作为预训练数据,MS COCO数据集是微软团队公开的一个可以用于图像领域的大规模数据集;使用YOLOv3神经网络对与预训练数据进行训练,并将分类类别调整为n+1,其中n类为非人体普通物体,1类为背景,训练得到一个物体检测的多分类模型;其中,YOLO(You Only Look Once)神经网络是一个针对实时处理的物体检测系统,YOLOv3是作者公开的第三个版本;YOLOv3神经网络将输入图像分成S×S网格,每个网格单元仅预测一个对象,即某一种类的物体;每个网格单元都会预测固定数量B的边界框,每个预测的边界框均有一个对应的置信度分数;每个网格单元只检测一个对象而不管框的数量,同时预测C个条件类概率值,对应每个类别的可能性。整个预训练YOLOv3模型的流程如图2所示。

进一步地,步骤S4中,使用步骤S3中预训练得到的多分类模型,以迁移学习的方式初始化人体检测模型的参数;同时在YOLOv3模型中增加可以拟合人体躺卧姿势的anchorbox超参数,使用YOLOv3神经网络作为训练的主体框架,并将最终的分类结构改为二分类,且改用logistic分类器和二元交叉熵损失函数来替代YOLOv3神经网络原先的softmax层和损失函数,降低计算复杂度。

进一步地,除了人体检测模型最后的全连接层和softmax层,以迁移学习的方式初始化人体检测模型的参数。人体检测模型的主体是YOLOv3神经网络模型,将最后的softmax层替换为logistic分类器,具体模型结构如图3所示。

进一步地,步骤S5中,将步骤S2中得到的综合扩增训练集作为输入训练集,采用端到端的方式对步骤S4中改变分类结构后的人体检测模型进行训练。

进一步地,步骤S6中,对输入的待检测图片做放缩操作调整成步骤S5训练完成的人体检测模型的输入大小,人体检测模型处理预处理后的待检测图像输出位置信息和类别信息,完成抗人体姿态干扰的室内无人值守快速检测。

相比于现有技术,本发明的优点在于:

本发明提供的基于深度卷积神经网络的抗人体姿态干扰的室内无人值守检测方法选择实际场景下的图像作为检测目标,并通过几何仿射变换、镜像对称、高斯滤波的方式人为随机地扩增训练图片,同时在训练阶段基于YOLOv3网络引入特征金字塔思想和增加适应人体侧身和卧趟姿势的anchor box超参数等优化操作,因此可以在很大程度上克服人体姿态干扰如侧身或卧趟、画面模糊,遮挡,目标过小,亦或是检测速度过慢等问题。本发明基于深度神经网络,开发以具体场景应用为导向的解决方案,以满足实时且准确的预警需求,能够有效辅助安防人员的工作。

附图说明

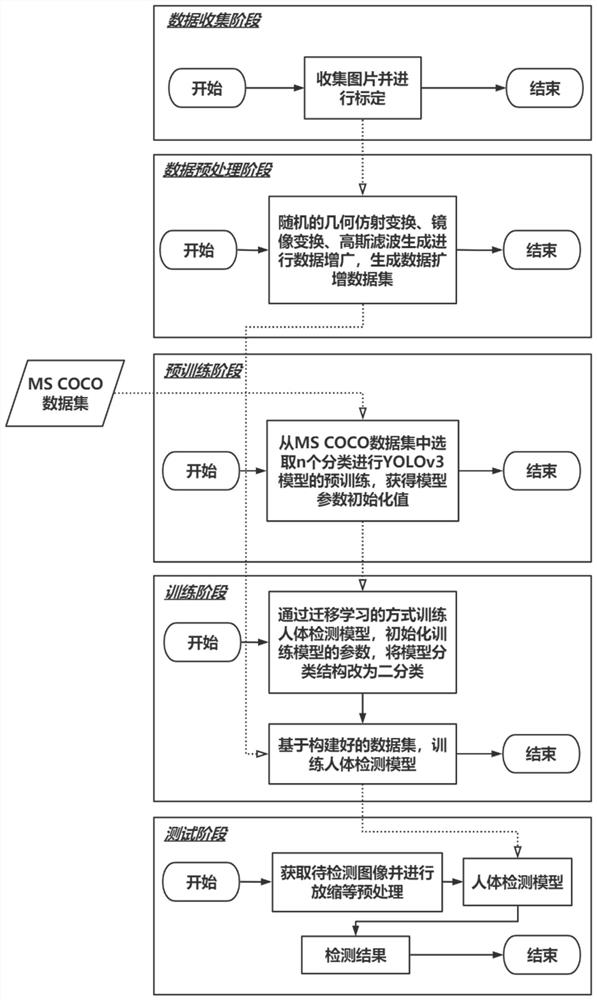

图1为本发明实施例中抗人体姿态干扰的室内无人值守快速检测方法的整体流程图;

图2为本发明实施例中预训练YOLOv3模型的流程图;

图3为本发明实施例中人体检测模型的结构图。

具体实施方式

下面将结合附图以及具体实例来详细说明本发明,但本发明的实施不限于此。

实施例:

抗人体姿态干扰的室内无人值守快速检测方法,如图1所示,包括以下步骤:

S1、数据收集阶段:收集图像并进行标定,生成原始训练集;

从实际场景的监控视频中收集大量室内值班人员值守的图像,使用矩形框对图像中的人体进行标定,要求矩形框能完全且准确地框住人体;同时记录矩形框的左上角点在图像中的位置坐标(x

S2、数据预处理阶段:对步骤S1中收集到的图像进行预处理,实现数据扩充,生成综合扩增训练集,包括以下步骤:

S2.1、对步骤S1中标定的图片随机进行缩放、平移、旋转或镜面对称的变换操作;

本实施例中,对图片做镜像对称,设原标定框左上角坐标为(x

S2.2、对进行变换操作后的图片继续进行高斯滤波,得到扩增训练集;

S2.3、对变换前后的所有数据进行整合,最终得到综合扩增训练集。扩增的方式都是随机的改变,保证了数据来源的随机性,更符合数据的真实分布情况,训练也会更加有效,模型的泛化能力会更好,降低过拟合的风险。

S3、预训练阶段:如图2所示,从MS COCO数据集中随机选取类别数为n的非人体普通物体的图片作为数据来预训练一个物体检测的多分类模型,获得模型参数初始化值;

使用大型公开数据集MS COCO,随机选择类别数为n的非人体普通物体的图片作为预训练数据,MS COCO数据集是微软团队公开的一个可以用于图像领域的大规模数据集;使用YOLOv3神经网络对与预训练数据进行训练,并将分类类别调整为n+1,其中n类为非人体普通物体,1类为背景,训练得到一个物体检测的多分类模型;其中,YOLO(You Only LookOnce)神经网络是一个针对实时处理的物体检测系统,YOLOv3是作者公开的第三个版本;YOLOv3神经网络将输入图像分成S×S网格,每个网格单元仅预测一个对象,即某一种类的物体;每个网格单元都会预测固定数量B的边界框,每个预测的边界框均有一个对应的置信度分数;每个网格单元只检测一个对象而不管框的数量,同时预测C个条件类概率值,对应每个类别的可能性。

S4、训练阶段:使用步骤S3中预训练得到的多分类模型,除了人体检测模型最后的全连接层和softmax层,以迁移学习的方式初始化人体检测模型的参数。如图3所示,人体检测模型的主体是YOLOv3神经网络模型,将最后的softmax层替换为logistic分类器。同时在YOLOv3模型中增加可以拟合人体躺卧姿势的anchor box超参数,并将最终的分类结构改为二分类,且改用logistic分类器和二元交叉熵损失函数来替代YOLOv3神经网络原先的softmax层和损失函数,降低计算复杂度。

S5、训练阶段:将步骤S2中得到的综合扩增训练集作为输入训练集,采用端到端的方式对步骤S4中改变分类结构后的人体检测模型进行训练;

本实施例中,将人体检测模型中的权值初始化选择标准方差为0.1的截断正态分布(Truncated Normal Distribution),选择参数优化方法为Adam,初始学习设定为0.01,权值衰减率参数设定为0.0005,学习率改变速度参数设定为0.1。

利用类似特征金字塔网络的特征金字塔思想,人体检测模型的网络中以3种不同的尺度进行预测,第一尺度是在最后一个特征图上进行第一组预测;第二尺度是从第一尺度的层向后倒回两层,并将第一尺度的特征图两倍上采样,然后采用具有更高分辨率的特征图于上采样的特征图进行逐元素相加,在合并的特征图上进行第二组预测;第三尺度是重复上面的过程,得到更高分辨率的特征图(具有更高级的语义信息和空间位置信息)进行第三组预测。

使用难例挖掘(Hard Example Mining)的方式,在目标检测中会事先标记标定框,然后在算法中会生成一系列似然,这些似然有跟标记的标定框有部分是重合的也有部分是没重合的,把重合度超过一定阈值(通常0.5)的判定为正样本,其他的则判定为负样本,然后扔进人体检测模型的网络中训练。但是,这么做的话可能会导致一个问题,就是正样本的数量会远小于负样本的数量,这样训练出来的分类器的效果总是有限的,会出现许多假阳性,把其中得分较高的这些假阳性视为难例,既然挖掘出了这些难例,就把这些扔进人体检测模型的网络再训练一次,从而加强分类器判别假阳性的能力。

S6、测试阶段:获取待检测图像,对待检测图像进行预处理,对输入的待检测图片做放缩即放大或缩小操作调整成步骤S5训练完成的人体检测模型的输入大小,例如448*448*3,表示图片的长*宽*通道,人体检测模型处理预处理后的待检测图像输出位置信息和类别信息,完成抗人体姿态干扰的室内无人值守快速检测。

- 抗人体姿态干扰的室内无人值守快速检测方法

- 基于无人机的抗外界环境温度干扰的人体温度检测方法