一种基于掩码的深度学习视频去摩尔纹方法

文献发布时间:2023-06-19 10:27:30

技术领域

本发明属于计算机视觉领域,具体涉及一种基于掩码的深度学习视频去摩尔纹方法。

背景技术

摩尔纹是两个空间频率接近时产生的干扰图案,该干扰图案是不规则的条纹,摩尔纹图像。由于其形状不规则、颜色各异、频率分布范围广,因此很难被去除。目前去除摩尔纹方法主要有两种,一种是传统方法,Liu提出一种低祗和稀疏矩阵分解方法来去除高频图像上的摩尔纹图案,这种利用摩尔纹图像的频率和空间特性进行处理只能去除高频摩尔纹,一些低频摩尔纹难以被去除并且容易造成图像过平滑,细节模糊。另一种方法是采用神经网络进行有监督的学习,通过学习摩尔纹图像和干净图像之间的映射关系,最终实现输出干净的图像。随着Sun等人提出采用卷积神经网络去除摩尔纹,去摩尔纹领域开始广泛使用深度学习的方法,而Gao等人提出的多尺度特征框架增强语义信息,但是他们提出的方法网络结构不强,特征表达能力弱,无法充分提取输入图像的特征。Bolin等人提出基于深度卷积网络的去摩尔纹方法可以有效去除大部分摩尔纹,但是他们仅使用低分辨率作为输入,且只能在单个频带上处理摩尔纹。现有的各种尝试虽取得一定的效果,但是无法很好的运用在实际工程中。

目前很多图像算法在处理单个图像的时候表现优异的效果,但将其直接用于视频往往会遇到时域不一致的问题,导致视频中出现闪烁的现象。为了提高时域的一致性,大多数研究者针对不同视频处理任务设计了专用的算法改善时域一致性。如Lei提出的方案针对视频上色,而Shocher所提出的方案针对视频超分,不具备通用性。Bonneel等人提出通过最小化输出和处理后的视频在梯度域上的距离以及两个连续输出帧之间的距离来改善这一问题,但这是建立在输出和处理后的视频在梯度域上是相似的,而这在现实情况下时不可能的。此外,有很多学者尝试使用卷积神经网络改善时域不一致问题,但随着训练的进行其性能会逐渐降低。

发明内容

有鉴于此,本发明的目的在于提供一种基于掩码的深度学习视频去摩尔纹方法,可以更简单地实现时域一致性,并得到去摩尔纹效果更好的视频。

为实现上述目的,本发明采用如下技术方案:

一种基于掩码的深度学习视频去摩尔纹方法,包括以下步骤:

步骤S1:获取高清图像和摩尔纹图像的成对图像,并对数据进行增强,构建图像数据集;

步骤S2:构建两阶段的U-Net网络模型,并基于图像数据集进行训练,得到图像消除摩尔纹模型;

步骤S3:将待处理视频逐帧图像输入图像消除摩尔纹模型,得到的消除了摩尔纹的图像;

步骤S4:将原始视频图像帧和经过图像消除摩尔纹模型得到的消除了摩尔纹的视频图像帧作为输入,通过所述的卷积神经网络,获得输出的时域对齐的视频图像帧,最后合成输出的时域对齐的视频图像帧,得到时域一致的完整视频。

进一步的,所述数据增强包括对图像进行裁剪和旋转操作。

进一步的,所述两阶段的U-Net网络模型包括生成掩码的模型和去摩尔纹网络模型。

进一步的,所述生成掩码的模型包括编码器部分和解码器部分;

所述编码器部分,将训练集中的摩尔纹图像输入编码器网络执行特征提取阶段,最终得到mask图像,具体步骤详情如下:

特征提取阶段包含三大块卷积层,三个卷积块可以由以下公式表示是:

下采样:

input=conv_R{conv_R(I

F1=conv_R{conv_R{DOWN(input)}} (2)

F2=conv{conv_R{conv_R{DOWN(F1)}}} (3)

Im=I

其中,Im表示高清图像与摩尔纹图像的差值,conv_R表示一个卷积层加一个激活函数RELU,conv表示一个卷积层,DOWN表示下采样,F表示特征提取阶段得到的输出结果,摩尔纹图像经过不同程度的卷积学习了深层次的特征。

上采样:

F3=conv{conv_R{conv_R{UP(F2)+F1}}} (5)

I

解码器部分由上采样组成,下采样经过学习以后再经过上采样恢复为原图大小,上采样用反卷积实现,最后得到I

进一步的,所述去摩尔纹网络模型采用多分辨率去摩尔纹的网络结构,构造一个自下而上的结构,将细特征融合到粗特征中,具体为:

下采样:

input=conv_R{conv_R{C(I

S1=conv_R{conv_R{DOWN(input)}} (8)

S2=conv_R{conv_R{DOWN(S1)}} (9)

S3=conv{conv_R{conv_R{DOWN(S2)}}} (10)

上采样:

S4=conv{conv_R{conv_R{UP(S3)+S2}}} (11)

S5=conv{conv_R{conv_R{UP(S4)+S1+S2}}} (12)

output=conv_R{conv_R{UP(S5)+input+S2+S1}}} (13)

其中,S表示各个阶段提取到的特征图。

进一步的,所述生成掩码的模型损失函数表示为:

L

去摩尔纹网络模型损失函数表示为:

L

两个网络均采用L

进一步的,所述模型训练采用渐进训练策略,将训练过程分为多个子训练周期,依次进行子训练周期的训练,训练开始时以大学习率开始训练,且每迭代完一个子训练周期逐步减小学习率,直至迭代完成。

本发明与现有技术相比具有以下有益效果:

本发明可以更简单地实现时域一致性,并得到去摩尔纹效果更好的视频。

附图说明

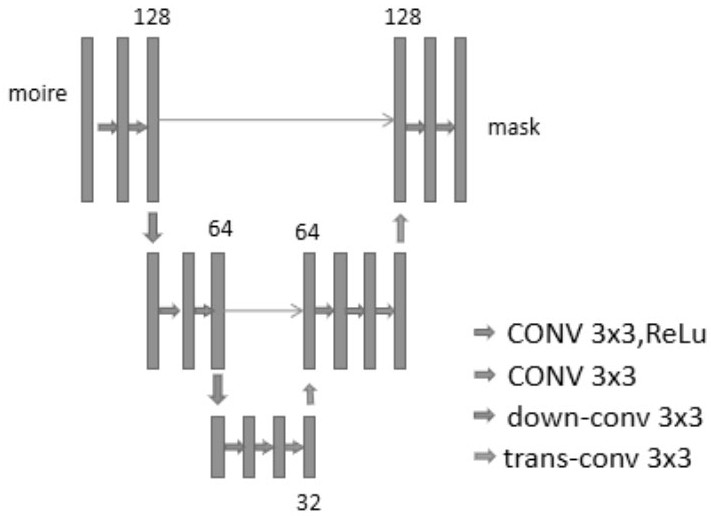

图1是本发明一实施例中生成掩码的网络结构;

图2是本发明一实施例中的生成掩码的效果图;

图3是本发明一实施例中的生成掩码的对比图;

图4是本发明一实施例中去摩尔纹网络结构;

图5是本发明一实施例中预测掩码效果图;

图6是本发明一实施例中去摩尔纹效果图;

图7是本发明一实施例中去摩尔纹对比图;

图8是本发明一实施例中视频去摩尔纹网络结构。

具体实施方式

下面结合附图及实施例对本发明做进一步说明。

本发明提供一种基于掩码的深度学习视频去摩尔纹方法,包括以下步骤:

步骤S1:获取高清图像和摩尔纹图像的成对图像,并对数据进行增强,构建图像数据集;

步骤S2:构建两阶段的U-Net网络模型,并基于图像数据集进行训练,得到图像消除摩尔纹模型;

步骤S3:将待处理视频逐帧图像输入图像消除摩尔纹模型,得到的消除了摩尔纹的图像;

步骤S4:将原始视频图像帧和经过消除摩尔纹模型得到的消除了摩尔纹的图像帧作为输入,通过所述卷积神经网络,获得输出的时域对齐的视频图像帧。最后,合成输出的时域对齐的视频图像帧,得到最终时域一致的完整视频。

在本实施例中,选取大量的I

优选的,生成掩码的模型包括编码器部分和解码器部分:

述编码器部分,掩码网络中,编码器部分,将训练集中的摩尔纹图像输入编码器网络执行特征提取阶段,得到特征图,经过优化最终得到逼近于真实掩码的图像,具体步骤详情如下:

特征提取阶段包含三大块卷积层,三个卷积块可以由以下公式表示是:

下采样:

input=conv_R{conv_R(I

F1=conv_R{conv_R{DOWN(input)}} (2)

F2=conv{conv_R{conv_R{DOWN(F1)}}} (3)

I

其中,I

上采样:

F3=conv{conv_R{conv_R{UP(F2)+F1}}} (5)

I

解码器部分由上采样组成,下采样经过学习以后再经过上采样恢复为原图大小,上采样用反卷积实现,最后得到I

在本实施例中,在步骤一中得到掩码模型后导入去摩尔纹网络用以预测摩尔纹图像的掩码,去摩尔纹网络模型采用多分辨率去摩尔纹的网络结构,包括了三条平行的分支,每个分支学习原始分辨率的

下采样:

input=conv_R{conv_R{C(I

S1=conv_R{conv_R{DOWN(input)}} (8)

S2=conv_R{conv_R{DOWN(S1)}} (9)

S3=conv{conv_R{conv_R{DOWN(S2)}}} (10)

上采样:

S4=conv{conv_R{conv_R{UP(S3)+S2}}} (11)

S5=conv{conv_R{conv_R{UP(S4)+S1+S2}}} (12)

output=conv_R{conv_R{UP(S5)+input+S2+S1}}} (13)

其中,S表示各个阶段提取到的特征图。网络中充分利用了skip-connection连接不同频带之间的特征图,一是可以防止梯度爆炸,二是将不同分支输出特征图相加,充分利用不同频带的摩尔纹特征,增强图像信息。

优选的,在本实施例中,所述生成掩码的模型利用I

L

在此使用的L

I表示每一个像素点,由于图像是RGB的彩色图像,因此计算损失函数时需要对图像三个通道各个像素点分别计算其损失值。

去摩尔纹网络模型利用输出的去摩尔纹图像I

L

两个网络均采用L

优选的,在本实施例中,模型训练采用渐进训练策略,将训练过程分为多个子训练周期,训练开始时以大学习率训练,在训练初期学习率大,学习相对较快。但是随着学习的进行,我们希望曲线在一个最小值附近的区域摆动,而不是大幅度的在最小值附近摆动,因此我们在每迭代完一个训练周期逐步减小学习率,使曲线可以在小区域范围内摆动,直至迭代完成。。

实施例1:

在本实施例中采用了一种利用视频深度先验的方法来解决时域不一致的问题。因为利用视频帧来训练卷积网络的过程中,视频不同帧之间的对应图像块的网络预测输出倾向于一致,所以可以通过将原始视频图像帧和经过图像去摩尔纹模型处理后的视频帧输入一个卷积网络,达到稳定时域的目的。

本实施例中,采用一种简单的框架,利用深度视频先验,通过在视频上训练卷积神经网络得到去摩尔纹视频。整体结构图如图8所示,由图可知,单张输入视频帧I

与以往的方法不同的是,我们的训练只需要单个视频无需训练集,且每次迭代使用单个帧对其进行优化:

其中,L

L

其中p代表图像是P维向量。

损失函数我们采用Perceptual Loss。该损失函数可以表示为:

其中,j表示网络的第j层,C

以上所述仅为本发明的较佳实施例,凡依本发明申请专利范围所做的均等变化与修饰,皆应属本发明的涵盖范围。

- 一种基于掩码的深度学习视频去摩尔纹方法

- 基于深度学习的图像去摩尔纹方法