一种针对上消化道内镜影像的病灶自动留图方法

文献发布时间:2023-06-19 11:52:33

技术领域

本发明涉及医疗辅助技术领域,尤其涉及一种针对上消化道内镜影像的病灶自动留图方法。

背景技术

内镜报告是一种应用广泛的医学图文报告形式,是一种方便患者储存、方便医师查阅的直观完整的消化内镜检查总结性文件。内镜报告是疾病的诊治随访、会诊交流、医疗鉴定等场景的客观依据。

在上消化道内镜检查过程中,内镜医师通过按下“采图”按钮或踩下“采图”脚踏板以记录检查所见,所有采集到的图片都以图库的形式保存在图文工作站中。内镜医师会查阅和回顾采图图库,以形成最终的总结性内镜检查图文报告。内镜检查图文报告的信息来源于采图图库,而其质量取决于采图图库的综合质量。目前,多部指南提出对消化内镜检查报告的质量控制意见,要求内镜下照片记录应完整包含全部解剖学标志性部位及异常病灶图片;但对于图片综合质量并未进行控制。临床实际环境中,由于不同内镜医师工作经验、工作习惯和临床环境等因素的干扰,人工记录方式通常存在漏洞,存在图库中病灶图片遗漏、采集图片不清晰等问题。内镜医师留图的质量和有效性差距大,不利于内镜图文报告质量的高水平同质化。

近年来人工智能技术在消化内镜领域取得了长足进展。深度学习技术,作为图像识别领域的强有力工具,已经被应用于消化内镜疾病诊断的方方面面,并显示出巨大的诊断和辅助潜力。人工智能设备具有自主采集图片的能力,但其存在盲目性和可变性。通过一套完备设计的病灶留图算法,有望实现人工智能稳定地、自动地生成高质量内镜图文报告。为此,我们提出一种针对上消化道内镜影像的病灶自动留图方法。

发明内容

基于背景技术存在的技术问题,本发明提出了一种针对上消化道内镜影像的病灶自动留图方法,实现自动稳定地留存上消化道异常病灶的高质量图片,并对其进行部位快速定位,以便医生回溯查验,解决了现有技术中内镜医师留图的质量和有效性差距大,不利于内镜图文报告质量的高水平同质化的问题。

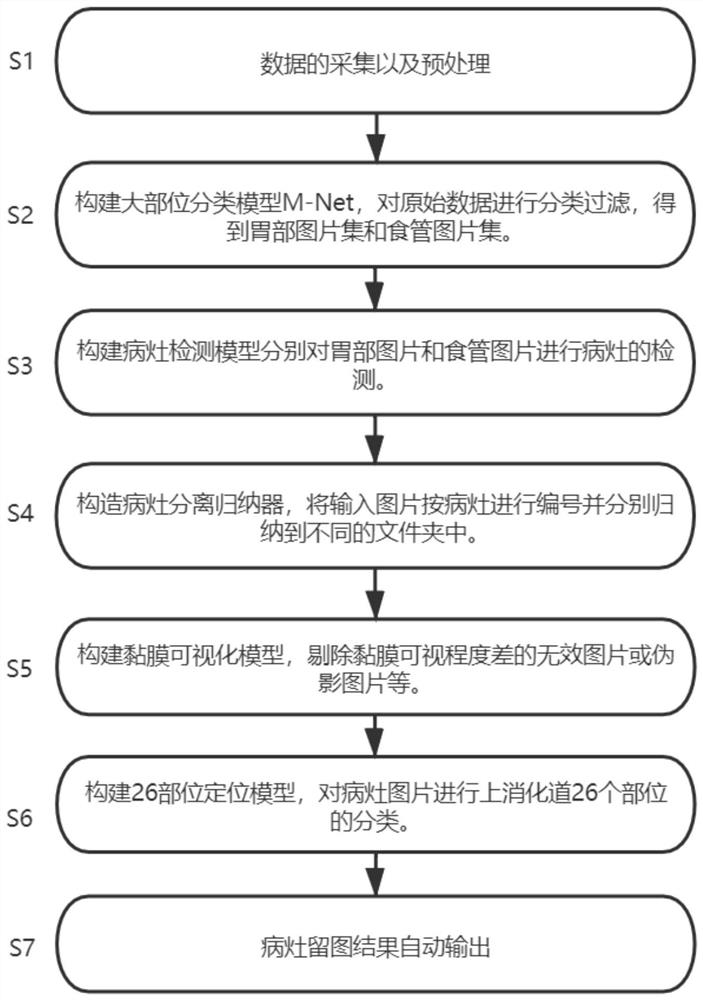

本发明提供如下技术方案:一种针对上消化道内镜影像的病灶自动留图方法,包括如下步骤:

S1、消化道数据采集及预处理;

S2、构建大部位分类模型M-Net,对原始数据进行分类过滤,得到胃部图片集和食管图片集;

S3、构建病灶检测模型分别对胃部图片和食管图片进行病灶的检测;

S4、构建病灶分离归纳器,将输入图片按病灶进行编号并分别归纳到不同的文件夹中;

S5、构建黏膜可视化模型,剔除黏膜可视化程度差的无效图片或伪影图片;

S6、构建26部位定位模型,对病灶图片进行上消化道26个部位的分类定位;

S7、病灶结果自动输出。

优选的,所述步骤S1中通过内镜检查设备获取胃镜视频,将视频解码为图片,并进行尺寸归一化预处理,仅保留图片的结构信息。

优选的,所述步骤S2中将原始数据分为三大类:胃部图片、食管图片、屏蔽图片;其中十二指肠部位图片纳入胃部图片一并分析,屏蔽图片经过滤后舍弃。

优选的,所述步骤S3中胃部图片和食管图片分别输入胃-Yolov3模型和食管-Yolov3模型进行病灶的检测。

优选的,所述步骤S4中基于步骤S3的病灶检测模型,将其输出的单张图片结果输入病灶分离归纳器,根据时序信息判断是否被激活,每一个激活时间段内的所有病灶图片被认为是同一病灶。

优选的,所述步骤S5中利用黏膜可视化模型对病灶图片进行过滤,用于剔除机器采集到的黏膜可视化差的无效图片或伪影图片。

优选的,所述步骤S7中每张病灶图片根据步骤S3的病灶检测模型、步骤S5的黏膜可视化模型和步骤S6的26部位定位模型的输出结果进行置信度加权排序,输出值最高的图片。

本发明提供了一种针对上消化道内镜影像的病灶自动留图方法,基于对上消化道内镜实时获取的视频进行图像分帧,利用M-Net模型,对食管与胃部两个不同场景下的病灶进行精确检测,通过本发明的病灶激活逻辑,避免了病灶检测模型假阳性带来的影响,提高了病灶实时检测的准确度,避免了内镜医师在采图时可能发生的遗漏和误留,降低了内镜医师在上消化道内镜检查过程中的漏诊率与误诊率,最终有助于提升内镜医师诊断报告的质量。

附图说明

图1为本发明原理示意图;

图2为本发明方法流程图;

图3为本发明尺寸归一化示意图;

图4为M-Net模型结构示意图;

图5为病灶检测模型结构示意图;

图6为病灶分离归纳器示意图;

图7为黏膜可视化模型结构示意图;

图8为26部位定位模型结构示意图;

图9为自动留图方法结果可视化。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

请参阅图1和2所示,本发明提供一种技术方案:一种针对上消化道内镜影像的病灶自动留图方法,

S1、数据的采集以及预处理。通过内镜检查设备获取胃镜视频,将视频按每秒7帧解码为图片集并进行尺寸归一化等预处理:长宽比不相同的图像补黑边统一为正方形,再缩放到360*360像素大小,仅保留图片的结构信息。如图3所示的尺寸归一化示意图。

S2、构建大部位分类模型M-Net,将整个上消化道图像分为食管部、胃部两个部分,其中贲门部图片纳入食管部,十二指肠部图片纳入胃部一并分析。

①数据集的准备:由专业医师对内镜图片进行分类标记,标签为:胃部图片、食管图片、屏蔽图片。再进行预处理,缩放到224*224尺寸。

②模型的构建与训练:作为优先的,以ResNet50为基础神经网络结构,最后一层池化层将由全局平均池化改为最大池化,激活函数采用Softmax。如图4所示,M-Net的损失函数采用多元交叉熵损失:

其中m为输入样本数,n为类别数,模型预测值为Y,真实值为

M-Net输出的结果是一个多维列向量,每个维度对应一个类别的概率,概率值越大表示该图像越有可能属于这一类别。

基于步骤S1的结果,输入M-Net模型中进行三分类,每张图片的输出结果为:胃部图片、食管图片、屏蔽图片。屏蔽图片经过滤后舍弃(如体外图片、口咽部图片及太模糊导致无法辨识部位和病灶的图片),保留胃部图片集和食管图片集。

S3、构建病灶检测模型对病灶进行检测并框取。如图5所示。

①数据集的准备:由专业医师对胃部图片和食管图片中的病灶区域进行标记,保存病灶类别以及矩形框坐标信息为xml文件,原始图片统一缩放到352*352尺寸,一个xml文件与对应的jpg图片作为一对训练数据。

②模型的构建与训练:作为优先的,以Yolov3模型为基础网络结构,模型的输入为352*352,经过Darknet-53特征网络进行特征提取,输出3个通道的预测值,分别对应预测大中小三种不同尺度的目标。

病灶检测模型的损失函数分为三个部分组成:

Loss=lbox+lobj+lcls

(1)坐标计算部分带来的误差,也就是bbox带来的loss:

其中S×S是网格大小,每个网格产生的候选框个数为B,

为了将目标与anchor之间的距离,重叠率以及尺度都考虑进去,将IoU损失改进为CIoU损失,如下所示:

其中α是权重函数,v是度量长宽比的相似性参数,ρ表示欧氏距离,b表示中心点,c表示最小外接矩形的对角线距离。

(2)置信度带来的误差,也就该bounding box中是否含有物体的概率:

(3)类别带来的误差,也就是类别带来的loss:

基于步骤S2得到的胃部图片集和食管图片集,作为输入分别进入胃-Yolov3模型和食管Yolov3模型,每张图片可得到0或1的预测结果,0代表无病灶,1代表有病灶。

S4、构造病灶分离归纳器。如图6所示,基于步骤S3的病灶检测模型输出结果,根据时序信息判断连续10张图片若有7张判定为1,则开始进入病灶激活时间段,处于病灶激活时间段内的所有图片将被认为是同一病灶的观察时段。若连续10张图片有7张判定为0,则退出病灶激活时间段。不被激活的时间段内预测结果为1的图片被认定为假阳性舍弃。每个激活时间段内的全部图片按病灶编号并分别归纳到不同的文件夹中。

S5、构建黏膜可视化模型对每张图片进行黏膜可视程度的评价,目的是剔除机器采集到的无法分析的无效图片等。如图7所示。

①数据集的准备:由专业医师对内镜图片进行分类标记,标签为:无效图片、有效图片。对原始图片统一缩放到224*224尺寸。

②模型的构建与训练:作为优先的,采用ResNet34作为基础神经网络结构,模型的输入为224*224,对输入进行卷积处理,经过了一系列的Building block模块后,最后进入全连接层,采用Sigmoid激活函数激活,输出二分类结果0或1。HL-Net的损失函数采用二元交叉熵损失:

其中m为输入样本数,模型预测值为Y,真实值为

基于步骤S4的输出结果,输入黏膜可视化模型中,每张图片的输出结果为有效图片或无效图片,仅保留每个病灶文件夹中的有效图片。

S6、构建26部位定位模型,对上消化道进行精确部位的分类。如图8所示。

①数据集的准备:由专业医师对内镜图片进行分类标记,标签为上消化道26个部位类型。对原始图片统一缩放到224*224尺寸。

②模型的构建与训练:作为优先的,采用ResNet50作为基础神经网络结构,使用Softmax激活函数将维度降低到类别数,向量的每一维度的值代表对应类别的概率,范围0~1,最高值对应的类别为预测的部位类别。

基于步骤S5的输出结果,去模糊后的病灶图片输入26部位模型中进行上消化道的26个部位分类,每张图片的输出结果为一个部位类别序号以及其置信度值。

S7、基于步骤S3的病灶检测模型输出、步骤S5的黏膜可视化模型输出和步骤S6的26部位定位模型输出,进行加权排序,每个病灶文件夹取加权后置信度C

其中C

为了验证本发明的鲁棒性,取100例视频由专家对留图结果进行评价,病灶漏查率仅为0.3%;病灶留图结果的质量高,图片重复率及模糊率仅为4%;平均每例节约内镜医师完成内镜报告的时间26s。

本发明基于对上消化道内镜实时获取的视频进行图像分帧,利用M-Net模型,对食管与胃部两个不同场景下的病灶进行精确检测,通过本发明的病灶激活逻辑,避免了病灶检测模型假阳性带来的影响,提高了病灶实时检测的准确度,避免了内镜医师在采图时可能发生的遗漏和误留,降低了内镜医师在上消化道内镜检查过程中的漏诊率与误诊率,最终有助于提升内镜医师诊断报告的质量;

本发明还将规范内镜医师检查报告的完整性和有效性,由于病灶图片输入病灶分离归纳器后,可根据时序信息将不同时刻观察到的病灶独立分开进行归纳,避免了同一病灶的重复留图,并在每一处病灶观察时按置信度加权方法可留下病灶角度最好、质量最清晰的图像,提高了内镜医师在打印检查报告时选择的多样性以及选图的效率;

本发明还将对上消化道异常病灶的所属部位进行精确定位,以供内镜医师在回溯报告时快速了解病灶的位置,在复查时可以针对性对重点部位进行观察,有助于提高内镜医师复查的效率,巩固检查报告的指导治疗价值及随访价值,缓解医院内镜医师资源紧张的问题。

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其发明构思加以等同替换或改变,都应涵盖在本发明的保护范围之内。

- 一种针对上消化道内镜影像的病灶自动留图方法

- 一种医学影像针对病灶区域分割方法