一种基于神经网络的建模方法及装置

文献发布时间:2023-06-19 11:14:36

技术领域

本发明涉及神经网络技术领域,尤指一种基于神经网络的建模方法及装置。

背景技术

循环神经网络(Recurrent Neural Network,RNN),相对全连接神经网络和卷积神经网络,能更好地提取时间序列前后之间的关系而得到广泛应用。

如图9所示,一个简单的循环神经网络(图9的左边部分)由输入层、一个隐藏层和一个输出层组成:x是一个向量,表示输入层的值;h是一个向量,表示隐藏层的值(或状态);o也是一个向量,表示输出层的值;U是输入层到隐藏层的权重矩阵,V是隐藏层到输出层的权重矩阵。

把图8的左边部分展开得到右边部分,可以看出隐藏层是循环层,网络在t时刻接收到输入x

其中,h

但是RNN网络在梯度反向传播中存在梯度消失问题。

权重矩阵W最终的梯度是各个时刻的梯度之和。如图10所示,从t-3时刻开始,梯度几乎减少到0(即梯度消失)。那么,从这个时刻开始再往前走,得到的梯度(几乎为零)就不会对最终的梯度值有任何贡献,这相当于无论t-3时刻之前的网络状态h是什么,在训练中都不会对权重数组W的更新产生影响,也就是网络事实上已经忽略了t-3时刻之前的状态。这就是RNN无法处理长距离依赖的原因。

为了缓解上述问题,现有技术中对RNN进行改进,得到循环神经网络的变形结构,如长短期记忆网络(Long Short Term MemoryNetwork,LSTM)和门控循环单元(GatedRecurrent Unit,GRU)。但是RNN及其改进仍然存在记忆能力不足和梯度反向传播困难等问题,这些问题将制约这些算法的应用。

发明内容

本发明的目的是提供一种基于神经网络的建模方法及装置,用于解决现有技术中存在的循环神经网络记忆能力不足和梯度反向传播困难的问题。

本发明提供的技术方案如下:

一种基于神经网络的建模方法,包括:至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构;按照预设规则将所有时刻分为增强时刻和非增强时刻;若当前时刻为非增强时刻,则根据当前时刻的前一时刻的状态,得到所述隐藏层在所述当前时刻的状态;若当前时刻为增强时刻,则根据当前时刻的前一时刻和前L个时刻的状态,L为第二预设数目,得到所述隐藏层在所述当前时刻的状态。

进一步地,所述的按照预设规则将所有时刻分为增强时刻和非增强时刻包括:以第一预设数目为周期设置增强时刻。

进一步地,所述第一预设数目等于所述第二预设数目。

进一步地,所述的根据当前时刻的前一时刻和前L个时刻的状态,得到所述隐藏层在所述当前时刻的状态,包括:根据当前时刻的前一时刻的状态,得到第一记忆值;将所述第一记忆值与所述当前时刻的前L个时刻的状态相加,得到所述隐藏层在所述当前时刻的状态。

进一步地,所述隐藏层采用循环神经网络RNN结构;根据以下公式得到第一记忆值M:

M=f(U*x

其中,x

根据以下公式得到所述隐藏层在当前时刻的状态:

其中,h

进一步地,所述隐藏层采用长短期记忆网络LSTM结构;根据以下公式得到第一记忆值N:

f

i

o

其中,h

根据以下公式得到所述隐藏层在当前时刻的状态:

其中,h

进一步地,所述隐藏层采用门控循环单元GRU结构;根据以下公式得到第一记忆值Q:

r

z

其中,W

根据以下公式得到所述隐藏层在当前时刻的状态:

其中,h

本发明还提供一种基于神经网络的建模装置,包括:至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构;时刻区分单元,用于按照预设规则将所有时刻分为增强时刻和非增强时刻;状态更新单元,用于根据每个非增强时刻的前一时刻的状态,得到所述隐藏层在所述非增强时刻的状态;根据每个增强时刻的前一时刻和前L个时刻的状态,得到所述隐藏层在所述增强时刻的状态。

进一步地,所述时刻区分单元,还用于以第一预设数目为周期设置增强时刻。

进一步地,所述状态更新单元,还用于根据当前时刻的前一时刻的状态,得到第一记忆值;将所述第一记忆值与所述当前时刻的前L个时刻的状态相加,得到所述隐藏层在所述当前时刻的状态。

通过本发明提供的一种基于神经网络的建模方法及装置,至少能够带来以下有益效果:

本发明通过优化传统RNN网络的结构,改善了基于循环神经网络的模型的记忆能力不足和梯度反向传播困难等问题,提高了模型预测的准确性。

附图说明

下面将以明确易懂的方式,结合附图说明优选实施方式,对一种基于神经网络的建模方法及装置的上述特性、技术特征、优点及其实现方式予以进一步说明。

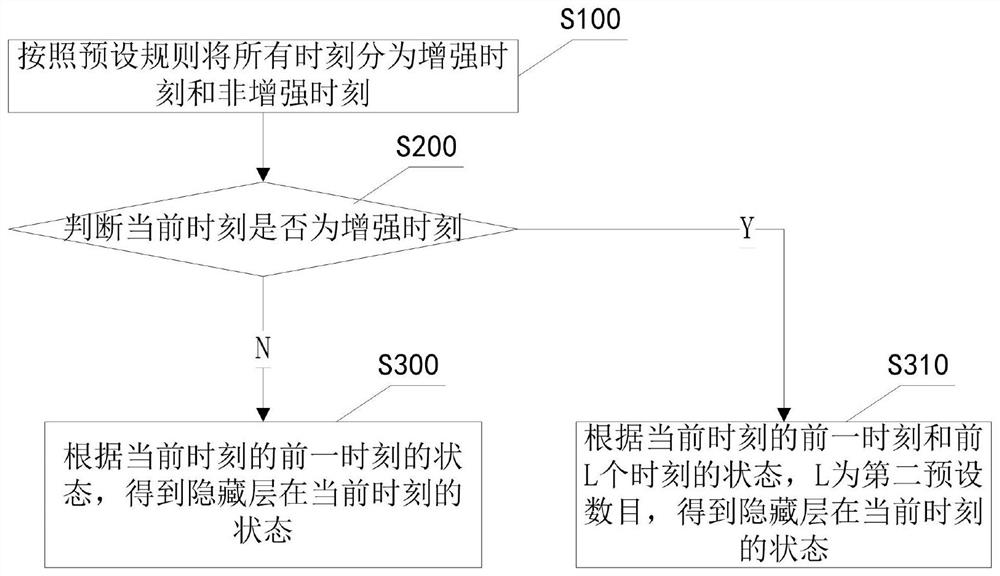

图1是本发明的一种基于神经网络的建模方法的一个实施例的流程图;

图2是图1中一种改进的循环神经网络结构的示意图;

图3是本发明的的一种基于神经网络的建模装置的一个实施例的结构示意图;

图4是将本发明提供的基于神经网络的建模方法和装置应用于心率分析模型的构建流程示意图;

图5是不同skip参数下心率分析模型的第一个隐藏层输出信号的均值、方差曲线图;

图6是不同skip参数下心率分析模型的第二个隐藏层输出信号的均值、方差曲线图;

图7是不同skip参数下心率分析模型的第三个隐藏层输出信号的均值、方差曲线图;

图8是不同skip参数下心率分析模型在训练过程中准确率和损失函数的变化情况示意图;

图9是传统RNN的结构图;

图10是传统RNN的各时刻的梯度以及最终的梯度之和的一种示意图。

具体实施方式

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对照附图说明本发明的具体实施方式。显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图,并获得其他的实施方式。

为使图面简洁,各图中只示意性地表示出了与本发明相关的部分,它们并不代表其作为产品的实际结构。另外,以使图面简洁便于理解,在有些图中具有相同结构或功能的部件,仅示意性地绘制了其中的一个,或仅标出了其中的一个。在本文中,“一个”不仅表示“仅此一个”,也可以表示“多于一个”的情形。

本发明的一个实施例,如图1所示,一种基于神经网络的建模方法,包括:

至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构。

步骤S100按照预设规则将所有时刻分为增强时刻和非增强时刻。

步骤S200判断当前时刻是否为增强时刻;

步骤S300若当前时刻为非增强时刻,则根据当前时刻的前一时刻的状态,得到隐藏层在当前时刻的状态;

步骤S310若当前时刻为增强时刻,则根据当前时刻的前一时刻和前L个时刻的状态,L为第二预设数目,得到隐藏层在当前时刻的状态。

具体地,模型包括输入层、隐藏层和输出层,可以有一个或多个隐藏层,至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构。

传统的循环神经网络(RNN或LSTM或GRU),其当前状态h

为了解决这个问题,对采用传统的循环神经网络结构的隐藏层进行改进:

将隐藏层的所有时刻分为增强时刻和非增强时刻。对于非增强时刻,仍然按照传统的循环神经网络算法计算隐藏层的状态,即根据隐藏层在前一时刻的状态h

可选地,按照传统的循环神经网络算法根据隐藏层在前一时刻的状态h

为了不过于增加计算的负担,并不是每个时刻都需要增强记忆,可按预设规则设置增强时刻。可选地,以第一预设数目为周期设置增强时刻。比如,当第一预设数目等于3时,表示每间隔3个时刻增强一次记忆。

可将第一预设数目等于第二预设数目。为了进一步减小运算量的增加,也可设置第一预设数目大于第二预设数目。

如图2所示,假设L等于3,将状态h

本实施例,优化了传统循环神经网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模方法,包括:

隐藏层采用循环神经网络RNN的结构。

步骤S10根据以下公式得到第一记忆值M;

M=f(U*x

其中,x

步骤S11根据以下公式得到隐藏层在当前时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。t=a+i×skip表明t为增强时刻,其他t为非增强时刻。比如a=1,则t=1+i×skip时表明t为增强时刻,其他时刻为非增强时刻,a也可以为其他正整数值,比如2、3等,本实施例对此不做限制。

M是按照传统的RNN网络根据隐藏层在前一时刻的状态h

本实施例优化了传统RNN网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模方法,包括:

隐藏层采用长短期记忆网络LSTM的结构。

步骤S20根据前一时刻的状态h

f

i

o

其中,W

步骤S21根据以下公式得到隐藏层在当前时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。t=a+i×skip表明t为增强时刻,其他t为非增强时刻。比如a=1,则t=1+i×skip时表明t为增强时刻,其他时刻为非增强时刻,a也可以为其他正整数值,比如2、3等,本实施例对此不做限制。

N是按照传统的LSTM网络根据隐藏层在前一时刻的状态h

本实施例优化了传统LSTM网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模方法,包括:

隐藏层采用门控循环单元GRU结构。

步骤S30根据前一时刻的状态h

r

z

其中,W

步骤S31根据以下公式得到隐藏层在当前时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。t=a+i×skip表明t为增强时刻,其他t为非增强时刻。比如a=1,则t=1+i×skip时表明t为增强时刻,其他时刻为非增强时刻,a也可以为其他正整数值,比如2、3等,本实施例对此不做限制。

Q是按照传统的GRU网络根据隐藏层在前一时刻的状态h

本实施例优化了传统GRU网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的一个实施例,如图3所示,一种基于神经网络的建模装置,包括:

至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构。

时刻区分单元100,用于按照预设规则将所有时刻分为增强时刻和非增强时刻;

状态更新单元200,用于判断当前时刻是否为增强时刻;若当前时刻为非增强时刻,则根据当前时刻的前一时刻的状态,得到隐藏层在当前时刻的状态;若当前时刻为增强时刻,则根据当前时刻的前一时刻和前L个时刻的状态,L为第二预设数目,得到隐藏层在当前时刻的状态。

具体地,模型包括输入层、隐藏层和输出层,可以有一个或多个隐藏层,至少有一个隐藏层采用循环神经网络RNN或长短期记忆网络LSTM或门控循环单元GRU的结构。

传统的循环神经网络(RNN或LSTM或GRU),其当前状态h

为了解决这个问题,对采用传统的循环神经网络结构的隐藏层进行改进:

将隐藏层的所有时刻分为增强时刻和非增强时刻。对于非增强时刻,仍然按照传统的循环神经网络算法计算隐藏层的状态,即根据隐藏层在前一时刻的状态h

可选地,按照传统的循环神经网络算法根据隐藏层在前一时刻的状态h

为了不过于增加计算的负担,并不是每个时刻都需要增强记忆,可按预设规则设置增强时刻。可选地,以第一预设数目为周期设置增强时刻。比如,当第一预设数目等于3时,表示每间隔3个时刻增强一次记忆。

可将第一预设数目等于第二预设数目。为了进一步减小运算量的增加,也可设置第一预设数目大于第二预设数目。

本实施例,优化了传统循环神经网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模装置,包括:

隐藏层采用循环神经网络RNN的结构。

时刻区分单元100,按照预设规则将所有时刻分为增强时刻和非增强时刻;预设规则为:若t=a+i×skip,则t为增强时刻,其他t为非增强时刻,i为任意正整数,a为预设数,skip是第一预设数目。

状态更新单元200,根据以下公式得到第一记忆值M;

M=f(U*x

其中,x

状态更新单元200,根据以下公式得到隐藏层在每个时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。

M是按照传统的RNN网络根据隐藏层在前一时刻的状态h

本实施例优化了传统RNN网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模装置,包括:

隐藏层采用长短期记忆网络LSTM的结构。

时刻区分单元100,按照预设规则将所有时刻分为增强时刻和非增强时刻;预设规则为:若t=a+i×skip,则t为增强时刻,其他t为非增强时刻,i为任意正整数,a为预设数,skip是第一预设数目。

状态更新单元200,根据前一时刻的状态h

f

i

o

其中,W

状态更新单元200,根据以下公式得到隐藏层在当前时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。

N是按照传统的LSTM网络根据隐藏层在前一时刻的状态h

本实施例优化了传统LSTM网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

本发明的另一个实施例,一种基于神经网络的建模装置,包括:

隐藏层采用门控循环单元GRU结构。

时刻区分单元100,用于按照预设规则将所有时刻分为增强时刻和非增强时刻;预设规则为:若t=a+i×skip,则t为增强时刻,其他t为非增强时刻,i为任意正整数,a为预设数,skip是第一预设数目。

状态更新单元200,根据前一时刻的状态h

r

z

其中,W

状态更新单元200,根据以下公式得到隐藏层在每个时刻的状态:

其中,h

具体地,第一预设数目等于第二预设数目,都为skip。

Q是按照传统的GRU网络根据隐藏层在前一时刻的状态h

本实施例优化了传统GRU网络的结构,通过引入增强时刻,定期增强网络对过去时刻状态的记忆,有效减缓了梯度爆炸和梯度消失,提高了网络预测的准确率。

需要说明的是,本发明提供的用于基于神经网络的建模装置的实施例与前述提供的应用于基于神经网络的建模方法的实施例均基于同一发明构思,能够取得相同的技术效果。因而,用于基于神经网络的建模装置的实施例的其它具体内容可以参照前述应用于基于神经网络的建模方法的实施例内容的记载。

本发明还提供一个具体实施场景示例,如图4所示,将本申请提供的方法和装置应用于心率分析模型中,具体步骤包括:

步骤一:采集数据,分析特征。

步骤二:数据预处理。

步骤三:建立动态模型。

步骤四:训练和优化模型。

步骤五:模型评价。

将心电图ECG作为研究对象,从医院获取相关心率正常、异常数据。

构建多层的动态循环神经网络模型,即RNN-SKIP模型。该模型由五层神经网络构成,分别是输入层、三个隐藏层和输出层,隐藏层由改进的LSTM循环神经网络构成。

计算隐藏层在当前时刻的状态:

1、先根据前一时刻的状态h

f

i

o

其中,W

2、再根据以下公式得到隐藏层在当前时刻的状态:

其中,h

实验使用RNN-SKIP模型对心率数据进行动态建模,针对不同的参数skip,分别进行了五组对比实验,并观察了三个隐藏层网络输出信号的均值和方差在训练过程中的变化情况。图5、图6和图7分别展示的是三个隐藏层输出的均值和方差在训练过程中的变化情况,其中参数skip分别为3,4,5,6或none,skip为none表示该组实验采用原始的循环神经网络,没有使用记忆增强。

图5展示了第一个隐藏层输出信号的均值在70轮(epoch)训练过程中的变化情况,从图中可以发现,没有使用记忆增强的网络的输出信号基本趋近0,而使用了记忆增强的网络的输出信号基本在0附近波动。当网络的输出信号y1趋近于零时,当前网络的权重的梯度也趋近于零,因此更容易发生梯度消失。当skip为3、4、5和6时,网络的输出信号基本在0附近波动,因此梯度向后传播相对更加容易,当skip为3时,可以发现第一个隐藏层的输出的分布变化相对较大,而当skip分别为4、5和6时,第一个隐藏层的输出的分布相对平稳。由于每层网络的输出的分布在训练过程中发生较大变化,导致训练深度神经网络非常复杂和困难。因此我们可以知道skip为3,相对为4、5和6时,网络训练更慢和更难。

如图8所示,我们记录了五组对比实验在训练过程中准确率(accuracy)和损失函数(loss)的变化情况。当skip分别为4、5和6时,被增强了记忆的网络的准确率均高于原始的循环神经网络。当skip为5时,准确率是最高的,损失函数是最低的。所以优先参数skip为5。

本实施例,将心电图ECG作为研究对象,通过对心率数据的实验与测试,分析了不同参数的模型效果,实验结果表明,运用该算法能够较好的优化循环神经网络的结构,改进后的循环神经网络准确率更高,可以有效减缓梯度消失。

应当说明的是,上述实施例均可根据需要自由组合。以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。

- 基于人工神经网络与机理建模的裂解反应建模方法及装置

- 一种基于神经网络的建模方法及装置