车辆用控制数据的生成方法及装置、车辆用控制装置及系统、车辆用学习装置和存储介质

文献发布时间:2023-06-19 11:50:46

技术领域

本公开涉及车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统及车辆用学习装置。

背景技术

例如在日本特开2016-6327号公报中记载了基于对加速器踏板的操作量进行滤波处理后的值来操作作为搭载于车辆的内燃机的操作部的节气门的控制装置。

上述滤波需要构成为,根据加速器踏板的操作量而将搭载于车辆的内燃机的节气门的操作量设定为合适的操作量。由此,在该滤波的适配中,熟练者需要花费很多工时。

这样,以往,在与车辆的状态相应的车辆内的电子设备的操作量等的适配(适当化)中,熟练者花费了很多工时。

发明内容

以下,对本公开的例子(Aspect,方案)进行记载。

例1.一种车辆用控制数据的生成方法,其中,所述生成方法应用于能够实现自动驾驶模式和手动驾驶模式的车辆,在所述自动驾驶模式下,与加速器操作相独立地自动生成推力生成装置的推力的指令值,在所述手动驾驶模式下,根据所述加速器操作来生成所述推力生成装置的推力的指令值,关系规定数据规定所述车辆的状态与行动变量的关系,所述行动变量是与所述车辆内的电子设备的操作相关的变量,所述生成方法在所述关系规定数据存储于存储装置的状态下,包括:利用执行装置,取得基于传感器的检测值的所述车辆的状态;操作所述电子设备;基于取得的所述车辆的状态,在所述车辆的特性满足基准的情况下与不满足的情况相比提供大的报酬;及通过将取得的所述车辆的状态、在所述电子设备的操作中使用了的所述行动变量的值及与该电子设备的操作对应的所述报酬设为向预先确定的更新映射的输入来更新所述关系规定数据,所述更新映射输出以使关于按照所述关系规定数据而所述电子设备被操作的情况下的所述报酬的期待收益增加的方式更新了的所述关系规定数据,提供所述报酬包括:相对于在所述手动驾驶模式下在所述车辆的特性是预定的特性时提供的所述报酬,变更在所述自动驾驶模式下在所述车辆的特性是所述预定的特性时提供的报酬。

在上述方法中,通过算出伴随于电子设备的操作的报酬,能够掌握通过该操作能够得到何种报酬。并且,基于报酬,通过按照强化学习的更新映射来更新关系规定数据。由此,能够设定车辆的状态与行动变量的合适的关系。因此,在设定车辆的状态与行动变量的合适的关系时,能够削减对熟练者要求的工时。

在自动驾驶模式和手动驾驶模式下,与电子设备的操作相关联的要求要素可能互相不同。因而,在对于自动驾驶模式和手动驾驶模式而报酬的提供方法相同的情况下,可能会难以将满足了自动驾驶模式和手动驾驶模式各自的固有的要求的合适的关系规定数据通过强化学习而学习。于是,在上述方法中,通过变更处理,在自动驾驶模式和手动驾驶模式下变更报酬的提供方法。由此,能够将满足了自动驾驶模式和手动驾驶模式各自的固有的要求的合适的关系规定数据通过强化学习而学习。

例2.根据上述例1所述的车辆用控制数据的生成方法,所述行动变量包括与所述推力生成装置的操作相关的变量,提供所述报酬包括:第1处理,在满足与对于所述推力的指令值的跟随性相关的基准的情况下与不满足的情况相比提供大的报酬;及第2处理,在满足与所述车辆的前后方向的加速度的绝对值相关的基准的情况下与不满足的情况相比提供大的报酬,变更所述报酬包括:以有利于与所述手动驾驶模式的情况相比在所述自动驾驶模式的情况下所述加速度的绝对值小时取得更大的报酬的方式,变更所述第1处理及所述第2处理中的至少1个处理。

在上述方法中,在自动驾驶模式下与手动驾驶模式相比,在车辆的加速度的绝对值成为更小的值的情况下,提供大的报酬。由此,能够将能够实现抑制了车辆的急剧的加速的自动驾驶的关系规定数据通过强化学习而学习。

例3.根据上述例1或例2所述的车辆用控制数据的生成方法,所述生成方法还包括:基于更新后的所述关系规定数据,将所述车辆的状态与使所述期待收益最大化的所述行动变量的值建立对应,从而利用所述执行装置生成控制用映射数据,所述控制用映射数据以所述车辆的状态为输入,输出使所述期待收益最大化的所述行动变量的值。

在上述方法中,基于通过强化学习而学习到的关系规定数据,生成控制用映射数据。将生成的控制用映射数据向控制装置安装。由此,能够基于车辆的状态而简易地设定使期待收益最大化的行动变量的值。

例4.一种车辆用控制装置,其中,该车辆用控制装置具备上述例1~例3中任一项所述的车辆用控制数据的生成方法中的所述存储装置及所述执行装置,操作所述电子设备包括:基于所述关系规定数据,按照与通过取得所述车辆的状态而取得的所述车辆的状态相应的所述行动变量的值来操作所述电子设备。

在上述构成中,基于通过强化学习而学习到的关系规定数据来设定行动变量的值,基于设定的行动变量的值来操作电子设备。由此,能够以增大期待收益的方式操作电子设备。

例5.一种车辆用控制系统,具备上述例4所述的车辆用控制装置中的所述执行装置及所述存储装置,其中,所述执行装置包括搭载于所述车辆的第1执行装置和另外于车载装置的第2执行装置,所述第1执行装置构成为至少执行取得所述车辆的状态和操作所述电子设备,所述第2执行装置构成为至少执行更新所述关系规定数据。

在上述构成中,将更新处理利用第2执行装置执行。由此,例如与第1执行装置执行更新处理的情况相比,能够减轻第1执行装置的运算负荷。

此外,第2执行装置是另外于车载装置的装置意味着第2执行装置不是车载装置。

例6.一种车辆用控制装置,具备上述例5所述的车辆用控制系统中的所述第1执行装置。

例7.一种车辆用学习装置,具备上述例5所述的车辆用控制系统中的所述第2执行装置。

例8.一种车辆用控制数据的生成装置,具备执行上述例1~例3中任一项所述的各种处理的执行装置和存储装置。

例9.一种计算机能够读取的存储介质,存储有使执行装置和存储装置执行上述例1~例3中任一项所述的各种处理的车辆用控制数据的生成处理。

附图说明

图1是示出本公开的第1实施方式的控制装置及驱动系的图。

图2是示出第1实施方式的控制装置所执行的处理的顺序的流程图。

图3是示出第1实施方式的生成射影数据的系统的图。

图4是示出第1实施方式的系统所执行的处理的顺序的流程图。

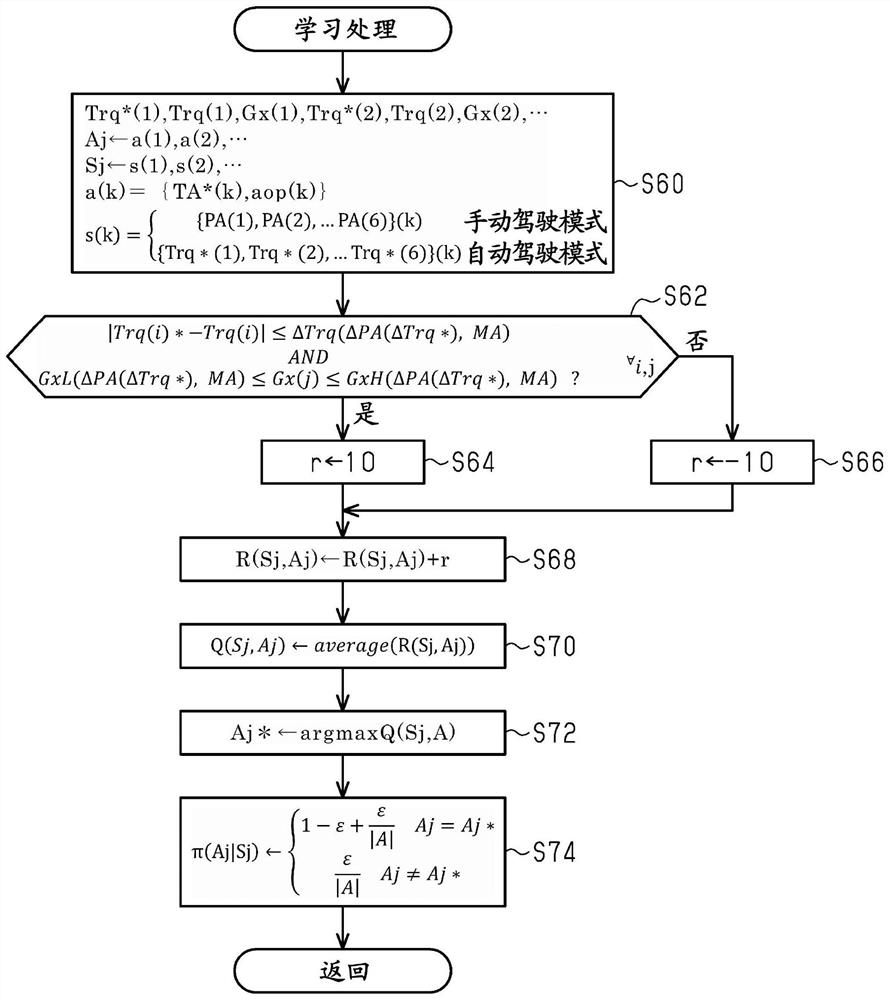

图5是示出第1实施方式的学习处理的详情的流程图。

图6是示出第1实施方式的射影数据的生成处理的顺序的流程图。

图7是示出本公开的第2实施方式的控制装置及驱动系的图。

图8是示出第2实施方式的控制装置所执行的处理的顺序的流程图。

图9是示出本公开的第3实施方式的系统的构成的图。

图10的(a)部分及(b)部分是示出第3实施方式的系统所执行的处理的顺序的流程图。

具体实施方式

以下,参照附图对车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统及车辆用学习装置的各实施方式进行说明。

<第1实施方式>

关于第1实施方式,参照图1~图6来说明。在图1中示出本实施方式的车辆VC1的驱动系及控制装置的构成。

如图1所示,在内燃机10的进气通路12从上游侧起依次设置有节气门14及燃料喷射阀16,吸入到进气通路12的空气、从燃料喷射阀16喷射出的燃料伴随于进气门18的打开而向由汽缸20及活塞22区划的燃烧室24流入。在燃烧室24内,燃料与空气的混合气伴随于点火装置26的火花放电而用于燃烧,通过燃烧而产生的能量经由活塞22而被变换为曲轴28的旋转能量。用于燃烧后的混合气伴随于排气门30的打开而作为排气向排气通路32排出。在排气通路32设置有作为净化排气的后处理装置的催化剂34。

在曲轴28能够经由具备锁止离合器42的变矩器40而机械连结变速装置50的输入轴52。变速装置50是使输入轴52的转速与输出轴54的转速之比即变速比可变的装置。在输出轴54机械连结有驱动轮60。

控制装置70以内燃机10为控制对象,为了控制作为其控制量的转矩、排气成分比率等而操作节气门14、燃料喷射阀16及点火装置26等内燃机10的操作部。另外,控制装置70以变矩器40为控制对象,为了控制锁止离合器42的接合状态而操作锁止离合器42。另外,控制装置70以变速装置50为控制对象,为了控制作为其控制量的变速比而操作变速装置50。此外,在图1中,记载了节气门14、燃料喷射阀16、点火装置26、锁止离合器42及变速装置50各自的操作信号MS1~MS5。

控制装置70为了控制量的控制而参照由空气流量计80检测的吸入空气量Ga、由节气门传感器82检测的节气门14的开口度(节气门开口度TA)、曲轴角传感器84的输出信号Scr。另外,控制装置70参照由加速器传感器88检测的加速器踏板86的踩踏量(加速器操作量PA)、由加速度传感器90检测的车辆VC1的前后方向的加速度Gx。另外,控制装置70参照模式变量MV、自动驾驶模式下的目标车速V*及基于雷达装置94的车辆VC1的前方的状态信号。在此,模式变量MV表示通过用户操作指示开关92而用户指示手动驾驶模式和自动驾驶模式的哪一个。此外,指示开关92是用于供车辆VC1的用户指示手动驾驶模式和自动驾驶模式的任一个或者在自动驾驶模式下指示目标车速V*的人机接口。另外,车辆VC1的前方的状态信号是包括与车辆VC1与前方的物体的距离、车辆VC1与前方的物体的相对速度相关的信息的信号。

控制装置70具备CPU72、ROM74、能够电改写的非易失性存储器(存储装置76)及周边电路78,它们能够经由局域网79而通信。在此,周边电路78包括生成规定控制装置70的内部的动作的时钟信号的电路、电源电路、复位电路等。

在ROM74中存储有控制程序74a和自适应巡航控制程序(ACC程序74b)。ACC程序74b是用于CPU72基于雷达装置94的状态信号而以优先使车辆VC1与前方车辆的距离成为预定值以上并使车辆VC1的速度成为目标车速V*的方式控制车辆的行驶的执行指令。

另一方面,在存储装置76中存储有射影数据DM。射影数据DM以节气门开口度TA的指令值即节气门开口度指令值TA*和点火正时的延迟量aop为输出变量。在此,延迟量aop是相对于预先确定的基准点火正时的延迟量,基准点火正时是MBT点火正时和爆震界限点中的延迟侧的正时。MBT点火正时是得到最大转矩的点火正时(最大转矩点火正时)。另外,爆震界限点是在爆震界限高的高辛烷值燃料的使用时在设想的最佳的条件下能够使爆震处于能够容许的水平以内的点火正时的提前界限值。另外,射影数据DM包括手动驾驶用射影数据DM1和自动驾驶用射影数据DM2。手动驾驶用射影数据DM1以加速器操作量PA的时间序列数据为输入变量。自动驾驶用射影数据DM2以内燃机10的转矩的指令值即转矩指令值Trq*的时间序列数据为输入变量。此外,影射数据是输入变量的离散的值和与输入变量的值的各自对应的输出变量的值的数据组。

在图2中示出本实施方式的控制装置70所执行的处理的顺序。图2所示的处理通过CPU72例如以预定周期反复执行存储于ROM74的程序而实现。此外,以下,利用开头标注了“S”的数字来表现各处理的步骤编号。

在图2所示的一系列处理中,CPU72首先判定模式变量MV的值是否是手动驾驶模式(S10)。CPU72在判定为模式变量MV的值是手动驾驶模式的情况下(S10:是),取得由加速器操作量PA的6个采样值“PA(1)、PA(2)、…PA(6)”构成的时间序列数据(S12)。在此,构成时间序列数据的各采样值在互相不同的时刻下采样。在本实施方式中,利用以一定的采样周期采样的情况下的互相在时间序列上相邻的6个采样值来构成时间序列数据。

然后,CPU72使用手动驾驶用射影数据DM1对节气门开口度指令值TA*及延迟量aop进行射影运算(S14)。在此,射影运算例如设为以下的处理即可:在输入变量的值与射影数据的输入变量的值的任一个一致的情况下,将对应的射影数据的输出变量的值设为运算结果,而在都不一致的情况下,将通过射影数据中包含的多个输出变量的值的插补而得到的值设为运算结果。

相对于此,CPU72在判定为模式变量MV的值是自动驾驶模式的情况下(S10:否),取得由转矩指令值Trq*的6个采样值“Trq*(1)、Trq*(2)、…Trq*(6)”构成的时间序列数据(S16)。在此,构成时间序列数据的各采样值在互相不同的时刻下采样。在本实施方式中,利用以一定的采样周期采样的情况下的互相在时间序列上相邻的6个采样值来构成时间序列数据。顺便一提,转矩指令值Trq*通过CPU72执行ACC程序74b而基于雷达装置94的输出等算出。

然后,CPU72使用自动驾驶用射影数据DM2对节气门开口度指令值TA*及延迟量aop进行射影运算(S18)。

CPU72在S14、S18的处理完成的情况下,通过向节气门14输出操作信号MS1来操作节气门开口度TA,并且通过向点火装置26输出操作信号MS3来操作点火正时(S20)。在此,在本实施方式中,例示将节气门开口度TA反馈控制成节气门开口度指令值TA*。由此,即使节气门开口度指令值TA*是同一值,操作信号MS1也可能成为互相不同的信号。另外,例如在进行周知的爆震控制(KCS)等的情况下,使基准点火正时以延迟量aop延迟后的值进一步由KCS反馈修正后的值被设为点火正时。在此,基准点火正时由CPU72根据曲轴28的转速NE及填充效率η而可变设定。此外,转速NE基于曲轴角传感器84的输出信号Scr而由CPU72算出。另外,填充效率η基于转速NE及吸入空气量Ga而由CPU72算出。

此外,CPU72在S20的处理完成的情况下,一度结束图2所示的一系列处理。

在图3中示出生成上述射影数据DM的系统。

如图3所示,在本实施方式中,对内燃机10的曲轴28(参照图1)经由变矩器40及变速装置50而机械连结测力计100。并且,使内燃机10工作时的各种各样的状态变量由传感器组102检测,检测结果向生成射影数据DM的计算机即生成装置110输入。此外,在传感器组102中包括搭载于图1所示的车辆VC1的传感器等。

生成装置110具备CPU112、ROM114、能够电改写的非易失性存储器(存储装置116)及周边电路118,它们能够通过局域网119而通信。在此,在存储装置116中存储有关系规定数据DR。关系规定数据DR是规定作为状态变量的加速器操作量PA或转矩指令值Trq*的时间序列数据与作为行动变量的节气门开口度指令值TA*及延迟量aop的关系的数据。关系规定数据DR包括以加速器操作量PA的时间序列数据为状态变量的手动驾驶用规定数据DR1和以转矩指令值Trq*的时间序列数据为状态变量的自动驾驶用规定数据DR2。另外,在ROM114中存储有通过强化学习来学习关系规定数据DR的学习程序114a。

在图4中示出生成装置110执行的处理的顺序。图4所示的处理通过CPU112执行存储于ROM114的学习程序114a来实现。

在图4所示的一系列处理中,CPU112首先选择手动驾驶模式或自动驾驶模式(S30)。接着,CPU112判定选择的模式是否是手动驾驶模式(S32)。并且,CPU112在判定为选择的模式是手动驾驶模式的情况下(S32:是),在使内燃机10工作的状态下,作为状态s而取得加速器操作量PA的时间序列数据(S34)。这里的时间序列数据是与图2的S12的处理中的时间序列数据同样的数据。不过,在图3所示的系统中,不存在加速器踏板86。因而,设为通过生成装置110模拟车辆VC1的状态而模拟地生成了加速器操作量PA。即,将模拟地生成的加速器操作量PA视为基于传感器的检测值的车辆的状态。

接着,CPU112按照手动驾驶用规定数据DR1所确定的策略π,设定与由S34的处理取得的状态s相应的行动a(S36)。行动a由与取得的状态s相应的节气门开口度指令值TA*及延迟量aop构成。

在本实施方式中,手动驾驶用规定数据DR1是确定行动价值函数Q及策略π的数据。在本实施方式中,行动价值函数Q是表示与状态s及行动a的8维的独立变量相应的期待收益的值的表形式的函数。另外,策略π确定以下规则:在给出了状态s时,优先选择独立变量成为给出的状态s的行动价值函数Q中的期待收益成为最大的行动a(贪婪行动),并以预定的概率选择其以外的行动a。

详细而言,本实施方式的行动价值函数Q的独立变量可取的值的数量通过状态s及行动a可取的值的全部组合的一部分由人的见解等削减而设定。即,例如加速器操作量PA的时间序列数据中的互相相邻的2个采样值的1个成为加速器操作量PA的最小值且另1个成为加速器操作量PA的最大值这样的情况被认为是不可能根据人对加速器踏板86的操作产生。由此,对于加速器操作量PA的该组合未定义行动价值函数Q。在本实施方式中,通过基于人的见解等的维度削减,将定义行动价值函数Q的状态s可取的值限制为10的4次方个以下,更优选的是10的3次方个以下。

接着,CPU112基于设定的节气门开口度指令值TA*及延迟量aop,与S20的处理同样地输出操作信号MS1、MS3(S38)。接着,CPU112取得内燃机10的转矩Trq、对于内燃机10的转矩指令值Trq*及加速度Gx(S40)。在此,CPU112将转矩Trq基于测力计100生成的负荷转矩和变速装置50的变速比而算出。另外,转矩指令值Trq*根据加速器操作量PA而设定。另外,CPU112作为设想为在假设内燃机10等搭载于车辆的情况下会在车辆产生的值而将加速度Gx基于测力计100的负荷转矩等算出。即,在本实施方式中,加速度Gx也是假想的,但关于该加速度Gx也视为车辆的状态的检测值。

接着,CPU112判定过渡标志F是否是“1”(S42)。过渡标志F在是“1”的情况下表示是过渡运转时,在是“0”的情况下表示不是过渡运转时。CPU112在判定为过渡标志F是“0”的情况下(S42:否),判定加速器操作量PA的每单位时间的变化量ΔPA的绝对值是否为预定量ΔPAth以上(S44)。在此,变化量ΔPA例如设为S42的处理的执行时刻下的最新的加速器操作量PA与该时刻的单位时间前的加速器操作量PA之差即可。

CPU112在判定为变化量ΔPA的绝对值为预定量ΔPAth以上的情况下(S44:是),对过渡标志F代入“1”(S46)。另一方面,在判定为变化量ΔPA的绝对值小于预定量ΔPAth的情况下(S44:否),返回S32的处理。

相对于此,CPU112在判定为过渡标志F是“1”的情况下(S42:是),判定从进行S46的处理起是否经过了预定期间(S48)。在此,预定期间设为直到加速器操作量PA的每单位时间的变化量ΔPA的绝对值为比预定量ΔPAth小的规定量以下的状态持续预定时间为止的期间。CPU112在判定为从进行S46的处理起经过了预定期间的情况下(S48:是),对过渡标志F代入“0”(S50)。另一方面,在判定为从进行S46的处理起未经过预定期间的情况下(S48:否),返回S32的处理。

CPU112在S46、S50的处理完成的情况下,认为1个事件(episode)结束,通过强化学习来更新行动价值函数Q(S52)。

在图5中示出S52的处理的详情。

在图5所示的一系列处理中,CPU112取得由最近结束的事件中的转矩指令值Trq*,转矩Trq及加速度Gx的3个采样值的组构成的时间序列数据和状态s及行动a的时间序列数据(S60)。在此,最近的事件在接在图4的S46的处理之后进行图5的S60的处理的情况下是过渡标志F持续为“0”的期间,在接在图4的S50的处理之后进行图5的S60的处理的情况下是过渡标志F持续为“1”的期间。

在图5中,括号中的数字不同的变量表示是不同的采样时刻下的变量的值。例如,转矩指令值Trq*(1)和转矩指令值Trq*(2)的采样时刻互相不同。另外,将属于最近的事件的行动a的时间序列数据设为行动集合Aj,将属于该事件的状态s的时间序列数据设为状态集合Sj。

接着,CPU112判定条件(i)与条件(ii)的逻辑与(逻辑乘)是否为真(S62)。条件(i)是属于最近的事件的任意的转矩Trq与转矩指令值Trq*之差的绝对值为规定量ΔTrq以下这样的条件。条件(ii)是加速度Gx为下限值GxL以上且上限值GxH以下这样的条件。

在此,CPU112在手动驾驶模式的情况下,将规定量ΔTrq通过事件的开始时的加速器操作量PA的每单位时间的变化量ΔPA而可变设定。即,CPU112在变化量ΔPA的绝对值大的情况下,认为是与过渡时相关的事件,与是稳态时的情况相比,将规定量ΔTrq设定为大的值。另外,CPU112在自动驾驶模式的情况下,通过事件的开始时的转矩指令值Trq*的每单位时间的变化量ΔTrq*而可变设定规定量ΔTrq。即,CPU112在变化量ΔTrq*的绝对值大的情况下,认为是与过渡时相关的事件,与是稳态时的情况相比,将规定量ΔTrq设定为大的值。另外,CPU112在手动驾驶模式的情况下,与自动驾驶模式的情况相比,将规定量ΔTrq设定为小的值。

另外,CPU112在手动驾驶模式的情况下,将下限值GxL通过事件的开始时的加速器操作量PA的变化量ΔPA而可变设定,在自动驾驶模式的情况下,将下限值GxL通过事件的开始时的转矩指令值Trq*的变化量ΔTrq*而可变设定。即,CPU112在是与过渡时相关的事件且变化量ΔPA为正的情况下,与是与稳态时相关的事件的情况相比,将下限值GxL设定为大的值。另外,CPU112在是与过渡时相关的事件且变化量ΔPA为负的情况下,与是与稳态时相关的事件的情况相比,将下限值GxL设定为小的值。

另外,CPU112在手动驾驶模式的情况下,将上限值GxH通过事件的开始时的加速器操作量PA的每单位时间的变化量ΔPA而可变设定,在自动驾驶模式的情况下,将上限值GxH通过事件的开始时的转矩指令值Trq*的变化量ΔTrq*而可变设定。即,CPU112在是与过渡时相关的事件且变化量ΔPA为正的情况下,与是与稳态时相关的事件的情况相比,将上限值GxH设定为大的值。另外,CPU112在是与过渡时相关的事件且变化量ΔPA为负的情况下,与是与稳态时相关的事件的情况相比,将上限值GxH设定为小的值。

另外,CPU112根据模式变量MV的值而可变设定上限值GxH及下限值GxL。详细而言,CPU112在手动驾驶模式的情况下,与自动驾驶模式的情况相比,以作为过渡时的加速度Gx的绝对值而容许更大的值的方式设定上限值GxH及下限值GxL。

CPU72在判定为条件(i)与条件(ii)的逻辑与为真的情况下(S62:是),对报酬r代入“10”(S64),另一方面,在判定为逻辑与为假的情况下(S62:否),对报酬r代入“-10”(S66)。S62~S66的处理是在满足与驾驶性能相关的基准的情况下与不满足的情况相比提供大的报酬的处理。CPU112在S64、S66的处理完成的情况下,更新存储于图3所示的存储装置76的关系规定数据DR。在本实施方式中,在关系规定数据DR的更新中使用ε-soft同策略型蒙特卡罗法(ε-soft on-policy Monte Carlo method)。

即,CPU112对由通过上述S60的处理读出的各状态和与各状态对应的行动的组确定的收益R(Sj,Aj)分别加上报酬r(S68)。在此,“R(Sj,Aj)”是将状态集合Sj的要素之一设为状态且将行动集合Aj的要素之一设为行动的对收益R进行总括的记载。接着,关于由通过上述S60的处理读出的各状态和与各状态对应的行动的组确定的收益R(Sj,Aj)的各自进行平均化,向对应的行动价值函数Q(Sj,Aj)代入(S70)。在此,平均化设为将通过S68的处理算出的收益R除以进行了S68的处理的次数的处理即可。此外,收益R的初始值设为零即可。

接着,CPU112关于通过上述S60的处理读出的状态,分别将对应的行动价值函数Q(Sj,A)中的期待收益成为最大值时的节气门开口度指令值TA*及延迟量aop的组即行动向行动Aj*代入(S72)。在此,“A”表示可取的任意的行动。此外,行动Aj*根据通过上述S60的处理读出的状态的种类而互相成为独立的值,但在此将记载简化,遍及状态的种类而利用同一符号来记载行动Aj*。

接着,CPU112关于通过上述S60的处理读出的状态的各自更新对应的策略π(Aj|Sj)(S74)。即,若将行动的总数设为“|A|”,则将由S72选择出的行动Aj*的选择概率设为“(1-ε)+ε/|A|”。另外,将行动Aj*以外的“|A|-1”个行动的选择概率分别设为“ε/|A|”。S74的处理是基于由S70的处理更新后的行动价值函数Q的处理。由此,规定状态s与行动a的关系的关系规定数据DR以使收益R增加的方式被更新。

此外,CPU112在S74的处理完成的情况下,一度结束图5所示的一系列处理。

返回图4,CPU112当S52的处理完成后,判定行动价值函数Q是否已收敛(S54)。在此,在基于S52的处理的行动价值函数Q的更新量成为预定值以下的连续次数到达预定次数的情况下判定为行动价值函数Q已收敛即可。CPU112在判定为行动价值函数Q未收敛的情况下(S54:否),返回S32的处理。相对于此,CPU112在判定为行动价值函数Q已收敛的情况下(S54:是),判定是否关于手动驾驶模式和自动驾驶模式的双方在S54的处理中作出了肯定判定(S56)。

CPU112在判定为关于任一方的模式还未在S54的处理中作出肯定判定的情况下(S56:否),返回S30的处理,选择未在该S54的处理中作出肯定判定的模式。另外,CPU112在S32的处理中作出否定判定的情况下,作为状态s而设定转矩指令值Trq*(1)、Trq*(2)、…、Trq*(6)(S58),反复进行S36~S54的处理。不过,在S36的处理中,使用自动驾驶用规定数据DR2。自动驾驶用规定数据DR2除了作为行动价值函数Q的独立变量的状态s与手动驾驶用规定数据DR1不同之外,是与手动驾驶用规定数据DR1同样的数据。另外,在S40的处理中取得的转矩指令值Trq*设为在S58的处理中设定的值中的最新的值。此外,在此利用的转矩指令值Trq*(1)、Trq*(2)、…、Trq*(6)通过将通过在车辆内基于雷达装置94的输出执行由ACC程序74b规定的指令而生成的值利用生成装置110模拟而得到。因而,在本实施方式中,将在此利用的转矩指令值Trq*(1)、Trq*(2)、…、Trq*(6)视为基于传感器的检测值的车辆的状态。

CPU112在S56的处理中作出肯定判定的情况下,一度结束图4所示的一系列处理。

在图6中示出生成装置110执行的处理中的尤其基于通过图4的处理学习到的行动价值函数Q来生成射影数据DM的处理的顺序。图6所示的处理通过CPU112执行存储于ROM114的学习程序114a而实现。

在图6所示的一系列处理中,CPU112首先设定手动驾驶模式和自动驾驶模式的任一个(S80)。然后,CPU112选择成为手动驾驶用射影数据DM1及自动驾驶用射影数据DM2中的与由S80的处理设定的模式对应的一方的输入变量的值的多个状态s中的1个(S82)。接着,CPU112选择由手动驾驶用规定数据DR1及自动驾驶用规定数据DR2中的与由S80的处理设定的模式对应的数据规定且与状态s对应的行动价值函数Q(s,A)中的使行动价值函数Q的值成为最大的行动a(S84)。即,在此,通过贪婪策略而选择行动a。接着,CPU112使状态s和行动a的组存储于存储装置116(S86)。

接着,CPU112判定是否通过S82的处理选择了设为手动驾驶用射影数据DM1及自动驾驶用射影数据DM2中的与由S80的处理设定的模式对应的一方的输入变量的值的全部状态s(S88)。并且,CPU112在判定为存在未选择的状态s的情况下(S88:否),返回S82的处理。相对于此,CPU112在判定为选择了全部的状态s的情况下(S88:是),判定是否通过S80的处理而设定了手动驾驶模式和自动驾驶模式双方(S90)。CPU112在判定为存在还未设定的模式的情况下(S90:否),返回S80的处理而设定还未设定的模式。

相对于此,CPU112在判定为已设定全部的模式的情况下(S90:是),生成手动驾驶用射影数据DM1及自动驾驶用射影数据DM2(S92)。在此,将与射影数据DM的输入变量的值是状态s的数据对应的输出变量的值设为对应的行动a。

此外,CPU112在S92的处理完成的情况下,一度结束图6所示的一系列处理。

在此,对本实施方式的作用及效果进行说明。

在图3所示的系统中,CPU112通过强化学习来学习行动价值函数Q。并且,在行动价值函数Q的值收敛的情况下,认为学习了为了满足关于驾驶性能要求的基准而合适的行动。然后,CPU112关于成为射影数据DM的输入变量的状态的各自,选择使行动价值函数Q最大化的行动,将状态和行动的组存储于存储装置116。接着,CPU112基于存储于存储装置116的状态和行动的组来生成射影数据DM。由此,不用使熟练者的工时过大就能够设定与加速器操作量PA、转矩指令值Trq*相应的合适的节气门开口度指令值TA*及延迟量aop。

尤其是,在本实施方式中,在手动驾驶模式和自动驾驶模式下,分别独立地学习了与状态s相应的行动a。详细而言,手动驾驶模式比自动驾驶模式相比,设置提高对于车辆的推力的指令值的跟随性的基准而提供了报酬。另一方面,自动驾驶模式与手动驾驶模式相比,设置在车辆产生的前后方向的加速度的大小更小这样的基准而提供了报酬。由此,能够使手动驾驶用射影数据DM1成为能够实现对于用户的加速器操作的响应性良好的控制的数据。另外,能够使自动驾驶用射影数据DM2成为能够实现抑制用户感受急加速的控制的数据。因此,能够省去将通过ACC程序74b的执行而生成的转矩指令值Trq*也考虑用户感受的加速度而适配的工夫。这样,CPU112在各事件结束的情况下,根据转矩、加速度是否满足基准而提供报酬,由此更新关系规定数据DR。CPU112在自动驾驶模式下与手动驾驶模式相比,以使向转矩指令值Trq*的跟随性的要求被缓和的方式,另外,基于加速度Gx的大小小的基准,提供报酬r。

根据以上说明的本实施方式,能够进一步得到以下记载的作用及效果。

(1)在控制装置70所具备的存储装置76中存储了射影数据DM而非行动价值函数Q等。由此,CPU72基于使用了射影数据DM的射影运算来设定节气门开口度指令值TA*及延迟量aop。由此,例如与执行选择行动价值函数Q中的成为最大值的行动价值函数Q的处理的情况相比,能够减轻运算负荷。

(2)在行动价值函数Q的独立变量中包括了加速器操作量PA的时间序列数据。由此,例如与关于加速器操作量PA仅将单个采样值设为独立变量的情况相比,能够对于加速器操作量PA的各种各样的变化细腻地调整行动a的值。

(3)在行动价值函数Q的独立变量中包括了节气门开口度指令值TA*自身。由此,例如,与将使节气门开口度指令值TA*的行为模型化而得到的模型式的参数等设为与节气门开口度相关的独立变量的情况相比,容易提高基于强化学习的探索的自由度。

<第2实施方式>

以下,关于第2实施方式,以与第1实施方式的不同点为中心,参照图7及图8来说明。

在图7中示出本实施方式的车辆VC1的驱动系及控制装置。此外,在图7中,关于与图1所示的构件对应的构件,为了方便而标注有同一标号。

如图7所示,在本实施方式中,在ROM74中除了控制程序74a及ACC程序74b之外还存储有学习程序74c。另外,在存储装置76中未存储射影数据DM,取而代之,存储有关系规定数据DR,另外,存储有转矩输出映射数据DT。在此,关系规定数据DR是通过图4的处理而学习到的学习完毕的数据,包括手动驾驶用规定数据DR1和自动驾驶用规定数据DR2。手动驾驶用规定数据DR1包括将状态s设为加速器操作量PA的时间序列数据的行动价值函数。自动驾驶用规定数据DR2包括将状态s设为转矩指令值Trq*的时间序列数据的行动价值函数。另外,由转矩输出映射数据DT规定的转矩输出映射是以转速NE、填充效率η及点火正时为输入且输出转矩Trq的神经网络等与学习完毕模型相关的数据。此外,上述转矩输出映射数据DT例如设为在执行图4的处理时将由S40的处理取得的转矩Trq设为教师数据(示教数据)而学习到的数据即可。

在图8中示出本实施方式的控制装置70所执行的处理的顺序。图8所示的处理通过CPU72例如以预定周期反复执行存储于ROM74的控制程序74a及学习程序74c而实现。此外,在图8中,关于与图4所示的处理对应的处理,为了方便而赋予同一步骤编号。

在图8所示的一系列处理中,CPU72首先执行相当于图2的S10、S12、S16的处理后,执行相当于图4的S36~S52的处理。此外,CPU72在S44、S48的处理中作出否定判定的情况下、或完成S52的处理的情况下,一度结束图8所示的一系列处理。顺便一提,S10、S12、S16、S36~50的处理通过CPU72执行控制程序74a而实现,S52的处理通过CPU72执行学习程序74c而实现。

这样,根据本实施方式,在控制装置70安装关系规定数据DR及学习程序74c。由此,与第1实施方式的情况相比,能够使学习频度提高。

<第3实施方式>

以下,关于第3实施方式,以与第2实施方式的不同点为中心,参照图9及图10来说明。

在本实施方式中,将关系规定数据DR的更新在车辆VC1外执行。

在图9中示出在本实施方式中执行强化学习的控制系统的构成。此外,在图9中,关于与图1所示的构件对应的构件,为了方便而标注有同一标号。

图9所示的车辆VC1内的控制装置70中的ROM74存储有控制程序74a及ACC程序74b,但未存储学习程序74c。另外,控制装置70具备通信机77。通信机77是用于经由车辆VC1的外部的网络120而与数据解析中心130通信的设备。

数据解析中心130解析从多个车辆VC1、VC2、…发送的数据。数据解析中心130具备CPU132、ROM134、能够电改写的非易失性存储器(存储装置136)、周边电路138及通信机137,它们能够通过局域网139而通信。在ROM134中存储有学习程序74c,在存储装置136中存储有关系规定数据DR。

在图10中示出本实施方式的强化学习的处理顺序。图10的(a)部分所示的处理通过CPU72执行存储于图9所示的ROM74的控制程序74a而实现。另外,图10的(b)部分所示的处理通过CPU132执行存储于ROM134的学习程序74c而实现。此外,在图10中,关于与图8所示的处理对应的处理,为了方便而标注有同一步骤编号。以下,沿着强化学习的时间序列来说明图10所示的处理。

在图10的(a)部分所示的一系列处理中,CPU72执行S10、S12、S16、S36~S50的处理后,通过操作通信机77来发送关系规定数据DR的更新处理所需的数据(S100)。在此,设为发送对象的数据包括在S46、S50的处理的即将执行前结束的事件中的模式变量MV的值、转矩指令值Trq*、转矩Trq及加速度Gx各自的时间序列数据、状态集合Sj及行动集合Aj。

相对于此,如图10的(b)部分所示,CPU132接收从车辆VC1发送出的数据(S110),基于接收到的数据来更新关系规定数据DR(S52)。然后,CPU132判定关系规定数据DR的更新次数是否为预定次数以上(S112),在判定为更新次数为预定次数以上的情况下(S112:是),通过操作通信机137而向发送了通过S110的处理而由数据解析中心130接收到的数据的车辆VC1发送关系规定数据DR(S114)。此外,CPU132在完成S114的处理的情况下、或在S112的处理中作出否定判定的情况下,一度结束图10的(b)部分所示的一系列处理。

相对于此,如图10的(a)部分所示,CPU72判定是否存在更新数据(S102),在判定为存在更新数据的情况下(S102:是),接收更新后的关系规定数据DR(S104)。然后,CPU72将在S36的处理中利用的关系规定数据DR利用接收到的关系规定数据DR改写(S106)。此外,CPU72在完成S106的处理的情况下、或在S44、S48、S102的处理中作出否定判定的情况下,一度结束图10的(a)部分所示的一系列处理。

这样,根据本实施方式,将关系规定数据DR的更新处理在车辆VC1的外部进行。由此,能够减轻控制装置70的运算负荷。而且,若例如通过在S110的处理中接收来自多个车辆VC1、VC2的数据而进行S52的处理,则能够容易地增大在学习中使用的数据数。

<对应关系>

上述实施方式中的事项与上述“发明内容”一栏所记载的事项的对应关系如下。以下,针对“发明内容”一栏所记载的例子的每个编号示出对应关系。

[1]、[2]推力生成装置对应于内燃机10。

执行装置和存储装置在图7中分别对应于CPU72及ROM74和存储装置76,在图3中分别对应于CPU112及ROM114和存储装置116,在图9中对应于CPU72、132及ROM74、134和存储装置76、136。

操作处理对应于S38的处理,取得处理对应于S12、S16、S34、S40、S58的处理。

报酬算出处理对应于S62~S66的处理。更新处理对应于S68~S74的处理。

更新映射对应于由基于学习程序74c的S68~S74的处理的执行指令规定的映射。

变更处理对应于在S62的处理中规定量ΔTrq、下限值GxL及上限值GxH根据模式变量MV而被设为可变。

[3]控制用映射数据对应于射影数据DM。

[4]车辆用控制装置对应于图7所示的控制装置70。

执行装置和存储装置分别对应于图7中的CPU72及ROM74和存储装置76。

[5]~[7]第1执行装置对应于图9的CPU72及ROM74,第2执行装置对应于图9的CPU132及ROM134。

<其他实施方式>

此外,本实施方式能够如以下这样变更而实施。本实施方式及以下的变更例能够在技术上不矛盾的范围内互相组合而实施。

“关于自动驾驶模式”

·作为自动驾驶模式,不限于ACC。例如也可以是关于操舵系也实现了自动化的自动驾驶。

“关于行动变量”

·在上述实施方式中,关于作为行动变量的与节气门的开口度相关的变量,例示了节气门开口度指令值TA*,但不限于此。例如,也可以将节气门开口度指令值TA*对于加速器操作量PA的响应性利用死区时间及二阶延迟滤波表现,将死区时间和规定二阶延迟滤波的2个变量这合计3个变量设为与节气门的开口度相关的变量。不过,在该情况下,状态变量优选取代加速器操作量PA的时间序列数据而设为加速器操作量PA的每单位时间的变化量。

·在上述实施方式中,关于作为行动变量的与点火正时相关的变量,例示了延迟量aop,但不限于此。例如,也可以是,被设为KCS的修正对象的点火正时自身是与点火正时相关的变量。

·在上述实施方式中,作为行动变量,例示了与节气门的开口度相关的变量及与点火正时相关的变量,但不限于此。例如,在如下述“关于电子设备”一栏所记载的那样将燃料喷射阀16设为与行动变量相应的操作对象的情况下,也可以除了与节气门的开口度相关的变量及与点火正时相关的变量之外还使用燃料喷射量。另外,关于这3个,也可以仅采用与节气门的开口度相关的变量及燃料喷射量,或者仅采用与点火正时相关的变量及燃料喷射量作为行动变量。而且,关于这3个,也可以仅采用它们中的1个作为行动变量。

·在如下述“关于内燃机”一栏所记载的那样是压缩着火式的内燃机的情况下,取代与节气门的开口度相关的变量而使用与喷射量相关的变量,取代与点火正时相关的变量而使用与喷射正时相关的变量即可。此外,优选除了与喷射正时相关的变量之外,还加上与1个燃烧循环中的喷射次数相关的变量,或者加上与1个燃烧循环中的1个气缸用的在时间序列上相邻的2个燃料喷射中的一方的结束正时与另一方的开始正时之间的时间间隔相关的变量。

·在如下述“关于电子设备”一栏所记载的那样在与行动变量相应的操作的对象中包括旋转电机的情况下,在行动变量中包括旋转电机的转矩、电流即可。即,作为与推力生成装置的负荷相关的变量即负荷变量,不限于与节气门的开口度相关的变量、喷射量,也可以是旋转电机的转矩、电流。

·作为行动变量,不限于与推力生成装置的操作相关的变量。例如在如下述“关于电子设备”一栏所记载的那样被设为与行动变量相应的操作的对象的电子设备包括变速装置的情况下,也可以是,变速装置的变速比是行动变量。另外,例如在变速装置50是有级变速装置的情况下,也可以将用于通过液压来调整离合器的接合状态的电磁阀的电流值等设为行动变量。

“关于状态”

·在上述实施方式中,将加速器操作量PA的时间序列数据设为了由以相等间隔采样到的6个值构成的数据,但不限于此。加速器操作量PA的时间序列数据只要是由互相不同的采样时刻下的2个以上的采样值构成的数据即可,此时,更优选是由3个以上的采样值构成的数据、采样间隔是相等间隔的数据。

·作为与加速器操作量相关的状态变量,不限于加速器操作量PA的时间序列数据,例如如上述“关于行动变量”一栏所记载的那样,也可以是加速器操作量PA的每单位时间的变化量等。

·在上述实施方式中,关于作为手动驾驶用规定数据DR1所确定的行动价值函数的独立变量的与推力生成装置的负荷的指令值相关的变量,例示了加速器操作量PA,但不限于此,例如也可以是转矩指令值Trq*。

·例如在如上述“关于行动变量”一栏所记载的那样将电磁阀的电流值设为行动变量的情况下,在状态中包括变速装置的输入轴52的转速、输出轴54的转速、由电磁阀调整的液压即可。另外,例如在如上述“关于行动变量”一栏所记载的那样将旋转电机的转矩、输出设为行动变量的情况下,也可以在状态中包括蓄电池的充电率、温度。

“关于表形式的数据的维度削减”

·作为表形式的数据的维度削减手法,不限于在上述实施方式中例示出的手法。例如,加速器操作量PA成为最大值的情况稀少。由此,也可以是,关于加速器操作量PA成为规定量以上的状态不定义行动价值函数Q,加速器操作量PA成为规定量以上的情况下的节气门开口度指令值TA*等另外适配。另外,例如,也可以通过从行动可取的值除去节气门开口度指令值TA*成为规定值以上的值等来进行数据的维度削减。

“关于关系规定数据”

·在上述实施方式中,将行动价值函数Q设为了表形式的函数,但不限于此。例如,也可以使用函数逼近器。

·例如,也可以取代使用行动价值函数Q,利用以状态s及行动a为独立变量且以采取行动a的概率为从属变量的函数逼近器来表现策略π。也可以将确定函数逼近器的参数根据报酬r而更新。在该情况下,也可以设置手动驾驶模式用的函数逼近器和自动驾驶模式用的函数逼近器,但不限于此,也可以在单个函数逼近器的输入中包括模式变量MV。不过,在该情况下,在手动驾驶模式和自动驾驶模式下,将表示作为状态s的推力生成装置的负荷的指令值的变量统一成转矩指令值Trq*等。

“关于操作处理”

·例如在如上述“关于关系规定数据”一栏所记载的那样将行动价值函数设为函数逼近器的情况下,将关于成为上述实施方式中的表形式的函数的独立变量的行动的离散的值的组的全部分别与状态s一起向行动价值函数Q输入。通过这样来确定使行动价值函数Q最大化的行动a即可。并且,基于确定出的行动a来选择在操作中采用的行动即可。

·例如在如上述“关于关系规定数据”一栏所记载的那样将以状态s及行动a为独立变量且以采取行动a的概率为从属变量的函数逼近器设为策略π的情况下,基于由策略π表示的概率来选择行动a即可。

“关于更新映射”

·在图5的S68~S74的处理中,例示了基于ε-soft同策略型蒙特卡罗法的更新映射,但不限于此。例如,也可以是基于异策略(off-policy)型蒙特卡罗法的更新映射。不过,也不限于蒙特卡罗法,例如,也可以使用异策略型TD法,或者例如如SARSA法那样使用同策略(on-policy)型TD法,或者例如作为同策略型的学习而使用资格迹(eligibility trace)法。

·例如在如上述“关于关系规定数据”一栏所记载的那样使用函数逼近器来表现策略π且基于报酬r直接更新函数逼近器的情况下,使用策略梯度法等来构成更新映射即可。

·不限于仅将行动价值函数Q和策略π中的任一方设为基于报酬r的直接的更新对象。例如,也可以如Actor-Critic法那样分别更新行动价值函数Q及策略π。另外,在Actor-Critic法中,不限于分别更新行动价值函数Q及策略π,例如也可以取代行动价值函数Q而将价值函数V设为更新对象。

·确定策略π的“ε”不限于固定值,也可以根据基于学习的进行程度预先确定的规则来更新“ε”。

“关于报酬算出处理”

·在上述实施方式中,根据条件(i)及条件(ii)的逻辑与是否为真而提供了报酬,但不限于此。例如,也可以执行根据是否满足条件(i)来提供报酬的处理和根据是否满足条件(ii)来提供报酬的处理。

·例如也可以取代在满足条件(i)的情况下一律提供相同的报酬,设为在转矩Trq与转矩指令值Trq*之差的绝对值小的情况下与该绝对值大的情况相比提供更大的报酬的处理。另外,例如,也可以取代在不满足条件(i)的情况下一律提供相同的报酬而设为在转矩Trq与转矩指令值Trq*之差的绝对值大的情况下与该绝对值小的情况相比提供更小的报酬的处理。

·例如也可以取代在满足条件(ii)的情况下一律提供相同的报酬而设为根据加速度Gx的大小而使报酬的大小可变的处理。另外,例如也可以取代在不满足条件(ii)的情况下一律提供相同的报酬而设为根据加速度Gx的大小而使报酬的大小可变的处理。

·作为与驾驶性能相关的基准,不限于与对于推力的指令值的跟随性相关的基准、与加速度相关的基准。例如,也可以是与振动及噪音的至少一方相关的基准。

·作为报酬算出处理,不仅限于在满足与驾驶性能相关的基准的情况下与不满足的情况相比提供大的报酬的处理。例如,也可以包括在能量利用效率满足基准的情况下与不满足的情况相比提供大的报酬的处理、在排气特性满足基准的情况下与不满足的情况相比提供大的报酬的处理。

·例如在如上述“关于行动变量”一栏所记载的那样将变速装置50的电磁阀的电流值设为行动变量的情况下,例如在报酬算出处理中包括以下的(a)~(c)这3个处理中的至少1个处理即可。

(a)是在变速装置对变速比的切换所需的时间为预定时间以内的情况下与超过预定时间的情况相比提供大的报酬的处理。

(b)是在变速装置的输入轴52的转速的变化速度的绝对值为输入侧预定值以下的情况下与超过输入侧预定值的情况相比提供大的报酬的处理。

(c)是在变速装置的输出轴54的转速的变化速度的绝对值为输出侧预定值以下的情况下与超过输出侧预定值的情况相比提供大的报酬的处理。

此外,(a)~(c)都是在满足与驾驶性能相关的基准的情况下与不满足的情况相比提供大的报酬的处理。详细而言,(a)是在满足与对于推力的指令值的跟随性相关的基准的情况下与不满足的情况相比提供大的报酬的处理,(b)及(c)是在满足与振动及噪音的至少一方相关的基准的情况下与不满足的情况相比提供大的报酬的处理。

“关于变更处理”

·在如上述“关于报酬算出处理”一栏所记载的那样执行根据是否满足图5的S62的上述条件(i)来提供报酬的处理和根据是否满足上述条件(ii)来提供报酬的处理的情况下,也可以将变更处理设为以下这样。即,也可以是,在自动驾驶模式下,将上述条件(i)的条件以成为不可能满足的条件的方式设定,且在不满足条件(i)的情况下作为报酬而提供“0”。这与在自动驾驶模式下不执行根据是否满足上述条件(i)来提供报酬的处理等效。因而,在自动驾驶模式下不执行根据是否满足上述条件(i)来提供报酬的处理能够视为变更根据是否满足上述条件(i)来提供报酬的处理和根据是否满足上述条件(ii)来提供报酬的处理这2个处理中的至少1个处理的处理。

另外,例如,也可以是,在手动驾驶模式下,将上述条件(ii)的条件以成为不可能满足的条件的方式设定,且在不满足条件(ii)的情况下,作为报酬而提供“0”。这与在手动驾驶模式下不执行根据是否满足上述条件(ii)来提供报酬的处理等效。因而,在手动驾驶模式下不执行根据是否满足上述条件(ii)来提供报酬的处理能够视为变更根据是否满足上述条件(i)来提供报酬的处理和根据是否满足上述条件(ii)来提供报酬的处理这2个处理中的至少1个处理的处理。

·在如上述“关于报酬算出处理”一栏所记载的那样将变速装置50的电磁阀的电流值设为行动变量的情况下,例如设为以下这样即可。即,在上述(a)的处理的情况下,相对于手动驾驶模式,在自动驾驶模式下延长预定时间。在上述(b)的情况下,相对于手动驾驶模式,在自动驾驶模式下减小输入侧预定值。在上述(c)的情况下,相对于手动驾驶模式,在自动驾驶模式下减小输出侧预定值。此外,在如上述“关于报酬算出处理”一栏所记载的那样作为与驾驶性能相关的基准而设置与振动及噪音的至少一方相关的基准的情况下,不限于(b)、(c),一般来说,相对于手动驾驶模式,在自动驾驶模式下,也可以在振动、噪音的强度超过更小的阈值的情况下提供小的报酬。

·若通过执行ACC程序74b而生成的转矩指令值Trq*是也考虑了车辆的加速度Gx的值,则也可以反过来将上述规定量ΔTrq与手动驾驶模式相比在自动驾驶模式的情况下设定得更小。

·在如上述“关于报酬算出处理”一栏所记载的那样执行在满足与能量利用效率相关的基准的情况下与不满足的情况相比提供大的报酬的处理、在排气特性满足预定的基准的情况下与不满足的情况相比提供大的报酬的处理的情况下,也可以对这些处理应用变更处理。具体而言,例如,在自动驾驶模式下,若如上述实施方式那样能够缓和向指令值的跟随性的基准等,则也可以反过来在自动驾驶模式下使与能量利用效率相关的基准、与排气特性相关的基准变严。

“关于电子设备”

·成为与行动变量相应的操作的对象的内燃机的操作部不限于节气门14、点火装置26。例如,燃料喷射阀16也可以是成为与行动变量相应的操作的对象的操作部。另外,也不限于内燃机的操作部,例如,也可以是变速装置50、锁止离合器42。另外,例如在如下述“关于推力生成装置”一栏所记载的那样具备旋转电机作为推力生成装置的情况下,也可以是连接于旋转电机的变换器等的电力变换电路。不过,不限于车载驱动系的电子设备,例如也可以是车载空调装置等。即使在该情况下,例如在车载空调装置由推力生成装置的旋转动力驱动的情况下,推力生成装置的动力中的驱动轮60的动力也依存于车载空调装置的负荷转矩。由此,使车载空调装置的负荷转矩包含于行动变量等是有效的。另外,即使例如是车载空调装置不利用旋转电机的动力的构成,车载空调装置也会影响能量利用效率。由此,向行动变量加入车载空调装置的消耗电力(功耗)是有效的。

“关于车辆用控制系统”

·在图10的处理中,将S52的处理全部在数据解析中心130中执行,但不限于此。例如,也可以是,关于S52的处理中的图5的S62~S66的处理,在车辆VC1侧执行,通过局部变更图10的(b)部分的S100的处理来将报酬r的算出结果从车辆VC1向数据解析中心130发送。

·作为车辆用控制系统,不限于由控制装置70及数据解析中心130构成。例如,也可以取代数据解析中心130而使用用户持有的便携终端,从而利用控制装置70及便携终端来构成车辆用控制系统。另外,例如,还可以利用控制装置70、便携终端及数据解析中心130来构成车辆用控制系统。该车辆用控制系统例如能够通过便携终端执行在图10中(a)部分的S36的处理而实现。

“关于车辆用控制数据的生成方法”

·在图4的S36的处理中,例示了基于行动价值函数Q来决定行动的处理,但不限于此,也可以在车辆的出货前的车辆用控制数据的生成工序等中,以相等概率选择可取的所有行动。

“关于执行装置”

作为执行装置,不限于具备CPU72(112、132)和ROM74(114、134)且执行软件处理。例如,也可以具备对在上述实施方式中软件处理的至少一部分进行硬件处理的例如ASIC等专用的硬件电路。即,执行装置是以下的(a)~(c)的任一构成即可。(a)具备按照程序来执行上述处理的全部的处理装置和存储程序的ROM等程序保存装置(包括非瞬时性的计算机能够读取的存储介质)。(b)具备按照程序来执行上述处理的一部分的处理装置及程序保存装置和执行剩余的处理的专用的硬件电路。(c)具备执行上述处理的全部的专用的硬件电路。在此,具备处理装置及程序保存装置的软件执行装置、专用的硬件电路也可以是多个。

“关于存储装置“

·在上述实施方式中,将存储关系规定数据DR的存储装置和存储学习程序74c、控制程序74a的存储装置(ROM74)设为了互相独立的存储装置,但不限于此。

“关于内燃机”

·作为内燃机,不限于火花点火式内燃机,例如也可以是使用轻油(柴油)等作为燃料的压缩着火式内燃机等。

“关于推力生成装置”

·作为搭载于车辆的推力生成装置,不仅限于内燃机,例如也可以如混合动力车那样是内燃机和旋转电机。另外,例如,也可以如电动汽车、燃料电池车那样,推力生成装置仅是旋转电机。

- 车辆用控制数据的生成方法及装置、车辆用控制装置及系统、车辆用学习装置和存储介质

- 车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统以及车辆用学习装置