基于深度强化学习的驾驶员纵向跟车行为模型构建方法

文献发布时间:2023-06-19 09:29:07

技术领域

本发明属于汽车智能安全与自动驾驶领域,特别是涉及一种基于深度强化学习的驾驶员纵向跟车行为模型构建方法。

背景技术

在未来的一段时间内,驾驶员将在智能汽车的驾驶任务中担任重要的角色。为降低驾驶员的驾驶负担,提高驾驶员的驾驶能力以及对智能驾驶系统的接受程度,需要对驾驶员的驾驶习性进行深入研究。建立准确反映驾驶员跟车行为的驾驶员模型对于智能驾驶系统控制策略的开发具有重要的意义。

近年来,从不同角度出发,如交通工程角度、人因工程角度等,或基于不同的理论、采用不同的研究方法对驾驶员跟车行为模型进行了研究。文献1(C.Lu,J.W.Gong,C.Lv, etal.A Personalized Behavior Learning System for Human-Like Longitudinal SpeedControl of Autonomous Vehicles,Sensors,19(2019)3672.)通过驾驶模拟器采集驾驶员跟车行驶数据,并使用人工神经网络学习驾驶员的速度规划行为,但是驾驶员模拟器采集的数据和实际道路的数据之间的误差较大,难以准确描述驾驶员的驾驶行为。文献2(Y.Q.Sun, H.Ge,R.H.Cheng.An extended car-following model under V2Vcommunication environment and its delayed-feedback control[J].Physica A:Statistical Mechanics and its Applications,508(2018)349-358)提出了最优速度模型,并引入一个反映驾驶员特性的参数以体现不同驾驶员的期望跟车距离。然而,该模型利用跟车行驶状态信息进行线性或非线性拟合而成,这种形式较难真实反应驾驶员跟车行为的随机性、复杂性。

深度强化学习是一种更接近人类思维方式的智能方法,其优势在于同时具有深度学习的感知能力以及强化学习的决策能力。因此,为更好的描述符合中国道路特征的驾驶员跟车行为特性,本发明从中国实际道路采集的自然驾驶数据中学习驾驶员的跟车行为,利用数据驱动对驾驶员行为进行学习,采用深度强化学习理论模拟并构建驾驶员跟车行为模型,通过模型实现对驾驶员跟车行为的复现能力。

发明内容

本发明的目的针对现有技术中存在的上述难点问题,提供可有效解决驾驶员跟车行为过程中连续动作空间上的决策问题,实现驾驶员纵向跟车行为模型的验证与评估的一种基于深度强化学习的驾驶员纵向跟车行为模型构建方法。

本发明包括以下步骤:

步骤1:基于中国实际道路工况,采集符合中国道路特征的驾驶员驾驶车辆行驶过程中的车辆状态信息和周围环境信息,统计分析采集的自然驾驶数据,给出驾驶员跟车行驶过程的行为特性及其影响因素。

步骤2:确定表征驾驶员在某个时刻t所采取动作的基准信息,建立描述驾驶员跟车行为状态迭代关系的数学模型。

步骤3,设计基于竞争Q网络构架的驾驶员纵向跟车行为模型的神经网络结构。

步骤4:设计基于竞争Q网络构架的神经网络的驾驶员纵向跟车行为学习流程,实现对驾驶员纵向跟车行为的模拟。

步骤5:设计基于深度强化学习的驾驶员纵向跟车行为模型的训练方法,实现驾驶员纵向跟车行为模型的验证与评估。

在步骤1中,所述采集符合中国道路特征的驾驶员驾驶车辆行驶过程中的车辆状态信息和周围环境信息,可采用激光雷达、CCD摄像机和采集驾驶员驾驶车辆行驶过程中的括速度、加速度、加速踏板开度信号等车辆状态信息以及天气、道路类型、信号灯、标志牌等环境信息;

所述统计分析采集的自然驾驶数据,给出驾驶员跟车行驶过程的行为特性及其影响因素的具体步骤可为:

(1)基于加权递推平均滤波法对采集的自然驾驶数据进行平滑处理,消除采集原始数据的噪声;

(2)通过频率分布和累积频率分布特征对不同工况下驾驶员跟车行为规律进行了分析和统计;

(3)通过相关系数分析了车间距离、相对速度、时距等因素的对不同工况下驾驶员跟车行为的影响,为建立驾驶员跟车行为模型提供基础。

在步骤2中,所述确定表征驾驶员在某个时刻t所采取动作的基准信息,建立描述驾驶员跟车行为状态迭代关系的数学模型的具体步骤可为:

(1)通过聚类统计分析,给出表征驾驶员基准信息的3个关键参数,分别为驾驶员跟车行为过程中自车的速度、加速度以及自车与前车之间的间距;

(2)基于建立描述驾驶员跟车行为过程中各状态变量迭代关系的数学表达式,采用速度作为性能指标,以最小化速度误差为目标,建立奖励函数。

在步骤3中,所述设计基于竞争Q网络构架的驾驶员纵向跟车行为模型的神经网络结构的具体方法可为:

(1)设计驾驶员纵向跟车行为模型竞争Q网络构架输入变量和输出变量,分别为自车速度信息、自车与前车的相对速度以及自车与前车的车间距离,输出变量为Q值函数;

(2)设计包括输入层、两个隐层以及输出层的竞争Q网络结构,其中隐层分别包含100 个和50个神经元;

(3)采用整流线性单元激活函数拟合隐层中的输入输出信号转换关系,构建激活函数表达式;

(4)设计从经验回放池取得经验样本后更新策略网络参数的损失函数,梯度下降完成神经网络参数的更新;

(5)每次训练完后,先使用梯度更新在线网络的参数,然后更新两个目标网络的参数。

在步骤4中,所述设计基于竞争Q网络构架的神经网络的驾驶员纵向跟车行为学习流程的具体步骤可为:

(1)对竞争Q网络的结构参数以及经验回放池进行初始化,基于行为策略选择随机化的加速度动作;

(2)在确定性策略中引入随机噪声,从而使动作的决策从确定性的过程变为随机过程然后再从随机过程中采样得到动作下达给环境执行;

(3)环境执行加速度动作后会获得相应的奖励,并进入下一个跟车状态,进一步将状态转换过程信息存入经验回放池中;

(4)循环训练时,从经验回放池中采样最小批量数据,进一步通过损失函数更新策略网络参数,通过策略梯度函数更新策略,最后更新目标网络参数,如此循环直至达到收敛条件。

在步骤5中,所述设计基于深度强化学习的驾驶员纵向跟车行为模型的训练方法的具体步骤可为:

(1)从总自然驾驶数据集中随机挑选并分成用于训练的训练数据集和用于验证的测试数据集;

(2)利用训练数据对跟车模型参数进行标定,训练开始时使用经验数据对状态进行初始化,并给出训练时的总训练步数;

(3)训练完成后,根据性能参数指标,如总奖励值或平均奖励值,输出模型训练效果较好时对应步数的模型参数;

(4)使用训练数据对输出的模型参数进行验证以评估所建立的驾驶员对新数据的泛化能力和适应能力。

本发明利用数据驱动对驾驶员行为进行学习,提出一种基于深度强化学习的驾驶员纵向跟车行为模型构建方法,首先通过对自然驾驶数据统计分析,给出表征驾驶员跟车行为动作基准信息的关键参数。其次,采用深度强化学习理论,构建基于竞争Q网络构架的驾驶员纵向跟车行为模型,有效解决驾驶员跟车行为过程中连续动作空间上的决策问题。然后,设计基于深度强化学习的驾驶员纵向跟车行为模型的训练方法,实现驾驶员纵向跟车行为模型的验证与评估。本发明利用数据驱动对驾驶员行为进行学习,可以准确地描述不同工况下驾驶员的跟车行为特性,实现对驾驶员跟车行为的复现能力。

附图说明

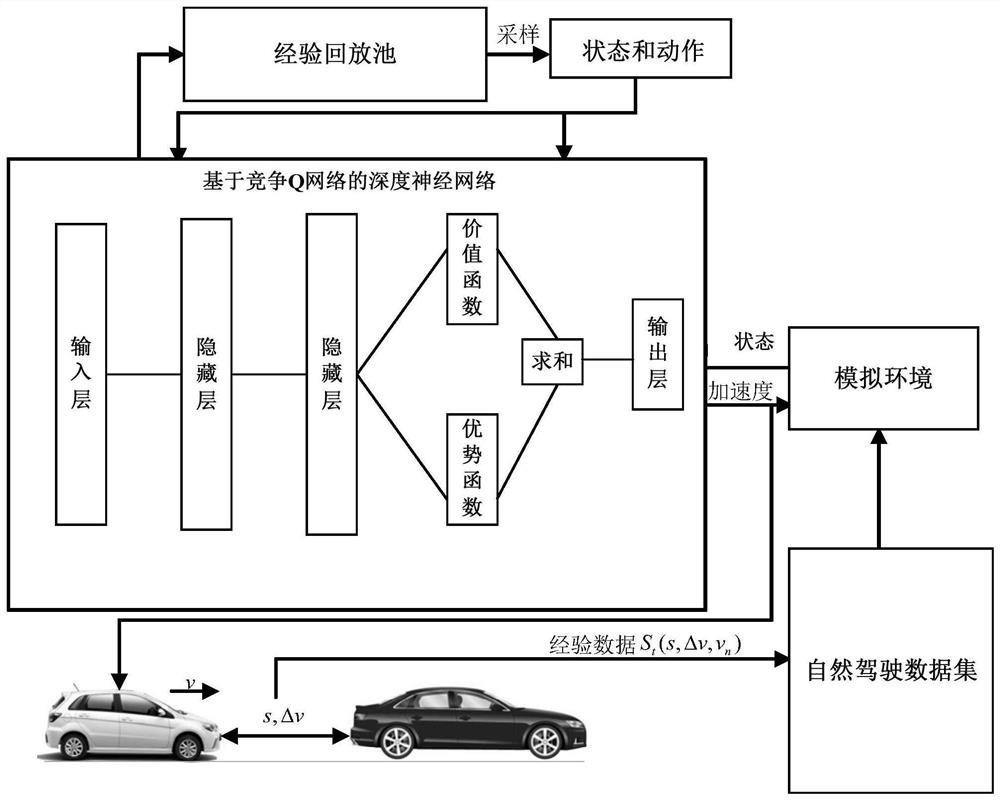

图1为本发明的驾驶员纵向跟车行为模型流程示意图。

具体实施方式

以下实施例将结合附图对本发明作进一步的说明。

本发明的驾驶员纵向跟车行为模型流程示意图如图1所示。首先采集符合中国道路特征的驾驶员跟车行为的数据,给出表征驾驶员行为动作的基准信息的关键参数,其次,构建驾驶员纵向跟车行为模型深度神经网络结构,有效解决驾驶员跟车行为过程中连续动作空间上的决策问题,然后,设计基于深度强化学习的驾驶员纵向跟车行为模型的训练方法,实现驾驶员纵向跟车行为模型的验证与评估。具体步骤如下所示:

步骤1:采集符合中国道路特征的驾驶员跟车行驶过程中的车辆状态信息和周围环境信息,统计分析采集的自然驾驶数据,给出驾驶员跟车行驶过程的行为特性及其影响因素。其过程包括如下子步骤:

步骤1.1,采用激光雷达、CCD摄像机和采集符合中国道路特征的驾驶员驾驶车辆行驶过程中的括速度、加速度、加速踏板开度信号等车辆状态信息以及天气、道路类型、信号灯、标志牌等环境信息。

步骤1.2,基于加权递推平均滤波法对采集的自然驾驶数据进行平滑处理,消除采集原始数据的噪声。

步骤1.3,通过频率分布和累积频率分布特征对不同工况下驾驶员跟车行为规律进行了分析和统计。

步骤1.4,并通过相关系数分析了车间距离、相对速度、时距等因素的对驾驶员跟车行为的影响,为建立驾驶员跟车行为模型提供基础。

步骤2:采用关键参数来表征驾驶员在某个时刻t所采取动作的基准信息,建立描述驾驶员跟车行为过程中各状态迭代关系的数学模型:

步骤2.1,确定表征驾驶员基准信息的3个关键参数,分别为第n辆车(假设为受控车辆)的速度v

步骤2.2,建立描述驾驶员跟车过程中各状态变量之间迭代关系的数学模型,如式(1)所示。

其中,T

步骤2.3,采用速度作为性能指标,以最小化速度误差为目标训练跟车模型,定义奖励函数形式如下

r=(v

其中,v

步骤3:设计驾驶员纵向跟车行为模型的深度神经网络结构。

步骤3.1,确定跟车行为模型深度神经网络结构为竞争网络结构,输入为跟车状态信息,包括主车速度、相对速度以及车间距离,输出为Q值函数。

步骤3.2,将跟车行为模型竞争网络结构设计为4层结构,依次包括输入层、两个隐藏层以及输出层,其中隐藏层分别包含100个和50个神经元。

步骤3.3,将跟车行为模型竞争网络结构的输出层设计为价格函数网络V(S

其中,S

步骤3.4,采用整流线性单元(Rectified Linear Unit,ReLU)激活函数拟合隐层中的输入输出信号转换关系。

步骤3.5,为限制隐层的输出范围,在隐层中采用tanh激活函数,使隐层输动作保持在 [-1,1]范围内。

步骤3.6,从经验回放池取得经验样本后,通过最小化损失函数更新策略网络参数,设计损失函数为:

其中,

步骤3.7,使用N个样本目标值与预计值的均方差来计算损失函数,通过梯度下降完成神经网络参数的更新。

步骤4:设计基于竞争Q网络构架的神经网络的驾驶员纵向跟车行为学习流程,实现对驾驶员纵向跟车行为的准确模拟:

步骤4.1,对竞争Q网络的结构参数以及经验回放池进行初始化,基于行为策略选择随机化的加速度动作。

步骤4.2,在确定性策略中引入Uhlenbeck-Ornstein随机噪声,从而使动作的决策从确定性的过程变为随机过程然后再从随机过程中采样得到动作下达给环境执行,其表达式为:

a

式中,N

步骤4.3,环境执行加速度动作后会获得相应的奖励,并进入下一个跟车状态,再进一步将状态转换过程信息(s

步骤4.4,循环训练时,从经验回放池中采样最小批量数据,进一步通过损失函数更新策略网络参数,通过策略梯度函数更新策略;最后更新目标网络参数,如此循环直至达到收敛条件。

步骤5:设计基于深度强化学习的驾驶员纵向跟车行为模型的训练方法,实现驾驶员纵向跟车行为模型的验证与评估:

步骤5.1,模型训练训练时,从总数据集中随机挑选并分成用于训练的训练数据集和用于验证的测试数据集两部分,其中训练数据集占比70%,测试数据集占比30%。

步骤5.2,步骤利用训练数据对跟车模型参数进行标定,训练开始时使用经验数据对状态进行初始化,训练时的总训练步数设置为1200。

步骤5.3,训练完成后,根据性能参数指标,如总奖励值或平均奖励值,输出模型训练效果较好时对应步数的模型参数。

步骤5.4,使用训练数据对输出的模型参数进行验证以评估所建立的驾驶员对新数据的泛化能力和适应能力。

以上内容是结合优选技术方案对本发明所做的进一步详细说明,不能认定发明的具体实施仅限于这些说明。对本发明所属技术领域的普通技术人员来说,在不脱离本发明的构思的前提下,还可以做出简单的推演及替换,都应当视为本发明的保护范围。

- 基于深度强化学习的驾驶员纵向跟车行为模型构建方法

- 基于深度强化学习的驾驶员纵向跟车行为模型构建方法