一种基于孪生网络的多尺度目标感知跟踪方法

文献发布时间:2023-06-19 10:51:07

技术领域

本发明属于图像处理领域,是一种基于孪生网络的多尺度目标感知跟踪方法。

背景技术

目标跟踪是计算机视觉领域的重要研究方向之一,在机器人、人机交互、军事侦查、智能交通、虚拟现实等军事、民用领域都有广泛的应用。近年来,许多学者在目标跟踪方面开展了大量工作,并取得了一定的进展。但是,在复杂环境中仍存在目标外观变形(目标纹理、形状、姿态变化等)、光照变化、快速运动和运动模糊、背景相似干扰、平面内外旋转、尺度变化、遮挡和出视野等难题,使得复杂环境下稳定实时的目标跟踪仍然是一个具有挑战性的问题。

基于孪生网络的跟踪器通过学习模板特征和搜索特征生成的相似性相关特征来预测目标在当前帧的位置信息,成功的将目标跟踪问题转换为相似性度量问题。SiamFC通过学习从基础相关(

发明内容

为了克服现有技术的不足,本发明提供一种基于孪生网络的多尺度目标感知跟踪方法,能够有效的获取分割图像的多尺度信息,从而提高了图像分割的精度。

为了解决上述技术问题本发明提供如下的技术方案:

一种基于孪生网络的多尺度目标感知跟踪方法,所述方法包括以下步骤:

S1.精细的特征聚合,过程如下:

S1.1根据视频序列第一帧获得的图片I

S1.2将获得的跟踪模板Z

S1.3将模板特征

其中,*表示基础相关计算,最后,将获得的特征

S2.注意力处理过程如下:

S2.1将相关特征R

其中H和W是相关特征R

其中,

其中⊙表示扩展的元素方式乘法(broadcasting element-wisemultiplication);

S2.2利用非局部注意力(Non-Local attention)来聚合全局上下文信息,首先将特征

其中,

其中,

S3多尺度对象感知,过程如下:

S3.1将相关特征R

其中,a和b表示该卷积模块的总卷积核尺寸,X

S4无锚预测过程如下:

S4.1将X

其中w

l=p

S4.2找到P

进一步,所述方法还包括以下步骤:

S5训练流程如下;

S5.1对训练数据集进行预处理,选取视频序列中间隔为T的两帧,根据标注信息,依照S1.1的方法裁切模板图片和搜索图片到127×127和255×255尺寸;

S5.2样本标签选取,依照大小不同的两个椭圆来分配正样本(1)、负样本(0)和忽视样本(-1),数学公式如下:

其中,(p

S5.3依次经过S1-S4.1后,分类损失L

其中P

其中,

L=L

S5.4训练过程中,批处理大小为128,学习率从0.001下降到0.0005,使用随机梯度下降算法(Stochastic Gradient Descent,SGD)迭代训练20次并保存每次迭代结果,前十次迭代冻结ResNet的参数,后十次迭代以整体网络学习率的十分之一开始训练。

一种基于孪生网络的多尺度目标感知跟踪系统(SiamMOP),包括以下四个子模块:精细特征聚合模块、注意力模块(包括通道注意力模块和非局部力注意模块)、多尺度对象感知模块(MOP)和无锚模块,SiamMOP从共享的特征提取网络ResNet开始,通过精细特征聚合模块聚合模板块和搜索块之间的特征信息;然后注意力模块结合模板特征的关键局部信息和搜索特征的上下文背景信息对相关特征进行微调;MOP模块集成了不同长宽比的相似性信息,确保每个正样本位置都能匹配不同宽高比的对象信息;无锚预测会将输入的特征进行降维,获得通道数为2的分类图和通道数为4的边框回归结果。最终算法根据分类图和边框回归结果就可以定位跟踪目标。

本发明的有益效果为:能够有效的获取跟踪区域的多尺度信息,从而提高了目标跟踪的精度。

附图说明

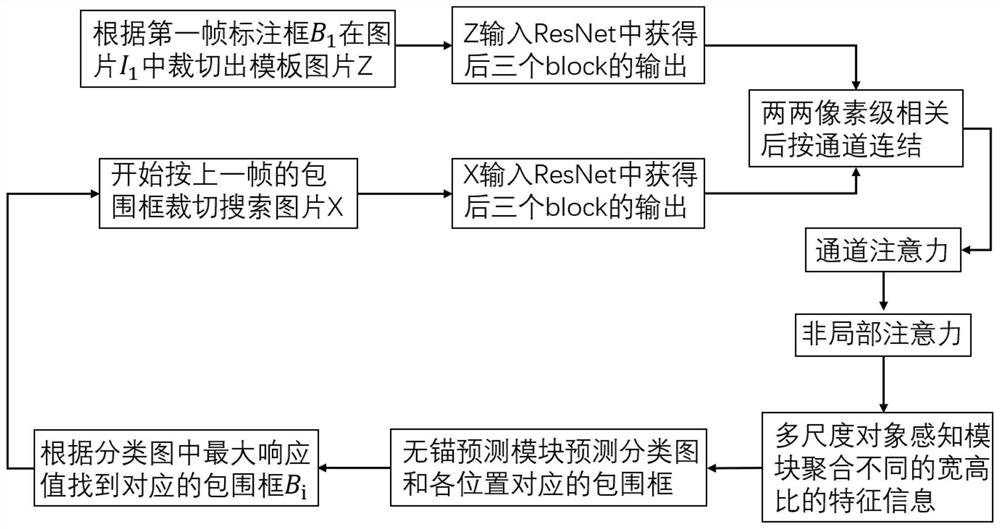

图1是SiamMOP的整体网络框架图。

图2是第一帧裁切的模板图。

图3是当前帧裁切的搜索图。

图4是通道注意力模块的网络框架图。

图5是非局部注意力模块的网络框架图。

图6是多尺度对象感知模块的网络框架图。

图7是无锚的预测模块的网络框架图。

图8是一种基于孪生网络的多尺度目标感知跟踪方法的跟踪流程图。

具体实施方式

下面结合附图对本发明作进一步描述。

参照图1~图7,一种基于孪生网络的多尺度目标感知跟踪方法,包括以下步骤:

S1.精细的特征聚合,过程如下:

S1.1根据视频序列第一帧获得的图片I

S1.2将获得的跟踪模板Z

S1.3将模板特征

其中,*表示基础相关计算,最后,将获得的特征

S2.注意力处理过程如下:

S2.1如图4所示是本发明的通道注意力模块网络图。将相关特征R

其中H和W是相关特征R

其中,

其中⊙表示扩展的元素方式乘法(broadcasting element-wisemultiplication),

S2.2如图5所示是本发明的非局部注意力模块网络图,利用非局部注意力(Non-Local attention)来聚合全局上下文信息,首先将特征

其中,

其中,

S3多尺度对象感知,过程如下:

S3.1如图6所示是本发明的多尺度对象感知模块网络图,将相关特征R

其中,a和b表示该卷积模块的总卷积核尺寸,X

S4无锚的预测,过程如下:

S4.1如图7所示是本发明的无锚的预测模块网络图,将X

其中w

l=p

S4.2找到P

S5训练流程如下:

S5.1对训练数据集进行预处理,选取视频序列中间隔为T的两帧,根据标注信息,依照S1.1的方法裁切模板图片和搜索图片到127×127和255×255尺寸;

S5.2样本标签选取,依照大小不同的两个椭圆来分配正样本(1)、负样本(0)和忽视样本(-1),数学公式如下:

其中,(p

S5.3依次经过S1-S4.1后,分类损失L

其中P

其中,

L=L

S5.4训练过程中,批处理大小为128,学习率从0.001下降到0.0005,使用随机梯度下降算法(Stochastic Gradient Descent,SGD)迭代训练20次并保存每次迭代结果,前十次迭代冻结ResNet的参数,后十次迭代以整体网络学习率的十分之一开始训练。

本实施例的基于孪生网络的多尺度目标感知跟踪系统(SiamMOP)包括以下四个子模块:精细特征聚合模块、注意力模块(包括通道注意力模块和非局部力注意模块)、多尺度对象感知模块(MOP)和无锚的预测模块,如图1所示,SiamMOP从共享的特征提取网络ResNet开始,通过精细特征聚合模块聚合模板块和搜索块之间的特征信息;然后注意力模块结合模板特征的关键局部信息和搜索特征的上下文背景信息对相关特征进行微调;此外,MOP模块集成了不同长宽比的相似性信息,确保每个正样本位置都能匹配不同宽高比的对象信息;无锚的预测模块会将输入的特征进行降维,获得通道数为2的分类图和通道数为4的边框回归结果。最终算法根据分类图和边框回归结果就可以定位跟踪目标。

如图8所示,本发明在第一帧会根据标注的目标包围框,在图片中裁切出一块作为模板图片,并输入ResNet网络提取其特征。在后续的跟踪过程中,首先会根据上一帧的目标位置信息在当前帧裁切出一定大小的搜索区域图片。其次输入相同的ResNet网络提取其特征,并与模板特征做像素级相关计算,获得具有两者的相似性信息的相关特征。然后将相关特征依次通过通道注意力模块、非局部注意力模块和无锚的预测模块,获得分类图和一致的边框回归结果。最后,找到分类图中正样本概率最高的位置,并以此找到对应的对象边框。当前帧目标的定位信息预测完毕,进入下一帧循环。

- 一种基于孪生网络的多尺度目标感知跟踪方法

- 一种基于目标感知的深度孪生网络高光谱视频目标跟踪方法