基于惩罚感知中心损失函数的用于细粒度物体检索方法

文献发布时间:2023-06-19 13:49:36

技术领域

本发明涉及深度度量学习和细粒度对象检索,具体是涉及一种基于深度度量学习的惩罚感知中心损失函数的用于细粒度物体检索的深度神经网络。

背景技术

随着深度神经网络在各种计算机领域任务上取得卓越的效果,深度神经网络的影响力日益扩大。在各种通用领域的任务可以较为容易的获得极高的性能与效果,比如猫狗检索等等问题。可是如果对于特定领域的问题的检索上,例如鸟类检索、车辆ReID,往往会存在误识别和较低检索精度的问题。这是由于在特定领域中,相同类别物体的类内差异较大,不同物体对象的类间差异较小导致的。因此,细粒度物体检索逐渐成为当前研究的热门领域,它的主要目的是通过在特定领域的问题中减小相同类别物体的类内差异和扩大不同类别物体的类间差异,来解决在特定领域的检索问题。

由于细粒度检索是对于特定领域的问题的检索上,例如鸟类检索、车辆ReID。因此,在这样的设置中,物体实例彼此相似,并且在一个通用类中。因此,不同的实例只能通过细微的部分来区分,这是关键的挑战。传统的细粒度物体检索方法往往采用人工设计的特征,比如LBP,Bag-of-Visual-Words等(具体内容可以参考文献Lingxi Xie,JingdongWang,Bo Zhang,and Qi Tian.2015.Fine-grained image search.IEEE Transactions onMultimedia),以及支持向量机来识别具有细粒度语义和视觉外观的实例。但这些人工设计的特征往往比较局限,它们对不同的环境和设备较为敏感,容易受到训练数据的干扰。随着深度学习的发展,深度神经网络被用于细粒度检索任务,并取得卓越的表现。近期,基于神经网络的方法(Xiu-Shen Wei,Jian-Hao Luo,Jianxin Wu,and Zhi-HuaZhou.2017.Selective Convolutional Descriptor Aggregation for Fine-GrainedImage Retrieval.IEEE Transactions on Image Processing.)提出利用粗粒度的显著性映射选择特征以提高检索性能的方法,说明目标定位的重要性。然而,利用粗粒度的显著性特征图和预训练的神经网络来提取的特征并不总是具有识别性,这需要精确的目标检测和实例分割。这往往需要设计复杂的网络结构和不能做到端到端训练,同时如此复杂的模型会导致泛化能力较差。

为解决上述问题,考虑使用深度度量学习来设计针对于细粒度检索问题的损失函数和网络结构来实现对于特定领域的问题的检索上,例如鸟类检索、车辆ReID。近来,目前基于代理点的损失函数设计成为深度度量学习的主要研究方向之一,例如基于代理点的损失函数(Xiawu Zheng,Rongrong Ji,Xiaoshuai Sun,Baochang Zhang,Yongjian Wu,andFeiyue Huang.2019.Towards Optimal Fine Grained Retrieval via DecorrelatedCentralized Loss with Normalize-Scale layer.In Proceedings of the Associationfor the Advance of Artificial Intelligence)通过改进经典的损失函数在细粒度检索问题上取得卓越的效果。尽管基于代理的triplet取得显著的进展,但这类工作通常在构建三元组时考虑局部数据的分布,往往忽略整个训练数据的全局分布,因为三元组是从训练数据的子集(通常是一批)中选取的。此外,该方法还存在一些数据点需要多次重复采样,而另一些数据点可能永远不会被采样的问题。因此,这种局部设置本质上不足以准确表征训练数据的整体几何结构,会导致模型对采样数据过拟合,而对未采样数据拟合不足。最后,在深度模型的训练中加入基于代理的学习使得上述问题更加严重,因为在每次迭代中只采样一小批来更新模型参数。此外,为解决深度神经网络容易过拟合的问题。考虑重新设计模型的损失函数,来解决上述问题。

发明内容

本发明的目的在于针对现有技术存在的在使用深度度量学习来设计针对于细粒度检索问题的损失函数时,没有将整个训练数据的全局分布和每一个batch中数据的局部分布特性综合起来考虑,以及一些数据点需要多次重复采样,而另一些数据点可能永远不会被采样等问题;提供一种基于深度度量学习的惩罚感知中心损失函数的用于细粒度物体检索的深度神经网络;本发明引入memory bank来存储全局中心,同时使用全局中心点来构造惩罚感知中心损失函数,使得模型更具鉴别性和泛化能力。

基于惩罚感知中心损失函数的细粒度检索方法,包括以下步骤:

1)使用resnet50网络对图片进行特征抽取,获得到对于输入信息的维度为2048的向量表征;

2)将全连接层的权重当做细粒度物体的全局中心点来构建全新的triplet loss损失函数;

3)在获得全局中心的基础上,计算每一个batch中的局部中心点,然后通过惩罚感知中心损失函数修正全局中心点,使最后参与计算的中心点尽可能接近实际意义上的中心点。

在步骤1)中,深度神经网络使用112*112大小的图片数据作为输入,单独使用一个resnet50网络对其特征抽取,在最后一个卷积层之后之后,使用一个全局池化层产生一个512维的判别特征,然后进入正则化层,将获得512维特征归一化到某一个超球面的表面层,然后进入Embedding Space,原始的欧氏距离||z

在步骤2)中,所述构建全新的triplet loss损失函数的具体步骤可为:使用z

λ

在步骤3)中,所述局部中心点C

其中,1{ }为指示函数,l

其中,e

λ

本发明的优点如下:

本发明提出一种罚感知中心损失函数,它充分利用全局数据分布和局部数据分布相结合的表达能力来学习高质量的距离度量。本发明解决了以往在使用深度度量学习来设计针对于细粒度检索问题的损失函数时,没有将整个训练数据的全局分布和每一个batch中数据的局部分布特性综合起来考虑,以及一些数据点需要多次重复采样,而另一些数据点可能永远不会被采样等问题。本发明在广泛使用的数据集CUB-200-2011上验证该方法的有效性。

附图说明

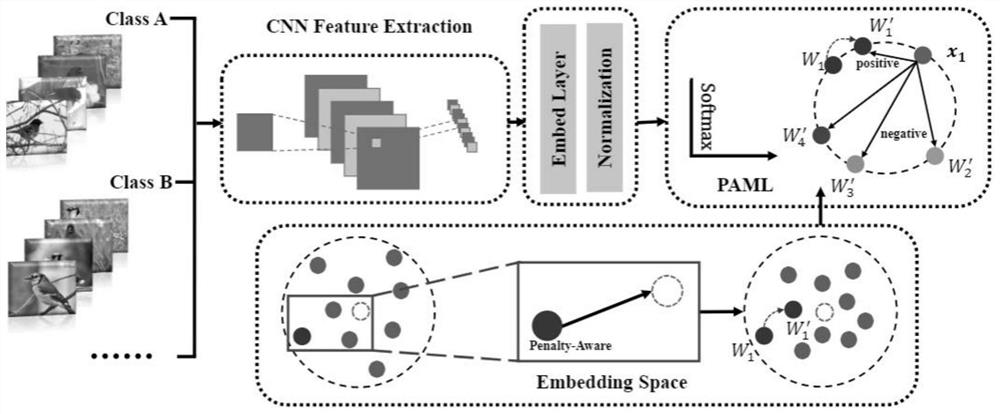

图1为本发明的网络结构框架图。

图2为本发明的对应数据集的T-SNE效果展示图。

具体实施方式

以下实施例将结合附图对本发明作详细的说明。

本发明包括以下部分:

1.正则化层(Normalization),如图1所示的Normalization层。网络使用112*112大小的图片数据作为输入,单独使用一个resnet50网络对其特征抽取,在最后一个卷积层之后之后,使用一个全局池化层产生一个512维的判别特征,然后进入正则化层,将获得512维特征归一化到某一个超球面的表面层,然后进入Embedding Space。所以,原始的欧氏距离||z

2.存储体(memory bank),为解决部分数据被多次重复采样,而另一些数据点可能永远不会被采样的问题,以及减少在传统的度量学习方法中构建三元组带来的大量计算。同时,将存储体定义为正则化层之后的全连接层的权重,与原始resnet50网络,这没有增加任何的存储空间,只是将全连接层的权重当做细粒度物体的全局中心点来构建全新的triplet loss损失函数。具体来说就是,使用z

3.惩罚感知策略,如图1所示,在获得全局中心的基础上,计算每一个batch中的局部中心点,然后通过局部中心点来修正全局中心点,使得最后参与计算的中心点可能的接近实际意义上的中心点。局部中心点C

其中,1{ }为指示函数,l

其中,e

以CUB-200-2011数据集为例进行说明。CUB-200-2011数据集包含1.2万张112*112大小的图片。图片总共可以分为200个类别的鸟类,每个鸟类都包含200张图片。

CUB-200-2011数据集中方法实验结果参见表1。

表1

从表1可以看出,在CUB-200-2011数据集上,在R@1,R@2,R@4和R@8指标上分别提高2.2,1.5,0.4,0.3个百分点。这种提高的难点于如何精准的区分只有细微差别的不同种类的的图片。

图2给出本发明的对应数据集的T-SNE效果展示图。可以看出,本发明解决一些数据点需要多次重复采样,而另一些数据点可能永远不会被采样等问题。本发明方法精确性更高。

- 基于惩罚感知中心损失函数的用于细粒度物体检索方法

- 基于对比相似性损失函数的细粒度图像检索方法