多角度增强网络的语义文本相似度计算方法

文献发布时间:2024-01-17 01:26:37

技术领域

本发明主要关于自然语言处理技术领域及计算机人工智能技术领域,特别是关于多角度增强网络的语义文本相似度计算方法。

背景技术

文本语义匹配是自然语言处理中的核心问题,也称为语义文本相似度(STS)计算,用来衡量两段文本之间的相似程度,可应用到大量的自然语言处理任务中,如信息检索、自动问答、机器翻译、推荐系统等。这些自然语言处理任务在很大程度上可以抽象为文本匹配问题,具体而言,信息检索任务,对比用户的查询与答案之间的相似度找到与其匹配的文档;自动问答任务通过问题找到与其相关的最佳候选答案;机器翻译为两种语言的相关性匹配;推荐系统通过用户的行为特征匹配用户可能感兴趣的相关度量标准。

通过将语义文本进行相似度计算归纳和分析的模型架构,主要总结为下述三类。

1、第一种框架是表示型框架,主要思想是“Siamese结构”,通过两个相同的编码器将文本对映射到同一空间中,仅利用向量间距离对两个文本向量进行相似度计算。然而,两个文本在编码过程中相互独立,缺少了明确的交互信息,造成了重要信息的丢失。

2、第二种是基于“matching-aggregation”的架构,通常使用RNN或CNN等编码器,将两个文本编码为相同长度的向量后捕获两个文本较小单元(例如字符、单词或上下文信息)的匹配信号,然后将匹配的结果聚合,从全局角度分析相似度。这种框架本质上在“Siamese network”中通过某种技术或方法进行交互,所以交互能力得到了显著提升,更好地把握了语义焦点和交互信息。

3、第三种框架是基于预训练模型的框架,它通过微调预训练的Bert模型完成具体的文本匹配任务,在多种NLP任务中都取得了不错的成果。这种方法虽然准确率有所提升但相较于前两种方法具有更高数量级的参数大小和时间成本,在平衡模型容量和准确度方面存在较大问题。

由于中文文本语义的复杂性和多义性,包含更多语义信息未被充分利用,并且仅从单一角度不能有效地捕捉上下文多角度的语义交互特征,目前的模型架构及方法还需进一步解决这个问题。

前述背景技术知识的记载旨在帮助本领域普通技术人员理解与本发明较为接近的现有技术,同时便于对本申请发明构思及技术方案的理解,应当明确的是,在没有明确的证据表明上述内容在本专利申请的申请日前已公开的情况下,上述背景技术不应当用于评价本申请技术方案的新创性。

发明内容

为解决上述背景技术中提及的至少一种技术问题,本发明的目的旨在提供一种基于简单循环单元的多角度增强网络的语义文本相似度计算方法,可以解决中文丰富的语义不能被完全利用和从单一角度无法有效地捕捉上下文语义交互特征的问题,从语义、时间和空间三个角度对文本进行全局相似性建模,捕获更丰富的全局相似性信息,从而可以提升计算语义文本相似度的准确性。

多角度增强网络的语义文本相似度计算方法,包括:

对中文文本进行分词,使用字符嵌入和词嵌入获得文本表示,在语料库中训练字符嵌入与词嵌入;

融合字符嵌入与词嵌入获得融合向量,使用Bi-SRU对融合向量进行编码;

使用软对齐注意力进一步捕获两个文本的相似性和差异性;

对文本进行全局相似性建模,捕获更丰富的全局相似性信息;

通过池化层将结果向量表示为固定向量,输入到MLP多分类器中,进行分类;

通过MLP多分类器的softmax对两个文本的相似程度进行预测,输出为文本语义相似度的预测概率。

作为本申请技术方案的优选,所述对中文文本进行分词时使用jieba分词工具进行。

作为本申请技术方案的优选,所述语料库包括维基百科和/或百度百科。

作为本申请技术方案的优选,所述在语料库中训练字符嵌入与词嵌入执行下述步骤:

字符嵌入和词嵌入由Word2Vec进行训练;

设置字符向量维度为300,词向量维度为300,得到两个文本a和b的词向量矩阵

作为本申请技术方案的优选,所述使用Bi-SRU对融合向量进行编码执行下述步骤:

将融合向量输入到Bi-SRU中;

在Bi-SRU中进行轻量计算去除门控结构中对上一时刻隐藏状态的依赖以减轻递归程度,同时,采用跳跃连接;

通过Bi-SRU后得到的特征序列为

作为本申请技术方案的优选,所述将融合向量输入到Bi-SRU时公式如下:

其中,

作为本申请技术方案的优选,所述使用软对齐注意力进一步捕获两个文本的相似性和差异性执行下述步骤:

使用软对齐注意力来计算文本对之间的隐藏状态组

对于

其中,

对于

作为本申请技术方案的优选,所述使用软对齐注意力进一步捕获两个文本的相似性和差异性更进一步的执行下述步骤:

通过计算元组

其中,⊙代表逐元素乘法,I

作为本申请技术方案的优选,所述对文本进行全局相似性建模时从语义、时间和空间三个角度进行。

作为本申请技术方案的优选,所述对文本进行全局相似性建模,捕获更丰富的全局相似性信息执行下述步骤:

将前述局部相似信息合成后输入到至少2层Bi-SRU中,分别捕获文本的语义和时间的全局相似性信息,具体公式包括:

其中,G为带有ReLU激活的1层前馈神经网络,l

作为本申请技术方案的优选,所述对文本进行全局相似性建模,捕获更丰富的全局相似性信息进一步执行下述步骤:

将上一步输出的结果

其中,k

在卷积生成输出的基础上进行最大池化和按列平均池化,以从中为每个特征图捕获最有价值的特征,并将这些向量连接起来表示为最终向量,整体NIN公式为:

其中,

作为本申请技术方案的优选,所述通过池化层将结果向量表示为固定向量,输入到MLP多分类器中,进行分类,具体执行下述步骤:

使用平均池化操作和最大池化操作获得向量结果,并将得到的向量结果与NIN层的输出连接起来,形成最终的固定向量o,公式如下:

其中,

将o输入到多层感知机分类器中:y=MLP(o);

其中,MLP包括一个带有tanh激活的隐藏层和一个带有softmax的输出层。

作为本申请技术方案的优选,训练模型的操作具体如下:

创建损失函数:使用sigmoid交叉熵损失函数进行训练,公式如下:

选择优化器:经过实验对比选择使用Adam优化器通过反向传播来更新参数,学习率设置为0.0002;

当模型尚未进行训练时,需要进行训练,在最优时保存模型参数;当模型训练完毕时,即可判断所输入的文本语义是否相似。

计算机可读存储介质,所述计算机可读存储介质内存储有可被处理器执行的计算机程序,所述计算机程序被处理器执行时运行前述所述多角度增强网络的语义文本相似度计算方法中的至少一个步骤。

计算机设备,所述计算机设备包括存储器、处理器、通信接口以及通信总线;其中,所述存储器、处理器、通信接口通过所述通信总线进行相互间的通信;所述存储器,用于存放计算机程序;所述处理器,用于执行所述存储器上所存放的计算机程序,所述处理器执行所述计算机程序时实现前述所述多角度增强网络的语义文本相似度计算方法中的至少一个步骤。

本申请的有益效果为:

(一)本发明使用字符粒度嵌入和词粒度嵌入融合,通过两种粒度的嵌入捕获中文文本中更细粒度的语义特征信息,充分利用中文文本的语义信息;

(二)利用易于拓展的简单循环单元网络(Bi-SRU)代替Bi-LSTM来提取文本语法及语义信息,降低模型计算时间,并提高准确性;

(三)从语义、时间和空间三个角度对文本进行全局相似性建模,捕获更丰富的全局相似性信息,从而提高文本语义文本相似度预测的准确性。

附图说明

为让本发明的上述和/或其他目的、特征、优点与实例能更明显易懂,下面将对本发明的具体实施方式中所需要使用的附图进行简单的介绍,显然地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域技术人员来讲,在不付出创造性劳动的情况下还可以根据这些附图获得其他的附图。

图1是本发明提出的多角度增强网络的语义文本相似度计算方法流程图;

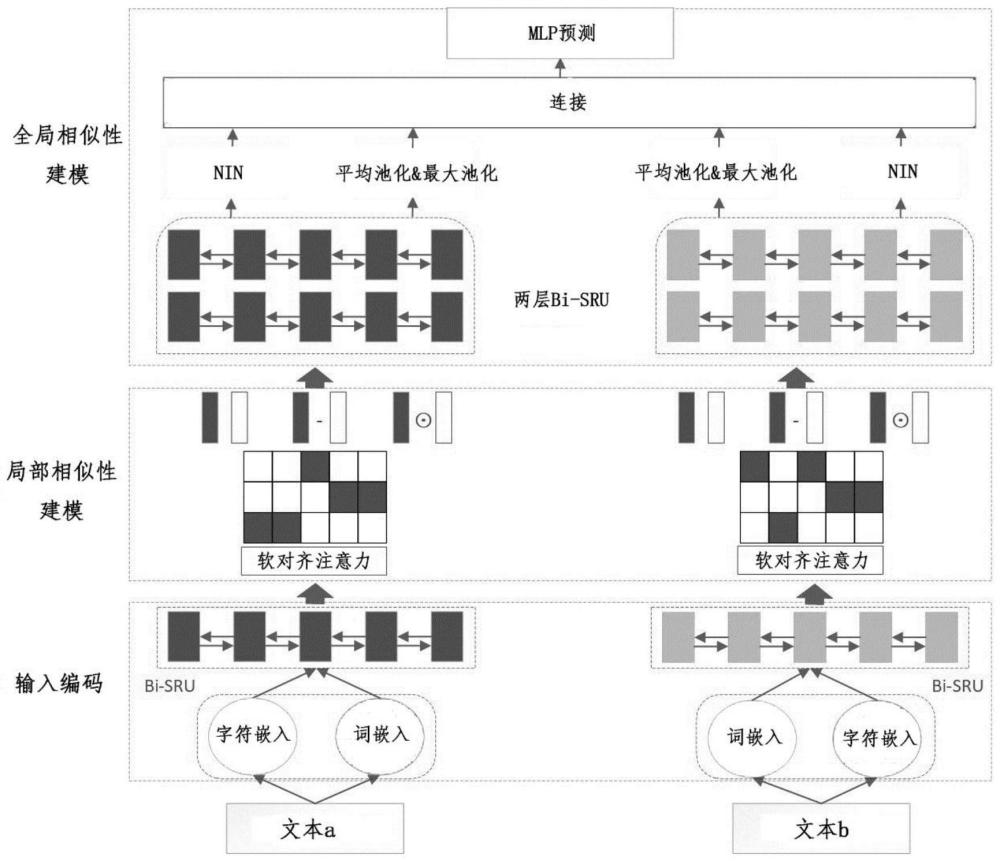

图2是本发明提出的多角度增强网络的语义文本相似度计算方法的技术流程框图。

具体实施方式

本领域技术人员可以借鉴本文内容,适当替换和/或改动工艺参数实现,然而特别需要指出的是,所有类似的替换和/或改动对本领域技术人员来说是显而易见的,它们都被视为包括在本发明。本发明所述产品和制备方法已经通过较佳实例进行了描述,相关人员明显能在不脱离本发明内容、精神和范围内对本文所述的产品和制备方法进行改动或适当变更与组合,来实现和应用本发明技术。

除非另有定义,本文所使用的技术和科学术语,具有本发明所属领域的普通技术人员通常所理解的相同的含义。本发明使用本文中所描述的方法和材料;但本领域中已知的其他合适的方法和材料也可以被使用。本文中所描述的材料、方法和实例仅是说明性的,并不是用来作为限制。所有出版物、专利申请案、专利案、临时申请案、数据库条目及本文中提及的其它参考文献等,其整体被并入本文中作为参考。若有冲突,以本说明书包括定义为准。

除非具体说明,本文所描述的材料、方法和实例仅是示例性的,而非限制性的。尽管与本文所述的那些方法和材料类似或等同的方法和材料可用于本发明的实施或测试,但本文仍描述了合适的方法和材料。

为了便于理解本发明的实施例,首先对本发明实施例中可能涉及的缩略语和关键术语进行解释说明或定义。

Bi-SRU:双向SRU网络;

MLP:Multilayer Perceptron,多层感知机,又称人工神经网络;

Word2Vec:一群用来产生词向量的相关模型,具体为浅而双层的神经网络,用来训练以重新建构语言学之词文本;

ReLU:Linear rectification function,线性整流函数,又称修正线性单元,是一种人工神经网络中常用的激活函数;

CNN:Convolutional Neural Networks,卷积神经网络;

tanh:双曲正切激活函数;

softmax:归一化指数函数;

decomposable attention:可分解的注意力模型;

ABCNN:Attention-Based Convolutional Neural Network,基于注意力的卷积神经网络模型;

BiMPM:bilateral multi-perspective matching model,双向多视角匹配模型;

ESIM:Enhanced Sequential Inference Model,增强型顺序推理模型,是一个综合应用了BiLSTM和注意力机制的模型;

RE2:阿里巴巴和南京大学发表的在2019年发表的一篇文本匹配论文:Simple andEffective Text Matching with Richer Alignment Features中提及的一种模型,没有使用LSTM进行特征提取,支持了并行化处理以及参数也少了很多;

ERCNN:基于误差反馈递归卷积神经网络。

以下详细描述本发明。

实施例1:

提供一种基于简单循环单元的多角度增强网络的语义文本相似度计算方法,流程图如图1所示,方法简要过程如下:

首先对中文文本进行分词,使用字符嵌入和词嵌入获得文本表示,在维基百科和百度百科预训练字符嵌入与词嵌入,通过两种粒度的嵌入捕获中文文本中更细粒度的语义特征信息。

其次利用易于拓展的简单循环单元网络(Bi-SRU)代替Bi-LSTM来对融合字符嵌入与词嵌入后获得的融合向量进行文本语法及语义信息的提取,对文本进行编码。

再次使用软对齐注意力进一步捕获两个文本的相似性和差异性。

最后从语义、时间和空间三个角度对文本进行全局相似性建模,捕获更丰富的全局相似性信息。

最终通过池化层将结果向量表示为固定向量,输入到MLP多分类器中,进行分类,对两个文本的相似程度进行预测,输出语义相似度的预测概率。

实施例2:

在前述实施例的基础上,进一步详细描述基于简单循环单元的多角度增强网络的语义文本相似度计算方法,其技术流程框图如图2所示,其具体步骤如下。

步骤一:

使用jieba分词工具对输入的两个中文文本进行分词,使用词嵌入和字符嵌入来获得文本表示。词嵌入和字符嵌入使用由Word2Vec预先使用相关语料库进行训练。在训练过程中发现可训练的词嵌入可能导致过拟合现象出现,因此,词嵌入是固定的。设置字符向量维度为300,词向量维度为300。得到两个文本的词向量矩阵

步骤二:

将词嵌入和字符嵌入进行融合,将融合的向量输入到双向SRU网络(Bi-SRU)中进行编码。在SRU中进行轻量计算去除门控结构中对上一时刻隐藏状态的依赖以减轻递归程度,同时,采用跳跃连接。通过Bi-SRU后得到的特征序列为

将得到的文本表示A和B输入到Bi-SRU中,公式如下:

其中,

步骤三:

使用软对齐注意力来计算文本对之间的隐藏状态组

对于

其中,

步骤四:

通过计算元组

其中,⊙代表逐元素乘法,I

步骤五:

将前述局部相似信息合成后输入到2层Bi-SRU中,分别捕获文本的语义和时间的全局相似性信息,具体公式为:

其中,G为带有ReLU激活的1层前馈神经网络,l

步骤六:

在完全捕获到时间角度和语义角度的全局相似性信息后,使用CNN层来进一步捕获空间角度的全局相似性信息,同时引入“NIN”思想,即“Network In Network”,来改进CNN以达到更好的性能。将上一步输出的结果

在卷积生成输出的基础上进行最大池化和按列平均池化,以从中为每个特征图捕获最有价值的特征,并将这些向量连接起来表示为最终向量,整体NIN公式为:

步骤七:

将通过两层Bi-SRU的向量结果经过池化层处理为固定长度的向量,具体是使用平均池化操作和最大池化操作,并将得到的向量结果与NIN层的输出连接起来,形成最终的固定长度的向量o。操作公式如下:

其中,

将o输入到多层感知机分类器中:y=MLP(o);其中,MLP包括一个带有tanh激活的隐藏层和一个带有softmax的输出层。

通过softmax来对两个文本的相似程度进行预测,MLP的输出为文本A和B语义相似度的预测概率。

训练模型的操作具体如下:

创建损失函数:使用sigmoid交叉熵损失函数进行训练,公式如下:

选择优化器:经过实验对比选择使用Adam优化器通过反向传播来更新参数,学习率设置为0.0002;

当模型尚未进行训练时,需要进行训练,在最优时保存模型参数;当模型训练完毕时,即可判断所输入的文本语义是否相似。

本发明方法首先对文本进行分词操作,使用词嵌入和字符嵌入来表示文本,并将字符粒度嵌入和词粒度嵌入融合,通过两种粒度的嵌入捕获中文文本中更细粒度的语义特征信息,充分利用中文文本的语义信息,然后通过简单循环单元网络(Bi-SRU)代替Bi-LSTM来提取文本语法及语义信息,降低模型计算时间不低于30%,旨在因本申请方案通过对文本进行全局相似性建模后从语义、时间和空间三个角度捕获更丰富的全局相似性信息,从而显著提高了文本语义文本相似度预测的准确性,表1示出了本申请方案同传统模型的验证结果对比,可知本申请模型(SMAEN)具有85.88%的准确率及86.62%的F1值,均优于现有技术的传统模型。

表1-模型验证结果

实施例3:

在前述实施例的基础上,提供一种计算机可读存储介质,所述计算机可读存储介质内存储有可被处理器执行的计算机程序,所述计算机程序被处理器执行时运行前述所述多角度增强网络的语义文本相似度计算方法的各个步骤,且能达到相同的技术效果,为避免重复,这里不再赘述。

实施例4:

在前述实施例的基础上,提供一种计算机设备,所述计算机设备包括存储器、处理器、通信接口以及通信总线;其中,所述存储器、处理器、通信接口通过所述通信总线进行相互间的通信;所述存储器,用于存放计算机程序;所述处理器,用于执行所述存储器上所存放的计算机程序,所述处理器执行所述计算机程序时实现前述所述多角度增强网络的语义文本相似度计算方法中的各个步骤,且能达到相同的技术效果,为避免重复,这里不再赘述。

计算机可读介质包括永久性和非永久性、可移动和非可移动媒体,可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(PR AM)、静态随机存取存储器(SRAM)、动态随机存取存储器(DRAM)、其他类型的随机存取存储器(RAM)、只读存储器(ROM)、电可擦除可编程只读存储器(EEPROM)、快闪记忆体或其他内存技术、只读光盘只读存储器(CD-ROM)、数字多功能光盘(DVD)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。按照本文中的界定,计算机可读介质不包括暂存电脑可读媒体(transitory media),如调制的数据信号和载波。

上述实施例中的常规技术为本领域技术人员所知晓的现有技术,故在此不再详细赘述。

本文中所描述的具体实施例仅仅是对本发明精神作举例说明。本发明所属技术领域的技术人员可以对所描述的具体实施例做各种修改或补充或采用类似的方式替代,但并不会偏离本发明的精神或者超越所附权利要求书所定义的范围。

尽管对本发明已作出了详细的说明并引证了一些具体实施例,但是对本领域熟练技术人员来说,只要不离开本发明的精神和范围可作各种变化或修正是显然的。

虽然上述具体实施方式已经显示、描述并指出应用于各种实施方案的新颖特征,但应理解,在不脱离本公开内容的精神的前提下,可对所说明的装置或方法的形式和细节进行各种省略、替换和改变。另外,上述各种特征和方法可彼此独立地使用,或可以各种方式组合。所有可能的组合和子组合均旨在落在本公开内容的范围内。上述许多实施方案包括类似的组分,并且因此,这些类似的组分在不同的实施方案中可互换。虽然已经在某些实施方案和实施例的上下文中公开了本发明,但本领域技术人员应理解,本发明可超出具体公开的实施方案延伸至其它的替代实施方案和/或应用以及其明显的修改和等同物。因此,本发明不旨在受本文优选实施方案的具体公开内容限制。

本发明未尽事宜均为公知技术。