一种储能参与调频辅助服务优化的控制方法及其系统

文献发布时间:2023-06-19 11:32:36

技术领域

本发明涉及电力系统储能技术领域,尤其涉及一种储能参与调频辅助服务优化的控制方法、系统、终端设备及其可读存储介质。

背景技术

储能可以和传统电源一样参与能量市场、调频市场和备用市场,以价格接受者方式在市场出清,提供服务获取收益。但因为储能不能发电,所以在能量市场中只能利用不同时段的电价差进行电能套利,收益十分微薄。在当前的电池成本水平下,仅仅参与能量市场很难收回投资成本。为了促进储能发展,寻找能够使其盈利的商业应用和模式至关重要。电池储能是一类优质的快速响应资源。让电池储能为电网提供备用、调频等辅助服务,一方面可以充分利用电池容量,增加其市场收益,改善其经济性,另一方面可以缓解电网的调峰调频压力。调频市场收益一般分为调频容量收益和调频绩效收益两部分,其中调频绩效收益是储能在调频辅助服务市场中的主要收益来源。调频绩效收益主要是通过调频设备响应功率与调频信号的重合程度来衡量的。对于快速调频信号,一般都是以秒级周期来更新响应信号。因此,设计储能在秒级时序上的优化控制策略,可以满足储能参与调频市场的需求,对于完善储能参与电力市场机制、促进储能设备发展具有重要意义。

发明内容

本发明目的在于,提供一种储能参与调频辅助服务优化的控制方法及其系统,通过优化储能的实时控制策略,提高储能的调频绩效收入,从而提高储能运营商的市场收益水平,同时也能优化储能设备的投资回报率,促进储能建设。

为实现上述目的,本发明提供一种储能参与调频辅助服务优化的控制方法,包括:

获得调频市场的历史调频信号数据,其中,所述历史调频信号数据包括训练数据集和测试数据集;

构建基于深度强化学习算法的储能参与调频辅助服务模型;

根据储能的当前状态、当前动作、当前动作的即时收益、下个时刻的状态以及调度周期结束标志建立深度强化学习的经验回放池;

根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型;

根据所述测试数据集检测训练完毕的所述储能参与调频辅助服务模型;

根据所述储能参与调频辅助服务模型对所述储能进行优化控制。

优选地,所述深度强化学习算法包括深度确定性策略梯度(DDPG)算法。

优选地,所述构建基于深度强化学习的储能参与调频辅助服务模型,包括:

随机初始化模型的权重参数θ

优选地,所述经验回放池包括五元组元素,所述五元组元素为

优选地,所述构建基于深度强化学习的储能参与调频辅助服务模型之前,还包括:建立秒级时序上的储能充放电模型和调频绩效收益模型。

优选地,根据所述调频绩效收益模型获得所述储能当前动作的即时收益

优选地,根据Actor网络选择所述储能的当前动作R

R

其中,N

优选地,所述根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型,包括:

从所述经验回放池中随机抽取N个所述五元组元素

根据损失函数和随机梯度下降法更新Critic网络Q(s

其中,y

其中,γ为折现率;

根据梯度下降方法更新Actor网络μ(s

其中,J代表当前状态下,选择动作R的期望收益值,R代表动作值变量,公式如下:

根据所述权重参数θ

θ

θ

其中λ为软更新系数;

判断所述权重参数θ

本发明提供还提供一种储能参与调频辅助服务优化的控制系统,应用于上述的储能参与调频辅助服务优化的控制方法,包括:

数据集分配模块,用于将调频市场的历史调频信号数据分为训练数据集和测试数据集;

模型构建模块,用于构建基于深度强化学习算法的储能参与调频辅助服务模型;

经验回放池建立模块,用于根据储能的当前状态、当前动作、当前动作的即时收益、下个时刻的状态以及调度周期结束标志建立深度强化学习的经验回放池;

模型训练模块,用于根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型;

模型检测模块,用于根据所述测试数据集检测训练完毕的所述储能参与调频辅助服务模型。

本发明还提供一种计算机终端设备,包括一个或多个处理器和存储器。存储器与所述处理器耦接,用于存储一个或多个程序;当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现如上述的储能参与调频辅助服务优化的控制方法。

本发明还提供一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现如上述的储能参与调频辅助服务优化的控制方法。

本发明的储能参与调频辅助服务优化的控制方法及其系统中,针对调频信号的随机性和快速变化的动态性质,提供一种基于深度强化学习的储能与调频信号互动方式,将储能的运行状态、调频信号映射为充放电动作,采用深度强化学习算法对储能的充放电策略进行优化,从而实现储能在秒级时序上的快速优化控制。

附图说明

为了更清楚地说明本发明的技术方案,下面将对实施方式中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施方式,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

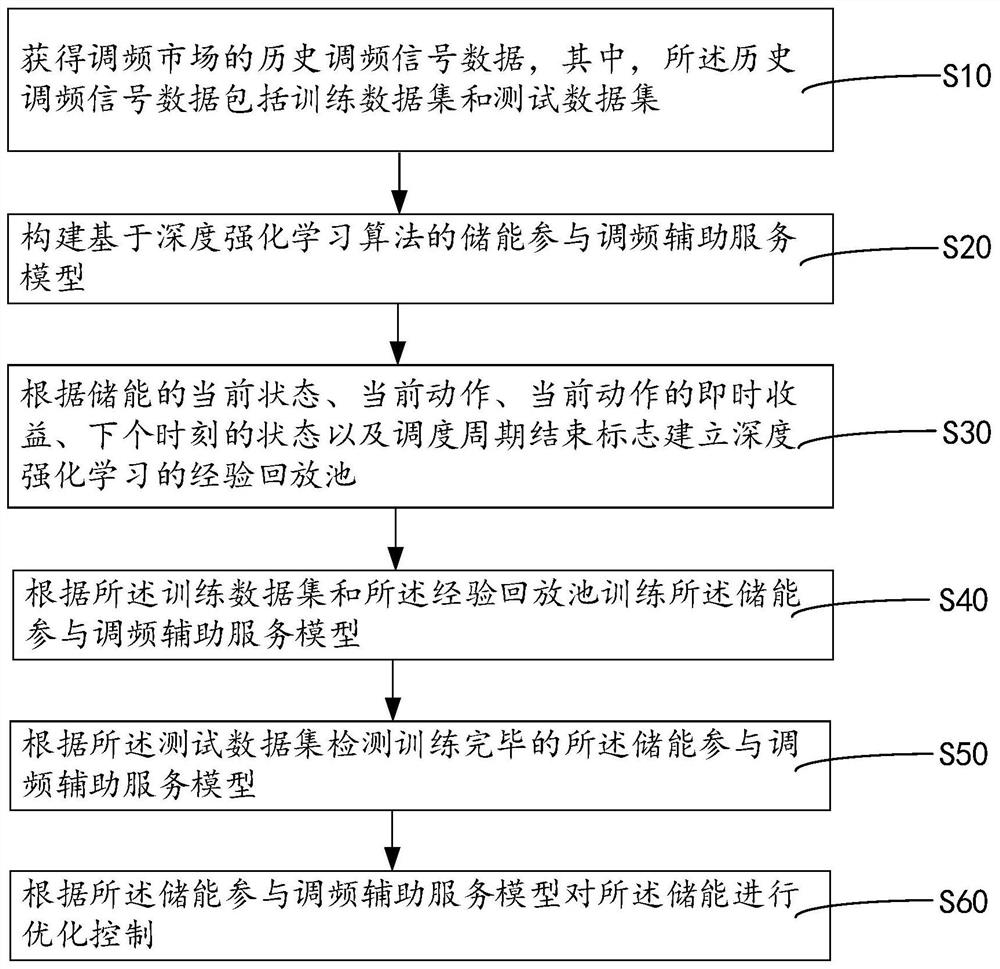

图1是本发明某一实施例提供的储能参与调频辅助服务优化的控制方法的流程示意图;

图2是本发明另一实施例提供的储能参与调频辅助服务优化的控制方法的流程示意图;

图3是本发明某一实施例提供的单个电池的最大充放电功率与荷电状态的约束条件的示意图;

图4是本发明某一实施例提供的计算机终端设备的结构示意图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

应当理解,文中所使用的步骤编号仅是为了方便描述,不对作为对步骤执行先后顺序的限定。

应当理解,在本发明说明书中所使用的术语仅仅是出于描述特定实施例的目的而并不意在限制本发明。如在本发明说明书和所附权利要求书中所使用的那样,除非上下文清楚地指明其它情况,否则单数形式的“一”、“一个”及“该”意在包括复数形式。

术语“包括”和“包含”指示所描述特征、整体、步骤、操作、元素和/或组件的存在,但并不排除一个或多个其它特征、整体、步骤、操作、元素、组件和/或其集合的存在或添加。

术语“和/或”是指相关联列出的项中的一个或多个的任何组合以及所有可能组合,并且包括这些组合。

请参阅图1和图2,本发明实施例提供一种储能参与调频辅助服务优化的控制方法,包括:

S10、获得调频市场的历史调频信号数据,其中,所述历史调频信号数据包括训练数据集和测试数据集;

S20、构建基于深度强化学习算法的储能参与调频辅助服务模型;

S30、根据储能的当前状态、当前动作、当前动作的即时收益、下个时刻的状态以及调度周期结束标志建立深度强化学习的经验回放池;

S40、根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型;

S50、根据所述测试数据集检测训练完毕的所述储能参与调频辅助服务模型;

S60、根据所述储能参与调频辅助服务模型对所述储能进行优化控制。

在本实施例中,保存调频市场的历史调频信号作为深度强化学习的输入数据,调频市场一般包含快调频和慢调频两类调频信号。以PJM市场为例,根据美国联邦能源管理委员会(FERC)的第755号法令的指示,依据绩效收入的原则,PJM提供了两类调节信号:传统的调频信号RegA和动态调频信号RegD。其中前者是传统的监管调频资源的信号,该信号考虑了资源的爬坡率限制,由此变化速率较慢。而RegD信号则用来调节具有很高爬坡率能够快速响应的资源,这种信号来于RegA信号相同的算法,然而,经过高通滤波,收益频率变得非常快,且该信号在60分钟之内是能量中性的,这对于无法自身生产能量的储能来说无疑是有利的。RegD信号一般以4s为间隔。设总记录采集到调频信号为{S

建立基于深度确定性策略梯度(DDPG)算法的储能参与调频辅助服务模型,构建DDPG的神经网络并初始化神经网络的参数。

使用训练数据集训练DDPG的神经网络模型。从训练集中选取一个样本并初始化储能状态,通过随机探索获得经验回放池的元素,从经验回放池中随机抽取一个批量的元素并用于训练DDPG的神经网络参数,重复以上过程直到各个神经网络的权重参数收敛。

使用所述测试数据集评价储能的优化控制策略执行效果,将所述测试数据集带入到训练完毕的所述储能参与调频辅助服务模型中,用于检测模型训练的效果。

最后,根据所述储能参与调频辅助服务模型对所述储能进行优化控制。

如此,基于深度强化学习的储能优化控制策略思路,相对于常规的随机优化方法,如随机动态规划等方法,该方法在计算优化策略时具有显著的时间效率,更能够适应储能在秒级时序上的快速优化控制需求。

在某一个实施例中,所述深度强化学习算法包括深度确定性策略梯度(DDPG)算法。

在本实施例中,利用深度确定性策略梯度(DDPG)算法构建储能参与调频辅助服务模型,在其他实施例中,所述深度强化学习算法还包括深度Q网络(DQN)和策略梯度算法(DPG),在此不做限定。

在某一个实施例中,所述构建基于深度强化学习的储能参与调频辅助服务模型,包括:

随机初始化模型的权重参数θ

在本实施例中,构建DDPG的神经网络。DDPG具有一种行动者-评论家(Actor-Critic)结构的神经网络。其中,动作估计(Actor)网络用于给出动作,状态估计(Critic)网络用于对动作的结果做出评价打分。Actor和Critic又各自分别有一个目标网络(target-net)和一个实际的网络(eval-net)。分别定义Actor网络和Critic网络为μ(s

随机初始化模型参数θ

采用深度确定性策略梯度(DDPG)算法对储能的充放电策略进行优化,从而实现储能在秒级时序上的快速优化控制。DDPG算法相对于其他深度学习算法的主要优势在于拥有连续的状态空间和连续的动作空间,因此更能适应储能参与调频辅助服务的场景需求。

在某一个实施例中,所述经验回放池包括五元组元素,所述五元组元素为

在本实施例中,建立深度强化学习的经验回放池。经验回放池的目的是让神经网络通过过去的经验来学习策略。经验回放池中包含的每一个元素都是一个五元组元素

经验回放池让储能参与调频辅助服务模型通过过去的经验来学习策略,实现储能参与调频辅助服务的优化控制。

在某一个实施例中,所述构建基于深度强化学习的储能参与调频辅助服务模型之前,还包括:建立秒级时序上的储能充放电模型和调频绩效收益模型。

建立秒级时序上的储能充放电模型。建立储能电量的动态方程、储能充放电功率约束条件、荷电状态约束条件、最大充放电功率与荷电状态的约束条件等,定义储能在调频辅助服务中的状态变量。具体地,

步骤1-1.储能电量的动态方程为:

其中,E

步骤1-2.储能的充放电功率会受到接口容量的限制,在一定范围内可控:

其中,SOC

步骤1-3.SOC

SOC

其中,SOC

请参阅图3,步骤1-4.单个电池的最大充放电功率与荷电状态的约束条件具体表达式如下:

步骤1-5.定义储能在t时刻的动作(也就是响应信号)R

其中,n为一个调度周期的指令数,可以取15分钟为一个调度周期,则n=15min/4s=225。可以看到R

步骤1-6.当储能参与调频辅助服务时,定义储能在t时刻的状态为s

建立秒级时序上的所述储能充放电模型,实现储能在秒级时序上的快速优化控制。

建立所述调频绩效收益模型。计算储能在调频市场中每个响应信号的调频绩效收益。不同市场规则中调频绩效收益的计算方式不同,但基本上都主要由调频性能指标决定,而调频性能指标通过比较调频信号和市场主体的响应信号决定。储能在调频辅助服务中的绩效收益基于调频总里程、调频价格和调频精确度,建立各时刻的调频精确度与储能响应信号之间的函数。具体地,

步骤2-1.首先计算调频信号的总里程,调频总里程M可以表示为:

步骤2-2.计算调频性能指标,调频性能指标具体表现为响应信号的精确度,是储能的充放电曲线与调频信号差值的函数。精确度越接近0,表示储能对信号的响应越低,越接近1,表示储能的充放电行为与调频信号越一致。调频性能指标可以表示为:

V为一个调度周期调频信号绝对值的平均值。可以看出A

步骤2-3.得到调频市场中,市场主体的调频绩效收益R

R

其中,p

通过建立调频绩效收益模型,计算储能在调频市场中每个响应信号的调频绩效收益。

在某一个实施例中,根据所述调频绩效收益模型获得所述储能当前动作的即时收益

在本实施例中,步骤2计算所述储能当前动作的即时收益

在某一个实施例中,根据Actor网络选择所述储能的当前动作R

R

其中,N

在本实施例中,通过Actor网络选择一个响应动作如下:

其中N

在某一个实施例中,所述根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型,包括:

从所述经验回放池中随机抽取N个五元组元素

根据损失函数和随机梯度下降法更新Critic网络Q(s

其中,y

其中,γ为折现率;

根据策略梯度方法更新Actor网络μ(s

其中,J代表当前状态下,选择动作R的期望收益值,R代表动作值变量,公式如下:

根据所述权重参数θ

θ

θ

其中λ为软更新系数;

判断所述权重参数θ

在本实施例中,使用训练数据集训练DDPG的神经网络模型。

步骤3-1.从训练数据集

步骤3-2.通过Actor网络选择一个响应动作如下:

其中N

步骤3-3.从经验回放池中随机抽取N个五元组元素

其中γ为折现率,可以取γ=0.95。

步骤3-4.采用如下损失函数更新的Q(s

采用的更新算法为随机梯度下降法(SGD)。

步骤3-5.用策略梯度方法更新Actor网络的参数θ

其中J代表当前状态下,选择不同动作R的期望收益值,因此用同一批量中的平均值表示、R代表是一个变量,不是固定的动作值。

步骤3-6.更新两个目标网络如下:

θ

θ

其中λ为软更新系数,即每次只更新目标网络的λ部分,保留原参数的1-λ部分。

并回到步骤3-3,重复步骤3-3至3-6。

步骤3-7.重复步骤3-1至3-6直至所述权重参数θ

最后通过训练得到的神经网络μ(s

并基于t时刻的动作(也就是响应信号)R

使用测试数据集

其中,Critic网络是一个价值评价网络,它的输入是当前状态和某个选定的动作,输出是在当前状态下选择该动作的价值。Actor网络是一个行动网络,输入当前状态,输出为最优动作。两个目标网络的意义是为了延迟更新参数,从而避免训练网络参数时出现发散的结果。

本发明实施例针对调频信号的随机性和快速变化的动态性质,提供一种基于深度强化学习的储能与调频信号互动方式,将储能的运行状态、调频信号映射为充放电动作,采用深度确定性策略梯度(DDPG)算法对储能的充放电策略进行优化,从而实现储能在秒级时序上的快速优化控制。

本发明实施例提供还提供一种储能参与调频辅助服务优化的控制系统,应用于上述任一实施例中的储能参与调频辅助服务优化的控制方法,包括:

数据集分配模块,用于将调频市场的历史调频信号数据分为训练数据集和测试数据集;

模型构建模块,用于构建基于深度强化学习算法的储能参与调频辅助服务模型;

经验回放池建立模块,用于根据储能的当前状态、当前动作、当前动作的即时收益、下个时刻的状态以及调度周期结束标志建立深度强化学习的经验回放池;

模型训练模块,用于根据所述训练数据集和所述经验回放池训练所述储能参与调频辅助服务模型;

模型检测模块,用于根据所述测试数据集检测训练完毕的所述储能参与调频辅助服务模型。

关于储能参与调频辅助服务优化的控制系统的具体限定可以参见上文中对于的限定,在此不再赘述。上述储能参与调频辅助服务优化的控制系统中的各个模块可全部或部分通过软件、硬件及其组合来实现。上述各模块可以硬件形式内嵌于或独立于计算机设备中的处理器中,也可以以软件形式存储于计算机设备中的存储器中,以便于处理器调用执行以上各个模块对应的操作。

请参阅图4,本发明实施例提供一种计算机终端设备,包括一个或多个处理器和存储器。存储器与所述处理器耦接,用于存储一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行,使得所述一个或多个处理器实现如上述任意一个实施例中的储能参与调频辅助服务优化的控制方法。

处理器用于控制该计算机终端设备的整体操作,以完成上述的储能参与调频辅助服务优化的控制方法的全部或部分步骤。存储器用于存储各种类型的数据以支持在该计算机终端设备的操作,这些数据例如可以包括用于在该计算机终端设备上操作的任何应用程序或方法的指令,以及应用程序相关的数据。该存储器可以由任何类型的易失性或非易失性存储设备或者它们的组合实现,例如静态随机存取存储器(Static Random AccessMemory,简称SRAM),电可擦除可编程只读存储器(Electrically Erasable ProgrammableRead-Only Memory,简称EEPROM),可擦除可编程只读存储器(Erasable ProgrammableRead-Only Memory,简称EPROM),可编程只读存储器(Programmable Read-Only Memory,简称PROM),只读存储器(Read-Only Memory,简称ROM),磁存储器,快闪存储器,磁盘或光盘。

在一示例性实施例中,计算机终端设备可以被一个或多个应用专用集成电路(Application Specific 1ntegrated Circuit,简称AS1C)、数字信号处理器(DigitalSignal Processor,简称DSP)、数字信号处理设备(Digital Signal Processing Device,简称DSPD)、可编程逻辑器件(Programmable Logic Device,简称PLD)、现场可编程门阵列(Field Programmable Gate Array,简称FPGA)、控制器、微控制器、微处理器或其他电子元件实现,用于执行上述的储能参与调频辅助服务优化的控制方法,并达到如上述方法一致的技术效果。

在另一示例性实施例中,还提供了一种包括程序指令的计算机可读存储介质,该程序指令被处理器执行时实现上述任意一个实施例中的储能参与调频辅助服务优化的控制方法的步骤。例如,该计算机可读存储介质可以为上述包括程序指令的存储器,上述程序指令可由计算机终端设备的处理器执行以完成上述的储能参与调频辅助服务优化的控制方法,并达到如上述方法一致的技术效果。

本发明提供的储能参与调频辅助服务优化的控制方法及其系统中,针对调频信号的随机性和快速变化的动态性质,提供一种基于深度强化学习的储能与调频信号互动方式,将储能的运行状态、调频信号映射为充放电动作,采用深度强化学习算法对储能的充放电策略进行优化,从而实现储能在秒级时序上的快速优化控制。

以上所述是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也视为本发明的保护范围。

- 一种储能参与调频辅助服务优化的控制方法及其系统

- 一种储能系统参与电网一次调频的控制方法及系统