基于深度学习人类视网膜光学相干层析图像批量滤波方法

文献发布时间:2023-06-19 09:26:02

技术领域

本发明属于光学测量和图像处理技术领域,涉及一种基于深度学习的人类视网膜光学相干层析图像批量滤波方法。

背景技术

光学相干层析成像技术(Optical coherence tomography,OCT)是一种无创的体内断面成像技术,广泛应用在医学成像和临床诊断领域,尤其是眼科医学[1-3]。因得益于对散射光(或反射光)时间相干性和空间相关性的充分利用,该技术具有以下优势:(1)对弱散射光的高灵敏性,(2)高达每秒几十万行的高成像速度,(3)对位于1-2毫米深处内部微观结构、形态的高分辨率[4-9]。

散斑作为一种固有现象,在OCT测量系统中经常出现,降低成像效果。这种现象通常取决于成像光束的波长和成像物体的细节。根据成像表现,可以将其分为信号携带散斑和信号衰减散斑[10-11]。其中,前者可以作为微观结构的信息载体,后者则是常见的散斑噪声。散斑噪声是一种具有颗粒状外观的乘性噪声,通常会覆盖图像的纹理特征(如结构和边缘),大大降低成像效果和图象质量[12-13],进而导致医学信息误读和病情诊断失败。因此,提高原始OCT图像的信噪比和对比度对OCT技术在医学诊断领域的应用至关重要。

为了提高OCT图像的质量,近三十年来,在基本原理、系统设计、图像处理等方面都提出了大量的改进,其中的大量工作关注于OCT图像的滤波方法研究[4,14-15]。OCT图像的滤波方法通常可分为空间域滤波方法、频率域滤波方法、以及空间域与频率域相结合的方法。其中,以自适应复扩散方法(Adaptive complex diffusion,ACD)[16]为代表的空间域方法可以有效去除OCT图像中的散斑噪声,但对纹理的保持能力有所欠缺;以曲波变换方法(Curvelet transform,Curvelet)[17]为代表的频率域方法可以很好地保持OCT图像的纹理特征,但对噪声的去除能力不足,往往会产生划痕,影响OCT图像的质量;以基于剪切波变换的全变分方法(Shearlet-based total variation algorithm,TV-SH)[18]为代表的方法可以同时兼顾较好的去噪性能和较好的纹理保持能力,但这类方法一般适用于低噪声水平情况,在噪声水平较高的情况下该方法很难获得较好的去噪结果。另外,上述传统方法往往需要通过反复调节所用参数才能获得较好结果,对于不同的OCT图像,通常还需要选择不同的滤波方法。显然,这不仅是非常不方便的,也是十分耗时的,严重限制了OCT技术在实时检测和批量处理领域中的应用。因此,我们希望找到一种能够实时批量去除人类视网膜OCT图像散斑噪声的智能方法。

深度学习是机器学习的一个重要分支,深度学习是学习样本数据的内在规律和表示层次,这些学习过程中获得的信息对诸如文字、图像和声音等数据的解释有很大的帮助。它的最终目标是让机器能够像人一样具有分析学习能力,能够识别文字、图像和声音等数据。深度学习本质上是构建含有多隐层的机器学习架构模型,通过大规模数据进行训练,得到大量更具代表性的特征信息,从而对样本进行分类和预测,提高分类和预测的精度。近年来,由于深度学习特别是卷积神经网络(Convolutional neural network,CNN)在图像识别、语音、自然语言等领域取得了显著地进展,而深层的非线性神经网络结构也适用于图像去噪,因此基于深度学习的图像去噪方法也被提出并得到了发展。通过训练各种去噪网络实现从含噪声图像到去噪图像的端到端的非线性映射。[19-20]

参考文献

1.D.Huang,E.A.Swanson,C.P.Lin,J.S.Schuman,W.G.Stinson,W.Chang,M.R.Hee,T.Flotte,K.Gregory,C.A.Puliafito,and J.G.Fujimoto,"Optical coherencetomography,"Science 254(5035),1178-1181(1991).

2.W.Drexler,U.Morgner,R.K.Ghanta,F.X.Kartner,J.S.Schuman,andJ.G.Fujimoto,“Ultrahigh-resolution ophthalmic optical coherence tomography,”Nat.Med.7(4),502–507(2001).

3.F.Fercher,W.Drexler,C.K.Hitzenberger,and T.Lasser,“Opticalcoherence tomography-principles and applications,”Rep.Prog.Phys.66(2),239–303(2003).

4.M.Wojtkowski,“High-speed optical coherence tomography:basics andapplications,”Appl.Opt.49(16),D30–D61(2010).

5.B.Potsaid,I.Gorczynska,V.J.Srinivasan,Y.L.Chen,J.Jiang,A.Cable,andJ.G.Fujimoto,“Ultrahigh speed spectral/Fourier domain OCT ophthalmic imagingat 70,000to 312,500axial scans per second,”Opt.Express 16(19),15149–15169(2008).

6.R.J.Zawadzki,B.Cense,Y.Zhang,S.S.Choi,D.T.Miller,and J.S.Werner,“Ultrahigh-resolution optical coherence tomography with monochromatic andchromatic aberration correction,”Opt.Express 16(11),8126–8143(2008).

7.M.L.Gabriele,G.Wollstein,H.Ishikawa,L.Kagemann,J.Xu,L.S.Folio,andJ.S.Schuman,“Optical coherence tomography:history,current status,andlaboratory work,”Invest.Ophthalmol.Vis.Sci.52(5),2425-2426(2011).

8.M.E.Brezinski,G.J.Tearney,and B.E.Brett,“Imaging of coronary arterymicrostructure with optical coherence tomography,”Amer.J.Cardiol.77(1),92–93(1996).

9.W.Drexler,“Ultrahigh-resolution optical coherence tomography,”J.Bio.Opt.9(1),47–74(2004).

10.J.M.Schmitt,S.H.Xiang,and K.M.Yung,“Speckle in optical coherencetomography,”J.Biomed.Opt.4(1),95–105(1999).

11.N.M.Grzywacz,J.Juan,C.Ferrone,D.Giannini,D.Huang,G.Koch,V.Russo,O.Tan,and C.Bruni,“Statistics of optical coherence tomography data from humanretina,”IEEE T.Med.Imaging 29(6),1224-1237(2010).

12.J.M.Schmitt,“Array detection for speckle reduction in opticalcoherence microscopy,”Phys.Med.Biol.42(7),1427–1427(1997).

13.A.A.Lindenmaier,L.Conroy,G.Farhat,R.S.DaCosta,C.Flueraru,andI.A.Vitkin,“Texture analysis of optical coherence tomography speckle forcharacterizing biological tissues in vivo,”Opt.Lett.38(8),1280–1282(2013).

14.A.E.Desjardins,B.J.Vakoc,G.J.Tearney,and B.E.Bouma,“Specklereduction in OCT usingmassively parallel detection and frequency-domainranging,”Opt.Express 14(11),4736–4745(2006).

15.M.Szkulmowski,I.Gorczynska,D.Szlag,M.Sylwestrzak,A.Kowalczyk,andM.Wojtkowski,“Efficient reduction of speckle noise in Optical CoherenceTomography,”Opt.Express 20(2),1337-1359(2012).

16.R.Bernardes,C.Maduro,P.Serranho,A.Araújo,S.Barbeiro,and J.Cunha-Vaz,“Improved adaptive complex diffusion despeckling filter,”Opt.Express 18(23),24084–24059(2010).

17.Z.Jian,L.Yu,B.Rao,Z.Chen,and B.J.Tromberg,“Speckle attenuation inoptical coherence tomography by curvelet shrinkage,”Opt.Lett.34(10),1516-1518(2009).

18.

19.[8]G.E.Hinton,R.R.Salakhutdinov.Reducing the Dimensionality ofData with Neural Networks.Science 313,504–507(2006).

20.[9]V.Jain,S.H.Seung.Natural Image Denoising with ConvolutionalNetworks.NIPS,769-776(2008).

发明内容

为克服现有技术的不足,本发明旨在实现人类视网膜OCT图像散斑噪声的批量移除。本发明通过构建一个端到端的人类视网膜OCT图像的去噪网络,实现了对多幅人类视网膜OCT图像的批量滤波。为此,本发明采取的技术方案是,基于深度学习人类视网膜光学相干层析图像批量滤波方法,步骤如下:

步骤1:构建训练数据集;

步骤2:构建人类视网膜OCT图像的去噪网络模型;

步骤3:将训练数据集输入网络,利用训练数据集对网络模型进行训练;

步骤4:将实测所得人类视网膜OCT图像作为测试集输入到训练好的网络中,并用所述测试集图像减去网络的输出图像,得到清晰的去噪图像。

步骤1:构建训练数据集具体步骤如下:

步骤1-1:图像全局去噪:采用基于剪切波变换的全变分去噪,通过在全变分去噪模型中引入剪切波保边正则项,实现对散斑噪声最大程度上的去除和对图象纹理最大程度上的保持;

步骤1-2:图像边缘增强:采用二阶方向偏微分方程SOOPDE(Second-orderoriented partial differential equations)方法,通过利用人类视网膜OCT图像的方向角度,实现沿边缘方向的自适应滤波,进而实现了对人类视网膜OCT图像的边缘增强;

步骤1-3:背景残留噪声清除:采用模糊C均值聚类方法FCM(Fuzzy C-Meansalgorithm),实现背景残留噪声清除,通过利用人类视网膜OCT图像的统计特征,实现对组织纹理和背景区域的分类提取,然后,通过将组织纹理区域的灰度值保持不变,将背景区域的灰度值设置为0,从而获得人类视网膜OCT图像的无噪标签。

步骤2:构建人类视网膜OCT图像去噪网络模型,具体步骤如下:

步骤2-1:网络的深度设置为20层。第一层由Conv+ReLU构成,即对输入图像卷积Conv(Convolution),然后使用校正线性单元ReLU(Rectified Linear Unit)进行激活处理;第二层到第十九层使用了Conv+BN+ReLU的组合。也就是在卷积层和ReLU之间加了一层批量归一化BN(Batch Normalization),最后一层仅使用Conv来重建输出层;

步骤2-2:卷积核的大小设置为3×3,网络的代价函数是残差图像v与网络估计出的噪声图像R(y)之间的均方差:

式(1)中θ表示网络的参数;x

步骤3:将训练数据集输入网络,利用训练数据集对网络模型进行训练,具体步骤如下:

步骤3-1:设置参数:在训练当中采用Adam优化方式;

步骤3-2:将步骤1构造的训练数据集输入网络开始进行训练;

步骤4:将新的人类视网膜OCT图像作为测试集输入到训练好的网络中,并用所述测试集图像减去网络的输出图像,得到清晰的去噪图像;然后再对去噪模型的去噪性能进行评价。

步骤4:具体步骤如下:

步骤4-1:将若干幅实测的人类视网膜OCT图像输入步骤3中训练好的网络中,得到去噪后的图像;

步骤4-2:选用四张具有不同病理生理特性的人类视网膜OCT图像作为测试样本,通过对比传统的ACD方法、Curvelet方法、TV-SH方法的去噪性能,对所提方法的去噪性能进行评价;

步骤4-3:选用100张具有不同病理生理特性的人类视网膜OCT图像作为测试样本,对所提方法的适用范围和泛化能力进行评价;

步骤4-4:选用10张连续采集的处于不同病情阶段的人类视网膜OCT图像作为测试样本,并将所提方法应用于视网膜疾病的病情监控和临床诊断。

本发明的特点及有益效果是:

本发明提出的基于深度学习的人类视网膜OCT图像批量滤波方法,相比于传统的人类视网膜OCT图像滤波方法可以实现对多幅人类视网膜OCT图像的批量滤波,滤波效果较好,且不需要复杂的参数设定与调整,可应用在视网膜疾病的病情监控和临床诊断领域。

附图说明:

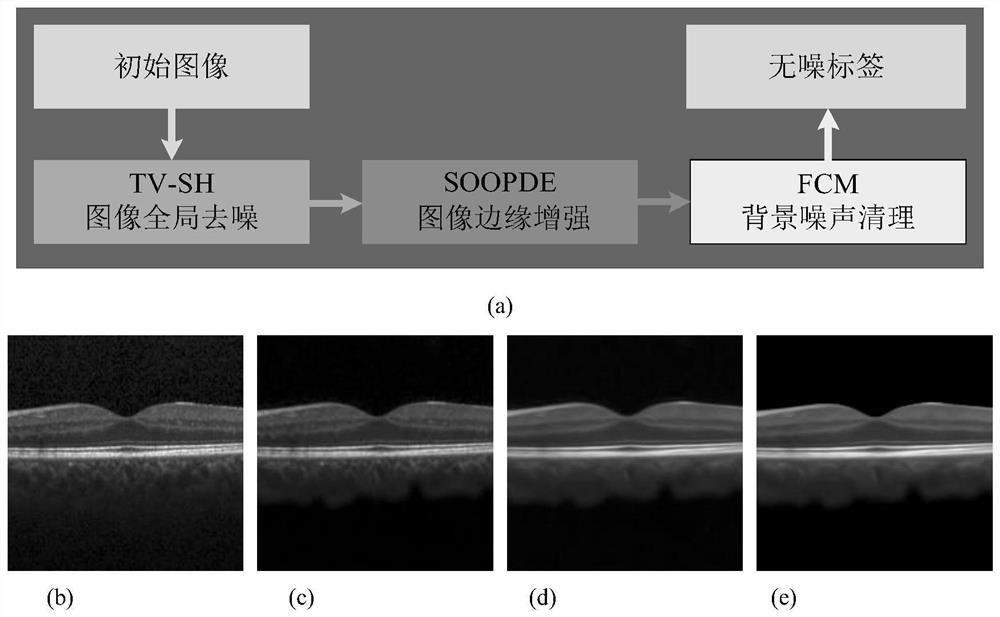

图1(a)是本发明所用的无噪标签提取方法流程图,图1(b)为原始图像,图1(c)是经图像全局去噪后所得到的结果,图1(d)为经过图像边缘增强后所得到的结果,图1(e)为经过背景噪声清理后所得到的结果,即所期望获得的无噪标签。

图2是本发明采用的部分训练数据集。

图3是本发明提出的去噪网络结构图。

图4是本发明采用的网络训练流程图。

图5是去噪结果的比较。其中,图5(a0)-5(a4)原始图像,5(b0)-5(b4)、5(c0)-5(c4)、5(d0)-5(d4)和5(e0)-5(e4)分别为ACD、Curvelet、TV-SH和所提方法的结果。

图6是去噪结果的比较。其中,图6(a0)-6(a4)原始图像,6(b0)-6(b4)、6(c0)-6(c4)、6(d0)-6(d4)和6(e0)-6(e4)分别为ACD、Curvelet、TV-SH和所提方法的结果。

图7是去噪结果的比较。其中,图7(a0)-7(a4)原始图像,7(b0)-7(b4)、7(c0)-7(c4)、7(d0)-7(d4)和7(e0)-7(e4)分别为ACD、Curvelet、TV-SH和所提方法的结果。

图8是去噪结果的比较。其中,图8(a0)-8(a4)原始图像,8(b0)-8(b4)、8(c0)-8(c4)、8(d0)-8(d4)和8(e0)-8(e4)分别为ACD、Curvelet、TV-SH和所提方法的结果。

图9是用于评价所提方法适用范围和泛化能力的部分人类视网膜OCT图像样本。

图10是采用所提方法对图9中样本进行去噪处理的所得结果。

图11是所提方法对视网膜疾病病情监控和临床诊断的应用结果。

具体实施方式

本发明采取的技术方案是,基于深度学习人类视网膜光学相干层析图像批量滤波方法,步骤如下:

步骤1:构建训练数据集;

步骤2:构建人类视网膜OCT图像的去噪网络模型;

步骤3:将训练数据集输入网络,利用训练数据集对网络模型进行训练;

步骤4:将实测所得人类视网膜OCT图像作为测试集输入到训练好的网络中,并用所述测试集图像减去网络的输出图像,得到清晰的去噪图像。

接下来进一步详细说明应用本发明提出的基于深度学习的人类视网膜OCT图像批量滤波方法对人类视网膜OCT图像进行滤波。具体步骤如下:

步骤1:构建训练数据集。网络在训练过程中通常需要含有噪声的原始图像和与之相应的无噪声标签。

为使训练所得网络能够同时具有较好的去噪性能和较高的纹理保持能力,本发明提出了一种利用实测人类视网膜OCT图像提取高质量无噪声标签的组合提取方法。图1(a)所示为该方法的具体流程,步骤如下:

步骤1-1:图像全局去噪。在该步骤中,本发明采用基于剪切波变换的全变分去噪方法,实现了对人类视网膜OCT图像(图1(a))的全局去噪。这一方法通过在全变分去噪模型中引入剪切波保边正则项,实现了对散斑噪声最大程度上的去除和对图象纹理最大程度上的保持。该步骤的所得结果如图1(b)所示。

步骤1-2:图像边缘增强。在该步骤中,本发明采用SOOPDE方法,实现了对步骤1-1所得结果的边缘增强。这一方法通过利用人类视网膜OCT图像的方向角度,实现了沿边缘方向的自适应滤波,进而实现了对人类视网膜OCT图像的边缘增强。该步骤的所得结果如图1(c)所示。

步骤1-3:背景残留噪声清除。在该步骤中,本发明采用模糊C均值聚类方法,实现了对步骤1-2所得结果的背景残留噪声清除。这一方法通过利用人类视网膜OCT图像的统计特征(均值、方差、相关系数),实现了对组织纹理和背景区域的分类提取。然后,通过将组织纹理区域的灰度值保持不变,将背景区域的灰度值设置为0,从而获得人类视网膜OCT图像的无噪标签。所得结果如图1(d)所示。

通过使用上述方法,可以构造一个令人满意的可取的训练数据集,并且之后的实验结果也证明了这一点。

为了使训练所得网络具有较广的适用能力以及较高的泛化能力,本发明使用4种不同病理条件下的100张人类视网膜OCT图像,构建了训练数据集。图2展示了训练数据集的部分样本。

步骤2:构建人类视网膜OCT图像去噪网络模型。具体步骤如下:

人类视网膜OCT图像去噪网络模型采用了残差学习的方式,在网络的隐层隐式地移除干净图像(x)。即输入为带噪声的人类视网膜OCT图像(y),输出为移除了干净图片的残差(噪声)图像(v)。这样做的动机是,用残差学习刻画恒等映射或近似的恒等映射R(y)=v,该网络期望学习R(y)=v,效果要比直接学习获得干净图片要相对好。这样就可以得到去噪后的人类视网膜OCT图像x=y-R(y)。网络结构如图3所示。

步骤2-1:网络的深度设置为20层。第一层由Conv+ReLU构成,即对输入图像卷积,然后使用校正线性单元(ReLU)进行激活处理。第二层到第十九层使用了Conv+BN+ReLU的组合。也就是在卷积层和ReLU之间加了一层批量归一化(Batch Normalization),采用批量归一化可以加快训练的收敛,从而大幅提高训练速度。最后一层仅使用卷积层(Conv)来重建输出层。

步骤2-2:卷积核的大小设置为3×3。网络的代价函数是残差图像(v)与网络估计出的噪声图像(R(y))之间的均方差:

式(1)中θ表示网络的参数;x

步骤3:将训练数据集输入网络,利用训练数据集对网络模型进行训练。训练的流程图如图4所示,具体步骤如下:

步骤3-1:设置参数:在训练当中采用Adam优化方式,初始学习率设为0.001,批尺寸(即Batch Size)设为100,α设为1,β设为8,σ设为60(α,β,σ的值可根据实际情况作出调整),一共训练50个时期(即Epoch)。

步骤3-2:将步骤1构造的训练数据集输入网络开始进行训练。

步骤4:将新的人类视网膜OCT图像作为测试集输入到训练好的网络中,并用所述测试集图像减去网络的输出图像,得到清晰的去噪图像;然后再对去噪模型的去噪性能进行评价。具体步骤如下:

步骤4-1:将若干幅实测的人类视网膜OCT图像输入步骤3中训练好的网络中,得到去噪后的图像。

步骤4-2:选用四张具有不同病理生理特性的人类视网膜OCT图像作为测试样本,通过对比传统的ACD方法、Curvelet方法、TV-SH方法的去噪性能,对所提方法的去噪性能进行评价。所得结果的对比如图5-图8所示。

步骤4-3:选用100张具有不同病理生理特性的人类视网膜OCT图像作为测试样本,对所提方法的适用范围和泛化能力进行评价。图9展示了部分人类视网膜OCT图像样本,图10展示了与之对应的去噪结果。

步骤4-4:选用10张连续采集的处于不同病情阶段的人类视网膜OCT图像作为测试样本,并将所提方法应用于视网膜疾病的病情监控和临床诊断。图11展示了所用人类视网膜OCT图像样本和与之对应的去噪结果。

为了验证方法的有效性,给出实验结果。

图5-图8展示的是以四幅具有不同病理生理特性的人类视网膜OCT图像作为测试数据得到滤波结果。其中,图(a0-a4)为原始图像及其在背景区域、背景与组织的交界区域、低频纹理区域、高频纹理区域的放大图像;图(b0-b4)为ACD方法所得结果及其在背景区域、背景与组织的交界区域、低频纹理区域、高频纹理区域的放大图像;图(c0-c4)为Curvelet方法所得结果及其在背景区域、背景与组织的交界区域、低频纹理区域、高频纹理区域的放大图像;图(d0-d4)为TV-SH方法所得结果及其在背景区域、背景与组织的交界区域、低频纹理区域、高频纹理区域的放大图像;图(e0-e4)为所提去噪方法所得结果及其在背景区域、背景与组织的交界区域、低频纹理区域、高频纹理区域的放大图像。

图9展示的是用来评价所提方法适用范围和泛化能力的部分人类视网膜OCT图像,图10展示的是与之对应的所提方法的去噪结果。

图11展示的是将所提方法应用在视网膜疾病病情监控和临床诊断中的结果。

尽管上面结合图示对本发明进行了描述,但是本发明并不局限于上述的具体实施方式,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本发明的启示下,在不脱离本发明宗旨的情况下,还可以作出很多变形,这些均属于本发明的保护之内。

本领域技术人员可以理解附图只是一个优选实施例的示意图,上述本发明实施例序号仅仅为了描述,不代表实施例的优劣。

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

- 基于深度学习人类视网膜光学相干层析图像批量滤波方法

- 光学相干层析图像视网膜病变智能检测系统及检测方法