一种快速光场角度超分辨重建方法

文献发布时间:2023-06-19 09:52:39

技术领域

本发明涉及光场成像领域,尤其涉及一种快速光场角度超分辨重建方法。

背景技术

光场相机可以一次拍摄记录多个视角图像,光场图像的空间分辨率和角度分辨率存在折衷,因此需要研究如何在保证高空间分辨率的同时提高光场的角度分辨率。

光场角度超分辨重建也叫光场新视角合成。传统的光场角度超分辨重建方法可以分为两种,第一种方法是采用深度估计算法,先获得准确的深度图,然后将已知视角图像映射到新视角位置重建新视角;第二种方法是把光场角度超分辨重建看作是全光函数的采样和重建,把已知视角图像的每个像素被看作是高维全光函数的采样。然而,以上两种方法容易受到非朗伯表面的影响。近年来,深度学习在图像降噪、超分辨率、去模糊等方面取得巨大进展,卷积神经网络(CNN)在光场角度超分辨重建领域的应用也开始出现。Yoon等首次将卷积神经网络应用于光场角度超分辨重建,该方法利用相邻多视角图像之间的信息重建新视角图像,但只能重建相邻视角的中间视角图像,不能在任意位置重建新视角图像。Kalantari等提出基于学习的光场新视角重建方法,该方法虽然提高了重建视角的质量,但是由于合成每张新视角都需要4张输入视角图像,导致合成视角速度慢。

因此,现有技术还有待于改进和发展。

发明内容

鉴于上述现有技术的不足,本发明的目的在于提供一种快速光场角度超分辨重建方法,旨在保证重建的新视角图像质量的同时,提高重建速度,节省运算资源。根据视图插值的几何原理,根据视差信息可以获得两个视图的中间视图。因此通过对输入视角进行选择,使得每张新视角图像的合成仅需要两个输入视角图像,以此来减少计算量,提高新视角的合成速度。

本发明的技术方案如下:

一种快速光场角度超分辨重建方法,其中,包括步骤:

根据预设视角图像的位置,获取两个输入视角图像;其中,所述预设视角与所述两个输入视角图像对应的输入视角仅存在水平方向视差;

将所述两个输入视角图像输入已训练的图像重建网络,通过所述图像重建网络对所述两个输入视角图像进行处理,得到新视角图像;

其中,所述新视角图像对应的视角为预设视角。

所述的快速光场角度超分辨重建方法,其中,所述预设视角的位置在两个所述输入视角之间或为两个输入视角的位置。

所述的快速光场角度超分辨重建方法,其中,所述已训练的图像重建网络包括已训练的深度估计网络和已训练的颜色估计网络,所述通过所述图像重建网络对所述两个输入视角图像进行处理,得到新视角图像,包括:

将所述两个输入视角图像输入已训练的深度估计网络,通过所述已训练的深度估计网络得到新视角图像的深度信息;

将所述新视角图像的深度信息以及所述两个输入视角图像输入所述已训练的颜色估计网络,通过所述已训练的颜色估计网络得到新视角图像。

所述的快速光场角度超分辨重建方法,其中,所述深度估计网络包括已训练的第一卷积神经网络,所述通过所述深度估计网络得到新视角图像的深度信息,包括:

根据所述预设视角与所述输入视角的最大视差范围,预设若干个深度等级;

根据所述若干个深度等级的深度信息,对所述两个输入视角图像进行特征提取,得到深度特征集;

将所述深度特征集输入第一卷积神经网络,通过所述第一卷积神经网络得到所述新视角图像的深度信息。

所述的快速光场角度超分辨重建方法,其中,所述根据所述若干个深度等级的深度信息,对所述两个输入视角图像进行特征提取,得到深度特征集,包括:

根据每个深度等级的深度信息以及所述两个输入视角图像,得到所述每个深度等级对应的两个第一映射图像;

根据所述每个深度等级对应的两个第一映射图像,得到每个深度等级对应的均值和标准差;

将所有深度等级对应的均值和标准差组成集合,得到深度特征集。

所述的快速光场角度超分辨重建方法,其中,所述已训练的颜色估计网络包括第二卷积神经网络,所述通过所述已训练的颜色估计网络得到新视角图像,包括:

根据所述新视角图像的深度信息、所述预设视角的位置以及所述两个输入视角图像得到颜色特征集;

将所述颜色特征集输入所述已训练的第二卷积神经网络,通过所述已训练的第二卷积神经网络得到新视角图像。

所述的快速光场角度超分辨重建方法,其中,所述根据所述新视角图像的深度信息、所述预设视角的位置以及所述两个输入视角图像得到颜色特征集,包括:

根据所述新视角图像的深度信息、所述预设视角的位置以及所述两个输入视角图像,得到两个第二映射图像;

将所述两个第二映射图像、所述新视角图像的深度信息以及所述预设视角的位置组成集合,得到颜色特征集。

所述的快速光场角度超分辨重建方法,其中,根据所述新视角图像的深度信息、所述预设视角的位置以及所述两个输入视角图像,得到两个第二映射图像,包括:

根据所述新视角图像的深度信息以及所述预设视角的位置,得到所述两个输入视角图像与所述新视角图像的视差;

根据所述视差以及所述两个输入视角图像,得到两个第二映射图像。

所述的快速光场角度超分辨重建方法,其中,所述已训练的图像重建网络采用如下步骤训练得到:

对光场数据集中的图像样本进行预处理,得到多组训练图像组,其中,每组训练图像组包括两个第一图像和所述两个第一图像对应的第二图像,所述第一图像和第二图像的视角仅存在水平方向视差,所述第二图像的视角位置在所述两个第一图像的视角位置之间;

将所述两个第一图像输入预设图像重建网络,得到所述两个第一图像对应的重建图像;所述预设图像重建网络根据所述两个第一图像对应的重建图像和所述两个第一图像对应的第二图像,对所述预设图像重建网络的网络参数进行修正,并继续执行根据所述两个第一图像,得到所述两个第一图像对应的重建图像的步骤,直至所述预设图像重建网络的训练情况满足预设条件,以得到已训练的图像重建网络。

所述的快速光场角度超分辨重建方法,其中,所述根据所述两个第一图像对应的重建图像和所述两个第一图像对应的第二图像,对所述预设图像重建网络的网络参数进行修正,并继续执行根据所述两个第一图像,得到所述两个第一图像对应的重建图像的步骤,直至所述预设图像重建网络的训练情况满足预设条件,以得到已训练的图像重建网络的步骤包括:

根据所述两个第一图像对应的重建图像和所述两个第一图像对应的第二图像,得到误差函数值;

根据所述误差函数值训练所述预设图像重建网络,并继续执行根据所述两个第一图像,得到所述两个第一图像对应的重建图像的步骤,直至所述预设图像重建网络的训练情况满足预设条件,以得到已训练的图像重建网络。

有益效果:本发明提供了一种快速光场角度超分辨重建方法,根据预设视角的位置,确定两个输入视角图像;将所述两个输入视角图像输入已训练的图像重建网络,通过所述图像重建网络对所述两个输入视角图像进行处理,得到新视角图像;所述新视角图像的视角与所述两个输入视角图像的视角仅存在水平方向视差。由于只采用了两个视角图像作为输入且两个输入视角图像与新视角图像仅存在水平视差,从而在保证新视角图像质量的同时提高了图像的重建速度,节省运算资源。同时,本发明可以重建任意位置的新视角图像。

附图说明

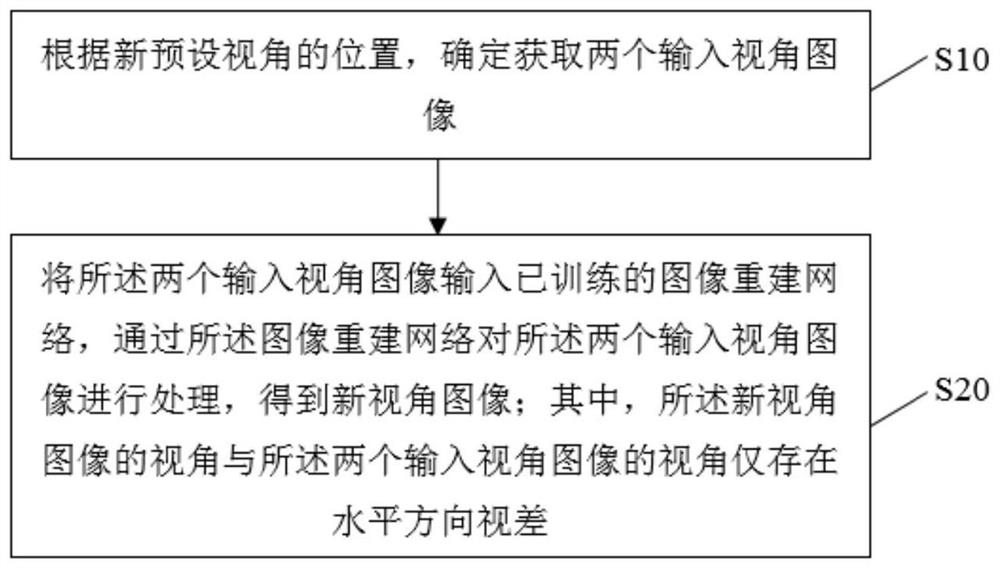

图1为本发明的一种快速光场角度超分辨重建方法较佳实施例的第一流程示意图。

图2为本发明的一种快速光场角度超分辨重建方法较佳实施例的第二流程示意图。

图3为视差原理图。

图4为预设视角和输入视角的位置关系示意图。

具体实施方式

本发明提供一种快速光场角度超分辨重建方法,为使本发明的目的、技术方案及效果更加清楚、明确,以下对本发明进一步详细说明。应当理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

本发明提供一种快速光场角度超分辨重建方法,如图1所示,图1为本发明的一种快速光场角度超分辨重建方法较佳实施例的第一流程示意图,所述方法包括步骤:

S10、根据预设视角的位置,确定两个输入视角图像;

S20、将所述两个输入视角图像输入已训练的图像重建网络,通过所述图像重建网络对所述两个输入视角图像进行处理,得到新视角图像。

具体地,如图3所示,图3为视差原理图,其中X指空间中一点,C和C′指左右两个相机,视差指空间中同一点在不同相机上的成像差异。对于光场多视角图像来说,同一行的视角图像仅存在水平方向视差,同一列的视角图像仅存在竖直方向的视差。根据视图插值的几何原理,预设视角与两个输入视角图像对应的输入视角仅存在水平方向视差,由视差信息可以获得两个视角图像的中间视角图像,也就是预设视角对应的新视角图像。因此通过根据预设视角选择两个输入视角图像,使得新视角图像的合成仅需要两个输入视角图像,减少了图片处理的计算量,提高新视角的合成速度。

新视角图像对应的视角为预设视角,输入视角图像对应的视角为输入视角。如图4所示,图4是预设视角和输入视角的位置关系示意图,黑色图像对应的视角位置在白色图像对应的的视角位置之间,黑色图像和白色图像对应的视角位置均可为预设视角的位置,白色图像对应的视角位置为输入视角的位置。选择一个预设视角的位置,根据该预设视角的位置,确定与其处于同一水平视差方向的两个输入视角,并获取该两个输入视角分别对应的两个输入图像,并且两个输入视角与预设视角仅存在水平方向视差,预设视角的位置在两个输入视角之间或为两个输入视角的位置。举例来说,选择第1行的第3个黑色图像作为新视角图像,则两个输入视角图像均为第1行图像,可将第1行的第1或2个图像作为一个输入视角图像,将第1行的第4、5、6、7或8个图像作为另一个输入视角图像。

本实施例通过采用已训练的图像重建网络,根据同一水平方向视角的两个输入视角图像,可以将该水平方向上两个输入视角之间的所有视角位置对应的图像进行重建,得到质量更高的新视角图像,同时,由于只采用同一水平方向视角的两个输入图像,可以提高图像重建网络的算法速度,节省运算资源。

进一步,所述已训练的图像重建网络包括已训练的深度估计网络和已训练的颜色估计网络,所述步骤S20包括:

S21、将所述两个输入视角图像输入已训练的深度估计网络,通过所述已训练的深度估计网络得到新视角图像的深度信息;

S22、将所述新视角图像的深度信息以及所述两个输入视角图像输入所述已训练的颜色估计网络,通过所述已训练的颜色估计网络得到新视角图像。

具体地,已训练的深度估计网络是用于根据两个输入图像提取预设视角处的深度特征,通过深度特征得到预设视角处的深度信息。已训练的颜色估计网络是用于根据预设视角处的深度信息得到预设视角处的颜色特征,根据该颜色特征得到新视角图像,已训练的深度估计网络与已训练的颜色估计网络的网络结构如图2所示。

进一步,所述已训练的深度估计网络包括第一卷积神经网络,步骤S21包括:

S211、根据所述预设视角与所述输入视角的最大视差范围,预设若干个深度等级;

S212、根据所述若干个深度等级的深度信息,对所述两个输入视角图像进行特征提取,得到深度特征集;

S213、将所述深度特征集输入第一卷积神经网络,通过所述第一卷积神经网络得到所述新视角图像的深度信息。

具体地,要根据新视角图像的深度信息,将输入图像映射到预设视角位置,从而得到新视角图像,由于深度信息×基线(新视角和输入视角的距离)=视差,根据预设视角与输入视角的最大视差范围,可以获得新视角图像的深度信息范围。最大视差指的预设视角与两个输入视角的视差中的最大视差,例如,如图4所示,选择第1行的第3个黑色图像对应的视角为预设视角,第1行两个白色图像对应的视角为两个输入视角,则右边的白色图像与该黑色图像的视差最大,假设是21,那么最大视差范围是[-21,21]。由于没有深度信息的真值,需要在该深度信息范围内进行深度信息估计。在新视角图像的深度信息范围内预设若干个深度等级,每个深度等级分别对应一个深度信息d

其中,

为了提取特征,计算每个深度等级对应的两个第一映射图像的均值和标准差(也就是每个深度等级对应的均值和标准差),每个深度等级对应的均值

其中,

得到深度特征集后,将其输入第一卷积神经网络,利用深度特征集来估计预设视角处的深度信息D

D

其中,D

进一步,所述颜色估计网络包括第二卷积神经网络,步骤S22包括:

S221、根据所述新视角图像的深度信息、所述预设视角的位置以及所述两个输入视角图像得到颜色特征集;

S222将所述颜色特征集输入所述第二卷积神经网络,通过所述已训练的第二卷积神经网络得到新视角图像。

具体地,得到新视角图像的深度信息后,根据新视角图像的深度信息分别将两个输入视角图像映射到预设视角的位置,得到该深度信息对应的两个第二映射图像,映射公式为:

其中,D

L

其中L

在一种实现方式中,所述已训练的图像重建网络采用如下步骤训练得到:

M1、对光场数据集中的图像样本进行预处理,得到多组训练图像组,其中,每组训练图像组包括两个第一图像和所述两个第一图像对应的第二图像,所述第一图像和第二图像的视角仅存在水平方向视差或竖直方向视差,所述第二图像的视角位置在所述两个第一图像的视角位置之间。

具体地,使用Stanford光场数据集进行网络训练,Stanford光场数据集中的数据是光场图像,光场图像通过LytroIllum光场相机获取,其实际角度分辨率为14×14,也就是说获得的光场图像是由14×14个视角图像组成的多视角图像。由于多视角图像的边缘视角图像受噪声、渐晕效应等因素的影响,因此,采用中间的8×8个视角图像作为光场数据集。训练集包含100张光场图像,测试集包含30张光场图像。由于对完整图像进行训练速度很慢,从完整图像中提取大小为60×60的图像块,步长为16个像素,从而得道超过100000个图像块以训练网络。在进行网络训练前,要对每个图像块进行预处理,也就是将每个图像块处理成多视角图像,多视角图像中,将同一水平方向视角的图像作为一个训练图像组。每个训练图像组中,以最靠左和最靠右的视角对应的两个图片作为第一图像,其他图像作为第二图像。

M2、将所述两个第一图像输入预设图像重建网络,得到所述两个第一图像对应的重建图像;所述预设网络模型根据所述两个第一图像对应的重建图像和所述两个第一图像对应的第二图像,对所述预设网络模型的模型参数进行修正,并继续执行根据所述两个第一图像,得到所述两个第一图像对应的重建图像的步骤,直至所述预设网络模型的训练情况满足预设条件,以得到已训练的图像重建网络。

具体地,预设图像重建网络包括预设深度估计网络和预设颜色估计网络。将两个第一图像输入预设图像重建网络,得到与两个第一图像对应的重建图像,通过将两个第一图像对应的重建图像

其中,k表示RGB的3个通道。为了使用梯度下降法以最小化误差函数,需要计算误差E和两个网络权重的偏导数,即

由于预设颜色估计网络的输出为重建图像,因此,

其中,

其中,

综上所述,本发明提供了一种快速光场角度超分辨重建方法,根据预设视角的位置,确定两个输入视角图像;将所述两个输入视角图像输入已训练的图像重建网络,通过所述图像重建网络对两个输入视角图像进行处理,得到新视角图像;所述新视角图像的视角与所述两个输入视角图像的视角仅存在水平方向视差。由于只采用了两个视角图像作为输入且两个输入视角图像与新视角图像仅存在水平视差,从而提高了新视角图像的重建的速度,节省运算资源。同时,本发明可以重建任意位置的新视角图像。

应当理解的是,本发明的应用不限于上述的举例,对本领域普通技术人员来说,可以根据上述说明加以改进或变换,所有这些改进和变换都应属于本发明所附权利要求的保护范围。

- 一种快速光场角度超分辨重建方法

- 光场图像角度超分辨率重建方法