具有旋转不变性的无人机目标重识别方法、系统及设备

文献发布时间:2023-06-19 18:27:32

技术领域

本发明属于计算机视觉目标检索技术领域,涉及一种无人机目标重识别方法、系统及设备,具体涉及一种具有旋转不变性的无人机目标重识别方法、系统及设备。

背景技术

目标重识别(Re-ID)是一项通过非重叠摄像头检索特定对象(例如行人、车辆)的任务[文献1-3]。该领域现有研究主要集中在城市相机上。然而,常用的城市摄像机在采集图像方面存在局限性,尤其是在大片开阔区域,城市摄像机的位置是固定的,导致拍摄范围有限,存在一些盲区[文献4]。随着无人机在视频监控领域的高速发展,无人机现在可以轻松覆盖大面积和难以到达的区域,展现出更多样且不可替代的视角[文献5-6]。这项技术可以被运用在很多场景下,例如城市治安、大型公共场所管理。我们定义了一项比普通目标重识别更具挑战性的新任务:无人机场景下的目标重识别,即在高空俯视角捕获的许多航空图像中识别特定目标。

与固定城市摄像头相比,无人机的快速移动和不断变化的高度导致了极大的视角差异[文献6]。为了正确识别身份,图像需要包含目标的全身。然而,这面临着两大难点问题:1)生成的边界框形状变化很大。这说明边界框比正常视角下包涵的背景区域更多,这使模型更容易因一些无意义内容干扰而受影响。2)边界框中同一个人的身体有不同的旋转方向。这导致无人机目标重识别比传统目标重识别的类内距离更大。对广泛运用的卷积神经网络模型来说识别大幅度旋转视角的目标很有挑战。

大量基于卷积神经网络的目标重识别方法[文献2,7,8,9,10]在城市摄像头情景取得了巨大成功,但它们很难解决无人机场景的旋转问题。无人机行人图像不可避免地包含了很大一部分背景,卷积神经网络的卷积是典型的局部相邻像素之间的操作[文献11]。所以,基于卷积神经网络的方法总是在背景上花费过多时间,从而不能精确地对提供有用信息的目标区域建模,限制了它们在无人机场景的适用性。而Transformer是一种完全基于注意力机制的结构,视觉Transformer[文献12]表现出强大的能力来模拟每个输入图像块部分之间的全局和远程关系。这个属性促使我们研究Transformer框架下旋转不变的解决方案。

在解决旋转问题上,有一些基于卷积神经网络来实现旋转不变性的研究应用于图像分类、目标监测和其他视觉任务[文献13-15]。例如通过向卷积神经网络插入可学习的模块来提高图像转换的适应性[文献15]。也有的方法通过强迫旋转前后的训练样本共享相似的特征表现来实现旋转不变性[文献14]。但是这些基于卷积和二维图像级操作的方法因块操作难以应用在Transformer上。

综上所述,为无人机Re-ID设计一个旋转不变的特征学习模型来解决上述问题至关重要。

[文献1]Ying-Cong Chen,Xiatian Zhu,Wei-Shi Zheng,and Jian-HuangLai.2017.Person re-identification by camera correlation aware featureaugmentation.IEEE TPAMI 40,2(2017),392–408.

[文献2]Mang Ye,Jianbing Shen,Gaojie Lin,Tao Xiang,Ling Shao,andSteven C.H.Hoi.2021.Deep learning for person re-identification:A survey andoutlook.IEEE TPAMI(2021),1–1.

[文献3]Liang Zheng,Yi Yang,and Alexander G Hauptmann.2016.Personreidentification:Past present and future.arXiv preprint arXiv:1610.02984(2016).

[文献4]Shizhou Zhang,Qi Zhang,Yifei Yang,Xing Wei,Peng Wang,BingliangJiao,and Yanning Zhang.2020.Person re-identification in aerial imagery.IEEETMM 23(2020),281–291.

[文献5]SV Kumar,Ehsan Yaghoubi,Abhijit Das,BS Harish,and Hugo

[文献6]Tianjiao Li,Jun Liu,Wei Zhang,Yun Ni,Wenqian Wang,and ZhihengLi.2021.UAV-Human:A Large Benchmark for Human Behavior Understanding withUnmanned Aerial Vehicles.In CVPR.16266–16275.

[文献7]Yifan Sun,Liang Zheng,Yi Yang,Qi Tian,and ShengjinWang.2018.Beyond part models:Person retrieval with refined part pooling(and astrong convolutional baseline).In ECCV.480–496.

[文献8]Guanshuo Wang,Yufeng Yuan,Xiong Chen,Jiwei Li,and XiZhou.2018.Learning discriminative features with multiple granularities forperson re-identification.In ACM MM.274–282.

[文献9]Hao Luo,Wei Jiang,Youzhi Gu,Fuxu Liu,Xingyu Liao,Shenqi Lai,and JianyangGu.2019.A strong baseline and batch normalization neck for deepperson re-identification.IEEE TMM 22,10(2019),2597–2609.

[文献10]Kaiyang Zhou,Yongxin Yang,Andrea Cavallaro,and TaoXiang.2019.Omni-scale feature learning for person re-identification.InICCV.3702–3712.

[文献11]Xiaolong Wang,Ross Girshick,Abhinav Gupta,and KaimingHe.2018.Non-local neural networks.In CVPR.7794–7803.

[文献12]Alexey Dosovitskiy,Lucas Beyer,Alexander Kolesnikov,DirkWeissenborn,XiaohuaZhai,Thomas Unterthiner,Mostafa Dehghani,MatthiasMinderer,Georg Heigold,Sylvain Gelly,et al.2020.An image is worth 16x16words:Transformers for image recognition at scale.arXiv preprint arXiv:2010.11929(2020).

[文献13]Aharon Azulay and Yair Weiss.2018.Why do deep convolutionalnetworks gen eralize so poorly to small image transformations?arXiv preprintarXiv:1805.12177(2018).

[文献14]Gong Cheng,Peicheng Zhou,and Junwei Han.2016.Rifd-cnn:Rotation-invariant and fisher discriminative convolutional neural networksfor object detection.In CVPR.2884–2893.

[文献15]Max Jaderberg,Karen Simonyan,Andrew Zisserman,etal.2015.Spatial transformer networks.Advances in neural informationprocessing systems 28(2015),2017–2025.

发明内容

为了解决上述技术问题,本发明提供了一种基于Vision Transformer(ViT)的具有旋转不变性的无人机目标重识别方法、系统及设备,实现了无人机场景目标重识别准确率的提升。

本发明的方法所采用的技术方案是:一种具有旋转不变性的无人机目标重识别方法,采用旋转不变目标识别网络进行无人机目标重识别;所述旋转不变目标识别网络,包括块生成模块和若干Transformer层;

具体包括以下步骤:

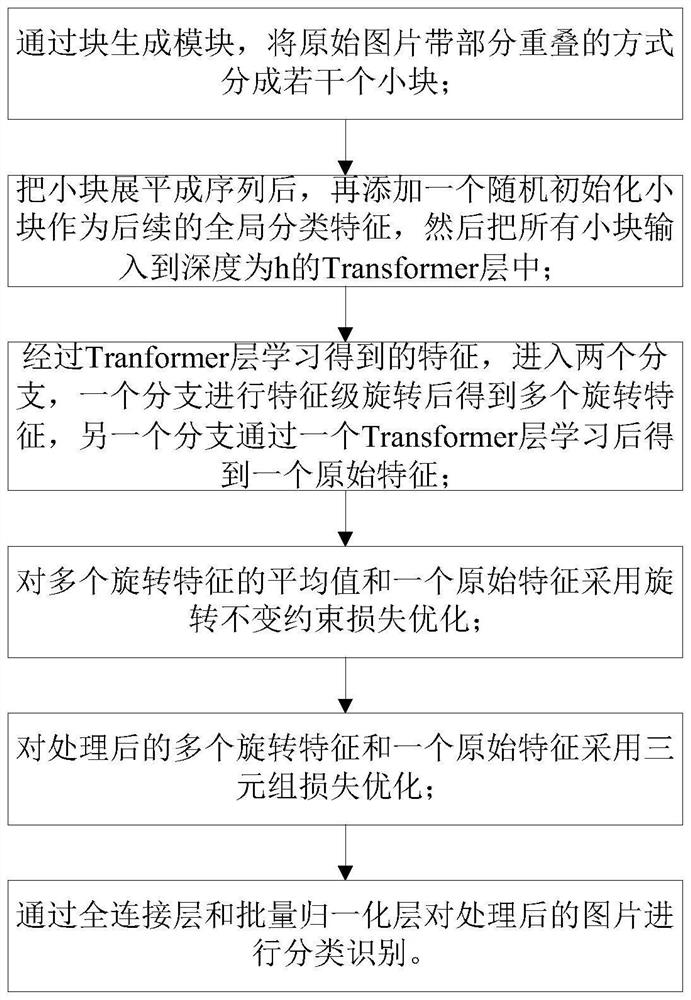

步骤1:通过块生成模块,将原始图片带部分重叠的方式分成若干个小块;

步骤2:把小块展平成序列后,再添加一个随机初始化小块作为后续的全局分类特征,然后把所有小块输入到深度为h的Transformer层中;

步骤3:经过步骤2中的Tranformer层学习得到的特征,进入两个分支,一个分支进行特征级旋转后得到多个旋转特征,另一个分支通过一个Transformer层学习后得到一个原始特征;

步骤4:对多个旋转特征的平均值和一个原始特征采用旋转不变约束损失优化;

步骤5:对步骤4处理后的多个旋转特征和一个原始特征采用三元组损失优化;

步骤6:通过全连接层和批量归一化层对步骤5处理后的图片进行分类识别。

本发明的系统所采用的技术方案是:一种具有旋转不变性的无人机目标重识别系统,采用旋转不变目标识别网络进行无人机目标重识别;所述旋转不变目标识别网络,包括块生成模块和若干Transformer层;

具体包括以下模块:

模块1,用于通过块生成模块,将原始图片带部分重叠的方式分成若干个小块;

模块2,用于把小块展平成序列后,再添加一个随机初始化小块作为后续的全局分类特征,然后把所有小块输入到深度为h的Transformer层中;

模块3,用于经过模块2中的Tranformer层学习得到的特征,进入两个分支,一个分支进行特征级旋转后得到多个旋转特征,另一个分支通过一个Transformer层学习后得到一个原始特征;

模块4,用于对多个旋转特征的平均值和一个原始特征采用旋转不变约束损失优化;

模块5,用于对模块4处理后的多个旋转特征和一个原始特征采用三元组损失优化;

模块6,用于通过全连接层和批量归一化层对模块5处理后的图片进行分类识别。

本发明的设备所采用的技术方案是:一种具有旋转不变性的无人机目标重识别设备,包括:

一个或多个处理器;

存储装置,用于存储一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器实现所述的具有旋转不变性的无人机目标重识别方法。

本发明具有以下优点:

(1)本发明设计了一种新的特征级的旋转策略来增强应对无人机旋转变化的泛化能力。

(2)本发明将旋转不变性约束集合到特征学习过程中,增强了对空间变化的鲁棒性,减少了因旋转变化导致的错误分类。

(3)本发明提出的方法在无人机和城市摄像头上进行评估,取得了比目前最先进技术更好的表现。在具有挑战性的PRAI-1581数据集上,Rank-1/mAP从63.3%/55.1%提升到70.8%/63.7%.

附图说明

图1为本发明实施例的方法流程图;

图2为本发明实施例的旋转不变目标识别网络架构图;

图3为本发明实施例的特征级旋转原理图。

具体实施方式

为了便于本领域普通技术人员理解和实施本发明,下面结合附图及实施案例对本发明做进一步的详细描述,应当理解,此处所描述的实施示例仅用于说明和解释本发明,并不用于限定本发明。

考虑到ViT有很强的建模能力和泛化能力,在常见的目标识别任务上表现很出色。本发明的核心思想是基于ViT设计一种新的特征级的旋转策略来增强应对旋转变化的泛化性,并将旋转不变性约束集成到特征学习过程中,增强对空间变化的鲁棒性,以减少因旋转变化导致的错误分类。具体地,本发明提出了一种在特征级上模拟块特征旋转来产生旋转特征的方法。最后,本发明在多个旋转特征和原始特征之间建立强约束,与原始目标一起优化,从而提高了检索率。

请见图1,本发明提供的一种具有旋转不变性的无人机目标重识别方法,采用旋转不变目标识别网络进行无人机目标重识别;旋转不变目标识别网络,包括块生成模块和若干Transformer层;

请见图2,本实施例的块生成模块包含一个卷积层,采用重叠方式以16*16为单位分割源图像。使用卷积核大小为16*16,步长为12。Transformer层由MSA(多头自注意力)和MLP(两层使用GELU激活函数的全连接网络)组成,在MSA和MLP之前均加上了LayerNorm和残差连接。

本实施例的方法具体包括以下步骤:

步骤1:通过块生成模块,将原始图片带部分重叠的方式分成若干个小块;

步骤2:把小块展平成序列后,再添加一个随机初始化小块作为后续的全局分类特征,然后把所有小块输入到深度为h的Transformer层中;

步骤3:经过步骤2中的Tranformer层学习得到的特征,进入两个分支,一个分支进行特征级旋转后得到多个旋转特征,另一个分支通过一个Transformer层学习后得到一个原始特征;

由框架网络学习的全局特征表示成

其中,W、H是图像的长和宽,P是一个块的大小,D是维度;

请见图3,本实施例把每个块都看作一个像素,f

与基于像素的图片旋转不同,特征级旋转是在更大块上进行的,所以旋转一个数值看起来很小的角度实际上模拟了一个相对较大的旋转。因此,本实施例定义一个参数α来限制产生的角度的大小,θ∈[-α,α]。通过实施上述旋转操作得到一系列多角度旋转图片F

步骤4:对多个旋转特征的平均值和一个原始特征采用旋转不变约束损失优化;

步骤3中的特征级旋转从多样性角度提升了网络对角度变化的泛化能力。此外,旋转特征和原始特征都表示同一个目标。本实施例人为地将旋转特征和原始特征的不变性约束加入损失函数中,以建立它们之间的关系。通过这种方法,缩短了类内的距离(Mang Ye,Jianbing Shen,Xu Zhang,Pong C Yuen,and Shih-Fu Chang.2020.Augmentationinvariant and instance spreading feature for softmaxembedding.IEEE TPAMI(2020)),更有利于正确分类。旋转特征的一组全局分类特征c

其中,c

本实施例的目标是限制平均旋转特征和原始特征之间的差异。有必要确保旋转特征表现出来的类别区分不会被削弱。Mean Square Error(MSE)是最常用的损失函数,它表示预测值与目标值之差的平方和。本实施例选择smooth L1 loss来计算差值,这可以有效防止梯度爆炸问题。该部分的旋转不变性约束表示为:

在训练阶段,整体损失函数由三个部分组成。当旋转特征更新时,原始特征也被输入到一个Transformer层以进一步更新代表全局的全局分类特征。本实施例将通过多个Transformer层学习得到的原始特征表示为c

此外,平均旋转特征是一种适应角度多样性的辅助特征表示。不变性约束控制着原始特征和旋转特征之间的差异。总体学习目标函数是:

其中,λ和1-λ分别表示原始特征和旋转特征的比重。

步骤5:对步骤4处理后的多个旋转特征和一个原始特征采用三元组损失优化;

步骤6:通过全连接层和批量归一化层(BN层)对步骤5处理后的图片进行分类识别。

本实施例的旋转不变目标识别网络,为训练好的旋转不变目标识别网络;由于旋转的随机性,每一个含有不同信息的旋转特征可以被看作一个新的特征。为了学习多样的特征,二维

每一个代表旋转特征的全局分类特征对整个模型的更新发挥着等同作用。

下面结合具体实验进一步阐述本实施例的原理。

本实施示例采用的深度学习框架为Pytorch。实验的硬件环境是NVIDIA GeForceRTX3090*8显卡,处理器为Intel(R)Xeon(R)Gold 6240。实验流程如下:

第一步:旋转特征生成网络搭建

实验中采用Vision Transformer(ViT)网络作为特征提取器,在特征级上模拟块特征旋转来产生旋转特征,最后建立原始特征和旋转后的特征之间的约束。并采用身份分类损失、三元组损失、smooth L1损失、交叉熵损失联合端到端特征提取器、旋转特征生成网络和旋转不变约束。

第二步:网络训练

划分目标对象照片和无人机拍摄照片为训练集和测试集。目标对象照片被送入特征旋转网络进行训练。利用前向传播和反向传播对网络参数进行优化和更新。

第三步:网络测试

测试集中目标对象的图像作为待查询集,无人机拍摄样本集作为图库集。采用训练过程中效果最好模型进行推理,得到测试集上最终检索结果。评价指标采用Rank-1、Rank5、mAP、mINP匹配精度,该精度反应了正确的重识别图像的检索概率。

本发明在PRAI-1581,UAVHuman,VRAI三个由无人机拍摄的数据集和Market1501、MSMT7是两个常用的使用地面监控摄像头收集的行人重识别数据集。PRAI-1581是为无人机任务提出的数据集。它由两架在20米至60米高度飞行的无人机拍摄的1581名行人的39461张图像组成。UAVHuman主要用于无人机行人行为研究,也可以被用到例如行人重识别、动作识别和高度估测等多种任务中。这个数据集包含1444个行人和41290张图像。VRAI是由13033辆车的137613张照片组成的车辆重识别数据集。车辆图片由在不同地方飞行的高度在15米到80米的无人机收集。同时也有丰富的注释,包含颜色、车种类、属性、图片和有区别的地方。

本发明将图像统一调整为256*256。此外,在训练数据中采用10个像素的填充、随机裁剪和概率为0.5的随机擦除。用ImageNet-1K预先训练的参数进行网络参数初始化。在重叠块嵌入阶段,patch大小设置为16,步幅大小设置为12。在特征级旋转中,旋转的特征数N为4,随机旋转角度的范围在-15度到15度之间。由于是基于块旋转,所以角度不宜设置过大。对于主干提取的原始特征和旋转特征,使用无边距的三元组损失,并在特征通过批泛化层后使用交叉熵损失。原始特征λ的权重为0.5,旋转特征1-λ的权重为0.5。在平均旋转特征和原始特征之间应用Smooth L1损失。在训练期间,使用随机梯度下降(SGD)优化器。初始学习率为0.008,采用余弦学习率衰减。训练次数为200。批大小设置为64,包括16个身份,每个身份有4张图像。在测试阶段,仅使用原始特征来计算距离矩阵。整个实验的实现基于PyTorch。

为了验证本发明的有效性,本节将本发明的检索结果与现有的无人机重识别方法进行了对比,现有的目标重识别方法主要有:

(1)PCB:Jianlou Si,Honggang Zhang,Chun-Guang Li,Jason Kuen,XiangfeiKong,Alex C Kot,and Gang Wang.2018.Dual attention matching networkforcontext-aware feature sequence based person re-identification.InCVPR.5363–5372.

(2)SP:Shizhou Zhang,Qi Zhang,Yifei Yang,Xing Wei,Peng Wang,BingliangJiao,and Yanning Zhang.2020.Person re-identification in aerial imagery.IEEETMM 23(2020),281–291.

(3)AGW:Mang Ye,Jianbing Shen,Gaojie Lin,Tao Xiang,Ling Shao,andSteven C.H.Hoi.2021.Deep learning for person re-identification:A survey andoutlook.IEEE TPAMI(2021),1–1.

(4)Multi-task:Peng Wang,Bingliang Jiao,Lu Yang,Yifei Yang,ShizhouZhang,Wei Wei,and Yanning Zhang.2019.Vehicle re-identification in aerialimagery:Dataset and approach.In ICCV.460–469.

(5)Baseline(ViT):Shuting He,Hao Luo,Pichao Wang,Fan Wang,Hao Li,andWei Jiang.2021.Transreid:Transformer-based object re-identification.InICCV.15013–15022.

(6)TransReID:Shuting He,Hao Luo,Pichao Wang,Fan Wang,Hao Li,and WeiJiang.2021.Transreid:Transformer-based object re-identification.InICCV.15013–15022.

在PRAI-1581,UAVHuman,VRAI数据集上进行测试,结果见表1

表1

在Market-1501和MSMT17数据集上进行测试,结果见表2

表2

从表1和表2可以看出:与近些年Re-ID相比,本发明所提方法不管在无人机目标重识别和城市摄像头目标重识别上均实现了检索率的提升。在PRAI-1581数据集上,所提方法性能明显优于表中所有方法,所提方法在Rank1和mAP上分别优于当前最优方法TransRe-ID4.8%和5.9%。在UAVHuman数据集上,mAP优于当前最优方法TransRe-ID 2%。在VRAI数据集上,本发明提出的方法在不使用任何辅助信息的情况下实现了83.5%的Rank1准确率和84.8%的mAP,超过了所有其他方法。在Market-1501和MSMT17数据集上,提出的方法在普通城市摄像头场景下实验也显示本发明的方法具有强大的泛化能力,mAP和Rank1比目前最优分别提高了5.4%和3.2%。在三个无人机采集数据集和两个地面摄像头采集数据集上的实验结果,证明了本发明所提方法的有效性和泛化性。

应当理解的是,上述针对较佳实施例的描述较为详细,并不能因此而认为是对本发明专利保护范围的限制,本领域的普通技术人员在本发明的启示下,在不脱离本发明权利要求所保护的范围情况下,还可以做出替换或变形,均落入本发明的保护范围之内,本发明的请求保护范围应以所附权利要求为准。

- 基于IRCNN和MTCNN的具有尺度旋转不变性的静脉识别方法及系统

- 基于旋转不变性等变网络应对目标旋转的方法和系统