一种基于自编码的视频超分辨率方法

文献发布时间:2024-01-17 01:13:28

技术领域

本发明属于计算机视觉领域,特别涉及一种基于自编码的视频超分辨率方法。

背景技术

在影视制作和处理中,利用视频超分辨率算法将低分辨率视频处理成超高清视频,一直都是一个刚性需求。随着深度神经网络的发展,基于深度网络的超分算法模型称为了解决超分任务的主流算法,而重建高分辨率图像方法的优劣决定了超分后的视频质量。现在存在的问题是:一般来说,重建高分辨率图像的过程,是一个从无到有的病态过程,即从少量已知信息中,猜测出大量未知信息,因此想要获得高质量的重建图像比较困难。通过前后视频帧提供信息,对当前视频帧进行高分辨率重建,比如采用光流算法关联前后视频帧,以此为当前视频帧的高分辨率重建提供信息,但是如何从较长的时间维度中有效提取重建高分辨率所需的依赖信息,依然是一个难以解决的问题,特别是超高清视频,需要消耗大量内存和算力。

与此同时,超分数据集的病态问题也需要解决。解决上述问题存在的难度为:在重建高分辨率图像这类任务中,不存在真实的标签。高清视频可以降低分辨率,处理成低分辨率的视频,但难以模拟出低质量、高噪声、抖动模糊的与真实拍摄一致的视频;同样的,真实拍摄的低分辨率的视频,也没有与之对应的真实的高分辨率视频。因此,制作低分辨率到高分辨率的是数据集,同样是一个病态数据集,与实际情况总有些差距。假如使用基于有监督学习的算法模型,就要制作这样一个病态数据集。而如果采用无监督学习的算法模型,则无需制作这样的数据集,输入什么,输出的标签就是什么,不存在数据集病态的问题,可以使用海量的视频进行自监督学习。

解决上述问题的意义为:解决在现有方法中,因重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题,从而有效地在较长的时间维度中提取重建高分辨率所需的依赖信息,无监督和有监督学习相结合一定程度缓解了数据集病态问题,最终实现视频超分后的视频质量提升。

发明内容

本发明提供了一种基于自编码的视频超分辨率方法,解决了现有方法中因重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题,实现了视频超分后的视频质量提升。

本发明的技术方案如下:

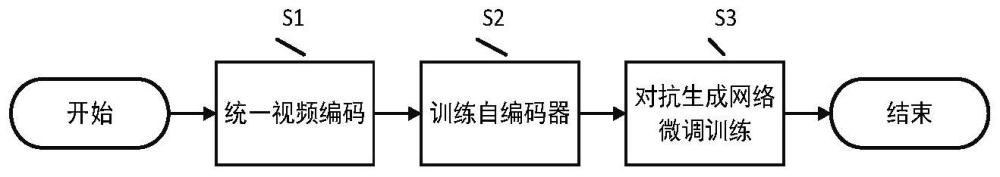

本发明的基于自编码的视频超分辨率方法,包括以下步骤:S1.统一视频编码:使用相同编码标准和编码参数,对视频进行重新编码,得到视频数据集;S2.训练自编码器:构建两个自编码器,一个用于RGB图像的特征提取,一个用于图像组的信息获取,并使用视频数据集进行训练;S3.对抗生成网络微调训练:使用卷积神经网络,融合两个自编码器的输出特征,得到生成器,并构建对抗生成网络对生成器进行微调训练,最终得到微调训练后的生成器。

可选地,在上述基于自编码的视频超分辨率方法中,在步骤S1中,将所有视频强制转为4K(3840*2160)视频,以此作为视频数据集。

可选地,在上述基于自编码的视频超分辨率方法中,在步骤S2中,两个自编码器为第一自编码器和第二自编码器,其中,第一自编码器基于CNN卷积神经网络,用于从解码后的图像进行特征提取;第二自编码器基于Transformer自注意力神经网络,用于从未解码的视频码流进行信息提取,使用步骤S1提供的视频数据集,分别训练第一自编码器和第二自编码器。

可选地,在上述基于自编码的视频超分辨率方法中,在步骤S3中,将步骤S2中得到的第一自编码器和第二自编码器,使用CNN卷积神经网络进行特征融合,以此作为生成器,并构建对抗生成网络对生成器进行微调训练,最终得到的微调训练后的生成器。

根据本发明的技术方案,产生的有益效果是:

本发明的基于自编码的视频超分辨率方法,针对重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题,构建了基于双自编码器的生成器算法模型,有效解决了旧有方法无法从视频流中获取重建高分辨率图像所需的依赖信息的问题。在现有技术中,一般将视频帧进行解码,得到每一帧图像的数组矩阵,直接进行上采样或依赖光流信息重建高分辨率图像,这样导致产生大量冗余数据,消耗大量内存和算力,难以建立长时间维度的图像依赖。本发明方法,根据视频自编码器的编解码特性,从未解码的视频流中获取重建高高分辨率图像所需的依赖信息,这是一个从有到有的过程,从而避免了旧有方法重建高分辨率图像缺乏依赖信息的从无到有的病态问题,最终实现具有足够依赖信息输入的视频超分功能。

为了更好地理解和说明本发明的构思、工作原理和发明效果,下面结合附图,通过具体实施例,对本发明进行详细说明如下:

附图说明

为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍。

图1是本发明的基于自编码的视频超分辨率方法的流程图;

图2是本发明的自编码器的自编码神经网络的示意图;

图3是本发明的生成对抗网络微调训练的示意图。

具体实施方式

为使本发明的目的、技术方法及优点更加清晰,下面结合附图及具体实例,对本发明做进一步的详细说明。这些实例仅仅是说明性的,而并非对本发明的限制。

本发明的基于自编码的视频超分辨率方法,通过构建两个自编码器进行无监督学习,之后使用GAN(生成对抗网络)进行有监督学习微调训练,得到一个依赖视频流信息重建高分辨率图像的生成器,以此解决在现有方法中,因重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题,从而有效地在较长的时间维度中提取重建高分辨率所需的依赖信息,无监督和有监督学习相结合一定程度缓解了数据集病态问题,最终实现视频超分后的视频质量提升。该算法利用自编码器的编解码特性,实现和自注意力机制神经网络的自相关性,实现长时间跨度的图像帧输入的超分算法。

本发明的基于自编码的视频超分辨率方法的原理是:1)利用自编码器的编解码特性,将RGB图像和图像组GOP编码同时作为算法的输入数据,以此消除上采样缺乏依赖信息的病态问题,进而实现依赖视频码流重建高分辨率图像的功能;2)利用卷积神经网络的特征融合能力,将自编码器输出特征融合,进而构建出重建高分辨率图像的生成器。

本发明的基于自编码的视频超分辨率方法,将视频RGB图像帧和图像组GOP编码同时作为算法模型的输入数据,利用自编码器的编解码特性以及卷积神经网络的特征融合能力,构建了重建高分辨率图像的生成器,从而实现从视频码流数据获取依赖信息并重建高分辨率图像的视频超分功能。

如图1所示,本发明的基于自编码的视频超分辨率方法,从开始到结束,包含以下步骤:

S1.统一视频编码:使用相同编码标准和编码参数,对视频进行重新编码,得到视频数据集。

具体地,将所有视频强制转为4K(3840*2160)视频,以此作为视频数据集。

S2.训练自编码器:构建两个自编码器,一个用于RGB图像的特征提取,一个用于图像组GOP的信息获取,并使用视频数据集进行训练。

图像组GOP是视频编码过程中的一组图像,两个关键帧之间的所有图像帧,这些图像帧是比特流,没有解码的,在内存中以字节流形式存储。图像组GOP的数据结构是以“未解码的视频码流”这种数据格式存储的。

优选地,构建两个自编码器:自编码器A1和自编码器A2,其中,自编码器A1基于CNN卷积神经网络,用于从解码后的图像(RGB图像)进行特征提取;自编码器A2基于Transformer自注意力神经网络,用于从未解码的视频码流进行信息提取。使用步骤S1提供的视频数据集,分别训练A1和A2。

S3.对抗生成网络微调训练:使用卷积神经网络,融合两个自编码器的输出特征,得到生成器,并构建对抗生成网络对生成器进行微调训练,最终得到微调训练后的生成器,即,具有将低质量转为高质量视频的超分辨率算法模型。

优选地,将步骤S2中得到的自编码器A1和自编码器A2,使用CNN卷积神经网络进行特征融合,以此作为生成器,并构建对抗生成网络对生成器进行微调训练,最终得到的微调训练后的生成器就是超分辩率算法模型。

本发明方法利用双自编码器特征融合构建了一个全新的视频超分辨率算法模型,模型支持RGB图像和视频图像组GOP码流的同时输入,算法模型从视频流编码中获取较长的时空依赖信息,并利用这些信息重建出高分辨率图像,这是一个从有到有的过程,以此解决现有方法中,因重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题。

具体实施步骤如下:

S1.统一视频编码:

使用相同的编码标准和编码参数,对所有视频文件进行重新编码,将所有视频强制转为4K(3840*2160)视频,此过程需要确保不造成源视频质量损失。首先,将H.264、H.265、XAVC、AVS3、AVS2等编码的视频文件,均采用H.265编码标准进行重新编码;其次,编码过程中的参数设置也要求相同,如输出分辨率4K(3840*2160)、最大码率250Mbps、色彩空间4:2:0等;最后,均采用.mp4格式进行封装。自编码器神经网络算法模型的训练集、测试集、验证集,均采用上述数据处理方式处理。而生成对抗网络GAN的训练集、测试集、验证集,除了满足上述要求外,还要求原视频本身4K超高清视频,而不是将低分辨率强制转为高分辨率的伪4K。

S2.训练自编码器:

如图2所示,是本发明的自编码器的自编码神经网络的示意图。自编码神经网络算法模型,由自编码器A1和自编码器A2构成,这两个自编码器相互独立。

自编码器A1,基于通用CNN卷积神经网络构建而成,网络输入数据为4K(3840*2160*3)超高清解码后的一帧RGB视频帧X[R,G,B],数据经过卷积神经编码网络CNNEncoder(图2中的卷积编码网络)编码,得到瓶颈特征向量Z1,Z1再经过卷积神经解码网络CNN Decoder(图2中的卷积解码网络)解码,得到一张4K(3840*2160*3)超高清RGB图像O[R,G,B]。训练过程采用无监督学习,输入X经过自编码器后输出O,期望输入和输出尽量一致,即O≈X。

自编码器A2,则是基于通用Transformer自注意力神经网络构建而成,网络输入数据G(码流)为一组或多组视频帧组GOP的编码数据,这是未解码的数据流,数据流经过自注意力神经编码网络Transformer Encoder(图2中的自注意力编码网络)编码,得到瓶颈特征向量Z2,Z2在经过自注意力神经解码网络Transformer Decoder(图2中的自注意力解码网络)解码,得到和输入数据量一致的输出数据流R。训练过程同样采用无监督学习,输入G经过自编码器后输出R[码流],期望输入和输出尽量一致,即G≈R。

上面自编码器A1和A2的训练,均采用无监督学习进行训练,无监督学习使得无需标注,就可以使用大量的4K超高清视频,作为数据集进行训练,以此可以有效解决视频超分辨率中,从无到有的重建丢失信息的病态问题。

S3.对抗生成网络微调训练:

步骤S2构建的自编码器神经网络算法模型的编码器A1和编码器A2,经过海量的超高清视频数据训练后,可以作为特征编码提取器。如图3所示,是本发明的对抗生成网络微调训练的示意图,将从步骤S2中得到的自编码器A1和A2,使用微调训练技术方法,将其编码网络的参数固定住,解码网络输入部分的参数也固定住,仅微调训练解码网络的输出位置的少量神经网络层。与此同时,使用CNN网络将自编码器A1和A2的输出特征进行融合,经过CNN网络计算后输出期望得到的超高清图像[R,G,B]。自编码器A1、自编码器A2和输出层的CNN网络共同构成了生成器,这是本发明方法的核心发明点,其与现有的公开的方法不同,通常的超分算法一般直接使用上采样来提升分辨率,并使用光流来建立帧与帧之间的关系,而本发明方法则采用全新的方式,使用自编码器A1进行特征提取,自编码器A2建立帧与帧之间的关系,CNN卷积层进行特征融合,以此为基础构建的生成器,不再是从无到有的重建丢失信息的病态问题,而是依赖视频编码连续帧时空维度提供的稀疏编码,进行重建高分辨率图像,是一个从有到有的过程,从而解决旧有方法重建高分辨率图像的从无到有的病态问题。

生成对抗网络微调训练过程中,输入生成器的数据为低质量视频的RGB视频帧和GOP数据流,经过生成器后输出高质量的图像(Image)。其中,低质量视频的分辨率也为4K,但码率较低,画面不清晰,细节模糊。图像T则来自真4K视频,画面清晰,细节完整。最后根据对抗生成网络GAN原理,生成器生成的图像(Image)和真4K高清图T[R,G,B],均作为判别器的输入数据,依次输入到判别器中进行判别,即真/假判断。之后使用通用的GAN网络训练方法,反复训练生成器和判别器,最终得到训练完成的生成器,该生成器就可以将低质量的视频转为高质量的视频。至此,完成了基于自编码的视频超分辨率算法实现的整个过程。

本发明从视频码流中获取重建高分辨率图像所需的依赖信息,实现一个从有到有的超分过程。特别的,基于视频自编码器的编解码能力,设计了基于CNN卷积神经网络的自编码器和基于Transformer自注意力神经网络的自编码器,以此让模型支持同时输入RGB图像和图像组GOP码流,并结合CNN卷积神经网络的特征融合能力,最终实现有信息依赖的重建高分辨率图像的功能。本发明利用自编码器的编码和解码特性,实现一个从视频编码码流中提取重建高分辨率图像所需的依赖信息的算法模型,进而实现一个视频超分辨率的方法,以此解决旧有方法中,因重建高分辨率图像过程的上采样依赖信息不足而导致的从无到有的病态问题。

以上说明是依据发明的构思和工作原理的最佳实施例。上述实施例不应理解为对本权利要求保护范围的限制,依照本发明构思的其他实施方式和实现方式的组合均属于本发明的保护范围。

- 一种基于多记忆及混合损失的视频超分辨率重建方法

- 针对视频压缩使用运动补偿的基于示例的超分辨率来编码视频信号的方法和设备

- 针对视频压缩使用运动补偿的基于示例的超分辨率来编码视频信号的方法和设备