一种基于分布式强化学习的智能兵棋推演方法

文献发布时间:2023-06-19 12:07:15

技术领域

本发明涉及智能兵棋推演技术领域,具体为一种基于分布式强化学习的智能兵棋推演方法。

背景技术

兵棋推演是模拟战争对抗的各方人员,使用代表战场及其军事力量的棋盘和棋子,依据从战争经验中总结的规则,对战争过程进行逻辑推演研究和评估的军事科学工具,是一类回合制博弈问题。把战争搬进沙盘和计算机,构设虚拟战场,通过尽可能接近实战的模拟,令军队在未来战争中获得更大胜算——这就是“兵棋推演”的意义所在。兵棋通常由地图(棋盘)、推演棋子(算子)和裁决规则(推演规则)3个部分组成。在现代众多兵棋类比赛中,较多采用的是以计算机为载体的电子兵棋系统。

如图1所示,一般兵棋推演任务采用四边或六边形栅格化地图,各栅格中通过不同标志或颜色标注该位置地形、地貌或高度。兵棋对抗由至少两方完成,各方均配备总体能力大致相同、但机动能力、射击方式等各不相同的棋子。通常,兵棋推演的任务大致有两种:歼灭对手和占据要地。大型兵棋地图中,有价值的栅格分布极为稀疏:通常,数千栅格中,对当前时刻策略制定有重要参考意义的仅数十格,各棋子的可行范围也仅周围数格。

兵棋推演是认识和掌握未来战争的有效工具,利用兵棋在虚拟作战环境中推演未来作战行动,有利于趋利避害,将各种作战设想转化为实际行动方案。未来,多域作战的概念将进一步发展、进一步完善,兵棋推演将在多域作战的发展中继续发挥重要作用,通过联合推演提高各军种之间的协同能力。

随着新军事革命由“信息化”向“智能化”转型,未来“人工智能+兵棋”将会在军事领域得到更多的应用。因此,利用人工智能技术研究兵棋推演策略是很有必要的。

国防大学的崔文华等人提出了一种基于强化学习的兵棋推演决策方法框架,采用了分层强化学习的方案,战场态势均使用人为设计的标签并加以向量化来描述,然而在实际应用中某些战场态势无法进行准确量化,导致采用分层强化学习的方案难以针对各种战场态势均能得到有效的决策结果;此外目前的基于强化学习的兵棋推演决策方法中采用统一的强化学习模型,网络规模大,需要高性能计算机支持。

发明内容

为解决现有技术存在的问题,本发明基于强化学习,提出了一种分布式智能兵棋推演方法,对于每个算子建立一个决策神经网络,并且在对战场态势描述中,除了使用常规的标签来描述战场态势之外,还采用图像数据对难以量化的环境状态、个体属性进行了表征,从而能够更加准确的针对各种战场态势得到有效的决策结果。

本发明的技术方案为:

所述一种基于分布式强化学习的智能兵棋推演方法,包括以下步骤:

步骤1:确定兵棋算子决策网络的状态变量与动作变量;

对于算子i而言,状态变量S

步骤2:在算法训练阶段,兵棋推演过程中通过与兵棋推演平台进行交互,获得算子每一步行动的得分作为奖励函数R;

步骤3:根据状态输入变量、状态输出变量确定马尔科夫决策过程

其中,

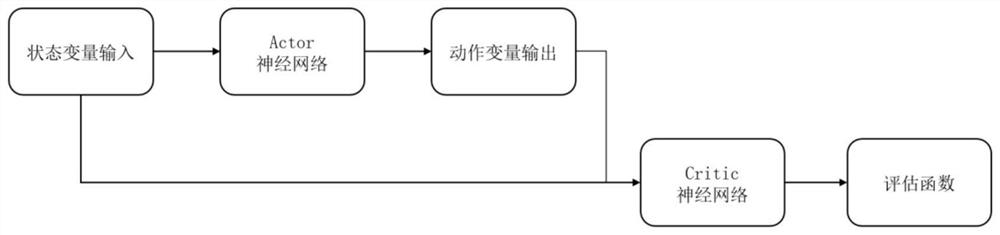

步骤4:对于每个算子采用Actor-Critic算法建立神经网络,其中Actor网络输入为算子的状态变量观测,输出为算子的动作变量,Critic网络的输入为算子的状态变量观测以及算子的动作变量,输出为评估函数,所述评估函数为算子真实奖励值与估计奖励值的差值;

以评估函数最小化为训练目标,结合经验池中的信息对每个算子神经网络的参数逐级进行训练,直至网络收敛;

之后将训练得到收敛的Actor网络接入兵棋推演系统,每个算子根据战场形势做出相应决策。

进一步的,所述算子i当前位置的通视状态通过通视图来表示,所述通视图为算子当前位置所能通视的范围构成的图像;将通视图经过卷积神经网络处理得到算子i当前位置的通视状态。

进一步的,己方算子的状态信息包括位置、机动力、剩余血量;敌方算子信息包括位置、算子种类、剩余血量。

进一步的,动作变量为机动、机动位置、攻击、攻击目标构成的4维向量。

进一步的,所述奖励函数R包括夺控分R

R=R

进一步的,所述Actor网络为三层全连接神经网络,第一层的神经元数量由输入的算子状态变量维度决定,第二层包含256个神经元,第三层的神经元数量由算子的动作变量维度决定。

进一步的,所述Critic网络为三层全连接神经网络,第一层的神经元数量由Actor神经网络输入的状态变量维度以及Actor神经网络输出的动作变量维度共同决定,第二层的神经元数量包含128个神经元,第三层的神经元数量为1。

进一步的,利用梯度下降法和反向梯度传播法对每个算子神经网络的参数逐级进行训练。

有益效果

本发明采用了分布式强化学习的方法,一个算子对应一个决策网络,网络规模小、搜索空间小,便于迁移。

本发明将图像信息也加入了算子的状态变量中,能够描述无法简单量化的复杂战场态势,从而能够更加准确的针对各种战场态势得到有效的决策结果。

本发明的附加方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实践了解到。

附图说明

本发明的上述和/或附加的方面和优点从结合下面附图对实施例的描述中将变得明显和容易理解,其中:

图1:一种兵棋地图;

图2:通视图示意;

图3:Actor-Critic算法运行流程图;

图4:兵棋推演环境下强化学习网络决策流程图。

具体实施方式

兵棋推演是典型的不完全信息博弈问题,目前主要以人人对战的方式来探索不同的对抗策略,有一定的局限性。本发明通过使用基于分布式强化学习的人工智能方法,设计无需人类过多干预的智能兵棋推演方案,实现了智能化的兵棋对抗。

本发明的具体步骤如下:

步骤1:确定兵棋算子决策网络的状态变量与动作变量。

对于算子i而言,状态变量S

实施例中,己方算子的数目为3,敌方算子数目为3,已观测到的敌方算子数目为1。因此对己方算子i而言,状态变量S

步骤2:在算法训练阶段,兵棋推演过程中通过与兵棋推演平台进行交互,获得算子每一步行动的得分作为奖励函数R,主要包括夺控分R

R=R

R值越高则本局兵棋比赛表现越好。

步骤3:根据状态输入变量、状态输出变量确定马尔科夫决策过程,表示如下:

其中,S为步骤1中算子的状态变量输入,A为步骤1算子动作变量输出;R为步骤2中的奖励函数,γ为折扣因子,其取值范围为γ∈[0,1]。

基于此,构建强化学习的训练池如下

其中,

算法训练阶段,每个算子与平台交互产生的信息,都将被存储在该算子经验池中,并用于神经网络训练。

步骤4:本发明采用分布式学习方法,每个算子都有自己的神经网络,均采用强化学习中常用的Actor-Critic算法进行实现,主要包括两个神经网络,一个为Actor网络,输入为算子的状态变量观测,输出为算子的动作;一个为Critic网络,输入为算子的状态变量观测、算子的动作变量,输出为评估函数,主要过程如图3所示。

其中定义每个算子的Actor网络的输入为步骤1中确定的算子的状态变量,状态变量的初始值为算子的初始位置和初始状态所表示的态势信息,输出为步骤1中确定的算子的动作变量。Actor网络为三层全连接神经网络,第一层的神经元数量由输入的状态变量维度决定,本实施例中,第一层的神经元数量为42,第二层包含256个神经元,第三层的神经元数量由算子的动作变量维度决定,本实施例中第三层的神经元数量为4。

定义每个算子的Critic网络的输入为Actor网络的输入以及Actor网络的输出,Critic网络的输出的评估函数为算子通过步骤2奖励函数计算的真实奖励值与Critic网络估计奖励值的差值。Critic神经网络为三层全连接层,第一层的神经元数量由Actor 神经网络输入的状态变量维度以及Actor神经网络输出的动作变量维度共同决定,本实施例中第一层的神经元数量为46,第二层的神经元数量包含128个神经元,第三层的神经元数量为1。

以评估函数最小化为训练目标,结合经验池中的信息利用梯度下降法和反向梯度传播法对该算子神经网络的参数逐级进行训练,直至网络收敛。

之后将训练得到收敛的Actor网络接入兵棋推演系统,每个算子根据战场形势做出相应决策。

尽管上面已经示出和描述了本发明的实施例,可以理解的是,上述实施例是示例性的,不能理解为对本发明的限制,本领域的普通技术人员在不脱离本发明的原理和宗旨的情况下在本发明的范围内可以对上述实施例进行变化、修改、替换和变型。

- 一种基于分布式强化学习的智能兵棋推演方法

- 一种基于强化学习的网络化多智能体系统分布式优化控制方法