一种基于动态记忆库模板更新的目标跟踪方法

文献发布时间:2023-06-19 09:26:02

技术领域

本发明涉及目标跟踪领域,尤其涉及一种基于动态记忆库模板更新的目标跟踪方法。

背景技术

随着社会信息化程度不断提高,电子设备产生大量信息,其中主要为视频信息,分析或利用视频信息的一项基础性技术是目标跟踪。对于很多种应用场景,比如无人驾驶,只有提取道路面运动物体的轨迹,才有可能针对该物体进行一系列的躲避动作,以保持安全距离。所以,大量的应用场景需要对视频进行目标跟踪处理,在此基础上做出相应的数据分析,进而做出相应的判断。

目标跟踪是指在设备获取的视频序列上,对其中的一个目标或者多个目标进行跟踪。预先给出目标在初始帧上的信息,包括位置信息和形状大小信息,通常使用一个包含目标的矩形框来表示。在后续帧上,通过目标跟踪算法得到目标的位置和大小的信息。目标跟踪的算法,可分为基于生成式的算法和基于判别式的算法。早期的算法比如光流法,均值漂移法,属于基于生成式的算法。目前主流的目标跟踪算法都是基于判别式的,其中又可分为基于相关滤波的算法和基于深度学习的算法。相关滤波算法,有KCF

由于视频序列中,目标存在形变,遮挡和旋转等问题,这使得目标跟踪十分具有挑战性。单一使用初始帧模板进行自始至终地模板匹配任务,这种方式对于跟踪算法性能提升有很大限制。因此,引入模板更新机制是必要的。但是简单的模板更新机制,比如简单地将上一帧的跟踪结果,作为下一帧的模板进行使用,会使性能不升反降。因为在跟踪任务中,只有初始帧模板是完全可信的,网络无法判断出当前的跟踪结果是否准确,是否需要修正;所以简单的模板更新机制会造成错误传播,降低性能。

发明内容

本发明提供了一种基于动态记忆库模板更新的目标跟踪方法,本发明可进行模板更新,提供可靠的模板,在针对目标遮挡、形变和旋转等具有挑战的环境下,具有良好的性能,详见下文描述:

一种基于动态记忆库模板更新的目标跟踪方法,所述方法包括:

构建目标跟踪的MemTrack基础网络框架;

将MemTrack基础网络框架中的初始帧模板特征参照即将进入动态记忆库的已有模板特征进行最小二乘映射;

将动态记忆库内写入更新后的模板特征参照处理后的模板特征进行最小二乘映射;

在训练阶段,使用ILSVRC VID数据集,参照MemTrack的网络结构方式进行训练。

其中,所述将MemTrack基础网络框架中的初始帧模板特征参照即将进入动态记忆库的已有模板特征进行最小二乘映射具体为:

其中,T

进一步地,所述将动态记忆库内写入更新后的模板特征参照动态记忆库中处理后的模板特征进行最小二乘映射具体为:

M

其中,

本发明提供的技术方案的有益效果是:

1、本发明以MemTrack

2、本发明对已经入动态记忆库的模板进行映射变换,使动态记忆库输出的模板既包含当前帧的信息,又包含过去帧的信息;最终,既提高模板的可信度,又提高模板所含信息量;通过基准数据库测试,本发明所提出的算法在性能上获得提升,可以得到更好的主观和客观结果。

附图说明

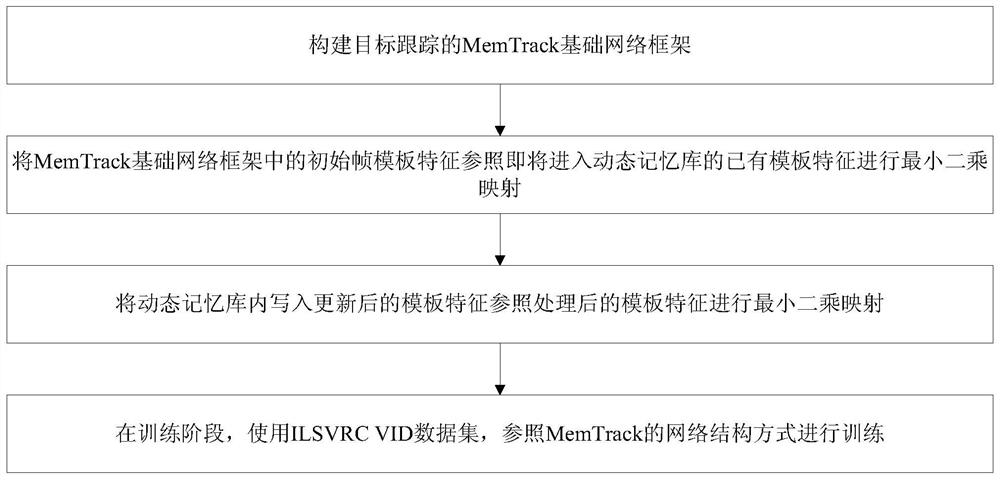

图1为一种基于动态记忆库模板更新的目标跟踪方法的流程图;

图2为基于动态记忆库模板更新的目标跟踪的网络框图;

图3为对比算法在OTB100测试的Success图和Precision图。

具体实施方式

为使本发明的目的、技术方案和优点更加清楚,下面对本发明实施方式作进一步地详细描述。

实施例1

本发明实施例提供了一种基于动态记忆库模板更新的目标跟踪方法,参见图1,该方法包括以下步骤:

101:构建目标跟踪算法的基础网络框架;

即首先搭建MemTrack的网络结构。MemTrack网络结构建立在SiamFC基础之上,包含两个特征提取分支和一个生成响应图的相关运算。除此之外,MemTrack网络结构在搜索分支上含有注意力模块和LSTM

其中,MemTrack的网络结构、SiamFC、LSTM模块均为本领域技术人员所公知,本发明实施例对此不做赘述。

102:在MemTrack的网络结构基础上加入最小二乘法映射函数;

将初始帧模板特征参照即将进入动态记忆库的模板特征进行最小二乘映射;将动态记忆库内存在的模板特征参照已进入动态记忆库的模板特征进行最小二乘映射。

103:在训练阶段,使用ILSVRC VID

首先,对每个视频序列进行随机采样,采样后的样本保持一个时间顺序,用来生成训练样本。训练时网络学习率按照指数衰减的方式更新,使用RMSProp优化器更新网络参数。训练过程加入尺度平滑变换函数和尺度变换惩罚。

其中,RMSProp优化器、尺度平滑变换函数和尺度变换惩罚均为本领域技术人员所公知,本发明实施例对此不做赘述。

104:在测试阶段,首先利用初始帧信息对网络参数进行初始化。通过卷积神经网络,对搜索区域进行特征提取,并将提取到的特征输入到注意力模块进行参数更新;根据注意力模块的输出和LSTM上一时刻的状态,对LSTM状态进行更新,生成各项控制或权重参数;综合当前动态记忆库内模板特征生成输出模板特征,与初始模板特征相加作为用于搜索目标的最终模板特征;将最终模板特征与搜索区域特征进行相关运算,生成响应图,计算得到目标的位置偏移和尺寸大小,完成对当前帧的目标跟踪。对跟踪结果进行特征提取并将其作为新的模板特征,参照初始模板帧特征进行最小二乘法变换后,输入动态记忆库;对输入动态记忆库的模板特征,参照动态记忆库内已有的模板帧特征进行最小二乘法变换后,对动态记忆库进行动态更新。

综上所述,本发明实施例通过步骤101至步骤104设计了一种基于动态记忆库模板更新的目标跟踪方法。在MemTrack原有网络结构基础上,引入最小二乘法映射变换。将初始帧模板和动态记忆库内已存在模板,参照写入动态记忆库的模板进行最小二乘法映射变换,使其富含初始帧模板信息和已存在模板信息。既提高了初始帧模板对网络的影响,又提高模板的可信度。本发明实施例是对MemTrack网络的在线更新机制的增强,使其面对大尺度变化,形变,旋转和遮挡等具有挑战性的目标跟踪环境,可以获得更好的性能。

实施例2

下面对实施例1中的方案进行进一步地介绍,详见下文描述:

201:构建SiamFC的目标跟踪框架;

视觉目标跟踪任务希望在给定初始帧信息的情况下,可以跟踪任意的目标。无论目标是否发生外观变化,算法都可以准确且实时进行跟踪。近年来,在目标跟踪领域,模板匹配的方法受到学者大量关注。模板匹配是指将初始帧模板和搜索帧的候选区域进行相关运算,找出最相似的候选区域作为当前帧跟踪结果。模板匹配方法可以获得良好的性能和可实时运行的速度,其中以SiamFC为基础框架的目标跟踪算法尤为受到关注。但模板匹配法的精确度和通过目标检测进行跟踪的算法仍有较大差距。其中一项关键原因是模板匹配法往往单纯使用初始帧信息进行匹配跟踪,不能包含目标外观变化信息,即没有模板更新机制。然而简单的模板更新机制,往往会降低算法性能。比如,最简单的模板更新机制:将上一帧的跟踪结果作为当前帧的模板,这种简单的方式会导致跟踪失败。因为不是每一帧的跟踪结果都是正确的,以此方式进行跟踪,会造成差错传播,进而跟踪失败。

因此加入模板更新机制,需要考虑的问题是如何提高更新后模板的可信度。在目标跟踪中,最可信的是初始帧模板信息,其余所有跟踪结果都是基于此生成。所以,提高初始帧模板在模板更新机制中的影响是合理且重要的。本发明实施例中,对跟踪结果进行特征提取并将其作为新的模板特征,参照初始模板帧特征进行映射变换后输入动态记忆库,正是基于这样的思想。

模板更新的目的是丰富模板信息,以适应当前目标的外观变化。在不降低可信度的前提下,如何提高更新后模板的信息量是模板更新的重要问题。本发明实施例在MemTrack 网络结构的基础上,通过对输入动态记忆库的模板特征参照动态记忆库内已有的模板帧特征进行映射变化的方式,增加更新后模板所含的信息量。

最小二乘法映射变换将计算转化到频域中通过FFT(快速傅立叶变换)迅速计算出,可以较小的计算开销提高网络的适应目标能力。同时最小二乘法映射变换可以看做一个简单的网络层,方便地插入到网络之中提高性能。

基于以上分析,本发明实施例提出的算法可对MemTrack算法的性能进行提升。

本发明实施例的算法网络结构如图2所示。

SiamFC的目标跟踪框架为,

其中,f(·)表示利用卷积神经网络进行特征提取,X

网络中注意力模块利用提取到的特征,生成表示目标特征的向量a

f

其中,α

202:在跟踪过程中,使用初始帧模板信息对网络进行初始化,从第二帧开始跟踪,过程如下:

在使用卷积神经网络提取搜索区域特征后,从动态记忆库

其中,N表示动态记忆库中存储单元数,M

读取权重

k

β

其中,h

在得到

r

其中,h

在进行相关运算后,可得到响应图S

然后进入第二部分,更新动态记忆库。输入动态记忆库的模板

其中,T

利用

其中,M

根据写入权重w

M

其中,translr

203:在训练阶段使用RMSProp优化算法;

s

其中,g

训练时用的损失函数和样本真值的定义,参考SiamFC使用的交叉熵损失函数和样本真值定义方式。

实施例3

下面结合具体的实验数据对实施例1和2中的方案进行效果评估,详见下文描述:

301:数据组成

测试集由OTB100

302:评估准则

本发明主要采用两种评价指标对目标跟踪算法的性能进行评估:

Precision图在OTB(目标跟踪基准库)数据集中提出,用于衡量跟踪算法的准确性,即跟踪结果的中心位置与真实的中心位置之间的误差。通过计算被跟踪目标的中心位置与所有帧的手动标记的真实值之间的平均欧几里德距离。然后计算两者之间的距离小于给定阈值的帧数,并将这些帧数除以总帧数。最后可以得到Precision图,一条随阈值变化而变化的百分比曲线。通常以将20像素点为阈值对应的精度值,作为该跟踪算法的精度值代表。

Success图,用于衡量跟踪算法得出的矩形框的准确程度。首先计算跟踪结果与真实值之间的交并比S,即:

其中,r

303:对比算法

在评估性能测试阶段,本发明实施例与3种深度学习方法SiameseFC-3s

表1展示几种算法在OTB100上测试得到的最好评价结果,其中MemTrack是本发明的基础框架。从表1中可以看到,本发明的评价结果Success和Precision较MemTrack分别提升了1.3%和1.9%,在Success上,比Siamese-3s提升5.7%,说明本发明可以有效提升基于孪生网络的目标跟踪算法应对目标外观变化的能力。同时在Precision上,比 SiamFC-3s高6.8%。相较于无监督的UDT算法性能也有所提升。与早期的相关滤波类算法CFNet相比,性能有显著提升。

表1

参考文献

[1]HenriquesF,Caseiro Rui,Martins Pedro,et al.High-Speed Trackingwith Kernelized Correlation Filters[J]//IEEE Transactions on Pattern Analysisand Machine Intelligence,2014, 37(3):583-596.

[2]Bolme Ds.Visual Object Tracking Using Adaptive Correlation Filters[C]//IEEE Conference on Computer Vision and Pattern Recognition Year,2010:2544-2550

[3]Danelljan Martin,Hager Gustav,Shahbaz Khan Fahad,et al.LearningSpatially Regularized Correlation Filters for Visual Tracking[C]//IEEEInternational Conference on Computer Vision, 2015:4310-4318.

[4]Danelljan Martin,Robinson Andreas,Khan Fahad Shahbaz,et al.Beyondcorrelation filters: Learning Continuous Convolution Operators for VisualTracking[C]//European Conference on Computer Vision,2016:472-488.

[5]Danelljan Martin,Bhat Goutam,Shahbaz Khan Fahad,et al.Eco:Efficient Convolution Operators for Tracking[C]//IEEE Conference on ComputerVision and Pattern Recognition, 2017:6638-6646.

[6]Bertinetto Luca,Valmadre Jack,Henriques Joao F,et al.Fully-Convolutional Siamese Networks for Object Tracking[C]//European Conference onComputer Vision,2016:850-865.

[7]Li Bo,Yan Junjie,Wu Wei,et al.High Performance Visual Trackingwith Siamese Region Proposal Network[C]//IEEE Conference on Computer Visionand Pattern Recognition,2018: 8971-8980.

[8]Li Bo,Wu Wei,Wang Qiang,et al.SiamRPN++:Evolution of SiameseVisual Tracking with Very Deep Networks[C]//IEEE Conference on ComputerVision and Pattern Recognition,2019: 4282-4291.

[9]Wang Qiang,Zhang Li,Bertinetto Luca,et al.Fast Online ObjectTracking and Segmentation: A unifying approach[C]//IEEE Conference onComputer Vision and Pattern Recognition,2019: 1328-1338.

[10]Nam Hyeonseob,Han Bohyung.Learning Multi-Domain ConvolutionalNeural Networks for Visual Tracking[C]//IEEE Conference on Computer Visionand Pattern Recognition,2016: 4293-4302.

[11]Song Yibing,Ma Chao,Wu Xiaohe,et al.VITAL:VIsual Tracking viaAdversarial Learning[C]//IEEE Conference on Computer Vision and PatternRecognition,2018:8990-8999.

[12]Danelljan Martin,Bhat Goutam,Khan Fahad Shahbaz,et al.ATOM:Accurate Tracking by Overlap Maximization[C]//IEEE Conference on ComputerVision and Pattern Recognition, 2019:4660-4669.

[13]Yang Tianyu,Chan Antoni B.Learning Dynamic Memory Networks forObject Tracking[C]//European Conference on Computer Vision ,2018:152-167.

[14]Hochreiter S,Schmidhuber J.Long short-term memory[J]//Neuralcomputation,1997,9(8): 1735-1780.

[15]Deng Jia,Dong Wei,Socher Richard,et al.ImageNet:A Large-ScaleHierarchical Image Database[C]//IEEE Conference on Computer Vision andPattern Recognition,2009:248-255.

[16]WuYi,Lim Jongwoo,YangMing-Hsuan.Object TrackingBenchmark[J]//IEEETransactions onPatternAnalysis and Machine Intelligence,2015,37(9):1834-1848.

[17]WangNing,Song Yibing,Ma Chao,etal.Unsupervised Deep Tracking[C]//IEEE Conference onComputer Vision and PatternRecognition,2019:1308-1317.

[18]Valmadre Jack,Bertinetto Luca,Henriques Joao,et al.End-to-endrepresentationlearning for Correlation Filter based tracking[C]//IEEEConference on Computer Vision and Pattern Recognition,2017:2805-2813.

本发明实施例对各器件的型号除做特殊说明的以外,其他器件的型号不做限制,只要能完成上述功能的器件均可。

本领域技术人员可以理解附图只是一个优选实施例的示意图,上述本发明实施例序号仅仅为了描述,不代表实施例的优劣。

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

- 一种基于动态记忆库模板更新的目标跟踪方法

- 一种基于目标模板更新的目标跟踪方法