一种基于神经网络的译码器

文献发布时间:2023-06-19 11:27:38

技术领域

本发明涉及通信工程技术领域,特别是涉及一种基于神经网络的译码器。

背景技术

人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connection Model),它是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。递归神经网络(RNN)是一类神经网络,其中节点之间的连接沿时间序列形成有向图。这使其具有时间动态行为。RNN源自前馈神经网络,可以使用其内部状态(内存)来处理可变长度的输入序列。这使它们适用于诸如未分段的,已连接的手写识别或语音识别之类的任务。“递归神经网络”被不加区分地用于指代具有相似一般结构的两大类网络,其中一类是有限冲量,另一类是无限冲量。这两类网络都表现出时间动态行为。有限脉冲递归网络是有向无环图,可以展开并用严格的前馈神经网络代替,而无限脉冲递归网络是不能展开的有向环图。有限脉冲和无限脉冲递归网络都可以具有其他存储状态,并且该存储可以在神经网络的直接控制下。如果包含时间延迟或具有反馈回路,则存储也可以由另一个网络或图形代替。这种受控状态称为门控状态或门控存储器,并且是长短期存储网络(LSTM)和门控循环单元(GRU)的一部分。

长短期记忆(LSTM)是在深度学习领域中使用的人工循环神经网络(RNN)架构。与标准前馈神经网络不同,LSTM具有反馈连接。它不仅可以处理单个数据点(例如图像),而且可以处理整个数据序列(例如语音或视频)。例如,LSTM适用于诸如网络通信或IDS(入侵检测系统)中的未分段,连接的手写识别,语音识别和异常检测之类的任务。常见的LSTM单元由单元,输入门,输出门和忘记门组成。单元会记住任意时间间隔内的值,并且三个门控制着进出单元的信息流。LSTM网络非常适合基于时间序列数据进行分类,处理和做出预测,因为时间序列中重要事件之间可能存在未知持续时间的滞后。开发LSTM是为了解决训练传统RNN时可能遇到的梯度消失问题。对间隙长度的相对不敏感是LSTM优于RNN,隐马尔可夫模型和其他序列学习方法的众多应用的优势。与普通循环单元相比,LSTM单元的优势在于其单元存储单元。单元向量具有封装忘记其先前存储的存储器的一部分的概念以及添加部分新信息的能力。为了说明这一点,必须检查单元的方程式及其在引擎盖下处理序列的方式。门控递归单元(GRU)是递归神经网络的门控机制,由Kyunghyun Cho等人在2014年提出。GRU就像带有遗忘门的长短期记忆(LSTM),但由于缺少输出门,因此参数比LSTM少。因此,采用GRU有较高的效率。

在计算机,电信,信息理论和编码理论中,纠错码(ECC,error correction/correcting code)是信息传输中错误检测与纠正的工具。它通常用在不可靠或嘈杂的信道中。Turbo码是一类高性能前向纠错(FEC)码,于1990-91年左右开发,但于1993年首次发布。它们是最早接近最大信道的实用代码。容量或香农极限,即在特定噪声水平下仍可进行可靠通信的编码率的理论最大值。Turbo码用于3G/4G移动通信(例如UMTS和LTE中)和(深空)卫星通信中,以及其他应用中,设计人员寻求在带宽或等待时间受限的通信链路中实现可靠的信息传输。存在数据损坏的噪声。Turbo码与LDPC码(“低密度奇偶校验”)竞争,后者提供类似的性能。常用的Turbo码本身具有效率较低的缺点。

发明内容

本发明所要解决的技术问题是提供一种基于神经网络的译码器,可以改善译码的繁琐过程,能够有效提高信息传输效率。

本发明解决其技术问题所采用的技术方案是:提供一种基于神经网络的译码器,包括第一子神经网络模块、第二子神经网络模块和第三子神经网络模块;所述第一子神经网络模块和第二子神经网络模块均用于消除上一时刻所述译码器输出的序列中的无效信息,得到上一时刻所述译码器输出的序列中的有效信息;所述第三子神经网络模块用于决定上一时刻所述译码器输出的序列中的有效信息的保留部分。

所述第一子神经网络模块的输入端接收上一时刻所述译码器输出的序列和输入层接收到的待译码序列,输出端通过一个乘法器与上一时刻所述译码器输出的序列相乘后输入至所述第三神经网络模块。

所述第一子神经网络模块为采用Sigmoid激活函数的全连接层。

所述第二子神经网络模块的输入端接收上一时刻所述译码器输出的序列和输入层接收到的待译码序列,输出端分为两路,第一路通过一个减法器后再通过一个乘法器与上一时刻所述译码器输出的序列相乘,第二路与所述第三子神经网络模块的输出相乘。

所述第二子神经网络模块为采用Sigmoid激活函数的全连接层。

所述第三子神经网络模块的输入端接收所述第一子神经网络模块输出与上一时刻所述译码器输出的序列相乘后的结果和输入层接收到的待译码序列,输出端与所述第二子神经网络模块的输出相乘后,再与所述第二子神经网络模块的输出端的经过第一路后得到的结果相加。

所述第三子神经网络模块为采用tanh激活函数的全连接层。

有益效果

由于采用了上述的技术方案,本发明与现有技术相比,具有以下的优点和积极效果:本发明能够降低译码器计算的复杂度,降低通信系统功耗,提高译码正确率,为移动终端和基站等通信设备的编译码过程提供了新的解决方案。

附图说明

图1是通信系统的数学模型图;

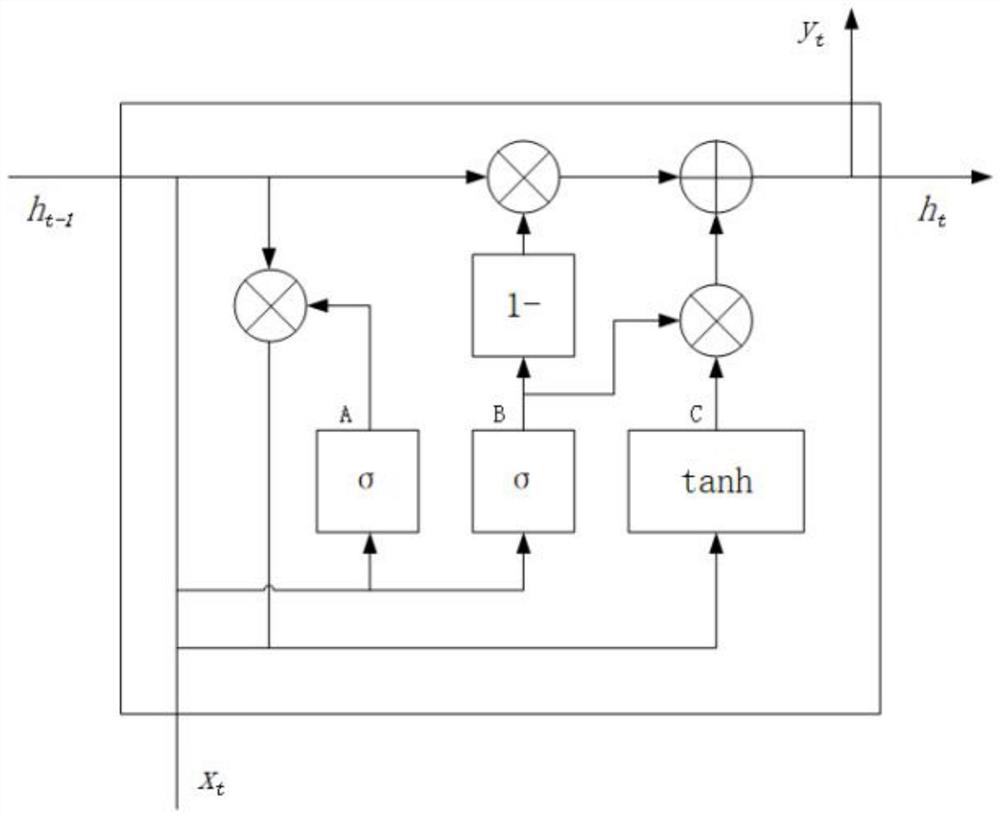

图2是本发明实施方式中的循环神经网络的示意图;

图3是本发明实施方式的译码器结构示意图;

图4是本发明实施方式的译码器的训练示意图;

图5是应用本发明实施方式的译码系统的结构示意图。

具体实施方式

下面结合具体实施例,进一步阐述本发明。应理解,这些实施例仅用于说明本发明而不用于限制本发明的范围。此外应理解,在阅读了本发明讲授的内容之后,本领域技术人员可以对本发明作各种改动或修改,这些等价形式同样落于本申请所附权利要求书所限定的范围。

本发明的实施方式涉及一种基于神经网络的译码器,该译码器能够使用在5G、4GLTE、WCDMA、CDMA20001x、WiFi、WiMax、蓝牙、ZigBee等通信技术中。

对于一个通信系统而言,假设长度为n发送端消息M为:

首先通过编码器生成长度为l位的编码序列X

本发明实施方式采用神经网络与传统通信系统相结合,采用基于神经网络的译码器,包括第一子神经网络模块、第二子神经网络模块和第三子神经网络模块;所述第一子神经网络模块和第二子神经网络模块均用于消除上一时刻所述译码器输出的序列中的无效信息,得到上一时刻所述译码器输出的序列中的有效信息;所述第三子神经网络模块用于决定上一时刻所述译码器输出的序列中的有效信息的保留部分。

本发明实施方式中以循环神经网络为例,然而在实际的使用过程中,具体使用的神经网络可以包括但不限于以下几种神经网络的任何一种人工神经网络:卷积神经网络、循环神经网络、深度神经网络、图神经网络。

循环神经网络,除去传统神经网络的输入层、输出层和隐藏层,各隐藏层节点之间的连接沿时间序列形成有向图。这使其具有时间动态行为,如图2所示。RNN源自前馈神经网络,可以使用其内部状态(内存)来处理可变长度的输入序列。这使它们适用于诸如未分段的,已连接的手写识别或语音识别之类的任务。因此,循环神经网络尤其适合处理消息信息。

本实施方式以门控循环单元(GRU)为例实现传统通信系统中的译码功能,如图3所示。其中,所述第一子神经网络模块A的输入端接收上一时刻所述译码器输出的序列和输入层接收到的待译码序列,输出端通过一个乘法器与上一时刻所述译码器输出的序列相乘后输入至所述第三神经网络模块C。所述第二子神经网络模块B的输入端接收上一时刻所述译码器输出的序列和输入层接收到的待译码序列,输出端分为两路,第一路通过一个减法器后再通过一个乘法器与上一时刻所述译码器输出的序列相乘,第二路与所述第三子神经网络模块C的输出相乘。所述第三子神经网络模块C的输入端接收所述第一子神经网络模块A输出与上一时刻所述译码器输出的序列相乘后的结果和输入层接收到的待译码序列,输出端与所述第二子神经网络模块B的输出相乘后,再与所述第二子神经网络模块B的输出端的经过第一路后得到的结果相加。

如图3所示,将来自于上一个时刻t-1的译码器的输出h

相似的,第二子神经网络B同样以输入h

然后,第三子神经网络模块C以译码器收到的待译码序列的输入x

由上可知,该译码器的输入变量(即接收到的待译码序列)为x

该译码器构成了图2中的循环卷积网络,用于对传统译码方法的机器学习。梯度下降是用于找到函数最小值的一阶迭代优化算法。在神经网络中,如果非线性激活函数是可微分的,则可以通过按误差相对于该权重的导数成比例地更改每个权重,来最小化误差项。通过使用神经网络配合传统的通信系统,能够降低计算复杂度,并能够有效改善通信的质量和效率,同时降低对通信系统的硬件配置要求。

如图4所示,该译码器可以通过将传统通信系统中的接收序列Y

如图5所示,基于神经网络的译码系统可以通过用户后续比较分析传统译码器和本实施方式的神经网络译码器的区别,而选择性输出理想的结果。在实际使用过程中,传统译码器和本实施方式的神经网络译码器同时进行译码。

- 一种基于神经网络的译码器

- 一种基于BP神经网络的钻速预测方法和基于BP神经网络以及粒子群算法的钻速优化方法