与使能音频/视频硬件相连使用的人工智能机械系统

文献发布时间:2023-06-19 18:32:25

相关申请的交叉引用

本申请要求2020年3月26日提交的美国临时申请第63/000,429号的优先权,并通过引用将其全部内容并入。

技术领域

本发明涉及利用人工智能机械臂通过视频屏幕增强用户体验。

背景技术

对于设备支托物和移动,现有技术的系统通常利用以下两种方法之一。第一种是使用预编程的机械臂设备。这种设备可以参考在一段时间旋转360度的三脚架上的视频相机。该设备具有被预编程为以固定的速度和速率进行旋转的能力。该设备不具有通过音频反馈跟随用户的能力。

第二种方法是当用户在(诸如在固定的安全相机上的)视频帧中移动进出时跟随他们。该设备可以被称为安全相机,该安全相机在用户走进或走出画面帧时跟随他们。该设备被编程为在人走动或跑动时检测其运动,然后具有在用户来回移动时跟随其运动的能力。该设备也不具有基于音频反馈而跟随用户的能力。

发明内容

本发明创造通过利用人工智能经由听觉和视觉提醒(cue)来增强用户体验和控制机械臂(以下称为“臂”),提供了优于现有技术方法的优势。臂的人工智能使用音频和视频两者来帮助引导用户体验。这种增强对于智能视频而言是必不可少的,有助于弥合个人域与设备域之间的技术差距。个人域被定义为是用户亲自参与的类别或活动。这可能是烹饪、玩电子游戏,或者在学校教室里。由于该域发生在现实世界中,用户拥有自由意志和自由的运动范围来观看所有角度并完全沉浸在体验中。这种增强使用来自用户的音频和/或视觉提醒,并使得视频屏幕能够在用户移动的同时跟随用户。

随着技术和创新市场的不断增长,人工智能机械臂与全方位运动以及视频和音频提醒的结合极大地增强了所有现有技术的系统和方法。一种能学习、理解并能够提供即时用户反馈的人工智能机械臂正是这种机械臂有别于现有技术的地方。

为了克服现有技术的缺点并提供额外的优点,公开了一种人工智能机械设备。在一个实施例中,该设备包括扣夹,该扣夹被配置为支撑用户交互设备并且抵靠用户交互设备展开和收缩,使得用户交互设备可从扣夹中移除。用户交互设备被配置为接收来自用户的用户输入,以及使用在用户交互设备上操作的人工智能服务将用户输入转换为服务请求。可移动支架连接到扣夹,使得可移动支架具有一个或多个电机,该电机被配置为向可移动支架和用户交互设备传递运动。存储器被配置有非暂时性机器可执行代码,而处理器被配置为执行存储在存储器上的机器可执行代码。机器可执行代码被配置为经由通信链路接收服务请求、将服务请求转换为移动命令,以及使用所传递的运动来执行移动命令以满足服务请求。

在一个实施例中,扣夹安装在多关节机械臂上,该多关节机械臂被配置为沿着一个或多个不同的移动轴传递运动。用户交互设备可以包括智能手机、平板电脑、笔记本电脑、个人计算机或计算设备。还可以设想,该设备还可以包括接收第二用户输入的用户接口,并且该机器可执行代码还被配置为将第二用户输入转换为第二服务请求,以及将第二服务请求转换为移动命令。

在一个实施例中,人工智能服务包括图像建模、文本建模、预测、规划、做出推荐、执行搜索、将语音处理成服务请求、将音频处理成服务请求、将视频处理成服务请求、将图像处理成服务请求、面部识别、运动检测、运动跟踪、生成音频、生成文本、生成图像和生成视频中的一个或多个。用户输入可以是音频格式或视频格式。用户输入可以是经由用户交互设备的相机接收的视频格式,并且所传递的运动可以包括移动用户交互设备,使得当用户相对于相机进行移动时,用户交互设备的屏幕面向该用户。

还公开了一种使用人工智能控制用户交互设备的移动的方法。该方法可以包括接收来自用户的对用户交互设备的用户输入,使用人工智能服务将用户输入转换为服务请求,将服务请求转换为移动命令,以及执行移动命令来移动用户交互设备以满足服务请求。

执行移动命令以满足服务的步骤可以包括引起沿着至少第一移动轴和第二移动轴的移动。该方法还可以包括通过移动用户交互设备来执行移动命令,使得当用户相对于用户交互设备的相机移动时,用户交互设备的屏幕面向该用户。在一个实施例中,该方法还通过移动用户交互设备来执行移动命令,使得用户交互设备将用户的移动进行镜像。人工智能服务可以包括图像建模、文本建模、预测、规划、做出推荐、执行搜索、将语音处理成服务请求、将音频处理成服务请求、将视频处理成服务请求、将图像处理成服务请求、面部识别、运动检测、运动跟踪、生成音频、生成文本、生成图像和生成视频中的一个或多个。

本文还公开了一种人工智能机械控制设备,其用于与用户交互设备一起使用,包括用于在基座上支撑用户交互设备的可移动支架,使得基座具有一个或多个电机,该电机被配置为将运动传递给可移动支架和用户交互设备。该设备还包括被配置为接收来自用户的输入并向用户提供结果的用户接口,以及人工智能机械控制设备内的被配置有非暂时性机器可执行代码的存储器。人工智能机械控制设备内的处理器被配置为执行存储在存储器上的机器可执行代码,机器可执行代码被配置为将来自用户的输入转换为服务请求、将服务请求转换为移动命令,以及执行移动命令以使用一个或多个电机移动可移动支架从而满足服务请求。

在一个实施例中,该设备还包括被配置为支撑用户交互设备的扣夹,该扣夹被配置为抵靠用户交互设备展开和收缩,使得用户交互设备可从扣夹中移除。扣夹可以安装在多关节机械臂上,使得多关节机械臂能够沿着第一移动轴和第二移动轴运动。在一种配置中,可移动支架被配置为在两个不同的移动轴上移动用户交互设备。用户交互设备可以永久性连接到可移动支架。输入可以是音频格式或视频格式。在一个实施例中,输入是经由用户交互设备的相机接收的视频格式,并且在用户相对于相机移动时,该设备移动用户交互设备的屏幕以面向用户从而满足服务请求。

附图说明

附图中的组件不一定是按比例绘制的,而是强调说明本发明的原理。在附图中,在不同的视图中,相同的附图标记表示相应的部分。

图1示出了人工智能机械臂系统的附接机构。

图2示出了利用180度运动范围的人工智能机械臂系统的Y轴运动。

图3示出了利用180度运动范围的人工智能机械臂系统的X轴运动。

图4示出了利用360度运动范围的人工智能机械臂系统的X轴运动。

图5示出了人工智能机械臂系统的一个示例实施例的组件的框图。

图6示出了使用人工智能机械臂系统的示例环境。

图7示出了人工智能机械臂系统及其附接的用户交互设备的示例软件模块布局。

图8A示出了使用智能视频设备的示例的人工智能机械臂系统的单用户交互能力。

图8B示出了使用两个用户与智能视频设备交互的示例的人工智能机械臂系统的多用户交互能力。

图9示出了使用人工智能机械臂系统的示例方法的流程图。

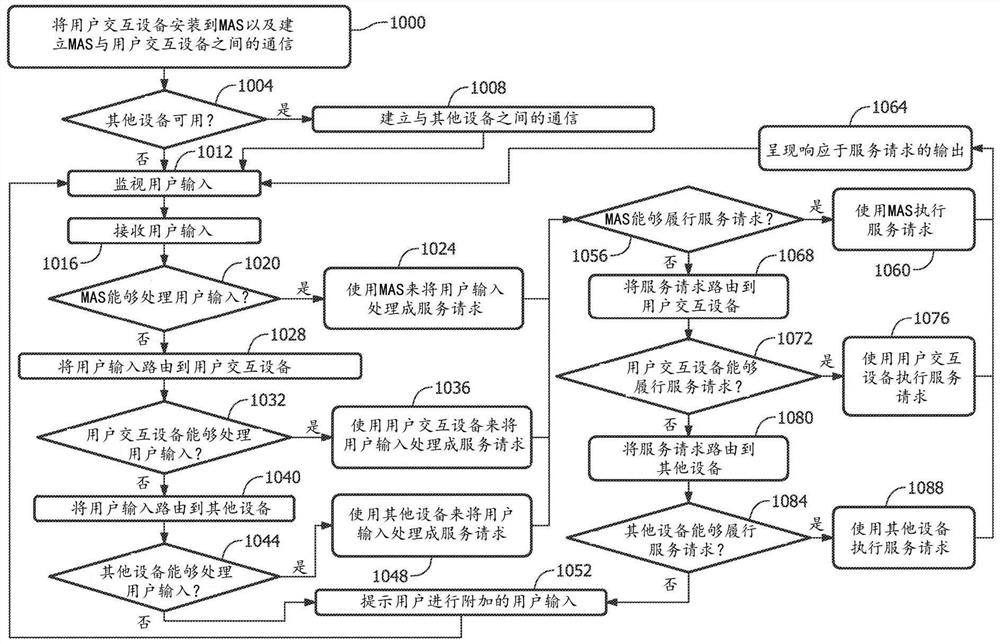

图10示出了人工智能机械臂系统、附接的用户交互设备以及其他设备或云程序或服务器之间的示例通信的流程图。

图11示出了示例性用户设备的框图。

图12示出了网络环境中的计算、移动设备或服务器的示例实施例。

具体实施方式

术语表

人工智能(“AI”)服务:使用人工智能处理和/或机器学习提供的服务,为现有系统提供附加和交互式的处理和功能。示例包括图像建模、文本建模、预测、规划、做出推荐、执行搜索、语音处理、音频处理、音频生成、文本生成、图像生成等等。

设备:至少是运行网络控制器和CPU的任何元素。可选地,加速器可以以GPU或其他专用硬件加速器的形式被附加。此加速器可以加快人工智能服务的计算速度。

用户交互设备:能够与用户进行交互的设备,诸如接收用户输入、处理用户输入和呈现响应于用户输入的输出,该输入包括文本输入、音频输入、图像输入、视频输入和任何数字格式的输入。用户交互设备可以是能够执行有限AI服务的设备,诸如可穿戴设备(智能手表、智能戒指、眼镜、助听器、耳塞、耳机等)、家庭设备(扬声器、安全相机、电视、投影屏幕监视器等)、车载(CarPlay)设备,或任何其他具有有限AI能力的设备(网络摄像头、回音壁等),或能够执行更鲁棒的AI服务的设备(诸如智能手机、平板电脑、个人计算机、笔记本电脑设备等)。更鲁棒的AI服务包括该有限AI服务(诸如也具有智能手表能力的智能手机)。

智能使能音频硬件(“智能音频设备”):包括声音或音频相关的硬件(诸如麦克风和扬声器)和智能音频虚拟助理的用户交互设备。智能音频虚拟助理具有AI能力,以促进音频相关的用户交互。音频相关的用户交互可以包括接受、处理用户的音频输入、触摸输入或被动交互(诸如但不限于通过监视用户放置、情感表达、移动、手势、面部特征和其他身体语言来被动监视用户输入)、和响应于其而呈现输出。机械臂系统(MAS)和智能音频虚拟助理可以经由诸如有线或无线的电子连接以及诸如蓝牙、网络、光通信、Wi-Fi、近场通信、蜂窝网络或任何有线协议的任何通信标准来彼此进行访问。

智能使能视频硬件(“智能视频设备”):包括智能视频虚拟助理上的图像或视频相关硬件(诸如相机和视频显示屏)的用户交互设备。智能视频虚拟助理具有AI能力,以促进视频相关的用户交互。视频相关的用户交互可以包括接受、处理用户的视觉或视频输入、和响应于其而呈现输出。MAS和智能音频虚拟助理可以经由电子连接来彼此进行访问。

域:用户在设备上正在使用的类别。例如,一个域可以是流式的,从而允许用户经由视频播放器屏幕观看电视节目。

AI应用模型:AI应用模型是指智能音频虚拟助理和智能视频虚拟助理中用以促进用户、智能音频设备、智能视频设备和MAS之间的直接通信的人工智能算法。模型是利用一个或多个函数来完成一个或多个任务的算法。AI应用模型可以是存储在存储器中的软件,使得该软件在处理器上执行,并且可以包括音频处理模型,诸如自动语音识别(“ASR”)模型和自然语言理解(“NLU”)模型,以及视频处理模型,诸如但不限于情绪检测、手势识别、身体跟踪、手跟踪、关键点监控和凝视跟踪。例如,如果用户说“请让屏幕面向我”,则智能音频AI应用模型可以利用用户音频处理来将音频命令(“请让屏幕面向我”)转换为MAS可以执行的文本命令。则智能视频AI应用模型可以利用用户视频处理来处理来自用户的视频输入。例如,用户交互设备的相机可以使用面部检测模型来定位用户的面部。该定位可以作为命令被发送,MAS将使用该命令将屏幕朝向用户旋转。

设备音频反馈:从用户交互设备到用户的、对用户请求予以确认的音频响应。例如,响应于用户命令“请让屏幕面向我”,用户交互设备可以说“知道了。我会旋转屏幕,让它面向你”。

设备视频反馈:视频屏幕显示或使用面部识别模型(在处理器上执行的软件)来定位和/或识别用户的面部。这可以用环绕用户面部的绿色圆圈来表示。这是设备传送请求已被听到并正在处理的一种方式。

设备域:用户通过用户交互设备执行的类别或活动,诸如观看烹饪视频或虚拟教室讲座。用户的观看体验受限于“教师”正在使用的视频流设备或呈现的视频的运动范围。教师被定义为正在呈现信息的用户。

机械臂系统(“MAS”):一种AI设备,包括具有在一个或多个轴上旋转能力的机械系统,其与智能音频设备和/或智能视频设备(诸如用户交互设备)结合使用。MAS可以在X轴上旋转,诸如在一个实施例中,旋转360度。MAS也可以在Y轴或Z轴上旋转。MAS可以包括或不包括臂,使得MAS可以包括在一个或多个旋转或移动轴上可移动的臂,或者MAS可以是用于用户交互设备的槽或支架,或者是到用户交互设备的永久(集成)连接。

本发明的其他系统、方法、特征和优点对于本领域技术人员来说,在研究了以下附图和详细描述后将会是或将会变得显而易见。所有这些附加的系统、方法、特征和优点都包含在本说明书中,包含在本发明的范围内,并且受到所附权利要求的保护。

MAS可以通过音频和视觉提醒与用户进行交互。智能音频设备和/或智能视频设备可以通过它们各自的AI应用模型来促进这种通信。AI应用模型可以处理输入到智能音频设备和/或智能视频设备的所有用户音频和/或视频输入,以及来自智能音频设备和/或智能视频设备的所有音频和/或输入。

在一个示例操作方法中,用户可以对用户交互设备(其可以是智能音频设备或智能视频设备)说“向右移动屏幕”。如上所述,智能视频设备可以包括智能音频硬件(诸如扬声器和麦克风)和智能音频AI应用模块。智能音频AI应用模型可以接收和处理音频输入,诸如通过使用自然语言理解模型(诸如下所述)来生成音频输入的数字数据表示,以及使用该数字数据表示来创建音频服务请求。

智能音频AI应用模型可以将音频服务请求传达给用户交互设备和MAS,或者直接传达给MAS。服务请求是一种动作命令,促使软件响应于该动作命令执行一个功能或一组功能,以便履行该服务请求。在该示例中,智能音频AI应用模块可以使用音频服务请求来使用户交互设备通过使用用户交互设备的扬声器输出音频反馈“好的,将会向右转动屏幕”来确认用户输入。智能视频AI应用模块可以通过以下方式来同时执行或随后执行音频服务请求:(1)使用视频硬件命令来使用户接口用户交互设备的相机定位用户的面部或身体,以向臂提供精确的旋转角度移动,以及(2)使用移动命令来使用户交互设备旋转,使得用户接口设备的屏幕移向右边,使得其面向右边的用户。在相机与软件之间可以有实时反馈,以实现正确的旋转量。该处理可以直接在包括智能音频AI应用模块和/或智能视频AI应用模块的用户交互设备上完成,或者使用MAS中内置的功能来完成。臂与计算之间的通信可以使用任何手段进行,诸如有线或无线,并且可以使用任何通信标准,诸如蓝牙、WIFI、近场通信或任何有线协议。

MAS可以与用户交互设备(诸如智能音频AI应用模块和/或智能视频AI应用模块)进行通信或连接。在一个实施例中,该连接包括将用户交互设备连接到MAS的有线连接,使得MAS可以访问用户交互设备中的音频和/或视频硬件。在一个实施例中,MAS可以具有其自己的智能音频设备。在一个实施例中,MAS的基座可以包括智能音频硬件和智能音频AI应用模块。在一个实施例中,MAS不包括内置智能音频设备。在该实施例中,MAS可以使用连接到该MAS的用户接口设备上的硬件和/或软件,诸如音频和视频硬件。

用户输入可以传送通过一个或多个输入处理模型(诸如ASR和/或NLU模型来处理音频输入)。输入处理模型可以由用户交互设备或MAS中的智能音频AI应用模型和/或智能视频AI应用模型来提供。输入处理模型可以将用户输入转换为服务请求。例如,音频处理模型可以将用户的音频输入转换为音频文件,然后该音频文件被处理成带有服务请求的文本文件的输出。

AI应用模型可以使用以下两种类型的音频提醒:用户音频提醒和设备音频提醒。用户音频提醒被定义为从用户说出的话语。例如,基于用户需要以不同的角度观看屏幕,用户可以说“将屏幕转向我的左边”作为动作命令。设备音频提醒被定义为从智能音频设备说出的话语。例如,在包括智能音频AI应用模块的用户交互设备检测到用户移动到房间的另一侧或移动到一侧或另一侧时,用户交互设备可以对用户说“你想要我旋转屏幕来使你能看得更清楚吗?”。

AI应用模块可以使用多种类型的视觉提醒。AI应用模型可以使用的两种示例性类型的视觉提醒包括用户生成的视频和设备生成的视频。用户生成的视频是正在使用用户交互设备的用户的实时流。设备生成的视频是与正在使用的域相关的视频流,即,正在用户设备上显示的视频。该视频流可以是与一个域相关的可编程视频,也可以是实况流视频。可编程视频的一个示例是电视节目或电影。视频聊天就是直播视频的一个示例。

在这里描述的实施例中,MAS具有以下列方式与用户交互的能力:(1)模仿,(2)用户视频检测,(3)用户音频检测,以及(4)多用户跟踪。

模仿是指MAS对用户的移动或手势进行模仿或做出反应的能力。例如,如果用户正在用户交互设备上观看具有赛车场景的电影,则用户可以模仿汽车在转弯时的运动或对其做出反应。MAS继而可以倾斜或旋转用户交互设备上的视频显示设备来模仿用户的运动。这种模仿是通过智能视频设备上的AI应用模型来实现的,使用户交互设备上的相机检测用户的运动,处理用户的运动以生成对MAS的服务请求,使MAS通过执行期望的移动来履行服务请求。在另一个示例中,如果用户将他们的头倾斜到一侧,屏幕也可以倾斜到该侧,从而保持理想的眼睛与屏幕的对准。

模仿可以涉及对人工智能应用模型的训练。可以用一组数据(例如用于单词检测的音频文件)来“训练”一个模型,然后作为训练过程的一部分随时间更新以改进该模型。AI模型可以复制决策过程来实现对用户请求的自动化和理解。AI和机器学习模型是使用用户输入、设备输入以及先前数据来实现训练的算法,该训练使用数据和人类专家输入来复制专家或用户在提供相同信息时会做出的决策。在上述用例中,可以在流式电影和电视节目上训练AI应用模型。训练数据可以包括用户观看电影和模仿屏幕上显示的场景的两种视频以及来自电影或节目中的实际场景。

第二种用户交互方式是用户视频检测,这是指MAS实时检测用户运动的能力。可以用被配置为正确标记、跟踪和跟随用户的软件来启用运动检测。术语“标记”指的是软件识别用户脸部、手臂、颈部、胸部和其他身体部位的能力。术语“跟踪”指的是软件记住被标记的身体部位的能力。术语“跟随”是指软件使用跟踪来实时跟随运动的能力。在模仿的情况下,用户可以使用音频提醒来命令机械臂执行任务或改变系统的模仿状态。例如,用户可以说“停止模仿我的动作”,并且MAS将通过NLU模型处理音频来执行命令。用户也可以说“跟踪我的手而不是脸”,并且MAS将跟踪用户的手。

运动检测对于连接到MAS的用户交互设备上的视频显示设备总是面向用户的方向是有用的。这允许用户使屏幕面向用户,因此用户可以在任何时候都能最好地看到视频屏幕(诸如在某个区域移动、烹饪、在视频聊天或演示期间,或者跟随家庭成员)。AI应用模型可以包括用于跟随用户移动的视频检测对准处理。AI应用模型也可以被训练用于运动检测。用户的最佳观看体验可以是将用户的瞳孔或脸直接对准用户交互设备的视频显示设备的中心的屏幕角度。

用户交互的第三种方式是用户音频检测,它是指用户说出的音频作为告诉用户交互设备要做什么的音频命令。例如,用户可以说“向左转动屏幕”,并且屏幕就会稍向左转动。以下是可以执行的示例性命令的片段,尽管其他命令也是可能的和预期的:

“向左转动屏幕”

“向右转动屏幕”

“跟随我的运动”

“停止跟随我”

“向上倾斜屏幕”

“向下倾斜屏幕”

“将屏幕以180度角放置”

“让屏幕与地面平行”

“让屏幕以稳定的速度前后左右旋转”

“让屏幕跟踪我面部的运动”

“让屏幕跟踪我胸部的运动”

“将屏幕右侧向地面倾斜”

“将屏幕左侧向天空倾斜”

“让屏幕旋转360度”

音频提醒和视频提醒与全方位运动MAS的组合极大地改善了用户体验。用户不再需要为了最佳体验而移动或调整用户交互设备,因为AI应用模型控制MAS来为用户将用户交互设备移动到定向或最佳位置。

第四种用户交互方式是多用户跟踪,这是指MAS单次跟踪两个或更多用户的能力。用户视频检测具有单次标记、跟踪和跟随多个用户的能力。例如,如果有两个用户,但是只有一个在移动,则MAS可以跟随移动中的用户的移动。用户能够将多用户跟踪与音频提醒相结合。例如,用户可以说“改为跟随约翰”,并且臂现在将跟踪约翰的运动。

图1示出了MAS与智能音频设备(诸如智能扬声器)和/或智能视频设备(诸如带屏幕的智能手机)的连接机制。在图1的示例性实施例中,MAS100包括三关节铰接颈部104。颈部104的一端连接到用户设备扣夹108,另一端连接到内置智能扬声器112。用户设备扣夹108用于将任何用户接口设备116保持在适当的位置。如果用户接口设备116是智能视频设备,则扣夹可以使得用户接口设备116的视频输出设备面向用户。

颈部104上的关节可以允许在X轴和Y轴上运动,并且颈部104到智能扬声器113的连接部分可以允许360度的圆形旋转。在其他实施例中,可以使用能够如本文所述起作用的任何其他类型的机械臂设备。例如,该臂可以由固定的扣夹代替,该扣夹将该设备保持在静止位置,该静止位置能够进行360度的旋转或者能够仅沿着两个轴移动。此外,代替扣夹,用户设备可以放置在槽或支架中。

在图1所示的示例中,智能音频设备包括智能扬声器112,该智能扬声器112包括促进音频相关的用户交互所必需的硬件(诸如检测用户音频输入的麦克风和输出声音的扬声器)和处理用户交互的智能音频AI应用模型,如上所述。在其他实施例中,MAS可以使用不包括内置智能扬声器的配重基座。MAS可以使用连接的用户交互设备116上或MAS可以远程访问的其他设备(下面将更详细地讨论)上的智能音频硬件和智能音频AI应用模块。

图2示出了MAS的Y轴运动,利用180度的拱形运动的运动范围,允许视频播放器设备使屏幕指向上或下。在其他实施例中,可以实现除180度之外的角运动。在其默认位置200,MAS允许用户交互设备的视频显示设备(诸如智能手机上的屏幕)面向用户。位置204示出了视频显示设备从开始位置以90度角朝上。这个位置对于站着向下看的用户或者独自或与他人一起玩游戏的用户可能是有用的。位置208示出了视频显示设备从开始位置以90度角面向下。这个位置对于希望使用用户交互设备来扫描文档或拍摄桌子上的东西的用户可能是有用的。这使得屏幕在各种不同的角度都是可见的。在一个实施例中,Y轴移动可以是从0到360范围内的任何角度。

图3示出了MAS的X轴运动,利用180度的拱形运动的运动范围。在其他实施例中,可以提供不同于180度的运动范围。拱形运动的范围从视频显示设备垂直放置在MAS的一侧(诸如位置300所示),到视频显示设备放置在MAS的顶部(诸如位置304所示),到视频显示设备垂直放置在MAS的另一侧(诸如位置308所示)。这使得视频播放器屏幕可以倾斜到最面向或匹配用户的角度。例如,180度角垂直对准300、308对于特定的用户体验可能是最佳的,而水平对准304对于不同的用户或使用可能是最佳的。当用户从一边到另一边移动他们的身体或头部以使视频显示设备与用户对准,例如通常与用户的眼睛对准时,该功能也是有用的。这意味着用户的眼睛对准可能处于不同的角度。MAS可以对用户的新姿势位置做出反应,并在代表用户当前版本的重心中心或眼睛对准的位置向用户显示视频播放器屏幕。这里公开的机械臂(KaiBot)允许这种范围的运动和自由度。在一个实施例中,拱形运动的范围可以是从0到360的任何角度。

图4示出了MAS机械臂在X轴上的运动范围。在该实施例中,X轴可以绕颈部的基座移动或旋转360度。旋转可以以任何方式发生,诸如通过旋转臂、基座或这两者的组合。X轴移动允许用户使用音频提醒来命令MAS,以告诉设备“将所连接的用户交互设备转圈旋转”或者旋转到特定位置或用于用户跟踪。X轴移动对准并显示优化的观看体验,允许MAS根据用户相对于视频显示设备的位置来指向或指引视频显示设备(诸如智能手机上的屏幕)。在一个实施例中,X轴运动的范围可以是从0到360范围内的任何角度。

图5示出了MAS的一个示例实施例的组件的框图。在其他实施例中,其他配置和元件是可能的。用户交互设备504可以通过机械链接508链接到MAS 512,机械链接508可以是MAS 512的一部分。机械链接可以是任何类型的机械链接,诸如将屏幕连接到基座以形成一体设备的扣夹、支架、托盘或永久连接(塑料)。如本文所述,用户交互设备504可以是智能手机、平板电脑、智能屏幕、屏幕或任何其他用户交互设备,其可以安装到机械链接508或永久性固定到基座。

在该实施例中,MAS 512可以包括一个或多个电机和其他移动元件,其控制机械链接508的移动和旋转或者MAS本身的运动。监督MAS 512的操作的可以是处理器520,其被配置为执行机器可执行指令或以其他方式监督和控制MAS的操作。处理器520与存储器524进行通信。存储器524可以是能够存储数据和/或机器可执行指令的任何类型的存储器。存储器524可以存储或配置有被配置为在处理器520上执行的机器可读代码(软件)。该实施例中还包括通信模块,该通信模块被配置为与用户交互设备504进行通信和/或通过网络(诸如局域网或互联网)进行通信来访问远程定位的计算机或服务器。通信模块可以利用任何类型的通信,包括有线或无线链路。

一个或多个传感器536可以是该实施例的一部分,以向MAS 512提供输入。传感器536可以包括但不限于相机、麦克风、振动传感器、加速度计、光探测器、温度计或任何其他类型的传感器。用户接口540可以包括一个或多个按钮、开关、触摸屏、显示器、轨迹球、控制杆或滚轮,以允许用户向机械臂系统502提供输入。还可以包括电源544,其被配置为向MAS502的各种元件供电。电源544可以从电池、太阳能或有线连接获得电力。

在一个实施例中,MAS 512还可以包括内置的用户输入设备548和输出设备552。例如,MAS可以具有内置的智能音频设备,其可以包括麦克风形式的用户输入设备548和扬声器形式的输出设备548。MAS还可以包括一个或多个相机。

图6示出了使用MAS的示例环境。这只是一种可能的使用和系统环境。可以设想,在阅读了下面结合附图提供的说明书之后,本领域普通技术人员可以得到在不同环境下的使用和配置。在图6中,MAS 600被连接到用户交互设备604或者被配置有用户交互设备604,用户交互设备604可以访问通信网络608。网络608可以是广域网(WAN)、局域网(LAN)、个人区域网(PAN)、Wi-Fi网络、蓝牙网络、云网络或由一个或多个通信连接组成的任何类型的网络。网络608也可以被云程序612和/或其他设备616访问。云程序612可以包括任何操作系统、用户接口应用、数据库或存储在云中或远程基于云的服务器中的任何其他非暂时性机器可执行代码。其他设备616又可以连接到设备特定的数据库620。安装在其他设备616上的用户交互应用程序也可以连接到它们的应用程序专用数据库。

如上所述,用户交互设备604便于MAS 600与用户的交互。用户交互设备604进而可以访问和使用来自网络608上的云程序(软件、硬件或这两者)612和其他设备616的资源,以进一步促进该交互。例如,MAS 600可以是没有内置智能音频AI应用模块的实施例,而用户交互设备604可以是具有有限AI能力的设备(诸如没有音频处理模块的智能手表)。因此,用户对MAS600或用户交互设备604的音频输入(诸如语音命令)可以通过网络608被路由到云程序612上的音频处理模块(诸如基于云的ASR模块)或另一设备616(诸如具有语音识别能力的智能手机)。

图7示出了MAS及其附接的用户交互设备的示例软件模块布局。这仅仅是一种可能的布局,并且可以设想,在阅读了下面结合附图提供的说明书之后,本领域普通技术人员可以得到不同的软件模块布局。

在图7中,用户交互设备700连接到MAS 704。用户交互设备700包括处理音频输入和输出的音频处理模块708、处理视频输入和输出的视频处理模块712、便于用户与MAS 704交互的设备AI应用模型716、以及便于用户交互设备700与MAS 704之间通信的第一通信模块720。MAS包括第二通信模块724和MAS AI应用模型728。

在图7中,用户交互设备700具有强大的AI能力(诸如智能手机或平板电脑)。因此,设备AI应用模型716可以是智能视频AI应用模型,并且可以以音频格式和视频格式促进用户与MAS的交互。如上所述,用户交互设备700也可以是具有有限AI能力的设备(诸如智能手表),并且其设备AI应用模型716可以是智能音频AI应用模型,其可以仅以音频格式促进用户与MAS704的交互。设想用户交互设备700(诸如平板计算设备)可以与MAS 704一起配置为单个单元,或者用户交互设备可以从MAS中移除。

第一通信模块720和第二通信模块724用于从用户交互设备700向MAS704发送信息,反之亦然。在一个实施例中,通信模块720、724可以被构建到AI应用模型中(诸如被配置为包括第一通信模块720的设备AI应用模型716,以及被配置为包括第二通信模块724的MASAI应用模型728)。

当用户732经由用户输入发起交互时,用户与MAS 704的交互开始。例如,用户交互设备700上的音频输入设备(诸如麦克风)可以接收用户732的音频命令。如果用户输入仅需要音频处理(诸如音频命令“将我的电话移向左边”),则用户输入被发送到音频处理模块708。音频处理模块使用其音频输入处理模块736将用户输入转换为服务请求,然后通过第一通信模块720和第二通信模块724将该服务请求从设备AI应用模型716路由到MAS AI应用模型728。MAS AI应用模型728可以使MAS 704执行服务请求并输出期望的用户响应(诸如使所附接的用户交互设备700——在该示例中是用户的电话——向左移动)。设备AI应用716还可以使音频输出处理模块740生成设备音频反馈(诸如用户交互设备700输出语音响应“好的,向左移动”)。

如果用户输入是要求音频和视频处理的请求(诸如音频命令“跟随我”),除了如上所述与用户输入的音频部分交互之外,MAS还可以与用户的视频输入交互(诸如移动)。用户交互设备700上的视频输入设备(诸如相机)可以检测和捕捉用户的视频输入(诸如移动)。视频处理模块712可以使用其视频输入处理模块744来将捕获的视频输入(诸如视频记录)处理成服务请求(诸如模仿该运动)。服务请求可以通过第一通信模块720和第二通信模块724从设备AI应用模型716路由到MAS AI应用模型728。MAS AI应用模型728可以使MAS 704执行服务请求,并执行或输出期望的用户响应(诸如模仿用户的移动或任何其他功能)。设备AI应用716还可以使视频输出处理模块748生成设备视频反馈(诸如,用户交互设备700输出用户的捕捉视频的显示并且示出用户的质心的指示符,该指示符随着用户移动而移动)。

在图7中,MAS 704不包括内置智能音频设备(诸如图1所示),或者内置智能视频设备。因此,MAS AI应用模型728可能仅具有响应服务请求以输出期望的用户响应的能力(诸如模仿用户的移动或手势,或者实现移动)。在其他实施例中,MAS 704可以包括内置智能音频设备(诸如图1所示)。在该实施例中,MAS AI应用模型728能够使用其自己的智能音频设备来处理用户的音频输入。在一个实施例中,MAS 704包括被配置为单个单元的内置智能视频设备。在该实施例中,MAS AI应用模型728能够使用其自己的智能视频设备来处理用户的音频和视频输入。

图8A以智能视频设备为例说明了MAS的单用户交互能力。尽管未示出,MAS也可以使用智能音频设备执行单用户交互,其中用户输入可以限于音频相关的输入(诸如语音命令),并且用户输入处理可以限于音频处理。智能音频设备可以包括用户交互设备(永久性或可移除地附接到MAS),或者智能音频设备可以集成在MAS内。

在图8A中,当用户800发起交互时,单用户交互开始。然后用户输入经过AI应用模型804,该模型同时处理用户的音频输入808和视频输入812。经由一个或多个用户响应的输出来返回交互,用户响应可以包括设备音频反馈816、设备视频反馈820和/或MAS响应824。

使用前面的示例,用户800可以对MAS说“跟随我”。AI应用模型804可将音频输入(诸如用户的语音命令)808处理成MAS 824执行移动的服务请求,以及用户交互设备输出设备音频反馈816“好的,正在跟随你”的服务请求。同时,AI应用模型804可以通过对以视频文件形式的用户800的移动进行检测和捕捉,使用户交互设备生成用户800的视频输入。视频文件然后可以被处理812成MAS 824必须执行的移动是对用户800的移动的模仿(跟踪)的服务请求,以及用户交互设备输出视频文件和指示符的显示的设备视频反馈820的服务请求,该指示符指示MAS正在跟踪和模仿用户的移动而使MAS移动用户设备。

图8B使用两个用户与智能视频设备交互的示例来说明MAS的多用户交互能力。尽管未示出,MAS也可以使用智能音频设备执行多用户交互,并且可以与任意数量的用户进行交互。在一个实施例中,用户的最大数量可以基于开发者的选择、用户偏好或资源的限制(诸如设备能力、设备电池电量或可用的移动数据)来指定。

在图8B中,当第一用户828或第二用户832任一者发起交互时,多用户交互开始。根据用户请求,一个或两个用户828、832的输入经过AI应用模型836,AI应用模型836同时处理一个或两个用户的音频和视频输入840、844,并生成服务请求(诸如模仿、跟踪或以其他方式与一个用户的移动交互)。AI应用模型可执行附加的音频和/或视频处理以识别附加的用户输入848、852,这可能是执行服务请求所必需的(诸如确定要模仿两个用户828、832中的哪一个)。在成功识别(诸如将第一用户828确定为要模仿的用户)并处理(诸如捕捉第一用户828的移动)附加的用户输入后,AI应用模型然后可以生成完整的服务请求,并使MAS输出期望的响应856(诸如模仿或跟踪第一用户828的移动,而不是第二用户)。虽然在图8B中未示出,但是代替MAS输出856或者除了MAS输出856之外,AI应用模型还生成针对设备音频反馈和/或设备视频反馈的附加服务请求。

例如,第一用户828和第二用户832可以都在由MAS保持的用户交互设备的视频屏幕上的视频帧中。当第一用户828正在玩视频游戏,而第二用户832正在观看第一用户828的屏幕时,可能会出现这种使用情况。

AI应用模型836初始可能不知道该用户可能是第一(主要)用户828,直到主要用户在玩游戏时说“跟随我的移动”。AI应用模型836可以处理音频命令以生成服务请求,该服务请求要求MAS执行移动以模仿(跟踪)主用户来保持屏幕面向主用户。

通过图像或视频捕捉和处理(图像处理可以由视频处理模块或其一部分来执行)840、844,AI应用模型836可以识别视频文件中的两个用户。AI应用模型836然后可以同时为两个用户执行音频和视频识别848、852,因为AI应用模型836不知道哪个用户说出了语音命令或发起了请求。

在对第一用户848执行音频和视频识别后,AI应用模型836可确定第一用户828当前在用户玩游戏时来回移动和/或第一用户828的嘴在检测到“跟随我的移动”的音频语音的同时也在动。任一个或两者确定可以指示应该跟随第一用户828。

同时,AI应用模型836可以对第二用户852执行音频和视频识别,以确定在检测到音频语音时第二用户832没有移动他的身体和/或他的嘴没有动。一个或两者确定可以指示不应该跟踪第二用户852。尽管在图8B中未示出,AI应用模型可能接收混淆或冲突的指示,并且可能使用第一轮识别仍然不能确定跟随哪个用户。AI应用模型可以执行识别或连续识别的多次迭代(诸如检测一个用户是否正在移动)以进行澄清。AI应用模型还可以提示音频输出来要求进行澄清(诸如“检测到两个用户,请指示跟随哪个用户”)。

在将第一用户828识别为要跟随的用户之后,AI应用模型836可以向MAS生成服务请求以跟随第一用户856。

图9示出了使用MAS的示例方法的流程图。图9的流程图示出了用户、MAS和其他元件(诸如附接的用户接口设备和/或其他设备或云程序或服务器)之间的通信,其中智能音频设备被内置于MAS中。其他操作方法和从该示例性方法操作分支的操作是可能的和预期的。例如,在上面讨论的实施例中,MAS可以不具有内置的智能音频设备,而是可以使用连接的用户设备的音频相关硬件和智能音频AI应用模型(诸如附接到MAS的智能手机上的麦克风和音频处理模块)。在另一个实施例中,MAS可以具有内置的智能音频设备和内置的智能视频设备,并且这两个内置设备与所附接的用户交互设备协同工作,以接收和处理通信。在又一实施例中,MAS和用户设备被集成到单个独立的单元中。

在步骤904中,用户交互设备(诸如智能手机)被安装(或者已经安装/永久性安装)到MAS。建立用户交互设备与MAS之间的通信。通信可以通过蓝牙、WiFi、NFC或有线连接中的一个或多个来进行。在另一个实施例中,用户交互设备可能已经永久性附接/连接到MAS。用户交互设备和MAS还可以建立与存储在云中或基于云的服务器中的其他设备、远程服务器、软件或硬件的通信。例如,当iPhone被安装到MAS时,iPhone和/或MAS也可以与同一房间中的智能扬声器和智能电视进行通信,或者与存储在云中的iPhone用户的Apple帐户信息进行通信。

在步骤908中,在用户交互设备与MAS之间建立通信后,可以发起交互会话。在一个实施例中,交互式会话可以自动发起。在另一个实施例中,交互式会话可以由用户命令发起。在交互会话期间,MAS上的内置智能音频设备会监控用户输入。在一个实施例中,MAS上的任何输入设备、用户交互设备以及任何其他设备或云端都可以用于监视用户输入。

在步骤912,MAS可以接收来自用户的输入(诸如用于语音识别的语音命令)。在超过一个的输入设备监视用户输入的实施例中,诸如其他输入设备也可以接收来自用户的输入。在步骤916中,MAS内置智能音频设备中的智能音频AI应用模型可以处理音频输入以评估选项。这种处理可以包括使用音频处理模块将语音命令的音频文件转录成服务请求。在一个实施例中,MAS上的任何输入设备、用户交互设备以及任何其他设备或云端都可以接收用户输入,且任何设备上的任何AI应用模型都可以用于处理接收到的用户输入。

在步骤920,MAS确定如何最好地履行服务请求。如果MAS可以在本地履行服务请求(使用MAS中的资源),则它可以这样做。如果MAS需要来自远程服务器或来自用户交互设备的附加信息或能力,它可以将服务请求卸载到远程服务器或用户交互设备。卸载意味着将未履行的服务请求路由到另一个设备和/或应用来履行。例如,简单的语音命令“向左移动”可以提示MAS通过将其机械臂向左移动来做出响应。更复杂的语音命令“扫描这一页并为我找到这一页所出自的书”可以提示MAS:(1)使连接到MAS的智能电话移动到面朝下的位置,从而智能电话上的相机可以扫描该页或条形码,(2)使扫描的图像被发送到远程服务器中的搜索引擎以找到书,以及(3)使得所识别的书的PDF版本被发送到智能手机,以向用户进行显示或提供购买该书(或任何物品)的订购信息。

在步骤924中,MAS可以向用户交互设备传送指令以处理服务请求。在步骤928中,用户交互设备中的AI应用模型可以执行来自MAS的指令。即使是MAS能够在没有用户交互设备的情况下执行的简单语音命令(诸如“向左移动”),也仍然可以使MAS向用户交互设备传送指令,以提供设备音频反馈(诸如“好的,向左移动”)。如前所述,AI应用模型促进了MAS与用户应用设备之间的通信。使用简单的语音命令“向左移动”作为示例,MAS可以向AI应用模块发送用于设备音频反馈的简单指令。然后,AI应用模块与用户交互设备的音频输出模块进行通信,以准备并输出音频反馈“好的,向左移动”或返回给用户的问题(诸如“这样够远吗?”)。

如在步骤904中所指定的,当MAS和/或用户交互设备与其他设备和/或远程服务器建立通信时,AI应用模型可以在多个设备上运行和/或跨多个设备进行接口。例如,“给我放个电影,但是在我的智能扬声器上播放声音”的语音命令可以使AI应用在用户交互设备的显示设备上输出电影,并且同时通过智能扬声器输出电影的音频文件。单个AI应用模型(诸如用户交互设备中的AI应用模型)可以提示两者输出,或者可以使用多个AI应用模型(诸如MAS中的第一AI应用模型、用户交互设备中的第二AI应用模型,以及智能扬声器中的第三AI应用模型)来协调两个输出。

更复杂的语音命令可以使MAS向用户交互设备传送指令,以履行附加的服务请求。在步骤932中,MAS和用户交互设备可以通过一个或多个AI应用模型一起工作以实时执行服务请求。例如,用户请求“跟随我”可能要求用户交互设备AI应用模型激活用户交互设备的相机来记录和处理用户的运动。然后,AI应用模型可以使用运动检测和运动跟踪模块来识别用户的运动,并将该运动传送给MAS。MAS AI应用模型然后可以使其臂模仿用户的运动。在一个实施例中,MAS中的AI应用模型可以控制用户交互设备,并且用户交互设备中的AI应用模型可以控制MAS移动手臂以跟随用户。用户跟踪软件为本领域普通技术人员所知,因此不再详细描述。这种软件可从Vision4CE.com获得。在一个实施例中,单个AI应用模型(诸如存储在MAS、用户交互设备、任何其他设备或云中)可以控制MAS、用户交互设备和所有其他设备。

图10示出流程图,其示出MAS、附接的用户交互设备以及其他设备或云程序或服务器之间的通信,使得用户请求处理和服务请求履行都可以从一个设备卸载到另一个设备。其他操作方法和从该示例性方法操作分支的操作是可能的和预期的。

在步骤1000中,用户交互设备(诸如智能电话)被安装到MAS,或者它可以是MAS的整体连接部分。建立用户交互设备与MAS之间的通信。通信可以通过蓝牙、WIFI、NFC或有线连接中的一个或多个来进行。在另一个实施例中,用户交互设备可能已经永久性连接到MAS。在步骤1004中,MAS和/或附接的用户交互设备中的AI应用模型可以搜索其他设备以建立通信。其他设备可以是其他用户交互设备、远程服务器或者存储在云或基于云的服务器中的软件或硬件。例如,当iPhone安装到MAS时,智能手机和/或MAS也可以与同一房间中的智能扬声器通信,或者与存储在云中的iPhone用户的Apple帐户信息通信。如果发现其他设备,在步骤1008中,MAS和/或所附接的用户交互设备中的AI应用模型可以与这些其他设备建立通信。

一旦所有设备与MAS之间的通信被建立,在步骤1012中,MAS和/或所附接的用户交互设备中的AI应用模型可以发起交互会话并监视用户输入。

当在步骤1016中接收到用户输入时,MAS可以首先尝试在本地处理用户输入。换句话说,MAS可以尝试使用它自己的内置AI应用模型来处理用户输入。例如,如果用户输入是语音命令的形式,MAS可以在其自己的AI应用模型中寻找语音识别模块,以将语音命令转换为服务请求。如果MAS确定其可以在本地处理用户输入,则在步骤1024中,MAS可以在本地处理用户输入。

如果MAS不能在本地处理用户输入(诸如,在MAS没有其自己的AI应用模型或者没有内置的语音识别模块的情况下),在步骤1028中,MAS可以将用户输入卸载到附接的用户交互设备进行处理。在步骤1032中,附接的用户交互设备中的AI应用模型可以尝试在本地处理用户输入。在一个实施例中,MAS和附接的用户交互设备可以使用单个AI应用模型,该模型可以在MAS或用户交互设备中。如果附接的用户交互设备可以在本地处理用户输入,则在步骤1036中,在附接的用户交互设备中处理用户输入。使用上面的示例,在MAS没有用于处理语音命令的内置语音识别模块的情况下,用户输入可以被路由到所连接的iPhone,该iPhone可以尝试使用其语音识别功能来将语音命令处理成服务请求。

如果所附接的用户交互设备不能在本地处理用户输入,则在步骤1040中,用户输入被卸载到MAS和/或用户交互设备与之建立通信的任何其他设备。在步骤1044中,一个或多个其他设备然后可以确定它们是否能够在本地处理用户输入。如果其他设备可以在本地处理用户输入,则在步骤1048中,其他设备可以将用户输入处理成服务请求。

在一个实施例中,MAS、所附接的用户交互设备和其他设备中的一个或多个AI应用模型可以确定处理用户输入的最佳设备,而不是遍历将用户输入从MAS卸载到附接的用户交互设备然后卸载到其他设备的默认步骤。例如,当在步骤1016接收到音频命令时,一个或多个AI应用模型可以自动确定云中的语音识别模块可能最适合于处理该音频命令,并且用户输入被直接路由到云,如步骤1040所示,而无需首先通过步骤1020至1032。

另一方面,如果没有设备(附接的MAS、附接的用户输入设备和任何其他设备)可以处理用户请求,则在步骤1052中,可以提示用户进行澄清。例如,用户的原始语音命令可能是费解的语音或模糊的命令的形式。用户可能已经输入了“find Harry Potter”的音频命令,但是语音识别功能将该短语识别为“bind harri water”。MAS或附接的用户交互设备然后可以向用户输出提示,诸如“你刚是说‘find Harry Potter’吗?”或者“请重复你的命令”。MAS和所有其他设备然后可以返回到步骤1012,以响应于该提示而监视另一用户输入。

如果在任何时候用户输入被成功地处理成可执行的服务请求,在步骤1056,服务请求可以首先被路由到MAS,以确定MAS是否可以在本地履行用户输入。如果MAS确定其可以在本地履行服务请求,则在步骤1060中,MAS尝试在本地履行服务请求。例如,MAS可以通过命令机械臂向左移动,在本地完成对简单语音命令“将我的电话移向左边”的服务请求。在步骤1064中,被履行的服务请求的结果是响应于用户输入的给用户的输出。在上面的示例中,响应输出可以是机械臂向左移动。

如果MAS不能在本地履行用户输入(例如,如果语音命令是播放音频文件,并且MAS没有内置扬声器),则在步骤1068中,服务请求可以被卸载到附接的用户交互设备。在一些情况下,即使当MAS可以在本地完成服务请求时,其仍然可以将附加的服务请求路由到所连接的用户交互设备。使用上面的示例,在机械臂被命令向左移动的情况下,MAS也可以指示iPhone输出设备音频反馈“好的,正在向左移动”。然后,步骤1064中的响应输出可以是机械臂向左移动和设备音频反馈输出的组合。

在接收到卸载的或附加的服务请求后,在步骤1072中,附接的用户交互设备中的AI应用模型可以尝试在本地履行服务请求。如上所述,在一个实施例中,AI应用模型可以使用户交互设备尝试在本地履行服务请求。如果附接的用户交互设备可以在本地履行服务请求,则在步骤1076中,在附接的用户交互设备中履行服务请求。例如,语音命令可以是播放视频,而MAS可能没有内置的视频显示设备。连接的iPhone随后可以使用其视频显示设备。然后,步骤1064中的响应输出是iPhone播放所请求的视频。步骤1064的响应输出应该被认为是可选的。

如果所附接的用户交互设备不能在本地履行服务请求,则在步骤1080中,服务请求被卸载到MAS和/或用户交互设备与之建立通信的任何其他设备。在步骤1084中,其他设备中的AI应用模型然后可以确定其是否能够在本地履行用户输入。在一个实施例中,任何AI应用模型都可以使其他设备做出该确定。如果其他设备可以在本地履行用户输入,则在步骤1088,其他设备履行服务请求。例如,用户输入可以是“在我的智能电视上播放第一部哈利波特电影”的语音命令。虽然连接的iPhone可能将电影存储在本地,但它可能会将电影文件路由到连接的智能电视或将其流式传输到电视。步骤1064中的响应输出可以是在智能电视上显示第一部哈利波特电影。

在一个实施例中,MAS、附接的用户交互设备和其他设备中的一个或多个AI应用模型确定履行服务请求的最佳设备,而不是遍历将服务请求从MAS卸载到附接的用户交互设备然后卸载到其他设备的默认步骤。例如,当在步骤1024、4036或1048接收到在智能电视设备上输出电影的服务请求时,一个或多个AI应用模型可以自动确定连接的智能电视可能最适合于处理音频命令,并且服务请求被直接路由到智能电视,如步骤1080所示,而不首先通过步骤1056至1072。

另一方面,如果没有设备(附接的MAS、附接的用户输入设备和任何其他设备)能够履行服务请求,则可以提示用户进行澄清,如步骤1052所示。例如,在用户输入是“在我的智能电视上播放第一部哈利波特电影”但是没有找到电影文件,或者没有连接智能电视的情况下,MAS或附接的用户交互设备然后可以向用户输出提示,诸如“你想要播放第二部哈利波特电影吗?”或者“没有找到智能电视,改为在iPhone上播放电影?”。

除了上面公开的那些之外,许多不同的使用示例也是可能的,其中MAS的AI能力和语音交互提供了诸多益处。运动跟踪和控制可用于使MAS在许多活动中跟踪用户,诸如播放音乐(集中在用户的手部)、当锻炼或做特技时、诸如舞蹈的现场表演、体育活动(诸如在篮球比赛或团队中跟随特定的运动员)、跟随用户创作或表演艺术、或用相机跟踪用户的一个方面的任何活动。

此外,MAS可用于保持、支撑或以其他方式引导除了用户计算设备之外的或者连同其的项目。例如,MAS可以保持并移动手电筒来照亮车底或水槽的区域或任何其他位置,诸如为用户照亮一个区域或提供夜灯或照亮人行道。MAS还可以保持并智能地移动投影仪设备,以将图像投影到墙壁或天花板上,诸如用于娱乐或观看视频。具有用户交互设备MAS也可以被设置为安全监控系统,其可以监控意外的声音或运动。MAX可以自动移动相机来创建房间或声音源的视频,并自动将该视频或声音上传到云或其他用户设备。

在外部环境中,MAS可以指向夜空,以基于用户输入或通过使用相关联的应用程序来跟踪、观察或拍摄或录制星星、行星或星座。它还可以用于创建具有来自用户的智能输入和输出的智能全景照片或院子、房子或室内空间。

图11示出了移动设备1100的示例实施例,移动设备1100也被称为用户设备或用户交互设备,其可以是移动的或不是移动的。这仅仅是一种可能的移动设备1100配置,因此可以设想,本领域普通技术人员可以不同地配置移动设备1100。移动设备1100可以包括能够如下所述执行的任何类型的移动通信设备。移动设备100可以包括PDA、蜂窝电话、智能电话、平板电脑、无线电子平板、物联网设备、“可穿戴”电子设备或任何其他用户交互设备。

在该示例实施例中,移动设备1100被配置有外部壳体1104,壳体1104被配置为保护和容纳下述组件。壳体1104内是处理器1108以及第一总线1112A和第二总线1112B(统称为1112)。处理器1108通过总线1112与移动设备1100的其他组件通信。处理器1108可以包括能够如本文所述执行的任何类型的处理器或控制器。处理器1108可以包括通用处理器、ASIC、ARM、DSP、控制器或任何其他类型的处理设备。处理器1108和移动设备1100的其他元件从电池1120或其他电源接收电力。电接口1124提供一个或多个电端口以与移动设备1100电连接,例如与第二电子设备、计算机、医疗设备或电源/充电设备电连接。接口1124可以包括任何类型的电接口或连接器格式。

一个或多个存储器1110是移动设备1100的一部分,用于存储在处理器1108上执行的机器可读代码,并用于存储数据,诸如图像数据、音频数据、用户数据、位置数据、加速度计数据或任何其他类型的数据。存储器1110可以包括RAM、ROM、闪存、光存储器或微驱动存储器。这里描述的机器可读代码(软件模块和/或例程)是非暂时性的。

作为该实施例的一部分,处理器1108连接到用户接口1116。用户接口1116可以包括被配置为接受用户输入来控制移动设备1100的任何系统或设备。用户接口1116可以包括以下的一个或多个:麦克风、键盘、滚球、按钮、滚轮、指针键、触摸板和触摸屏。还提供了触摸屏控制器1130,其通过总线1112接口并连接到显示器1128。

显示器包括被配置为向用户显示视觉信息的任何类型的显示屏。该屏幕可以包括LED、LCD、薄膜晶体管屏幕、OEL CSTN(彩色超扭曲向列)、TFT(薄膜晶体管)、TFD(薄膜二极管)、OLED(有机发光二极管)、AMOLED显示器(有源矩阵有机发光二极管)、电容式触摸屏,电阻式触摸屏或者这些技术的任意组合。显示器1128从处理器1108接收信号,并且如本领域所理解的,这些信号被显示器翻译成文本和图像。显示器1128还可以包括显示处理器(未示出)或与处理器1108接口的控制器。触摸屏控制器1130可以包括被配置为从覆盖在显示器1128上的触摸屏接收信号的模块。

该示例性移动设备1100的一部分还有扬声器1134和麦克风1138。扬声器1134和麦克风1138可以由处理器1108控制。麦克风1138被配置为基于处理器1108的控制来接收音频信号并将音频信号转换为电信号。同样,处理器1108可以激活扬声器1134来生成音频信号。这些设备如本领域所理解的那样操作,因此在此不再详细描述。

第一无线收发器1140和第二无线收发器1144也连接到一条或多条总线1112,它们中的每一个都连接到相应的天线1148、1152。第一收发器1140和第二收发器1144被配置为从远程发射器接收输入信号,并对信号执行模拟前端处理以生成模拟基带信号。输入信号可以通过转换为数字格式来进一步处理,例如通过模数转换器,用于处理器1108的后续处理。同样,第一收发器1140和第二收发器1144被配置为从处理器1108或移动设备1100的另一组件接收输出信号,并将这些信号从基带上变频到RF频率,以便通过相应的天线1148、1152进行传输。尽管示出了第一无线收发器1140和第二无线收发器1144,但是可以预期,移动设备1100可以仅具有一个这样的系统或者两个或更多个收发器。例如,一些设备支持三频或四频,或者具有蓝牙、NFC或其他通信能力。

可以设想,移动设备1100以及因此第一无线收发器1140和第二无线收发器1144可以被配置为根据任何现有的或未来开发的无线标准进行操作,包括但不限于蓝牙、WI-FI,例如IEEE 802.11a、b、g、n、无线LAN、WMAN、宽带固定接入、WiMAX、任何蜂窝技术,包括CDMA、GSM、EDGE、3G、4G、5G、TDMA、AMPS、FRS、GMRS、民用波段无线电、VHF、AM、FM和无线USB。

移动设备1100的一部分是连接到第二总线1112B的一个或多个系统,其也与处理器1108接口。这些设备包括具有相关天线1162的全球定位系统(GPS)模块1160。GPS模块1160能够接收和处理来自卫星或其他转发器的信号,以生成关于GPS模块1160的位置、行进方向和速度的位置数据。GPS在本领域中是公知的,因此在此不再详细描述。陀螺仪1164连接到总线1112B,以生成并提供关于移动设备1100的方位的方位数据。提供磁力计1168以向移动设备1100提供方向信息。加速度计1172连接到总线1112B,以提供关于移动设备1100所经受的冲击或力的信息或数据。在一种配置中,加速度计1172和陀螺仪1164生成数据并将其提供给处理器1108,以指示移动设备1100的移动路径和方位。

提供一个或多个相机(静态、视频或这两者)1176来捕捉图像数据,以存储在存储器1110中和/或用于可能通过无线或有线链路传输或用于以后观看。一个或多个相机1176可以被配置为使用可见光和/或近红外光来检测图像。相机1176还可以被配置为利用图像增强、主动照明或热视觉来在黑暗环境中获得图像。处理器1108可以处理存储在存储器上的机器可读代码,以执行这里描述的功能。

提供闪光灯和/或手电筒1180(诸如LED灯),并且是处理器可控制的。闪光灯或手电筒1180可以用作闪光灯或传统的手电筒。闪光灯或手电筒1180也可以被配置为发射近红外光。功率管理模块1184与电池1120连接或监控电池1120,以管理功耗、控制电池充电,并向可能需要不同功率需求的各种设备提供电源电压。

图12是根据一个示例性实施例的诸如上述设备之一的计算或移动设备或服务器的示意图。用户交互设备1200旨在表示各种形式的数字计算机,例如智能手机、平板电脑、信息亭、笔记本电脑、台式机、工作站、个人数字助理、服务器、刀片服务器、大型机和其他适当的计算机。用户交互设备1250旨在表示各种形式的移动设备,例如个人数字助理、蜂窝电话、智能电话和其他类似的用户交互设备。这里示出的组件、它们的连接和关系以及它们的功能仅是示例性的,并不意味着限制本文档中描述和/或要求保护的实施方式。

用户交互设备1200包括处理器1202、存储器1204、存储设备1206、连接到存储器1204和高速扩展端口1210的高速接口或控制器1208、以及连接到低速总线1214和存储设备1206的低速接口或控制器1212。组件1202、1204、1206、1208、1210和1212中的每一个使用各种总线互连,并且可以安装在公共主板上或者以其他适当的方式安装。处理器1202可以处理用于在用户交互设备1200内执行的指令,包括存储在存储器1204中或存储设备1206上的指令,以在外部输入/输出设备(诸如耦合到高速控制器1208的显示器1216)上显示GUI的图形信息。在其他实现中,可以适当地使用多个处理器和/或多个总线,以及多个存储器和多种类型的存储器。此外,可以连接多个用户交互设备1200,每个设备提供必要操作的部分(诸如,作为服务器组、一组刀片服务器或多处理器系统)。

存储器1204在用户交互设备1200内存储信息。在一个实现中,存储器1204是一个或多个易失性存储单元。在另一实现中,存储器1204是一个或多个非易失性存储单元。存储器1204也可以是另一种形式的计算机可读介质,例如磁盘或光盘。

存储设备1206能够为用户交互设备1200提供大容量存储。在一个实施方式中,存储设备1206可以是或包含计算机可读介质,例如硬盘设备、光盘设备或磁带设备、闪存或其他类似的固态存储设备、或设备阵列,包括存储区域网络或其他配置中的设备。计算机程序产品可以有形地包含在信息载体中。计算机程序产品还可以包含指令,当被执行时,这些指令执行一种或多种方法,例如上面描述的那些方法。信息载体是计算机或机器可读介质,例如存储器1204、存储设备1206或处理器1202上的存储器。

高速控制器1208管理用户交互设备1200的带宽密集型操作,而低速控制器1212管理较低带宽密集型操作。这种功能分配仅仅是示例性的。在一个实现中,高速控制器1208耦合到存储器1204、显示器1216(诸如,通过图形处理器或加速器),并且耦合到高速扩展端口1210,高速扩展端口1210可以接受各种扩展卡(未示出)。在该实现中,低速控制器1212耦合到存储设备1206和低速总线1214。可包括各种通信端口(诸如,USB、蓝牙、以太网、无线以太网)的低速总线1214可通过例如网络适配器耦合到一个或多个输入/输出设备,例如键盘、定点设备、扫描仪或诸如交换机或路由器的网络设备。

如图所示,用户交互设备1200可以以多种不同的形式实现。例如,它可以被实现为标准服务器1220,或者在一组这样的服务器中多次实现。它也可以被实现为机架式服务器系统1224的一部分。此外,它可以在诸如笔记本电脑1222的个人计算机中实现。或者,来自用户交互设备1200的组件可以与移动设备(未示出)中的其他组件组合,例如设备1250。每个这样的设备可以包含一个或多个用户交互设备1200、1250,并且整个系统可以由相互通信的多个用户交互设备1200、1250组成。

用户交互设备1250包括处理器1252、存储器1264、诸如显示器1254的输入/输出设备、通信接口1266和收发器1268以及其他组件。设备1250还可以配备有存储设备,例如微驱动器或其他设备,以提供附加的存储。组件1250、1252、1264、1254、1266和1268中的每一个都使用各种总线互连,并且这些组件中的几个可以安装在公共主板上或者以其他适当的方式安装。

处理器1252可以执行用户交互设备1250内的指令,包括存储在存储器1264中的指令。处理器可以被实现为包括单独的和多个模拟和数字处理器的芯片的芯片组。例如,处理器可以提供设备1250的其他组件的协调,诸如对用户接口、设备1250运行的应用以及设备1250的无线通信的控制。

处理器1252可以通过耦合到显示器1254的控制接口1258和显示接口1256与用户通信。显示器1254可以是例如TFT LCD(薄膜晶体管液晶显示器)或OLED(有机发光二极管)显示器,或者其他合适的显示技术。显示接口1256可以包括用于驱动显示器1254向用户呈现图形和其他信息的适当电路。控制接口1258可以从用户接收命令,并转换它们以提交给处理器1252。此外,可以提供与处理器1252通信的外部接口1262,以实现设备1250与其他设备的近距离通信。外部接口1262可以例如在一些实现中提供有线通信,或者在其他实现中提供无线通信,并且也可以使用多个接口。

存储器1264在用户交互设备1250内存储信息。存储器1264可以被实现为一个或多个计算机可读介质、一个或多个易失性存储器单元或一个或多个非易失性存储器单元中的一者或多者。还可以提供扩展存储器1274,并通过扩展接口1272连接到设备1250,扩展接口1272可以包括例如SIMM(单列直插存储器模块)卡接口。这种扩展存储器1274可以为设备1250提供附加的存储空间,或者也可以为设备1250存储应用或其他信息。具体地,扩展存储器1274可以包括执行或补充上述过程的指令,并且还可以包括安全信息。因此,例如,扩展存储器1274可以作为设备1250的安全模块来提供,且可以用允许设备1250的安全使用的指令来编程。此外,可以通过SIMM卡提供安全应用以及附加信息,例如以不可破解的方式在SIMM卡上放置识别信息。

如下所述,存储器可以包括例如闪存和/或NVRAM存储器。在一种实施方式中,计算机程序产品有形地包含在信息载体中。计算机程序产品包含指令,当被执行时,这些指令执行一种或多种方法,例如上述的那些方法。信息载体是计算机或机器可读介质,例如存储器1264、扩展存储器1274或处理器1252上的存储器,其可以例如通过收发器1268或外部接口1262接收。

设备1250可以通过通信接口1266进行无线通信,通信接口1266在必要时可以包括数字信号处理电路。通信接口1266可以提供各种模式或协议下的通信,例如GSM语音呼叫、SMS、EMS或MMS消息收发、CDMA、TDMA、PDC、WCDMA、CDMA2000或GPRS等。这种通信可以例如通过射频收发器1268进行。此外,可以进行短程通信,例如使用蓝牙、Wi-Fi或其他这样的收发器(未示出)。此外,GPS(全球定位系统)接收机模块1270可以向设备1250提供附加的导航和位置相关的无线数据,这些数据可以被运行在设备1250上的应用适当地使用。

设备1250还可以使用音频编解码器1260进行可听通信,音频编解码器1260可以从用户接收口头信息并将其转换为可用的数字信息。音频编解码器1260同样可以为用户生成可听声音,例如通过扬声器,例如在设备1250的听筒中。这种声音可以包括来自语音电话呼叫的声音,可以包括记录的声音(诸如,语音消息、音乐文件等)并且还可以包括由在设备1250上运行的应用生成的声音。

如图所示,用户交互设备1250可以以多种不同的形式实现。例如,它可以被实现为蜂窝电话1260。它也可以被实现为智能电话1282、个人数字助理、计算机平板或其他类似移动设备的一部分。

因此,这里描述的系统和技术的各种实现可以在数字电子电路、集成电路、特别设计的ASIC(专用集成电路)、计算机硬件、固件、软件和/或其组合中实现。这些不同的实现可以包括在可编程系统上可执行和/或可解释的一个或多个计算机程序中的实现,该可编程系统包括至少一个可编程处理器、至少一个输入设备和至少一个输出设备,该可编程处理器可以是专用或通用的,被耦合以从存储系统接收数据和指令,以及向存储系统发送数据和指令。

这些计算机程序(也称为程序、软件、软件应用或代码)包括用于可编程处理器的机器指令,并且可以用高级过程和/或面向对象的编程语言和/或汇编/机器语言来实现。如这里所使用的,术语“机器可读介质”“计算机可读介质”指的是用于向可编程处理器提供机器指令和/或数据的任何计算机程序产品、装置和/或设备(诸如,磁盘、光盘、存储器、可编程逻辑设备(PLD)),包括接收机器指令作为机器可读信号的机器可读介质。术语“机器可读信号”是指用于向可编程处理器提供机器指令和/或数据的任何信号。

为了提供与用户的交互,这里描述的系统和技术可以在计算机上实现,该计算机具有用于向用户显示信息的显示设备(诸如,CRT(阴极射线管)或LCD(液晶显示器)监视器)以及用户可以用来向计算机提供输入的键盘和定点设备(诸如,鼠标、操纵杆、轨迹球或类似设备)。也可以使用其他类型的设备来提供与用户的交互;例如,提供给用户的反馈可以是任何形式的感觉反馈(诸如,视觉反馈、听觉反馈或触觉反馈);并且可以以任何形式接收来自用户的输入,包括声音、语音或触觉输入。

这里描述的系统和技术可以在计算系统(诸如,用户交互设备1200和/或1250)中实现,该计算系统包括后端组件(诸如,作为数据服务器、投币游戏记账系统、玩家跟踪系统等),或者包括中间件组件(诸如,应用服务器),或者包括前端组件(诸如,具有图形用户接口或网络浏览器的客户端计算机,用户可以通过该图形用户接口或网络浏览器与这里描述的系统和技术的实现进行交互),或者这些后端、中间件、前端组件的任意组合。系统的组件可以通过任何形式或介质的数字数据通信(诸如,通信网络)来互连。通信网络的示例包括局域网(“LAN”)、广域网(“WAN”)和互联网。

计算系统可以包括客户端和服务器。客户端和服务器通常彼此远离,并且通常通过通信网络进行交互。客户端和服务器的关系是由于在各自的计算机上运行的计算机程序而产生的,并且彼此具有客户端-服务器关系。

虽然已经描述了本发明的各种实施例,但是对于本领域普通技术人员来说,很明显,在本发明的范围内,更多的实施例和实现是可能的。此外,本文描述的各种特征、元素和实施例可以以任何组合或布置来要求保护或组合。