一种神经语言网络模型的训练方法、装置、设备及介质

文献发布时间:2023-06-19 11:39:06

技术领域

本发明涉及神经网络领域,尤其涉及一种神经语言网络模型的训练方法、装置、设备及存储介质。

背景技术

近些年来,基于海量数据的深度学习方法在文本领域取得了较好的效果,但其学习过程大部分都是有监督的,即需要大量的带标注的训练数据。而现实场景中海量数据的标注工作不仅是单调乏味,浪费时间,而且需要耗费一定的人力和物力,如领域文本的实体标注,分类等任务。

为了解决此类问题,提出了迁移学习(transfer learning)的概念,即试图将源任务获得的知识,应用于目标领域。在文本领域,迁移学习最常见的应用是神经语言模型网络,如ELMo、GPT和BERT等模型,其中BERT模型是目前效果最好的。现有技术中先使用BERT模型在大规模语料上进行无监督学习得到的预训练模型,然后进行特定文本任务的迁移学习,实验表明虽然可以显著的降低文本深度网络对标注数据量的需求,但在实际任务中对语言模型的训练需要消耗大量时间,并且经模型训练识别后,仍需要数千级以上的待标注训练数据,特别是针对一些特殊应用领域,如医学、政务等,需专家进行标注,仍需花费较大的代价。

综上所述,现有技术中的文本深度学习网络,训练数据标注量较大,语言模型的训练时间较长。

发明内容

本发明实施例提供了一种神经语言网络模型的训练方法、装置、设备及存储介质,用以降低训练样本数据的标注量,同时提高语言模型的训练效率。

第一方面,本发明实施例提供一种神经语言网络模型的训练方法,包括:

获取训练样本数据;

循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:

利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率;

依据预设选择策略,基于每个训练样本数据的识别概率,从未进行标注的训练样本数据中选择部分训练样本数据请求进行人工标注;

获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。

本发明实施例提供的神经语言网络模型的训练方法,根据业务需求,获取训练样本数据后,循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:首先,利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率;然后依据预设选择策略,并基于每个训练样本数据的识别概率,在未进行标注的训练样本数据中选择出部分训练样本数据,请求进行人工标注;最后获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。与现有技术相比,在训练过程对神经语言网络模型不断进行优化,提高了模型的训练效率,经不断优化的模型识别后,有效降低了训练样本数据的标注量,减少了样本数据标注的成本。

在一种可能的实施方式中,基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,包括:

基于所有已人工标注的训练样本数据对前一次训练得到的神经语言网络模型进行训练。

在一种可能的实施方式中,利用前一次训练得到的神经语言网络模型对训练样本数据进行预测,包括:

首次对训练样本数据进行预测时,使用预训练的神经语言网络模型作为前一次训练得到的神经语言网络模型。

在一种可能的实施方式中,预设选择策略,包括:选择识别概率小于预设概率阈值的数据;

依据预设选择策略,基于每个训练样本数据的识别概率,从训练样本数据中选择部分训练样本数据请求进行人工标注,包括:

从训练样本数据中选择识别概率小于预设概率阈值的部分训练样本数据请求进行人工标注。

第二方面,本发明实施例提供一种神经语言网络模型的训练装置,包括:

获取单元,用于获取训练样本数据;

处理单元,用于循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:

利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率;

依据预设选择策略,基于每个训练样本数据的识别概率,从未进行标注的训练样本数据中选择部分训练样本数据请求进行人工标注;

获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。

在一种可能的实施方式中,处理单元具体用于:

基于所有已人工标注的训练样本数据对前一次训练得到的神经语言网络模型进行训练。

在一种可能的实施方式中,处理单元具体用于:

首次对训练样本数据进行预测时,使用预训练的神经语言网络模型作为前一次训练得到的神经语言网络模型。

在一种可能的实施方式中,预设选择策略,包括:选择识别概率小于预设概率阈值的数据;

处理单元具体用于:

从训练样本数据中选择识别概率小于预设概率阈值的部分训练样本数据请求进行人工标注。

第三方面,本发明实施例提供一种神经语言网络模型的训练设备,包括:至少一个处理器、至少一个存储器以及存储在存储器中的计算机程序指令,当计算机程序指令被处理器执行时实现本发明实施例第一方面提供的神经语言网络模型的训练方法。

第四方面,本发明实施例提供一种计算机可读存储介质,其上存储有计算机程序指令,当计算机程序指令被神经语言网络模型的训练设备的处理器执行时实现本发明实施例第一方面提供的神经语言网络模型的训练方法。

附图说明

通过参考附图阅读下文的详细描述,本发明示例性实施方式的上述以及其他目的、特征和优点将变得易于理解。在附图中,以示例性而非限制性的方式示出了本发明的若干实施方式,其中:

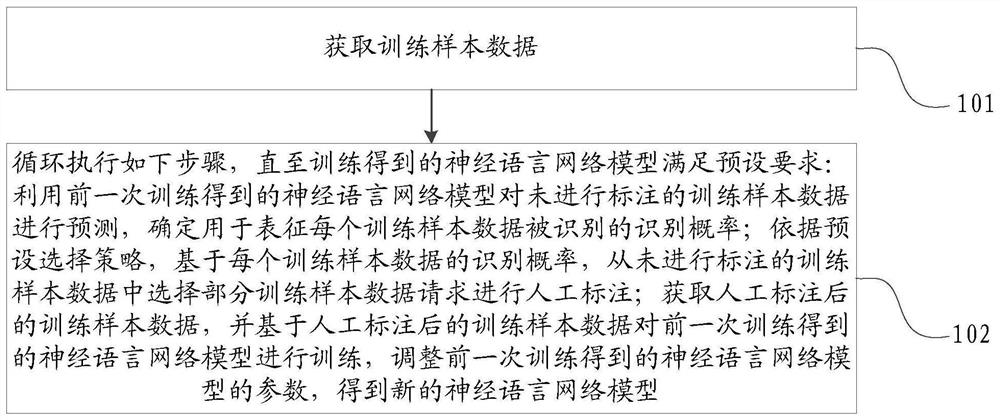

图1为本发明实施例提供的一种神经语言网络模型的训练方法的示意流程图;

图2为本发明实施例提供的一种神经语言网络模型的训练方法的具体流程的示意流程图;

图3为本发明实施例提供的一种神经语言网络模型的训练方法的原理示意图;

图4为本发明实施例提供的另一神经语言网络模型的训练方法的示意流程图;

图5为本发明实施例提供的一种神经语言网络模型的训练装置的结构示意图;

图6为本发明实施例提供的一种神经语言网络模型的训练设备的结构示意图。

具体实施方式

以下结合附图对本发明的实施例进行说明,应当理解,此处所描述的实施例仅用于说明和解释本发明,并不用于限定本发明。

鉴于现有技术中的文本深度学习网络,语言模型的训练时间较长,训练数据标注量较高,本发明实施例提供一种神经语言网络模型的训练方案,用以提高语言模型的训练效率,有效降低标注数据量,减少数据标注的成本。

下面结合附图对本发明实施例提供的方案进行详细说明。

如图1所示,本发明实施例提供一种神经语言网络模型的训练方法,其可以包括以下步骤:

步骤101,获取训练样本数据。

步骤102,循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率;依据预设选择策略,基于每个训练样本数据的识别概率,从未进行标注的训练样本数据中选择部分训练样本数据请求进行人工标注;获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。

下面结合图2,对本发明实施例提供的神经语言网络模型的训练方法的具体流程进行详细说明。

如图2所示,步骤201,获取训练样本数据。

具体实施时,根据业务需求,确定需要处理的文本任务类型,如序列标注、文本分类等,收集相关的任务资源,将未被标注的任务资源确定为训练样本数据。

循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:

步骤202,利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率。

需要说明的是,当首次对未进行标注的训练样本数据进行预测时,使用的是预训练的神经语言网络模型;非首次对未进行标注的训练样本数据进行预测时,使用的是前一次训练得到的神经语言网络模型。

步骤203,依据预设选择策略,基于每个训练样本数据的识别概率,从未进行标注的训练样本数据中选择部分训练样本数据请求进行人工标注。

在一种可能的实施方式中,预设选择策略包括,选择识别概率小于预设概率阈值的数据;

依据预设选择策略,基于每个训练样本数据的识别概率,从训练样本数据中选择部分训练样本数据请求进行人工标注,包括:

从训练样本数据中选择识别概率小于预设概率阈值的部分训练样本数据请求进行人工标注。

具体实施时,采用最小置信(Least confidence,LC)方法作为预设选择策略,即基于样本的预测不确定性进行采样。

对于文本分类任务,可直接对单个样本的预测概率进行升序排序,选择概率值较小的样本集合作为待标注的数据。

对于序列标注任务,需考虑序列生成的最大概率,设X

按照式1进行降序排列,值越大表示对应的样本序列的不确定性越大,但是该方法倾向于选择较长的句子,因此相关学者提出了归一化对数概率(Maximum Normalized Log-Probability,MNLP)的方法来解决以上问题,如式2:

具体实施时,按照LC方法并结合MNLP的方法作为样本选择策略,从未识别的训练样本数据中选取部分样本,并请求进行人工标注。

步骤204,获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。

步骤205,若新的神经语言网络模型满足预设要求,则执行步骤206,否则返回步骤202。

步骤206,输出满足预设要求的神经语言网络模型。

具体实施时,当BERT模型在某个特定的文本任务上取得了满意的效果,即与现有水平相当,则认定神经语言网络模型满足预设要求。

在一种可能的实施方式中,基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,包括:

基于所有已人工标注的训练样本数据对前一次训练得到的神经语言网络模型进行训练。

具体实施时,对前一次训练得到的神经语言网络模型进行训练,可以基于当前次人工标注的训练样本数据,也可以基于当前所有已进行人工标注的训练样本数据,本发明对此不做限定。

如图3所示,为本发明实施例提供的神经语言网络模型的学习过程示意图,首先使用基于公开任务数据进行微调的BERT模型,对大量无标注任务场景数据进行预测(文本分类,序列标注等任务);然后利用主动学习的样本选择策略方法从预测样本中选出部分显著样本进行人工标注,其中部分显著样本是对模型效果影响大的样本;最后将人工标注的样本集合输入到BERT模型进行增量式的微调。对以上三步进行多次的循环,直到模型获得满意的结果。

下面以具体实施例对本发明实施例提供的神经语言网络模型的训练方法的具体过程进行详细说明。

如图4所示,步骤401,根据业务需求,确定需要处理的文本任务类型,如序列标注、文本分类等,收集相关数据资源,记为U={C

步骤402,将BERT模型作为预设的神经语言网络模型,使用相同任务类型的公开数据集,对BERT模型进行微调,得到具备特定文本任务(序列标注、文本分类等)能力的BERT预训练模型,记为M

步骤403,使用BERT模型对集合C

具体实施时,首先,BERT模型在每一次对样本进行预测后,都要利用带标注的样本对其进行微调,则首次应用的BERT模型为M

步骤404,利用集合S依据预设样本选择策略方法(即判断哪些样本需要进行标记),选出部分无标注的样本集W={w

具体实施时,采用LC方法作为预设选择策略,即基于样本的预测不确定性进行采样,并结合MNLP的方法作为样本选择策略,从未识别的训练样本数据中选取部分样本,并请求进行人工标注。

步骤405,对无标注的样本集W进行人工标注,获得带标注样本Q={q

步骤406,利用带标注的样本集合L对预训练BERT模型进行微调。

步骤407,判断BERT模型是否满足预设要求,即与现有水平相当,如果是则执行步骤408,否则返回步骤403。

步骤408,输出满足预设要求的BERT模型。

具体实施时,带标注的样本集合L中的样本,随着BERT模型的训练识别后进行人工标注的样本的增加而增加。即BERT模型M

在一种可能的实施方式中,本发明实施例还提供一种神经语言网络模型的训练装置,如图5所示,包括:

获取单元51,用于获取训练样本数据;

处理单元52,用于循环执行如下步骤,直至训练得到的神经语言网络模型满足预设要求:

利用前一次训练得到的神经语言网络模型对未进行标注的训练样本数据进行预测,确定用于表征每个训练样本数据被识别的识别概率;

依据预设选择策略,基于每个训练样本数据的识别概率,从未进行标注的训练样本数据中选择部分训练样本数据请求进行人工标注;

获取人工标注后的训练样本数据,并基于人工标注后的训练样本数据对前一次训练得到的神经语言网络模型进行训练,调整前一次训练得到的神经语言网络模型的参数,得到新的神经语言网络模型。

在一种可能的实施方式中,处理单元52具体用于:

基于所有已人工标注的训练样本数据对前一次训练得到的神经语言网络模型进行训练。

在一种可能的实施方式中,处理单元52具体用于:

首次对训练样本数据进行预测时,使用预训练的神经语言网络模型作为前一次训练得到的神经语言网络模型。

在一种可能的实施方式中,预设选择策略,包括:选择识别概率小于预设概率阈值的数据;

处理单元52具体用于:

从训练样本数据中选择识别概率小于预设概率阈值的部分训练样本数据请求进行人工标注。

基于相同的发明构思,本发明实施例还提供一种神经语言网络模型的训练设备。

如图6所示,本发明实施例提供一种神经语言网络模型的训练设备60,包括:至少一个处理器61、至少一个存储器62以及存储在存储器中的计算机程序指令,当计算机程序指令被处理器61执行时实现本发明实施例提供的神经语言网络模型的训练方法。

在示例性实施例中,还提供了一种包括指令的存储介质,例如包括指令的存储器62,上述指令可由神经语言网络模型的训练设备的处理器61执行以完成上述方法。

可选地,存储介质可以是非临时性计算机可读存储介质,例如,非临时性计算机可读存储介质可以是ROM、随机存取存储器(RAM)、CD-ROM、磁带、软盘和光数据存储设备等。

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其它实施方案。本申请旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由下面的权利要求指出。

应当理解的是,本公开并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本公开的范围仅由所附的权利要求来限制。

- 一种神经语言网络模型的训练方法、装置、设备及介质

- 一种卷积神经网络模型加速训练方法、装置、电子设备及存储介质