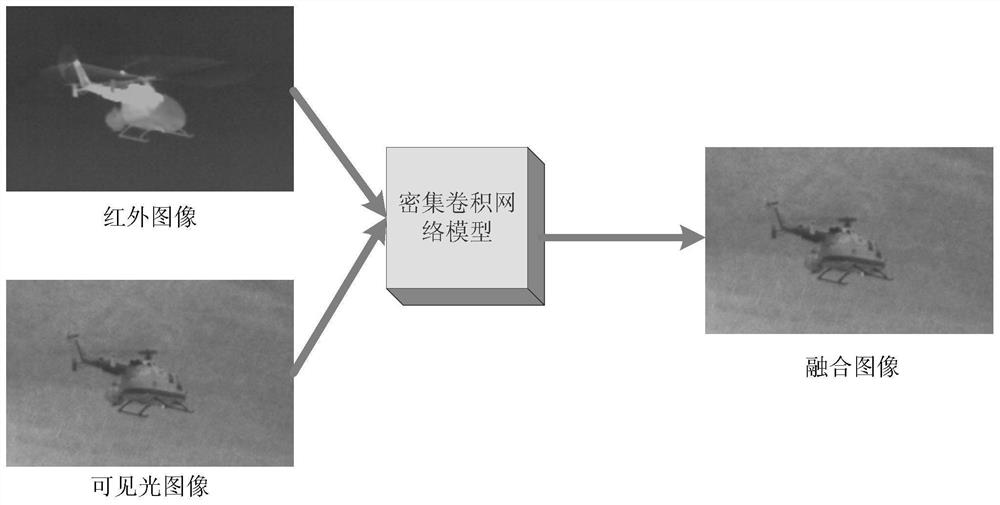

基于深度无监督密集卷积网络的红外和可见光图像融合方法

文献发布时间:2023-06-19 09:43:16

技术领域

本发明属于图像处理技术领域,具体涉及一种红外与可见光图像的图像融合方法,可以应用于各种图像处理系统。

背景技术

图像融合是指利用一定的技术将两幅或者多幅多源图像的重要信息进行合并的过程,目的是使所获得的融合图像能够充分利用不同源图像特有信息,以便更准确全面描述场景信息。作为图像融合技术中一个重要组成部分,红外与可见光图像融合后的图像清晰度更高、信息量更大、获取目标和场景的信息更全面且更适合人类视觉感知,已经在工业和民用等领域得到应用。在民用领域中,将红外与可见光融合技术应用在汽车夜视系统中,可以提高汽车在浓雾、大雨等恶劣天气条件下行车的安全性。

近年来,由于深度学习在计算机视觉与图像处理领域中取得的相关成果,使得许多学者开始研究将深度学习应用到图像融合方面。文献“李红,刘芳,杨淑媛,等.基于深度支撑值学习网络的遥感图像融合[J].计算机学报,2016.”将深度学习用于遥感图像融合中,提出了一种基于深度支撑值学习网络的融合方法。本方法利用在训练深度网络时加入结构风险最小化的损失函数,使得融合图像较好地保持了图像的光谱信息和空间信息。文献“Liu Y,Chen X,Ward R,et al.Image Fusion With Convolutional SparseRepresentation.IEEE Signal Processing Letters,2016.”提出基于卷积稀疏表示的图像融合算法。算法通过高斯滤波将图像分解为基础层和细节,利用基于卷积稀疏表示的方法对上述两尺度图像进行融合得到加权平均的融合图像。本方法克服了传统的基于稀疏表示的方法细节保留能力低的问题,所提出的方法用于图像融合可以得到一定的效果,但算法存在实现复杂、实现效率不高以及融合效果不理想的问题。文献“Tang H,Xiao B,Li W,et al.Pixel Convolutional Neural Network for Multi-Focus ImageFusion.Information Sciences,2017.”提出基于逐像素的卷积神经网络的多聚焦图像融合方法,利用数据驱动的焦点检测方法来克服手动焦点检测的低效率,但要取得更好的融合效果需要依赖后续的优化处理。针对上述文献存在问题,本发明提出一种基于密集卷积网络(Dense Convolutional Networks,DCN)的红外和可见光图像融合算法。

发明内容

要解决的技术问题

针对传统的红外与可见光图像融合算法过度依赖人工设计、算法复杂度高、效率低问题,以及基于深度学习的图像融合存在的需要标准参考图像的问题,本发明提出一种基于密集卷积网络的红外与可见光图像融合的新方法。通过构建密集卷积网络,生成从源图像到最终融合图的直接映射,避免了人工手动操作,模型中算法利用无参考图像质量评价指标设计损失函数和优化网络模型,最终获得高质量的融合图像。

技术方案

一种基于深度无监督密集卷积网络的红外和可见光图像融合方法,其特征在于步骤如下:

步骤1:输入待融合的红外图像A与可见光图像B;

步骤2:将红外图像A依次输入四个卷积层C1、DC1、DC2、DC3进行特征提取,将可见光图像B依次输入四个卷积层C1、DC1、DC2、DC3进行特征提取,每个卷积层的卷积核的大小均为3×3,步长为1,卷积层的特征图输出通道为16,每个卷积层的输入都为前面所有卷积层输出的级联;

步骤3:采用L1范数加法策略来融合不同输入图像的特征,用以获得最终的融合特征,即:

其中m∈{1,2,...,M},M=64代表特征图的数量,

步骤4:将步骤3输出的融合后的特征图f

步骤2中所述的C1为1×16。

步骤2中所述的DC1为16×16。

步骤2中所述的DC2为32×16。

步骤2中所述的DC3为48×16。

步骤4中所述的C2为64×64。

步骤4中所述的C3为64×32。

步骤4中所述的C4为32×16。

步骤4中所述的C5为16×1。

一种用于基于深度无监督密集卷积网络的红外和可见光图像融合方法的损失函数,其特征在于基于结构相似性和图像质量:

(1)结构相似度SSIM,用于计算两幅图像在对应位置的不同滑动窗口的结构相似度,假设输入图像为I,输出图像为O,则SSIM可定义为:

其中C

L

(2)邻域内的图像质量测量,根据两幅输入图像的结构相似性作为匹配的指标,当输入图像A的标准差std(A|w)大于输入图像B的对应标准差std(B|w),则表明输入图像A更匹配,因此图像质量的表达式为:

其中O表示输出图像,w表示滑动窗口,大小设置为7×7,滑动窗口以一个像素为步长从左到右、从上到下依次滑动;

(3)基于结构相似性和图像质量的损失函数,在密集卷积网络训练采用融合性能评价度量是通过上述结构相似度SSIM和邻域内的图像质量Scope(A,B,O)测量两部分因素,得到基于结构相似性和图像质量的损失函数:

其中,N表示图像中滑动窗口的总数。

有益效果

本发明提出一种基于密集卷积网络的红外与可见光图像融合的新方法,通过针对红外和可见光图像构建密集卷积网络,利用基于结构、亮度和对比度的结构相似性以及基于标准差的图像质量,针对性的设计了基于结构相似性和图像质量的损失函数以优化网络模型,同时为了优化网络模型,采用自适应矩估计算法最小化损失函数。其次,本发明采用泄漏整流线性单元作为网络的激活函数,为加快网络模型收敛速度并生成从源图像到最终融合图的直接映射,得到高质量的融合图像,避免了人工手动操作。实验结果表明,本发明通过该网络得到从源图像到融合图像的直接映射,避免了传统图像融合方法中依赖标准参考图像以及需要后续优化处理,解决传统图像融合方法的算法复杂、效率低问题,图像的融合质量得到进一步提高。

附图说明

图1基于深度无监督密集卷积网络的红外和可见光图像融合算法结构示意图;

图2基于深度无监督密集卷积网络的红外和可见光图像融合网络结构图;

图3红外与可见光图像组;

图4本发明算法在不同图像集的融合结果:(a1)源图像1;(a2)源图像2;(a3)DWT;(a4)CSR;(a5)WLS(a6)HMSD;(a7)GDGF-PCNN;(a8)CNN;(a9)DF;(a10)本发明(b1)源图像1;(b2)源图像2;(b3)DWT;(b4)CSR;(b5)WLS;(b6)HMSD;(b7)GDGF-PCNN(b8)CNN;(b9)DF;(b10)本发明;(c1)源图像1;(c2)源图像2;(c3)DWT;(c4)CSR;(c5)WLS(c6)HMSD;(c7)GDGF-PCNN;(c8)CNN;(c9)DF;(c10)本发明;(d1)源图像1;(d2)源图像2;(d3)DWT;(d4)CSR;(d5)WLS(d6)HMSD;(d7)GDGF-PCNN;(d8)CNN;(d9)DF;(d10)本发明;

图5不同客观指标的折线图:(a)Q

图6本发明算法在不同图像集的融合结果:(a)多聚焦图像融合;(b)医学图像融合;(c)多曝光图像融合。

具体实施方式

现结合实施例、附图对本发明作进一步描述:

密集卷积网络的网络结构

本发明提出的基于密集卷积网络的网络结构目的在于生成一幅红外和可见光融合图像,网络结构如图2所示。从输入图像1,2到输出图像F,该网络结构主要包括以下四部分:(1)输入,(2)特征提取,(3)特征融合,(4)输出。

首先,输入待融合的红外图像A与可见光图像B;接着,通过密集卷积操作提取输入图像的特征;然后,通过特征融合层来融合图像特征获得融合特征;最后,经过重构融合特征输出得到融合图像。即:(1)输入,(2)特征提取,(3)特征融合,(4)输出。

(1)输入。在网络学习阶段,本发明提出的密集卷积网络结构的输入为一对待融合的红外与可见光图像,并且两幅图像的大小要保持一致,本发明中训练时所用的图像大小为256×256。

(2)特征提取。如图2所示特征提取部分采用密集卷积网络以提取深层特征,其中包含四个卷积层,每一层的输入都为前面所有层输出的级联,从而能够增强特征的复用和特征的传播,减少参数的训练。第一个卷积层用于提取粗略信息,随着卷积层数的增加,提取的信息也增多。对于每一个卷积层,特征图的输出通道为16,卷积核的大小均为3×3,步长为1。

(3)特征融合。特征融合部分的作用在于融合不同输入图像的互补特征,用以获得最终的融合特征。本发明采用加法策略来融合不同输入图像的特征,即:

其中m∈{1,2,...,M},M=64代表特征图的数量,

(4)输出。输出模块的功能是生成融合图像,该模块将特征融合部分输出的结果(即f

基于结构相似性和图像质量的损失函数

在对密集卷积网络模型进行训练过程中,需要采用相应的损失函数完成网络模型参数学习。假设输入的一对图像为A与B,θ是用于被优化的网络参数,训练网络模型的目标是学习一个映射函数f用来生成一幅全聚焦图像

(1)结构相似度SSIM,用于计算两幅图像在对应位置的不同滑动窗口的结构相似度,假设输入图像为I,输出图像为O,则SSIM可定义为:

其中C

L

(3)邻域内的图像质量测量,根据两幅输入图像的结构相似性作为匹配的指标,当输入图像A的标准差std(A|w)大于输入图像B的对应标准差std(B|w),则表明输入图像A更匹配,因此图像质量的表达式为:

其中O表示输出图像,w表示滑动窗口,大小设置为7×7,滑动窗口以一个像素为步长从左到右、从上到下依次滑动。

(3)基于结构相似性和图像质量的损失函数,在密集卷积网络训练采用融合性能评价度量是通过上述结构相似度SSIM和邻域内的图像质量Scope(A,B,O)测量两部分因素,得到基于结构相似性和图像质量的损失函数:

密集卷积网络的训练细节

在本发明提出的密集卷积网络训练中,所采用的训练参数设置如表1所示,网络结构中所涉及的8个卷积层,其中前四个卷积层在密集卷积网络中用于特征提取,如图2中C1(1×16)、DC1(16×16)、DC2(32×16)、DC3(48×16),后面四个卷积层在卷积神经网络中用于特征重构(如图2中C2(64×64)、C3(64×32)、C4(32×16)、C5(16×1)),其中所有卷积层的大小设置为3×3,步长设置为1,密集块的输出通道均为16。第一层是在输入图像上进行滤波操作的,最后四层是融合图像。特征提取的分支是由三个级联的卷积层组成的密集卷积网络。本发明提出的密集卷积网络在训练过程中,所有的卷积层的激活函数都采用负斜率为0.2的LeakyReLU。采用随机初始化权重参数所有的卷积层(除了最后一层)都连接一个负斜率为0.2的LeakyReLU。在进行卷积之前,对所有的特征图进行边缘零填充以确保其大小与输入的一致。

表1深度无监督密集卷积网络训练参数设置

本发明所采用的训练图片来自标准的库MS-COCO的40000张图片,大小均为256×256,训练网络模型是采用TensorFlow,采用自适应优化算法进行训练,以便达到最小化损失函数。批量大小设置为2,纪元大小为4。动量和重量衰减分别设置为0.9和0.0005,所有权重均进行随机初始化,学习率为0.0001。

1.实验参数设置

实验环境为Intel(R)Core(TM)i3-8350 CPU@3.4GHz,内存为16GB,GPU处理器为NVIDA GeForce GTX 1080Ti。

实验数据来源为标准图像融合图像库。将所提出的融合方法与常用基于DWT、CSR、WLS、HMSD、GDGF-PCNN、CNN以及DF的融合方法进行对比,红外与可见光图像融合方法进行比较,这些方法是基于离散小波变换(Discrete Wavelet Transform,DWT)、卷积稀疏表示(Convolutional Sparse Representation,CSR)、加权最小二乘(weighted least square,WLS)、混合多尺度分解(Hybrid Multi-scale Decomposition,HMSD)、梯度域导向滤波和改进PCNN(Gradient domain guided filter and improved PCNN,GDGF-PCNN)、卷积神经网络(Convolution Neural Network,CNN)和密集融合(Dense Fuse,DF)的图像融合方法的图像融合方法,对比方法中相关参数取相应论文中给出的最佳参数。客观评价在图像融合中起着重要作用,因为融合方法的表现主要通过多个客观评价指标进行定量评估。在本发明中,本发明选择的四个客观度量准则:1)归一化的互信息(Normalized mutualinformation,Q

2.实验内容

本发明通过构建密集卷积网络,生成从源图像到最终融合图像的直接映射,避免了人工手动操作,同时利用结构相似性和图像质量来设计损失函数以优化网络模型,得到高质量的融合图像。通过归一化互信息Q

3.评价指标

图像融合的效果通常是用客观评价指标进行性能评价,但对客观评价指标的选择并没有统一的准则,因此本发明图像融合中普遍接受的四个准则进行评价。

(1)规范化的互信息Q

Hossny提出的规范化的互信息Q

其中,H(A)、H(B)和H(F)分别表示源图像A、源图像B和融合图像F的熵,MI(A,F)表示源图像A和融合图像F之间的互信息,MI(B,F)表示源图像B和融合图像F之间的互信息。

(2)基于梯度的度量Q

Q

其中,

(3)基于结构相似性的度量Q

Q

其中:SSIM(A,F|w)为A和F之间的结构相似度,定义为SSIM(A,F|w)=l(m,n)·c(m,n)·s(m,n),l(m,n)表示两幅图像的亮度相似性,c(m,n)表示两幅图像的对比度相似性,s(m,n)表示两幅图像的结构相似性,SSIM(B,F|w),SSIM(A,B|w)的定义相似。w为一个7×7的窗口大小,权值τ(w)定义如下式:

其中s(A|w)和s(B|w)分别为源图像A和B在窗口为w处的方差。

(4)基于人类感知的度量Q

Q

Q

其中,λ

4.仿真测试

为了对本发明提出的本发明算法的有效性进行检验,将本发明提出的算法分别与基于离散小波变换(Discrete Wavelet Transform,DWT)、卷积稀疏表示(ConvolutionalSparse Representation,CSR)、加权最小二乘(weighted least square,WLS)、混合多尺度分解(Hybrid Multi-scale Decomposition,HMSD)、梯度域导向滤波和改进PCNN(Gradientdomain guided filter and improved PCNN,GDGF-PCNN)、卷积神经网络(ConvolutionNeural Network,CNN)和密集融合(Dense Fuse,DF)的图像融合方法相比较,并从主观和客观层面进行分析。其中基于DWT的图像融合方法是经典的多尺度变换的融合方法,其在多聚焦图像融合的效果良好;基于CSR的图像融合方法是近几年提出的应用较广泛的变换域的方法;基于WLS的图像融合方法是近年来提出的新的空间域方法,被广泛应用在该领域并取得较好的效果;基于HMSD和GDGF-PCNN的图像融合方法属于混合变换的方法且GDGF-PCNN的融合方法为本文第三章提出的融合方法;基于CNN和DF的图像融合方法属于深度学习的方法,是最新提出来用于红外与可见光图像融合的方法。实验对比方法分别从变换域、空间域、混合变换和深度学习四个方面对图像融合算法进行对比测试,因此实验测试方法具有多样性,能够充分验证本发明提出的算法。

本发明采用4组红外和可见光图像进行实验,如下图3所示。其中图像的大小为256×256。对比方法的参数设置均采用对应文章中给出的最优参数。本发明实验环境为Intel(R)Core(TM)i3-8350 CPU@3.4GHz,内存为16GB,同时采用Python3.6编程。

红外与可见光图像融合实验与分析

将本发明方法分别与基于DWT、CSR、WLS、HMSD、GDGF-PCNN、CNN以及DF的融合方法进行对比,结果图如图4所示,其中(1)(2)分别表示待融合的红外与可见光图像,(3)表示基于DWT方法的图像融合结果,(4)表示基于CSR方法的图像融合结果,(5)表示基于WLS方法的图像融合结果,(6)表示基于HMSD方法的图像融合结果,(7)表示基于GDGF-PCNN方法的图像融合结果,(8)表示基于CNN方法的图像融合结果,(9)表示基于DF方法图像融合结果,(10)表示基于本发明算法图像融合结果。

(1)主观评价

由图4(a1)可以看到红外图像中的中心处的矩形目标,图4(a2)可以看到可见光图像中远处的路灯以及山上的房子,通过基于DWT和基于CNN的图像融合方法得到的融合图像细节信息丢失(如图4(a3)和(a8)中红外图像中的矩形目标不完整);基于CSR和基于HMSD的图像融合方法对比度降低并且信息丢失(如图4(a4)中远处的山以及(a6)中近处的路面);基于WLS的图像融合方法得到的融合图像边缘过渡不自然(如图4(a5)中远处山的边缘);基于DF的图像融合方法得到的融合图像对比度下降(如图4(a9)中远处的山和路灯);基于GDGF-PCNN的图像融合方法和本发明所提算法不存在明显的错误,所得的融合图像对目标的细节保留完整同时对比度也有所提高。

由图4(b1)可以看到红外图像中运动中的汽车、人以及房屋,图4(b2)可以看到可见光图像中道路两边的栅栏和路灯,通过基于DWT和基于DF的图像融合方法得到的融合图像细节信息丢失(如图4(b3)和(b9)中左下角的汽车);基于CSR和基于WLS的图像融合方法得到的融合图像对比度降低(如图4(b4)和(b5)所示);基于HMSD、GDGF-PCNN和CNN的图像融合方法(如图4(b6)、(b7)和(b8)所示)得到的融合图像与本发明所提算法效果相差不大,所得的融合图像不仅能够保留可见光图像的细节信息,而且能分辨出红外图像中的目标。

由图4(c1)可以看出红外图像中包含在可见光图像中没有发现的目标,图4(c2)可以看到可见光图像中的栅栏、树木以及房屋,通过基于DWT的图像融合方法得到的融合图像细节信息丢失(如图4(c3)中的栅栏);基于CSR的融合方法不适于红外和可见光的融合,图像存在大范围失真(如图4(c4)所示);基于CNN的图像融合方法得到的融合图像存在模糊(如图4(c8)所示);基于DF的图像融合方法得到的融合图像存在块效应(如图4(c9)中下方区域);基于WLS、HMSD和GDGF-PCNN的图像融合方法(如图4(c5)、(c6)和(c7)所示)得到的融合图像与本发明所提算法效果相差不大,不仅能够保留可见光图像中的细节信息,而且能分辨出红外图像中的目标。

由图4(d1)可以看到红外图像中植物的叶子以及远处树林中隐藏的目标,图4(d2)可以看到可见光图像中明亮的正方形板,通过基于DWT和基于CNN的图像融合方法得到的融合图像细节信息丢失(如图4(d3)和(d8)中近处的树叶);基于WLS和基于DF的图像融合方法得到的融合图像对比度降低(如图4(d5)和(d9)所示);基于CSR和基于HMSD的图像融合方法得到的融合图像存在大范围失真(如图4(d4)和(d6)中左上方区域);基于GDGF-PCNN的图像融合方法(如图4(d7)所示)与本发明所提算法效果相差不大,不仅能够保留可见光图像中的细节信息,而且能分辨出红外图像中的目标。

(2)客观评价

上述主观评价会受到主观因素的影响,为了更客观的评价本发明方法的有效性和适用性,本发明采用信息熵Q

表2四组红外与可见光图像在不同融合方法下的客观评价指标

由表可知:对于第一组融合图像,本发明算法的Q

由图5可以更直观的看出:对于指标Q

- 基于深度无监督密集卷积网络的红外和可见光图像融合方法

- 一种基于统一多尺度密集连接网络的红外与可见光图像融合方法