信息处理方法及信息处理系统

文献发布时间:2023-06-19 11:26:00

技术领域

本发明涉及对语音等音响进行合成的技术。

背景技术

以往提出了对任意音位的语音进行合成的语音合成技术。例如在专利文献1中公开了片段连接型的语音合成技术,其通过将多个语音片段之中的与目标的音位相应地选择出的语音片段相互地连接,从而生成音(以下称为“目标音”)。

专利文献1:日本特开2007-240564号公报

发明内容

近年的语音合成技术中,要求对由多样的发声者通过多样的发音风格发音的目标音进行合成。但是,为了通过片段连接型的语音合成技术应对以上的要求,需要针对发声者和发音风格的每个组合而单独地准备多个语音片段的集合。因此,存在为了准备语音片段而需要过大的工作量这样的问题。考虑以上的情况,本发明的一个方式的目的在于,不需要语音片段,生成使发音源(例如发声者)和发音风格的组合存在差异的多样的目标音。

为了解决以上的课题,本发明的一个方式所涉及的信息处理方法将表示发音源的发音源数据、表示发音风格的风格数据和表示发音条件的合成数据输入至通过机器学习而生成的合成模型,由此基于所述发音风格及所述发音条件而生成表示应该由所述发音源进行发音的目标音的音响特征的特征数据。

本发明的一个方式所涉及的信息处理系统具有合成处理部,该合成处理部将表示发音源的发音源数据、表示发音风格的风格数据和表示发音条件的合成数据输入至通过机器学习而生成的合成模型,由此基于所述发音风格及所述发音条件而生成表示应该由所述发音源进行发音的目标音的音响特征的特征数据。

本发明的一个方式所涉及的信息处理系统具有大于或等于1个处理器和大于或等于1个存储器,通过执行在所述大于或等于1个存储器中存储的程序,所述大于或等于1个处理器将表示发音源的发音源数据、表示发音风格的风格数据和表示发音条件的合成数据输入至通过机器学习而生成的合成模型,由此基于所述发音风格及所述发音条件而生成表示应该由所述发音源进行发音的音响的音响特征的特征数据。

附图说明

图1是例示实施方式所涉及的信息处理系统的结构的框图。

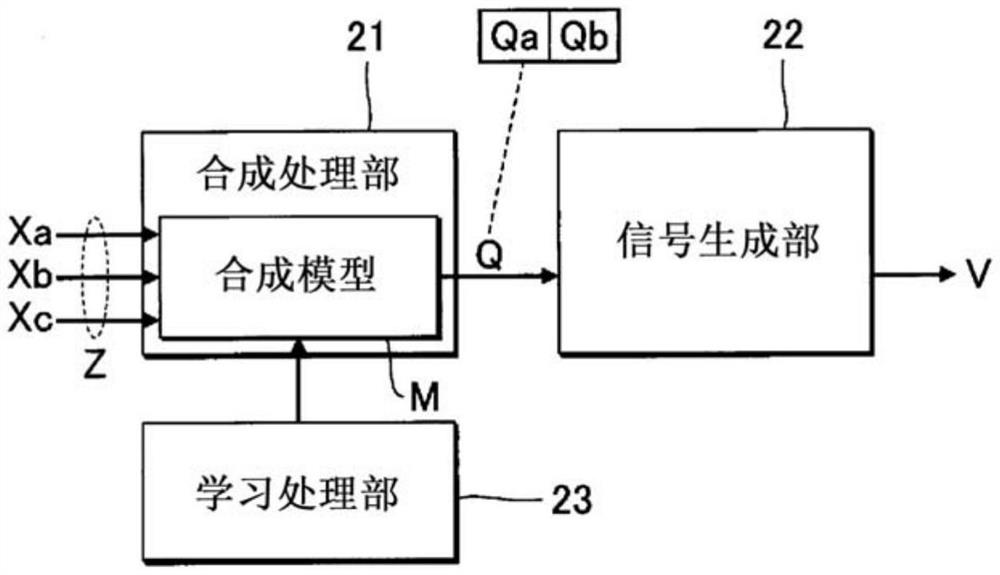

图2是例示信息处理系统的功能结构的框图。

图3是例示合成处理的具体顺序的流程图。

图4是学习处理的说明图。

图5的例示学习处理的具体顺序的流程图。

图6是补充处理的说明图。

图7是例示补充处理的具体顺序的流程图。

图8是例示第2实施方式中的合成模型的结构的框图。

图9是例示第3实施方式中的合成模型的结构的框图。

图10是变形例中的合成处理的说明图。

具体实施方式

<第1实施方式>

图1是例示第1实施方式所涉及的信息处理系统100的结构的框图。信息处理系统100是对由特定的歌唱者通过特定的歌唱风格虚拟地歌唱乐曲而发出的语音(以下称为“目标音”)进行生成的语音合成装置。歌唱风格(发音风格的例示)是指与例如歌唱方式相关的特征。例如与说唱(rap)、R&B(rhythm and blues)或者朋克(punk)等各种音乐类型的乐曲相适合的歌唱方式是歌唱风格的具体例。

第1实施方式的信息处理系统100是通过具有控制装置11、存储装置12、输入装置13和放音装置14的计算机系统实现的。例如移动电话、智能手机或者个人计算机等信息终端被利用为信息处理系统100。此外,信息处理系统100除了作为单体装置而实现以外,还可以通过相互地分体构成的多个装置的集合而实现。

控制装置11由对信息处理系统100的各要素进行控制的单个或者多个处理器构成。例如,控制装置11由CPU(Central Processing Unit)、SPU(Sound Processing Unit)、DSP(Digital Signal Processor)、FPGA(Field Programmable Gate Array)或者ASIC(Application Specific Integrated Circuit)等大于或等于1种的处理器构成。

输入装置13接收由利用者进行的操作。例如由利用者进行操作的操作件、或者对利用者的接触进行检测的触摸面板被利用为输入装置13。另外,也可以将能够语音输入的拾音装置利用为输入装置13。放音装置14对与来自控制装置11的指示相对应的音响进行播放。例如扬声器或者耳机是放音装置14的典型例。

存储装置12例如是由磁记录介质或者半导体记录介质等公知的记录介质构成的单个或者多个存储器,对由控制装置11执行的程序和由控制装置11使用的各种数据进行存储。此外,也可以通过多种记录介质的组合而构成存储装置12。另外,也可以将能够相对于信息处理系统100装卸的移动式记录介质、或者能够经由通信网与信息处理系统100通信的外部记录介质(例如在线储存器)利用为存储装置12。第1实施方式的存储装置12对多个(Na个)歌唱者数据Xa、多个(Nb个)风格数据Xb和合成数据Xc进行存储(Na及Nb各自为大于或等于2的自然数)。此外,歌唱者数据Xa的个数Na和风格数据Xb的个数Nb可以相同也可以不同。

第1实施方式的存储装置12对与不同的歌唱者相对应的Na个歌唱者数据Xa(发音源数据的例示)进行存储。各歌唱者的歌唱者数据Xa是表示由该歌唱者发音的歌唱音的音响特征(例如音质)的数据。第1实施方式的歌唱者数据Xa是多维的第1空间中的嵌入向量(embedding vector)。第1空间是与歌唱音的音响特征相应地决定空间内的各歌唱者的位置的连续空间。在歌唱者之间歌唱音的音响特征越类似,则第1空间内的该歌唱者之间的向量的距离成为越小的数值。如根据以上的说明所理解那样,第1空间表现为对与歌唱音的特征相关的歌唱者之间的关系进行表示的空间。利用者通过适当地操作输入装置13,从而对在存储装置12中存储的Na个歌唱者数据Xa的任意者的数据(即,期望的歌唱者的数据)进行选择。此外,关于歌唱者数据Xa的生成在后面记述。

第1实施方式的存储装置12对与不同的歌唱风格相对应的Nb个风格数据Xb进行存储。各歌唱风格的风格数据Xb是表示通过该歌唱风格进行发音的歌唱音的音响特征的数据。第1实施方式的风格数据Xb是多维的第2空间中的嵌入向量。第2空间是与歌唱音的音响特征相应地决定空间内的各歌唱风格的位置的连续空间。在歌唱风格之间歌唱音的音响特征越类似,则第2空间内的该歌唱风格之间的向量的距离成为越小的数值。即,如根据以上的说明所理解那样,第2空间表现为对与歌唱音的特征相关的歌唱风格之间的关系进行表示的空间。利用者通过适当地操作输入装置13,从而对在存储装置12中存储的Nb个风格数据Xb的任意者的数据(即期望的歌唱风格的数据)进行选择。关于风格数据Xb的生成在后面记述。

合成数据Xc对目标音的歌唱条件进行指定。第1实施方式的合成数据Xc是对于构成乐曲的多个音符分别指定音高、音位(发音文字)和发音期间的时间序列数据。合成数据Xc可以指定每个音符的音量等控制参数的数值。例如依照MIDI(Musical InstrumentDigital Interface)标准的格式的文件(SMF:Standard MIDI File)被利用为合成数据Xc。

图2是例示通过由控制装置11执行在存储装置12中存储的程序而实现的功能的框图。第1实施方式的控制装置11实现合成处理部21、信号生成部22和学习处理部23。此外,也可以通过相互地分体构成的多个装置而实现控制装置11的功能。可以将控制装置11的功能的一部分或者全部由专用的电子电路实现。

<合成处理部21及信号生成部22>

合成处理部21生成表示目标音的音响特征的特征数据Q的时间序列。第1实施方式的特征数据Q例如包含目标音的基本频率(音调)Qa和频谱包络Qb。频谱包络Qb是目标音的频谱的概略形状。特征数据Q是以每个规定长度(例如5毫秒)的单位期间而依次生成的。即,第1实施方式的合成处理部21生成基本频率Qa的时间序列和频谱包络Qb的时间序列。

信号生成部22根据特征数据Q的时间序列而生成音响信号V。在利用特征数据Q的时间序列而生成音响信号V时,例如利用公知的声码器技术。具体地说,信号生成部22相应于频谱包络Qb,调整与基本频率Qa对应的频谱中的每个频率的强度,将调整后的频谱变换为时间区域,由此生成音响信号V。由信号生成部22生成的音响信号V供给至放音装置14,由此目标音作为声波而从放音装置14进行辐射。此外,将音响信号V从信号变换为模拟信号的D/A变换器的图示为了方便起见而进行了省略。

在第1实施方式中,在通过合成处理部21进行的特征数据Q的生成时利用合成模型M。合成处理部21将输入数据Z输入至合成模型M。输入数据Z包含:Na个歌唱者数据Xa之中的由利用者选择出的歌唱者数据Xa、Nb个风格数据Xb之中的由利用者选择出的风格数据Xb和在存储装置12中存储的合成数据Xc。

合成模型M是对输入数据Z和特征数据Q的关系进行了学习的统计性预测模型。第1实施方式的合成模型M由深层神经网络(DNN:Deep Neural Network)构成。具体地说,合成模型M是通过使控制装置11执行根据输入数据Z而生成特征数据Q这一运算的程序(例如构成人工智能软件的程序模块)和应用于该运算的多个系数的组合而实现的。对合成模型M进行规定的多个系数由利用了多个学习数据的机器学习(特别是深层学习)进行设定而保存于存储装置12。关于合成模型M的机器学习在后面记述。

图3是例示由第1实施方式的控制装置11生成音响信号V的处理(以下称为“合成处理”)的具体顺序的流程图。例如以来自利用者的针对输入装置13的指示为契机而开始合成处理。

如果开始合成处理,则合成处理部21从利用者接收歌唱者数据Xa及风格数据Xb的选择(Sa1)。在与不同的乐曲相对应的多个合成数据Xc存储于存储装置12的情况下,合成处理部21可以从利用者接收对合成数据Xc的选择。合成处理部21通过将包含由利用者选择出的歌唱者数据Xa及风格数据Xb和在存储装置12中存储的合成数据Xc在内的输入数据Z输入至合成模型M,从而生成特征数据Q的时间序列(Sa2)。信号生成部22根据由合成处理部21生成的特征数据Q的时间序列而生成音响信号V(Sa3)。

如以上说明所述,在第1实施方式中,通过将歌唱者数据Xa、风格数据Xb和合成数据Xc输入至合成模型M,从而生成特征数据Q。因此,不需要语音片段就能够生成目标音。另外,在歌唱者数据Xa和合成数据Xc的基础上将风格数据Xb输入至合成模型M。因此,与生成与歌唱者数据Xa和合成数据Xc相对应的特征数据Q的结构相比较,存在下述优点,即,不必针对每个歌唱风格而准备歌唱者数据Xa,就能够生成与歌唱者和歌唱风格的组合相对应的多样的语音的特征数据Q。例如,通过对与歌唱者数据Xa一同选择的风格数据Xb进行变更,从而能够生成由特定的歌唱者通过不同的多种歌唱风格而发音出的目标音的特征数据Q。另外,通过对与风格数据Xb一同选择的歌唱者数据Xa进行变更,从而能够生成由多个歌唱者各自通过共通的歌唱风格而发音出的目标音的特征数据Q。

<学习处理部23>

图2的学习处理部23通过机器学习而生成合成模型M。通过学习处理部23进行机器学习后的合成模型M被利用于图3中的特征数据Q的生成(以下称为“推定处理”)Sa2。图4是用于说明通过学习处理部23进行的机器学习的框图。在合成模型M的机器学习时利用多个学习数据L。多个学习数据L存储于存储装置12。另外,在机器学习的结束判定中利用的评价用的学习数据(以下称为“评价用数据”)L也存储于存储装置12。

多个学习数据L各自包含识别信息Fa、识别信息Fb、合成数据Xc和音响信号V。识别信息Fa是用于对特定的歌唱者进行识别的数值列。例如,将与不同的歌唱者相对应的多个要素之中的与特定的歌唱者相对应的要素设定为数值1、将剩余的要素设定为数值0的one-hot表现的数值列,被利用为该特定的歌唱者的识别信息Fa。另外,识别信息Fb是用于对特定的歌唱风格进行识别的数值列。例如,将与不同的歌唱风格相对应的多个要素之中的与特定的歌唱风格相对应的要素设定为数值1、将剩余的要素设定为数值0的one-hot表现的数值列,被利用为该特定的歌唱风格的识别信息Fb。此外,关于识别信息Fa或者识别信息Fb,也可以采用对one-hot表现中的数值1和数值0进行了置换的one-cold表现。识别信息Fa、识别信息Fb和合成数据Xc的组合针对每个学习数据L而存在差异。但是,对于大于或等于2个学习数据L,识别信息Fa、识别信息Fb和合成数据Xc的一部分也可以是共通的。

任意的1个学习数据L所包含的音响信号V,是表示由识别信息Fa所表示的歌唱者通过识别信息fb所表示的歌唱风格对合成数据Xc所表示的乐曲进行歌唱的情况下的歌唱音的波形的信号。例如通过对由歌唱者实际发音出的歌唱音进行收录而事先准备音响信号V。

第1实施方式的学习处理部23将编码模型Ea及编码模型Eb与作为机器学习的原本目的的合成模型M一并进行训练。编码模型Ea是将歌唱者的识别信息Fa变换为该歌唱者的歌唱者数据Xa的编码器。编码模型Eb是将歌唱风格的识别信息Fb变换为该歌唱风格的风格数据Xb的编码器。编码模型Ea及编码模型Eb由例如深层神经网络构成。由编码模型Ea生成的歌唱者数据Xa、由编码模型Eb生成的风格数据Xb和学习数据L的合成数据Xc供给至合成模型M。如前所述,合成模型M输出与歌唱者数据Xa、风格数据Xb和合成数据Xc相对应的特征数据Q的时间序列。

特征解析部24根据各学习数据L的音响信号V而生成特征数据Q。特征数据Q包含例如基本频率Qa和频谱包络Qb。特征数据Q的生成是以每个规定长度(例如5毫秒)的单位期间反复进行的。即,特征解析部24根据音响信号V而生成基本频率Qa的时间序列和频谱包络Qb的时间序列。特征数据Q相当于与合成模型M的输出相关的已知的正确值。

学习处理部23针对合成模型M、编码模型Ea和编码模型Eb,分别反复地对多个系数进行更新。图5是例示由学习处理部23执行的处理(以下称为“学习处理”)的具体顺序的流程图。例如以来自利用者的针对输入装置13的指示为契机而开始学习处理。

如果开始学习处理,则学习处理部23对在存储装置12中存储的多个学习数据L的任意者进行选择(Sb1)。学习处理部23将从存储装置12选择出的学习数据L的识别信息Fa输入至暂定的编码模型Ea,并且将该学习数据L的识别信息Fb输入至暂定的编码模型Eb(Sb2)。编码模型Ea生成与识别信息Fa相对应的歌唱者数据Xa。编码模型Eb生成与识别信息Fb相对应的风格数据Xb。

学习处理部23将包含由编码模型Ea生成的歌唱者数据Xa及由编码模型Eb生成的风格数据Xb和学习数据L的合成数据Xc在内的输入数据Z输入至暂定的合成模型M(Sb3)。合成模型M生成与输入数据Z相对应的特征数据Q。

学习处理部23对评价函数进行计算,该评价函数表示由合成模型M生成的特征数据Q和根据学习数据L的音响信号V而由特征解析部24生成的特征数据Q(即,正确值)的误差(Sb4)。例如向量间距离或者交叉熵等指标被利用为评价函数。学习处理部23对合成模型M、编码模型Ea和编码模型Eb各自的多个系数进行更新,以使得评价函数接近规定值(典型情况为零)(Sb5)。在与评价函数相对应的多个系数的更新时利用例如误差反向传播法。

学习处理部23对是否以规定次数反复进行了以上说明的更新处理(Sb2~Sb5)进行判定(Sb61)。在更新处理的反复次数低于规定值的情况下(Sb61:NO),学习处理部23在从存储装置12选择接下来的学习数据L(Sb1)后,针对该学习数据L执行更新处理(Sb2~Sb5)。即,针对多个学习数据L分别反复进行更新处理。

在更新处理(Sb2~Sb5)的次数达到规定值的情况下(Sb61:YES),学习处理部23对由更新处理后的合成模型M生成的特征数据Q是否达到规定品质进行判定(Sb62)。在评价特征数据Q的品质时利用在存储装置12中存储的前述的评价用数据L。具体地说,学习处理部23对由合成模型M根据评价用数据L生成的特征数据Q和根据评价用数据L的音响信号V由特征解析部24生成的特征数据Q(正确值)的误差进行计算。学习处理部23与特征数据Q间的误差是否低于规定的阈值相应地,对特征数据Q是否达到规定品质进行判定。

在特征数据Q没有达到规定品质的情况下(Sb62:NO),学习处理部23开始反复进行规定次数的更新处理(Sb2~Sb5)。如根据以上的说明所理解那样,在每次反复进行规定次数的更新处理时对特征数据Q的品质进行评价。在特征数据Q达到规定品质的情况下(Sb62:YES),学习处理部23将该时刻的合成模型M确定为最终的合成模型M(Sb7)。即,最新的更新后的多个系数存储于存储装置12。通过以上的顺序确定出的训练好的合成模型M被利用于前述的推定处理Sa2。

如根据以上的说明所理解那样,训练好的合成模型M基于在与各学习数据L相对应的输入数据Z和与该学习数据L的音响信号V相对应的特征数据Q之间潜在的倾向,能够针对未知的输入数据Z而生成在统计上妥当的特征数据Q。即,合成模型M对输入数据Z和特征数据Q之间的关系进行学习。

另外,编码模型Ea对识别信息Fa和歌唱者数据Xa之间的关系进行学习,以使得合成模型M能够根据输入数据Z而生成在统计上妥当的特征数据Q。学习处理部23通过将Na个识别信息Fa各自依次输入至训练好的编码模型Ea,从而生成Na个歌唱者数据Xa(Sb8)。按照以上的顺序由编码模型Ea生成的Na个歌唱者数据Xa用于推定处理Sa2而存储于存储装置12。在存储有Na个歌唱者数据Xa的阶段,不需要训练好的编码模型Ea。

同样地,编码模型Eb对识别信息Fb和风格数据Xb之间的关系进行学习,以使得合成模型M能够根据输入数据Z而生成在统计上妥当的特征数据Q。学习处理部23通过将Nb个识别信息Fb各自依次输入至训练好的编码模型Eb,从而生成Nb个风格数据Xb(Sb9)。按照以上的顺序由编码模型Eb生成的Nb个风格数据Xb用于推定处理Sa2而存储于存储装置12。在存储有Nb个风格数据Xb的阶段,不需要训练好的编码模型Eb。

<新的歌唱者的歌唱者数据Xa的生成>

如果利用训练好的编码模型Ea而生成了Na个歌唱者数据Xa,则不需要该编码模型Ea。因此,编码模型Ea在Na个歌唱者数据Xa生成后被废弃。但是,关于没有生成歌唱者数据Xa的新的歌唱者(以下称为“新歌唱者”),有可能事后需要生成歌唱者数据Xa。第1实施方式的学习处理部23利用与新歌唱者相对应的多个学习数据Lnew和训练好的合成模型M,生成新歌唱者的歌唱者数据Xa。

图6是由学习处理部23生成新歌唱者的歌唱者数据Xa的处理(以下称为“补充处理”)的说明图。多个学习数据Lnew各自包含对由新歌唱者通过特定的歌唱风格歌唱乐曲时的歌唱音进行表示的音响信号V和该乐曲的合成数据Xc(新合成数据的一个例子)。学习数据Lnew的音响信号V是通过对由新歌唱者实际发音出的歌唱音进行收录而事先准备的。特征解析部24根据各学习数据Lnew的音响信号V而生成特征数据Q的时间序列。另外,歌唱者数据Xa作为学习对象的变量而供给至合成模型M。

图7是例示补充处理的具体顺序的流程图。如果开始补充处理,则学习处理部23对在存储装置12中存储的多个学习数据Lnew的任意者进行选择(Sc1)。学习处理部23将设定为初始值的歌唱者数据Xa(新发音源数据的一个例子)、与新歌唱者的歌唱风格相对应的已有的风格数据Xb和从存储装置12选择出的学习数据Lnew的合成数据Xc输入至训练好的合成模型M(Sc2)。歌唱者数据Xa的初始值例如设定为随机数。合成模型M生成与风格数据Xb和合成数据Xc相对应的特征数据Q(新特征数据的一个例子)。

学习处理部23对评价函数进行计算,该评价函数表示由合成模型M生成的特征数据Q和根据学习数据Lnew的音响信号V而由特征解析部24生成的特征数据Q(即,正确值)的误差(Sc3)。由特征解析部24生成的特征数据Q是“已知特征数据”的一个例子。学习处理部23对歌唱者数据Xa和合成模型M的多个系数进行更新,以使得评价函数接近规定值(典型情况为零)(Sc4)。此外,也可以在将合成模型M的多个系数固定不变的情况下,对歌唱者数据Xa进行更新以使得评价函数接近规定值。

学习处理部23对是否反复进行了规定次数以上说明的追加更新(Sc2~Sc4)进行判定(Sc51)。在追加更新的次数低于规定值的情况下(Sc51:NO),学习处理部23在从存储装置12选择接下来的学习数据Lnew后(Sc1),针对该学习数据Lnew而执行追加更新(Sc2~Sc4)。即,针对多个学习数据Lnew分别反复进行追加更新。

在追加更新(Sc2~Sc4)的次数达到规定值的情况下(Sc51:YES),学习处理部23对通过追加更新后的合成模型M生成的特征数据Q是否达到规定品质进行判定(Sc52)。在特征数据Q的品质的评价时与前述的例示同样地利用评价用数据L。在特征数据Q没有达到规定品质的情况下(Sc52:NO),学习处理部23开始遍及规定次数的追加更新(Sc2~Sc4)的反复进行。如根据以上的说明所理解那样,在遍及规定次数的追加更新的每次反复进行时对特征数据Q的品质进行评价。在特征数据Q达到规定品质的情况下(Sc52:YES),学习处理部23,学习处理部23将最新的更新后的多个系数和歌唱者数据Xa作为确定值而储存于存储装置12(Sc6)。新歌唱者的歌唱者数据Xa在用于对由新歌唱者发出的歌唱音进行合成的合成处理中被应用。

此外,补充处理前的合成模型M是利用多样的歌唱者的学习数据L而训练好的,因此即使在对于新歌唱者无法准备充分个数的学习数据Lnew的情况下,也能够生成新歌唱者的多样的目标音。例如,对于新歌唱者的不存在学习数据Lnew的音位或者音高,通过利用训练好的合成模型M,从而也能够健全地生成高品质的目标音。即,具有不需要新歌唱者的充分的学习数据Lnew(例如包含全部种类的音素的发音在内的学习数据),就能够生成该新歌唱者的目标音这一优点。

另外,关于利用仅1名歌唱者的学习数据L而训练好的合成模型M,如果利用其他新歌唱者的学习数据Lnew而执行再学习,则有时合成模型M的多个系数大幅地变化。第1实施方式的合成模型M是利用许多歌唱者的学习数据L而训练好的。因此,即使执行利用了新歌唱者的学习数据Lnew的再学习,合成模型M的多个系数也不会大幅地变化。

<第2实施方式>

对第2实施方式进行说明。此外,关于在以下的各例示中功能与第1实施方式相同的要素,沿用在第1实施方式的说明中使用的标号而适当地省略各自的详细说明。

图8是例示第2实施方式中的合成模型M的结构的框图。第2实施方式的合成模型M包含第1训练好的模型M1和第2训练好的模型M2。第1训练好的模型M1由例如长短期存储(LSTM:Long Short Term Memory)等递归型神经网络(RNN:Recurrent Neural Network)构成。第2训练好的模型M2由例如卷积神经网络(CNN:Convolutional Neural Network)构成。第1训练好的模型M1及第2训练好的模型M2是通过利用了多个学习数据L的机器学习对多个系数进行更新后的训练好的模型。

第1训练好的模型M1与包含歌唱者数据Xa、风格数据Xb和合成数据Xc在内的输入数据Z相应地生成中间数据Y。中间数据Y是表示与乐曲歌唱相关的多个要素各自的时间序列的数据。具体地说,中间数据Y表示音高(例如音名)的时间序列、歌唱中的音量的时间序列和音素的时间序列。即,在由歌唱者数据Xa所表示的歌唱者通过风格数据Xb所表示的歌唱风格而歌唱出合成数据Xc的乐曲时的音高、音量和音素的时间性变化通过中间数据Y表现。

第2实施方式的第1训练好的模型M1具有第1生成模型G1和第2生成模型G2。第1生成模型G1根据歌唱者数据Xa和风格数据Xb而生成表情数据D1。表情数据D1是表示歌唱音的音乐性表情的特征的数据。如根据以上的说明所理解那样,表情数据D1是与歌唱者数据Xa和风格数据Xb的组合相应地生成的。第2生成模型G2与在存储装置12中存储的合成数据Xc和由第1生成模型G1生成的表情数据D1相应地生成中间数据Y。

第2训练好的模型M2与在存储装置12中存储的歌唱者数据Xa和由第1训练好的模型M1生成的中间数据Y相应地生成特征数据Q(基本频率Qa及频谱包络Qb)。如图8例示那样,第2训练好的模型M2具有第3生成模型G3、第4生成模型G4和第5生成模型G5。

第3生成模型G3生成与歌唱者数据Xa相对应的发音数据D2。发音数据D2是表示歌唱者的发音机构(例如声带)及调音机构(例如声道)的特征的数据。例如,由歌唱者的发音机构及调音机构对歌唱音赋予的频率特性通过发音数据D2表现。

第4生成模型G4(第1生成模型的例示)与由第1训练好的模型M1生成的中间数据Y和由第3生成模型G3生成的发音数据D2相应地生成特征数据Q的基本频率Qa的时间序列。

第5生成模型G5(第2生成模型的例示)与由第1训练好的模型M1生成的中间数据Y、由第3生成模型G3生成的发音数据D2和由第4生成模型G4生成的基本频率Qa的时间序列相应地生成特征数据Q的频谱包络Qb的时间序列。即,第5生成模型G5与由第4生成模型G4生成的基本频率Qa的时间序列相应地生成目标音的频谱包络Qb的时间序列。包含由第4生成模型G4生成的基本频率Qa和由第5生成模型G5生成的频谱包络Qb在内的特征数据Q的时间序列供给至信号生成部22。

在第2实施方式中也实现与第1实施方式相同的效果。另外,在第2实施方式中,合成模型M包含生成基本频率Qa的时间序列的第4生成模型G4和生成频谱包络Qb的时间序列的第5生成模型G5。因此,具有下述优点,即,能够明示地学习输入数据Z和基本频率Qa的时间序列之间的关系。

<第3实施方式>

图9是例示第3实施方式中的合成模型M的结构的框图。第3实施方式中的合成模型M的结构与第2实施方式相同。即,第3实施方式的合成模型M包含生成基本频率Qa的时间序列的第4生成模型G4和生成频谱包络Qb的时间序列的第5生成模型G5。

第3实施方式的控制装置11在与第1实施方式相同的要素(合成处理部21、信号生成部22及学习处理部23)的基础上,还作为图9的编辑处理部26起作用。编辑处理部26与来自利用者的针对输入装置13的指示相应地,对由第4生成模型G4生成的基本频率Qa的时间序列进行编辑。

第5生成模型G5与由第1训练好的模型M1生成的中间数据Y、由第3生成模型G3生成的发音数据D2和通过编辑处理部26进行编辑后的基本频率Qa的时间序列相应地生成特征数据Q的频谱包络Qb的时间序列。包含通过编辑处理部26进行编辑后的基本频率Qa和由第5生成模型G5生成的频谱包络Qb在内的特征数据Q的时间序列供给至信号生成部22。

在第3实施方式中也实现与第1实施方式相同的效果。另外,在第3实施方式中,与根据来自利用者的指示进行编辑后的基本频率Qa的时间序列相应地生成频谱包络Qb的时间序列,因此能够生成在基本频率Qa的时间性变化中反映了利用者的意图的目标音。

<变形例>

下面,例示对以上例示出的各方式附加的具体的变形方式。可以将从下面的例示中任意地选择出的大于或等于2个方式在不相互矛盾的范围适当地合并。

(1)在前述的各方式中,在合成模型M的训练后将编码模型Ea及编码模型Eb废弃,但也可以如图10例示那样,将编码模型Ea及编码模型Eb与合成模型M一起利用于合成处理。在图10的结构中,输入数据Z包含歌唱者的识别信息Fa、歌唱风格的识别信息Fb和合成数据Xc。由编码模型Ea根据识别信息Fa生成的歌唱者数据Xa、由编码模型Eb根据识别信息Fb生成的风格数据Xb和输入数据Z的合成数据Xc输入至合成模型M。

(2)在前述的各方式中,例示出特征数据Q包含基本频率Qa和频谱包络Qb的结构,但特征数据Q的内容并不限定于以上的例示。例如,表示频谱的特征(以下称为“谱特征”)的各种数据也可以用作特征数据Q。作为能够用作特征数据Q的频谱特征,除了前述的频谱包络Qb以外,例如还例示出梅尔谱(Mel spectrum)、梅尔倒谱(Mel cepstrum)、梅尔频谱图(Mel spectrogram)或者频谱图(spectrogram)。此外,在将能够确定基本频率Qa的谱特征用作特征数据Q的结构中,也可以从特征数据Q将基本频率Qa省略。

(3)在前述的各方式中,关于新歌唱者通过补充处理生成了歌唱者数据Xa,但生成歌唱者数据Xa的方法并不限定于以上的例示。例如,通过对多个歌唱者数据Xa进行插补或者外推,从而也可以生成新的歌唱者数据Xa。通过对歌唱者A的歌唱者数据Xa和歌唱者B的歌唱者数据Xa进行插补,从而生成以歌唱者A和歌唱者B的中间的音质进行发声的虚拟性的歌唱者的歌唱者数据Xa。

(4)在前述的各方式中,例示出具有合成处理部21(及信号生成部22)和学习处理部23这两者的信息处理系统100,但也可以将合成处理部21和学习处理部23搭载于分体的信息处理系统。具有合成处理部21及信号生成部22的信息处理系统作为根据输入数据Z生成音响信号V的语音合成装置而被实现。在语音合成装置中可以有也可以没有学习处理部23。另外,具有学习处理部23的信息处理系统,作为通过利用了多个学习数据L的机器学习而生成合成模型M的机器学习装置而被实现。在机器学习装置中可以有也可以没有合成处理部21。可以通过能够与终端装置进行通信的服务器装置而实现机器学习装置,将由机器学习装置生成的合成模型M传送至终端装置。终端装置具有合成处理部21,该合成处理部21利用从机器学习装置传送出的合成模型M而执行合成处理。

(5)在前述的各方式中,对由歌唱者发音出的歌唱音进行了合成,但在除了歌唱音以外的音响的合成中也可以应用本发明。例如在不以音乐为必要条件的会话音等一般性的说话声的合成、或者乐器的演奏音的合成中也可以应用本发明。歌唱者数据Xa相当于除了歌唱者以外还表示包含说话者或者乐器等在内的发音源的发音源数据的一个例子。另外,风格数据Xb作为除了歌唱风格以外还表示包含说话风格或者乐器演奏的风格等在内的发音风格(performance style)的数据而统括地表现。合成数据Xc作为除了歌唱条件以外还表示包含说话条件(例如音位)或者演奏条件(例如音高及音量)在内的发音条件的数据而统括地表现。在与乐器的演奏相关的合成数据Xc中省略音位的指定。

此外,风格数据Xb所表示的发音风格(发音条件)包含发音环境及收录环境。发音环境例如是指无响室、回响室或者屋外等环境,收录环境例如是指利用了数字器材的收录或者利用了模拟磁带介质的收录等的环境。利用包含发音环境或者收录环境不同的音响信号V的学习数据L,对编码模型或者合成模型M进行训练。

此外,存在与时代时代的音乐类型相对应的演奏场所、录音器材。鉴于该点,风格数据Xb所示的发音风格可以是表示发音环境、收录环境的风格。更具体地说,发音环境例如是“在无响室内演奏出的音”、“在回响室内演奏出的音”、“在屋外演奏出的音”等,收录环境例如是“记录于数字器材的音”、“记录于模拟磁带介质的音”的类别等。

(6)前述的各方式所涉及的信息处理系统100的功能是通过计算机(例如控制装置11)和程序的协同动作实现的。本发明的一个方式所涉及的程序以储存于计算机可读取的记录介质的方式提供而安装于计算机。记录介质例如是非易失性(non-transitory)的记录介质,CD-ROM等光学式记录介质(光盘)是优选例,但也可包含半导体记录介质或者磁记录介质等公知的任意形式的记录介质。此外,非易失性的记录介质包含除了瞬时传输信号(transitory,propagating signal)以外的任意的记录介质,并不是将易失性的记录介质排除在外。另外,也能够以经由通信网的传送方式将程序提供给计算机。

(7)用于实现合成模型M的人工智能软件的执行主体并不限定于CPU。例如,TensorProcessing Unit或者Neural Engine等神经网络专用的处理电路、或者人工智能专用的DSP(Digital Signal Processor)可以执行人工智能软件。另外,可以是从以上的例示选择出的多种处理电路协同动作而执行人工智能软件。

<附记>

根据以上例示出的方式,例如掌握下面的结构。

本发明的一个方式(第1方式)所涉及的信息处理方法将表示发音源的发音源数据、表示发音风格的风格数据和表示发音条件的合成数据输入至通过机器学习而生成的合成模型,由此基于所述发音风格及所述发音条件而生成表示应该由所述发音源进行发音的目标音的音响特征的特征数据。在以上的方式中,通过将发音源数据、合成数据和风格数据输入至机器学习好的合成模型,从而生成表示目标音的音响特征的特征数据。因此,不需要语音片段就能够生成目标音。另外,在发音源数据和合成数据的基础上将风格数据输入至合成模型。因此,与通过将发音源数据和合成数据输入至训练好的模型而生成特征数据的结构相比较,具有下述优点,即,不针对每个发音风格准备发音源数据,就能够生成与发音源和发音风格的组合相对应的多样的语音的特征数据。

在第1方式的具体例(第2方式)中,所述发音条件包含针对每个音符的音高。另外,在第1方式或第2方式的具体例(第3方式)中,所述发音条件包含针对每个音符的音位。第3方式中的发音源为歌唱者。

在第1方式至第3方式的任意方式的具体例(第4方式)中,向所述合成模型输入的发音源数据是与不同的发音源相对应的多个发音源数据之中的由利用者选择出的发音源数据。根据以上的方式,例如能够对于与利用者的意图或者爱好相吻合的发音源而生成目标音的特征数据。

在第1方式至第4方式的任意方式的具体例(第5方式)中,向所述合成模型输入的风格数据是与不同的发音风格相对应的多个风格数据之中的由利用者选择出的风格数据。根据以上的方式,例如能够对于与利用者的意图或者爱好相吻合的发音风格而生成目标音的特征数据。

第1方式至第5方式的任意方式的具体例(第6方式)所涉及的信息处理方法还通过将表示新发音源的新发音源数据、表示与所述新发音源相对应的发音风格的风格数据和表示由所述新发音源进行的发音的发音条件的新合成数据输入至所述合成模型,由此基于所述新发音源的发音风格及由所述新发音源进行的发音的发音条件而生成表示由所述新发音源进行发音的音响的音响特征的新特征数据,对所述新发音源数据及所述合成模型进行更新,以使得与基于所述新合成数据所表示的发音条件而由所述新发音源发音出的音响相关的已知特征数据和所述新特征数据的差异减少。根据以上的方式,即使在对于新发音源无法充分地准备新合成数据和音响信号的情况下,也能够生成合成模型,该合成模型能够健全地生成与新发音源相关的高品质的目标音。

在第1方式至第6方式的任意方式的具体例(第7方式)中,所述发音源数据表示第1空间中的向量,所述第1空间表示与由不同的多个发音源进行发音的音响的特征相关的所述多个发音源之间的关系,所述风格数据表示第2空间中的向量,所述第2空间表示与通过不同的多个发音风格进行发音的音响的特征相关的所述多个发音风格之间的关系。根据以上的方式,能够利用发音源数据和风格数据而生成与发音源和发音风格的组合相对应的适当的合成音的特征数据,其中,发音源数据是根据与音响的特征相关的发音源之间的关系这一观点表现的,风格数据是根据与音响的特征相关的发音风格之间的关系这一观点表现的。

在第1方式至第7方式的任意方式的具体例(第8方式)中,所述合成模型包含第1生成模型和第2生成模型,该第1生成模型生成所述目标音的基本频率的时间序列,该第2生成模型与由所述第1生成模型生成的基本频率的时间序列相应地生成所述目标音的频谱包络的时间序列。根据以上的方式,合成模型包含生成目标音的基本频率的时间序列的第1生成模型和生成目标音的频谱包络的时间序列的第2生成模型,因此能够明示地学习包含发音源数据、风格数据和合成数据在内的输入和基本频率的时间序列之间的关系。

在第8方式的具体例(第9方式)中,与来自利用者的指示相应地对由所述第1生成模型生成的基本频率的时间序列进行编辑,所述第2生成模型与所述编辑后的基本频率的时间序列相应地生成所述目标音的频谱包络的时间序列。根据以上的方式,与根据来自利用者的指示进行编辑后的基本频率的时间序列相应地生成频谱包络的时间序列,因此能够生成在基本频率的时间性变化中反映了利用者的意图的目标音。

作为执行以上例示出的各方式的信息处理方法的信息处理系统、或者使计算机执行以上例示出的各方式的信息处理方法的程序,也会实现本发明的各方式。

标号的说明

100…信息处理系统,11…控制装置,12…存储装置,13…输入装置,14…放音装置,21…合成处理部,22…信号生成部,23…学习处理部,24…特征解析部,26…编辑处理部,M…合成模型,Xa…歌唱者数据,Xb…风格数据,Xc…合成数据,Z…输入数据,Q…特征数据,V…音响信号,Fa、Fb…识别信息,Ea、Eb…编码模型,L、Lnew…学习数据。

- 细胞观察信息处理系统、细胞观察信息处理方法、细胞观察信息处理程序、细胞观察信息处理系统具有的记录部和细胞观察信息处理系统具有的装置

- 信息处理系统、信息处理装置、信息处理系统的信息处理方法、记录介质和车内部共享系统