一种基于激光雷达与相机融合的远距离目标感知方法

文献发布时间:2023-06-19 12:02:28

技术领域

本发明涉及自动驾驶技术领域,特别是关于一种基于激光雷达与相机融合的 远距离目标感知方法。

背景技术

环境感知是自动驾驶发展的基础。随着传感器技术的发展,鲁棒而有效的环 境感知算法研究受到了广泛的关注。适用于自动驾驶的传感器种类繁多,且各有 优缺点。激光雷达能获取环境三维空间信息,得到目标的轮廓特征,但通常点云 数据量大,这将给实时感知带来挑战。照相机的感知数据与人眼获取的直观信息 最接近,能够得到目标的颜色、纹理等信息,但该传感器受光照影响大,且造成 环境空间信息缺失。为弥补两种类型传感器的感知缺陷,提高自动驾驶传感器系 统感知能力,多源信息融合成为了更优的解决方案。

现有技术可通过融合激光雷达点云和相机视觉图像完成实时的道路目标检 测,但目前仍难以覆盖远距离障碍物的准确检测。由于距离自动驾驶车辆距离较 远的目标返回的点云稀少,且图像中占据的数量较小,往往难以获得准确的感知 结果。而远距离目标检测对于扩展自动驾驶车辆鲁棒感知范围具有重要意义。

发明内容

本发明的目的在于提供一种基于激光雷达与相机融合的远距离目标感知方 法来克服或至少减轻现有技术的上述缺陷中的至少一个。

为实现上述目的,本发明提供一种基于激光雷达与相机融合的远距离目标感 知方法,该方法包括:

步骤1,采集激光雷达点云数据,确定光学图像感兴趣区域,并获取目标在 所述光学图像感兴趣区域中隶属于n种类型障碍物的概率合集

步骤2,获取目标在所述激光雷达点云数据中隶属于n种类型障碍物的概率 合集

步骤3,融合所述F

其中,ω

进一步地,所述步骤1中的所述f

步骤11,点云地面分割,获得地上点云;

步骤12,将所述地上点云中特征相似的点云设置成一个点云聚类;

步骤13,利用尺度预设值对所述点云聚类进行滤波;

步骤14,将滤波后的点云聚类转换成点云聚类图像投影;

步骤15,根据每一个所述点云聚类图像投影中的横坐标最大值u

步骤16,利用SINet网络对所述光学图像感兴趣区域进行目标检测,输出f

进一步地,所述步骤11具体包括:

步骤111,在所述采集激光雷达点云数据中选取激光雷达坐标系中x>0的点 云作为第一点云;

步骤112,在所述第一点云中选取与所述光学图像感兴趣区域的可视范围相 重合区域内的点云作为第二点云;

步骤113,滤除所述第二点云中隶属于地面的点云,留下的所述第二点云作 为地上点云。

进一步地,所述步骤15中的“合并具有重合区域的所述矩形框”的过程具体 包括:

步骤151,在像素坐标系中,将放大后的所述矩形框的选定顶点的坐标中u值 大小进行排序;

步骤152,按照所述步骤151的排序,遍历所有所述矩形框,依次以每一个所 述矩形框作为参照框,判断所述参照框与其相邻的所述矩形框在所述光学图像感 兴趣区域中是否彼此分隔,若是,则进行新的光学图像感兴趣区域合并;反之, 则将两个所述矩形框进行合并。

进一步地,所述步骤151中的所述矩形框的选定顶点设置在该矩形框的左上 角点p′

进一步地,所述步骤152将第i所述矩形框和第i+1所述矩形框合并为新矩形 框s时,所述新矩形框s的右边界

进一步地,所述步骤14利用式(1)提供的图像投影变换关系,将所述点云 聚类转换成所述点云聚类图像投影:

其中,p

进一步地,所述步骤16还输出目标的矩形框;

所述步骤2中的所述f

步骤21,检测所述矩形框中对应的点云聚类,并对检测出的点云聚类进行点 云积累及分类运算;

步骤22,在步骤21得到的上一时刻的点云聚类中寻找关联目标,将当前时刻 包含点云数量小于数量预设值的点云聚类进行目标关联及点云配准积累,获得积 累点云;

步骤23,利用深度神经网络,对所述积累点云进行点云分类,并输出所述f

进一步地,所述步骤22中的目标关联的方法具体包括:

以当前时刻自动驾驶车辆坐标为基准,将上一时刻所述点云聚类转换到当前 时刻坐标系中,以目标b中心为圆心,半径r=δt·v

本发明通过基于SINet网络的图像检测和结合点云时间积累的点云分类,利 用多源信息融合综合两种算法在远距离缺失数据下的感知优势,对目标尺度变化 不敏感的SINet网络进行光学图像感兴趣区域感知,以提升相机对小目标的感知 能力,最大限度剔除图像非RoI,降低检测方法整体时间消耗。本发明还将点云 历史数据引入检测框架中进行积累,以增强点云数据对远距离稀疏点云情况下目 标感知性能。另外,本发明提供结合点云积累的点云分类方法,增加远距离目标 返回的点云数据量,进而提升点云分类准确性。

附图说明

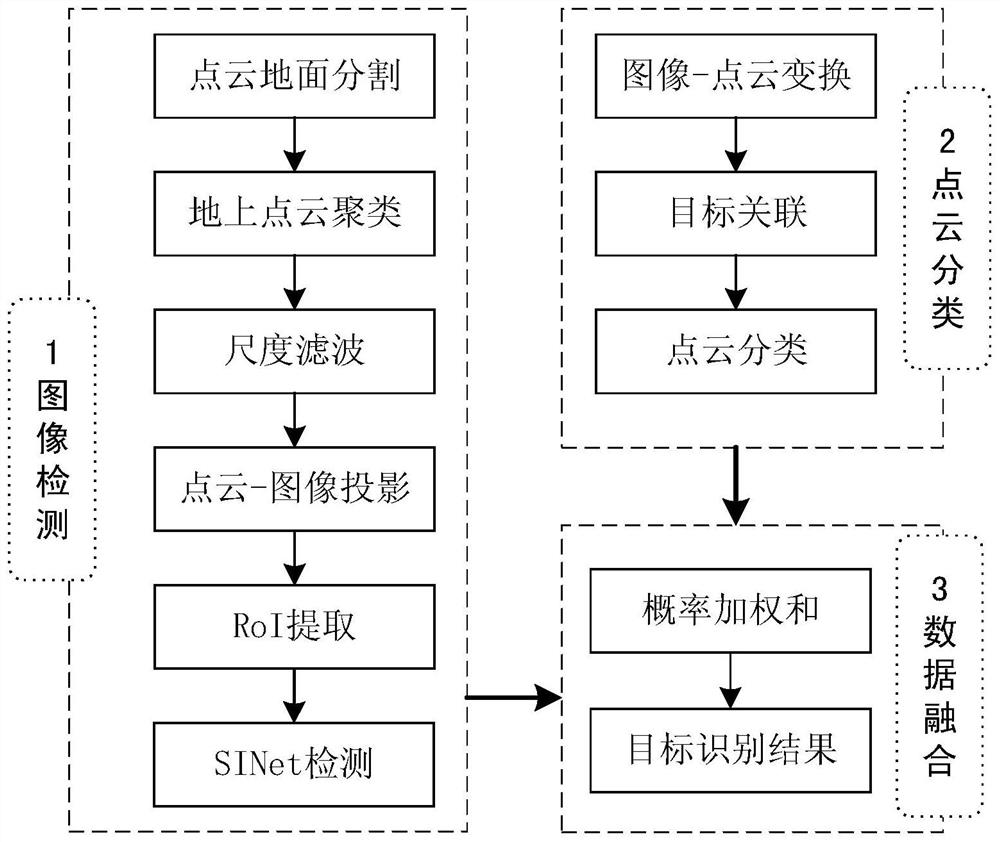

图1为本发明实施例提供的融合感知流程示意图。

图2为本发明实施例提供的合并矩形框的示意图。

图3为本发明实施例提供的图像检测SINet网络的结构示意图。

图4为本发明实施例提供的点云分类网络的结构示意图。

图5为本发明实施例提供的合并具有重合区域的所述矩形框的一种实现方 式示意图。

图6为本发明实施例提供的进行新的光学图像感兴趣区域合并的示例。

具体实施方式

下面结合附图和实施例对本发明进行详细的描述。

如图1所示,本发明实施例所提供的远距离目标感知方法主要包括:

步骤1,采集激光雷达点云数据,确定光学图像感兴趣区域以及利用深度神 经网络检测图像中的交通障碍物,并获取目标在所述光学图像感兴趣区域中隶属 于n种类型障碍物的概率合集

步骤2,获取目标在所述激光雷达点云数据中隶属于n种类型障碍物的概率 合集

步骤3,步骤1和步骤2分别从图像处理和点云处理角度得到同一目标分属不 同类型障碍物的概率,本步骤利用加权平均和对两种数据中的检测概率融合F

其中,ω

本实施例提出的基于激光雷达与相机融合的远距离目标检测方法综合利用 光学图像感兴趣区域和点云数据下远距离目标检测的能力进行融合,以解决远距 离图像模糊、点云稀疏造成目标感知能力差的问题。利用光学图像感兴趣区域与 激光雷达数据特点相互补足,增强远距离目标感知能力。

在一个实施例中,步骤1中的所述f

步骤11,点云地面分割,获得地上点云。

优选地,步骤11具体包括:

步骤111,在所述采集激光雷达点云数据中选取激光雷达坐标系中x>0的点 云作为第一点云。其中,激光雷达坐标系定义为:原点为激光雷达中心,x轴的 正方向为车辆车身纵向前进的方向,y轴的正方向为车辆车身横向且位于x轴正 方向的左侧,z轴的正方向为车辆车身的高度方向且垂直地面向上。

步骤112,在所述第一点云中选取与所述光学图像感兴趣区域的可视范围相 重合区域内的点云作为第二点云。

步骤113,滤除所述第二点云中隶属于地面的点云,留下的所述第二点云作 为地上点云。其中,可以使用扩展卡尔曼滤波平面状态跟踪、随机抽样一致性地 面拟合、高斯过程回归地面建模等方式建立地面高程模型等地面建模方式,滤除 所述第二点云中隶属于地面的点云。点云地面分割方法可以使用基于RANSAC(随 机抽样一致性)的地面平面拟合,基于最小二乘拟合的地面分割方法等。

通过步骤11,可以滤除点云中的地面返回值,降低后续点云处理的计算量。

步骤12,将所述地上点云中特征相似的点云设置成一个点云聚类。例如:可 以使用k-means聚类、基于密度的算法等,利用点云空间和属性等特征相似性, 将地上点云中特征相似的点云聚为一个类别,完成障碍物的空间分割。

步骤13,利用尺度预设值对所述点云聚类进行滤波。其中,尺度预设值包括 长度阈值T

步骤14,将滤波后的点云聚类转换成点云聚类图像投影。

比如:可以利用式(1)提供的图像投影变换关系,将每个点云聚类转换成 光学图像感兴趣区域上的投影,文中简称为点云聚类图像投影:

其中,p

步骤15,根据每一个所述点云聚类图像投影中的横坐标最大值u

由于环境中障碍物间可能存在遮挡,为更好地检测环境中的障碍物,放大各 所述矩形框、以及合并具有重合区域的所述矩形框,获得光学图像感兴趣区域。

作为“合并具有重合区域的所述矩形框”的一种实现方式,其包括:

步骤151,在像素坐标系中,将放大后的所述矩形框的选定顶点的坐标中u值 大小进行排序。需要说明的是,实际环境中目标返回的点云数据可能受到遮挡等 因素影响,无法反映出完整的目标轮廓,直接变换时往往矩形框中的目标显示不 全,所以本实施例通过对矩形框进行放大,尽量能将一个目标完整地框入到矩形 框中。

步骤151中的所述矩形框的选定顶点设置在该矩形框的左上角点p′

当然,在选定顶点的位置设置在矩形框的其它位置时,公式将在式(2)的 基础上做出相应修改即可。

例如图5,图中的1、2为场景中的目标,1的部分被2遮挡(虚线显示),假设 通过前述步骤15获得的矩形框为3,可以看出因为存在遮挡,3无法包含1全部信 息,因此设置安全边界α,横坐标最大值u

步骤152,按照步骤151的排序,遍历所有所述矩形框,依次以每一个所述矩 形框作为参照框,判断所述参照框与其相邻的所述矩形框在所述光学图像感兴趣 区域中是否彼此分隔,若是,则进行新的光学图像感兴趣区域合并;反之,则将 两个所述矩形框进行合并。

例如:如图2所示,步骤152将第i所述矩形框和第i+1所述矩形框合并为新 矩形框s时,可以采用:

根据各个矩形框的左上角点p′

也可以采用:

新矩形框s的左边界取第i和i+1矩形框中的最左侧边界,新矩形框s的右边 界取第i和i+1矩形框中的最右侧边界,取第i和i+1矩形框中的下方边界为下边 界,新矩形框s的上边界取第i和i+1矩形框中的最上方边界,由此确定新矩形 框s的四个边界。

在一个实施例中,步骤152中的“进行新的光学图像感兴趣区域合并”的方 法具体包括:

例如:如图6所示,从左至右有6个矩形框,包含了可能存在目标的感兴趣 区域,感兴趣区域合并的过程可以理解为,在原第1和2矩形框(图6的左侧两 个矩形框)有重合的情形下,将原第1和2矩形框包围的新第1矩形框;在原第1和 2矩形框没有重合,则将原第3矩形框作为新的起始位置,进行同样地搜索。当 原第3和4矩形框(图6的中间两个矩形框)有重合的情形下,将原第3和4矩形 框包围的新第2矩形框;按照上述相同的方法,依次遍历6个原矩形框,最后得 到了3个合并区域的矩形框。

步骤16,利用SINet网络对所述光学图像感兴趣区域进行目标检测,检测 结果为场景中目标类型(如车辆、行人等)及在图片中的包围框(表示位置), 输出f

SINet网络构成如图3所示,如图3所示,将步骤15得到的一个或多个光 学图像感兴趣区域分别输入SINet检测网络中,其具体包括:

首先,经过RPN(Region Proposal Networks)层,获得卷积特征图及一组proposal,每个proposal表示大量可能包含物体的区域及其预测矩形框。再利 用CARoI池化提取每个proposal中的特征,采用双线性核的反卷积操作,避免 较小的proposal中利用RoI池化带来的物体表征错误。不同卷积层中的池化特 征进行合并,依据proposal尺寸通过多分支决策网络,每个决策网络包含一个 卷积层和一个全连接层,随后分别连接两个分类器,一个用来得到目标分类结果, 一个用来回归目标包围框位置。该网络对大尺寸proposal和小尺寸proposal 分层处理,通过大尺度proposa检测得到近处目标,通过小尺度proposal检测 得到远处目标,从而完成场景中远、近处目标检测,得到proposal属于每一类 型目标的概率。根据图像成像特点,图片中距离比较近的目标,一般尺寸较大, 同样目标如果距离较远,则尺寸变小。

在一个实施例中,根据步骤1中得到的光学图像感兴趣区域感知结果,利用 图像-点云对应关系将检出的目标投影到三维点云数据中,利用相邻帧点云中聚 类积累,并对积累后的点云进行点云分类,以滤除图像检测中的虚警,予以剔除。

所述步骤2中的所述f

步骤21,检测所述矩形框中对应的点云聚类,并对检测出的点云聚类进行点 云积累及分类运算。

步骤22,在步骤21得到的上一时刻的点云聚类中寻找关联目标,将当前时刻 包含点云数量小于数量预设值的点云聚类进行目标关联及点云配准积累,获得积 累点云。

步骤22中的目标关联的方法可以一种方式实现:

以当前时刻自动驾驶车辆坐标为基准,将上一时刻所述点云聚类转换到当前 时刻坐标系中,以目标b中心为圆心,半径r=δt·v

步骤22中的目标关联的方法可以另一种方式实现:以当前时刻自动驾驶车辆 坐标为基准,将上一时刻点云转换到当前时刻坐标系中,以目标b中心为基准, [-v

目标关联的方式还有较多,本实施例将不再一一列举。

其中的“较小”可以理解为,比如设定一个阈值,如是车辆目标时,可以考 虑车辆在0.1秒时间内偏航角不会发生大范围变化,可将该角度阈值设置为但不 限于20度,若旋转角度小于20度则可以认为“较小”,判断为关联目标。

步骤23,利用深度神经网络,对所述积累点云进行点云分类,并输出所述f

步骤2,点云目标分类:

步骤21,图像-点云变换:对于步骤16输出的图像检测结果,依据步骤14中的 图像投影变换关系找到图像中检测出目标的矩形框中对应的点云聚类,对这些点 云聚类进行后续点云积累及分类运算。

步骤22,目标关联:在步骤21得到的上一时刻的点云中寻找关联目标,对于 当前时刻包含点云数量小于阈值T

其中,目标关联方法具体包括如下过程:

以当前时刻自动驾驶车辆坐标为基准,将上一时刻点云转换到当前时刻坐标 系中,以目标b中心为圆心,半径r=δt·v

点云配准积累方法具体包括:

对于关联目标,将上一时刻点云转换到当前时刻坐标系中,并与当前时刻点 云进行融合,完成稀疏点云目标的点云积累。

步骤23,点云分类:利用深度神经网络,对步骤22输出的积累点云进行点 云分类。

深度神经网络结构如图4所示,如图4所示,假设目标b=(x

后续点云分类网络包括5层卷积网络,参数分别为(32,1,4)、(64,1,1)、 (128,1,1)、(512,1,1)、(512,1,1),参数的格式为(卷积核数量,高度,宽度), 各卷积层中卷积步长为1*1。随后,进入最大池化层,得到1×512的向量。接着, 输入后面的全连接层,最后,经输出层输出目标b属于每一类型障碍物的概率。

上述实施例中所涉及的“地面点云分割”和“地上点云聚类”可包含多种替 代方案,如地面点云分割可采用网格法、地面建模法、平面拟合法等,点云聚类 可包括k-means聚类、基于密度的聚类、基于网格的聚类方法等。

最后需要指出的是:以上实施例仅用以说明本发明的技术方案,而非对其限 制。本领域的普通技术人员应当理解:可以对前述各实施例所记载的技术方案进 行修改,或者对其中部分技术特征进行等同替换;这些修改或者替换,并不使相 应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

- 一种基于激光雷达与相机融合的远距离目标感知方法

- 一种基于多焦距相机与激光雷达融合的三维目标检测方法