一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法

文献发布时间:2023-06-19 12:02:28

技术领域

本发明涉及一种图像恰可察觉失真(Just Noticeable Difference,JND)阈值估计方法,尤其是涉及一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法。

背景技术

随着不同的社交软件的出现,人们更乐于在这些社交软件或网络上上传自己的生活及娱乐照片或视频,来和他人分享自己的乐事。这就涉及到图像的编码任务,如何隐藏无用的并保留有效的信息是节省网络资源的关键,而JND阈值估计技术正是为此服务的。在过去的十几年中有不少的JND阈值估计方法被提出,然而大部分的方法都不能对图像的JND阈值做出十分准确地估计,例如有些方法只考虑了亮度对图像JND阈值的影响,有些方法虽然考虑了亮度自适应性与对比度掩蔽效应的同时作用,但依然无法准确有效地估计出图像的JND阈值。

传统的图像JND阈值估计方法对估计图像中纹理比较粗糙的区域的阈值并没有很好的表现。根据人眼视觉系统(Human Visual System,HVS)的特性,相较于纹理相对平坦的区域,HVS对纹理比较粗糙的区域的失真程度有着更高的容忍度,这些区域的JND阈值理应更高,但以往提出的图像JND阈值估计方法忽略了这一点,从而导致对图像的JND阈值的估计不准确。因此,如何有效地描述图像局部区域的纹理粗糙度,并依此对图像的JND阈值做出有效的估计,是JND阈值估计领域中需要研究与解决的问题。

发明内容

本发明所要解决的技术问题是提供一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法,其能够很好地计算出图像局部区域纹理的粗糙度,进而可以实现对图像JND阈值的有效估计。

本发明解决上述技术问题所采用的技术方案为:一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法,其特征在于包括以下步骤:

步骤1:将原始图像记为{I

步骤2:对{I

步骤3:采用差分盒计数方法,计算出{I

步骤4:计算{I

步骤5:将{I

步骤6:计算{I

步骤7:计算{I

步骤8:采用GBVS,计算{I

步骤9:对{I

与现有技术相比,本发明的优点在于:

1)本发明方法采用分形理论(采用差分盒计数方法)对图像局部区域纹理的粗糙度做出合理检测,进而准确地找到图像上相对粗糙的和相对平坦的区域,不同的粗糙度通过分形维数的计算值表现出来,并通过这些值指导对图像恰可察觉失真阈值的估计,本发明方法能更准确地对图像的恰可察觉失真阈值作出估计。

2)相较于其他现有的方法,本发明方法对图像的处理更符合人眼视觉系统的感知特性,人眼更倾向于对不复杂的物体的信息进行获取,对于表面纹理比较粗糙的物体会尽可能减少信息的获取,本发明方法正是利用此点,通过分形理论对图像局部区域纹理的粗糙度进行有效地分析与描述,并指导恰可察觉失真阈值的计算。

附图说明

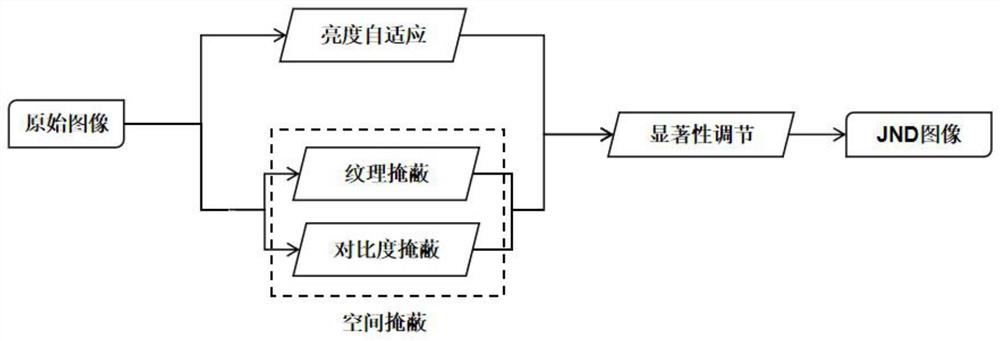

图1为本发明方法的总体实现框图;

图2为一幅原始图像;

图3a为图2所示的原始图像经过本发明方法的步骤1至步骤3后得到的与原始图像尺寸相同的权值图;

图3b为图2所示的原始图像的灰度图像中的所有像素点的空间掩蔽效应构成的图像;

图3c为图2所示的原始图像的灰度图像中的所有像素点的亮度自适应性构成的图像;

图3d为图2所示的原始图像的灰度图像中的所有像素点的初步恰可察觉失真阈值构成的图像;

图3e为图2所示的原始图像的灰度图像的显著图;

图3f为图2所示的原始图像的灰度图像中的所有像素点的最终恰可察觉失真阈值构成的图像。

图3g为图2所示的原始图像经本发明方法加噪处理后的图像(PSNR为30.20)。

具体实施方式

以下结合附图实施例对本发明作进一步详细描述。

根据人眼视觉系统的特性,对于图像中纹理比较粗糙的区域,人眼会本能地减少信息的获取,对于图像中纹理比较平滑的区域,人眼倾向于获取更多的信息,所以,对于图像中纹理比较粗糙的区域,人眼能够容忍更大程度的失真,对于图像中纹理比较平滑的区域,人眼所能够容忍的失真程度是较低的。以往所出现的方法都无法对图像局部区域的纹理粗糙度做出准确的描述,为此本发明提出了一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法,其总体实现框图如图1所示,其包括以下步骤:

步骤1:将原始图像记为{I

图2给出了一幅原始图像,原始图像为整型的图像。对{I

步骤2:对{I

步骤3:采用差分盒计数方法,计算出{I

在此,差分盒计数方法为现有技术,其引用自Sarkar N等人的An efficientdifferential box-counting approach to compute fractal dimension of image(一个有效的计算图像分形维数的差分盒计数方法);图3a给出了图2所示的原始图像经过步骤1至步骤3后得到的与原始图像尺寸相同的权值图,即{D

步骤4:计算{I

步骤5:将{I

步骤6:计算{I

步骤7:计算{I

图3b给出了图2所示的原始图像的灰度图像中的所有像素点的空间掩蔽效应构成的图像,图3c给出了图2所示的原始图像的灰度图像中的所有像素点的亮度自适应性构成的图像,图3d给出了图2所示的原始图像的灰度图像中的所有像素点的初步恰可察觉失真阈值构成的图像。

步骤8:采用GBVS(Graph-Based Visual Saliency),计算{I

图3e给出了图2所示的原始图像的灰度图像的显著图。

步骤9:对{I

图3f给出了图2所示的原始图像的灰度图像中的所有像素点的最终恰可察觉失真阈值构成的图像。

对{I

为进一步说明本发明方法的可行性和有效性,对本发明方法进行实验。

对本发明方法进行了主观评分测试与客观指标检测。表1给出了经本发明方法处理后的图像(即原始图像注入噪声后得到的图像)与原始图像进行质量比较的主观实验评判标准。客观指标采用VSI,VSI越高证明经本发明方法处理后的图像越好。用于对比实验的原始图像的来源为TID 2013图像库,在此从TID 2013图像库中挑选了前10幅图像用于实验,10幅图像分别为I01、I02、I03、I04、I05、I06、I07、I08、I09、I10。

表1经本发明方法处理后的图像与原始图像进行质量比较的主观实验评判标准

在此采用与其他现有方法对比的形式来表现本发明方法的优越性。被用来对比的现有方法有Liu等人的Just Noticeable Difference for Images With DecompositionModel for Separating Edge and Textured Regions(带有边缘和纹理区域的分解模型的图像的恰可察觉失真模型,简称为Liu2010)、Wu等人的Just Noticeable DifferenceEstimation for Images With Free-Energy Principle(基于自由能量原理的恰可察觉失真模型,简称为Wu2013)、Wu等人的Enhanced Just Noticeable Difference Model forImages With Pattern Complexity(基于模式复杂度的增强的恰可察觉失真模型,简称为Wu2017)、Chen等人的Asymmetric Foveated Just-Noticeable-Difference Model forImages With Visual Field Inhomogeneities(具有视野不均匀性的图像的非对称凹面恰可察觉失真模型,简称为Chen2020)。表2给出了经Liu2010方法处理后的图像的PSNR、VSI、MOS(平均主观质量得分)值,表3给出了经Wu2013方法处理后的图像的PSNR、VSI、MOS值,表4给出了经Wu2017方法处理后的图像的PSNR、VSI、MOS值,表5给出了经Chen2020方法处理后的图像的PSNR、VSI、MOS值,表6给出了经本发明方法处理后的图像的PSNR、VSI、MOS值。

表2经Liu2010方法处理后的图像的PSNR、VSI、MOS值

表3经Wu2013方法处理后的图像的PSNR、VSI、MOS值

表4经Wu2017方法处理后的图像的PSNR、VSI、MOS值

表5经Chen2020方法处理后的图像的PSNR、VSI、MOS值

表6经本发明方法处理后的图像的PSNR、VSI、MOS值

从表2至表6中可以看出,在PSNR几乎相同的情况下,经本发明方法处理后的图像不仅拥有最高的主观得分,而且还拥有最高的客观指标得分。这充分地说明了本发明方法优于其他现有方法。

- 一种基于纹理掩蔽效应的图像恰可察觉失真阈值估计方法

- 一种基于稀疏表示的自然图像恰可察觉失真阈值估计方法