端到端双目图像联合压缩方法、装置、设备和介质

文献发布时间:2023-06-19 10:43:23

技术领域

本公开涉及图像处理技术领域,尤其涉及一种端到端双目图像联合压缩方法、装置、设备和介质。

背景技术

双目图像联合压缩(Stereo image compression,SIC)旨在共同压缩一对左右的双目影像,实现两个图像的高质量高效率压缩。在自动驾驶领域、虚拟现实、和视频监视领域,双目图像联合压缩技术已成为最关键的技术之一,也在最近引起了来自学术界和工业界越来越多的关注。通过充分利用两个图像中的互信息,SIC与独立压缩每个图像相比,可以获得更高的压缩率。

与单目图像压缩相比,SIC为更具挑战性,需要充分利用左右双目图像之间的内在联系。现有的SIC方法包括:(1)依靠匹配提取人为设计的特征点,采用传统的优化理论使速率失真损失最小化,但这种压缩方式限制了压缩效率;(2)基于深度学习的双目图像压缩方法(Deepstereo image compression,DSIC),利用双目图像对之间的内容冗余来降低联合比特率,但该方法是密集参数连接的图像匹配方案,具有很高的计算复杂度,而且,该方法要求左右图像必须在同一水平线上,即双目图像拍摄过程中摄像机的水平位置需要保持一致,导致方案只能适用一些特定情况。

发明内容

为了解决上述技术问题或者至少部分地解决上述技术问题,本公开实施例提供了一种端到端双目图像联合压缩方法、装置、设备和介质。

第一方面,本公开实施例提供了一种端到端双目图像联合压缩方法,基于端到端双目图像联合压缩模型实现,所述压缩模型包括深度网络回归模型、第一编码器、第一条件熵模型、第二编码器和第二条件熵模型,所述第一条件熵模型与所述第二条件熵模型属于相同类型的熵模型,均包括基于混合高斯模型的熵模型或基于上下文的熵模型;所述方法包括:

将双目图像中第一目图像输入所述第一编码器,得到用于表征所述第一目图像的第一图像特征;

利用所述第一条件熵模型对所述第一图像特征进行压缩处理,得到所述第一目图像的压缩码流数据;

将所述第一目图像和所述双目图像中的第二目图像输入所述深度网络回归模型,输出所述第一目图像和所述第二目图像之间的单应性透视变换矩阵;

基于所述单应性透视变换矩阵对所述第一目图像进行透视变换,得到第一变换图像;

利用所述第二编码器确定所述第二目图像和所述第一变换图像之间的差异图像数据,并基于所述差异图像数据,得到用于表征所述第二目图像的第二图像特征;

利用所述第二条件熵模型,基于所述第一图像特征,对所述第二图像特征进行压缩处理,得到所述第二目图像的压缩码流数据。

第二方面,本公开实施例还提供了一种端到端双目图像联合压缩装置,基于端到端双目图像联合压缩模型实现,所述压缩模型包括深度网络回归模型、第一编码器、第一条件熵模型、第二编码器和第二条件熵模型,所述第一条件熵模型与所述第二条件熵模型属于相同类型的熵模型,均包括基于混合高斯模型的熵模型或基于上下文的熵模型,所述装置包括:

第一图像特征确定模块,用于将双目图像中第一目图像输入所述第一编码器,得到用于表征所述第一目图像的第一图像特征;

第一压缩模块,用于利用所述第一条件熵模型对所述第一图像特征进行压缩处理,得到所述第一目图像的压缩码流数据;

变换矩阵输出模块,用于将所述第一目图像和所述双目图像中的第二目图像输入所述深度网络回归模型,输出所述第一目图像和所述第二目图像之间的单应性透视变换矩阵;

第一变换图像确定模块,用于基于所述单应性透视变换矩阵对所述第一目图像进行透视变换,得到第一变换图像;

第二图像特征确定模块,用于利用所述第二编码器确定所述第二目图像和所述第一变换图像之间的差异图像数据,并基于所述差异图像数据,得到用于表征所述第二目图像的第二图像特征;

第二压缩模块,用于利用所述第二条件熵模型,基于所述第一图像特征,对所述第二图像特征进行压缩处理,得到所述第二目图像的压缩码流数据。

第三方面,本公开实施例还提供了一种电子设备,包括存储器和处理器,其中:所述存储器中存储有计算机程序,当所述计算机程序被所述处理器执行时,使得所述电子设备实现本公开实施例提供任一所述的端到端双目图像联合压缩方法。

第四方面,本公开实施例还提供了一种计算机可读存储介质,所述存储介质中存储有计算机程序,当所述计算机程序被计算设备执行时,使得所述计算设备实现本公开实施例提供的任一所述的端到端双目图像联合压缩方法。

本公开实施例提供的技术方案与现有技术相比至少具有如下优点:在本公开实施例中,提出了一种用于双目图像联合压缩的端到端可训练的深度网络(Deep Homographyfor Efficient Stereo Image Compression,HESIC),可以利用双分支自动编码器架构,分别对双目图像中的两幅图像进行压缩处理,相比于现有技术降低了计算复杂度,提高了压缩效率,并且本方案对双目图像的位置没有特殊性要求,方案适用范围更为广泛。在具体压缩处理过程中,利用深度回归模型估计双目图像之间的单应性透视变换矩阵(即H矩阵),然后利用条件熵模型对双目图像之间的残余信息进行编码,充分挖掘了两幅图像之间的相关性,降低了编码比特率。

附图说明

此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。

为了更清楚地说明本公开实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

图1为本公开实施例提供的一种端到端双目图像联合压缩处理的架构示意图;

图2为本公开实施例提供的一种端到端双目图像联合压缩模型的结构示意图;

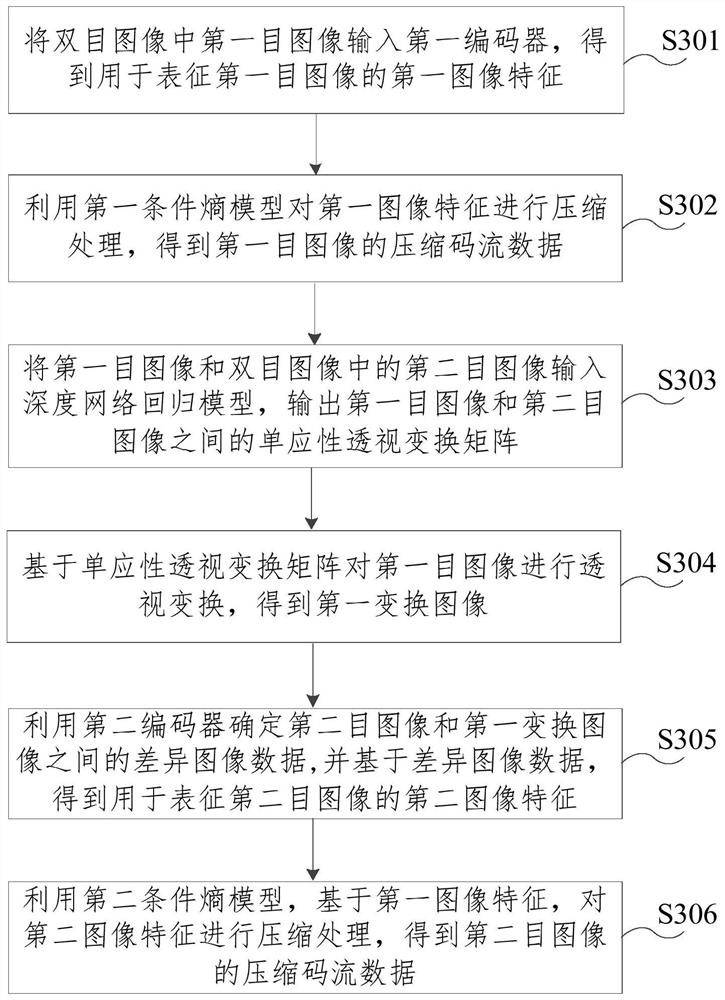

图3为本公开实施例提供的一种端到端双目图像联合压缩方法的流程图;

图4为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图;

图5为本公开实施例提供的一种基于混合高斯模型的双目熵模型的结构示意图;

图6为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图;

图7为本公开实施例提供的一种基于上下文的双目熵模型的结构示意图;

图8为本公开实施例提供的另一种端到端双目图像联合压缩方法的流程图;

图9为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图;

图10为本公开实施例提供的一种用于双目图像联合压缩的交叉质量增强网络模型的结构示意图;

图11为本公开实施例提供的一种端到端双目图像联合压缩装置的结构示意图;

图12为本公开实施例提供的一种电子设备的结构示意图。

具体实施方式

为了能够更清楚地理解本公开的上述目的、特征和优点,下面将对本公开的方案进行进一步描述。需要说明的是,在不冲突的情况下,本公开的实施例及实施例中的特征可以相互组合。

在下面的描述中阐述了很多具体细节以便于充分理解本公开,但本公开还可以采用其他不同于在此描述的方式来实施;显然,说明书中的实施例只是本公开的一部分实施例,而不是全部的实施例。

图1为本公开实施例提供的一种端到端双目图像联合压缩处理的架构示意图,用于对本公开实施例进行示例性说明。如图1所示,在双目图像压缩过程中,利用深度网络回归模型(RegressionModel)输出双目图像之间的单应性透视变换矩阵(即H矩阵),并对双目图像中第一目图像进行H矩阵的空间变换,为第二目图像的压缩补偿先验信息,然后对双目图像之间的残余信息进行编码,得到压缩比特流(Bitstream),以达到节省比特率的效果,在图像解压缩阶段,再次利用H矩阵对解压缩之后的第一目图像进行图像空间变换,用于恢复得到双目图像中的第二目图像。在以下描述中,双目图像中第一目图像可以是左目图像或右目图像,相应的,双目图像中第二目图像可以是右目图像或左目图像,本公开实施例不作具体限定。

图2为本公开实施例提供的一种端到端双目图像联合压缩模型的结构示意图,用于对本公开实施例进行示例性说明。如图2所示,该压缩模型包括深度网络回归模型、第一编码器ENC、第一条件熵模型、第二编码器ENC和第二条件熵模型,第一条件熵模型与第二条件熵模型属于相同类型的熵模型,均包括基于混合高斯模型的熵模型或基于上下文的熵模型,在双目图像压缩过程中可以充分利用双目图像之间的相关性,达到节省比特率的压缩效果。其中,深度网络回归模型用于输出单应性透视变换矩阵,具体网络结构可以参考现有技术实现;第一编码器和第二编码器均基于现有的编码器(Encoder)实现,用于提取图像特征,示例性的,第一编码器和第二编码器均可以采用自编码器实现;第一条件熵模型与第二条件熵模型分别用于对双目图像进行量化和熵编码处理,属于本方案的核心技术之一,具体网络结构可以参见下文中的详细描述。

图3为本公开实施例提供的一种端到端双目图像联合压缩方法的流程图,该方法可以由端到端双目图像联合压缩装置执行,该装置可以采用软件和/或硬件实现,并可集成在任意具有计算能力的电子设备上。以下结合图2和图3对本公开实施例提供的一种端到端双目图像联合压缩方法进行示例性说明。

如图3所示,本公开实施例提供的端到端双目图像联合压缩方法可以包括:

S301、将双目图像中第一目图像输入第一编码器,得到用于表征第一目图像的第一图像特征。

其中,第一目图像即用图2中的输入1(x

S302、利用第一条件熵模型对第一图像特征进行压缩处理,得到第一目图像的压缩码流数据。

S303、将第一目图像和双目图像中的第二目图像输入深度网络回归模型,输出第一目图像和第二目图像之间的单应性透视变换矩阵。

其中,第二目图像即用图2中的输入2(x

双目图像总是在同一时刻不同角度拍摄,两幅图像上的所有物体存在非常相似的空间变换关系,因此,可以利用单应性透视变换(一种双目图像刚性匹配技术)来匹配双目图像。并且,相比于利用像素级的密集映射连接计算来传递双目图像之间的信息,单应性透视变换可以极大地降低计算复杂度。

单应性透视变换矩阵易于计算,且通过转变为图像的四个角点坐标后也易于传输。具体来说,第一目图像中的任一坐标点(u,v)可以通过H矩阵转化为第二目图像中相应的坐标点(u′,v′),关系如下:

深度网络回归模型可以由多个卷积层和全连接层组成,根据两幅输入图像来输出透视变换匹配后对应的图像角点坐标变化值,然后通过角点坐标关系代入上述公式中计算H矩阵。

S304、基于单应性透视变换矩阵对第一目图像进行透视变换,得到第一变换图像。

得到H矩阵后,可以采用可微分的空间变换(Spatial Transformation,ST)模块将第一目图像扭曲为第二目图像的角度,即得到第一变换图像。ST模块主要包含采样网格生成器和图像插值拟合两部分,并且可以通过设计插值函数来提高变换质量。在采样网格生成器中,H矩阵首先进行归一化反变换得到H逆矩阵来生成采样网格,则第二目图像中每个像素(u′,v′)都存在一个第一目图像中对应的反变换后的坐标值(u,v),但这个坐标值通常并不是整数,所以需要插值拟合处理,将第一图像(u,v)周围像素点插值拟合,算出第一目图像对应的像素值,作为对应(u′,v′)的像素值。示例性的,插值拟合处理可以选择双线性插值进行拟合,具体计算公式可以参考如下:

其中M

通过基于单应性透视变换矩阵对第一目图像进行透视变换,得到的第一变换图像与第二目图像属于相同的拍摄角度,进而可以确定出第二目图像和第一变换图像之间的差异图像数据,也即双目图像之间的不同信息,从而降低压缩存储所需的比特数。

S305、利用第二编码器确定第二目图像和第一变换图像之间的差异图像数据,并基于差异图像数据,得到用于表征第二目图像的第二图像特征。

如图2所示,本公开实施例将第二目图像和第一变换图像进行通道合并,然后输入第二编码器,第二编码器可以学习两幅图像之间的不同信息,并基于学到的图像间的不同信息得到用于表征第二目图像的第二图像特征,从而为降低压缩存储所需的比特数奠定基础。

S306、利用第二条件熵模型,基于第一图像特征,对第二图像特征进行压缩处理,得到第二目图像的压缩码流数据。

如图2所示,双目图像中的第一目图像可以单独进行压缩编码,在第二目图像的压缩过程中,第一目图像的第一图像特征作为先验信息,参与第二目图像的压缩,提高第二目图像的抽象表征(即第二图像特征)的概率熵模型的准确性,降低图像压缩失真率。

在本公开实施例中,提出了一种用于双目图像联合压缩的端到端可训练的深度网络,可以利用双分支自动编码器架构,分别对双目图像中的两幅图像进行压缩处理,相比于现有技术降低了计算复杂度,提高了压缩效率,并且本方案对双目图像的位置没有特殊性要求,方案适用范围更为广泛。在具体压缩处理过程中,利用深度回归模型估计双目图像之间的单应性透视变换矩阵,然后利用条件熵模型对双目图像之间的残余信息进行编码,充分挖掘了两幅图像之间的相关性,降低了编码比特率。

图4为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图,具体以基于混合高斯模型(Gaussion Mixture Model,GMM)的熵模型为例,对本公开实施例中的压缩模型进行示例性说明。如图4所示,第一条件熵模型包括第一量化器Q、第一熵编码器、用于生成超先验参数的第一变换网络模块和第一混合高斯模型g1,第二条件熵模型包括第二量化器Q、第二熵编码器、用于生成超先验参数的第二变换网络模块和第二混合高斯模型g2。此时,第一条件熵模型与第二条件熵模型可以合称为基于混合高斯模型的双目熵模型。图4中具体以算术编码为例,各个熵编码器均为算术编码器AE,相应的,各个熵解码器均为算术解码器AD。在实际应用中,可以根据需求合理选择可用的熵计算模型,并不限于算术编码。

图5为本公开实施例提供的一种基于混合高斯模型的双目熵模型的结构示意图,对第一混合高斯模型g1和第二混合高斯模型g2以及第一变换网络模块和第二变换网络模块的网络结构进行了详细的示意。应当理解,可以根据实际需求灵活设计网络结构,并且每个网络层的参数也可以根据需求而定,不应当将图5中给出的示例理解为对本公开实施例的具体限定。同样的,图5中具体以算术编码为例,各个熵编码器均为算术编码器AE,各个熵解码器均为算术解码器AD。

示例性的,如图4或图5所示,用于生成超先验参数的第一变换网络模块可以包括:第一超先验编码器ENC

基于图4或图5,可选的,利用第一条件熵模型对第一图像特征进行压缩处理,得到第一目图像的压缩码流数据,包括:

将第一图像特征y

将第一图像特征y输入第一变换网络模块,生成第一超先验参数

将第一超先验参数

基于第一量化结果的概率分布

其中,第一量化结果的概率分布

其中,N表示高斯函数的个数,

进一步的,以算术编码为例,第一目图像x

其中,E函数表示算术编码中比特数期望值的计算函数,

相应的,利用第二条件熵模型,基于第一图像特征,对第二图像特征进行压缩处理,得到第二目图像的压缩码流数据,包括:

将第二图像特征y

将第二图像特征y

对第二超先验参数

将合并结果输入第二混合高斯模型g2,估计第二量化结果

基于第二量化结果的概率分布

其中,第二量化结果的概率分布

其中,N表示高斯函数的个数,

进一步的,以算术编码为例,第二目图像x

其中,E函数表示算术编码中比特数期望值的计算函数,

进而,双目图像的整体压缩码流数据可以表示为R=R

在本方案中,基于

图6为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图,具体以基于上下文(Context)的熵模型为例,对本公开实施例中的压缩模型进行示例性说明。如图6所示,第一条件熵模型包括第一量化器Q、第一熵编码器、用于生成超先验参数的第一变换网络模块、第一超先验解码器DEC1

图7为本公开实施例提供的一种基于上下文的双目熵模型的结构示意图,对基于上下文的双目熵模型的具体结构组成进行详细的示意。应当理解,可以根据实际需求灵活设计网络结构,并且每个网络层的参数也可以根据需求而定,不应当将图7中给出的示例理解为对本公开实施例的具体限定。此外,图6或图7中同样具体以算术编码为例,各个熵编码器均为算术编码器AE,各个熵解码器均为算术解码器AD。在实际应用中,可以根据需求合理选择可用的熵计算模型,并不限于算术编码。

图6与图4或者图7与图5中,功能相同且名称相同的网络模块,具有相同的网络结构,例如用于生成超先验参数的第一变换网络模块和第二变换网络模块,可以参考图5中示出的网络结构实现。

基于图6或图7,可选的,利用第一条件熵模型对第一图像特征进行压缩处理,得到第一目图像的压缩码流数据,包括:

将第一图像特征y

将第一图像特征y

将第一超先验参数

利用第一上下文预测模块,基于第一量化结果

将第一依赖结果和第一上采样结果进行合并(即通道合并Concat),并将合并结果输入第一高斯模型c1,估计第一量化结果的概率分布

基于第一量化结果的概率分布

其中,第一量化结果的概率分布

其中,

第一目图像x

其中,E函数表示算术编码中比特数期望值的计算函数,

相应的,利用第二条件熵模型,基于第一图像特征,对第二图像特征进行压缩处理,得到第二目图像的压缩码流数据,包括:

将第二图像特征y

将第二图像特征y

将第二超先验参数

利用第二上下文预测模块,基于第二量化结果,分别输出第二目图像中任一像素与任一像素之前完成编码的在前像素之间的第二依赖结果;数据流处理如图7所示,在第二上下文预测模块中利用循环展开的形式,不断地将当前像素i之前编码/译码完成的像素作为已知内容来预测当前像素i对应的概率分布值,其中涉及的具体实现原理可以参考现有技术中关于基于上下文进行预测的神经网络模型的实现原理;

将第二依赖结果、第一量化结果

基于第二量化结果的概率分布

其中,第二量化结果的概率分布

其中,

第二目图像x

其中,E函数表示算术编码中比特数期望值的计算函数,

进而,双目图像的整体压缩码流数据可以表示为R=R

在本方案中,基于

图8为本公开实施例提供的另一种端到端双目图像联合压缩方法的流程图,基于上述技术方案进一步进行扩展。需要说明的是,图8中各个步骤的执行顺序可以根据实际处理进行调整,不应当将图8中所示出的执行顺序理解为对本公开实施例的具体限定。并且,压缩模型的结构示意可以参考图4或图6,压缩模型中还包括第一解码器DEC和第二解码器DEC。示例性的,第一解码器DEC和第二解码器DEC可以采用自解码器实现。

如图8所示,本公开实施例提供的端到端双目图像联合压缩方法可以包括:

S801、将双目图像中第一目图像输入第一编码器,得到用于表征第一目图像的第一图像特征。

S802、利用第一条件熵模型对第一图像特征进行压缩处理,得到第一目图像的压缩码流数据。

S803、将第一目图像和双目图像中的第二目图像输入深度网络回归模型,输出第一目图像和第二目图像之间的单应性透视变换矩阵。

S804、利用深度网络回归模型输出第一目图像和第二目图像之间预设数量的角点坐标的变化值,并对角点坐标的变化值进行编码,得到角点坐标的变化值的压缩码流数据。

如图4或图6所示,在双目图像联合压缩过程中,H矩阵的传输也是一个需要考虑的问题,如果直接将H矩阵传输到解码端会增加编码比特率。考虑图像上的四个角点坐标变化值与H矩阵可以相互转换,因此可以通过传输四个整数型角点坐标的方式来代替直接传输浮点型3x3的H矩阵。也即角点坐标的变化值的压缩码流数据用于根据角点坐标变化值与单应性透视变换矩阵之间的关系,得到单应性透视变换矩阵,以用于双目图像的解压缩过程。

具体的,可以首先将角点坐标取整,然后进行二进制编码存储,对于512x512大小的图片为例,传输角点只需

S805、基于单应性透视变换矩阵对第一目图像进行透视变换,得到第一变换图像。

S806、利用第二编码器确定第二目图像和第一变换图像之间的差异图像数据,并基于差异图像数据,得到用于表征第二目图像的第二图像特征。

S807、利用第二条件熵模型,基于第一图像特征,对第二图像特征进行压缩处理,得到第二目图像的压缩码流数据。

S808、利用第一条件熵模型对第一目图像的压缩码流数据进行解压缩处理,并将解压缩处理结果输入第一解码器,得到解压缩之后的第一目图像。

解压缩之后的第一目图像即图4或图6中的示出的输出1。

S809、利用第二条件熵模型对第二目图像的压缩码流数据进行解压缩处理,并将解压缩处理结果输入第二解码器,得到解压缩之后的差异图像数据。

S810、对角点坐标的变化值的压缩码流数据进行解压缩处理,并基于解压缩处理结果得到单应性透视变换矩阵。

如图4或图6所示,角点坐标的变化值的压缩码流数据解压缩之后,可以根据角点坐标变化值与单应性透视变换矩阵之间的关系,恢复得到单应性透视变换矩阵。

S811、利用单应性透视变换矩阵对解压缩之后的第一目图像进行透视变换,得到第二变换图像。

S812、基于解压缩之后的差异图像数据和第二变换图像,得到解压缩之后的第二目图像。

如图4或图6所示,将解压缩之后的差异图像数据和第二变换图像进行通道合并,然后恢复得到解压缩之后的第二目图像,即图4或图6中的示出的输出2。

在本公开实施例中,利用深度回归模型估计双目图像之间的单应性透视变换矩阵,然后利用条件熵模型对双目图像之间的残余信息进行编码,充分挖掘了两幅图像之间的相关性,降低了编码比特率;并且,相比于现有技术降低了计算复杂度,提高了压缩效率,对双目图像的位置没有特殊性要求,方案适用范围更为广泛。

图9为本公开实施例提供的另一种端到端双目图像联合压缩模型的结构示意图,即在上述技术方案的基础上,本公开实施例中的压缩模型还包括交叉质量增强网络模型(Cross Quality Enhancement,CQE),用于对解压缩之后的双目图像进行质量增强,进一步提高解压缩结果。

并且,图9具体是以基于混合高斯模型的熵模型为例,应当理解,在本公开实施例中,同样可以在基于上下文的熵模型的基础上,增加交叉质量增强网络模型,得到本公开实施例中的另一种压缩模型。

图10为本公开实施例提供的一种用于双目图像联合压缩的交叉质量增强网络模型的结构示意图,具体的,交叉质量增强网络模型可以包括第一交叉质量增强子网络模型和第二交叉质量增强子网络模型。其中,第一交叉质量增强子网络或第二交叉质量增强子网络均包括卷积层和残差网络层。如图10所示,第一交叉质量增强子网络模型或第二交叉质量增强子网络模型均可以包括多个卷积层(例如图中所示出卷积核大小为32x1x1的卷积层)和多个残差块(Residual Block,RB),各个残差块结构相同,交叉质量增强网络模型的具体网络结构可以根据需求进行灵活设置,例如卷积层数和残差块数量均可以灵活设置。

结合图9和图10,在上述技术方案的基础上,进一步的,本公开实施例提供的方法还包括:

计算单应性透视变换矩阵的逆变换矩阵H

利用逆变换矩阵H

将第三变换图像和解压缩之后的第一目图像

将第二变换图像(即对解压缩之后的第一图像

在本公开实施例中,通过利用交叉质量增强网络模型,基于双目图像内容的相关性,对解压缩之后的双目图像进行增强处理,提高了两幅图解压缩后的输出质量。

在上述技术方案的基础上,进一步的,本公开实施例需要对压缩模型进行预先训练,首先对深度网络回归模型进行训练,通过训练,使得深度网络回归模型具有输出单应性透视变换矩阵的功能;然后对整个压缩模型进行训练,使得压缩模型具有对双目图像进行压缩和解压缩的功能。模型训练的具体原理可以参考现有模型的训练原理,本公开实施例不作具体限定。

在深度网络回归模型的训练过程中,采用以下损失函数:

L

其中,x

在端到端双目图像联合压缩模型的训练过程中,采用以下损失函数:

其中,λ

通过调整λ

图11为本公开实施例提供的一种端到端双目图像联合压缩装置的结构示意图,基于端到端双目图像联合压缩模型实现,压缩模型包括深度网络回归模型、第一编码器、第一条件熵模型、第二编码器和第二条件熵模型,第一条件熵模型与第二条件熵模型属于相同类型的熵模型,均包括基于混合高斯模型的熵模型或基于上下文的熵模型。

如图11所示,本公开实施例提供的端到端双目图像联合压缩装置1100可以包括第一图像特征确定模块1101、第一压缩模块1102、变换矩阵输出模块1103、第一变换图像确定模块1104、第二图像特征确定模块1105和第二压缩模块1106,其中:

第一图像特征确定模块1101,用于将双目图像中第一目图像输入第一编码器,得到用于表征第一目图像的第一图像特征;

第一压缩模块1102,用于利用第一条件熵模型对第一图像特征进行压缩处理,得到第一目图像的压缩码流数据;

变换矩阵输出模块1103,用于将第一目图像和双目图像中的第二目图像输入深度网络回归模型,输出第一目图像和第二目图像之间的单应性透视变换矩阵;

第一变换图像确定模块1104,用于基于单应性透视变换矩阵对第一目图像进行透视变换,得到第一变换图像;

第二图像特征确定模块1105,用于利用第二编码器确定第二目图像和第一变换图像之间的差异图像数据,并基于差异图像数据,得到用于表征第二目图像的第二图像特征;

第二压缩模块1106,用于利用第二条件熵模型,基于第一图像特征,对第二图像特征进行压缩处理,得到第二目图像的压缩码流数据。

可选的,如果第一条件熵模型与第二条件熵模型均为基于混合高斯模型的熵模型,则第一条件熵模型包括第一量化器、第一熵编码器、用于生成超先验参数的第一变换网络模块和第一混合高斯模型,第二条件熵模型包括第二量化器、第二熵编码器、用于生成超先验参数的第二变换网络模块和第二混合高斯模型;

相应的,第一压缩模块1102包括:

第一量化单元,用于将第一图像特征输入第一量化器,得到第一量化结果;

第一超先验参数生成单元,用于将第一图像特征输入第一变换网络模块,生成第一超先验参数;

第一估计单元,用于将第一超先验参数输入第一混合高斯模型,估计第一量化结果的概率分布;

第一压缩单元,用于基于第一量化结果的概率分布和第一量化结果,利用第一熵编码器得到第一目图像的压缩码流数据;

相应的,第二压缩模块1106包括:

第二量化单元,用于将第二图像特征输入第二量化器,得到第二量化结果;

第二超先验参数生成单元,用于将第二图像特征输入第二变换网络模块,生成第二超先验参数;

合并单元,用于对第二超先验参数进行上采样,并将上采样之后的第二超先验参数和第一量化结果进行合并;

第二估计单元,用于将合并结果输入第二混合高斯模型,估计第二量化结果的概率分布;

第二压缩单元,用于基于第二量化结果的概率分布和第二量化结果,利用第二熵编码器得到第二目图像的压缩码流数据。

可选的,第一量化结果的概率分布

其中,N表示高斯函数的个数,

第二量化结果的概率分布

其中,N表示高斯函数的个数,

可选的,如果第一条件熵模型与第二条件熵模型均为基于上下文的熵模型,则第一条件熵模型包括第一量化器、第一熵编码器、用于生成超先验参数的第一变换网络模块、第一超先验解码器、第一上下文预测模块和第一高斯模型,第二条件熵模型包括第二量化器、第二熵编码器、用于生成超先验参数的第二变换网络模块、第二超先验解码器、第二上下文预测模块和第二高斯模型;

第一超先验解码器或第二超先验解码器均包括反卷积层,第一上下文预测模块或第二上下文预测模块均包括掩模卷积神经网络层;

相应的,第一压缩模块1102包括:

第一量化单元,用于将第一图像特征输入第一量化器,得到第一量化结果;

第一超先验参数生成单元,用于将第一图像特征输入第一变换网络模块,生成第一超先验参数;

第一上采样结果确定单元,用于将第一超先验参数输入第一超先验解码器,得到第一上采样结果;

第一依赖结果确定单元,用于利用第一上下文预测模块,基于第一量化结果,分别输出第一目图像中任一像素与任一像素之前完成编码的在前像素之间的第一依赖结果;

第一估计单元,用于将第一依赖结果和第一上采样结果进行合并,并将合并结果输入第一高斯模型,估计第一量化结果的概率分布;

第一压缩单元,用于基于第一量化结果的概率分布和第一量化结果,利用第一熵编码器得到第一目图像的压缩码流数据;

相应的,第二压缩模块1106包括:

第二量化单元,用于将第二图像特征输入第二量化器,得到第二量化结果;

第二超先验参数生成单元,用于将第二图像特征输入第二变换网络模块,生成第二超先验参数;

第二上采样结果确定单元,用于将第二超先验参数输入第二超先验解码器,得到第二上采样结果;

第二依赖结果确定单元,用于利用第二上下文预测模块,基于第二量化结果,分别输出第二目图像中任一像素与任一像素之前完成编码的在前像素之间的第二依赖结果;

第二估计单元,用于将第二依赖结果、第一量化结果和第二上采样结果进行合并,并将合并结果输入第二高斯模型,估计第二量化结果的概率分布;

第二压缩单元,用于基于第二量化结果的概率分布和第二量化结果,利用第二熵编码器得到第二目图像的压缩码流数据。

可选的,第一量化结果的概率分布

其中,

第二量化结果的概率分布

其中,

可选的,第一目图像的压缩码流数据由以下公式得到:

其中,E函数表示算术编码中比特数期望值的计算函数,

第二目图像的压缩码流数据由以下公式得到:

其中,E函数表示算术编码中比特数期望值的计算函数,

可选的,本公开实施例提供的装置1100还包括:

角点编码模块,用于利用深度网络回归模型输出第一目图像和第二目图像之间预设数量的角点坐标的变化值,并对角点坐标的变化值进行编码,得到角点坐标的变化值的压缩码流数据;

其中,角点坐标的变化值的压缩码流数据用于根据角点坐标变化值与单应性透视变换矩阵之间的关系,得到单应性透视变换矩阵,以用于双目图像的解压缩过程。

可选的,压缩模型还包括第一解码器和第二解码器,本公开实施例提供的装置1100还包括:

第一解压模块,用于利用第一条件熵模型对第一目图像的压缩码流数据进行解压缩处理,并将解压缩处理结果输入第一解码器,得到解压缩之后的第一目图像;

第二解压模块,用于利用第二条件熵模型对第二目图像的压缩码流数据进行解压缩处理,并将解压缩处理结果输入第二解码器,得到解压缩之后的差异图像数据;

角点变换模块,用于对角点坐标的变化值的压缩码流数据进行解压缩处理,并基于解压缩处理结果得到单应性透视变换矩阵;

第二变换图像确定模块,用于利用单应性透视变换矩阵对解压缩之后的第一目图像进行透视变换,得到第二变换图像;

第二目图像生成模块,用于基于解压缩之后的差异图像数据和第二变换图像,得到解压缩之后的第二目图像。

可选的,压缩模型还包括第一交叉质量增强子网络模型和第二交叉质量增强子网络模型,本公开实施例提供的装置1100还包括:

逆变换矩阵计算模块,用于计算单应性透视变换矩阵的逆变换矩阵;

第三变换图像确定模块,用于利用逆变换矩阵对解压缩之后的第二目图像进行透视变换,得到第三变换图像;

第一图像增强模块,用于将第三变换图像和解压缩之后的第一目图像进行合并,并将合并结果输入第一交叉质量增强子网络模型,得到第一目解压增强图像;

第二图像增强模块,用于将第二变换图像和解压缩之后的第二目图像进行合并,并将合并结果输入第二交叉质量增强子网络模型,得到第二目解压增强图像;

其中,第一交叉质量增强子网络或第二交叉质量增强子网络均包括卷积层和残差网络层。

可选的,在深度网络回归模型的训练过程中,采用以下损失函数:

L

其中,x

在端到端双目图像联合压缩模型的训练过程中,采用以下损失函数:

其中,λ

本公开实施例所提供的端到端双目图像联合压缩装置可执行本公开实施例所提供的任意端到端双目图像联合压缩方法,具备执行方法相应的功能模块和有益效果。本公开装置实施例中未详尽描述的内容可以参考本公开任意方法实施例中的描述。

图12为本公开实施例提供的一种电子设备的结构示意图,用于对实现本公开实施例提供的端到端双目图像联合压缩方法的电子设备进行示例性说明。本公开实施例中的电子设备可以包括但不限于诸如移动电话、笔记本电脑、数字广播接收器、PDA(个人数字助理)、PAD(平板电脑)、PMP(便携式多媒体播放器)、车载终端(例如车载导航终端)等等的移动终端以及诸如数字TV、台式计算机、智能家居设备、可穿戴电子设备、服务器等等的固定终端。图12示出的电子设备仅仅是一个示例,不应对本公开实施例的功能和占用范围带来任何限制。

如图12所示,电子设备1200包括一个或多个处理器1201和存储器1202。

处理器1201可以是中央处理单元(CPU)或者具有数据处理能力和/或指令执行能力的其他形式的处理单元,并且可以控制电子设备1200中的其他组件以执行期望的功能。

存储器1202可以包括一个或多个计算机程序产品,计算机程序产品可以包括各种形式的计算机可读存储介质,例如易失性存储器和/或非易失性存储器。易失性存储器例如可以包括随机存取存储器(RAM)和/或高速缓冲存储器(cache)等。非易失性存储器例如可以包括只读存储器(ROM)、硬盘、闪存等。在计算机可读存储介质上可以存储一个或多个计算机程序指令,处理器1201可以运行程序指令,以实现本公开实施例提供的端到端双目图像联合压缩方法,还可以实现其他期望的功能。在计算机可读存储介质中还可以存储诸如输入信号、信号分量、噪声分量等各种内容。

在一个示例中,电子设备1200还可以包括:输入装置1203和输出装置1204,这些组件通过总线系统和/或其他形式的连接机构(未示出)互连。

此外,该输入装置1203还可以包括例如键盘、鼠标等等。

该输出装置1204可以向外部输出各种信息,包括确定出的距离信息、方向信息等。该输出装置1204可以包括例如显示器、扬声器、打印机、以及通信网络及其所连接的远程输出设备等等。

当然,为了简化,图12中仅示出了该电子设备1200中与本公开有关的组件中的一些,省略了诸如总线、输入/输出接口等等的组件。除此之外,根据具体应用情况,电子设备1200还可以包括任何其他适当的组件。

除了上述方法和设备以外,本公开的实施例还可以是计算机程序产品,其包括计算机程序指令,计算机程序指令在被处理器运行时使得计算设备实现本公开实施例所提供的任意端到端双目图像联合压缩方法。

计算机程序产品可以以一种或多种程序设计语言的任意组合来编写用于执行本公开实施例操作的程序代码,程序设计语言包括面向对象的程序设计语言,诸如Java、C++等,还包括常规的过程式程序设计语言,诸如“C”语言或类似的程序设计语言。程序代码可以完全地在用户电子设备上执行、部分地在用户电子设备上执行、作为一个独立的软件包执行、部分在用户电子设备上且部分在远程电子设备上执行、或者完全在远程电子设备上执行。

此外,本公开实施例还可以提供一种计算机可读存储介质,其上存储有计算机程序指令,计算机程序指令在被处理器运行时使得计算设备实现本公开实施例所提供的任意端到端双目图像联合压缩方法。

计算机可读存储介质可以采用一个或多个可读介质的任意组合。可读介质可以是可读信号介质或者可读存储介质。可读存储介质例如可以包括但不限于电、磁、光、电磁、红外线、或半导体的系统、装置或器件,或者任意以上的组合。可读存储介质的更具体的例子(非穷举的列表)包括:具有一个或多个导线的电连接、便携式盘、硬盘、随机存取存储器(RAM)、只读存储器(ROM)、可擦式可编程只读存储器(EPROM或闪存)、光纤、便携式紧凑盘只读存储器(CD-ROM)、光存储器件、磁存储器件、或者上述的任意合适的组合。

需要说明的是,在本文中,诸如“第一”和“第二”等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个……”限定的要素,并不排除在包括要素的过程、方法、物品或者设备中还存在另外的相同要素。

以上仅是本公开的具体实施方式,使本领域技术人员能够理解或实现本公开。对这些实施例的多种修改对本领域的技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本公开的精神或范围的情况下,在其它实施例中实现。因此,本公开将不会被限制于本文的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

- 端到端双目图像联合压缩方法、装置、设备和介质

- 端到端双目图像联合压缩方法、装置、设备和介质