人眼追踪装置、方法及3D显示设备、方法和终端

文献发布时间:2023-06-19 11:17:41

技术领域

本申请涉及裸眼式3D显示技术,例如涉及人眼追踪装置、方法及3D显示设备、方法和终端。

背景技术

3D(立体)影像是视像行业中的热点技术之一,推动着从平面显示向3D显示的技术变革。3D显示技术是3D影像产业中的关键一环,主要分为两类,即眼镜式3D显示和裸眼式3D显示技术。裸眼式3D显示技术是一种用户无需佩戴眼镜而能够之间观看到3D显示画面的技术。与眼镜式3D显示相比,裸眼式3D显示减少了对用户的约束。

裸眼式3D显示是基于视点的,近来还提出了多视点的裸眼3D显示,从而在空间中不同位置处形成视差图像(帧)的序列,使得具有视差关系的3D图像对可以分别进入人的左右眼当中,从而给用户带来3D感。对于具有例如N个视点的传统的多视点裸眼3D显示器,要用显示面板上的多个独立像素来投射空间的多个视点。

在一些研究进展中,这样的多视点显示还基于人脸或人眼追踪数据来提供更佳的观看体验。在一些常规的人脸或人眼追踪装置中,仅检测人脸与屏幕的距离,并依靠预设的或默认的瞳距来确定人眼所在的视点位置。这样识别的精度不高,无法满足高质量的裸眼式3D显示。例如,这样的人脸或人眼追踪装置无法确定用户双眼的实际空间位置,也无法确定人眼是否相对于屏幕倾斜,这可能会造成视点计算错误。

而且,常规的人脸或人眼追踪装置在以较高的实时度来追踪时还存在计算瓶颈,这影响识别速度或追踪速度。

本背景技术仅为了便于了解本领域的相关技术,并不视作对现有技术的承认。

发明内容

为了对披露的实施例的一些方面有基本的理解,下面给出了简单的概括。该概括不是泛泛评述,也不是要确定关键/重要组成元素或描绘这些实施例的保护范围,而是作为后面的详细说明的序言。

本申请的实施例意图提供人眼追踪装置、方法及3D显示设备、方法和终端。

在一个方案中,提供了一种人眼追踪装置,包括:人眼追踪器,包括被配置为拍摄用户的人脸的黑白图像的黑白摄像头和被配置为获取人脸的景深信息的景深获取装置;人眼追踪图像处理器,被配置为基于黑白图像和景深信息确定人眼的空间位置。

通过这种人眼追踪装置,能够实现分别高精度地确定用户双眼的空间位置以及实现高速度地识别人眼,或者说实时追踪人眼。从而能够提供符合用户双眼的空间位置的显示对象的3D显示画面,提升观看体验。基于用户双眼的实际空间位置能够确定用户双眼所处的视点位置,从而能向用户提供更精确的、自由度更高的3D显示。

在一些实施例中,人眼追踪图像处理器还被配置为基于黑白图像识别人眼的存在。

在一些实施例中,人眼追踪装置包括人眼追踪数据接口,被配置为传输包含人眼的空间位置的人眼空间位置信息。

在一些实施例中,景深获取装置为结构光摄像头或TOF摄像头。

在一些实施例中,人眼追踪装置还包括视角确定装置,被配置为计算用户相对于3D显示设备的视角。

根据视角,能够以随动的方式生成从不同角度观察到的显示对象的3D显示画面,从而使用户能够观看到与视角相符合的3D显示画面,增强3D显示的真实感和沉浸感。

在一些实施例中,黑白摄像头被配置为拍摄黑白图像序列。

在一些实施例中,人眼追踪图像处理器包括:缓存器,配置为缓存黑白图像序列中多幅黑白图像;比较器,配置为比较黑白图像序列中的前后多幅黑白图像;判决器,被配置为,当比较器通过比较在黑白图像序列中的当前黑白图像中未识别到人眼的存在且在之前或之后的黑白图像中识别到人眼的存在时,将基于之前或之后的黑白图像和获取的景深信息确定的人眼空间位置信息作为当前的人眼空间位置信息。

基于此,例如在黑白摄像头出现卡顿或跳帧等情况时,能够为用户提供更为连贯的显示画面,确保观看体验。

在一个方案中,提供了一种3D显示设备,包括:多视点裸眼3D显示屏,包括对应多个视点的多个子像素;如上文描述的人眼追踪装置,被配置为确定用户人眼的空间位置;以及3D处理装置,被配置为根据用户人眼的空间位置确定视点,并且基于3D信号渲染与视点对应的子像素。

在一些实施例中,多视点裸眼3D显示屏包括多个复合像素,多个复合像素中的每个复合像素包括多个复合子像素,多个复合子像素中的每个复合子像素由对应于多个视点的多个子像素构成。

在一些实施例中,3D处理装置与人眼追踪装置通过人眼追踪数据接口通信连接。

在一些实施例中,3D显示设备还包括:3D拍摄装置,被配置为采集3D图像,3D拍摄装置包括景深摄像头和至少两个彩色摄像头。

在一些实施例中,人眼追踪装置与3D拍摄装置集成设置。

在一些实施例中,3D拍摄装置前置于3D显示设备。

在一个方案中,提供了一种人眼追踪方法,包括:拍摄用户的人脸的黑白图像;获取人脸的景深信息;基于黑白图像和所述景深信息确定人眼的空间位置。

在一些实施例中,人眼追踪方法还包括:基于黑白图像识别人眼的存在。

在一些实施例中,人眼追踪方法还包括:传输包含人眼的空间位置的人眼空间位置信息。

在一些实施例中,人眼追踪方法还包括:拍摄出包括黑白图像的黑白图像序列。

在一些实施例中,人眼追踪方法还包括:缓存黑白图像序列中多幅黑白图像;比较黑白图像序列中的前后多幅黑白图像;当通过比较在黑白图像序列中的当前黑白图像未识别到人眼的存在且在之前或之后的黑白图像中识别到人眼的存在时,基于之前或之后的黑白图像和获取的景深信息确定的人眼空间位置信息作为当前的人眼空间位置信息。

在一个方案中,提供了一种3D显示方法包括:确定用户人眼的空间位置;根据用户人眼的空间位置确定视点,并且基于3D信号渲染与视点对应的子像素;其中,3D显示设备包括多视点裸眼3D显示屏,多视点裸眼3D显示屏包括对应多个视点的多个子像素。

在一个方案中,提供了一种3D显示终端,包括处理器、存储有程序指令的存储器和多视点裸眼3D显示屏,处理器被配置为在执行程序指令时,执行如上文描述的3D显示方法。

以上的总体描述和下文中的描述仅是示例性和解释性的,不用于限制本申请。

附图说明

一个或多个实施例通过与之对应的附图进行示例性说明,这些示例性说明和附图并不构成对实施例的限定,附图不构成比例限制,并且其中:

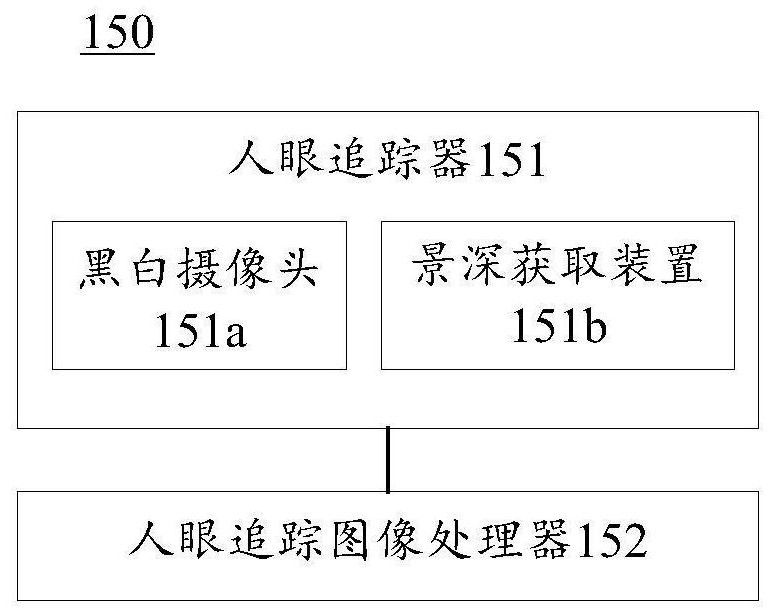

图1是根据本公开实施例的人眼追踪装置的示意图;

图2A和图2B是根据本公开实施例的3D显示设备的示意图;

图3是利用根据本公开实施例的人眼追踪装置确定人眼的空间位置的示意图;

图4是根据本公开实施例的人眼追踪方法的步骤示意图;

图5是根据本公开实施例的人眼追踪方法的步骤示意图;

图6是根据本公开实施例的人眼追踪方法的步骤示意图;

图7是根据本公开实施例的3D显示方法的步骤示意图;

图8是根据本公开实施例的3D显示终端的结构示意图。

附图标记:

100:3D显示设备;101:处理器;122:寄存器;110:多视点裸眼3D显示屏;120:3D拍摄装置;121:摄像头单元;121a:第一彩色摄像头;121b:第二彩色摄像头;121c:景深摄像头;125:3D图像输出接口;126:3D图像处理器;130:3D处理装置;131:缓存器;140:信号接口;150:人眼追踪装置;151:人眼追踪器;151a:黑白摄像头;151b:景深获取装置;152:人眼追踪图像处理器;155:视角确定装置;156:缓存器;157:比较器;153:人眼追踪数据接口;FP:焦平面;O:镜头中心;f:焦距;MCP:黑白摄像头平面;R:用户的右眼;L:用户的左眼;P:瞳距;XR:用户的右眼在焦平面内成像的X轴坐标;XL:用户的左眼在焦平面内成像的X轴坐标;β

具体实施方式

为了能够更加详尽地了解本公开实施例的特点与技术内容,下面结合附图对本公开实施例的实现进行详细阐述,所附附图仅供参考说明之用,并非用来限定本公开实施例。

在本文中,“裸眼3D(立体)显示”涉及用户(例如观看者)无需佩戴3D显示用的眼镜而能在平面显示器上观察到3D效果的显示图像的技术,包括但不限于“视差屏障”、“柱状透镜”、“指向式背光”技术。

在本文中,“多视点”具有本领域的常规含义,意指在空间中不同位置(视点)处能观看到显示屏的不同像素或子像素显示的不同图像。在本文中,多视点将意味着至少3个视点。

在本文中,“光栅”具有本领域中广义的解释,包括但不限于“视差屏障”光栅和“透镜”光栅、如“柱状透镜”光栅。

在本文中,“透镜”或“透镜光栅”具有本领域的常规含义,例如包括柱状透镜和球面透镜。

常规的“像素”意指2D显示器或者作为2D显示器显示时就其分辨率而言的最小显示单位。

然而,在本文的一些实施例中,当应用于裸眼3D显示领域的多视点技术时所称的“复合像素”指裸眼3D显示器提供多视点显示时的最小显示单位,但不排除用于多视点技术的单个复合像素可包括或呈现为多个2D显示的像素。在本文中,除非具体说明为“3D显示”或“多视点”应用的复合像素或3D像素,像素将指2D显示时的最小显示单位。同样,当描述为多视点的裸眼3D显示“复合子像素”时,将指裸眼3D显示器提供多视点显示时的复合像素中呈现的单个颜色的复合子像素。在本文中,“复合子像素”中的子像素将指单个颜色的最小显示单位,其往往是与视点相对应的。

在本公开实施例中,提供了一种人眼追踪装置,被配置为用于3D显示设备,人眼追踪装置包括:人眼追踪器,包括被配置为拍摄黑白图像的黑白摄像头和被配置为获取景深信息的景深获取装置;人眼追踪图像处理器,被配置为基于黑白图像识别人眼的存在且基于黑白图像和获取的景深信息确定人眼的空间位置。这种人眼追踪装置在图1中示例性地示出。

在本公开实施例中,提供了一种3D显示设备,包括:多视点裸眼3D显示屏,包括对应多个视点的多个子像素;3D处理装置,被配置为基于3D信号渲染与视点对应的子像素;其中,视点由用户的人眼的空间位置确定;以及根据上文描述的人眼追踪装置。

作为解释而非限制性地,由人眼的空间位置确定视点可由3D处理装置实现,也可由人眼追踪装置的人眼追踪图像处理器实现。

在一些实施例中,3D处理装置与多视点裸眼3D显示屏通信连接。

在一些实施例中,3D处理装置与多视点裸眼3D显示屏的驱动装置通信连接。

在本公开实施例中,提供了一种人眼追踪方法,包括:拍摄黑白图像;获取景深信息;基于黑白图像识别人眼的存在;基于黑白图像和获取的景深信息确定人眼的空间位置。

在本公开实施例中,提供了一种3D显示方法,适用于3D显示设备,3D显示设备包括多视点裸眼3D显示屏,包括对应多个视点的多个子像素;3D显示方法包括:传输3D信号;利用根据上文描述的人眼追踪方法确定用户的人眼的空间位置;基于人眼的空间位置确定人眼所在的视点;基于3D信号渲染与视点对应的子像素。

图2A示出了根据本公开实施例的3D显示设备100的示意图。参考图2A,在本公开实施例中提供了一种3D显示设备100,包括多视点裸眼3D显示屏110、被配置为接收3D信号的视频帧的信号接口140、与信号接口140通信连接的3D处理装置130和人眼追踪装置150。人眼追踪装置150通信连接至3D处理装置130,由此,3D处理装置130可以直接接收人眼追踪数据。

在一些实施例中,3D处理装置被配置为由人眼的空间位置确定用户双眼所在的视点。在另一些实施例中,由人眼的空间位置确定用户双眼所在的视点也可通过人眼追踪装置实现,3D处理装置接收包含视点的人眼追踪数据。

作为解释而非限制性地,人眼追踪数据可以包含人眼的空间位置,例如用户的双眼相对于多视点裸眼3D显示屏的间距、用户的双眼所在的视点、用户视角等。

多视点裸眼3D显示屏110可包括显示面板和覆盖在显示面板上的光栅(未标识)。在图2A所示的实施例中,多视点裸眼3D显示屏110可包括m列n行、亦即m×n个复合像素并因此限定出m×n的显示分辨率。

在一些实施例中,m×n的分辨率可以为全高清(FHD)以上的分辨率,包括但不限于,1920×1080、1920×1200、2048×1280、2560×1440、3840×2160等。

作为解释而非限制地,每个复合像素包括多个复合子像素,各复合子像素由对应于i个视点的i个同色子像素构成,i≥3。在图2A所示的实施例中,i=6,但可以想到i为其他数值。在所示的实施例中,多视点裸眼3D显示屏可相应地具有i(i=6)个视点(V1-V6),但可以想到可以相应地具有更多或更少个视点。

作为解释而非限制地,在图2A所示的实施例中,每个复合像素包括三个复合子像素,并且每个复合子像素由对应于6个视点(i=6)的6个同色子像素构成。三个复合子像素分别对应于三种颜色,即红(R)、绿(G)和蓝(B)。在图2A所示的实施例中,每个复合像素中的三个复合子像素呈单列布置,每个复合子像素的六个子像素呈单行布置。但可以想到,各复合像素中的多个复合子像素成不同排布形式;也可以想到,各复合子像素中的多个子像素成不同排布形式。

作为解释而非限制性地,例如图2A所示,3D显示设备100可设置有单个3D处理装置130。单个3D处理装置130同时处理对多视点裸眼3D显示屏110的各复合像素的各复合子像素的子像素的渲染。在另一些实施例中,3D显示设备100也可设置有一个以上3D处理装置130,它们并行、串行或串并行结合地处理对多视点裸眼3D显示屏110的各复合像素的各复合子像素的子像素的渲染。本领域技术人员将明白,一个以上3D处理装置可以有其他的方式分配且并行处理多视点裸眼3D显示屏110的多行多列复合像素或复合子像素,这落入本公开实施例的范围内。

在一些实施例中,3D处理装置130还可以选择性地包括缓存器131,以便缓存所接收到的视频帧。

在一些实施例中,3D处理装置为FPGA或ASIC芯片或FPGA或ASIC芯片组。

继续参考图2A,3D显示设备100还可包括通过信号接口140通信连接至3D处理装置130的处理器101。在本文所示的一些实施例中,处理器101被包括在计算机或智能终端、如移动终端中或作为其处理器单元。但是可以想到,在一些实施例中,处理器101可以设置在3D显示设备的外部,例如3D显示设备可以为带有3D处理装置的多视点裸眼3D显示器,例如非智能的裸眼3D电视。

为简单起见,下文中的3D显示设备的示例性实施例内部包括处理器。基于此,信号接口140为连接处理器101和3D处理装置130的内部接口。在本文所示的一些实施例中,作为3D显示设备的内部接口的信号接口可以为MIPI、mini-MIPI接口、LVDS接口、min-LVDS接口或Display Port接口。在一些实施例中,如图2A所示,3D显示设备100的处理器101可包括寄存器122。寄存器122可被配置为暂存指令、数据和地址。在一些实施例中,寄存器122可被配置为接收有关多视点裸眼3D显示屏110的显示要求的信息

在一些实施例中,3D显示设备100还可以包括编解码器,配置为对压缩的3D信号解压缩和编解码并将解压缩的3D信号经信号接口140发送至3D处理装置130。

参考图2B,3D显示设备100还包括被配置为采集3D图像的3D拍摄装置120,人眼追踪装置150集成在3D拍摄装置120中,也可以想到集成到处理终端或显示设备的常规摄像装置中。在所示的实施例中,3D拍摄装置120为前置摄像装置。3D拍摄装置120包括摄像头单元121、3D图像处理器126、3D图像输出接口125。

如图2B所示,摄像头单元121包括第一彩色摄像头121a、第二彩色摄像头121b、景深摄像头121c。在另一些实施例中,3D图像处理器126可以集成在摄像头单元121内。在一些实施例中,第一彩色摄像头121a被配置为获得拍摄对象的第一彩色图像,第二彩色摄像头121b被配置为获得拍摄对象的第二彩色图像,通过合成这两幅彩色图像获得中间点的合成彩色图像;景深摄像头121c被配置为获得拍摄对象的景深信息。通过合成获得的合成彩色图像和景深信息形成3D图像。在本公开实施例中,第一彩色摄像头和第二彩色摄像头是相同的彩色摄像头。在另一些实施例中,第一彩色摄像头和第二彩色摄像头也可以是不同的彩色摄像头。在这种情况下,为了获得合成彩色图像,可以对第一彩色图像和第二彩色图像进行校准或矫正。景深摄像头121c可以是TOF(飞行时间)摄像头或结构光摄像头。景深摄像头121c可以设置在第一彩色摄像头和第二彩色摄像头之间。

在一些实施例中,3D图像处理器126被配置为将第一彩色图像和第二彩色图像合成为合成彩色图像,并将获得的合成彩色图像与景深信息合成为3D图像。所形成的3D图像通过3D图像输出接口125传输至3D显示设备100的处理器101。

可选地,第一彩色图像、第二彩色图像以及景深信息经由3D图像输出接口125直接传输至3D显示设备100的处理器101,并通过处理器101进行上述合成两幅彩色图像以及形成3D图像等处理。

可选地,3D图像输出接口125还可通信连接到3D显示设备100的3D处理装置130,从而可通过3D处理装置130进行上述合成彩色图像以及形成3D图像等处理。

在一些实施例中,第一彩色摄像头和第二彩色摄像头中至少一个是广角的彩色摄像头。

继续参考图2B,人眼追踪装置150集成在3D拍摄装置120内并且包括人眼追踪器151、人眼追踪图像处理器152和人眼追踪数据接口153。

人眼追踪器151包括黑白摄像头151a和景深获取装置151b。黑白摄像头151a被配置为拍摄黑白图像,景深获取装置151b被配置为获取景深信息。在3D拍摄装置120是前置的并且人眼追踪装置150集成在3D拍摄装置120内的情况下,人眼追踪装置150也是前置的。那么,黑白摄像头151a的拍摄对象是用户脸部,基于拍摄到的黑白图像识别出人脸或人眼,景深获取装置至少获取人眼的景深信息,也可以获取人脸的景深信息。

在一些实施例中,人眼追踪装置150的人眼追踪数据接口153通信连接至3D显示设备100的3D处理装置130,由此,3D处理装置130可以直接接收人眼追踪数据。在另一些实施例中,人眼追踪图像处理器152可通信连接至3D显示设备100的处理器101,由此人眼追踪数据可以从处理器101通过人眼追踪数据接口153被传输至3D处理装置130。

在一些实施例中,人眼追踪装置150与摄像头单元121通信连接,由此可在拍摄3D图像时使用人眼追踪数据。

可选地,人眼追踪器151还设置有红外发射装置154。在黑白摄像头151a工作时,红外发射装置154被配置为选择性地发射红外光,以在环境光线不足时、例如在夜间拍摄时起到补光作用,从而在环境光线弱的条件下也能拍摄能识别出人脸及人眼的黑白图像。

在一些实施例中,人眼追踪装置150或集成有人眼追踪装置的处理终端或显示设备可以配置为,在黑白摄像头工作时,基于接收到的光线感应信号,例如检测到光线感应信号低于给定阈值时,控制红外发射装置的开启或调节其大小。在一些实施例中,光线感应信号是从处理终端或显示设备集成的环境光传感器接收的。

可选地,红外发射装置154配置为发射波长大于或等于1.5微米的红外光,亦即长波红外光。与短波红外光相比,长波红外光穿透皮肤的能力较弱,因此对人眼的伤害较小。

拍摄到的黑白图像被传输至人眼追踪图像处理器152。示例性地,人眼追踪图像处理器配置为具有视觉识别功能、例如人脸识别功能,并且配置为基于黑白图像识别出人脸和人眼。基于识别出的人眼,能够得到用户相对于显示设备的显示屏的视角,这将在下文中描述。

通过景深获取装置151b获取到的人眼或人脸的景深信息也被传输至人眼追踪图像处理器152。人眼追踪图像处理器152被配置为基于黑白图像和获取的景深信息确定人眼的空间位置,这将在下文中描述。

在一些实施例中,景深获取装置151b为结构光摄像头或TOF摄像头。

作为解释而非限制性地,TOF摄像头包括投射器和接收器,通过投射器将光脉冲到被观测对象上,然后通过接收器接收从被观测对象反射回的光脉冲,通过光脉冲的往返时间来计算被观测对象与摄像头的距离。

作为解释而非限制性地,结构光摄像头包括投影器和采集器,通过投影器将面结构光、例如编码结构光投射到被观测对象上,在被观测对象表面形成面结构光的畸变图像,然后通过采集器采集并解析畸变图像,从而还原被观测对象的三维轮廓、空间信息等。

在一些实施例中,黑白摄像头151a是广角的黑白摄像头。

在一些实施例中,景深获取装置151b和3D拍摄装置120的景深摄像头121c可以是相同的。在这种情况下,景深获取装置151b和景深摄像头121c可以是同一个TOF摄像头或同一个结构光摄像头。在另一些实施例中,景深获取装置151b和景深摄像头121c可以是不同的。

在一些实施例中,人眼追踪装置150包括视角确定装置155,视角确定装置155被配置为计算用户相对于3D显示设备或其显示屏或黑白摄像头的视角。

基于黑白摄像头151a拍摄的黑白图像,视角包括但不限于用户的单眼与黑白摄像头镜头中心O/显示屏中心DLC的连线相对于黑白摄像头平面MCP/显示屏平面DLP的倾斜角、双眼连线的中点(双眼中心)与黑白摄像头镜头中心O/显示屏中心DLC的连线相对于黑白摄像头平面MCP/显示屏平面DLP的倾斜角。

在此基础上,再结合景深获取装置151b获取的深度图像,除了上述倾斜角,视角还可以包括双眼连线相对于黑白摄像头平面MCP/显示屏平面DLP的倾斜角、人脸所在平面HFP相对于黑白摄像头平面MCP/显示屏平面DLP的倾斜角等。其中,人脸所在平面HFP可通过提取若干人脸特征来确定,例如眼睛和耳朵、眼睛和嘴角、眼睛和下巴等。在本公开实施例中,由于人眼追踪装置150及其黑白摄像头151a相对于3D显示设备或其显示屏为前置的,可将黑白摄像头平面MCP视作显示屏平面DLP。

作为解释而非限制性的,上文描述的线相对于面的倾斜角包括但不限于线与线在面内的投影的夹角、线在面内的投影与面的水平方向的夹角、线在面内的投影与面的竖直方向的夹角。其中,线与线在面内的投影的夹角可具有水平方向的分量和竖直方向的分量。

在一些实施例中,如图2B所示,视角确定装置155可集成设置在人眼追踪图像处理器152内。如上文所述,人眼追踪图像处理器152被配置为基于黑白图像和景深信息确定人眼的空间位置。在本公开实施例中,人眼的空间位置包括但不限于上文描述的视角、人眼相对于黑白摄像头平面MCP/显示屏平面DLP的距离、人眼相对于人眼追踪装置或其黑白摄像头/3D显示设备或其显示屏的空间坐标等。在一些实施例中,人眼追踪装置150还可包括视角数据输出接口,视角数据输出接口被配置为输出由视角确定装置计算出的视角。

在另一些实施例中,视角确定装置可集成设置在3D处理装置内。

作为解释而非限制性地,通过黑白摄像头151a拍摄的包含了用户左眼和右眼的黑白图像,可得知左眼和右眼在黑白摄像头151a的焦平面FP内成像的X轴(水平方向)坐标和Y轴(竖直方向)坐标。如图3所示,以黑白摄像头151a的镜头中心O为原点,X轴和与X轴垂直的Y轴(未示出)形成黑白摄像头平面MCP,其与焦平面FP平行;黑白摄像头151a的光轴方向为Z轴,Z轴也是深度方向。也就是说,在图3所示的XZ平面内,左眼和右眼在焦平面FP内成像的X轴坐标XR、XL是已知的;而且,黑白摄像头151a的焦距f是已知的;在这种情况下,可算出左眼和右眼与黑白摄像头镜头中心O的连线在XZ平面内的投影相对于X轴的倾斜角β,这将在下文中进一步描述。同理,在(未示出的)YZ平面内,左眼和右眼在焦平面FP内成像的Y轴坐标是已知的,再结合已知的焦距f,可算出左眼和右眼与黑白摄像头镜头中心O的连线在YZ平面内的投影相对于黑白摄像头平面MCP的Y轴的倾斜角。

作为解释而非限制性地,通过黑白摄像头151a拍摄的包含了用户左眼和右眼的黑白图像以及景深获取装置151b获取的左眼和右眼的景深信息,可得知左眼和右眼在黑白摄像头151a的坐标系内的空间坐标(X,Y,Z),其中,Z轴坐标即为景深信息。据此,如图3所示,可算出左眼和右眼的连线在XZ平面内的投影与X轴的夹角α。同理,在(未示出的)YZ平面内,可算出左眼和右眼的连线在YZ平面内的投影与Y轴的夹角。

图3示意性地示出了利用黑白摄像头151a和景深获取装置151b(未示出)确定人眼的空间位置的几何关系模型的俯视图。其中,R和L分别表示用户的右眼和左眼,XR和XL分别为用户右眼R和左眼L在黑白摄像头151a的焦平面FP内成像的X轴坐标。在已知黑白摄像头151a的焦距f、双眼在焦平面FP内的X轴坐标XR、XL的情况下,可以得出用户的右眼R和左眼L与镜头中心O的连线在XZ平面内的投影相对于X轴的倾斜角β

在此基础上,通过(未示出的)景深获取装置151b获得的右眼R和左眼L的景深信息,可得知用户右眼R和左眼L相对于黑白摄像头平面MCP/显示屏平面DLP的距离DR和DL。据此,可以得出用户双眼连线在XZ平面内的投影与X轴的夹角α以及瞳距P分别为:

上述计算方法和数学表示仅是示意性的,本领域技术人员可以想到其他计算方法和数学表示,以得到所需的人眼的空间位置。本领域技术人员也可以想到,必要时将黑白摄像头的坐标系与显示设备或其显示屏的坐标系进行变换。

在一些实施例中,当距离DR和DL不等并且夹角α不为零时,可认为用户斜视显示屏平面DLP;当距离DR和DL相等并且视角α为零时,可认为用户平视显示屏平面DLP。在另一些实施例中,可以针对夹角α设定阈值,在夹角α不超过阈值的情况下,可以认为用户平视显示屏平面DLP。

在一些实施例中,人眼追踪装置150包括人眼追踪数据接口153,被配置为传输人眼空间位置信息,包括但不限于如上文描述的倾斜角、夹角、空间坐标等。利用人眼空间位置信息可向用户提供有针对性的或定制化的3D显示画面。

作为解释而非限制性地,视角、例如用户双眼中心与显示屏中心DLC的连线相对于水平方向(X轴)或竖直方向(Y轴)的夹角通过人眼追踪数据接口153传输至3D处理装置130。3D处理装置130基于接收到的视角随动地生成与视角相符合的3D显示画面,从而能够向用户呈现从不同角度观察的显示对象。

示例性地,基于用户双眼中心与显示屏中心DLC的连线相对于水平方向(X轴)的夹角能够呈现水平方向上的随动效果;基于用户双眼中心与显示屏中心DLC的连线相对于竖直方向(Y轴)的夹角能够呈现竖直方向上的随动效果。

作为解释而非限制性地,用户的左眼和右眼的空间坐标通过人眼追踪数据接口153传输至3D处理装置130。3D处理装置130基于接收到的空间坐标确定用户双眼所处的且由多视点裸眼3D显示屏110提供的视点,并基于3D信号的视频帧渲染相应的子像素。

示例性地,当基于人眼空间位置信息确定用户的双眼各对应一个视点时,基于3D信号的视频帧渲染各复合像素的多个复合子像素中与这两个视点相对应的子像素,也可额外地渲染各复合像素的多个复合子像素中与这两个视点相邻的视点相对应的子像素。

示例性地,当基于人眼空间位置信息确定用户的双眼各分别位于两个视点之间时,基于3D信号的视频帧渲染各复合像素的多个复合子像素中与这四个视点相对应的子像素。

示例性地,当基于人眼空间位置信息确定用户双眼中至少一只眼睛产生了运动时,可基于3D信号的下一视频帧渲染各复合像素的多个复合子像素中与新的预定的视点对应的子像素。

示例性地,当基于人眼空间位置信息确定有一个以上用户时,可基于3D信号的视频帧渲染各复合像素的多个复合子像素与各用户双眼分别所处的视点相对应的子像素。

在一些实施例中,分别确定用户的视角和视点位置,并据此提供随视角和视点位置变化的3D显示画面,提升观看体验。

在另一些实施例中,人眼空间位置信息也可被直接传输至3D显示设备100的处理器101,3D处理装置130通过人眼追踪数据接口153从处理器101接收/读取人眼空间位置信息。

在一些实施例中,黑白摄像头151a配置为拍摄出黑白图像序列,其包括按照时间前后排列的多幅黑白图像。

在一些实施例中,人眼追踪图像处理器152包括缓存器156和比较器157。缓存器156被配置为缓存黑白图像序列中分别按照时间前后排列的多幅黑白图像。比较器157被配置为比较黑白图像序列中按照时间前后拍摄的多幅黑白图像。通过比较,例如可以判断人眼的空间位置是否变化或者判断人眼是否还处于观看范围内等。

在一些实施例中,人眼追踪图像处理器152还包括判决器(未示出),被配置为基于比较器的比较结果,在黑白图像序列中的当前黑白图像中未识别到人眼的存在且在之前或之后的黑白图像中识别到人眼的存在时,基于之前或之后的黑白图像确定的人眼空间位置信息作为当前的人眼空间位置信息。这种情况例如为用户短暂转动头部。在这种情况下,有可能短暂地无法识别到用户的脸部及其眼睛。

示例性地,在缓存器156的缓存段内存有黑白图像序列中的若干黑白图像。在某些情况下,无法从所缓存的当前黑白图像中识别出人脸及人眼,然而可以从所缓存的之前或之后的黑白图像中识别出人脸及人眼。在这种情况下,可以将基于在当前黑白图像之后的、也就是更晚拍摄的黑白图像确定的人眼空间位置信息作为当前的人眼空间位置信息;也可以将基于在当前黑白图像之前的、也就是更早拍摄黑白图像确定的人眼空间位置信息作为当前的人眼空间位置信息。此外,也可以对基于上述之前和之后的能识别出人脸及人眼的黑白图像确定的人眼空间位置信息取平均值、进行数据拟合、进行插值或以其他方法处理,并且将得到的结果作为当前的人眼空间位置信息。

在一些实施例中,黑白摄像头151a被配置为以24帧/秒或以上的频率拍摄黑白图像序列。示例性地,以30帧/秒的频率拍摄。示例性地,以60帧/秒的频率拍摄。

在一些实施例中,黑白摄像头151a被配置为以与3D显示设备的显示屏刷新频率相同的频率进行拍摄。

本公开实施例还可以提供一种人眼追踪方法,其利用上述实施例中的人眼追踪装置来实现。

参考图4,在一些实施例中,人眼追踪方法包括:

S401:拍摄用户的人脸的黑白图像;

S402:获取人脸的景深信息;

S403:基于拍摄的黑白图像和景深信息确定人眼的空间位置。

参考图5,在一些实施例中,人眼追踪方法包括:

S501:拍摄用户的人脸的黑白图像;

S502:获取人脸的景深信息;

S503:基于拍摄的黑白图像识别人眼的存在;

S504:基于拍摄的黑白图像和景深信息确定人眼的空间位置;

S505:传输包含人眼的空间位置的人眼空间位置信息。

参考图6,在一些实施例中,人眼追踪方法包括:

S601:拍摄出包括用户的人脸的黑白图像的黑白图像序列;

S602:缓存黑白图像序列中多幅黑白图像;

S603:比较黑白图像序列中的前后多幅黑白图像;

S604:获取人脸的景深信息;

S605:当通过比较在黑白图像序列中的当前黑白图像未识别到人眼的存在且在之前或之后的黑白图像中识别到人眼的存在时,基于之前或之后的黑白图像和获取的景深信息确定的人眼空间位置信息作为当前的人眼空间位置信息。

本公开实施例还可以提供一种3D显示方法,其适用于上述实施例中的3D显示设备,3D显示设备包括多视点裸眼3D显示屏,多视点裸眼3D显示屏包括对应多个视点的多个子像素。

参考图7,在一些实施例中,3D显示方法包括:

S701:确定用户人眼的空间位置;

S702:根据用户人眼的空间位置确定视点,并且基于3D信号渲染与视点对应的子像素。

本公开实施例提供了一种3D显示终端800,参考图8,3D显示终端800包括:处理器814、存储器811、多视点裸眼3D显示屏810,还可以包括通信接口812和总线813。其中,多视点裸眼3D显示屏810、处理器814、通信接口812、存储器811通过总线813完成相互间的通信。通信接口812可以用于信息传输。处理器814可以调用存储器811中的逻辑指令,以执行上述实施例的3D显示方法。

此外,存储器811中的逻辑指令可以通过软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。

存储器811作为一种计算机可读存储介质,可被配置为存储软件程序、计算机可执行程序,如本公开实施例中的方法对应的程序指令/模块。处理器814通过运行存储在存储器811中的程序指令/模块,从而执行功能应用以及数据处理,即实现上述方法实施例中的人眼追踪方法和/或3D显示方法。

存储器811可包括存储程序区和存储数据区,其中,存储程序区可存储操作系统、至少一个功能所需的应用程序;存储数据区可存储根据终端设备的使用所创建的数据等。此外,存储器811可以包括高速随机存取存储器,还可以包括非易失性存储器。

本领域技术人员可以意识到,结合本文中所公开的实施例描述的各示例的单元及算法步骤,能够以电子硬件、或者计算机软件和电子硬件的结合来实现。这些功能究竟以硬件还是软件方式来执行,可以取决于技术方案的特定应用和设计约束条件。本领域技术人员可以对每个特定的应用来使用不同方法以实现所描述的功能,但是这种实现不应认为超出本公开实施例的范围。

本文所披露的实施例中,所揭露的方法、产品(包括但不限于装置、设备等),可以通过其它的方式实现。例如,以上所描述的装置或设备实施例仅仅是示意性的,例如,单元的划分,可以仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。另外,所显示或讨论的相互之间的耦合或直接耦合或通信连接可以是通过一些接口,装置或单元的间接耦合或通信连接,可以是电性,机械或其它的形式。作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本实施例。另外,在本公开实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。

另外,在附图中的流程图所对应的描述中,不同的方框所对应的操作或步骤也可以以不同于描述中所披露的顺序发生,有时不同的操作或步骤之间不存在特定的顺序。

- 人眼追踪装置、方法及3D显示设备、方法和终端

- 一种利用陀螺仪辅助人眼追踪的3D显示方法及装置