状态判定装置、状态判定方法以及状态判定程序

文献发布时间:2023-06-19 11:55:48

技术领域

本发明涉及状态判定装置、状态判定方法以及状态判定程序。

背景技术

人有时处于不清醒状态。例如,不清醒状态是瞌睡状态、因饮酒而瞌睡的状态等。

另外,为了防止事故,判定车内或工厂内的人的不清醒状态的技术正在开发中。例如,从心率、脑电波、眨眼等中提取在不清醒状态时发生变化的特征量。接着,对该特征量和阈值进行比较。根据比较结果判定不清醒状态。这样,不清醒状态可以根据心率等生物信号进行判定。但是,在该判定方法中,人佩戴着传感器。因此,在该判定方法中,人感到麻烦。此外,在人没有佩戴传感器的情况下,该判定方法不能使用。并且,该判定的方法由于使用传感器,因而耗费成本。

在此,提出有检测瞌睡状态的技术(参照专利文献1)。例如,专利文献1的瞌睡驾驶检测装置使用眨眼频度来检测驾驶员的瞌睡状态。此外,提出有判定驾驶员的困倦状态的技术(参照专利文献2)。例如,专利文献2的困倦判定装置使用眨眼频度来判定困倦状态。

现有技术文献

专利文献

专利文献1:日本特开平11-339200号公报

专利文献2:日本特开2008-212298号公报

非专利文献

非专利文献1:Paul Viola,Michael J Jones"Robust Real-Time FaceDetection International Journal of Computer Vision57(2)",2004年

非专利文献2:Laurenz Wiskott,Jean-Marc Fellous,Norbert Kruger,Christoph von der Malsburg"Face Recognition by Elastic Bunch Graph Matching",1996年

非专利文献3:Navneet Dalal and Bill Triggs"Histograms of OrientedGradients for Human Detection"

发明内容

发明要解决的课题

专利文献1、2的技术使用眨眼频度。但是,眨眼频度的个人差异较大。例如,在清醒时眨眼频度非常高的人的情况下,难以使用专利文献1、2的技术来判定是否处于不清醒状态。

因此,如何高精度地判定不清醒状态成为问题。

本发明的目的在于高精度地判定不清醒状态。

用于解决课题的手段

提供本发明一个方式的状态判定装置。状态判定装置具有:提取部,其从通过拍摄用户的面部而依次取得的多个帧的各个帧中提取表示所述面部的区域的面部区域,从所述面部区域中提取表示面部的部位的面部特征点,根据所述面部特征点计算面部特征量提取区域,从所述面部特征量提取区域中提取作为特征量的面部特征量,所述面部特征量提取区域是在所述用户处于不清醒状态时在所述面部区域中产生变化的区域;状态判定部,其根据所述多个帧各自的所述面部特征量和预先生成的判定信息,判定所述用户是否处于所述不清醒状态;以及输出部,其输出判定结果。

发明效果

根据本发明,能够高精度地判定不清醒状态。

附图说明

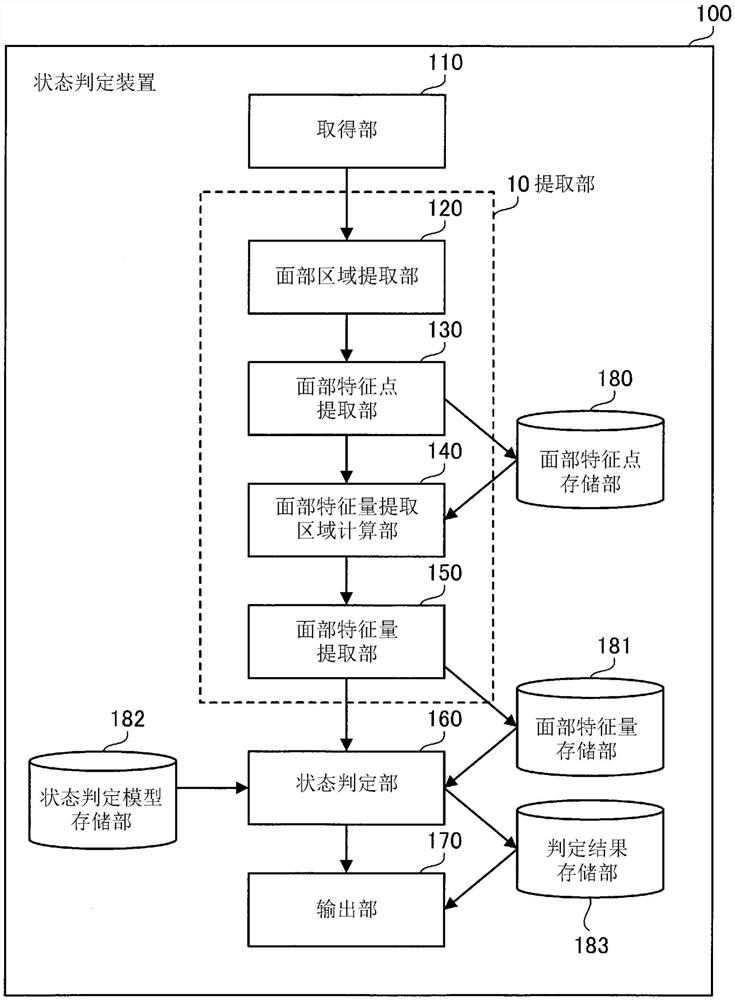

图1是表示实施方式1的状态判定装置的图。

图2是表示实施方式1的状态判定装置具有的硬件的结构的图。

图3是表示实施方式1的面部特征点表的例子的图。

图4的(A)、(B)是表示面部特征量提取区域的计算例的图。

图5是表示实施方式1的面部特征量表的例子的图。

图6是表示实施方式1的状态判定模型表的例子的图。

图7是用于说明实施方式1的计算在眉间产生皱纹的次数的方法的图。

图8是表示实施方式1的不清醒等级的具体例的图。

图9是表示实施方式1的判定结果表的例子的图。

图10是表示实施方式1的面部特征量提取区域的计算处理的流程图。

图11是表示实施方式1的面部特征量的提取处理的流程图。

图12是表示实施方式1的计数处理的流程图。

图13是表示实施方式1的不清醒状态的判定处理的流程图。

图14是表示实施方式2的状态判定装置的结构的功能框图。

图15是表示实施方式2的平均面部特征点模型表的一例的图。

图16的(A)~(C)是表示面部条件表的一例的图。

图17是表示实施方式2的提取区域决定模型表的一例的图。

图18是表示实施方式2的面部条件的判定处理的流程图。

图19是表示实施方式2的面部特征量提取区域的决定处理的流程图。

具体实施方式

以下,参照附图说明实施方式。以下的实施方式只不过是例子,在本发明的范围内能够进行各种变更。

实施方式1

图1是表示实施方式1的状态判定装置的图。状态判定装置100是执行状态判定方法的装置。

状态判定装置100判定不清醒状态。例如,不清醒状态是瞌睡状态、因饮酒而瞌睡的状态等。此外,不清醒状态包含意识朦胧的状态。例如,意识朦胧的状态是用户昏昏欲睡的状态、用户因饮酒而醉酒的状态等。这里,用户有时在从瞌睡状态暂时成为清醒状态后再次成为瞌睡状态。对于这样用户从瞌睡状态经过短时间后再次成为瞌睡状态的情况,也可以认为用户处于瞌睡状态。因此,不清醒状态包含用户从瞌睡状态暂时成为清醒状态后再次成为瞌睡状态的情况。

接着,说明状态判定装置100具有的硬件。

图2是表示实施方式1的状态判定装置具有的硬件的结构的图。状态判定装置100具有处理器101、易失性存储装置102、非易失性存储装置103、摄像机104以及显示器105。

处理器101控制状态判定装置100整体。例如,处理器101是CPU(CentralProcessing Unit:中央处理单元)或FPGA(Field Programmable Gate Array:现场可编程门阵列)等。处理器101可以是多处理器。状态判定装置100可以通过处理电路来实现,或者也可以通过软件、固件或者它们的组合来实现。另外,处理电路也可以是单一电路或复合电路。

易失性存储装置102是状态判定装置100的主存储装置。例如,易失性存储装置102是RAM(Random Access Memory:随机存取存储器)。非易失性存储装置103是状态判定装置100的辅助存储装置。例如,非易失性存储装置103是SSD(Solid State Drive:固态硬盘)。

摄像机104是拍摄面部的装置。此外,摄像机104也称作摄像设备。显示器105是显示信息的装置。此外,显示器105也称作显示设备。

另外,状态判定装置100在不具有摄像机104和显示器105的状态下,也可以被认为是信息处理装置。

返回图1,说明状态判定装置100。

状态判定装置100具有取得部110、提取部10、状态判定部160和输出部170。提取部10具有面部区域提取部120、面部特征点提取部130、面部特征量提取区域计算部140和面部特征量提取部150。

此外,状态判定装置100具有面部特征点存储部180、面部特征量存储部181、状态判定模型存储部182和判定结果存储部183。

提取部10、取得部110、面部区域提取部120、面部特征点提取部130、面部特征量提取区域计算部140、面部特征量提取部150、状态判定部160和输出部170的一部分或全部可以由处理器101实现。

此外,提取部10、取得部110、面部区域提取部120、面部特征点提取部130、面部特征量提取区域计算部140、面部特征量提取部150、状态判定部160和输出部170的一部分或全部也可以作为处理器101执行的程序的模块来实现。例如,由处理器101执行的程序也被称作状态判定程序。例如,状态判定程序被保存在易失性存储装置102、非易失性存储装置103等记录介质中。

面部特征点存储部180、面部特征量存储部181、状态判定模型存储部182和判定结果存储部183也可以作为在易失性存储装置102或非易失性存储装置103中确保的存储区域来实现。

取得部110从摄像机104取得通过拍摄用户的面部而依次取得的多个帧。多个帧可以表现为动态图像。帧是图像。此外,多个帧也可以表现为在不同的时刻拍摄用户的面部而得到的多个帧。

提取部10从多个帧的各个帧中提取面部区域,从面部区域中提取面部特征点,根据面部特征点计算面部特征量提取区域,从面部特征量提取区域中提取面部特征量。另外,面部区域表示面部的区域。面部特征点表示面部的部位。面部特征量提取区域是在用户处于不清醒状态时在面部区域中产生变化的区域。面部特征量是特征量。

此外,面部特征量提取区域也可以表现为:在用户处于不清醒状态时在面部区域中产生变化且在用户处于不清醒状态时作为用户的面部运动不产生个人差异的区域。

使用面部区域提取部120、面部特征点提取部130、面部特征量提取区域计算部140和面部特征量提取部150详细说明由提取部10执行的处理。

面部区域提取部120从动态图像中提取面部区域。面部区域提取部120可以使用基于Adaboost学习的利用Haar-like特征的识别器来实现。例如,在非专利文献1中记载有提取面部区域的方法。

面部特征点提取部130基于面部区域提取轮廓、眉毛、眼睛、鼻子、嘴等面部特征点。例如,在非专利文献2中记载有提取面部特征点的方法。

面部特征点提取部130将面部特征点保存在面部特征点存储部180中。这里,对面部特征点存储部180进行说明。面部特征点存储部180存储面部特征点表。

图3是表示实施方式1的面部特征点表的例子的图。面部特征点表180a被保存在面部特征点存储部180中。面部特征点表180a具有特征点、面部朝向的项目。此外,面部特征点表180a具有坐标、角度的项目。

例如,将面部特征点提取部130提取左眼内端而得到的坐标登记在面部特征点表180a中。另外,左眼内端也称作左内眼角。

面部特征点提取部130根据面部特征点计算面部朝向。面部朝向由Yaw、Pitch、Roll(偏转、俯仰、滚转)表示。面部特征点提取部130将面部朝向登记在面部特征点表180a中。

返回图1,说明面部特征量提取区域计算部140。

面部特征量提取区域计算部140计算在不清醒状态的判定中使用的面部特征量的提取区域。

在此,作为用户处于不清醒状态时进行的行为或者用户成为不清醒状态的预兆行为,用户进行抗拒困倦的行为。抗拒困倦的行为是指用户故意紧闭眼睛的行为。抗拒困倦的行为也可以表现为用户故意紧闭眼睛的强烈眨眼。在用户故意紧闭眼睛的情况下,在眉间产生皱纹。因此,面部特征量提取区域计算部140计算面部区域内的眉间区域作为面部特征量提取区域。

此外,在用户因饮酒而处于不清醒状态等的情况下,用户为了缓解口渴而舔嘴唇。因此,面部特征量提取区域计算部140计算面部区域内的嘴部区域作为面部特征量提取区域。

进而,作为用户处于不清醒状态时进行的行为或者用户成为不清醒状态的预兆行为,用户打呵欠。在用户打呵欠的情况下,嘴部张开。此外,在用户打呵欠的情况下,在脸颊上产生皱纹。因此,面部特征量提取区域计算部140计算面部区域内的嘴部区域和脸颊区域作为面部特征量提取区域。

这里,作为具体例,说明眉间区域的计算和嘴部区域的计算。

图4的(A)、(B)是表示面部特征量提取区域的计算例的图。图4的(A)是眉间区域的计算例。面部特征量提取区域计算部140从由面部特征点提取部130提取出的面部特征点中确定左右内眼角。面部特征量提取区域计算部140计算左内眼角与右内眼角之间的中间点200。面部特征量提取区域计算部140计算以中间点200为中心的矩形区域201(即,a[像素]×a[像素]的区域)。矩形区域201是眉间区域。这样,面部特征量提取区域计算部140计算眉间区域。

此外,面部特征量提取区域计算部140根据由面部区域提取部120提取出的作为面部区域的矩形区域,使矩形区域201的各边成为k倍。因此,面部特征量提取区域计算部140能够计算(a×k)[像素]×(a×k)[像素]的矩形区域。

这里,有时不能根据面部朝向准确地计算眉间区域。因此,面部特征量提取区域计算部140可以根据由面部特征点提取部130计算出的面部朝向和中间点来计算眉间区域。具体进行说明。例如,假设面部朝向左方。当面部朝左方时,眉间产生皱纹的区域的中心位于左内眼角与右内眼角之间的中间点靠左的位置。因此,面部特征量提取区域计算部140计算该中间点向左平行移动l[像素]的坐标,作为眉间区域的中心坐标。面部特征量提取区域计算部140计算以中心坐标为中心的矩形区域。

图4的(B)是嘴部区域的计算例。面部特征量提取区域计算部140从面部特征点提取部130提取出的面部特征点中确定左右嘴角。面部特征量提取区域计算部140计算左嘴角与右嘴角之间的中间点210。面部特征量提取区域计算部140计算以中间点210为中心的矩形区域211(即,b[像素]×b[像素]的区域)。矩形区域211是嘴部区域。这样,面部特征量提取区域计算部140计算嘴部区域。

此外,面部特征量提取区域计算部140根据由面部区域提取部120提取出的作为面部区域的矩形区域,使矩形区域211的各边成为k倍。因此,面部特征量提取区域计算部140能够计算(b×k)[像素]×(b×k)[像素]的矩形区域。

并且,面部特征量提取区域计算部140也可以根据面部特征点提取部130计算出的面部朝向和面部特征点,计算嘴部区域。计算方法如上所述。

面部特征量提取区域计算部140同样能够计算脸颊区域。

返回图1,说明面部特征量提取部150。

面部特征量提取部150基于眉间区域、嘴部区域和脸颊区域来提取面部特征量。面部特征量是HOG(Histograms of Oriented Gradients:定向梯度直方图)特征量。例如,HOG特征量记载在非专利文献3中。

此外,面部特征量也可以是HOG特征量以外的特征量。例如,面部特征量是SIFT(Scaled Invariance Feature Transform:尺度不变特征变换)特征量、SURF(Speeded-upRobust Features:加速鲁棒特征)、Haar-like特征量等。

面部特征量提取部150将面部特征量保存在面部特征量存储部181中。这里,对面部特征量存储部181进行说明。面部特征量存储部181存储面部特征量表。

图5是表示实施方式1的面部特征量表的例子的图。面部特征量表181a被保存在面部特征量存储部181中。面部特征量表181a具有特征量和值的项目。面部特征量提取部150将面部特征量登记在面部特征量表181a中。即,面部特征量提取部150将表示面部特征量的信息登记在面部特征量表181a的面部特征量的项目中。并且,面部特征量提取部150将与面部特征量对应的值登记在面部特征量表181a的值的项目中。

此外,在面部特征量表181a中登记有与取得部110在规定时间取得的n(n为2以上的整数)个帧分别对应的HOG特征量。另外,例如规定时间为5分钟。

返回图1,说明状态判定部160。

状态判定部160根据多个帧各自的面部特征量和预先生成的判定信息,判定用户是否处于不清醒状态。此外,状态判定部160也可以表现为:根据与多个帧分别对应的面部特征量和预先保存的判定信息,判定用户是否处于不清醒状态。

对状态判定部160进行详细说明。

状态判定部160根据HOG特征量判定不清醒状态。具体而言,状态判定部160根据用户在规定时间内进行了上述的3个行为的次数,判定不清醒状态。另外,3个行为是:用户使眉间产生皱纹的行为、用户为了缓解口渴而舔嘴唇的行为、以及用户打呵欠的行为。此外,例如规定时间为5分钟。

这里,状态判定模型存储部182中存储有用于判定不清醒状态的信息。此外,在状态判定装置100执行不清醒状态的判定之前,将该信息预先保存在状态判定模型存储部182中。

该信息称作状态判定模型表。对状态判定模型表进行说明。

图6是表示实施方式1的状态判定模型表的例子的图。状态判定模型表182a被保存在状态判定模型存储部182中。状态判定模型表182a具有不清醒等级、5分钟内眉间产生皱纹的次数、5分钟内舔嘴唇的次数以及5分钟内打呵欠的次数的项目。

状态判定模型表182a也称作判定信息。此外,状态判定模型表182a包含用于决定与用户使眉间产生皱纹的次数对应的不清醒等级的信息。状态判定模型表182a包含用于决定与用户舔嘴唇的次数对应的不清醒等级的信息。状态判定模型表182a包含用于决定与用户打呵欠的次数对应的不清醒等级的信息。

这里,说明状态判定部160判定为在眉间产生皱纹的方法。状态判定部160使用式(1)计算余弦相似度Sn。

平均值Hm是由面部特征量提取部150针对高清醒状态(即,通常状态)的多个帧提取出的HOG特征量的平均值。此外,在状态判定装置100执行不清醒状态的判定之前,预先计算平均值Hm。此外,例如平均值Hm被保存在面部特征量存储部181中。

HOG特征量Hn是与取得部110在规定时间取得的n帧对应的HOG特征量。

在此,对表示余弦相似度Sn与时间的关系例的图进行说明。

图7是用于说明实施方式1的计算在眉间产生皱纹的次数的方法的图。图7的曲线图的纵轴表示余弦相似度Sn。图7的曲线图的横轴表示时间。在眉间产生皱纹的情况下,皱纹的边缘表现得较强。在皱纹的边缘表现得较强的情况下,余弦相似度Sn成为较小的值。

状态判定部160在余弦相似度Sn是比预先设定的阈值S小的值的情况下,判定为眉间产生皱纹。状态判定部160在判定为眉间产生皱纹的情况下,对在眉间产生皱纹的次数进行增计数。

判定为在眉间产生皱纹的方法和判定为舔嘴唇的方法是同样的方法。此外,判定为在眉间产生皱纹的方法和判定为打呵欠的方法是同样的方法。因此,对判定为舔嘴唇的方法和判定为打呵欠的方法省略说明。

这样,状态判定部160根据从多个帧各自的眉间区域中提取出的面部特征量,计算用户使眉间产生皱纹的次数。状态判定部160根据从多个帧各自的嘴部区域中提取出的面部特征量,计算用户舔嘴唇的次数。状态判定部160根据从多个帧各自的嘴部区域和脸颊区域中提取出的面部特征量,计算用户打呵欠的次数。

状态判定部160根据在眉间产生皱纹的次数和状态判定模型表182a,决定不清醒等级。状态判定部160根据舔嘴唇的次数和状态判定模型表182a,决定不清醒等级。状态判定部160根据打呵欠的次数和状态判定模型表182a,决定不清醒等级。

图8是表示实施方式1的不清醒等级的具体例的图。图8示出根据在眉间产生皱纹的次数决定的不清醒等级是等级2。图8示出根据舔嘴唇的次数决定的不清醒等级是等级4。图8示出根据打呵欠的次数决定的不清醒等级是等级3。

状态判定部160计算3个不清醒等级的平均值。例如,状态判定部160计算作为平均值的等级3(=(2+4+3)/3)。此外,状态判定部160也可以对平均值的小数点以下进行四舍五入。

状态判定部160在平均值为预先设定的阈值以上的情况下,判定为用户处于不清醒状态。例如,阈值是3。另外,该阈值也称作阈值等级。这样,状态判定部160在平均值为等级3以上的情况下,判定为用户处于不清醒状态。另外,能够根据评价方法来变更将哪个等级判定为不清醒状态。

状态判定部160将判定结果保存在判定结果存储部183中。判定结果是平均值。这里,对判定结果存储部183进行说明。判定结果存储部183存储判定结果表。

图9是表示实施方式1的判定结果表的例子的图。判定结果表183a被保存在判定结果存储部183中。判定结果表183a具有不清醒等级的项目。状态判定部160将计算出的平均值登记到判定结果表183a中。

此外,状态判定部160也可以根据通过使用Random Forest(随机森林)、SVM(Support Vector Machine:支持向量机)、Adaboost、CNN(Convolutional NeuralNetwork:卷积神经网络)等进行机器学习而得到的信息和面部特征量,判定不清醒状态。另外,该信息也称作判定信息。即,判定信息是通过机器学习得到且用于判定用户是否处于不清醒状态的信息。

返回图1,对输出部170进行说明。输出部170输出判定结果。对输出部170进行详细说明。

输出部170输出登记在判定结果表183a中的不清醒等级。例如,输出部170将不清醒等级输出到显示器105。此外,输出部170也可以通过声音来输出不清醒等级。另外,登记在判定结果表183a中的不清醒等级也称作表示平均值的信息。

输出部170也可以在判定结果表183a中登记的不清醒等级为等级3以上的情况下,输出用户处于不清醒状态。输出部170也可以在判定结果表183a中登记的不清醒等级为等级2以下的情况下,输出用户不处于不清醒状态。

接着,使用流程图说明状态判定装置100执行的处理。

图10是表示实施方式1的面部特征量提取区域的计算处理的流程图。另外,在图10中,对眉间区域的计算处理进行说明。此外,图10是面部特征量提取区域计算部140执行的处理的一例。

(步骤S11)面部特征量提取区域计算部140从面部特征点存储部180中取得左右内眼角的坐标和面部朝向。

(步骤S12)面部特征量提取区域计算部140计算左内眼角与右内眼角之间的中间点。

(步骤S13)面部特征量提取区域计算部140根据中间点和面部朝向计算中心坐标。具体而言,面部特征量提取区域计算部140计算作为使中间点平行移动后的坐标的中心坐标。

(步骤S14)面部特征量提取区域计算部140计算以中心坐标为中心的矩形区域。

(步骤S15)面部特征量提取区域计算部140取得由面部区域提取部120提取出的作为面部区域的矩形区域。

(步骤S16)面部特征量提取区域计算部140根据作为面部区域的矩形区域,对在步骤S14中计算出的矩形区域的大小进行变更。例如,面部特征量提取区域计算部140根据作为面部区域的矩形区域,使矩形区域的各边成为k倍。由此,计算与面部大小对应的眉间区域。

面部特征量提取区域计算部140能够通过与上述处理相同的处理来计算嘴部区域和脸颊区域。

图11是表示实施方式1的面部特征量的提取处理的流程图。

(步骤S21)面部特征量提取部150取得由面部特征量提取区域计算部140计算出的3个面部特征量提取区域。即,3个面部特征量提取区域是眉间区域、嘴部区域和脸颊区域。

(步骤S22)面部特征量提取部150根据眉间区域来提取HOG特征量。此外,面部特征量提取部150根据嘴部区域来提取HOG特征量。进而,面部特征量提取部150根据脸颊区域来提取HOG特征量。

(步骤S23)面部特征量提取部150将根据眉间区域提取出的HOG特征量保存到面部特征量存储部181中。此外,面部特征量提取部150将根据嘴部区域提取出的HOG特征量保存到面部特征量存储部181中。进而,面部特征量提取部150将根据脸颊区域提取出的HOG特征量保存到面部特征量存储部181中。

由此,将分别根据3个面部特征量提取区域提取出的各个HOG特征量分别登记到面部特征量表181a中。

图12是表示实施方式1的计数处理的流程图。在图12中,说明对在眉间产生皱纹的次数进行计数的情况。

(步骤S31)状态判定部160根据从1个帧(例如,称作第1帧)中提取出的眉间区域,从面部特征量存储部181中取得提取出的HOG特征量。

(步骤S32)状态判定部160使用式(1)计算余弦相似度Sn。

(步骤S33)状态判定部160判定在步骤S32中计算出的余弦相似度Sn是否小于阈值S。

例如,在步骤S32中计算出的余弦相似度Sn小于阈值S的情况是眉间的皱纹边缘表现得较强的情况。即,在步骤S32中计算出的余弦相似度Sn小于阈值S的情况是用户使眉间产生皱纹的情况。

在满足判定条件的情况下,状态判定部160使处理进入步骤S34。在不满足判定条件的情况下,状态判定部160使处理进入步骤S35。

(步骤S34)状态判定部160对眉间产生皱纹的次数进行增计数。

(步骤S35)状态判定部160判定从开始计数处理起是否经过了5分钟。状态判定部160在经过了5分钟的情况下,结束处理。状态判定部160在未经过5分钟的情况下,使处理进入步骤S31。另外,例如在该步骤S31中,状态判定部160根据从取得部110在第1帧之后取得的第2帧中提取出的眉间区域,从面部特征量存储部181中取得提取出的HOG特征量。

这样,状态判定部160根据取得部110在5分钟内取得的n个帧内的眉间区域,取得提取出的各个HOG特征量。状态判定部160根据各个HOG特征量,判定是否在眉间产生皱纹。由此,状态判定部160能够取得在5分钟内用户使眉间产生皱纹的次数。

通过与图11所示的计数处理相同的方法,取得舔嘴唇的次数。例如,在步骤S31中记载的眉间区域被变换成嘴部区域。由此,状态判定部160能够取得在5分钟内用户舔嘴唇的次数。

此外,通过与图11所示的计数处理相同的方法,取得打呵欠的次数。例如,在步骤S31中记载的眉间区域被变换成嘴部区域和脸颊区域。并且例如,在步骤S33中,状态判定部160在根据与嘴部区域对应的HOG特征量计算出的余弦相似度Sn、和根据与脸颊区域对应的HOG特征量计算出的余弦相似度Sn小于预先设定的阈值的情况下,使处理进入步骤S34。由此,状态判定部160能够取得在5分钟内用户打呵欠的次数。

另外,上述的5分钟是任意的时间。因此,5分钟的时间也可以是5分钟以外的时间。

图13是表示实施方式1的不清醒状态的判定处理的流程图。

(步骤S41)状态判定部160根据状态判定模型表182a和在眉间产生皱纹的次数,决定不清醒等级。状态判定部160根据状态判定模型表182a和舔嘴唇的次数,决定不清醒等级。状态判定部160根据状态判定模型表182a和打呵欠的次数,决定不清醒等级。

(步骤S42)状态判定部160根据3个不清醒等级计算平均值。状态判定部160也可以对平均值的小数点以下进行四舍五入。

(步骤S43)状态判定部160根据平均值判定不清醒状态。例如,状态判定部160在平均值为等级3以上的情况下,判定为用户处于不清醒状态。

(步骤S44)状态判定部160将判定结果保存在判定结果存储部183中。

根据实施方式1,状态判定装置100基于用户使眉间产生皱纹的行为、用户舔嘴唇的行为以及用户打呵欠的行为,判定是否处于不清醒状态。不清醒状态下的3个行为的个人差异小或者没有个人差异。状态判定装置100基于个人差异小或者没有个人差异的用户行为来判定不清醒状态,因而能够高精度地判定不清醒状态。

此外,状态判定部160也可以根据用户使眉间产生皱纹的次数和状态判定模型表182a决定不清醒等级,在所决定的不清醒等级为预先设定的阈值等级以上的情况下,判定为用户处于不清醒状态。例如,预先设定的阈值等级是等级3。输出部170也可以输出所决定的不清醒等级。

此外,状态判定部160也可以根据用户舔嘴唇的次数和状态判定模型表182a决定不清醒等级,在所决定的不清醒等级为预先设定的阈值等级以上的情况下,判定为用户处于不清醒状态。例如,预先设定的阈值等级是等级3。输出部170也可以输出所决定的不清醒等级。

此外,状态判定部160也可以根据用户打呵欠的次数和状态判定模型表182a决定不清醒等级,在所决定的不清醒等级为预先设定的阈值等级以上的情况下,判定为用户处于不清醒状态。例如,预先设定的阈值等级是等级3。输出部170也可以输出所决定的不清醒等级。

此外,在上文中,说明了状态判定部160根据3个不清醒等级的平均值来判定用户是否处于不清醒状态的情况。状态判定部160也可以根据2个不清醒等级的平均值来判定用户是否处于不清醒状态。例如,状态判定部160根据基于用户使眉间产生皱纹的次数的不清醒等级、和基于用户舔嘴唇的次数的不清醒等级的平均值,判定用户是否处于不清醒状态。并且例如,状态判定部160根据基于用户使眉间产生皱纹的次数的不清醒等级、和基于用户打呵欠的次数的不清醒等级的平均值,判定用户是否处于不清醒状态。并且例如,状态判定部160根据基于用户舔嘴唇的次数的不清醒等级、和基于用户打呵欠的次数的不清醒等级的平均值,判定用户是否处于不清醒状态。

实施方式2

接着,说明实施方式2。对于实施方式2,主要说明与实施方式1不同的事项,省略与实施方式1相同事项的说明。实施方式2参照图1~13。

图14是表示实施方式2的状态判定装置的结构的功能框图。状态判定装置100a具有提取部10a。提取部10a具有面部条件判定部191和面部特征量提取区域决定部192。

此外,状态判定装置100a具有平均面部特征点模型存储部184、面部条件存储部185以及提取区域决定模型存储部186。

提取部10a、面部条件判定部191以及面部特征量提取区域决定部192的一部分或全部也可以通过处理器101来实现。此外,提取部10a、面部条件判定部191以及面部特征量提取区域决定部192的一部分或者全部也可以作为处理器101执行的程序的模块来实现。例如,由处理器101执行的程序也被称作状态判定程序。

平均面部特征点模型存储部184、面部条件存储部185以及提取区域决定模型存储部186可以作为在易失性存储装置102或非易失性存储装置103中确保的存储区域来实现。

对与图1所示的结构相同的图14的结构,标注与图1所示的标号相同的标号。

面部条件判定部191根据多个帧,判定用户是否佩戴着佩戴物。例如,面部条件判定部191在作为面部特征点没有提取出眼睛的特征点的情况下,判定为用户佩戴着太阳镜。并且例如,面部条件判定部191在作为面部特征点没有提取出嘴部的特征点的情况下,判定为用户佩戴着口罩。

此外,面部条件判定部191也可以如以下说明的那样,判定用户是否佩戴着佩戴物。首先,对平均面部特征点模型存储部184进行说明。平均面部特征点模型存储部184存储平均面部特征点模型表。

图15是表示实施方式2的平均面部特征点模型表的一例的图。平均面部特征点模型表184a被保存在平均面部特征点模型存储部184中。在状态判定装置100a执行不清醒状态的判定之前,将平均面部特征点模型表184a保存在平均面部特征点模型存储部184中。平均面部特征点模型表184a也称作平均面部特征点模型信息。

平均面部特征点模型表184a具有特征点和平均坐标的项目。平均面部特征点模型表184a表示平均的面部部位的位置。例如,在平均面部特征点模型表184a中登记有许多人的面部的平均左眉外端的位置为(100,100)。

面部条件判定部191使用平均面部特征点模型表184a和面部特征点,判定用户是否佩戴着佩戴物。例如,面部条件判定部191在左眼的特征点位置与登记在平均面部特征点模型表184a中的左眼(即,左眼外端和左眼内端)的平均坐标位置之间的距离为阈值以上的情况下,判定为作为左眼的特征点位置可靠性低。并且,面部条件判定部191判定为用户佩戴着太阳镜。同样,面部条件判定部191在嘴部的特征点位置与登记在平均面部特征点模型表184a中的嘴部的平均坐标之间的距离为阈值以上的情况下,判定为用户佩戴着口罩。

这里,面部条件判定部191在对登记在平均面部特征点模型表184a中的信息和面部特征点进行比较的情况下,使用欧几里得距离或者马氏距离。另外例如,面部条件判定部191在使用欧几里德距离或马氏距离的情况下,使由面部特征点提取部130提取出的左眼外端与右眼外端之间的距离、和登记在平均面部特征点模型表184a中的左眼外端与右眼外端之间的距离相同。这样,面部条件判定部191使用左眼外端与右眼外端之间的距离。此外,面部条件判定部191也可以使用左眼外端与右眼外端之间的距离以外的距离。例如,面部条件判定部191使用左眉外端与右眉外端之间的距离。

此外,面部条件判定部191判定在n帧的任意帧中是否包含阴影。进而,面部条件判定部191判定在多个帧的任意帧中是否存在飞色。例如,飞色是指泛白。泛白是指在帧内出现白色部分。例如,在通过照明从左方照射光的情况下,帧内的左面部分飞色。

面部条件判定部191控制成在帧中包含阴影或飞色的区域的情况下,不将阴影或飞色的区域设定成特征量提取区域。由此,面部特征量提取区域计算部140能够计算恰当的区域作为面部特征量提取区域。

此外,面部条件判定部191在用户没有佩戴佩戴物且在帧中没有包含阴影和飞色的区域的情况下,判定为通常时。

面部条件判定部191将判定结果保存到面部条件存储部185中。这里,说明面部条件存储部185。面部条件存储部185存储面部条件表。

图16的(A)~(C)是表示面部条件表的一例的图。面部条件表185a具有面部条件的项目。

图16的(A)表示面部条件判定部191在面部条件表185a中登记了“通常时”的状态。图16的(B)表示面部条件判定部191在面部条件表185a中登记了“佩戴口罩”的状态。图16的(C)表示面部条件判定部191在面部条件表185a中登记了“从左照射”的状态。

面部条件判定部191也可以在根据面部朝向判定为帧中不存在面部的左半部分的情况下,将“倾斜面部”登记到面部条件表185a中。

接着,对提取区域决定模型存储部186进行说明。提取区域决定模型存储部186存储提取区域决定模型表。

图17是表示实施方式2的提取区域决定模型表的一例的图。提取区域决定模型表186a被保存在提取区域决定模型存储部186中。在状态判定装置100a执行不清醒状态的判定之前,提取区域决定模型表186a被保存在提取区域决定模型存储部186中。提取区域决定模型表186a具有面部条件和面部特征量提取区域的项目。提取区域决定模型表186a也称作提取区域决定模型信息。提取区域决定模型表186a是表示根据佩戴物被佩戴的位置将面部区域中的哪个区域作为面部特征量提取区域的信息。此外,提取区域决定模型表186a是表示根据存在阴影或飞色的位置将面部区域中的哪个区域作为面部特征量提取区域的信息。

面部特征量提取区域决定部192在判定为用户佩戴着佩戴物的情况下,根据提取区域决定模型表186a决定面部特征量提取区域。详细而言,面部特征量提取区域决定部192根据提取区域决定模型表186a和由面部条件判定部191判定出的面部条件,决定面部特征量提取区域。

此外,面部特征量提取区域决定部192在判定为多个帧的任意帧中存在阴影或飞色的情况下,根据提取区域决定模型表186a决定面部特征量提取区域。

例如,在面部条件判定部191判定为佩戴口罩的情况下,面部特征量提取区域决定部192将面部特征量提取区域决定为眉间区域。这里,在用户佩戴着口罩的情况下,面部特征量提取区域计算部140难以计算嘴部区域和脸颊区域。因此,面部特征量提取区域决定部192控制成不将嘴部区域和脸颊区域设为面部特征量提取区域。并且,面部特征量提取区域决定部192将面部特征量提取区域决定为眉间区域。

面部特征量提取区域计算部140根据由面部特征点提取部130提取出的面部特征点,计算由面部特征量提取区域决定部192决定的面部特征量提取区域。

接着,使用流程图说明状态判定装置100a执行的处理。

图18是表示实施方式2的面部条件的判定处理的流程图。此外,图18是面部条件判定部191执行的处理的一例。

(步骤S51)面部条件判定部191从面部特征点存储部180中取得面部特征点。

(步骤S52)面部条件判定部191判定在帧内是否存在阴影或飞色。

例如,面部条件判定部191在帧内有面部的区域的色彩为黑色的情况下,判定为在帧内存在阴影。并且例如,在帧内有面部的区域的色彩为白色的情况下,或者在不能取得帧内的某个区域的面部特征点的情况下,面部条件判定部191判定为在帧内存在飞色。另外,在图18中,假设阴影或飞色是由于通过照明从左方照射光而产生的。

此外,面部条件判定部191也可以在取得了表示照明的设置场所的位置信息的情况下,根据该位置信息,判定在帧内是否存在阴影或飞色。

在帧内存在阴影或飞色的情况下,面部条件判定部191使处理进入步骤S53。在帧内不存在阴影和飞色的情况下,面部条件判定部191使处理进入步骤S54。

(步骤S53)面部条件判定部191在面部条件表185a中登记“从左照射”。然后,面部条件判定部191结束处理。

(步骤S54)面部条件判定部191判定用户是否佩戴着佩戴物。例如,面部条件判定部191在作为面部特征点没有提取出眼睛的特征点的情况下,判定为用户佩戴着佩戴物。

在用户佩戴着佩戴物的情况下,面部条件判定部191使处理进入步骤S56。在用户没有佩戴着佩戴物的情况下,面部条件判定部191使处理进入步骤S55。

(步骤S55)面部条件判定部191在面部条件表185a中登记“通常时”。然后,面部条件判定部191结束处理。

(步骤S56)面部条件判定部191判定用户是否佩戴着口罩。例如,面部条件判定部191在作为面部特征点没有提取出嘴部的特征点的情况下,判定为用户佩戴着口罩。

在用户佩戴着口罩的情况下,面部条件判定部191使处理进入步骤S57。在用户没有佩戴着口罩的情况下,面部条件判定部191使处理进入步骤S58。

(步骤S57)面部条件判定部191在面部条件表185a中登记“佩戴口罩”。然后,面部条件判定部191结束处理。

(步骤S58)面部条件判定部191判定用户是否佩戴着太阳镜。例如,面部条件判定部191在作为面部特征点没有提取出眼睛的特征点的情况下,判定为用户佩戴着太阳镜。

在用户佩戴着太阳镜的情况下,面部条件判定部191使处理进入步骤S59。在用户没有佩戴着太阳镜的情况下,面部条件判定部191结束处理。

(步骤S59)面部条件判定部191在面部条件表185a中登记“佩戴太阳镜”。然后,面部条件判定部191结束处理。

图19是表示实施方式2的面部特征量提取区域的决定处理的流程图。

(步骤S61)面部特征量提取区域决定部192从面部条件表185a中取得面部条件。

(步骤S62)面部特征量提取区域决定部192根据提取区域决定模型表186a和面部条件决定面部特征量提取区域。例如,面部特征量提取区域决定部192在面部条件为“佩戴口罩”的情况下,将面部特征量提取区域决定为眉间区域。并且例如,面部特征量提取区域决定部192在面部条件为“佩戴太阳镜”的情况下,将面部特征量提取区域决定为嘴部区域和脸颊区域。并且例如,面部特征量提取区域决定部192在面部条件为“从左照射”的情况下,将面部特征量提取区域决定为眉间区域、嘴部区域、右脸颊区域。即,面部特征量提取区域决定部192不将左脸颊区域设为面部特征量提取区域。

根据实施方式2,即使在用户佩戴着佩戴物的情况下,状态判定装置100a也能够使用可提取的面部特征量提取区域判定不清醒状态。此外,即使在对用户照射光的情况下,状态判定装置100a也能够使用可提取的面部特征量提取区域判定不清醒状态。

以上说明的各实施方式中的特征能够相互适当组合。

标号说明

10、10a:提取部;100、100a:状态判定装置;101:处理器;102:易失性存储装置;103:非易失性存储装置;104:摄像机;105:显示器;110:取得部;120:面部区域提取部;130:面部特征点提取部;140:面部特征量提取区域计算部;150:面部特征量提取部;160:状态判定部;170:输出部;180:面部特征点存储部;180a:面部特征点表;181:面部特征量存储部;181a:面部特征量表;182:状态判定模型存储部;182a:状态判定模型表;183:判定结果存储部;183a:判定结果表;184:平均面部特征点模型存储部;184a:平均面部特征点模型表;185:面部条件存储部;185a:面部条件表;186:提取区域决定模型存储部;186a:提取区域决定模型表;191:面部条件判定部;192:面部特征量提取区域决定部;200:中间点;201:矩形区域;210:中间点;211:矩形区域。

- 生理状态判定装置、生理状态判定方法、生理状态判定装置用程序以及生理状态判定系统

- 继电器状态判定装置、继电器状态判定系统、继电器状态判定方法及程序