视频去噪方法、装置、设备及存储介质

文献发布时间:2023-06-19 10:41:48

技术领域

本申请涉及计算机视觉领域,特别涉及一种视频去噪方法、装置、设备及存储介质。

背景技术

在日常生活中,人们常会受到恶劣天气的影响,比如暴雨天气、大雾天气、大雪天气等,恶劣天气会对拍摄的图像或视频造成干扰。

示意性的,雨滴是恶劣天气中常见的影响拍摄画面的因素,雨滴会造成局部区域的遮挡和模糊,导致拍摄出的图像或视频出现画面质量降低,在对该类图像或视频进行后续处理时,易于产生不准确的处理结果。相关技术中,以拍摄视频为例,通过卷积神经网络对视频帧中的雨滴元素对应的结构信息进行提取,并根据该结构信息去除视频帧中的雨滴元素。

上述技术方案中,在一些情况下,视频的分辨率不高时,卷积神经网络易于提取出不准确的结构信息,导致对视频中的雨滴元素进行误分类,经过去雨处理后的视频的清晰度不佳。

发明内容

本申请实施例提供了一种视频去噪方法、装置、设备及存储介质,通过从含有持续噪点元素的视频帧序列中提取空间特征和时间特征,基于融合后的时空特征对视频帧进行去噪处理,得到处理后的视频,提高了视频的清晰度。所述技术方案为如下方案。

根据本申请的一个方面,提供了一种视频去噪方法,所述方法包括如下步骤:

获取视频,所述视频的视频帧序列中存在持续噪点元素,所述持续噪点元素是在至少两帧视频帧上连续出现的噪点元素;

提取所述视频帧序列的空间特征和时间特征;

将所述空间特征和所述时间特征进行融合,得到所述视频帧序列对应的融合后的时空特征;

基于所述融合后的时空特征对所述视频帧序列进行去噪处理,得到处理后的视频。

根据本申请的另一方面,提供了一种视频去噪装置,所述装置包括如下部分:

获取模块,用于获取视频,所述视频的视频帧序列中存在持续噪点元素,所述持续噪点元素是在至少两帧视频帧上连续出现的噪点元素;

特征提取模块,用于提取所述视频帧序列的空间特征和时间特征;

特征融合模块,用于将所述空间特征和所述时间特征进行融合,得到所述视频帧序列对应的融合后的时空特征;

去噪模块,用于基于所述融合后的时空特征对所述视频帧序列进行去噪处理,得到处理后的视频。

根据本申请的另一方面,提供了一种计算机设备,所述计算机设备包括:处理器和存储器,所述存储器中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由所述处理器加载并执行以实现如上方面所述的视频去噪方法。

根据本申请的另一方面,提供了一种计算机可读存储介质,所述可读存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由处理器加载并执行以实现如上述方面所述的视频去噪方法。

根据本申请的另一方面,提供了一种计算机程序产品或计算机程序,所述计算机程序产品或计算机程序包括计算机指令,所述计算机指令存储在计算机可读存储介质中。计算机设备的处理器从所述计算机可读存储介质读取所述计算机指令,所述处理器执行所述计算机指令,使得所述计算机设备执行如上方面所述的视频去噪方法。

本申请实施例提供的技术方案带来的有益效果至少包括如下效果。

通过在视频帧对应的空间特征上附加视频帧对应的时间特征,基于融合后的时空特征对视频进行去噪处理,根据融合后的时空特征能够确定持续噪点元素在视频帧中的位置,以及确定持续噪点元素在视频帧序列中的运动轨迹,使得视频帧中具有持续噪点元素的区域能够更完整地从原视频帧中分离出来并被去除,从而具有更好的去噪效果,使得经过去噪处理后的视频更加清晰。

附图说明

为了更清楚地说明本申请实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本申请的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

图1是本申请一个示例性实施例提供的计算机系统的框架图;

图2是本申请一个示例性实施例提供的视频去噪方法的流程图;

图3是本申请一个示例性实施例提供的神经网络模型的框架图;

图4是本申请另一个示例性实施例提供的视频去噪方法的流程图;

图5是本申请一个示例性实施例提供的空间特征提取单元的框架图;

图6是本申请一个示例性实施例提供的双向卷积长短记忆单元的框架图;

图7是本申请一个示例性实施例提供的长短期记忆网络的框架图;

图8是本申请一个示例性实施例提供的时空互助单元的框架图;

图9是本申请一个示例性实施例提供的密集残差模块的框架图;

图10是本申请一个示例性实施例提供的神经网络模型的训练方法的流程图;

图11是本申请一个示例性实施例提供的视频去噪装置的结构框图;

图12是本申请一个示例性实施例提供的服务器的装置结构示意图。

具体实施方式

为使本申请的目的、技术方案和优点更加清楚,下面将结合附图对本申请实施方式作进一步地详细描述。

首先,对本申请实施例涉及的名词进行介绍。

长短期记忆网络(Long Short-Term Memory,LSTM):是一种时间递归神经网络,适合于处理和预测时间序列中间隔和延迟相对较长的重要事件,属于循环神经网络(Recurrent Neural Network,RNN)中的一种。

在一个示例中,当预测“云彩在X中”X的内容时,相关信息“云彩”与预测的答案X(“天空”)的位置之间的间隔较小,循环神经网络会根据相关信息预测出“天空”,但如果预测“我在法国长大,我会说一口流利的Y”时,需要预测的答案Y是一种语言(法语),由于Y与“法国”之间的间隔较长,此时运用循环神经网络预测Y的内容,可能会产生预测失败的问题,而运用LSTM神经网络预测的方式则能够避免产生此类问题。

LSTM神经网络具有“门”结构(包括输入门、遗忘门和输出门),能够消除或者增加信息到细胞状态(Cell)的能力,使得LSTM神经网络能够记住长期的信息。

双向长短期记忆网络(Bi-directional Long Short-Term Memory,BiLSTM):由前向长短期记忆网络(Long Short-Term Memory,LSTM)与后向LSTM网络组合而成。适合做上下有关系的序列标注任务,因此在自然语言处理任务中常被用来识别上下文信息。双向LSTM网络是LSTM网络的改进版。本申请实施例中的双向长短期记忆网络用于根据相邻视频帧对应的空间特征,提取视频帧对应的时间特征。

人工智能(Artificial Intelligence,AI):是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个综合技术,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

计算机视觉技术(Computer Vision,CV)是一门研究如何使机器“看”的科学,更进一步的说,就是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等机器视觉,并进一步做图形处理,使电脑处理成为更适合人眼观察或传送给仪器检测的图像。作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取信息的人工智能系统。计算机视觉技术通常包括图像处理(如图像去噪处理)、图像识别、图像语义理解、图像检索、光学字符识别(Optical Character Recognition,OCR)、视频处理(如视频去噪处理)、视频语义理解、视频内容/行为识别、三维物体重建、3D技术、虚拟现实、增强现实、同步定位与地图构建等技术,还包括常见的人脸识别、指纹识别等生物特征识别技术。

人工智能技术是一门综合学科,涉及领域广泛,既有硬件层面的技术也有软件层面的技术。人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术主要包括计算机视觉技术、自然语言处理技术、人工智能医疗技术等几大方向。

随着人工智能技术研究和进步,人工智能技术在多个领域展开研究和应用,例如常见的智能家居、智能穿戴设备、虚拟助理、智能音箱、智能营销、无人驾驶、自动驾驶、无人机、机器人、智能医疗、智能客服等,相信随着技术的发展,人工智能技术将在更多的领域得到应用,并发挥越来越重要的价值。

机器学习(Machine Learning,ML):是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。机器学习是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域。机器学习和深度学习通常包括人工神经网络、置信网络、强化学习、迁移学习、归纳学习、示教学习等技术。

本申请实施例中去除的噪点可以是天气因素产生的天气颗粒元素,如雨滴元素,本申请实施例提供的视频去噪方法可以应用于如下场景。

一、监控摄像头拍摄场景。

在该应用场景下,采用本申请实施例提供的视频去噪方法可应用于监控摄像头对应的服务器中。该监控摄像头可以是位于路边的监控摄像头,也可以是位于公路上的测速摄像头,本申请实施例对摄像头的类型不加以限定。服务器中构建有神经网络模型,监控摄像头将采集的监控视频帧发送至该服务器中。服务器调用神经网络模型对该监控视频帧进行去噪处理,从监控视频帧中提取天气颗粒元素对应的空间特征,再根据连续的视频帧的空间特征提取出监控视频帧对应的时间特征,以此类推,提取出视频帧序列对应的时间特征。将空间特征与时间特征进行融合,得到融合后的时空特征,基于融合后的时空特征对视频帧进行去噪处理,得到去噪后的清晰视频。示意性的,在大雨天气下,公路上的测速摄像头拍摄到的视频中含有来往车辆,雨滴可能会对车辆的车牌号进行遮挡,导致无法确定超速车辆,通过神经网络模型对视频进行去雨处理(去噪处理)后可从该视频中获得准确的车牌号信息。

二、日常拍摄场景。

在该应用场景下,采用本申请实施例提供的视频去噪方法可应用于用户使用的智能手机、平板电脑等终端中。示意性的,终端中安装有摄像应用程序,该摄像应用程序是基于神经网络模型构建的,在用户使用该摄像应用程序在恶劣天气下拍摄视频(或图像)时,摄像应用程序调用神经网络模型对采集到的视频进行去噪处理,从该视频中提取出天气颗粒元素对应的空间特征,再根据连续的视频帧的空间特征提取出视频帧的时间特征,以此类推,提取出视频帧序列对应的时间特征。将空间特征和时间特征进行融合,得到融合后的时空特征,基于融合后的时空特征对视频帧进行去噪处理,得到去噪后的清晰视频。比如,在大雨天气下,摄像应用程序调用神经网络模型对拍摄的视频进行去雨处理(去噪处理),得到清晰的视频或图像,避免雨滴元素对视频内容进行遮挡。

上述仅以两种应用场景为例进行说明,本申请实施例提供的方法还可以应用于其他需要去除视频或图像中的噪点元素的场景(比如,对旧照片中被雨滴遮挡的人脸进行恢复、影视作品的后期修复等),本申请实施例并不对具体应用场景进行限定。可以理解的是,天气颗粒元素除雨滴元素外,雾气元素、雾霾元素、雪花元素、沙尘暴元素或砂砾、冰雹元素等元素均能够对视频或图像的质量造成影响。

本申请实施例提供的视频去噪方法可以应用于具有较强的数据处理能力的计算机设备中。在一种可能的实施方式中,本申请实施例提供的视频去噪方法可以应用于个人计算机、工作站或服务器中,即可以通过个人计算机、工作站或服务器去除视频帧中的噪点,提高视频(或图像)的质量。示意性的,视频去噪方法应用于应用程序的后台服务器中,以便安装有应用程序的终端借助后台服务器接收到去噪处理后且质量较高的视频(或图像)。

图1示出了本申请一个示例性实施例提供的计算机系统的示意图。该计算机系统100包括终端110和服务器120,其中,终端110与服务器120之间通过通信网络进行数据通信。示意性的,通信网络可以是有线网络也可以是无线网络,且该通信网络可以是局域网、城域网以及广域网中的至少一种。

终端110中安装和运行有应用程序,该应用程序可以是具有视频播放功能或视频拍摄功能的摄像应用程序、视频应用程序(包括短视频应用程序)、直播应用程序、社交类应用程序、音乐应用程序、虚拟现实应用程序(Virtual Reality,VR)、增强现实应用程序(Augmented Reality,AR)、游戏应用程序、购物应用程序等。该应用程序还可以是具有图像查看功能或图像拍摄功能的相册应用程序(图库应用程序)、摄像应用程序、美颜相机应用程序等。

示意性的,终端110上安装有摄像应用程序,用户通过该摄像应用程序拍摄视频,该视频是在大雨天气的情况下拍摄的,因为视频中每帧视频中存在雨滴元素。该摄像应用程序内置有训练好的神经网络模型,通过调用神经网络模型对视频进行去雨处理(去噪处理),得到处理后的清晰视频。

在一些实施例中,终端110可以是智能手机、智能手表、平板电脑、膝上便携式笔记本电脑、智能机器人等终端,也可以是台式电脑、投影式电脑等终端,本申请实施例对终端的类型不加以限定。

服务器120可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、内容分发网络(Content Delivery Network,CDN)、以及大数据和人工智能平台等基础云计算服务的云服务器。在一种可能的实施方式中,服务器120是终端110中安装的应用程序的后台服务器。

如图1所示,在本实施例中,终端110将拍摄到的含有持续噪点元素的视频发送至服务器120,服务器120用于执行如下步骤:步骤11,获取视频;步骤12,从视频的视频序列中提取时空特征;步骤13,基于时空特征对视频进行去噪处理;步骤14,得到处理后的视频。

服务器获取的视频是存在持续噪点元素的视频,持续噪点元素是至少两帧连续出现在视频帧上的噪点元素。持续噪点元素是指在视频帧中遮挡原视频帧或原图像中已有的像素点的持续性出现的元素,如天气颗粒元素,在恶劣天气的情况下进行视频采集,对视频内容的可视性产生一定影响。由于恶劣天气导致的、影响视频内容的可视性的天气颗粒元素包括但不限于如下元素中的至少一种元素:雨滴元素、雪花元素、雾气元素、雾霾元素、冰雹元素、沙尘暴等元素。

示意性的,以持续噪点元素为雨滴元素为例,服务器120中构建有神经网络模型,服务器120调用神经网络模型对视频进行去雨处理,神经网络模型从含有雨滴元素的视频帧中提取空间特征,然后根据相邻视频帧中的空间特征提取出隐含的时间特征,并将时间特征与空间特征进行融合,得到融合后的时空特征,基于融合后的时空特征对视频进行去噪处理,得到去噪处理后的清晰视频。

服务器120将去噪处理后的清晰视频发送至终端110,在终端110中显示该去噪处理后的清晰视频。示意性的,在终端110中的相册应用程序中播放去噪处理后的清晰视频;或在终端110中的视频播放应用程序中播放去噪处理后的清晰视频。需要说明的是,去噪处理后的视频中可能仍存在部分雨滴,但去噪处理后的视频的清晰度要高于未进行去噪处理的视频的清晰度。

可以理解的是,上述实施例仅以视频去噪方法应用于应用程序对应的服务器中为例,在实际应用中,上述视频去噪方法还可以应用于用户使用的终端中,终端中安装有用于去除持续噪点元素的应用程序,该应用程序是基于神经网络模型构建的,该神经网络模型用于对视频进行去噪处理。当用户使用该应用程序拍摄视频时,该应用程序调用神经网络模型对视频进行去噪处理,得到处理后的清晰视频。

在一些实施例中,终端或服务器中构建有针对不同类型的持续噪点元素对应的的神经网络模型,如,终端或服务器中构建有针对不同类型的天气颗粒元素对应的神经网络模型,如去雪模型、去雾模型、去霾模型等。

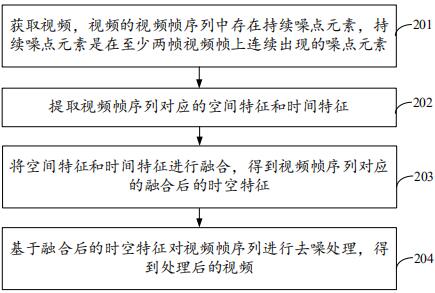

图2示出了本申请一个示例性实施例提供的视频去噪方法的流程图。本实施例以该方法用于如图1所示的计算机系统100中为例进行说明,该方法包括如下步骤。

步骤201,获取视频,视频的视频帧序列中存在持续噪点元素,持续噪点元素是在至少两帧视频帧上连续出现的噪点元素。

在采集视频(或图像)时,可能由于拍摄手法不当或硬件设施老化,使得视频或图像中出现持续噪点元素。该持续噪点元素是指在视频帧中遮挡原始视频帧或原始图像中已有的像素点的持续性出现的元素。在一些实施例中,持续噪点元素出现在视频帧序列中一次,如持续噪点元素在视频帧序列中的第3帧至第20帧出现;在另一些实施例中,持续噪点元素出现在视频帧序列中多次,如持续噪点元素在视频帧序列中的第3帧至第20帧出现,又在第31帧至第35帧出现。即持续噪点元素在时间维度上具有连续性,可提取出对应的时间特征。

示意性的,该持续噪点元素包括人为遮挡元素,如用户在拍摄时,指尖遮挡住镜头的一小部分,使得拍摄出的视频中部分区域被指尖遮挡。示意性的,该持续噪点元素包括天气颗粒元素,天气颗粒元素是指由于天气原因对视频的可视性产生影响的颗粒元素。天气颗粒元素包括但不限于如下元素中的至少一种:雨滴元素、雪花元素、冰雹元素、雷电元素、雾气元素、雾霾元素、沙尘暴元素。在一些实施例中,天气颗粒元素在视频帧中的排布密度较高,或天气颗粒元素的尺寸较大,均会对视频帧中的部分区域或部分元素进行遮挡。本申请以持续噪点元素为天气颗粒元素进行举例说明。

在视频拍摄的过程中,天气颗粒元素占据视频帧序列中的部分或全部视频帧。在一帧视频帧中,天气颗粒元素占据视频帧的全部区域或部分区域,如雨滴元素占据一帧视频帧的全部画面区域,或雨滴元素占据一帧视频帧的下半部分画面区域。

示意性的,以天气颗粒元素为雨滴元素进行举例说明。本申请实施例将天气颗粒元素对视频的可视性(或清晰度)造成影响的视频命名为颗粒影响视频,如雨滴影响视频。雨滴影响视频是指视频的视频帧序列中存在雨滴元素。当多帧视频帧中具有雨滴元素时,由于雨滴是动态运动的,一滴雨滴在连续的多帧视频帧中的空间位置不同。比如,在雨滴掉落的过程中,连续多帧视频帧中的同一雨滴趋近于画面区域的边缘。

示意性的,视频是通过终端的采集得到的,在终端中安装有摄像应用程序(操作系统中的摄像应用程序),该摄像应用程序调用摄像头进行视频采集,将采集到的视频存储在终端中。在一些实施例中,在终端中安装有第三方应用程序,该第三方应用程序用于调用终端的摄像头对视频进行采集,将采集到的视频存储在终端中。在另一些实施例中,视频是终端中存储的视频,该视频可以是用户通过网络下载至终端中的视频,如从视频网页中下载的视频,或即时通讯程序中的好友转发的视频。

示意性的,视频是预先存储在服务器中的视频,服务器包括用于存储视频的数据库,视频是大量用户通过应用程序上传至服务器中的。比如,用户通过美颜相机应用程序调用终端的摄像头采集视频,通过该美颜相机应用程序将采集到的视频上传至服务器。又如,服务器记录并存储每次进行去噪处理的视频。

示意性的,视频是公开的视频数据集中的视频,将公开的视频数据集导入至终端,或服务器中,终端或服务器对视频进行存储。

步骤202,提取视频帧序列对应的空间特征和时间特征。

对视频帧序列中的每帧视频帧进行特征提取,提取出每帧视频帧中的雨滴元素对应的空间特征,该空间特征用于表征雨滴元素在一帧视频帧中的空间位置。

通过相邻视频帧之间对应的时间差可提取视频帧序列对应的时间特征,示意性的,在提取当前视频帧对应的时间特征时,利用当前视频帧和位于当前视频帧之前的视频帧之间的时间差提取到当前视频帧对应的时间特征,以此类推,根据当前视频帧对应的时间特征得到整个视频帧序列对应的时间特征。

示意性的,终端中设置有对应的特征提取单元,利用该特征提取单元对视频帧序列对应的时间特征和空间特征进行提取,即将视频帧序列输入至该特征提取单元,得到视频帧序列对应的空间特征和时间特征;或,终端中设置有时间特征提取单元和空间特征提取单元,将视频帧序列输入至空间特征提取单元,得到视频帧序列对应的空间特征,将视频帧序列输入至时间特征提取单元,得到视频帧序列对应的时间特征。

示意性的,终端中安装有用于进行去噪处理的应用程序,该应用程序内置有特征提取单元,在进行去噪处理时,该应用程序调用特征提取单元对视频帧序列进行特征提取,得到视频帧序列对应的空间特征和时间特征;或,该应用程序设置有空间特征提取单元和时间特征提取单元,应用程序调用空间特征提取单元对视频帧序列进行特征提取,得到视频帧序列对应的空间特征,应用程序调用时间特征提取单元对视频帧序列进行特征提取,得到视频帧序列对应的时间特征。

示意性的,服务器中设置有对应的特征提取单元,利用该特征提取单元对视频帧序列对应的时间特征和空间特征进行提取,即将视频帧序列输入至该特征提取单元,得到视频帧序列对应的空间特征和时间特征;或,服务器中设置有时间特征提取单元和空间特征提取单元,将视频帧序列输入至空间特征提取单元,得到视频帧序列对应的空间特征,将视频帧序列输入至时间特征提取单元,得到视频帧序列对应的时间特征。

步骤203,将空间特征和时间特征进行融合,得到视频帧序列对应的融合后的时空特征。

特征融合的目的是将从图像或视频帧中提取到的特征,合并成一个比输入特征更具有判别能力的特征,使得融合后的特征有助于对视频帧或图像进行语义分割。示意性的,终端中设置有特征融合单元,将提取到的空间特征和时间特征输入至该特征融合单元中,通过特征融合单元对不同尺度的特征进行融合。示意性的,服务器中设置有特征融合单元,将提取到的空间特征和时间特征输入至该特征融合单元中,通过特征融合单元对不同尺度的特征进行融合。

按照融合与神经网络模型预测的先后顺序,分为早融合(Early Fusion)和晚融合(Late Fusion)。

早融合是指先融合多层特征,然后再融合后的特征上训练神经网路模型。可通过调用concat()函数或add()函数对特征进行融合。concat()函数用于直接将两个特征进行连接,比如,两个输入特征x和y对应的维数分别为p和q,则输出的特征z对应的维数为p+q。add()函数用于将两个特征组合成复合向量,比如,对于输入特征x和y,融合的特征z为z=x+iy,其中,i是虚数单位。

晚融合是指通过结合神经网络模型的不同层的预测结果改进神经网络模型的预测性能。示意性的,输入特征不融合,预测模型对多尺度的特征分别进行预测,然后对预测结果进行综合;或者,通过拉普拉斯金字塔融合的方式对输入特征进行融合,对融合后的特征进行预测。

步骤204,基于融合后的时空特征对视频帧序列进行去噪处理,得到处理后的视频。

去噪处理本质上是将图像或视频帧划分为噪点层和无噪点层,然后将噪点层从图像或视频帧中分离出来,留下无噪点层的图像或视频帧的一个分类过程。

示意性的,以持续噪点元素为雨滴元素为例,去噪处理(去雨处理)是将图像或视频帧划分为雨水层和无雨层,然后将雨水层从图像或视频帧中分离出来,留下无雨层图像或视频帧的一个分类过程。

示意性的,终端中设置有神经网络模型,该神经网络模型用于对视频帧序列进行去噪处理。以该神经网络模型用于去除视频帧中的雨滴元素为例,将视频帧序列输入至该神经网络模型中,该神经网络模型针对视频帧中的画面区域属于雨滴区域的预测概率设置有概率阈值,响应于视频帧中的画面区域属于雨滴区域的预测概率大于概率阈值,确定该画面区域属于雨滴区域。将视频帧中属于雨滴区域的画面区域从视频帧中分离,以此类推,将视频帧序列中含有雨滴元素的视频帧均进行上述去噪处理,得到经过去噪处理(去雨处理)后的视频。在一些实施例中,神经网络模型针对视频帧中的画面图层属于雨滴层的预测概率设置有概率阈值,响应于视频帧中的画面图层属于雨滴层的预测概率大于概率阈值,确定该画面图层属于雨滴层。将视频帧中属于雨滴层的画面图层从视频帧中分离,以此类推,将含有雨滴元素的帧视频帧中的雨滴层与无雨层进行分离,得到经过去噪处理后的视频。

神经网络模型通过融合后的时空特征对视频帧中的雨滴元素的位置以及连续视频帧中雨滴的位置进行追踪,使得经过去噪处理的视频帧序列能够将雨滴层更好地分离出来。

在一些实施例中,服务器中设置有神经网络模型,该神经网络模型用于对视频帧序列进行去噪处理。

综上所述,本实施例提供的方法,通过在视频帧对应的空间特征上附加视频帧对应的时间特征,基于融合后的时空特征对视频进行去噪处理,根据融合后的时空特征能够确定持续噪点元素在视频帧中的位置,以及确定持续噪点元素在视频帧序列中的运动轨迹,使得视频帧中具有持续噪点元素的区域能够更完整地从原视频帧中分离出来并被去除,从而具有更好的去噪效果,使得经过去噪处理后的视频更加清晰。

下面对本申请实施例中提供的用于去除持续噪点元素的神经网络模型的框架进行说明,如图3所示。

神经网络模型包括三部分:空间特征提取单元42(Spatial InteractionConsistency Memory,SICM)、双向卷积长短记忆单元43(Spatial-Temporal InteractionLearning Memory,STIM)和时空互助单元44(Enhanced Spatio-Temporal ConsistencyMemory,ESTM)。空间特征提取单元42用于从视频帧序列中提取空间特征;双向卷积长短记忆单元43用于根据相邻视频帧对应的空间特征提取时间特征;时空互助单元44用于将提取到的空间特征和时间特征进行融合,并基于融合后的时空特征对视频帧序列中的视频帧进行去噪处理,得到处理后的视频。

视频帧序列41输入至空间特征提取单元42,由空间特征提取单元42提取视频帧序列41对应的空间特征,将空间特征输入至双向卷积长短记忆单元43中。神经网络模型基于每帧视频帧进行处理,以第t帧视频帧为例(t为大于1正整数),空间特征提取单元42提取第t帧视频帧对应的空间特征,将第t帧视频帧对应的空间特征输入至第t帧视频帧对应的双向卷积长短记忆单元43,第t帧视频帧对应的双向卷积长短记忆单元43结合第t-1帧视频帧对应的双向卷积长短记忆单元43输出的状态特征、第t-1帧视频帧对应的空间特征、第t帧视频帧对应的空间特征,得到第t帧视频帧对应的第一时间特征。同理,通过将第t帧视频帧对应的空间特征、第t+1帧视频帧对应的空间特征和第t+1帧视频帧对应的状态特征反向输入至双向卷积长短记忆单元43,得到第t帧视频帧对应的第二时间特征。双向卷积长短记忆单元43根据第一时间特征和第二时间特征得到第t帧视频帧对应的时间特征。将第t帧视频帧对应的时间特征和空间特征输入至时空互助单元44进行特征融合,基于融合后的时空特征对视频帧进行去噪处理,根据处理后的视频帧得到处理后的视频。

图4示出了本申请另一个示例性实施例提供的视频去噪方法的流程图。本实施例以该方法用于如图1所示的计算机系统100中为例进行说明,该方法包括如下步骤。

步骤401,获取视频,视频的视频帧序列中存在持续噪点元素,持续噪点元素是在至少两个视频帧上连续出现的噪点元素。

持续噪点元素是指在视频帧中遮挡原始视频帧或原始图像中已有的像素点的持续性出现的元素。示意性的,该持续噪点元素包括人为遮挡元素,如用户在拍摄时,指尖遮挡住镜头的一小部分,使得拍摄出的视频中部分区域被指尖遮挡。示意性的,该持续噪点元素包括天气颗粒元素,天气颗粒元素是指由于天气原因对视频的可视性产生影响的颗粒元素。天气颗粒元素包括但不限于如下元素中的至少一种:雨滴元素、雪花元素、冰雹元素、雷电元素、雾气元素、雾霾元素、沙尘暴元素。在一些实施例中,天气颗粒元素在视频帧中的排布密度较高,或天气颗粒元素的尺寸较大,均会对视频帧中的部分区域或部分元素进行遮挡。本申请以持续噪点元素为天气颗粒元素进行举例说明。

示意性的,视频是通过终端的采集得到的,在终端中安装有摄像应用程序(操作系统中的摄像应用程序),该摄像应用程序调用摄像头进行视频采集,将采集到的视频存储在终端中。在一些实施例中,在终端中安装有第三方应用程序,该第三方应用程序用于调用终端的摄像头对视频进行采集,将采集到的视频存储在终端中。在另一些实施例中,视频是终端中存储的视频,该视频可以是用户通过网络下载至终端中的视频,如从视频网页中下载的视频,或即时通讯程序中的好友转发的视频。

示意性的,视频是预先存储在服务器中的视频,服务器包括用于存储视频的数据库,视频是大量用户通过应用程序上传至服务器中的。比如,用户通过美颜相机应用程序调用终端的摄像头采集视频,通过该美颜相机应用程序将采集到的视频上传至服务器。又如,服务器记录并存储每次进行去噪处理的视频。

示意性的,视频是公开的视频数据集中的视频,将公开的视频数据集导入至终端,或服务器中,终端或服务器对视频进行存储。

步骤402,提取视频帧序列中的视频帧的空间特征。

空间特征的提取方法由如图3所示的神经网络模型执行,该神经网络模型包括空间特征提取单元42,该空间特征提取单元42包括第一卷积神经网络(ConvolutionalNeural Networks,CNN),即空间特征通过该空间特征提取单元42中的第一卷积神经网络进行提取,上述步骤402可替换为如下步骤。

步骤4021,调用第一卷积神经网络对视频帧进行下采样处理,得到尺寸缩小的视频帧。

如图5所示,空间特征提取单元42是基于第一卷积神经网络构建的,通过对输入视频帧411进行下采样处理422来缩小输入视频帧411的尺寸,即对输入视频帧411进行压缩。图5中的“×2”、“×4”等表示对视频帧缩小的倍数。

下采样处理(Subsampled)是指对视频帧或图像的尺寸进行缩小的处理,又被命名为降采样(Downsampled)。下采样处理的目的是使得图像或视频帧符合显示区域的大小,或者生成与图像或视频帧对应的缩略图。对于一幅图像I尺寸为M*N,对其进行s倍下采样,即得到(M/s)*(N/s)尺寸的得分辨率图像,示意性的,s是M和N的公约数。如果是矩阵形式的图像,就是把原始图像s*s窗口内的图像变成一个像素,这个像素点的值就是窗口内所有像素点的均值。图5中的“×2”、“×4”等表示对视频帧进行“×2”、“×4”倍下采样,即缩小的倍数为2倍、4倍。

步骤4022,从所尺寸缩小的视频帧中提取至少两个维度的特征。

对输入视频帧411进行不同倍数的下采样处理422,得到该输入视频帧411对应的多个尺寸的视频帧,从该多个尺寸的视频帧中提取至少两个维度的特征(或两个层次的特征)。示意性的,在持续噪点元素为雨滴元素的视频帧中,雨滴元素的深度信息对应有不同维度的特征,深度信息较大的雨滴元素(即距离拍摄镜头较远的雨滴元素)对应深层次的空间特征,深度信息较小的雨滴元素(即距离拍摄镜头较近的雨滴元素)对应浅层次的空间特征。基于多个尺寸的视频帧,可提取到多个维度的空间特征。

步骤4023,将至少两个维度的特征进行连接,得到尺寸缩小的视频帧对应的第一空间特征。

如图5所示,将至少两个维度的空间特征421进行连接(Concat),得到第一空间特征424。

步骤4024,对尺寸缩小的视频帧进行上采样处理,得到尺寸放大的视频帧,尺寸放大的视频帧对应有第二空间特征。

将尺寸缩小的视频帧进行上采样处理423来放大视频帧的尺寸,即对缩小视频帧411进行放大。上采样处理(Upsampling)是指对视频帧或图像的尺寸进行放大的处理,又被命名为图像插值处理(Interpolating)。上采样处理的主要目的是放大原图像或原视频帧,从而可以显示在更高分辨率的显示设备上,对图像或视频帧的缩放操作并不能产生更多关于图像或视频帧的信息,因此图像或视频帧的质量将受到影响。图像或视频帧的上采样处理通常都是采用内插值方法,即在原有图像或视频帧中的原有像素的基础上,在像素点之间采用合适的插值算法插入新的元素。

示意性的,在将视频帧放大至与输入视频帧411相同尺寸时,可提取到该尺寸下视频帧对应的第二空间特征425。

步骤4025,将第一空间特征和第二空间特征进行融合,得到视频帧对应的空间特征。

将第一空间特征424和第二空间特征425进行融合,得到输入视频帧411对应的空间特征。

步骤403,根据相邻的视频帧的空间特征,提取视频帧的时间特征。

在提取视频帧的时间特征时,所需的视频帧包括:当前视频帧、位于当前视频帧之前的在前视频帧以及位于当前视频帧之后的在后视频帧。当前帧是指空间特征提取单元42正在处理的视频帧,位于当前视频帧之前的任意一帧或几帧视频帧都被命名为在前视频帧,位于当前视频帧之后的任意一帧或几帧视频帧都被命名为在后视频帧。在视频播放时,在前视频帧先于在后视频帧播放,即在时间轴上,在前视频帧的播放时间早于在后视频帧的播放时间。

基于当前视频帧的空间特征、在前视频帧的空间特征以及在后视频帧的空间特征,提取当前视频帧对应的时间特征。

时间特征的提取方法由如图3所示的神经网络模型执行,该神经网络模型包括双向卷积长短记忆单元43,该双向卷积长短记忆单元43包括双向长短记忆网络和第二卷积神经网络。

步骤4031,调用双向长短记忆网络对当前视频帧对应的空间特征、在前视频帧对应的空间特征和在前视频帧对应的状态特征进行正向处理,得到当前视频帧对应的第一状态特征。

如图6所示,双向长短记忆单元431用于对视频帧序列中的视频帧进行时间特征的提取,该提取过程是对含有持续噪点元素的视频帧按照一帧为单位进行处理。图6示出的双向长短记忆单元431是针对某一帧视频帧进行处理的单元,在双向卷积长短记忆单元43中存在多个双向长短记忆单元431。双向长短记忆单元431是基于双向长短记忆网络构建的,即由前向长短期记忆网络和后向长短期记忆网络构建的。上一帧视频帧对应的双向长短记忆单元431输出的状态信息作为下一帧视频帧对应的双向长短记忆单元431的输入。

示意性的,以第t帧视频帧是当前视频帧为例(t为大于1的整数),将第t帧视频帧输入至如图5所示的空间特征提取单元42中,通过调用第一卷积神经网络对第t帧视频帧进行空间特征的提取,得到第t帧视频帧对应的空间特征,同理,利用空间特征提取单元42对第t-1帧视频帧进行空间特征的提取,得到第t-1帧视频帧对应的空间特征。由图4所示的神经网络模型的框架可知,第t-1帧视频帧对应的双向长短记忆单元431输出第t-1帧视频帧对应的状态特征。将第t帧视频帧对应的空间特征、第t-1帧视频帧对应的空间特征以及第t-1帧视频帧对应的状态特征输入至第t帧视频帧对应的双向长短记忆单元431中,双向长短记忆单元431中的前向长短期记忆网络对上述三种特征进行正向处理,得到当前视频帧对应的第一状态特征432。

上述三种特征按照第t-1帧视频帧、第t帧视频帧的正向顺序输入至双向长短记忆单元431中的前向长短期记忆网络。

对每帧视频帧对应的长短记忆网络输出状态信息的过程进行说明。

LSTM神经网络的结构如图7所示,LSTM神经网络中包括细胞状态(C

在LSTM神经网络中,遗忘门601用于决定哪些信息需要从细胞状态600中被遗忘。遗忘门601以上一层的输出向量ht-1和本次待输入的向量Xt作为输入,通过一个逻辑回归函数(Sigmoid)得到输出结果,输出结果的取值在[0,1]区间,表示上一层细胞状态(即输出向量ht-1对应的细胞状态)被遗忘的概率,“1”代表完全保留,“0”代表完全舍弃。

输入门602包括两个部分:第一,使用Sigmoid函数的部分,第二,使用双曲正切(tanh)函数的部分。第一部分用于决定哪些新信息该被加入细胞状态600中,确定哪些新信息要加入后,需要将新信息通过tanh函数转换成能够加入到细胞状态600的形式。示意性的,细胞状态600由C

输出门603基于细胞状态600保存的内容来确定输出向量h

可以理解的是,第t-1帧视频帧对应的状态特征,也是由第t-1帧视频帧对应的前向长短期记忆网络和后向长短期记忆网络结合输出的。

步骤4032,调用双向长短记忆网络对当前视频帧对应的空间特征、在后视频帧对应的空间特征和在后视频帧对应的状态特征进行反向处理,得到当前视频帧对应的第二状态特征。

同理,类似于前向长短期记忆网络的工作原理,将视频帧按照第t+1帧、第t帧反向输入至双向长短记忆单元431中的后向长短期记忆网络中,后向长短期记忆网络与前向长短期记忆网络的工作原理一致,只是在处理顺序上将t+1帧视频帧对应的空间状态和特征状态作为第t帧视频帧对应的后向长短期记忆网络的输入。将第t+1帧视频帧对应的状态特征和空间特征、第t帧视频帧对应的空间特征输入至第t帧视频帧对应的后向长短期记忆网络中,得到第t帧视频帧对应的第二状态特征433。

步骤4033,调用第二卷积神经网络对第一状态特征和第二状态特征进行处理,得到当前视频帧对应的时间特征。

调用第二卷积神经网络对第一状态432和第二状态433进行处理,得到当前视频帧(第t帧视频帧)对应的时间特征434。

结合一组公式对双向卷积长短记忆单元43输出第t帧视频帧对应的状态特征进行说明。

公式一

其中,

上述公式一中的第一个公式表示单向长短期记忆网络(前向或后向)中的遗忘门对应的输出,第二个公式表示单向长短期记忆网络中的输入门对应的输出,第三个公式表示单向长短期记忆网络对应的状态更新值,第四个公式表示单向长短期记忆网络根据状态更新值更新后的细胞状态,第五个公式表示单向长短期记忆网络中的输出门对应的输出,第六个公式表示单向长短期记忆网络输出的状态值,第七个公式表示双向长短期记忆网络输出的状态值。

上述公式一中的最后一个公式即表示通过对第一状态特征和第二状态特征进行卷积操作,得到第t帧视频帧对应的状态特征。此外,其他公式与LSTM网络中的运算过程相同,在每步运算中需要结合第t-1帧对应的空间状态和第t帧对应的空间特征进行运算。此处不再赘述。

需要说明的是,上述实施例中仅以第t-1帧、第t帧和第t+1帧视频帧为例进行说明,在实际进行特征提取处理时,可以对连续的几帧同时处理,本申请实施例对此不加以限定。

步骤404,将空间特征和时间特征进行融合,得到视频帧序列对应的融合后的时空特征。

示意性的,通过卷积双向长短记忆单元43对视频帧对应的时间特征和空间特征进行融合,或者,通过时空互助单元44对视频帧对应的时间特征和空间特征进行融合。本申请实施例以通过时空互助单元44对视频帧对应的时间特征和空间特征进行融合为例进行说明。

步骤405,调用第三卷积神经网络基于融合后的时空特征,对视频中的视频帧进行卷积处理,得到视频帧对应的卷积矩阵。

去除噪点的方法由如图3所示的神经网络模型执行,该神经网络模型包括时空互助单元44,时空互助单元44包括第三卷积神经网络和第四卷积神经网络。

如图8所示,时空互助单元44包括第三卷积神经网络和第四卷积神经网络,该时空互助单元44的输入是含有持续噪点元素的视频帧(对应有空间特征)和双向卷积长短记忆单元43输出的时间特征作为输入。时空互助单元44将时间特征和含有持续噪点元素的视频帧对应的空间特征进行融合,得到视频帧对应的时空特征,基于该时空特征调用第三卷积神经网络441对视频帧进行卷积处理,示意性的,该第三卷积神经网络是一个卷积核为5×5×3,缩小倍数为64的三维卷积神经网络。输出视频帧对应的卷积矩阵。

步骤406,调用第四卷积神经网络对卷积矩阵进行残差处理,得到去噪处理后的视频帧。

将卷积矩阵输入至第四卷积神经网络442中,通过第四卷积神经网络输出去噪处理后的视频帧。

示意性的,第四卷积神经网络442是一个卷积核为3×3×1,用于进行残差处理的二维卷积神经网络。该第四卷积神经网络442是基于密集残差块(Residual Dense Block,RDB)构建成的。RDB模块是根据残差模块(Residual Block)和密集模块(Dense Block)进行集合后形成的模块,每一个RDB包含以下三个模块,如图9所示。

“RDB d-1”表示第d-1个RDB模块,“RDB d+1”表示第d+1个RDB模块,对第d个RDB模块的内部结构进行说明。

相邻记忆模块91(Contiguous Memory):包括多个卷积层(Conv)—激活层(ReLu)组成的单元,即图9中连接层(Concat)之前的结构。然后将F

局部特征融合模块92(Local Feature Fusion):包括在串接之后连接的1*1的卷积层和融合层(以符号“⊕”表示),主要用于多通道的特征融合和降维作用。

局部残差学习模块93(Local Residual Learning):用于将F

上述第一卷积神经网络、第二卷积神经网络、第三卷积神经网络和第四卷积神经网络可以是相同的卷积神经网络或不同的卷积神经网络,示意性的,根据卷积神经网络的用途采用不同的视频样本对卷积神经网络进行训练,得到对应功能的卷积神经网络。

步骤407,根据去噪处理后的视频帧,得到处理后的视频。

示意性的,神经网络模型中设置有第一误差损失函数和第二误差损失函数,通过第一误差损失函数和第二误差损失函数计算视频帧对应的第一误差损失结果和第二误差损失结果,根据第一误差损失结果和第二误差损失结果的加权和结果得到当前视频帧对应的误差损失结果,当加权和结果收敛时,得到处理后的当前视频帧。

根据上述实施例中一帧视频帧的处理方式,得到一帧处理后的视频帧,将一帧处理后的视频帧组合成处理后的视频,处理后的视频可清除全部或部分持续噪点元素,提高视频的清晰度。

综上所述,本实施例提供的方法,通过在视频帧对应的空间特征上附加视频帧对应的时间特征,基于融合后的时空特征对视频进行去噪处理,根据融合后的时空特征能够确定持续噪点元素在视频帧中的位置,以及确定持续噪点元素在视频帧序列中的运动轨迹,使得视频帧中具有持续噪点元素的区域能够更完整地从原视频帧中分离出来并被去除,从而具有更好的去噪效果,使得经过去噪处理后的视频更加清晰。

本实施例提供的方法,还通过空间特征提取单元对视频帧对应的空间特征进行提取,利用卷积神经网络提取隐含在输入视频中的结构信息,将从经过下采样处理后的视频帧中提取出至少两个维度的空间特征,以及从视频中提取到的空间特征进行融合,融合不同维度(不同层次)的空间特征,使得提取到的视频帧对应的空间特征更具有代表性,便于后续时间特征的提取。

本实施例提供的方法,还通过创新地提供一种双向卷积长短记忆单元,以对视频帧进行时间特征的提取,基于双向长短记忆单元的特性,根据相邻视频帧对应的空间特征来提取视频帧之间隐含的时间特征,从而利用提取到的时间特征对视频帧进行去噪处理。使得提取到的视频帧对应的时间特征更具有代表性,从而便于后续根据融合后的时空特征对视频帧进行去噪处理后,得到质量较高的视频。

本实施例提供的方法,还通过创新地提供一种增强的时空互助单元,利用时空互助单元中的卷积神经网络,基于融合后的时空特征协同完成对视频去噪处理。

基于图4的可选实施例中,对上述实施例中的神经网络模型的训练方法进行说明。如图10所示,该神经网络模型的训练方法包括如下步骤。

步骤1001,获取样本视频,样本视频包括样本有噪视频和样本无噪视频,样本有噪视频是含有持续噪点元素的样本视频,样本无噪视频是不含有持续噪点元素的样本视频。

样本有噪视频中至少两帧视频帧上存在持续噪点元素,样本无噪视频中不存在持续噪点元素,即干净的样本视频。示意性的,样本有噪视频和样本无噪视频是针对同一场景进行拍摄的视频,即视频内容相同。

示意性的,样本视频是来源于公开视频集中的视频,公开视频集是各个用户或视频应用程序开发者提供的视频形成的视频数据集;或,样本视频是应用程序的使用用户自行上传的视频,由该应用程序对应的服务器进行收集并存储。

步骤1002,将样本有噪视频输入至神经网络模型中,输出经过去噪处理后的样本视频。

将样本有噪视频输入至如图3所示的神经网络模型中,将样本有噪视频按照视频帧为单位进行处理,通过空间特征提取单元42从当前视频帧中提取空间特征。将当前视频帧对应的空间特征输入至双向卷积长短记忆单元43,双向卷积长短记忆单元43对当前视频帧对应的空间特征、位于当前视频帧之前的在前视频帧对应的空间特征和状态特征进行正向处理,得到当前视频帧对应的第一状态特征;对当前帧对应的空间特征、对位于当前帧之后的在后视频帧对应的空间特征和状态特征进行反向处理,得到当前视频帧对应的第二状态特征。对第一状态特征和第二状态特征进行卷积处理,得到当前视频帧对应的时间特征。

将当前帧对应的时间特征和空间特征进行融合,得到当前帧对应的融合后的时空特征。时空互助单元44基于融合后的时空特征对当前视频帧进行处理,得到处理后的视频帧,视频中含有持续噪点元素的视频帧都以该方式进行处理,得到处理后的视频,即经过去噪处理后的样本视频。

步骤1003,计算经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果。

利用双向卷积长短记忆单元43对应的第一误差损失结果和时空互助单元44对应的第二损失误差结果分别对经过去噪处理后的样本视频和样本无噪视频之间的误差损失结果进行计算。

根据第一误差损失结果和第二误差损失结果的加权和结果,得到经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果,通过如下公式表示经过去噪处理后的样本视频和样本无噪视频之间的误差损失结果。

公式二:

其中,

步骤1004,根据误差损失结果对神经网络模型进行训练,得到训练后的神经网络模型。

神经网络模型基于上述误差损失结果不断训练,响应于误差损失结果收敛,得到训练后的神经网络模型。

综上所述,本实施例的方法,通过经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果来训练神经网络模型,提升了神经网络模型对视频进行去噪处理的效果,使得训练后的神经网络模型在对视频帧进行去噪处理时,处理后的视频的质量更高。

基于图10的实施例中,上述步骤1003可替换为如下步骤。

步骤1003a,获取第一误差损失结果,第一误差损失结果是双向长短记忆网络和第二卷积神经网络对应的误差损失结果。

第一误差损失结果即双向卷积长短记忆单元对应的误差损失结果,该双向卷积长短记忆单元包括双向长短记忆网络和第二卷积神经网络。

S1、获取样本无噪视频对应的第一状态特征和样本有噪视频对应的第二状态特征。

S2、获取样本视频中的像素点的坐标、样本视频的宽度尺寸和样本视频的高度尺寸。

S3、根据第一状态特征、第二状态特征、像素点的坐标、宽度尺寸和高度尺寸,得到第一误差损失结果。

通过如下公式三计算双向卷积长短记忆单元43对应的第一误差损失结果。

公式三:

其中,W表示当前视频帧的宽度尺寸,H表示当前视频帧的高度尺寸,

步骤1003b,获取第二误差损失结果,第二误差损失结果是第三卷积神经网络和第四卷积神经网络对应的误差损失结果。

第二误差损失结果即时空互助单元对应的第二误差损失结果,该时空互助单元包括第三卷积神经网络和第四卷积神经网络。

S11、获取样本无噪视频对应的第一状态特征、样本有噪视频对应的第二状态特征,以及经过去噪处理后的样本视频对应的第三状态特征。

S22、获取样本视频中的像素点的坐标、样本视频的宽度尺寸和样本视频的高度尺寸。

S33、根据第一状态特征、第二状态特征、第三状态特征、像素点的坐标、宽度尺寸、高度尺寸,得到第二误差损失结果。

通过如下公式四计算时空互助单元44对应的第二误差损失结果。

公式四:

其中,W表示当前视频帧的宽度尺寸,H表示当前视频帧的高度尺寸,

步骤1003c,根据第一误差损失结果和第二误差损失结果的加权和结果,得到经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果。

参见上述公式二的实施方式,在一些实施例中,当α为零时,最终的误差损失结果

综上所述,本实施例提供的方法,通过利用双向卷积长短记忆单元对应的第一误差损失结果来对双向卷积长短记忆单元进行训练,使得双向卷积长短记忆单元能够从视频帧中更准确地提取出视频帧对应的时间特征,便于后续神经网络模型输出处理后的清晰视频。

本实施例提供的方法,还通过利用时空互助单元对应的第二误差损失结果来对时空互助单元进行训练,使得时空互助单元能够从视频帧中更准确地基于融合后的时空特征对视频进行去噪处理,使得神经网络模型输出处理后的清晰视频。

在一些实施例中,上述设置有神经网络模型的终端,或设置有神经网络模型的服务器可以是一个分布式系统中的一个节点,其中,该分布式系统可以为区块链系统,该区块链系统可以是由该多个节点通过网络通信的形式连接形成的分布式系统。其中,节点之间可以组成点对点(P2P,Peer To Peer)网络,任意形式的计算设备,比如服务器、终端等电子设备都可以通过加入该点对点网络而成为该区块链系统中的一个节点。其中,节点包括硬件层、中间层、操作系统层和应用层。通过节点向区块链系统中发送去噪处理后的视频,以存储经过去噪处理后的视频,使得参与区块链系统的节点均能够查看去噪处理后的视频,丰富了神经网络模型进行训练时的样本视频,有利于神经网络模型的训练。

图11示出了本申请一个示例性实施例提供的视频去噪装置的结构框图,该装置包括如下部分。

获取模块1110,用于获取视频,视频的视频帧序列中存在持续噪点元素,持续噪点元素是在至少两帧视频帧上连续出现的噪点元素;

特征提取模块1120,用于提取视频帧序列的空间特征和时间特征;

特征融合模块1130,用于将空间特征和时间特征进行融合,得到视频帧序列对应的融合后的时空特征;

去噪模块1140,用于基于融合后的时空特征对视频帧序列进行去噪处理,得到处理后的视频。

在一个可选的实施例中,所述特征提取模块1120,用于提取视频帧序列中的视频帧的空间特征;根据相邻的视频帧的空间特征,提取视频帧的时间特征。

在一个可选的实施例中,该装置包括神经网络模型,神经网络模型包括第一卷积神经网络;

所述特征提取模块1120,用于调用第一卷积神经网络对视频帧进行下采样处理,得到尺寸缩小的视频帧;从尺寸缩小的视频帧中提取至少两个维度的特征;将至少两个维度的特征进行连接,得到尺寸缩小的视频帧对应的第一空间特征;对尺寸缩小的视频帧进行上采样处理,得到尺寸放大的视频帧,尺寸放大的视频帧对应有第二空间特征;

所述特征融合模块1130,用于将第一空间特征和第二空间特征进行融合,得到视频帧对应的空间特征。

在一个可选的实施例中,视频帧包括:当前视频帧、位于当前视频帧之前的在前视频帧以及位于当前视频帧之后的在后视频帧;

所述特征提取模块1120,用于基于当前视频帧的空间特征、在前视频帧的空间特征以及在后视频帧的空间特征,提取当前视频帧对应的时间特征。

在一个可选的实施例中,该装置包括神经网络模型,神经网络模型包括双向长短记忆网络和第二卷积神经网络;

所述特征提取模块1120,用于调用双向长短记忆网络对当前视频帧对应的空间特征、在前视频帧对应的空间特征和在前视频帧对应的状态特征进行正向处理,得到当前视频帧对应的第一状态特征;

所述特征提取模块1120,用于调用双向长短记忆网络对当前视频帧对应的空间特征、在后视频帧对应的空间特征和在后视频帧对应的状态特征进行反向处理,得到当前视频帧对应的第二状态特征;

所述特征提取模块1120,用于调用第二卷积神经网络对第一状态特征和第二状态特征进行处理,得到当前视频帧对应的时间特征。

在一个可选的实施例中,该神经网络模型包括,神经网络模型包括第三卷积神经网络和第四卷积神经网络;

所述特征提取模块1120,用于调用第三卷积神经网络基于融合后的时空特征,对视频中的视频帧进行卷积处理,得到视频帧对应的卷积矩阵;调用第四卷积神经网络对卷积矩阵进行残差处理,得到去噪处理后的视频帧;根据去噪处理后的视频帧,得到处理后的视频。

在一个可选的实施例中,持续噪点元素包括天气颗粒元素,天气颗粒元素包括雨滴元素、雪花元素、冰雹元素、雾气元素和雾霾元素中的至少一种。

在一个可选的实施例中,该装置包括处理模块1150和训练模块1160;

所述获取模块1110,用于获取样本视频,样本视频包括样本有噪视频和样本无噪视频,样本有噪视频是含有持续噪点元素的样本视频,样本无噪视频是不含有持续噪点元素的样本视频;

所述处理模块1150,用于将样本有噪视频输入至神经网络模型中,输出经过去噪处理后的样本视频;计算经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果;

所述训练模块1160,用于根据误差损失结果对神经网络模型进行训练,得到训练后的神经网络模型。

在一个可选的实施例中,所述获取模块1110,用于获取第一误差损失结果,第一误差损失结果是双向长短记忆网络和第二卷积神经网络对应的误差损失结果;获取第二误差损失结果,第二误差损失结果是第三卷积神经网络和第四卷积神经网络对应的误差损失结果;

所述处理模块1150,用于根据第一误差损失结果和第二误差损失结果的加权和结果,得到经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果。

在一个可选的实施例中,所述获取模块1110,用于获取样本无噪视频对应的第一状态特征和样本有噪视频对应的第二状态特征;获取样本视频中的像素点的坐标、样本视频的宽度尺寸和样本视频的高度尺寸;

所述处理模块1150,用于根据第一状态特征、第二状态特征、像素点的坐标、宽度尺寸和高度尺寸,得到第一误差损失结果。

在一个可选的实施例中,所述获取模块1110,用于获取样本无噪视频对应的第一状态特征、样本有噪视频对应的第二状态特征,以及经过去噪处理后的样本视频对应的第三状态特征;获取样本视频中的像素点的坐标、样本视频的宽度尺寸和样本视频的高度尺寸;

所述处理模块1150,用于根据第一状态特征、第二状态特征、第三状态特征、像素点的坐标、宽度尺寸、高度尺寸,得到第二误差损失结果。

综上所述,本实施例的装置,通过在视频帧对应的空间特征上附加视频帧对应的时间特征,基于融合后的时空特征对视频进行去噪处理,根据融合后的时空特征能够确定持续噪点元素在视频帧中的位置,以及确定持续噪点元素在视频帧序列中的运动轨迹,使得视频帧中具有持续噪点元素的区域能够更完整地从原视频帧中分离出来并被去除,从而具有更好的去噪效果,使得经过去噪处理后的视频更加清晰。

本实施的装置,还通过空间特征提取单元对视频帧对应的空间特征进行提取,利用卷积神经网络提取隐含在输入视频中的结构信息,将从经过下采样处理后的视频帧中提取出至少两个维度的空间特征,以及从视频中提取到的空间特征进行融合,融合不同维度(不同层次)的空间特征,使得提取到的视频帧对应的空间特征更具有代表性,便于后续时间特征的提取。

本实施的装置,还通过空间特征提取单元对视频帧对应的空间特征进行提取,利用卷积神经网络提取隐含在输入视频中的结构信息,将从经过下采样处理后的视频帧中提取出至少两个维度的空间特征,以及从视频中提取到的空间特征进行融合,融合不同维度(不同层次)的空间特征,使得提取到的视频帧对应的空间特征更具有代表性,便于后续时间特征的提取。

本实施的装置,还通过创新地提供一种双向卷积长短记忆单元,以对视频帧进行时间特征的提取,基于双向长短记忆单元的特性,根据相邻视频帧对应的空间特征来提取视频帧之间隐含的时间特征,从而利用提取到的时间特征对视频帧进行去噪处理。使得提取到的视频帧对应的时间特征更具有代表性,从而便于后续根据融合后的时空特征对视频帧进行去噪处理后,得到质量较高的视频。

本实施例提供的装置,还通过创新地提供一种增强的时空互助单元,利用时空互助单元中的卷积神经网络,基于融合后的时空特征协同完成对视频去噪处理。

本实施例的装置,还通过经过去噪处理后的样本视频与样本无噪视频之间的误差损失结果来训练神经网络模型,提升了神经网络模型对视频进行去噪处理的效果,使得训练后的神经网络模型在对视频帧进行去噪处理时,处理后的视频的质量更高。

本实施例的装置,还通过利用双向卷积长短记忆单元对应的第一误差损失结果来对双向卷积长短记忆单元进行训练,使得双向卷积长短记忆单元能够从视频帧中更准确地提取出视频帧对应的时间特征,便于后续神经网络模型输出处理后的清晰视频。

本实施例提供的装置,还通过利用时空互助单元对应的第二误差损失结果来对时空互助单元进行训练,使得时空互助单元能够从视频帧中更准确地基于融合后的时空特征对视频进行去噪处理,使得神经网络模型输出处理后的清晰视频。

图12示出了本申请一个示例性实施例提供的服务器的结构示意图。该服务器可以如图1所示的计算机系统100中的服务器120。

服务器1200包括中央处理单元(CPU,Central Processing Unit)1201、包括随机存取存储器(RAM,Random Access Memory)1202和只读存储器(ROM,Read Only Memory)1203的系统存储器1204,以及连接系统存储器1204和中央处理单元1201的系统总线1205。服务器1200还包括帮助计算机内的各个器件之间传输信息的基本输入/输出系统(I/O系统,Input Output System)1206,和用于存储操作系统1213、应用程序1214和其他程序模块1215的大容量存储设备1207。

基本输入/输出系统1206包括有用于显示信息的显示器1208和用于用户输入信息的诸如鼠标、键盘之类的输入设备1209。其中显示器1208和输入设备1209都通过连接到系统总线1205的输入输出控制器1210连接到中央处理单元1201。基本输入/输出系统1206还可以包括输入输出控制器1210以用于接收和处理来自键盘、鼠标、或电子触控笔等多个其他设备的输入。类似地,输入输出控制器1210还提供输出到显示屏、打印机或其他类型的输出设备。

大容量存储设备1207通过连接到系统总线1205的大容量存储控制器(未示出)连接到中央处理单元1201。大容量存储设备1207及其相关联的计算机可读介质为服务器1200提供非易失性存储。也就是说,大容量存储设备1207可以包括诸如硬盘或者紧凑型光盘只读存储器(CD-ROM,Compact Disc Read Only Memory)驱动器之类的计算机可读介质(未示出)。

计算机可读介质可以包括计算机存储介质和通信介质。计算机存储介质包括以用于存储诸如计算机可读指令、数据结构、程序模块或其他数据等信息的任何方法或技术实现的易失性和非易失性、可移动和不可移动介质。计算机存储介质包括RAM、ROM、可擦除可编程只读存储器(EPROM,Erasable Programmable Read Only Memory)、带电可擦可编程只读存储器(EEPROM,Electrically Erasable Programmable Read Only Memory)、闪存或其他固态存储其技术,CD-ROM、数字通用光盘(DVD,Digital Versatile Disc)或固态硬盘(SSD,Solid State Drives)、其他光学存储、磁带盒、磁带、磁盘存储或其他磁性存储设备。其中,随机存取记忆体可以包括电阻式随机存取记忆体(ReRAM,Resistance RandomAccess Memory)和动态随机存取存储器(DRAM,Dynamic Random Access Memory)。当然,本领域技术人员可知计算机存储介质不局限于上述几种。上述的系统存储器1204和大容量存储设备1207可以统称为存储器。

根据本申请的各种实施例,服务器1200还可以通过诸如因特网等网络连接到网络上的远程计算机运行。也即服务器1200可以通过连接在系统总线1205上的网络接口单元1211连接到网络1212,或者说,也可以使用网络接口单元1211来连接到其他类型的网络或远程计算机系统(未示出)。

上述存储器还包括一个或者一个以上的程序,一个或者一个以上程序存储于存储器中,被配置由CPU执行。

在一个可选的实施例中,提供了一种计算机设备,该计算机设备包括处理器和存储器,存储器中存储有至少一条指令、至少一段程序、代码集或指令集,至少一条指令、至少一段程序、代码集或指令集由处理器加载并执行以实现如上所述的视频去噪方法。

在一个可选的实施例中,提供了一种计算机可读存储介质,该存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,至少一条指令、至少一段程序、代码集或指令集由处理器加载并执行以实现如上所述的视频去噪方法。

可选地,该计算机可读存储介质可以包括:只读存储器(ROM,Read Only Memory)、随机存取记忆体(RAM,Random Access Memory)、固态硬盘(SSD,Solid State Drives)或光盘等。其中,随机存取记忆体可以包括电阻式随机存取记忆体和动态随机存取存储器。上述本申请实施例序号仅为了描述,不代表实施例的优劣。

本申请实施例还提供了一种计算机程序产品或计算机程序,所述计算机程序产品或计算机程序包括计算机指令,所述计算机指令存储在计算机可读存储介质中。计算机设备的处理器从所述计算机可读存储介质读取所述计算机指令,所述处理器执行所述计算机指令,使得所述计算机设备执行如上方面所述的视频去噪方法。

作为示例,程序指令可被部署在一个计算设备上执行,或者在位于一个地点的多个计算设备上执行,又或者,在分布在多个地点且通过通信网络互连的多个计算设备上执行,分布在多个地点且通过通信网络互连的多个计算设备可以组成区块链系统。

应当理解的是,在本文中提及的“多个”是指两个或两个以上。“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,A和/或B,可以表示:单独存在A,同时存在A和B,单独存在B这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。

本领域普通技术人员可以理解实现上述实施例的全部或部分步骤可以通过硬件来完成,也可以通过程序来指令相关的硬件完成,所述的程序可以存储于一种计算机可读存储介质中,上述提到的存储介质可以是只读存储器,磁盘或光盘等。

以上所述仅为本申请的可选实施例,并不用以限制本申请,凡在本申请的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本申请的保护范围之内。

- 视频去噪方法、装置、设备及存储介质

- 视频图像的去噪方法、装置、电子设备和可读存储介质