一种基于深度学习3D姿态分析的运动评分方法及装置

文献发布时间:2023-06-19 13:26:15

技术领域

本发明涉及计算机技术领域,尤其涉及一种基于深度学习3D姿态分析的运动评分方法及装置。

背景技术

随着时代的迅猛发展,人们的生活质量不断提高,在物质生活得到满足下,越来越多的人开始关心身心健康,健身锻炼成为不可缺少。在进行健身锻炼的传统学习或比赛中,主要是依据人的经验进行判断并评分,这种方法对人的依赖性很高,效率以及准确性却不高,不能准确判断训练或比赛过程中的动作是否符合标准。目前,还有一种通过进行人体姿态识别进行评分,虽然效率提高了,但是,分析步骤中通常采用的是2D的人体姿态,由于缺乏深度信息,使其姿态信息具有一定歧义,无法准确表达运动人员的动作。

发明内容

为了解决上述技术问题,本发明提出一种基于深度学习3D姿态分析的运动评分方法及装置。在所述方法及装置中,基于双目立体视觉技术结合深度学习算法的方式捕捉了3D人体骨架,充分还原了运动人员的动作时空特征,然后与标准/专业运动人员的3D人体骨架数据数据做时空特征对比,通过计算两组数据时空特征的相似度,评判运动得分,在精确度方面高于现有的基于2D人体骨架的运动评分系统。

为了达到上述目的,本发明的技术方案如下:

一种基于深度学习3D姿态分析的运动评分方法,包括如下步骤:

通过双目相机拍摄目标人物,获取具有目标人物的左镜头画面和右镜头画面,并提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架;

基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架;

提取多帧连续的3D人体骨架的时空特征;

确定待测目标人物与预存的标准运动人员的3D人体骨架的时空特征相似度,并根据相似度进行运动评分。

优选地,所述提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架中,调用预先训练的深度卷积神经网络模型分别对所述左镜头画面和右镜头画面中目标人物进行人体关键点检测,获得2D人体骨架并保存。

优选地,所述人体关键点包括鼻子、脖子、右肩、右肘、右手腕、左肩、左肘、左手腕、右臀、右膝盖、右脚踝、左臀、左膝盖、左脚踝、右眼、左眼、右耳朵和左耳朵关键点。

优选地,所述基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架,具体包括如下步骤:

对所述左镜头画面和右镜头画面中目标人物的2D人体骨架进行关键点匹配,获得2D人体骨架关键点对;

基于提前标定的相机参数和最小二乘法获得2D人体骨架关键点对对应在空间点坐标;

遍历图像中所有匹配成功的2D人体骨架关键点对,得到每对2D人体骨架关键点对对应的空间点坐标,即获得3D人体骨架。

优选地,所述提前标定的相机参数是采用张氏标定法标定双目相机,并计算获得。

优选地,所述确定待测目标人物与预存的标准运动人员的3D人体骨架的时空特征相似度,并根据相似度进行运动评分,具体包括如下步骤:

对待测目标人物的3D骨架序列和标准运动员的3D骨架序列分别进行小波变换,获得目标人物对应的时空特征和标准时空特征;

采用动态时间规整将目标人物对应的时空特征和标准时空特征进行动作相似度的计算,根据计算结果进行运动评分。

一种基于深度学习3D姿态分析的运动评分装置,包括:双目相机、第一处理单元、构建单元、第二处理单元和对比单元,其中,

所述双目相机,用于拍摄目标人物,获取具有目标人物的左镜头画面和右镜头画面,并将左镜头画面和右镜头画面发送至第一处理单元;

所述第一处理单元,用于接收左镜头画面和右镜头画面,并提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架;

所述构建单元,用于基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架;

所述第二处理单元,用于提取多帧3D人体骨架的时空特征;

所述对比单元,用于对比待测目标人物与预存的标准运动人员的3D人体骨架的时空特征相似度,并根据相似度进行运动评分。

一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机可执行指令,所述计算机可执行指令被处理器执行时实现如上述任意一项所述的方法中的步骤。

基于上述技术方案,本发明的有益效果是:本发明基于双目立体视觉技术结合深度学习算法的方式捕捉了3D人体骨架,充分还原了运动人员的动作时空特征,然后与标准/专业运动人员的3D人体骨架数据数据做时空特征对比,通过计算两组数据时空特征的相似度,评判运动得分,在精确度方面高于现有的基于2D人体骨架的运动评分系统。本发明同时是一种通用化的动作分析系统,只需要拍摄两个视频段,即可分析得到两个视频中的动作相似度,可以在不改变算法的前提下,用于多种运动的评分,如太极、瑜伽、健身等。

附图说明

下面结合附图对本发明的具体实施方式作进一步详细的说明。

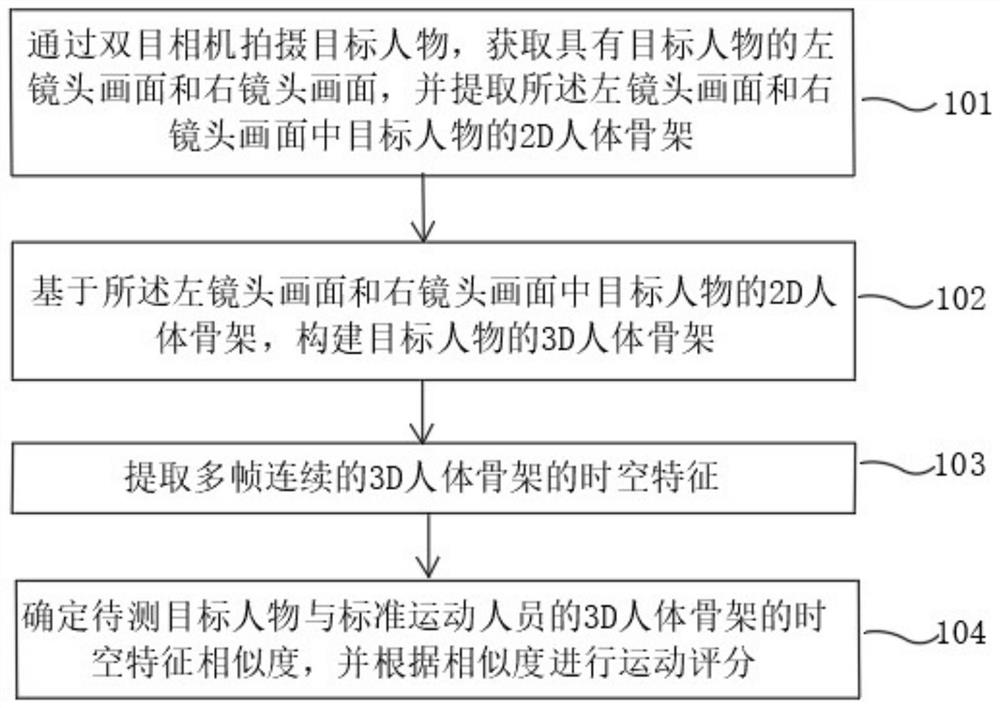

图1是一个实施例中一种基于深度学习3D姿态分析的运动评分方法流程图;

图2是一个实施例中人体关键点的示意图;

图3是一个实施例中双目相机时差原理图;

图4是一个实施例中一种基于深度学习3D姿态分析的运动评分方法中构建目标人物的3D人体骨架的方法流程图;

图5是一个实施例中一种基于深度学习3D姿态分析的运动评分方法中动作相似度评判的方法流程图;

图6是一个实施例中一种基于深度学习3D姿态分析的运动评分装置的原理框图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述。

如图1所示,本实施例提供一种基于深度学习3D姿态分析的运动评分方法,包括如下步骤:

步骤101,通过双目相机拍摄目标人物,获取具有目标人物的左镜头画面和右镜头画面,并提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架。

本实施例中,通过双目相机在前端实时拍摄目标人物,对于双目摄像头的每一帧视频图像都包含了左右相机两个镜头的照片,其左镜头画面和右镜头画面中均具有目标人物。

提取左镜头画面和右镜头画面中目标人物的2D人体骨架,本申请采用cocokeypoint数据集作为训练集,获取coco keypoint数据集图片样本与关键点标注标签,一共标注了人体的18个2D人体关键点,包括鼻子、脖子、右肩、右肘、右手腕、左肩、左肘、左手腕、右臀、右膝盖、右脚踝、左臀、左膝盖、左脚踝、右眼、左眼、右耳朵和左耳朵关键点,如图2所示。

调用预先训练的2D人体关键点检测模型以深度卷积神经网络(CNN)为主干网络,对每一帧下左镜头画面和右镜头画面中的目标人物进行2D人体关键点的提取。

如图3所示是基于双目相机系统的视差原理图,P(x,z)为空间中的物体,CL和CR分别是左右相机的光心,物体分别与左右相机光心会在左右成像平面形成交点,也就是物体的投影点(成像点)PL(XL,f)和PR(XR,f)。b为两个相机光心的间距,也就是基线长。f为相机的焦距,两个相平面的对同一点P的成像位置PL和PR会有坐标上的差异,该差异也就是双目视觉系统中的视差。视差公式的推导如下式所示:

通过上式可知,深度z与视差d成反比。在深度计算过程中,需要用到双目视觉系统的部分参数,如焦距f,基线b等。这些相机参数需要提前进行标定,本实施例中采用的标定方法为张式标定法。对于双目视觉系统,相机标定以后会得到内参和外参,内参包含了相机的焦距和畸变系数等参数,外参包含了左右两个相机相对位姿,对左右两个镜头下的图像进行畸变校正和规范化校正。

步骤102,基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架;

本实施例中,如图4所示,首先是用深度学习算法对左右镜头的画面进行人体姿态评估,得到两个镜头下的任务姿态评估结果,这一步得到的是2D的姿态数据。接了下来对两个镜头下的2D姿态进行匹配,对所述左镜头画面和右镜头画面中目标人物的2D人体骨架进行关键点匹配,获得2D人体骨架关键点对;基于提前标定的相机参数和最小二乘法获得2D人体骨架关键点对对应在空间点坐标;遍历图像中所有匹配成功的2D人体骨架关键点对,得到每对2D人体骨架关键点对对应的空间点坐标,即获得3D人体骨架,这个步骤需要使用离线步骤(提前)标定得到的相机内参和外参以及基础矩阵。

步骤103,提取多帧连续的3D人体骨架的时空特征;

步骤104,确定待测目标人物与标准运动人员的3D人体骨架的时空特征相似度,并根据相似度进行运动评分。

如图5所示,本实施例中,预先通过双目相机系统实时监测标准运动人员演示待测项目的标准动作下的2D人体骨架,并记录到系统内部,根据2D人体骨架建立构建标准运动人员的3D人体骨架,待测项目包括但不限于太极、瑜伽、健身等,对不同时间点下的标准运动员的3D骨架序列进行小波变换得到其对应的标准时空特征。

获取待测目标人物的3D骨架序列并进行小波变换得到其对应的时空特征。时空特征反应了连续多帧3D人体骨架序列的动作变化特征。直接将两组特征序列对比的话,由于两组特征序列的长度不一致,传统的欧几里得距离无法直接计算这两个序列的距离,最简单的对齐方式就是scaling(伸缩)了。把短的序列线性放大到和长序列一样的长度再比较,或者把长的线性缩短到和短序列一样的长度再比较。但是这样的计算没有考虑到待测目标人物的动作在不同情况下的持续时间会产生或长或短的变化,因此识别效果不理想,会导致较大的误差,所以本发明采用动态时间规整对两组特征序列进行相似度(距离)的计算,可以得到很精确的动作相似度评判结果,根据该动作相似度评判结果进行运动评分,在精确度方面远远高于现有的基于2D人体骨架的运动评分系统。

以上所述仅为本发明所公开的一种基于深度学习3D姿态分析的运动评分方法的优选实施方式,并非用于限定本说明书实施例的保护范围。凡在本说明书实施例的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本说明书实施例的保护范围之内。

如图6所示,本实施例中提供一种基于深度学习3D姿态分析的运动评分装置,包括:双目相机201、第一处理单元202、构建单元203、第二处理单元204和对比单元205,其中,

所述双目相机201,用于拍摄目标人物,获取具有目标人物的左镜头画面和右镜头画面,并将左镜头画面和右镜头画面发送至第一处理单元;

所述第一处理单元202,用于接收左镜头画面和右镜头画面,并提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架;

所述构建单元203,用于基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架;

所述第二处理单元204,用于提取多帧3D人体骨架的时空特征;

所述对比单元205,用于对比待测目标人物与标准运动人员的3D人体骨架的时空特征相似度,根据时空特征相似度进行运动评分。

上述实施例阐明的装置或单元,具体可以由计算机芯片或实体实现,或者由具有某种功能的产品来实现。一种典型的实现设备为计算机。具体的,计算机例如可以为个人计算机、膝上型计算机、蜂窝电话、相机电话、智能电话、个人数字助理、媒体播放器、导航设备、电子邮件设备、游戏控制台、平板计算机、可穿戴设备或者这些设备中的任何设备的组合。

本实施例中提供一种计算机可读存储介质,所述计算机可读存储介质中存储有计算机可执行指令,所述计算机可执行指令被处理器执行时实现如下步骤:

通过双目相机拍摄目标人物,获取具有目标人物的左镜头画面和右镜头画面,并提取所述左镜头画面和右镜头画面中目标人物的2D人体骨架;

基于所述左镜头画面和右镜头画面中目标人物的2D人体骨架,构建目标人物的3D人体骨架;

提取多帧连续的3D人体骨架的时空特征;

确定待测目标人物与预存的标准运动人员的3D人体骨架的时空特征相似度,并根据相似度进行运动评分。

计算机可读存储介质包括永久性和非永久性、可移动和非可移动媒体可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(PRAM)、静态随机存取存储器(SRAM)、动态随机存取存储器(DRAM)、其他类型的随机存取存储器(RAM)、只读存储器(ROM)、电可擦除可编程只读存储器(EEPROM)、快闪记忆体或其他内存技术、只读光盘只读存储器(CD-ROM)、数字多功能光盘(DVD)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。按照本文中的界定,计算机可读介质不包括暂存电脑可读媒体(transitory media),如调制的数据信号和载波。

还需要说明的是,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、商品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、商品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个……”限定的要素,并不排除在包括所述要素的过程、方法、商品或者设备中还存在另外的相同要素。

本说明书实施例中的各个实施例均采用递进的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于系统实施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

- 一种基于深度学习3D姿态分析的运动评分方法及装置

- 基于HRNet深度学习的姿态、行为分析模块及分析方法