车辆用控制数据的生成方法、控制装置、系统及学习装置

文献发布时间:2023-06-19 12:16:29

技术领域

本公开涉及车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统以及车辆用学习装置。

背景技术

例如日本特开2016-6327号公报中记载了一种控制装置,该控制装置基于将加速踏板(油门踏板)的操作量通过过滤器进行处理所得到的值来操作节气门。节气门是搭载于车辆的内燃机的操作部的一例。

发明内容

发明所要解决的问题

上述过滤器需要构成为根据加速踏板的操作量将搭载于车辆的内燃机的节气门的操作量设定为适当的操作量。因此,过滤器的设定需要熟练者花费许多工时。如此,以往在与车辆的状态相应的车辆内的电子设备的操作量等的设定中,熟练者花费了许多工时。

用于解决问题的技术方案

以下,对本公开的例子进行记载。

例1.一种车辆用控制数据的生成方法,在存储装置中存储有规定车辆的状态与行动变量的关系的关系规定数据,所述车辆具备旋转电机和内燃机,所述行动变量是与所述车辆内的电子设备的操作有关的变量,所述生成方法包括:使执行装置执行以下处理:取得处理,取得基于传感器的检测值所获得的所述车辆的状态、和确定变量,所述确定变量是确定模式为EV(electric vehicle,电动汽车)模式和HV(hybrid vehicle,混合动力汽车)模式中的哪一方的变量,所述EV模式是仅由所述旋转电机的转矩(torque)生成所述车辆的推力的模式,所述HV模式是所述内燃机的转矩有助于生成所述推力的模式;操作处理,操作所述电子设备;奖励(奖赏)计算处理,基于通过所述取得处理所取得的所述车辆的状态,在所述车辆的特性满足基准的情况下,与所述车辆的特性不满足所述基准的情况相比,给予较大的奖励;以及更新处理,将通过所述取得处理所取得的所述车辆的状态、在所述电子设备的操作中使用了的所述行动变量的值、和与该操作对应的所述奖励作为向预先确定的更新映射的输入,更新所述关系规定数据,所述更新映射是输出以使按照所述关系规定数据来操作所述电子设备的情况下的关于所述奖励的期待收益增加的方式进行了更新的所述关系规定数据的映射,所述奖励计算处理包括以下变更处理:相对于在为所述HV模式且所述车辆的特性为预定特性时给予的所述奖励,变更在为所述EV模式且所述车辆的特性为所述预定特性时给予的奖励。

在上述方法中,通过计算伴随电子设备的操作的奖励,能够掌握通过该操作而获得怎样的奖励。而且,通过基于奖励,根据按照强化学习的更新映射,将关系规定数据更新,从而能够设定车辆的状态与行动变量的适当的关系。因此,能够削减在设定车辆的状态与行动变量的适当的关系时要求熟练者花费的工时。

在EV模式和HV模式下,对车辆的特性的要求可能不同。于是,在上述方法中,通过在EV模式和HV模式下改变给予奖励的方式,能够通过强化学习来学习可获得按各模式所瞄准的特性的关系规定数据。

例2.根据上述例1所述的车辆用控制数据的生成方法,所述奖励计算处理包括以下处理:在能量利用效率高的情况下,与能量利用效率低的情况相比,给予较大的奖励,所述变更处理包括以下处理:变更所述奖励,以使得在所述EV模式的情况下,与所述HV模式的情况相比,在获得更大的奖励方面,提高所述能量利用效率较为有利。

在上述方法中,能够通过强化学习来学习适合于进行在EV模式下提高能量利用效率的控制的关系规定数据,所以能够延长EV模式下的行驶距离。

例3.根据上述例1或者例2所述的车辆用控制数据的生成方法,使所述执行装置执行以下处理:基于通过所述更新处理更新出的所述关系规定数据,将所述车辆的状态与使所述期待收益最大化的所述行动变量的值相关联,从而生成以所述车辆的状态为输入并输出使所述期待收益最大化的所述行动变量的值的控制用映射数据。

在上述方法中,基于通过强化学习而学习过的关系规定数据,生成控制用映射数据。因此,通过将该控制用映射数据安装于控制装置,能够基于车辆的状态和行动变量容易地设定使期待收益最大化的行动变量的值。

例4.一种车辆用控制装置,是具备旋转电机和内燃机的车辆用的控制装置,具备:存储装置,其构成为存储规定所述车辆的状态与行动变量的关系的关系规定数据,所述行动变量是与所述车辆内的电子设备的操作有关的变量;以及执行装置,所述执行装置构成为执行以下处理:取得处理,取得基于传感器的检测值所获得的所述车辆的状态、和确定变量,所述确定变量是确定模式为EV模式和HV模式中的哪一方的变量,所述EV模式是仅由所述旋转电机的转矩生成所述车辆的推力的模式,所述HV模式是所述内燃机的转矩有助于生成所述推力的模式;操作处理,操作所述电子设备;奖励计算处理,基于通过所述取得处理所取得的所述车辆的状态,在所述车辆的特性满足基准的情况下,与所述车辆的特性不满足所述基准的情况相比,给予较大的奖励;以及更新处理,将通过所述取得处理所取得的所述车辆的状态、在所述电子设备的操作中使用了的所述行动变量的值、和与该操作对应的所述奖励作为向预先确定的更新映射的输入,更新所述关系规定数据,所述更新映射是输出以使按照所述关系规定数据来操作所述电子设备的情况下的关于所述奖励的期待收益增加的方式进行了更新的所述关系规定数据的映射,所述奖励计算处理包括以下变更处理:相对于在为所述HV模式且所述车辆的特性为预定特性时给予的所述奖励,变更在为所述EV模式且所述车辆的特性为所述预定特性时给予的奖励,所述操作处理包括以下处理:基于所述关系规定数据,按照与所述车辆的状态相应的行动变量的值,操作所述电子设备。

在上述构成中,基于通过强化学习而学习过的关系规定数据设定行动变量的值,并基于该行动变量的值操作电子设备,从而能够操作电子设备以使期待收益增大。

例5.一种车辆用控制系统,是具备旋转电机和内燃机的车辆用的控制系统,具备:存储装置,其构成为存储规定所述车辆的状态与行动变量的关系的关系规定数据,所述行动变量是与所述车辆内的电子设备的操作有关的变量;以及执行装置,所述执行装置构成为执行以下处理:取得处理,取得基于传感器的检测值所获得的所述车辆的状态、和确定变量,所述确定变量是确定模式为EV模式和HV模式中的哪一方的变量,所述EV模式是仅由所述旋转电机的转矩生成所述车辆的推力的模式,所述HV模式是所述内燃机的转矩有助于生成所述推力的模式;操作处理,操作所述电子设备;奖励计算处理,基于通过所述取得处理所取得的所述车辆的状态,在所述车辆的特性满足基准的情况下,与所述车辆的特性不满足所述基准的情况相比,给予较大的奖励;以及更新处理,将通过所述取得处理所取得的所述车辆的状态、在所述电子设备的操作中使用了的所述行动变量的值、和与该操作对应的所述奖励作为向预先确定的更新映射的输入,更新所述关系规定数据,所述更新映射是输出以使按照所述关系规定数据来操作所述电子设备的情况下的关于所述奖励的期待收益增加的方式进行了更新的所述关系规定数据的映射,所述奖励计算处理包括以下变更处理:相对于在为所述HV模式且所述车辆的特性为预定特性时给予的所述奖励,变更在为所述EV模式且所述车辆的特性为所述预定特性时给予的奖励,所述操作处理包括以下处理:基于所述关系规定数据,按照与所述车辆的状态相应的行动变量的值,操作所述电子设备,所述执行装置包括搭载于所述车辆的第1执行装置和有别于车载装置的第2执行装置,所述第1执行装置具备第1处理电路,所述第1处理电路构成为至少执行所述取得处理和所述操作处理,所述第2执行装置具备第2处理电路,所述第2处理电路构成为至少执行所述更新处理。

在上述构成中,通过第2执行装置执行更新处理,与第1执行装置执行更新处理的情况相比,能够减轻第1执行装置的运算负荷。

此外,第2执行装置是有别于车载装置的装置意味着第2执行装置不是车载装置。

例6.一种车辆用控制装置,具备上述例5所述的车辆用控制系统的第1执行装置。

例7.一种车辆用学习装置,具备上述例5所述的车辆用控制系统的第2执行装置。

附图说明

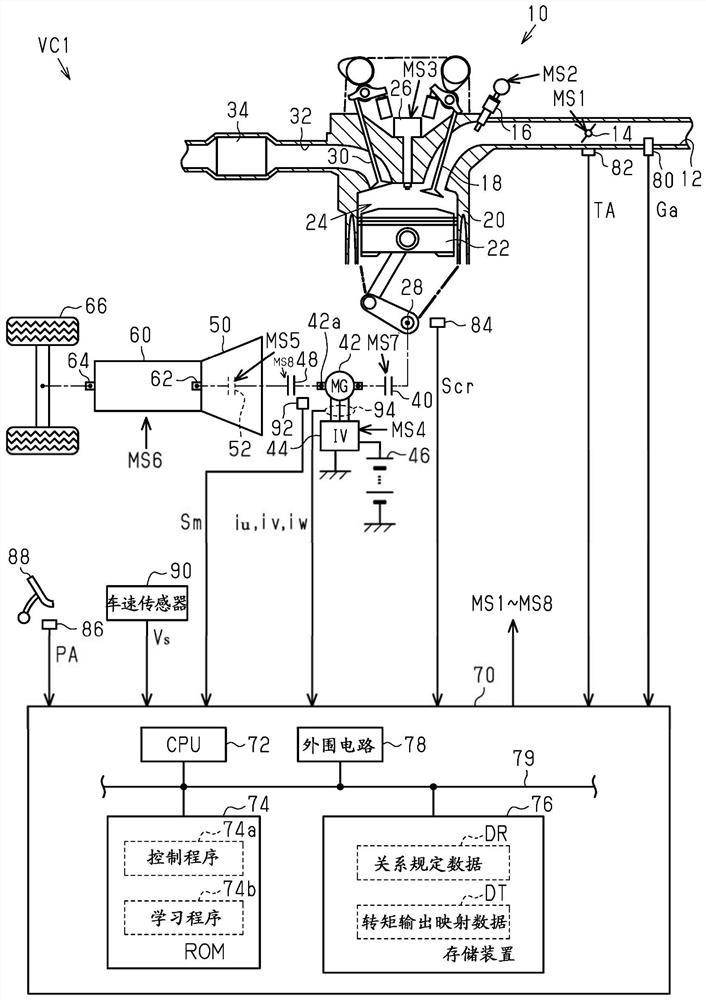

图1是表示第1实施方式涉及的控制装置以及驱动系统的图。

图2是表示图1的控制装置执行的处理的步骤的流程图。

图3是表示第1实施方式涉及的生成映射数据的系统的图。

图4是表示第1实施方式涉及的系统执行的处理的步骤的流程图。

图5是表示第1实施方式涉及的学习处理的详情的流程图。

图6是表示第1实施方式涉及的映射数据的生成处理的步骤的流程图。

图7是表示第2实施方式涉及的控制装置以及驱动系统的图。

图8是表示图7的控制装置执行的处理的步骤的流程图。

图9是表示第3实施方式涉及的系统的构成的图。

图10A是表示第3实施方式涉及的系统执行的处理的步骤的流程图。

图10B是表示第3实施方式涉及的系统执行的处理的步骤的流程图。

具体实施方式

以下,参照附图,对车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统以及车辆用学习装置所涉及的实施方式进行说明。

<第1实施方式>

图1表示本实施方式涉及的车辆VC1的驱动系统以及控制装置的构成。

如图1所示,在内燃机10的进气通路12,从上游侧起依次配置有节气门14以及燃料喷射阀16。被吸入到进气通路12的空气以及从燃料喷射阀16喷射出的燃料随着进气门18的开阀而向由汽缸20和活塞22划分的燃烧室24流入。在燃烧室24内,燃料与空气的混合气伴随着点火装置26的火花放电而供燃烧。通过燃烧产生的能量经由活塞22被转换为曲轴28的旋转能。供燃烧了的混合气随着排气门30的开阀而作为排气(废气)向排气通路32排出。在排气通路32设置有作为净化排气的后处理装置的催化剂34。

电动发电机42的旋转轴42a能够经由离合器40机械地连结于曲轴28。电动发电机42具有多个端子。作为直流电压源的电池46的端子电压经由逆变器44转换为交流电压,并施加于各端子。

变速装置60的输入轴62能够经由离合器48以及具备锁止离合器52的变矩器(转矩变换器)50机械地连结于旋转轴42a。变速装置60是使变速比(传动比、齿轮速比)可变的装置,变速比是输入轴62的转速与输出轴64的转速之比。驱动轮66机械地连结于输出轴64。

控制装置70控制内燃机10。详细而言,控制装置70操作内燃机10的操作部以控制内燃机10的控制量、例如转矩以及排气成分比率等。操作部例如是节气门14、燃料喷射阀16以及点火装置26。控制装置70控制电动发电机42。详细而言,控制装置70操作逆变器44以控制例如电动发电机42的转矩以及转速。控制装置70控制变矩器50。详细而言,控制装置70操作锁止离合器52以控制锁止离合器52的接合状态。另外,控制装置70控制变速装置60。详细而言,控制装置70操作变速装置60以控制变速装置60的控制量、例如变速比。在图1中记载了节气门14、燃料喷射阀16、点火装置26、逆变器44、锁止离合器52、变速装置60、离合器40和离合器48各自的操作信号MS1~MS8。

控制装置70为了进行控制量的控制,例如参照由空气流量计80检测的吸入空气量Ga、由节气门传感器82检测的节气门14的开度(节气门开度TA)以及曲轴角传感器84的输出信号Scr。控制装置70参照由加速器传感器86检测的加速踏板88的踏入量(加速器操作量PA)以及由车速传感器90检测的车速Vs。另外,控制装置70参照检测旋转轴42a的旋转角度的旋转角度传感器92的输出信号Sm以及由电流传感器94检测的流通于电动发电机42的电流iu、iv、iw。

控制装置70执行混合动力汽车(HV)模式和电动汽车(EV)模式。在HV模式下,使离合器40、48为接合状态,将内燃机10的动力传递到驱动轮66,利用内燃机10的转矩生成车辆VC1的推力。在EV模式下,使离合器40为分离状态,仅利用电动发电机42的转矩生成车辆VC1的推力。控制装置70在HV模式下将内燃机10的动力和电动发电机42的动力按照根据相对于车辆VC1的请求动力所预先确定的分配比传递到驱动轮66。

控制装置70具备CPU72、ROM74、存储装置76以及外围电路78,它们能够经由局域网79相互通信。在此,外围电路78包括生成规定内部动作的时钟信号的电路、电源电路以及复位(reset)电路。存储装置76例如是可电改写的非易失性存储器。

在ROM74中存储有控制程序74a。控制程序74a是指示内燃机10在运转时的控制执行的程序。另一方面,在存储装置76中存储有映射数据DM,映射数据DM以当前的变速比GR、车速Vs以及加速器操作量PA为输入变量并以变速比GR的指令值即变速比指令值GR*为输出变量。映射数据DM包括作为EV模式用的映射数据的EV用映射数据DM1和作为HV模式用的映射数据的HV用映射数据DM2。此外,映射数据指的是输入变量的离散的值和与输入变量的值各自对应的输出变量的值的成组数据。

图2表示本实施方式涉及的控制装置70执行的处理的步骤。图2所示的处理通过由CPU72例如以内燃机10处于运转状态为条件并按预定周期反复执行存储于ROM74的控制程序74a来实现。此外,以下利用开头附加有“S”的数字来表示各处理的步骤编号。

在图2所示的一系列处理中,首先,CPU72判定是否为EV模式(S10)。而且,CPU72在判定为是EV模式的情况下(S10:是),选择EV用映射数据DM1(S12),另一方面,在判定为是HV模式的情况下(S10:否),选择HV用映射数据DM2(S14)。

在S12、S14的处理完成时,CPU72取得加速器操作量PA、当前的变速比GR和车速Vs(S16)。而且,CPU72使用EV用映射数据DM1和HV用映射数据DM2中的选择出的一方,对变速比指令值GR*进行映射运算(S18)。在此,映射运算例如设为以下处理即可:在输入变量的值与映射数据的输入变量的值中的某一个一致的情况下,将对应的映射数据的输出变量的值作为运算结果,相对于此,在输入变量的值与映射数据的输入变量的值中的每一个都不一致的情况下,将通过映射数据所包含的多个输出变量的值的内插所获得的值作为运算结果。接着,CPU72对变速装置60输出操作信号MS6来操作变速比(S20)。

在S20的处理完成时,CPU72暂时结束图2所示的一系列处理。

图3表示生成上述映射数据DM的系统。

如图3所示,能够将电动发电机42经由离合器40机械地连结于内燃机10的曲轴28。能够将测力计(dynamometer)100经由离合器48、变矩器50以及变速装置60机械地连结于电动发电机42。由传感器组102检测在使内燃机10以及电动发电机42运转时产生的各种状态变量,并将这些检测结果输入到生成装置110,生成装置110是生成映射数据DM的计算机。此外,传感器组102中包括图1所示的搭载于车辆VC1的一个以上的传感器。

生成装置110具备CPU112、ROM114、存储装置116以及外围电路118,它们能够经由局域网119相互通信。存储装置116例如是可电改写的非易失性存储器。在存储装置116中存储有关系规定数据DR。关系规定数据DR是规定状态变量与行动变量的关系的数据。状态变量是加速器操作量PA、车速Vs以及变速比GR。行动变量是变速比指令值GR*。在ROM114中存储有通过强化学习来学习关系规定数据DR的学习程序114a。

图4表示生成装置110执行的处理的步骤。图4所示的处理通过由CPU112执行存储于ROM114的学习程序114a来实现。

在图4所示的一系列处理中,首先,CPU112设定确定变量VU的值(S30)。接着,CPU112设定(取得)加速器操作量PA、当前的变速比GR、车速Vs和确定变量VU作为状态“s”(S32)。在此,图3所示的系统不具备加速踏板88。因此,加速器操作量PA通过生成装置110模拟车辆VC1的状态而虚拟地生成。虚拟地生成的加速器操作量PA被视为基于传感器的检测值的车辆的状态。CPU112计算车速Vs作为在假设为实际存在车辆的情况下所获得的车辆的行驶速度。该车速被视为基于传感器的检测值的车辆的状态。详细而言,CPU112首先基于旋转角度传感器92的输出信号Sm计算变矩器50的输入轴的转速。之后,CPU112基于该转速和变速比GR计算车速Vs。

然后,CPU112按照关系规定数据DR所确定的策略π,设定由与通过S32的处理取得的状态“s”相应的变速比指令值GR*所规定的行动“a”(S34)。

关系规定数据DR是确定行动价值函数Q以及策略π的数据。详细而言,行动价值函数Q是表(table)形式的函数,表示与状态s及行动a的维度的自变量相应的期待收益的值。另外,策略π确定以下规则:在被给出了状态s时,优先选择自变量成为被给出的状态s的行动价值函数Q中的期待收益的值成为最大的行动a(贪婪行动(greedy action)),并且也以预定的概率选择除此以外的行动a。

详细而言,行动价值函数Q的自变量可取的值的数量例如是根据人的见解而削减了状态s及行动a的可取的值的全部组合中的一部分后的数量。即,例如为了避免变速比GR从2档急剧地变为4档,在当前的变速比GR为2档的情况下,将作为可取的行动a的变速比指令值GR*限制为1档、2档和3档。即,在作为状态s的变速比GR为2档的情况下,没有定义4档以上的行动a。

接着,CPU112基于所设定的变速比指令值GR*,与S20的处理同样地输出操作信号MS6(S36)。接着,CPU112取得旋转轴42a的转速Nm、被输入到变矩器50的转矩Trq、以及请求转矩指令值Trqd*(S38)。请求转矩指令值Trqd*是由加速器操作量PA所请求的向变矩器50的输入转矩的指令值。CPU112基于测力计100生成的负载转矩和变速装置60的变速比,计算转矩Trq。另外,请求转矩指令值Trqd*根据加速器操作量PA及变速比GR来设定。变速比指令值GR*是强化学习的行动变量。因此,变速比指令值GR*不限于使请求转矩指令值Trqd*成为在每次的运行状态下能够由内燃机10和电动发电机42中的至少一方实现的最大转矩以下。另外,请求转矩指令值Trqd*不限于在每次的状态下能够由内燃机10和电动发电机42中的至少一方实现的最大转矩以下的值。

接着,CPU112判定从执行S30的处理的时间点和进行后述的S42的处理的时间点中的较晚一方起是否经过了预定期间(S40)。在此,预定期间设为以下的(a)或者(b)的期间即可。

(a)加速器操作量PA的变化量的绝对值成为第1预定值以上后到成为小于第1预定值的第2预定值以下且经过具有预定长度的时间为止的期间。

(b)到加速器操作量PA的变化量的绝对值成为第1预定值以上为止的期间。

但是,即使在(a)或者(b)的期间的中途,当从EV模式和HV模式中的某一方切换为另一方时,将该时间点作为预定期间的起点或者终点。

而且,CPU112在判定为经过了预定期间的情况下(S40:是),通过强化学习将行动价值函数Q进行更新(S42)。

图5表示S42的处理的详情。

在图5所示的一系列处理中,CPU112取得预定期间内的转速Nm、请求转矩指令值Trqd*以及转矩Trq的包括3个采样值的组的时间序列数据、状态s的时间序列数据、行动a的时间序列数据和确定变量VU(S50)。在图5中,括号中记载的不同的多个数字表示在互不相同的采样时间点获得的变量的值。例如,请求转矩指令值Trqd*(1)和请求转矩指令值Trqd*(2)是在互不相同的采样时间点获得的。另外,将预定期间内的行动a的时间序列数据定义为行动集合Aj,将预定期间内的状态s的时间序列数据定义为状态集合Sj。

接着,CPU112基于转矩Trq以及转速NE的时间序列数据,计算内燃机10以及电动发电机42的效率ηe的时间序列数据和基准效率ηer的时间序列数据(S52)。此外,CPU112基于曲轴角传感器84的输出信号Scr计算转速NE。

详细而言,在电动发电机42的转矩为零的情况下,CPU112基于由转矩Trq(k)和转速NE(k)确定的工作点,计算内燃机10的效率ηe(k)和基准效率ηer。k(1、2、3、……)表示采样正时。效率ηe按内燃机10的每个工作点来定义。效率ηe是在将内燃机10的燃烧室24内的混合气的空燃比设为预定值且将点火正时设为预定正时的情况下产生的燃烧能量中的作为动力取出的能量的比例。另外,基准效率ηer按内燃机10的每个输出来定义。基准效率ηer是对在将内燃机10的燃烧室24内的混合气的空燃比设为预定值且将点火正时设为预定正时的情况下产生的燃烧能量中的作为动力取出的比例的最大值乘以小于“1”的预定系数得到的值。即,基准效率ηer是对在作为动力取出的比例成为最大的工作点的该比例乘以预定系数得到的值。具体而言,例如在ROM114中存储有以内燃机10的转矩及转速NE为输入变量且以效率ηe为输出变量的映射数据的情况下,CPU112通过映射运算求取效率ηe。另外,例如在ROM114中存储有以内燃机10的转矩及转速NE的乘积即输出为输入变量且以基准效率ηer为输出变量的映射数据的情况下,CPU112通过映射运算求取基准效率ηer。

同样地,在离合器40为分离状态的情况下,CPU112基于由转矩Trq(k)和转速NE(k)确定的电动发电机42的工作点,计算效率ηe(k)。效率ηe(k)被作为电动发电机42的输出相对于向逆变器44的输入电力的比例来算出。另外,CPU112计算对应的基准效率ηer。

相对于此,当在HV模式下电动发电机42的转矩大于零的情况下,CPU112基于流通于电动发电机42的电流iu、iv、iw,计算电动发电机42的转矩。再者,CPU112通过从转矩Trq减去计算出的转矩,计算内燃机10的转矩。而且,CPU112基于电动发电机42的转矩和转速,计算效率。效率是电动发电机42的输出相对于向逆变器44的输入电力的比例。然后,CPU112基于内燃机10的转矩和转速计算内燃机10的效率,并将效率ηe作为效率的平均值来算出。另外,CPU112计算对应的基准效率ηer。

接着,CPU112计算从将效率ηe(k)除以基准效率ηer(k)得到的值减去“1”后的值的累计值,并将对该累计值乘以系数K得到的值代入到奖励r(S54)。根据该处理,在效率ηe大于基准效率ηer的情况下,与效率ηe小于基准效率ηer的情况相比,奖励r成为较大的值。

在此,CPU112使系数K根据确定变量VU可变。详细而言,在确定变量VU表示EV模式的情况下,与其表示HV模式的情况相比,将系数K设定为较大的值。该设定是使在EV模式下给予预定奖励时的效率的基准降低的设定。即,获得同一奖励时的效率ηe在EV模式下降低。由此,在EV模式下,当选择了效率ηe高的工作点时,与HV模式相比,奖励r成为较大的值。

接着,CPU112判定预定期间内的任意转矩Trq与请求转矩指令值Trqd*之差的绝对值在规定量ΔTrq以下这一意思的条件(A)是否成立(S56)。

在此,CPU112根据预定期间的开始时的加速器操作量PA的每单位时间的变化量ΔPA和确定变量VU的值,可变地设定规定量ΔTrq。即,CPU112在变化量ΔPA的绝对值大的情况下设为是关于过渡时的情节,与稳态(定常)时的情况相比,将规定量ΔTrq设定为较大的值。另外,CPU112在EV模式的情况下,与HV模式的情况相比,将规定量ΔTrq设定为较大的值。

CPU112在判定为上述差的绝对值在规定量ΔTrq以下的情况下(S56:是),对奖励r加上“K1·n”(S58),另一方面,在判定为上述差的绝对值大于规定量ΔTrq的情况下(S56:否),从奖励r减去“K1·n”(S60)。在此,“n”表示预定期间内的效率ηe的采样数。S56~S60的处理是在满足与加速响应(acceleration response)有关的基准的情况下比不满足的情况下给予较大的奖励的处理。

在S58、S60的处理完成的情况下,CPU112判定是否满足加速器操作量PA在预定期间内的最大值在阈值PAth以上这一意思的条件(B)(S62)。在此,CPU112在EV模式的情况下,与HV模式的情况相比,将阈值PAth设定为较大的值。CPU112在判定为满足条件(B)的情况下(S62:是),从奖励r减去“K2·n”(S64)。即,在加速器操作量PA过大的情况下,用户可能会感觉转矩不够,所以给予负的奖励以施加惩罚。

在S64的处理完成时以及在S62的处理中作出否定判定时,CPU112将图3所示的存储于存储装置76的关系规定数据DR更新。在本实施方式中,使用ε软同策略型蒙特卡洛方法(ε-soft on-policy type Monte Carlo method)。

即,CPU112对由通过上述S50的处理读取到的各状态和与其对应的行动的组所确定的收益R(Sj,Aj)加上奖励r(S66)。在此,“R(Sj,Aj)”是对将状态集合Sj的元素之一作为状态、且将行动集合Aj的元素之一作为行动的收益R进行了总括的记载。接着,对由通过上述S50的处理读取到的各状态和与其对应的行动的组所确定的收益R(Sj,Aj)进行平均化,将平均化了的收益R(Sj,Aj)代入到对应的行动价值函数Q(Sj,Aj)(S68)。在此,平均化作为将通过S66的处理计算出的收益R除以进行了S66的处理的次数的处理即可。此外,收益R的初始值设为零即可。

接着,CPU112对通过上述S50的处理读取到的状态,分别将对应的行动价值函数Q(Sj,A)中的、使行动价值函数Q的值成为最大值的行动代入到行动Aj*(S70)。在此,“A”表示可取的任意的行动。此外,行动Aj*虽然根据通过上述S50的处理读取到的状态的种类而成为不同的值,但在此对记载进行简化,用同一标号进行记载。

接着,CPU112对通过上述S50的处理读取到的状态的每一个,将对应的策略π(Aj|Sj)更新(S72)。即,若将行动的总数设为“|A|”,则将通过S70选择出的行动Aj*的选择概率设为“(1-ε)+ε/|A|”。另外,将行动Aj*以外的“|A|-1”个行动的选择概率分别设为“ε/|A|”。S72的处理基于通过S70的处理而进行了更新的行动价值函数Q进行。因此,规定状态s与行动a的关系的关系规定数据DR以使收益R增加的方式被更新。

此外,在S72的处理完成的情况下,CPU112暂时结束图5所示的一系列处理。

回到图4,在S42的处理完成时,CPU112判定行动价值函数Q是否已收敛(S44)。在此,在通过S44的处理对行动价值函数Q的更新量成为预定值以下的连续次数达到预定次数的情况下判定为收敛即可。CPU112在判定为行动价值函数Q未收敛的情况下(S44:否)或者在S40的处理中作出否定判定的情况下,回到S32的处理。相对于此,CPU112在判定为行动价值函数Q收敛了的情况下(S44:是),判定对于EV模式和HV模式双方是否在S44的处理中作出了肯定判定(S46)。

CPU112在判定为对于EV模式和HV模式中的某一方尚未在S44的处理中作出肯定判定的情况下(S46:否),回到S30的处理,设定确定变量VU。在S46的处理中作出肯定判定的情况下,CPU112暂时结束图4所示的一系列处理。

图6表示生成装置110执行的处理中的特别是基于通过图4的处理学习过的行动价值函数Q来生成映射数据DM的处理的步骤。图6所示的处理通过由CPU112执行存储于ROM114的学习程序114a来实现。

在图6所示的一系列处理中,首先,CPU112设定确定变量VU的值(S80)。然后,CPU112选择由关系规定数据DR所规定的多个状态s中的一个(S82)。接着,CPU112选择与状态s对应的行动价值函数Q(s,A)中的、使行动价值函数Q的值最大的行动a(S84)。在S84中,利用贪婪策略选择行动a。接着,CPU112使状态s与行动a的组存储于存储装置116(S86)。

接着,CPU112判定是否通过S82的处理选择了由关系规定数据DR所规定的状态s的全部值(S88)。而且,CPU112在判定为存在未被选择的值的情况下(S88:否),回到S82的处理。相对于此,CPU112在判定为全部都被选择了的情况下(S88:是),判定是否通过S80的处理设定了可取作确定变量VU的值的全部值(S90)。CPU112在判定为存在尚未设定的值的情况下(S90:否),回到S80的处理,设定该值。

相对于此,CPU112在判定为已设定了全部值的情况下(S90:是),生成EV用映射数据DM1以及HV用映射数据DM2(S92)。在此,在映射数据DM中,将与状态s即输入变量的值对应的输出变量的值设为对应的行动a。

此外,在S92的处理完成的情况下,CPU112暂时结束图6所示的一系列处理。

在此,对本实施方式的作用以及效果进行说明。

在图3所示的系统中,CPU112通过强化学习来学习行动价值函数Q。而且,行动价值函数Q的值收敛意味着学习到了适合于满足关于能量利用效率所要求的基准和关于加速响应所要求的基准的行动。而且,CPU112对于成为映射数据DM的输入变量的状态的每一个,选择使行动价值函数Q最大化的行动,并将状态与行动的组存储于存储装置116。接着,CPU112基于存储于存储装置116的状态与行动的组,生成映射数据DM。由此,无需使熟练者花费的工时过大就能够设定与加速器操作量PA、车速Vs以及变速比GR相应的适当的变速比指令值GR*。

特别是,在本实施方式中,根据是EV模式还是HV模式,学习了与各状态s对应的行动a。详细而言,相比于HV模式,EV模式放宽对于加速响应的基准,另一方面以使效率ηe提高更为有利的方式给予奖励。由此,在EV模式下的关系规定数据DR的学习时,即使使加速响应比较低,也能够满足上述条件(A)以及条件(B)而获得基于S58的处理给予的奖励,并且使效率ηe尽量高有利于增大总的奖励。因此,能够将EV用映射数据DM1设为可进行使能量利用效率增高的控制的数据,进而能够延长EV模式下的行驶距离。

另一方面,在HV模式下的关系规定数据DR的学习时,尽管提高了效率ηe,但通过S54的处理所获得的奖励却减小,所以满足上述条件(A)以及条件(B)而获得基于S58的处理给予的奖励有利于增大总的奖励。因此,根据HV用映射数据DM2,能够进行使对于用户的加速器操作的响应性良好的控制。

根据以上说明的本实施方式,还能获得以下所述的作用以及效果。

(1)在控制装置70具备的存储装置76中存储了映射数据DM,而并非行动价值函数Q。在该情况下,CPU72基于使用映射数据DM的映射运算,设定变速比指令值GR*。由此,与执行选择行动价值函数Q中的成为最大值的函数的处理的情况相比,能够减轻运算负荷。

<第2实施方式>

以下,参照附图,以与第1实施方式的不同之处为中心,对第2实施方式进行说明。

图7表示本实施方式涉及的车辆VC1的驱动系统以及控制装置。此外,在图7中,为方便起见,对与图1所示的部件对应的部件标记同一标号。

如图7所示,在本实施方式中,除了控制程序74a之外,在ROM74中还存储有学习程序74b。另外,存储装置76中没有存储映射数据DM,取而代之地存储有关系规定数据DR,另外还存储有转矩输出映射数据DT。在此,关系规定数据DR是通过图4的处理学习了的已学习过的数据。在关系规定数据DR中,状态s包括加速器操作量PA、确定变量VU、车速Vs以及变速比GR,行动a包括变速比指令值GR*。另外,转矩输出映射由转矩输出映射数据DT规定。转矩输出映射是与以转速NE、填充效率η以及点火正时为输入并输出内燃机10的转矩的例如神经网络的已学习过的模型有关的数据。此外,上述转矩输出映射数据DT例如也可以是在执行图4的处理时将基于通过S38的处理取得的转矩Trq所计算出的内燃机10的转矩作为监督(教师)数据而学习了的数据。此外,填充效率η也可以由CPU72基于转速NE以及吸入空气量Ga来算出。

图8表示本实施方式涉及的控制装置70执行的处理的步骤。图8所示的处理通过由CPU72例如按预定周期反复执行存储于ROM74的控制程序74a以及学习程序74b来实现。此外,在图8中,为方便起见,对与图4所示的处理对应的处理附加同一步骤编号。

在图8所示的一系列处理中,首先,CPU72取得确定变量VU(S30a)。接着,CPU72取得作为状态s的加速器操作量PA、确定变量VU、车速Vs以及变速比GR(S32a),并执行图4的S34~S42的处理。此外,当在S40的处理中作出否定判定的情况下或者完成S42的处理的情况下,CPU72暂时结束图8所示的一系列处理。顺便说一下,S30a、S32a、S34~S40的处理通过由CPU72执行控制程序74a来实现,S42的处理通过由CPU72执行学习程序74b来实现。

如此,根据本实施方式,通过对控制装置70安装关系规定数据DR以及学习程序74b,相比于第1实施方式的情况,能够提高学习频度。

<第3实施方式>

以下,参照附图,以与第2实施方式的不同之处为中心,对第3实施方式进行说明。

在本实施方式中,在车辆VC1之外执行关系规定数据DR的更新。

图9表示在本实施方式中执行强化学习的控制系统的构成。此外,在图9中,为方便起见,对与图1所示的部件对应的部件标记同一标号。

图9所示的车辆VC1内的控制装置70中的ROM74虽然存储有控制程序74a,但没有存储学习程序74b。另外,控制装置70具备通信机77。通信机77是用于经由车辆VC1外部的网络120与数据解析中心130进行通信的设备。

数据解析中心130解析从多个车辆VC1、VC2、……发送的数据。数据解析中心130具备CPU132、ROM134、存储装置136、外围电路138以及通信机137,它们能够通过局域网139相互通信。存储装置136例如是可电改写的非易失性存储器。在ROM134中存储有学习程序134a,在存储装置136中存储有关系规定数据DR。

图10A以及图10B表示本实施方式涉及的强化学习的处理步骤。图10A所示的处理通过图9所示的CPU72执行存储于ROM74的控制程序74a来实现。另外,图10B所示的处理通过由CPU132执行存储于ROM134的学习程序134a来实现。此外,在图10A以及图10B中,为方便起见,对与图8所示的处理对应的处理标记同一步骤编号。以下,按照强化学习的时间序列,说明图10A以及图10B所示的处理。

在图10A所示的一系列处理中,CPU72执行S30a、S32a、S34~S38的处理,并在判定为经过了预定期间的情况下(S40:是),通过操作通信机77,发送进行关系规定数据DR的更新处理所需的数据(S100)。在此,成为发送对象的数据包括预定期间内的确定变量VU的值、转速NE、请求转矩指令值Trqd*、转矩Trq的时间序列数据、状态集合Sj以及行动集合Aj。

相对于此,如图10B所示,CPU132接收被发送的数据(S110),并基于接收到的数据更新关系规定数据DR(S42)。然后,CPU132判定关系规定数据DR的更新次数是否在预定次数以上(S112),在判定为更新次数在预定次数以上的情况下(S112:是),操作通信机137,向发送了通过S110的处理接收到的数据的车辆VC1发送关系规定数据DR(S114)。此外,在完成S114的处理的情况下或者在S112的处理中作出否定判定的情况下,CPU132暂时结束图10B所示的一系列处理。

相对于此,如图10A所示,CPU72判定是否有更新数据(S102),并在判定为有更新数据的情况下(S102:是),接收被更新了的关系规定数据DR(S104)。然后,CPU72将在S34的处理中利用的关系规定数据DR改写成接收到的关系规定数据DR(S106)。此外,在完成S106的处理的情况下或者在S40、S102的处理中作出否定判定的情况下,CPU72暂时结束图10A所示的一系列处理。

如此,根据本实施方式,在车辆VC1的外部进行关系规定数据DR的更新处理。因此,能够减轻控制装置70的运算负荷。再者,例如在S110的处理中接收来自多个车辆VC1、VC2、……的数据后进行S42的处理,则能够容易地增大用于学习的数据数量。

<对应关系>

上述实施方式中的事项与上述“发明内容”栏中记载的事项的对应关系如下。以下,按“发明内容”栏中记载的例子的编号表示了对应关系。

[1、2]例1、2中的“执行装置”在图7中对应于CPU72以及ROM74,在图3中对应于CPU112以及ROM114,在图9中对应于CPU72、132以及ROM74、134。例1、2中的“存储装置”在图7中对应于存储装置76,在图3中对应于存储装置116,在图9中对应于存储装置76、136。“取得处理”对应于图4的S30、S32、S38的处理、或者图8以及图10A的S30a、S32a、S38的处理。“操作处理”对应于S36的处理,“奖励计算处理”对应于S52~S64的处理,“更新处理”对应于S66~S72的处理。“更新映射”对应于由学习程序74b中的执行S66~S72的处理的指令所规定的映射。“变更处理”对应于在S54的处理中使系数K根据确定变量VU可变的处理、在S56的处理中使规定量ΔTrq根据确定变量VU可变的处理、或者在S62的处理中使阈值PAth根据确定变量VU可变的处理。

[3]例3中的“控制用映射数据”对应于映射数据DM。

[4]在例4中,“执行装置”对应于图7中的CPU72以及ROM74,“存储装置”对应于图7中的存储装置76。

[5~7]在例5~例7中,“第1执行装置(第1处理电路)”对应于CPU72以及ROM74,“第2执行装置(第2处理电路)”对应于CPU132以及ROM134。

<其他实施方式>

此外,本实施方式可以如下进行变更来实施。本实施方式以及以下的变更例可以在技术上不矛盾的范围内相互组合来实施。

“关于确定变量”

·作为确定变量,不限于确定模式是EV模式和至少利用内燃机10的转矩生成车辆的推力的HV模式中的哪一方的变量。例如,也可以将HV模式细分为仅由内燃机10的转矩生成车辆的推力的模式、和通过内燃机10的转矩和电动发电机42的转矩的协同工作生成车辆的推力的模式这两个模式,将确定变量设为辨别这两个模式和EV模式的三个模式的变量。

“关于变更处理”

·在S56的处理中,使规定量ΔTrq根据是否为EV模式而可变,但不限于此。例如,也可以根据是否为EV模式,使S58、S60的处理中的系数K1可变。即,例如在EV模式下使系数K1减小,则满足条件(A)并不怎么有利于增大总的奖励,所以易于进行提高效率ηe的学习。

·在S62的处理中,使阈值PAth根据是否为EV模式而可变,但不限于此。例如,也可以根据是否为EV模式,使S64的处理中的系数K2可变。即,例如在EV模式下使系数K2减小,则在S62的处理中作出否定判定并不怎么有利于增大总的奖励,所以易于进行提高效率ηe的学习。

·不限于仅执行如S56、S62的处理那样变更与加速响应有关的基准的处理以及如上述变更例那样根据是否满足与加速响应有关的基准变更奖励的处理中的某一方,例如也可以执行双方。

·例如也可以,在S54的处理中使系数K根据确定变量VU而可变,并且也不执行变更与加速响应有关的基准的处理以及如上述变更例那样根据是否满足与加速响应有关的基准变更奖励的处理的双方。

·在EV模式和HV模式下变更给予奖励的方式的处理的目的不限于优先考虑在EV模式下提高能量利用效率。例如也可以,在EV模式下,将对于加速响应的基准设为比HV模式的情况下高,以强调由与内燃机相比转矩的响应性较高的旋转电机所实现的特有的加速感。

“关于关系规定数据”

·在上述实施方式中,将行动价值函数Q设为了表形式的函数,但不限于此,例如也可以使用函数逼近器。

·例如,也可以取代使用行动价值函数Q,而用以状态s及行动a为自变量并以取行动a的概率为因变量的函数逼近器来表现策略π,根据奖励r,将确定函数逼近器的参数更新。此外,在该情况下,既可以具备分别根据确定变量VU的值而不同的函数逼近器,另外例如也可以使确定变量VU包含于作为单一函数逼近器的自变量的状态s。

“关于操作处理”

·例如在如“关于关系规定数据”一栏中记载的那样,将行动价值函数设为函数逼近器的情况下,通过将成为上述实施方式中的表形式的函数的自变量的关于行动的离散的值的全部与状态s一起输入到行动价值函数Q,确定使行动价值函数Q最大化的行动a即可。在该情况下,例如在操作中主要采用所确定的行动a,并且也以预定的概率选择除此以外的行动即可。

·例如在如“关于关系规定数据”一栏中记载的那样,将策略π设为以状态s及行动a为自变量并以取行动a的概率为因变量的函数逼近器的情况下,基于由策略π表示的概率选择行动a即可。

“关于更新映射”

·在S66~S72中,例示了利用ε软同策略型蒙特卡洛方法的处理,但不限于此,例如也可以采用异策略型(off-policy type)蒙特卡洛方法。再者,也不限于蒙特卡洛方法,例如也可以使用异策略型TD(Temporal-difference,时序分差)法,另外例如也可以使用如SARSA(state-action-reward-state'-action')法的同策略型TD法,另外例如作为同策略型的学习,也可以使用资格迹方法(eligibility trace method)。

·例如在如“关于关系规定数据”一栏中记载的那样,使用函数逼近器表现策略π并基于奖励r直接更新策略π的情况下,例如使用策略梯度法构成更新映射即可。

·也可以取代仅将行动价值函数Q和策略π中的某一方作为基于奖励r的直接的更新对象,而例如如Actor Critic(演员评判家)法那样将行动价值函数Q和策略π双方更新。另外,在Actor Critic法中,例如也可以取代行动价值函数Q而将价值函数V作为更新对象。

“关于行动变量”

·例如也可以,在EV模式下,使行动变量包括电动发电机42的转矩指令值,在HV模式下,使行动变量包括电动发电机42的转矩指令值和内燃机10的转矩指令值。另外,例如也可以使用节气门开度TA的指令值代替内燃机10的转矩指令值作为行动变量。

再者,在节气门开度TA的指令值代替内燃机10的转矩指令值包含于行动变量的情况下,也可以进而还使用与点火正时有关的变量或者与空燃比控制有关的变量作为行动变量。另外例如,在如“关于内燃机”一栏中记载的那样,是压缩着火式的内燃机的情况下,使用与喷射量有关的变量代替与节气门的开度有关的变量即可。另外除此之外,例如也可以使用与喷射正时有关的变量、或者与1个燃烧循环(cycle)中的喷射次数有关的变量、或与1个燃烧循环内的用于一个汽缸的在时间序列上相邻的两个燃料喷射中的一方的结束定时与另一方的开始定时之间的时间间隔有关的变量。

·在如下述“关于电子设备”一栏中记载的那样,使与行动变量相应的操作的对象包括锁止离合器52的情况下,使行动变量包括表示锁止离合器52的接合状态的变量即可。在此,在使行动变量包括锁止离合器52的接合状态的情况下,根据要提高能量利用效率之意的请求事项的优先级的高低,改变作为行动变量的值的锁止离合器52的接合状态特别有效。

·在如下述“关于电子设备”一栏中记载的那样,使成为与行动变量相应的操作的对象的电子设备包括车载空调装置的情况下,使行动变量包括压缩机的负载转矩或者空调装置的功耗即可。

“关于状态”

·也可以使状态包括电池46的充电率或者温度。另外例如在如“关于行动变量”一栏中记载的那样,使行动包括压缩机的负载转矩或者空调装置的功耗的情况下,也可以使状态包括车室内的温度。

“关于奖励计算处理”

·作为在能量利用效率高的情况下比能量利用效率低的情况下给予较大的奖励的处理,不限于取成为基准的效率和实际的工作点处的效率之比与“1”之差的处理,例如,也可以是取成为基准的效率与实际的工作点处的效率之差的处理。

·例如也可以取代在满足条件(A)的情况下一律给予相同的奖励,而设为在转矩Trq与请求转矩指令值Trqd*之差的绝对值小的情况下比该绝对值大的情况下给予较大的奖励的处理。另外例如,也可以取代在不满足条件(A)的情况下一律给予相同的奖励,而设为在转矩Trq与请求转矩指令值Trqd*之差的绝对值大的情况下比该绝对值小的情况下给予较小的奖励的处理。

·作为在满足与加速响应有关的基准的情况下比不满足该基准的情况下给予较大的奖励的处理,不限于根据是否满足条件(A)而给予奖励的处理以及根据是否满足条件(B)而给予奖励的处理。例如,也可以设为除了条件(A)之外还根据车辆的前后加速度是否在预定范围内而给予奖励的处理。

·不限于由在满足与加速响应有关的基准的情况下比不满足该基准的情况下给予较大的奖励的处理以及在能量利用效率满足基准的情况下比能量利用效率不满足基准的情况下给予较大的奖励的处理构成奖励计算处理。例如,也可以由在满足与加速响应有关的基准的情况下比不满足该基准的情况下给予较大的奖励的处理以及在车室内的状态满足基准的情况下比车室内的状态不满足基准的情况下给予较大的奖励的处理构成奖励计算处理。在此,作为在车室内的状态满足基准的情况下比车室内的状态不满足基准的情况下给予较大的奖励的处理,例如也可以是在车辆的振动强度小于等于预定值的情况下比车辆的振动强度超过预定值的情况下给予较大的奖励等、在车辆的振动强度小的情况下比车辆的振动强度大的情况下给予较大的奖励的处理。另外,例如也可以是在车辆的噪音强度小于等于预定值的情况下比车辆的噪音强度超过预定值的情况下给予较大的奖励等、在车辆的噪音强度小的情况下比车辆的噪音强度大的情况下给予较大的奖励的处理。

·也可以包括:在电池的充电率在预定范围内的情况下比该充电率不在预定范围内的情况下给予较大的奖励的处理,或者在电池的温度在预定范围内的情况下比该温度不在预定范围内的情况下给予较大的奖励的处理。

·例如在如“关于行动变量”一栏中记载的那样,行动变量包括压缩机的负载转矩或者空调装置的功耗的情况下,也可以加上在车室内的温度在预定范围内的情况下比车室内的温度不在预定范围内的情况下给予较大的奖励的处理。该处理是在车室内的状态满足基准的情况下比车室内的状态不满足基准的情况下给予较大的奖励的处理,详细而言是在车室内的舒适度高的情况下比车室内的舒适度低的情况下给予较大的奖励的处理。

“关于车辆用控制数据的生成方法”

·在图4的S34的处理中,基于行动价值函数Q决定了行动,但不限于此,也可以按等概率选择可取的所有的行动。

“关于控制用映射数据”

·作为通过将车辆的状态与使期待收益最大化的行动变量的值一对一地关联而以车辆的状态为输入并输出使期待收益最大化的行动变量的值的控制用映射数据,不限于映射数据,例如也可以是函数逼近器。这例如能够通过如下来实现:如在上述“关于更新映射”一栏中记载的那样,例如在使用策略梯度法的情况下,用表示可取行动变量的值的概率的高斯分布来表现策略π,用函数逼近器表现其平均值,将表现平均值的函数逼近器的参数更新,并将学习后的平均值作为控制用映射数据。即,在此将函数逼近器输出的平均值视作使期待收益最大化的行动变量的值。此时,虽然也可以按确定变量VU的每个值设置不同的函数逼近器,但也可以使单一函数逼近器的自变量中的状态s包括确定变量VU。

“关于电子设备”

·作为成为与行动变量相应的操作的对象的驱动系统所涉及的装置,不限于变速装置60,例如也可以是内燃机10的操作部。在此,作为内燃机10的操作部,例如可以选择节气门。不过,也不限于节气门14,例如也可以是点火装置26或者燃料喷射阀16。另外,作为成为与行动变量相应的操作的对象的驱动系统装置,例如也可以是锁止离合器52。

·作为成为与行动变量相应的操作的对象的电子设备,不限于车载驱动系统的电子设备,例如也可以包括车载空调装置。即使在该情况下,例如在车载空调装置由推力生成装置的旋转动力驱动时,推力生成装置的动力中的供给到驱动轮的动力取决于车载空调装置的负载转矩,所以,使行动变量包括车载空调装置的负载转矩等也是有效的。

“关于车辆用控制系统”

·在图10B所示的例子中,由数据解析中心130执行了S42的全部处理,但不限于此。例如也可以,在数据解析中心130中,执行S66~S72的处理,但是不执行作为奖励的计算处理的S52~S64的处理,而在S100的处理中发送奖励的计算结果。

·在图10A所示的例子中,在车辆侧执行了基于策略π决定行动的处理(S34的处理),但不限于此。例如也可以,从车辆VC1发送通过S32a的处理所取得的数据,由数据解析中心130使用发送来的数据决定行动a,并将决定的行动发送给车辆VC1。

·作为车辆用控制系统,不限于由控制装置70以及数据解析中心130构成的系统,例如也可以使用用户的便携终端代替数据解析中心130。另外,也可以由控制装置70以及数据解析中心130和便携终端构成车辆用控制系统。这例如能够通过由便携终端执行S34的处理来实现。

“关于执行装置”

·作为执行装置,不限于具备CPU72(112、132)和ROM74(114、134)并执行软件处理的装置。例如,也可以具备对在上述实施方式中被执行的软件处理的至少一部分进行处理的硬件电路、例如ASIC。即,执行装置是以下的(a)~(c)中的某个构成即可。(a)具备按照程序执行上述处理的全部的处理装置、和存储程序的ROM等程序存储装置。(b)具备按照程序执行上述处理的一部分的处理装置以及程序存储装置、和执行其余处理的专用硬件电路。(c)具备执行上述处理的全部的专用硬件电路。在此,具备处理装置以及程序存储装置的软件执行装置或者专用硬件电路也可以为多个。即,上述处理由具备一个或多个软件处理电路以及一个或多个专用硬件电路中的至少一方的处理电路(processing circuitry)执行即可。

“关于存储装置”

·将存储关系规定数据DR的存储装置与存储学习程序74b、114a和控制程序74a的存储装置(ROM74、114、134)设为了有别的存储装置,但不限于此。

“关于混合动力车辆”

·作为混合动力车辆,不限于并联混合动力车,例如也可以是混联式混合动力车。

“关于内燃机”

·内燃机具备的燃料喷射阀不限于是向进气通路12喷射燃料的进气口喷射阀,也可以是直接向燃烧室24喷射燃料的缸内喷射阀。或者,内燃机也可以具备进气口喷射阀和缸内喷射阀双方。

·作为内燃机,不限于火花点火式内燃机,例如也可以是使用轻油等作为燃料的压缩着火式内燃机等。

- 车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统以及车辆用学习装置

- 车辆用控制数据的生成方法、车辆用控制装置、车辆用控制系统以及车辆用学习装置