一种基于光场成像的点云地图获取方法

文献发布时间:2023-06-19 09:44:49

技术领域

本发明属于图像处理技术领域,具体涉及一种点云地图获取方法。

背景技术

在全球卫星系统失效或者导航精度不足的情况下,常常使用信息量大且准确、协同干扰小及实时性强的视觉导航作为传统导航的辅助系统。利用视觉信息进行自主导航是无人机智能化的重要标志,在完全未知的环境中,通过图像传感器来构建所处环境的地图实现自主飞行的SLAM(即时定位与地图构建)技术逐渐变成目前的主流定位技术。准确的地图模型建立是无人机实现自主飞行的基础,现有环境地图主要分为几何地图、栅格地图和点云地图三类,其中点云地图由于对环境的显示和描述较为直观、易于生成及与其他地图转换方便等优点成为视觉SLAM中较为常用的地图形式。视觉SLAM按照视觉传感器的类别分成单目SLAM、双目SLAM和RGBD-SLAM三类,其中RGBD-SLAM同时生成的RGB图像和深度图像经过相机标定后便可以获得三维点云数据。而现有的RGB-D相机体积较大,难以满足无人机在自主飞行时对轻量的要求,且RGB-D相机在获取图像时会产生桶形失真,增加后续处理的步骤。

光场成像的原理是在传统相机的主透镜和传感器平面之间加入微透镜阵列,该阵列使得通过主透镜的光线发生二次折射,在记录二维空间信息的基础上添加了二维角度信息。四维数据使光场相机具有重聚焦功能、且在获得RGB图像的基础上,可以根据重聚焦特性来获取深度图像。深度图像和RGB图像的结合可以获取拍摄场景的点云数据。

发明内容

为了克服现有技术的不足,本发明提供了一种基于光场成像的点云地图获取方法,首先根据canny算子和角度区域划分对原始图像的边缘进行提取并获取初步深度图像,再利用遮挡线索提取和马尔科夫优化的方式来优化深度图像使图像中深度的表示更为清晰;然后利用原始图像、深度图像及点云图像之间的转换关系生成点云图像;最后生成多幅点云图像,利用ICP算法对点云图像进行拼接。本发明可以满足无人机在进行自主飞行时对轻量的要求,且光场相机的微透镜阵列不同于传统的RGB-D相机,拍摄出来的场景不会产生桶形失真,能够简化后续的图像处理步骤,使无人机在自主飞行时的快速性得到满足。

本发明解决其技术问题所采用的技术方案包括以下步骤:

步骤1:采用canny算子对光场相机拍摄图像进行边缘提取;设置重聚焦系数,对光场相机拍摄图像进行重聚焦;将边缘提取得到的图像和重聚焦得到的图像融合获得初步深度图像;

步骤2:采用基于梯度、方差、均值三种评价指标的遮挡线索方法对步骤1中提取的边缘进行增强;

步骤3:利用马尔科夫随机场,构建基于像素值和遮挡线索值的能量函数,见下式:

其中|Z

遍历所有像素点,对初始深度图像进行平滑,使能量函数最小,得到优化深度图像;

步骤4:将光场相机拍摄图像与优化深度图像进行融合得到多幅点云图像,利用ICP算法对多幅点云图像进行拼接生成点云地图。

有益效果:

由于采用了本发明提出的一种基于光场成像的点云地图获取方法,可以满足无人机在进行自主飞行时对轻量的要求,且光场相机的微透镜阵列不同于传统的RGB-D相机,拍摄出来的场景不会产生桶形失真,能够简化后续的图像处理步骤,使无人机在自主飞行时的快速性得到满足。

附图说明

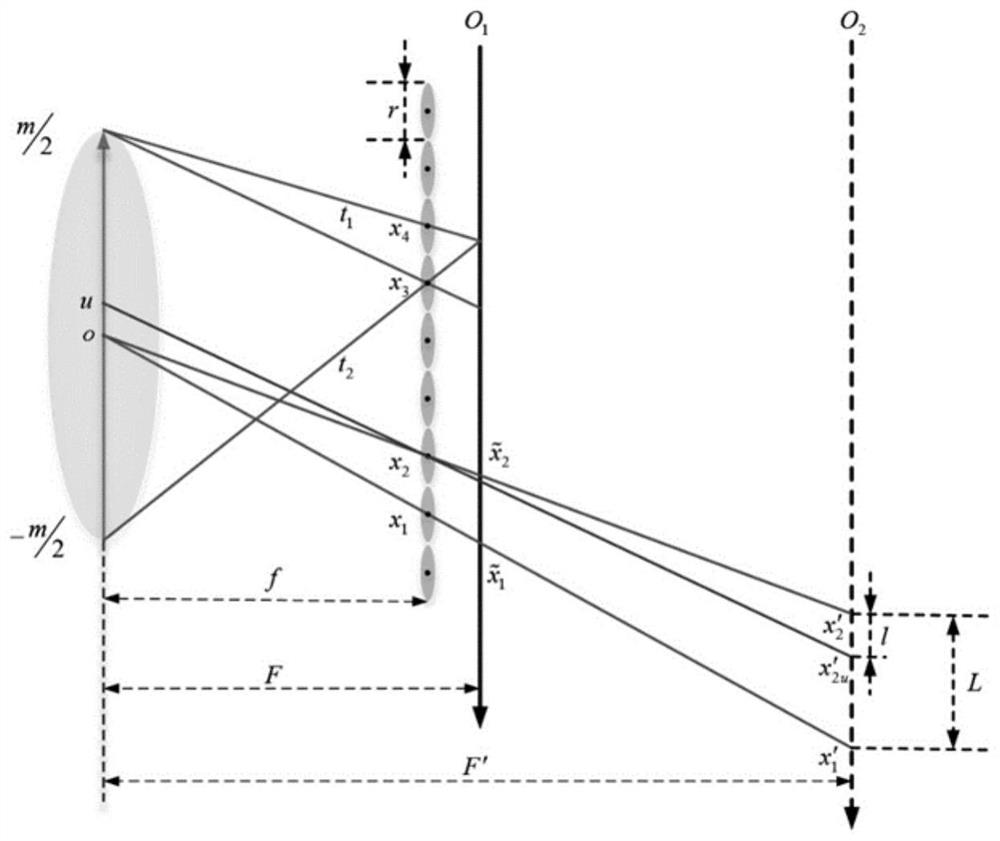

图1为本发明中构建的重聚焦模型示意图。

图2为本发明实施例中通过canny算子和角度区域分割得到的初步深度图像。

图3为本发明实施例中通过遮挡线索提取和马尔科夫的奥的优化深度图像。

图4为本发明实施例光场相机拍摄图像。

图5为本发明实施例最终获得的点云图像。

具体实施方式

下面结合附图和实施例对本发明进一步说明。

一种基于光场成像的点云地图获取方法,包括如下步骤:

步骤1:采用canny算子对光场相机拍摄图像进行边缘提取;设置重聚焦系数,对光场相机拍摄图像进行重聚焦;将边缘提取得到的图像和重聚焦得到的图像融合获得初步深度图像;

步骤2:采用基于梯度、方差、均值三种评价指标的遮挡线索方法对步骤1中提取的边缘进行增强;

步骤3:利用马尔科夫随机场,构建基于像素值和遮挡线索值的能量函数,见下式:

其中|Z

遍历所有像素点,对初始深度图像进行平滑,使能量函数最小,得到优化深度图像;

步骤4:将光场相机拍摄图像与优化深度图像进行融合得到多幅点云图像,利用ICP算法对多幅点云图像进行拼接生成点云地图。

具体实施例:

本发明目的在于为无人机在自主飞行时同一种生成点云地图的新思路,传统RGB-D相机相对于无人机来说体积及重量较大,而本发明基于光场成像的原理,仅在主透镜和传感器之间增加微透镜阵列,从一定程度上可以更好地满足自主飞行中无人机对轻量的要求。

本发明的思路是利用主透镜、微透镜阵列、传感器平面及成像平面之间的三角关系搭建重聚焦模型并基于此推出重聚焦公式以及重聚焦系数

具体过程如下:

1、如图1所示,光场相机图像用4D的光场信息L(x,y,u,v)来表征,其中(u,v)为二维角度信息、(x,y)为二维空间信息。在构建重聚焦模型时为了简化主透镜、传感器、微透镜阵列、成像平面和光线之间的线面三角关系将L(x,y,u,v)压缩成2D的形式L(x,u),如图1所示,根据成像平面和光线之间的三角相似关系可以得出在仅用二维数据来表征光场信息的情况下,光场相机传感器平面上的成像点和重聚焦平面上的成像点之间的位置关系,如式(1)所示:

其中,

将2D的光场信息扩展成4D,则扩展后的重聚焦公式如(2)所示:

其中,(x′,y′)为扩展后的二维空间信息,L

将光场的所有角度信息经过相加后得到(3)式即为光场的重聚焦公式:

通过(3)式可得将4D光场信息中所有角度像素对应的空间像素求和,则可获得在重聚焦平面上每点的像素值,即重聚焦后的二维图像。由此可知,通过改变聚焦系数α可以使不同目标物体达到其正确聚焦深度。

由(3)式可知重聚焦后各个点的像素值可以根据该点的角度信息求和得到,遍历所有像素点后即可得到重聚焦后的二维图像,即重聚焦系数可以改变聚焦深度。光线聚焦至像素点的正确深度时,该位置在图像中最为清晰,且满足以下关系:

其中,object表示物体和相机之间的相对距离,image表示成像距离,f为重聚焦模型中主透镜与微透镜阵的焦距,由重聚焦系数和式(4)的关系可知,聚焦系数α和object之间的关系成负相关,即用聚焦系数组成的灰度图像可看作是深度图像。

2、遍历所有像素点,提取每个像素点的所有角度信息组成角度区域并截取原图中同样大小的空间区域作为对照,根据两图像的梯度划分边缘的角度,若两图像角度一致则表示该区域没有遮挡物,即实现了深度同一,反之则存在遮挡。根据角度区域划分的结果及canny算子边缘提取的结果来进行深度估计。利用方差的大小来表示像素点之间差异的大小,没被遮挡的区域由于像素变化较为平缓方差也相应的较小,方差计算如式(5):

其中

利用聚焦的发散程度同样可以作为判断区域是否存在遮挡的依据,建立散焦响应:

将方差和散焦响应相加结合构成新的评价指标:

当评价指标达到最小时意味着该像素点聚焦至正确深度。

3、使用梯度作为描述图像边缘的参考线索,对已初步获取的深度图像求梯度,并为了保证整体差异性不要过大导致其余遮挡线索值过小而被忽略,将梯度值与该点的像素值相除获得第一个遮挡线索值:

式中,

由于未被遮挡的区域像素变化平缓所得方差值较小,而有遮挡的区域相反,所以将区域间的方差值作为第二个遮挡线索值:

同理,可将区域间的均值作为第三个遮挡线索值:

将三个遮挡线索值归一化如式(11)所示,并设定阈值为0.1来将图像的边缘更为清晰的提取出来。

W(x,y)=N(W

将归一化的遮挡线索值W(x,y)和初始深度图像一起利用马尔科夫随机场进行平滑优化,其实质是利用聚类的思想,基于图像中各个像素点属于不同类别的概率进行分类:

其中,U为像素点集合,V为分类结果,由于在优化之前并不知道类别的数量,则构造概率密度函数:

P(V)=z

其中E(V)为根据初始深度图像构建能量函数:

其中|Z

遍历所有像素点,对初始深度图像进行平滑,使能量函数E最小,得到优化深度图像;

将光场相机拍摄图像与优化深度图像进行融合得到多幅点云图像,利用ICP算法对多幅点云图像进行拼接生成点云地图。

- 一种基于光场成像的点云地图获取方法

- 一种基于点云地图的图像边界获取方法、设备及飞行器