信息处理装置、信息处理方法、程序、移动体控制装置和移动体

文献发布时间:2023-06-19 11:55:48

技术领域

本技术涉及信息处理装置、信息处理方法、程序、移动体控制装置和移动体,并且具体而言,涉及适合用于追踪对象物的信息处理装置、信息处理方法、程序、移动体控制装置和移动体。

背景技术

过去,已经提出了使用毫米波雷达和图像传感器来监视车辆的周围,并且提高检测关于融合区域中的物体的信息的精度,该融合区域是毫米波雷达所覆盖的区域和图像传感器所覆盖的区域重叠的区域(例如,参考专利文献1)。

引文列表

专利文献

专利文献1:日本专利申请公开号2009-31299

发明内容

技术问题

但是,专利文献1公开了融合区域是固定的,这未必是合适的。例如,即使不存在障碍物,在融合区域中检测信息的精度也总是被设置得很高。这可能导致不必要的高处理负荷。

本技术是鉴于上述情况而作出的,并且使得可以适当地设置检测物体的精度。

问题的解决方案

根据本技术的第一方面的信息处理装置包括第一物体检测器,其基于来自第一传感器的第一传感器数据执行物体检测;第二物体检测器,其基于来自类型不同于第一传感器的第二传感器的第二传感器数据执行物体检测;追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

根据本技术的第一方面的信息处理方法由信息处理装置执行,所述信息处理方法包括:基于来自第一传感器的第一传感器数据执行物体检测;基于来自类型不同于第一传感器的第二传感器数据执行物体检测;根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

一种程序基于来自第一传感器的第一传感器数据执行物体检测;基于来自类型不同于第一传感器的第二传感器数据执行物体检测;根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

根据本技术的第二方面的移动体控制装置包括第一物体检测器,其基于来自第一传感器的第一传感器数据,执行关于移动体周围的物体检测;第二物体检测器,其基于来自类型不同于第一传感器的第二传感器的第二传感器数据,执行关于移动体周围的物体检测;追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;以及检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及移动控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

根据本技术的第三方面的移动体包括:第一传感器;第二传感器,其类型不同于第一传感器;第一物体检测器,其基于来自第一传感器的第一传感器数据执行物体检测;第二物体检测器,其基于来自第二传感器的第二传感器数据执行物体检测;追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;以及检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及移动控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

在本技术的第一方面中,基于来自第一传感器的第一传感器数据执行物体检测;基于来自类型不同于第一传感器的第二传感器数据执行物体检测;根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

在本技术的第二方面中,基于来自第一传感器的第一传感器数据,执行关于移动体周围的物体检测;基于来自类型不同于第一传感器的第二传感器的第二传感器数据,执行关于移动体周围的物体检测;根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及基于根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

在本技术的第三方面中,基于来自第一传感器的第一传感器数据执行物体检测;基于来自第二传感器的第二传感器数据执行物体检测;根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

附图说明

图1是示出了应用本技术的车辆控制系统的配置的示例的框图。

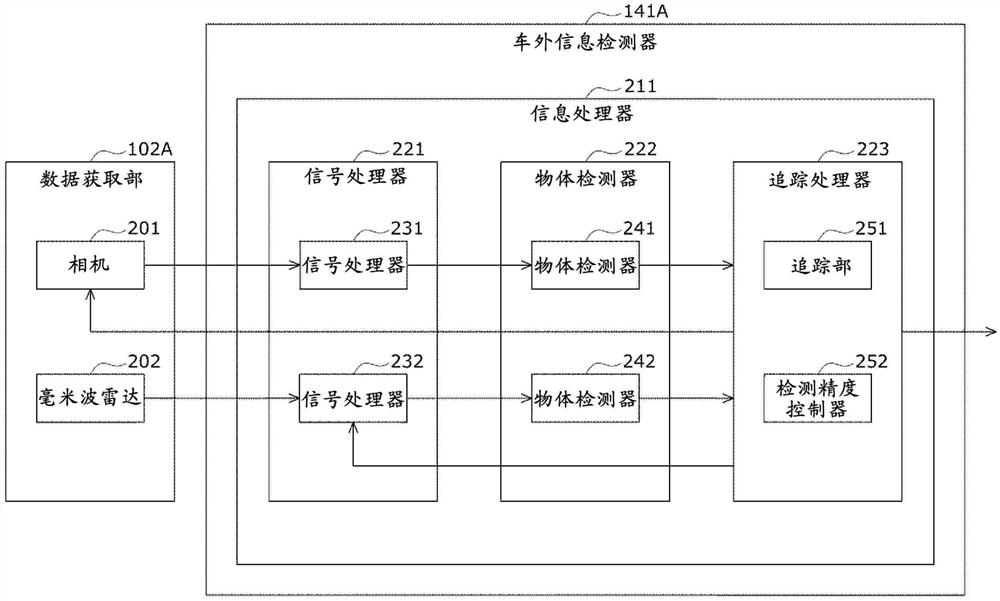

图2是示出数据获取部的第一实施例和车外信息检测器的第一实施例的框图。

图3是示出相机的配置的示例的框图。

图4是用于描述对象物追踪处理的流程图。

图5是用于描述基于捕获图像执行的物体检测处理的细节的流程图。

图6是用于描述基于毫米波数据执行的物体检测处理的细节的流程图。

图7是示出数据获取部的第二实施例和车外信息检测器的第二实施例的框图。

图8示出了计算机的配置的示例。

具体实施方式

以下描述用于执行本技术的实施例。按照以下顺序进行描述。

1.第一实施例(使用相机和毫米波雷达的示例)

2.第二实施例(添加LiDAR的示例)

3.修改

4.其他

<1.第一实施例>

首先,参考图1至图6描述本技术的第一实施例。

图1是示出作为本技术可应用的移动体控制系统的示例的车辆控制系统100的示意性功能配置的示例的框图。

注意,当要将设置有车辆控制系统100的车辆10与其他车辆区分开时,设置有车辆控制系统100的车辆在下文中将被称为本车或本车辆。

车辆控制系统100包括输入部101、数据获取部102、通信部103、车内装备104、输出控制器105、输出部106、传动系控制器107、传动系系统108、车身相关控制器109、车身相关系统110、存储器111和自动驾驶控制器112。输入部101、数据获取部102、通信部103、输出控制器105、传动系控制器107、车身相关控制器109、存储器111和自动驾驶控制器112通过通信网络121彼此连接。例如,通信网络121包括总线或符合诸如控制器局域网(CAN)、局域互联网络(LIN)、局域网(LAN)或FlexRay(注册商标)的任何标准的车载通信网络。注意,车辆控制系统100的各个结构元件可以直接彼此连接,而不使用通信网络121。

注意,当车辆控制系统100的各个结构元件通过通信网络121彼此通信时,以下将省略对通信网络121的描述。例如,当输入部101和自动驾驶控制器112通过通信网络121彼此通信时,将简单地陈述输入部101和自动驾驶控制器112彼此通信。

输入部101包括由车载人员用来输入各种数据、指令等的装置。例如,输入部101包括诸如触摸面板、按钮、麦克风、开关和控制杆的操作设备;可以用来通过除了手动操作之外的方法(诸如声音或手势)执行输入的操作设备;等等。或者,例如,输入部101可以是诸如使用红外线或其他无线电波的远程控制装置的外部连接装备,或者与车辆控制系统100的操作兼容的移动装备或可穿戴装备。输入部101基于由车载人员输入的数据、指令等产生输入信号,并将所产生的输入信号提供给车辆控制系统100的各个结构元件。

数据获取部102包括用于获取用于由车辆控制系统100执行的处理的数据的各种传感器等,并且将所获取的数据提供给车辆控制系统100的各个结构元件。

例如,数据获取部102包括用于检测例如本车的状态的各种传感器。具体而言,例如,数据获取部102包括陀螺仪;加速度传感器;惯性测量单元(IMU);以及传感器等,用于检测加速器踏板的操作量、制动器踏板的操作量、方向盘的转向角、引擎的转数、马达的转数、车轮转速等。

此外,例如,数据获取部102包括用于检测关于本车的外部的信息的各种传感器。具体而言,例如,数据获取部102包括图像捕获装置,诸如飞行时间(ToF)相机、立体相机、单目相机、红外相机和其他相机。此外,例如,数据获取部102包括用于检测天气、气象现象等的环境传感器,以及用于检测本车周围的物体的周围信息检测传感器。例如,环境传感器包括雨滴传感器、雾传感器、阳光传感器、雪传感器等。周围信息检测传感器包括超声波传感器、雷达、LiDAR(光检测和测距、激光成像检测和测距)、声纳等。

此外,例如,数据获取部102包括用于检测本车的当前位置的各种传感器。具体而言,例如,数据获取部102包括例如从GNSS卫星接收GNSS信号的全球导航卫星系统(GNSS)接收器。

此外,例如,数据获取部102包括用于检测关于车辆内部的信息的各种传感器。具体而言,例如,数据获取部102包括捕获驾驶员的图像的图像捕获装置、检测驾驶员的生物信息的生物传感器、收集车辆内部的声音的麦克风等。例如,生物传感器被设置在座椅表面,方向盘等上,并且检测坐在座椅上的车载人员或握住方向盘的驾驶员的生物信息。

通信部103与车载装备104以及各种车辆外部装备、服务器、基站等进行通信,发送由车辆控制系统的各个结构元件提供的数据并将所接收的数据提供给车辆控制系统100的各个结构元件。注意,通信部103所支持的通信协议不受特别限制。通信部103也可以支持多种类型的通信协议。

例如,通信部103使用无线LAN、蓝牙(注册商标)、近场通信(NFC)、无线USB(WUSB)等与车载装备104进行无线通信。此外,例如,通信部103通过连接端子(未显示)(如有必要,还可以使用线缆)使用通用串行总线(USB)、高清多媒体接口(HDMI)(注册商标)、移动高清链路(MHL)等与车载设备104有线通信。

此外,例如,通信部103通过基站或接入点与位于外部网络(例如,因特网、云网络或运营商专用网络)中的装备(例如,应用服务器或控制服务器)进行通信。此外,例如,通信部103使用对等网络(P2P)技术与位于本车附近的终端(例如,行人或商店的终端或机器类型的通信(MTC)终端)进行通信。此外,例如,通信部103执行诸如车辆与车辆间通信、车辆与基础设施间通信、本车与家庭之间的车辆与家庭间通信以及车辆与行人间通信的V2X通信。此外,例如,通信部103包括信标接收器,接收从例如安装在道路上的无线电台发射的无线电波或电磁波,并且获取关于例如当前位置、交通堵塞、交通管制或必要时间的信息。

车内装备104的示例包括车载人员的移动装备或可穿戴装备、带入或附接到本车的信息装备、以及搜索到任何目的地的路线的导航装置。

输出控制器105控制向本车辆的车载人员或向本车辆的外部输出各种信息。例如,输出控制器105生成包括视觉信息(诸如图像数据)或音频信息(诸如声音数据)中的至少一个的输出信号,将输出信号提供给输出部106,并且由此控制从输出部106的视觉信息和音频信息的输出。具体而言,例如,输出控制器105组合由数据获取部102的不同图像捕获装置捕获的图像的数据,生成鸟瞰图像、全景图像等,并且将包括所生成的图像的输出信号提供给输出部106。此外,例如,输出控制器105生成包括例如警告诸如碰撞、接触或进入危险区域的危险的警告蜂鸣声或警告消息的声音数据,并且将包括所生成的声音数据的输出信号提供给输出部106。

输出部106包括能够向本车辆的车载人员或向本车辆的外部输出视觉信息或音频信息的装置。例如,输出部106包括显示装置、仪表板、音频扬声器、耳机、用于佩戴在车载人员上的诸如眼镜型显示器的可穿戴设备、投影仪、灯等。代替包括通常使用的显示器的装置,输出部106中包括的显示装置可以是诸如平视显示器、透明显示器的装置,或者包括增强现实(AR)显示功能的装置,其在驾驶员的视野中显示视觉信息。

传动系控制器107产生各种控制信号,将它们提供给传动系系统108,从而控制传动系系统108。此外,传动系控制器107根据需要将控制信号提供给除了传动系系统108之外的结构元件,以例如将控制传动系系统108的状态通知给它们。

传动系系统108包括与本车的传动系相关的各种装置。例如,传动系系统108包括产生驱动力的驱动力产生装置(诸如内燃机和驱动马达),用于将驱动力传递到车轮的驱动力传递机构,调节转向角的转向机构,产生制动力的制动装置,防抱死制动系统(ABS),电子稳定控制(ESC)系统,电动转向装置等。

车身相关控制器109产生各种控制信号,将它们提供给车身相关系统110,从而控制车身相关系统110。此外,车身相关控制器109根据需要向除了车身相关系统110之外的结构元件提供控制信号,以例如向它们通知控制车身相关系统110的状态。

车身相关系统110包括设置到车身的各种车身相关装置。例如,车身相关系统110包括无钥匙进入系统、智能钥匙系统、电动车窗装置、电动座椅、方向盘、空调、各种灯(诸如头灯、尾灯、刹车灯、闪光信号灯和雾灯)等。

例如,存储器111包括只读存储器(ROM)、随机存取存储器(RAM)、诸如硬盘驱动器(HDD)的磁存储设备、半导体存储设备、光存储设备、磁光存储设备等。存储器111中存储有由车辆控制系统100的各个结构元件使用的各种程序、数据等。例如,存储器111在其中存储地图数据,诸如三维高精度地图、全局地图和局部地图。高精度地图是动态地图等。全局地图的精度较低,并且覆盖比高精度地图更宽的区域。局部地图包括关于本车的周围的信息。

自动驾驶控制器112执行与自动驾驶相关的控制,诸如自主行驶或驾驶辅助。具体而言,例如,自动驾驶控制器112执行旨在实现高级驾驶员辅助系统(ADAS)的功能的协同控制,包括对本车的碰撞避免或冲击减轻、基于车辆之间的距离在前车之后行驶、在维持车速的同时行驶、本车的碰撞的警告、本车偏离车道的警告等。此外,例如,自动驾驶控制器112执行旨在实现例如自动驾驶的协作控制,所述自动驾驶是没有驾驶员执行的操作的自主行驶。自动驾驶控制器112包括检测器131、自身位置估计器132、状态分析器133、计划部134和移动控制器135。

检测器131检测控制自动驾驶所需的各种信息。检测器131包括车外信息检测器141、车内信息检测器142和车辆状态检测器143。

车外信息检测器141基于来自车辆控制系统100的各结构元件的数据或信号,执行检测与本车的外部有关的信息的处理。例如,车外信息检测器141执行对本车周围的物体进行检测、识别、追踪的处理,以及对到物体的距离进行检测的处理。检测对象物的示例包括车辆、人、障碍物、构造物、道路、信号灯、交通标识、道路标识等。此外,例如,车外信息检测器141执行检测本车周围的环境的处理。检测对象周围环境的示例包括天气、温度、湿度、亮度和路面状况。车外信息检测器141将指示检测处理的结果的数据提供给例如自身位置估计器132;状态分析器133的地图分析器151、交通规则识别部152和状态识别部153;以及移动控制器135的紧急事件回避部171。

车内信息检测器142执行基于来自车辆控制系统100的每个结构元件的数据或信号检测关于车辆内部的信息的处理。例如,车内信息检测器142执行认证和识别驾驶员的处理、检测驾驶员的状态的处理、检测车载人员的处理和检测车辆内部环境的处理。驾驶员的检测对象状态的示例包括身体状况、觉醒度、集中度、疲劳度、视线方向等。检测对象车内环境的示例包括温度、湿度、亮度以及气味。车内信息检测器142将指示检测处理的结果的数据提供给例如状态分析器133的状态识别部153和移动控制器135的紧急事件回避部171。

车辆状态检测器143执行基于来自车辆控制系统100的各结构元件的数据或信号检测本车的状态的处理。本车的检测对象状态的示例包括速度、加速度、转向角、有无异常及其内容、驾驶操作状态、电动座椅的位置及倾斜、门锁的状态以及其他车载装备的状态。车辆状态检测器143将表示检测处理结果的数据例如提供给状态分析器133的状态识别部153和移动控制器135的紧急事件回避部171。

自身位置估计器132执行基于来自诸如车外信息检测器141和状态分析器133的状态识别部153的车辆控制系统100的各结构元件的数据或信号估计本车的位置、姿势等的处理。此外,自身位置估计器132根据需要生成用于估计自身位置的局部地图(在下文中称为自身位置估计图)。例如,自身位置估计图是使用诸如同时定位与地图绘制(SLAM)的技术的高精度地图。自身位置估计器132将指示估计处理的结果的数据提供给例如状态分析器133的地图分析器151、交通规则识别部152和状态识别部153。此外,自身位置估计器132将自身位置估计图存储在存储器111中。

状态分析器133执行分析本车及其周围的状态的处理。状态分析器133包括地图分析器151、交通规则识别部152、状态识别部153和状态预测部154。

地图分析器151根据需要,使用来自诸如自身位置估计器132和车外信息检测器141的车辆控制系统100的各结构元件的数据或信号,执行分析存储在存储器111中的各种地图的处理,并构建包括自动驾驶处理所需的信息的地图。地图分析器151将所构建的地图提供给例如交通规则识别部152、状态识别部153和状态预测部154,以及计划部134的路线计划部161、行为计划部162和移动计划部163。

交通规则识别部152执行基于来自诸如自身位置估计器132、车外信息检测器141和地图分析器151的车辆控制系统100的各个结构元件的数据或信号来识别本车周围的交通规则的处理。通过该识别处理,能够识别本车周围的信号灯的位置和状态、在本车周围进行的交通管制的内容以及可行驶车道。交通规则识别部152将指示识别处理结果的数据提供给例如状态预测部154。

状态识别部153执行基于来自诸如自身位置估计器132、车外信息检测器141、车内信息检测器142、车辆状态检测器143和地图分析器151的车辆控制系统100的各个结构元件的数据或信号,识别与本车相关的状态的处理。例如,状态识别部153执行识别本车的状态、本车的周围的状态、本车的驾驶员的状态等的处理。此外,状态识别部153根据需要生成用于识别本车的周围的状态的局部地图(以下称为状态识别地图)。状态识别地图是例如占用栅格图。

本车的识别对象状态的示例包括本车的位置、姿势、移动(诸如速度、加速度、移动方向)以及有无异常及其内容。本车的周围的识别对象状态的示例包括本车周围的静止物体的类型和位置;本车周围的移动物体的类型、位置和移动(诸如速度、加速度和移动方向);本车周围的道路结构和路面状况;以及本车周围的天气、温度、湿度和亮度。驾驶员的识别对象状态的示例包括身体状况、觉醒度、集中度、疲劳度、视线的移动和驾驶操作。

状态识别部153将指示识别处理的结果的数据(必要时包括状态识别地图)提供给例如自身位置估计器132和状态预测部154。此外,状态识别部153将状态识别地图存储在存储器111中。

状态预测部154执行基于来自诸如地图分析器151、交通规则识别部152和状态识别部153的车辆控制系统100的各个结构元件的数据或信号,预测与本车相关的状态的处理。例如,状态预测部154执行预测本车的状态、本车的周围的状态、驾驶员的状态等的处理。

本车的预测对象状态的示例包括本车的行为、本车的异常的发生、本车的可行驶距离等。本车的周围的预测对象状态的示例包括移动物体的行为、信号灯的状态变化、诸如本车的周围的天气的环境变化。驾驶员的预测对象状态的示例包括驾驶员的行为和身体状况。

状态预测部154将表示预测处理结果的数据与来自交通规则识别部152和状态识别部153的数据一起提供给例如计划部134的路线计划部161、行为计划部162和移动计划部163。

路线计划部161基于来自诸如地图分析器151和状态预测部154的车辆控制系统100的各结构元件的数据或信号,计划到目的地的路线。例如,路线计划部161基于全球地图设置从当前位置到指定目的地的路线。另外,例如,路线计划部161基于交通堵塞、事故、交通管制和施工的状态以及驾驶员的身体状况等,适当变更路线。路线计划部161将表示所计划的路线的数据提供给例如行为计划部162。

行为计划部162基于来自诸如地图分析器151和状态预测部154的车辆控制系统100的各结构元件的数据或信号,计划本车的行为,以便本车在由路线计划部161计划的时间内,在由路线计划部161计划的路线上安全行驶。例如,行为计划部162进行关于例如开始移动、停止、行进方向(诸如向前移动、向后移动、左转、右转和方向改变)、用于行驶的车道、行进速度和超车的计划。行为计划部162例如向移动计划部163提供表示所计划的本车的行为的数据。

移动计划部163基于来自诸如地图分析器151和状态预测部154的车辆控制系统100的各个结构元件的数据或信号,计划本车的移动,以实现由行为计划部162计划的行为。例如,移动计划部163进行关于例如加速度、减速度和行驶路径的计划。移动计划部163将表示所计划的本车的移动的数据提供给例如移动控制器135的加减速控制器172和方向控制器173。

移动控制器135控制本车的移动。移动控制器135包括紧急事件回避部171、加/减速控制器172和方向控制器173。

紧急事件回避部171基于车外信息检测器141、车内信息检测器142以及车辆状态检测器143的检测结果,执行检测诸如碰撞、接触、进入危险区域、驾驶员的异常、车辆的异常的紧急事件的处理。当紧急事件回避部171检测到紧急事件的发生时,紧急事件回避部171计划诸如紧急停止或急转弯的本车的移动,以回避紧急事件。紧急事件回避部171将表示所计划的本车的移动的数据例如提供给加减速控制器172和方向控制器173。

加减速控制器172进行加减速控制,以实现由移动计划部163或紧急事件回避部171计划的本车的移动。例如,加减速控制器172计算驱动力产生装置或制动装置用于实现所计划的加速度、所计划的减速度或所计划的紧急停止的控制目标值,并将表示计算出的控制目标值的控制指令提供给传动系控制器107。

方向控制器173控制用于实现由移动计划部163或紧急事件回避部171计划的本车的移动的方向。例如,方向控制器173计算用于转向机构实现由移动计划部163计划的行驶路径或由紧急回避部171计划的急转弯的控制目标值,并将表示计算出的控制目标值的控制指示提供给传动系控制器107。

<数据获取部102A和车外信息检测器141A的配置示例>

图2示出了作为车辆控制系统100中的数据获取部102的第一实施例的数据获取部102A和作为车辆控制系统100中的车外信息检测器141的第一实施例的车外信息检测器141A的配置的部分示例。

数据获取部102A包括相机201和毫米波雷达202。车外信息检测器141A包括信息处理器211。信息处理器211包括信号处理器221、物体检测器222和追踪处理器223。信号处理器221包括信号处理器231和信号处理器232。物体检测器222包括物体检测器241和物体检测器242。追踪处理器223包括追踪部251和检测精度控制器252。

相机201例如是极高清(例如,10兆像素)相机。相机201捕获例如位于车辆10前方的区域的图像。相机201减少通过执行图像捕获获得的图像(以下称为捕获图像)中的像素数量,以生成具有降低的分辨率的低分辨率图像。此外,相机201从捕获图像中切出由车外信息检测器141A的检测精度控制器252设置的高清的读取范围的图像,从而生成裁切图像。相机201将低分辨率图像和裁切图像提供给信号处理器231。

毫米波雷达202针对位于车辆10前方的区域进行感测,并且毫米波雷达202和相机201的感测范围至少部分重叠。例如,毫米波雷达202在车辆10的前方发送包括毫米波的发送信号,并使用接收天线接收作为从位于车辆10前方的物体反射的信号的接收信号。例如,在车辆10的横向方向(宽度方向)上以指定间隔布置多个接收天线。此外,还可以在高度方向上布置多个接收天线。毫米波雷达202向信号处理器232提供按时间顺序指示使用每个接收天线接收的接收信号的强度的数据(以下称为毫米波数据)。

信号处理器231对低分辨率图像和裁切图像执行指定的信号处理。例如,信号处理器231对低分辨率图像和裁切图像执行RGB显影。换句话说,信号处理器231执行对低分辨率图像和裁切图像的每个像素的R分量、G分量和B分量进行插值的处理。信号处理器231将已经对其执行了信号处理的低分辨率图像和裁切图像提供给物体检测器241。

信号处理器232对毫米波数据执行指定的信号处理,以估计与位于车辆10前方的物体(反射器)的距离、方向和速度。信号处理器232产生指示与位于车辆10前方的每个物体的距离、方向和速度以及从物体反射的接收信号的强度的雷达图,并将雷达图提供给物体检测器242。

物体检测器241执行基于低分辨率图像和裁切图像,检测位于车辆10的前方的物体的处理。物体检测器241向追踪处理器223提供指示对象的检测结果的数据。

物体检测器242基于雷达图执行检测位于车辆10前方的物体的处理。物体检测器242向追踪处理器223提供指示物体的检测结果的数据。

例如,追踪部251执行使用用于基于观测值估计和预测状态的滤波器(诸如卡尔曼滤波器或粒子滤波器)追踪位于车辆10前方的对象物的处理。例如,追踪部251基于由物体检测器241执行的物体检测的结果、由物体检测器242执行的物体检测的结果以及预测位于车辆10前方的对象物的状态的结果,来估计位于车辆10前方的对象物的当前状态。此外,追踪部251基于由物体检测器241执行的物体检测的结果、由物体检测器242执行的物体检测的结果、以及由追踪部251执行的位于车辆10前方的对象物的当前状态的估计结果,预测位于车辆10前方的对象物的未来状态。

这里,对象物是位于车辆10前方的追踪对象物,并且任何物体都可以被设置为对象物。然而,有利的是,包括具有毫米波雷达202的发射信号的高反射率的部分的物体被设置为对象物。以下作为示例适当地描述对象物是车辆的情况。

此外,例如,对象物的位置、速度等被估计和预测为对象物的状态。

追踪部251将指示估计对象物的状态的结果的数据提供给例如自身位置估计器132;状态分析器133的地图分析器151、交通规则识别部152和状态识别部153;以及移动控制器135的紧急事件回避部171。

检测精度控制器252基于对位于车辆10前方的对象物的状态进行预测的结果来控制检测物体的精度。具体而言,检测精度控制器252基于预测的对象物的位置来设置高清读取范围。检测精度控制器252生成指示高清读取范围的读取控制信号,并将该读取控制信号提供给相机201。另外,检测精度控制器252基于对象物的预测位置和预测速度来设置高清处理范围。检测精度控制器252生成表示高清处理范围的信号处理控制信号,并将该信号处理控制信号提供给信号处理器232。

<相机201的配置的示例>

图3示出相机201的配置的示例。相机201包括镜头311、图像传感器312、缓冲器313、数量减少部314、控制接口(I/F)部315、切出部316和输出接口(I/F)部317。

镜头311在图像传感器312的受光面上形成被摄体的图像。

图像传感器312是高清(例如,10兆像素)图像传感器。任何类型的图像传感器(诸如CMOS图像传感器或CCD图像传感器)都可以用作图像传感器312。图像传感器312捕获被摄体的图像,并将获得的捕获图像临时存储在缓冲器313中。

数量减少部314减少存储在缓冲器313中的捕获图像的像素数量,以生成具有降低的分辨率的低分辨率图像。数量减少部314将低分辨率图像提供给输出I/F部317。

控制I/F部315从车外信息检测器141A的检测精度控制器252接收读取控制信号,并将该读取控制信号提供给切出部316。

切出部316从存储在缓冲器313中的捕获图像中切出由读取控制信号指示的高清读取范围中的图像,以生成裁切图像。切出部316将裁切图像提供给输出I/F部317。

输出I/F部317将低分辨率图像和裁切图像提供给信号处理器231。

<对象物追踪处理>

接下来,参照图4的流程图描述由车辆10执行的对象物追踪处理。

该处理例如在进行使车辆10起动而开始驾驶的操作时、即在例如车辆10的点火开关、电源开关、起动开关等接通时开始。此外,例如,当执行用于终止车辆10的驾驶的操作时,即,例如当车辆10的点火开关、电源开关、启动开关等被关断时,该处理终止。

在步骤S1中,车辆10基于捕获图像执行物体检测处理。根据该处理,检测位于车辆10前方的区域的捕获图像中的物体,并且将表示捕获图像中的物体的区域和物体的类型的数据从物体检测器241提供到追踪处理器423。

注意,稍后详细描述该处理。

在步骤S2中,车辆10基于毫米波数据执行物体检测处理。根据该处理,检测位于车辆10前方的物体,并且将表示所检测到的物体的位置和速度的数据从物体检测器242提供给追踪处理器423。

注意,稍后详细描述该处理。

此外,基于捕获图像进行的物体检测处理和基于毫米波数据进行的物体检测处理不一定按上述顺序进行。例如,基于捕获图像执行的处理和基于毫米波数据执行的处理可以以相反的顺序执行,或者可以并行执行。

在步骤S3中,追踪部251执行追踪对象物的处理。具体而言,追踪部251基于由物体检测器241执行的对捕获图像中的物体的区域和物体的类型的检测的结果、由物体检测器242执行的对物体的位置和速度的检测的结果、以及在最近执行的物体-对象追踪处理(在时间t-1)中执行的步骤S4的处理中预测(在时间t)的对象物的当前状态的结果,来估计(在时间t)的对象物的当前状态。例如,基于由物体检测器241执行的对捕获图像中的物体的区域和物体的类型的检测的结果,以及由物体检测器242执行的对物体的位置和速度的检测的结果,追踪部251校正预测对象物的当前状态的结果,以估计对象物的当前状态。因此,估计对象物的当前位置和当前速度。

注意,对象物的位置由例如距车辆10的距离和相对于车辆10的行驶方向(前方)的方向(角度)表示。对象物的速度由例如相对于车辆10的相对速度表示。

追踪部251将指示估计对象物的当前状态的结果的数据提供给例如自身位置估计器132;状态分析器133的地图分析器151、交通规则识别部152和状态识别部153;以及移动控制器135的紧急事件回避部171。

自身位置估计器132例如基于估计对象物的状态的结果,执行估计车辆10的位置、姿势等的处理。

地图分析器151例如基于估计对象物的状态的结果,执行对存储器111中存储的各种地图进行分析的处理,并构筑包括自动驾驶处理所需的信息的地图。

交通规则识别部152基于例如估计对象物的状态的结果,执行识别车辆10周围的交通规则的处理。

状态识别部153基于例如估计对象物的状态的结果,执行识别车辆10的周围的状态的处理。

当紧急事件回避部171基于例如估计对象物的状态的结果而检测出紧急事件的发生时,紧急事件回避部171计划车辆10的诸如紧急停止或急转弯的移动,以回避该紧急事件。

在步骤S4中,追踪部251预测对象物的状态。例如,追踪部251基于估计对象物的当前状态(在时间t)的结果来预测对象物的下一状态(在时间t+1)。因此,预测对象物的下一位置(距离和方向(角度))和下一速度(相对速度)。

在步骤S5中,检测精度控制器252基于预测的对象物的状态,控制检测对象物时的精度。

具体而言,检测精度控制器252基于对象物的预测位置设置高清读取范围。例如,检测精度控制器252将捕获图像中的以对象物的预测位置为中心的矩形区域设置为高清读取范围,该预测位置位于距车辆10指定距离以上的距离。高清读取区域的矩形的大小和形状既可以是固定的,也可以根据对象物的大小和形状而变化。通过相机201的控制I/F部315,检测精度控制器252向切出部316提供表示高清读取范围的读取控制信号。

另外,检测精度控制器252基于对象物的预测位置和预测速度来设置高清处理范围。例如,检测精度控制器252将到被追踪的对象物的预测距离的值为距离范围的中心值并且对象物的预测速度的值为速度范围的中心值的距离速度范围设置为高清处理范围。检测精度控制器252将表示高清处理范围的信号处理控制信号提供给信号处理器232。

此后,处理返回到步骤S101,并且重复执行步骤S101到S105的处理。

<基于捕获图像执行的物体检测处理的详情>

接下来,参照图5的流程图详细描述在图4的步骤S1中基于捕获图像执行的物体检测处理。

在步骤S31中,相机201捕获车辆10前方区域的图像。具体而言,图像传感器312通过镜头311捕获车辆10前方区域的图像,并将所获得的捕获图像储存于缓冲器313中。

在步骤S32中,数量减少部314对捕获图像执行数量减少处理。具体而言,数量减少部314从缓冲器313读取最近帧的捕获图像。数量减少部314减少要去除的像素的数量,例如,捕获图像中的指定位置处的像素,以便减少捕获图像的数据大小。通过输出I/F部317,数量减少部314向信号处理器231提供通过执行数量减少的处理而获得的低分辨率图像。

在步骤S33中,切出部316对捕获图像执行切出处理。具体而言,切出部316从缓冲器313读取最近帧的捕获图像。切出部316从捕获图像中切出在最近进行的对象物追踪处理中执行的步骤S5的处理中由检测精度控制器252设置的高清读取范围的图像,从而生成裁切图像。切出部316通过输出I/F部317将裁切图像提供给信号处理器231。

在步骤S34中,信号处理器231对捕获图像执行信号处理。具体而言,信号处理器231对低分辨率捕获图像和裁切图像执行指定的信号处理,诸如RGB显影处理。信号处理器231将低分辨率捕获图像和已经对其执行了信号处理的裁切图像提供给物体检测器241。

在步骤S35中,物体检测器241检测物体。换句话说,物体检测器241执行检测低分辨率捕获图像和裁切图像中的物体的处理。

当执行检测低分辨率图像中的物体的处理时,检测比裁切图像更宽的范围,或者更具体而言,检测相机201的整个图像捕获范围(视角)中的物体。然而,由于低分辨率图像的分辨率低于裁切图像的分辨率,因此低分辨率图像的检测精度较低。

另一方面,当执行检测裁切图像中的物体的处理时,高清读取范围中的检测物体的精度变得比其他范围中更高,并且这使得可以在高清读取范围中以高精度检测物体。例如,精确地检测图像中的诸如远处车辆的具有小尺寸的物体。

物体检测器241向追踪处理器223提供指示捕获图像(低分辨率图像和切出图像)中存在物体的区域和物体类型的数据。

此后,终止基于捕获图像进行的物体检测处理。

<基于毫米波数据执行的物体检测处理的细节>

接下来,参照图6的流程图详细描述在图4的步骤S2中基于毫米波数据执行的物体检测处理。

在步骤S61中,毫米波雷达202对位于车辆10前方的区域执行感测。具体而言,毫米波雷达202沿车辆10的前进方向发射信号,并使用多个接收天线接收作为从位于车辆10前方的物体反射的信号的接收信号。毫米波雷达202向信号处理器232提供按时间顺序指示使用每个接收天线接收的接收信号的强度的毫米波数据。

在步骤S62中,信号处理器232基于毫米波数据估计物体的位置和速度。具体而言,信号处理器232对由每个接收天线获得的毫米波数据执行指定的信号处理,以估计发射信号被反射的物体的位置和速度。物体的位置例如由距车辆10的距离以及物体相对于毫米波雷达202的光轴方向(车辆10的行驶方向)的方向(角度)来表示。物体的速度例如由相对于车辆10的相对速度表示。

这里,可以使用例如傅立叶变换,以相对小的计算量来估计到物体的距离和物体的速度。另一方面,使用例如Capon方法、Esri方法或深度学习来估计物体的方向,即接收信号所来自的方向,并且其计算量非常大。

因此,例如,首先,信号处理器232估计与位于车辆10前方的物体的距离和速度。接下来,信号处理器232估计位于车辆10前方的物体的方向。这里,信号处理器232基于到物体的距离和物体的速度来改变执行信号处理的精度。具体而言,信号处理器232基于到物体的距离和物体的速度来改变估计物体的方向的精度。例如,对于除了在最近执行的对象物追踪处理中执行的步骤S5的处理中设置的高清处理范围之外的距离和速度范围,信号处理器232使该距离和速度范围中的角分辨率(可分辨的数,二进制)低于高清处理范围中的角分辨率,并估计物体的方向。

这使得可以减少计算量。此外,在高清处理范围中,即,在预测存在对象物的范围中,将角分辨率设置得比在除高清处理范围之外的范围中的角分辨率高,并且可以以高精度估计物体的方向。

信号处理器232产生指示位于车辆10前方的每个物体的距离、方向和速度以及从物体反射的接收信号的强度的雷达图,并将该雷达图提供给物体检测器242。

在步骤S63中,物件检测器242检测物体。具体而言,物体检测器242基于雷达图检测位于车辆10前方的每个物体的位置和速度。物体的位置例如由距车辆10的距离和相对于车辆10的行驶方向(前方)的方向(角度)表示。物体的速度例如由相对于车辆10的相对速度表示。物体检测器242向追踪处理器223提供表示每个物体的位置和速度的检测结果的数据。

此后,终止基于毫米波数据执行的物体检测处理。

如上所述,通过有效地使用车辆控制系统100的有限资源,可以以高精度追踪对象物。

例如,由相机201执行的物体检测的结果和由毫米波雷达202执行的物体检测的结果被融合以追踪对象物。这使得相机201和毫米波雷达202中的一个能够弥补相机201和毫米波雷达202中的另一个的检测条件不是那么好的状态,并且这使得追踪精度得到提高。

此外,当由相机201生成低分辨率图像和裁切图像以发送至输出侧时,与在不改变地将捕获图像发送至输出侧的情况下相比,减少了数据传输量。例如,当图像传感器312是以30fps运行的10兆像素图像传感器时,诸如通信网络121的传输路径必须是用于以3.6Gbps或更大传输的高速传输路径,以便将捕获图像无变化地传输到输出侧。另一方面,从相机201向输出侧发送低分辨率图像和裁切图像使得可以降低传输路径的传送速率。

此外,使用低分辨率图像和裁切图像而不是捕获图像还使得可以降低信号处理器231和物体检测器241的处理能力。另一方面,可以使用高分辨率裁切图像来检测在低分辨率图像中难以检测到的对象物(例如,远距离车辆)。因此,当降低捕获图像的分辨率时,也能够以高精度追踪对象物。

此外,可以相对于相同传送速率的传输路径安装比以往更高清的相机201,并且信号处理器231和物体检测器241各自具有相同的处理能力。因此,例如,代替分别提供广角相机和远摄相机,而使用广角镜头作为镜头311,使得可以使相机201单独用作广角相机和远摄相机两者。这使得可以单独使用相机201来更远且更广泛地追踪对象物。这使得例如实现车辆控制系统100的成本的降低以及布局和设计的改进。

<2.第二实施例>

接下来,参考图7描述本技术的第二实施例。

<数据获取部102的第二实施例和车外信息检测器11的第二实施例>

图7示出了作为车辆控制系统100中的数据获取部102的第二实施例的数据获取部102B和作为车辆控制系统100中的车外信息检测器141的第二实施例的车外信息检测器141B的配置的部分示例。注意,图中与图2中的部分对应的部分由与图2相同的附图标记表示,并且适当地省略其描述。

数据获取部102B与图2的数据获取部102A的相似之处在于包括相机201和毫米波雷达202,并且与数据获取部102A的不同之处在于包括LiDAR 401。

车外信息检测器141B包括信息处理器411。信息处理器411包括信号处理器421、物体检测器422和追踪处理器423。信号处理器421与图2的信号处理器221类似之处在于包括信号处理器231和信号处理器232,并且与信号处理器221的不同之处在于包括信号处理器431。物体检测器422与图2的物体检测器222相似之处在于包括物体检测器241和物体检测器242,并且与物体检测器222不同之处在于包括物体检测器441。追踪处理器423包括追踪部451和检测精度控制器452。

例如,LiDAR 401是闪光LiDAR。例如,LiDAR 401在横向方向和高度方向上在两个维度上径向地向位于车辆10前方的区域照射指定波长的激光(例如,红外光),并且使用包括二维布置的光接收元件的传感器来接收激光的反射光。LiDAR向信号处理器431提供指示由每个光接收元件接收的反射光的强度的光接收数据。

信号处理器431对该光接收数据执行特定的信号处理,以产生指示位于车辆10前方的物体的形状和位置的三维点群数据(点云)。信号处理器431将该点群数据提供给物体检测器441。

物体检测器441基于该点群数据执行检测位于车辆10前方的物体的处理。例如,物体检测器441基于该点群数据来检测位于车辆10前方的每个物体的位置(到该物体的距离和该物体的方向)。物体检测器441向追踪处理器423提供指示检测每个物体的位置的结果的数据。

例如,与追踪部251的情况相同,追踪部451使用用于基于观测值来估计和预测状态的滤波器(诸如卡尔曼滤波器或粒子滤波器)来执行追踪位于车辆10前方的对象物的处理。例如,追踪部451基于由物体检测器241执行的物体检测的结果、由物体检测器242执行的物体检测的结果、由物体检测器441执行的物体检测的结果、以及位于车辆10前方的对象物的状态预测的结果,来估计位于车辆10前方的对象物的当前状态。此外,追踪部251基于由物体检测器241执行的物体检测的结果、由物体检测器242执行的物体检测的结果、由物体检测器441执行的物体检测的结果、以及由追踪部251执行的位于车辆10前方的对象物的当前状态的估计的结果,来预测位于车辆10前方的对象物的未来状态。

追踪部451将指示估计对象物的状态的结果的数据提供给例如自身位置估计器132;状态分析器133的地图分析器151、交通规则识别部152和状态识别部153;以及移动控制器135的紧急事件回避部171。

检测精度控制器452基于预测位于车辆10前方的对象物的状态的结果来控制检测物体的精度。具体而言,如在图2的检测精度控制器252的情况下,检测精度控制器452基于对象物的预测位置来设置高清读取范围。检测精度控制器452生成表示高清读取范围的读取控制信号,并将该读取控制信号提供给相机201。另外,检测精度控制器452与检测精度控制器252同样,基于对象物的预测位置和预测速度,设置第一高清处理范围。检测精度控制器452生成表示第一高清处理范围的第一信号处理控制信号,并将该第一信号处理控制信号提供给信号处理器232。

此外,检测精度控制器452基于对象物的预测位置来设置第二高清处理范围。例如,检测精度控制器452将以距车辆10指定距离以上的对象物的预测位置为中心的指定范围设置为第二高清处理范围。检测精度控制器452生成表示第二高清处理范围的第二信号处理控制信号,并将该第二信号处理控制信号提供给信号处理器431。

如上所述,LiDAR 401的添加使得可以以更高的精度来追踪对象物。

另一方面,为了生成点群数据,需要大量的计算。在这一方面,信号处理器431提高第二高清处理范围中的点群数据的精度,并且降低第二高清处理范围以外的范围中的点群数据的精度,以减少生成点群数据所需的计算量。由于第二高清处理范围中的点群数据的精度的提高,因此即使当存在计算量的减少时,也抑制了检测对象物的减少。

<<3.修改>>

下面描述对上述本技术的实施例的修改。

以上已经描述了追踪位于车辆10前方的对象物的示例。然而,本技术也适用于追踪从车辆10观察时位于另一方向上的对象物的情况。

此外,本技术还可应用于追踪除车辆之外的移动体周围的对象物的情况。例如,可以想到的是,本技术可以应用于诸如摩托车、自行车、个人移动性、飞机、轮船、建筑机械和农业机械(拖拉机)的移动物体。此外,可应用本技术的移动物体的示例还包括诸如无人机和机器人的移动物体,其在用户不上到该移动物体的情况下由用户远程操作。

此外,本技术也适用于在诸如监视系统的固定位置处追踪对象物的情况。

此外,本技术可应用于融合由相机201(图像传感器201A)执行的检测的结果和由LiDAR 401执行的检测的结果的情况,或者可应用于融合由毫米波雷达202执行的检测的结果和由LiDAR 401执行的检测的结果的情况。

此外,用作LiDAR 401的闪光LiDAR可以采用在横向方向(水平方向)上径向地照射激光并且在高度方向上执行扫描的方案。

此外,代替闪光LiDAR,可以使用利用激光脉冲执行扫描的LiDAR作为LiDAR 401。

此外,本技术也适用于使用除了毫米波雷达和LiDAR之外的检测物体的传感器的情况。

上面已经描述了相机201减少像素数量以生成低分辨率图像的示例。然而,例如,可以通过滤波处理等降低捕获图像的分辨率以生成低分辨率图像。

<<4.其他>>

<计算机的配置的示例>

上述一系列处理可以使用硬件或软件来执行。当使用软件执行一系列处理时,包括在软件中的程序被安装在计算机上。这里,计算机的示例包括并入专用硬件的计算机,以及能够通过安装在其上的各种程序执行各种功能的诸如通用个人计算机的计算机。

图8是使用程序执行上述一系列处理的计算机的硬件配置的示例的框图。

在计算机1000中,中央处理单元(CPU)1001、只读存储器(ROM)1002和随机存取存储器(RAM)1003通过总线1004彼此连接。

此外,输入/输出接口1005连接到总线1004。输入部1006、输出部1007、记录部1008、通信部1009和驱动器1010连接到输入/输出接口1005。

输入部1006包括例如输入开关、按钮、麦克风和成像元件。输出部1007包括例如显示器和扬声器。记录部1008包括例如硬盘和非易失性存储器。通信部1009包括例如网络接口。驱动器1010驱动诸如磁盘、光盘、磁光盘或半导体存储器的可移除介质1011。

在具有上述配置的计算机1000中,通过CPU 1001将例如记录在记录部1008中的程序加载到RAM 1003中并经由输入/输出接口1005和总线1004执行该程序,来执行上述一系列处理。

例如,由计算机1000(CPU 1001)执行的程序可以通过被记录在用作例如封装介质的可移除介质1011中来提供。此外,可以经由诸如局域网、因特网或数字卫星广播的有线或无线传输介质来提供程序。

在计算机1000中,可以通过安装在驱动器1010上的可移除介质1011经由输入/输出接口1005将程序安装在记录部1008上。此外,程序可以由通信部1009经由有线或无线传输介质接收,以安装在记录部1008上。此外,程序可以预先安装在ROM 1002或记录部1008上。

注意,由计算机执行的程序可以是其中按照这里的描述顺序按时间顺序执行处理的程序,或者可以是其中并行执行处理或者在诸如调用定时的必要定时执行处理的程序。

此外,如本文所使用的系统是指多个组件(诸如装置和模块(部件))的集合,并且所有组件是否在单个外壳中并不重要。因此,容纳在单独的壳体中并经由网络彼此连接的多个装置以及其中多个模块容纳在单个壳体中的单个装置都是系统。

此外,本技术的实施例不限于上述示例,并且在不脱离本技术的范围的情况下,可以对其进行各种修改。

例如,本技术还可以具有云计算的配置,其中,单个功能被共享以由多个装置经由网络协作地处理。

此外,除了由单个装置执行之外,使用上述流程图描述的各个步骤可以由多个装置共享执行。

此外,当单个步骤包括多个处理时,除了由单个装置执行之外,包括在单个步骤中的多个处理可以被共享以由多个装置执行。

<配置的组合示例>

本技术还可以采用以下配置。

(1)一种信息处理装置,包括:

第一物体检测器,其基于来自第一传感器的第一传感器数据执行物体检测;

第二物体检测器,其基于来自类型不同于第一传感器的第二传感器的第二传感器数据执行物体检测;

追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及

检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

(2)根据(1)所述的信息处理装置,其中

第一传感器和第二传感器中的一个是毫米波雷达,以及

所述信息处理装置还包括信号处理器,所述信号处理器执行对毫米波雷达输出的数据的信号处理,并且使得高分辨率范围中的信号处理的精度比其他范围中的信号处理的精度高。

(3)根据(2)所述的信息处理装置,其中

所述信号处理器基于由毫米波雷达输出的数据来估计到物体的距离、物体的速度和物体的方向,并且使得高分辨率范围中估计物体的方向的精度比其他范围中估计物体的方向的精度高。

(4)根据(3)所述的信息处理装置,其中

所述信号处理器使高分辨率范围中的角分辨率高于其他范围中的角分辨率,以估计物体的方向。

(5)根据(3)或(4)所述的信息处理装置,其中

所述高分辨率范围是使由所述信号处理器执行的物体的方向估计的精度高于其他范围中的物体的方向估计的精度的距离和速度范围。

(6)根据(1)至(5)中任一项所述的信息处理装置,其中

第一传感器和第二传感器中的一个是图像传感器,以及

所述高分辨率范围是由包括图像传感器的相机输出的图像中使分辨率高于其他范围中的分辨率的范围。

(7)根据(6)所述的信息处理装置,其中

所述检测精度控制器根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的位置来设置高分辨率范围。

(8)根据(7)所述的信息处理装置,其中

所述检测精度控制器基于离开指定距离以上的对象物的预测的位置来设置高分辨率范围。

(9)根据(6)至(8)中任一项所述的信息处理装置,其中

所述相机输出第二图像和第三图像,所述第二图像是通过降低由图像传感器获得的第一图像的分辨率而获得的,所述第三图像是通过从第一图像中切出高分辨率范围中的图像而获得的,以及

第一物体检测器和第二物体检测器中的一个基于第二图像和第三图像执行物体检测。

(10)根据(1)至(9)中任一项所述的信息处理装置,其中

第一传感器和第二传感器中的一个是闪光LiDAR,以及

所述信息处理装置还包括信号处理器,所述信号处理器基于由所述闪光LiDAR输出的数据来生成点群数据,并且使得所述高分辨率范围中的点群数据的精度高于其他范围中的点群数据的精度。

(11)根据(10)所述的信息处理装置,其中

所述检测精度控制器基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的位置来设置高分辨率范围。

(12)根据(1)至(11)中任一项所述的信息处理装置,其中

第一传感器和第二传感器是图像传感器、毫米波雷达和闪光LiDAR中的两种。

(13)根据(1)至(12)中任一项所述的信息处理装置,其中

所述追踪部根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,估计和预测对象物的状态。

(14)根据(13)所述的信息处理装置,其中

所述追踪部使用卡尔曼滤波器或粒子滤波器。

(15)根据(1)至(14)中任一项所述的信息处理装置,其中

第一物体检测器和第二物体检测器各自执行关于移动体周围的物体检测,以及

所述追踪部预测位于移动体周围的对象物的状态。

(16)一种由信息处理装置执行的信息处理方法,所述信息处理方法包括:

基于来自第一传感器的第一传感器数据执行物体检测;

基于来自类型不同于第一传感器的第二传感器数据执行物体检测;

根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及

基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

(17)一种用于使计算机执行包括以下步骤的处理的程序:

基于来自第一传感器的第一传感器数据执行物体检测;

基于来自类型不同于第一传感器的第二传感器数据执行物体检测;

根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果,预测作为追踪对象的对象物的状态;以及

基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围。

(18)一种移动体控制装置,包括:

第一物体检测器,其基于来自第一传感器的第一传感器数据,执行关于移动体周围的物体检测;

第二物体检测器,其基于来自类型不同于第一传感器的第二传感器的第二传感器数据,执行关于移动体周围的物体检测;

追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;以及

检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及

移动控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

(19)一种移动体,包括:

第一传感器;

第二传感器,其类型不同于第一传感器;

第一物体检测器,其基于来自第一传感器的第一传感器数据执行物体检测;

第二物体检测器,其基于来自第二传感器的第二传感器数据执行物体检测;

追踪部,其根据基于第一传感器数据执行的物体检测的结果以及基于所述第二传感器数据执行的物体检测的结果,估计和预测作为追踪对象的对象物的状态;以及

检测精度控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而预测的对象物的状态来设置高分辨率范围,所述高分辨率范围是执行物体检测的精度比其他范围更高的范围;以及

移动控制器,其基于根据基于第一传感器数据执行的物体检测的结果以及基于第二传感器数据执行的物体检测的结果而估计的对象物的状态来控制移动体的移动。

注意,本文描述的效果不是限制性的,而仅仅是说明性的,并且可以提供其他效果。

附图标记列表

10 车辆

100 车控制系统

102、102A、102B 数据获取部

107 传动系控制器

108 传动系系统

135 移动控制器

141、141A、141B 车外信息检测器

201 相机

202 毫米波雷达

211 信息处理器

221 信号处理器

222 物体检测器

223 追踪处理器

231、232 信号处理器

241、242 物体检测器

251 追踪部

252 检测精度控制器

312 图像传感器

314 数量减少部

316 切出部

401 LiDAR

411 信息处理器

421 信号处理器

422 物体检测器

423 追踪处理器

431 信号处理器

441 物体检测器

451 追踪部

452 检测精度控制器

- 信息处理装置、信息处理方法、程序、移动体控制装置和移动体

- 信息处理装置、信息处理方法、程序、移动体控制装置和移动体