一种细胞培养控制方法以及系统

文献发布时间:2023-06-19 10:40:10

技术领域

本发明涉及一种细胞培养控制方法以及系统。本发明的方法以及系统在满足细胞培养蛋白表达量要求的同时,不会影响产品纯度和质量。

背景技术

生物反应器是一种是在体外利用酶或生物体(例如细胞)的功能并进行生化反应的装置系统,是一种生物功能模拟机,其被广泛运用生物药的生产和研发,包括但不限于利用生物反应器悬浮培养细胞生产抗体抗原等产物。对于已经选定的反应物和反应工艺类型而言,对反应过程的控制成为关键。生物反应器的控制极大程度的影响生物药的产量、质量和投入成本。为了保持最优环境中进行反应,通过对反应的各种运行参数进行随时监控和控制。

例如,在生物反应器中培养细胞并进行生产的情况下,由于生物细胞培养期间生物反应器的可控参数较多(例如温度、搅拌、通气、以及多种成分的填补料添加量),以及培养周期状态(培养液成分、活细胞密度、温度、PH等)较多且变化呈现非线性,并且培养周期较长,因而如何在培养周期内的各阶段采用正确的生物反应器操作和培养工艺以取得最佳效益,是困扰生物药生产公司的难题。

具体而言,例如在生物药研发中需要进行大量生物反应实验,通过实验结果筛选出最可靠的细胞株培养操作流程,从而保证长期稳定的产生流程、高产量、与药物质量。这样的生物反应实验需要探索大范围的实验参数(比如:糖、乳酸、氧气、氨基酸等)在每时每刻对细胞株的影响,所以优化细胞株培养工艺是整个生物药研发里需要大量实验成本与时间投入的核心工艺之一。

目前,为了确定合适的反应参数,生物药公司往往需要投入大量的人力物力针对特定的生物药来进行反复实验,以优化该生物药细胞培养生物反应器的操作方法和培养工艺。该过程耗时长达数月以上,且耗费大量的人力物力,同时实验结果过度依赖操作人员的经验和主观判断。

现在虽然也有一些其他的培养方法,但大多依赖于机理模型。赛多利斯的SIMCAOnline软件内置一些判断规则和多因素模型,当测量物质超出设定的范围时,会及时通过一些反应操作纠正,但是不能根据当前状态总结出范围内的最佳操作。有些则是机理模型的改进,例如CN111308893A只针对机理模型已知的发酵过程,涉及到微生物培养的生物反应器的补料的速率调控,其将培养过程划分为非均匀的网格,在网格中优化补料的补充速率。机理模型在一定程度上可以优化培养过程,但是并没有在整体上考虑生物药的多样性、培养环境的多样性和操作方法的多样性,这些因素在一定条件下会产生相互作用,而机理模型往往针对单一行为,并不考虑复杂的相互作用和多种行为。

除了简单的机理模型以外,最近也有研究运用了强化学习在生物反应器中。Pandian BJ和Noel MM在《Control of a bioreactor using a new partiallysupervised reinforcement learning algorithm》,Journal of Process Control,2018;69:16–29中将强化学习Q-learning和人工神经网络ANN以及半监督学习的强化学习PSRL运用到酵母菌发酵的生物反应器的控制,其培养目的是控制生物反应器的补料含量在一定限度,但是其考虑的状态非常有限。其中将参数分成了10个水平,因为Q-learning适用于这种离散状态且状态水平少的场景。但实际上生物反应器的状态参数比较多,且大多数是连续变量,只做几个状态划分不能满足实际的使用。

Neythen J.Treloar等在《Deep reinforcement learning for the control ofmicrobial co-cultures in bioreactors》,PLOS Computational Biology,16(4):e1007783,apr 2020中将深度强化网络(DQN)运用于优化进入生物反应器的营养物质组成,以更好的维持多种微生物菌株的生存。但其同样考虑了较少的状态参数(实际上仅采用了两种微生物的含量作为参数),进行的控制也仅为优化补料(碳源、精氨酸和色氨酸的补料)的控制,因为DQN适用于这种状态参数少控制参数少的环境。但是在参数多和操作行为多的情况下,DQN更可能选择过高的估计值,从而导致过于乐观的值估计,从而带来错误的行为推荐。

由此,以上两种算法并不适用于生物制药业的大多数更为复杂的环境。目前也并没有其他算法运用到生物药生产为目的生物反应器环境,并以整个培养过程的生物药的产量和质量为最终衡量目的的强化学习运用的场景。

发明内容

本发明人认为,生物药细胞培养的生物反应器的控制过程在数学本质上可以被视为一种最优决策问题,也称马尔科夫决策过程(Markov decision process,MDP),可以使用强化学习来优化控制工艺。本发明人使用双深度Q网络(Double Deep Q Network,DoubleDQN)的算法模型,提出综合的奖励分数,结果经过湿实验论证与对照的经过3-4个月的多轮实验人工筛选出来的最优工艺组合进行比较,本发明的方法和使用了本发明的装置在满足细胞培养蛋白表达量要求的同时,不会影响产品纯度和质量。

本发明是基于上述发现的发明,因此,本发明的一个方面涉及一种细胞培养控制方法,其特征在于,包括以下步骤:步骤1)从细胞培养开始起,在具有指定间隔的时间点获取参数的测得值,步骤2)将参数的测得值输入双深度Q网络算法模型得到参数的算得值,步骤3)根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数;可选地,还包括步骤4)重复步骤1)~步骤3),直至细胞培养结束。

本发明的另一个方面涉及一种细胞培养控制系统,其特征在于,包括:用于从细胞培养开始起在具有指定间隔的时间点获取参数的测得值的装置1,用于将参数的测得值输入双深度Q网络算法模型得到参数的算得值的装置2,用于根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数的装置3;可选地,还包括用于对装置1~3进行重复直至细胞培养结束的装置4。

本发明的又一个方面涉及一种计算机可读存储介质,其特征在于,所述存储介质上存储有指令或计算机程序,当所述指令或计算机程序被处理器执行时,实现下述步骤:步骤1)从细胞培养开始起,在具有指定间隔的时间点获取参数的测得值,步骤2)将参数的测得值输入双深度Q网络算法模型得到参数的算得值,步骤3)根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数;可选地,还包括步骤4)重复步骤1)~步骤3),直至细胞培养结束。

附图说明

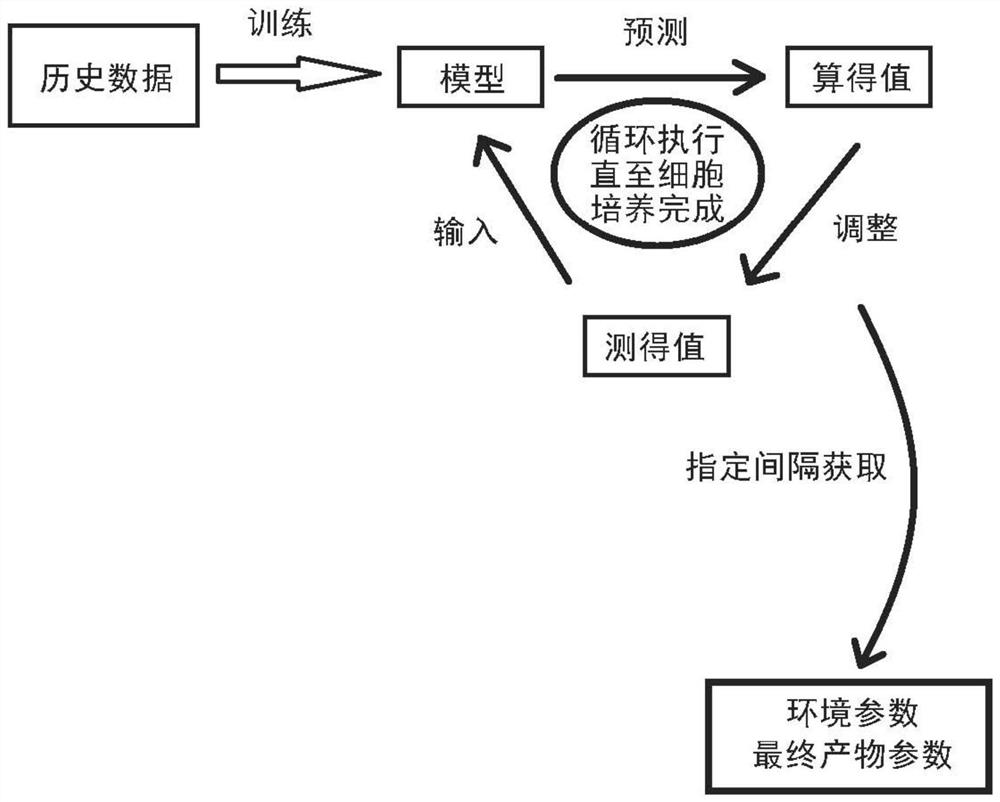

图1是采用本发明的模型进行本发明的细胞培养控制方法的示意图。

图2是实施例2的反应过程中取样、测试、调整、测试、返回模型预测的示意图。

图3是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的pH的图。

图4是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的温度的图。

图5是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的葡萄糖的图。

图6是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的钠的图。

图7是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的谷氨酰胺的图。

图8是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的谷氨酸盐的图。

图9是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的铵的图。

图10是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的渗透压的图。

图11是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的pCO

图12是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的细胞生长的图。

图13是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的细胞存活率的图。

图14是示出实施例2的反应过程中,模型预测、湿实验论证、对照中每天的乳酸堆积情况的图。

具体实施方式

发明人发现,深度强化学习中的双深度Q网络(Double Deep Q Network,DoubleDQN)的算法模型能够在当前的背景下获得良好的学习效果。双深度Q网络的算法模型能够从多个参数的大量的历史数据中效果良好地学习到当前状态下最佳的生物反应器的操控方法。

具体而言,在本发明中,希望最终的回报(G)尽可能地高。该回报为整个过程累计的奖励(R)的和,所述奖励(R)是各时间点的趋势参数和最终产物参数分别乘以各自的权重值并求和。

将应用了本发明的细胞培养控制方法的生产工艺与对照的人工筛选出来的最优工艺组合进行比较,发现采用了本发明的细胞培养控制方法进行控制的生产工艺在满足细胞培养蛋白表达量要求的同时,不会影响产品纯度和质量。因此,采用本发明的细胞培养控制方法进行控制的生产工艺可取代操作人的经验判断,适用于小规模、中规模和大规模的生物反应器,可广泛运用于生物药生产企业,缩短工艺开发和优化的时间,从而节约大量的人力物力的摸索,具有广泛的运用前景。

深度学习是一种典型的监督学习方式,基于大量带有标签的数据进行预测(回归问题)或分类(分类问题),而强化学习则是通过与环境不断地交互获得奖励,并基于这些奖励调整学习过程以获得全局最优的行为策略。生物药细胞培养的生物反应器的控制过程需要基于大量历史数据,并且需要在整体上考虑生物药的多样性、培养环境的多样性和操作方法的多样性以及它们之间的相互作用,因此如果将深度学习与强化学习结合,则有可能兼顾上述两者。

深度Q网络(Deep Q Network,DQN)是一种典型的深度强化学习,其是将Q学习(Qlearning)通过神经网络近似值函数的一种方法。在Q学习中,对于任何有限的马尔科夫决策过程(MDP),Q学习最终会找到一个最优策略,即从当前状态开始,所有连续步骤的总回报回报的期望值是最大值可以实现的。

但是,深度Q网络也存在缺点。根据Hado van Hasselt等在《Deep ReinforcementLearning with Double Q-learning》,arXiv:1509.06461中的描述,Q学习和DQN算法都会过高估计(overestimate)Q值,从而带来错误的行为推荐。

双深度Q网络能够很好地解决该问题。在本发明中,我们采用以下算法流程来训练得到算法模型。

1.1算法输入:迭代轮数T,状态特征维度n,动作集A,步长α,衰减因子γ,当前Q网络Q,目标Q网络Q′,批量梯度下降的样本数m,目标Q网络参数更新频率C;

1.2输出:Q网络参数;

1.3随机初始化所有的状态和动作对应的价值Q。随机初始化当前Q网络的所有参数w,初始化目标Q和网络Q′的参数w′=w。清空经验回放的集合D;

1.4从1到T,进行迭代;

1.5初始化S为当前状态序列的第一个状态,拿到其特征向量φ(S);

1.6在Q网络中使用φ(S)作为输入,得到Q网络的所有动作对应的Q值输出。当前Q值输出中选择Q值最大对应的动作A;

1.7在状态S执行当前动作A,得到新状态S″对应的特征向量φ(S′)和奖励φ(S′)和奖励R$,是否终止状态is_end;

1.8将{φ(S),A,R,φ(S′),is_end}这个五元组存入经验回放集合D;

1.9S=S′;

1.10从经验回放集合D中采样m个样本

{φ(Sj),Aj,Rj,φ(S′j),is_endj},j=1,2.,,,m计算当前目标Q值yj;

1.11使用均方差损失函数

1.12如果T%C=1,则更新目标Q网络参数w′=w;

1.13如果S′是终止状态,当前轮迭代完毕,否则转到步骤1.6。

在明确所要使用的数据模型后,将该模型应用于本发明的细胞培养控制方法中。具体而言,本发明的细胞培养控制方法包括以下步骤:

步骤1)获取状态参数的测得值:从细胞培养开始起,在具有指定间隔的时间点获取参数的测得值,

步骤2)得到状态参数的算得值:将状态参数的测得值输入双深度Q网络算法模型得到状态参数的算得值,

步骤3)调整培养体系:根据一个或多个状态参数的算得值分别调整细胞培养体系的一个或多个参数;

可选地,还包括步骤4)重复步骤1)~步骤3),直至细胞培养结束。

获取参数的测得值

从细胞培养开始起,在具有指定间隔的时间点获取状态参数的测得值。术语“状态参数”是用于表征细胞培养体系的各方面状态的参数,该状态包括但不限于培养细胞的属性参数、和培养细胞的环境参数,例如所述培养细胞的属性参数表征所要培养的细胞的固有特性,包括但不限于所用细胞的体积、所用细胞的合适的增殖密度和温度等。所述培养细胞的环境参数表征培养环境的各项指标,包括但不限于培养物整体或其组分的理化性质特征、以及补料的特征。

为了获得所述状态参数的测得值,在具有指定间隔的时间点对细胞培养体系的状态参数进行测定。所述指定间隔根据以下因素综合决定,所述因素包括但不限于:所培养的细胞、所要求的产物种类、培养的总时间、所要求的产物浓度和等级以及细胞培养的时间预算和经济预算等。在整个细胞培养过程中,所述指定间隔可以变化或不变。例如,可以将整个细胞培养过程平均划分为均等的多个时间间隔,规律地对细胞培养体系的状态参数进行测定。也可以根据需要以变化的时间间隔测定细胞培养体系的状态参数,例如可以在细胞培养过程的前期以较长的时间间隔测定细胞培养体系的状态参数,在细胞培养过程的中期以较短的时间间隔测定细胞培养体系的状态参数,并在在细胞培养过程的后期以较长的时间间隔测定细胞培养体系的状态参数,这取决于细胞何时进入细胞增殖的指数期等各种因素;并且细胞培养过程的前中后期中测定细胞培养体系的状态参数的指定间隔各自可以是均匀、规律的,也可以是非均匀、不规律的。

在一个实例中,所述指定间隔可以是10分钟至2天,例如15分钟、20分钟、30分钟、45分钟、1小时、1.5小时、2小时、2.5小时、3小时、4小时、5小时、6小时、7小时、8小时、10小时、12小时、15小时、18小时、20小时、22小时、24小时、28小时、32小时、36小时、40小时、44小时、42小时、48小时以及介于这些时间间隔之间的任意时间间隔。考虑到人力和实验室消耗成本,在其充裕的情况下,可选择相对短的指定间隔。例如,可选择1小时的指定间隔。或者,也可以选择相对长的指定间隔,例如可选择12小时乃至24小时作为指定间隔。

得到状态参数的算得值

将状态参数的测得值输入双深度Q网络算法模型得到状态参数的算得值。在将状态参数的测得值输入双深度Q网络算法模型前,预先对双深度Q网络算法模型进行训练。双深度Q网络算法模型的训练过程如“双深度Q网络”小节中所述。

通过历史数据对双深度Q网络算法模型进行训练。所述历史数据是指在本次细胞培养前收集到的各批次中与细胞培养相关的数据,包括但不限于细胞培养过程中的各种状态参数、动作、所要生产的目标物质的产量、纯度和质量等级等。所述历史数据被输入到模型中并以此对模型进行训练,以获得使最终的回报(G)达到最高的模型。回报(G)是整个过程累计的奖励(R)的和,所述奖励(R)为各时间点的趋势参数和最终产物参数分别乘以各自的权重值并求和。

术语“趋势参数”是指如下参数:该参数的增加代表对细胞培养和/或产物生产越接近所希望的目标。例如,在希望产物的纯度高的情况下,如果某一参数越高则产物的纯度越高,则将这样的参数作为趋势参数。在一些情况下,这样的参数是细胞培养环境中某些物质的量的增加或浓度的增加,但实际上该参数不限于此。例如,希望产物的产量高的情况下,如果培养时间越长则产物的产量越高,则将培养时间也称为“趋势参数”。

本领域技术人员可以理解,趋势参数根据所培养的细胞以及对产物的要求而不同。此处所述的对产物的要求可以是一个或多个要求,例如可以要求兼顾产物的产量和纯度,或要求兼顾产物的产量、纯度、和等级。本领域技术人员能够根据实际需求选择对产物的要求,并由此选择趋势参数。

术语“最终产物参数”是表征最终得到的产物的特性、性质、性能、效力中的至少一个的参数。例如,最终产物参数包括但不限于产物的产量、产物的活性、产物的纯度、产物的异构体比例、产物的等级等。当细胞培养的目的是增殖细胞(例如,收获细胞以用于细胞治疗),则细胞本身就是产物。

最终产物参数可能表征上述的对产物的要求的一部分、全部,也可能不表征上述的对产物的要求。即,这两者可能存在相关性,也可能存在部分相关性,也可能不存在相关性,无特别限定。

作为趋势参数和最终产物参数的一个实例,在将CHO-K1细胞株用于生产单克隆抗体的情况下,将在各阶段中增加的乳酸含量(也记作“Cla”)作为趋势参数,将在各阶段中的目标物质(即单克隆抗体)的最终产量(也记作“Ti”)、纯度(也记作“Pu”)和质量等级(也记作“Qu”)作为最终产物参数。并且,将Cla、Ti、Pu、Qu的权重分别记作W1、W2、W3、W4。在该情况下,各阶段的奖励R=W1*Cla+W2*Ti+W3*Pu+W4*Qu。将各时间点的R累计,得到回报G。将回报G达到最大的模型作为最后训练完毕的双深度Q网络算法模型。

需要注意的是,趋势参数和最终产物参数可以以与状态参数相同的指定间隔进行测定,也可以独立于状态参数的测定而单独测定。例如,在最终产物是细胞分泌物或表达物的情况下,可以仅在细胞培养后期进行趋势参数和最终产物参数的测定。另外,趋势参数的测定和最终产物参数的测定可以一起测定,也可以分别在不同的时间点独立测定。

将状态参数的测得值输入到训练完毕的双深度Q网络算法模型中,得到参数的算得值。需要注意的是,也可以进行前后连续的多次状态参数的测定,将它们的平均值作为状态参数的测得值。例如,可以在某段时间内以均匀或不均匀的指定间隔测定状态参数并求其平均,将所得的平均值作为状态参数的测得值使用。例如,在在线监测环境状态下,状态参数可每小时测定一次,后取每日平均值作为状态参数的测得值,也可以直接使用每小时测定一次而得的值作为状态参数的测得值。或者例如在离线环境状态数据下,可每天测定一次并直接将其作为状态参数的测得值使用。

调整培养体系

根据一个或多个状态参数的算得值分别调整细胞培养体系的一个或多个参数。

状态参数是可以是能够根据模型进行调节的参数,也可以是不能进行调节的参数。例如,作为能够根据模型进行调节的参数,包括但不限于细胞培养体系的pH值、温度,以及例如各种添加的补料和存在于体系中的组分的种类、份量、浓度等。添加的补料和存在于体系中的组分包括但不限于

本领域普通技术人员能够理解的是,在能够根据模型进行调节的参数中,一部分能够上调和下调,另一部分只能够上调而不能够下调。例如,在对体系带来额外影响的情况下,可以通过本领域公知的方法对pH进行上调和下调,这是本领域普通技术人员能够做到的。但是,对于部分添加的补料和存在于体系中的组分而言,仅能够上调,即能够进一步增加而不能够减少其含量或浓度。本领域普通技术人员能够理解的是,有时也存在不能进行调节的状态参数,例如在确定了所要进行的反应以及所要培养/生产的目标物质的情况下,整个反应的容量上限、所要培养的细胞的固有特性如最佳生长温度等。本领域普通技术人员能够根据本领域公知常识确定所使用的状态参数以及该状态参数属于上述哪一类并根据实际进行操作。

在一些实施方式中,当状态参数的算得值大于相应时间点中细胞培养体系的状态参数的测得值时,则将细胞培养体系的状态参数上调至趋近或等于状态参数的算得值;当状态参数的算得值小于相应时间点中细胞培养体系的状态参数的测得值时,则将细胞培养体系的状态参数下调至趋近或等于状态参数的算得值;当状态参数的算得值等于相应时间点中细胞培养体系的状态参数的测得值时,则不调整细胞培养体系的状态参数。

在一些实施方式中,当状态参数的算得值大于相应时间点中细胞培养体系的状态参数的测得值时,则将细胞培养体系的状态参数上调至趋近或等于状态参数的算得值;当状态参数的算得值小于或等于相应时间点中细胞培养体系的状态参数的测得值时,则不调整细胞培养体系的状态参数。

本文所使用的“趋近”是通过调整使状态参数尽可能达到状态参数的算得值,例如达到状态参数的算得值的±10%、±8%、±7%、±6%、±5%、±4.5%、±4%、±3.5%、±3%、±2.5%、±2%、±1.8%、±1.6%、±1.5%、±1.4%、±1.3%、±1.2%、±1.1%、±1%、±0.9%、±0.8%、±0.7%、±0.6%、±0.5%、±0.4%、±0.3%、±0.2%、±0.1%、±0.05%、±0.04%、±0.03%、±0.02%、±0.1%、±0.005%。在一个实例中,例如为±0%,即达到状态参数的算得值。

此处所用的“调整”是指对细胞培养体系进行的操作,包括但不限于加压、减压、加热、冷却、补料种类、补料时间、补料间隔、补料顺序等等。通过所述调整,状态参数被改变或保持。

需要说明的是,在同一次调整中,往往一些状态参数的算得值大于(或小于)相应时间点中细胞培养体系的状态参数的测得值,而另一些状态参数的算得值小于(或大于)相应时间点中细胞培养体系的状态参数的测得值。在这样的情况下,对不同的状态参数分别进行调整,而不会对所有的状态参数进行相同趋势的调整。

重复步骤1)~步骤3)

在具有指定间隔的时间点进行上述步骤1)~步骤3),直至细胞培养过程完毕。图1是采用本发明的模型进行本发明的细胞培养控制方法的示意图。

本领域技术人员可以理解的是,如果如上所述的指定间隔足够长、或细胞培养时间足够短,则在整个细胞培养过程中,存在仅进行一次步骤1)~步骤3)的情况。即,在细胞培养过程中,仅进行一次循环。在该情况下,本领域技术人员可以理解步骤4)是可选的步骤。但是,为了提供更准确的方法,本发明中优选包含步骤4)。

在细胞培养结束后,对湿实验论证与对照的经过三个多月的多轮实验人工筛选出来的最优工艺组合进行比较。本文所用的“湿实验”是指在湿实验室中进行的工作,对“干试验”相对。涉及生物、化学、生态、常规物理的一般都可以划为湿实验,它是化学品,药物或其他物质或生物物质在液体溶液或挥发性相中进行处理,需要直接通风和专用管道设施(通常为水和各种气体)的实验室。而干实验是指在实验室中的计算或应用数学分析在计算机生成的模型上进行的实验。在本发明中,湿实验被用于论证通过本发明的模型所得的(即干实验方法所得的)控制方法。

本发明还提供一种细胞培养控制系统,所述系统包括用于控制细胞培养的装置。所述装置包括用于实现所述用途的硬件、或是软件例如程序、或是以上两者。

在一些实施方式中,所述系统包括:

用于从细胞培养开始起在具有指定间隔的时间点获取参数的测得值的装置1,

用于将参数的测得值输入双深度Q网络算法模型得到参数的算得值的装置2,

用于根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数的装置3;

可选地,还包括用于重复装置1~装置3直至细胞培养结束的装置。

用于从细胞培养开始起在具有指定间隔的时间点获取参数的测得值的装置可包括一个或多个装置、仪器、设备。例如一个或多个的温度测定装置、压力测定装置、pH测定装置、成分测定装置、浓度测定装置、体积测定装置、时间计量和/或控制装置等。其中,时间的计量和/或控制也可以通过人工进行。

用于将参数的测得值输入双深度Q网络算法模型得到参数的算得值的装置可包括一个或多个装置、仪器、设备,例如数字处理装置。在另一些实施方式中,所述数字处理装置包括执行装置功能的一个或多个硬件中央处理器单元(CPU)、通用图形处理单元(GPGPU)、或现场可编程门阵列(FPGA)。在又一些实施方式中,所述数字处理装置还包括配置为执行可执行指令的操作系统。在一些实施方式中,所述数字处理装置任选地与计算机网络连接。在又一些实施方式中,所述数字处理装置任选地与云计算基础架构连接。在其它实施方式中,所述数字处理装置任选地与内联网连接。在其它实施方式中,所述数字处理装置任选地与数据存储装置连接或包括数据存储装置。作为非限制性示例,数字处理装置可以是服务器计算机、台式计算机、膝上型计算机、笔记本计算机。在一些实施方式中,所述数字处理装置包括配置为执行可执行指令的操作系统。操作系统例如是软件,包括程序和数据,用于管理装置的硬件并提供执行应用程序的服务。在一些实施方式中,所述装置包括存储和/或记忆装置。在一些实施方式中,所述双深度Q网络算法模型储存于所述存储和/或记忆装置。在一些实施方式中,所述数字处理装置包括用于接收来自用户的信息的输入装置。在一些实施方式中,所述输入装置的非限制性实例是键盘、鼠标、触摸屏或其组合。

用于根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数的装置可包括一个或多个装置、仪器、设备。例如可进行定量进料的注射器、泵、进液器、管线,调节温度的加热器、制冷器,调节压力的压力阀、进气管、放气阀等。

用于重复从细胞培养开始起在具有指定间隔的时间点获取参数的测得值的步骤、将参数的测得值输入双深度Q网络算法模型得到参数的算得值的的步骤、和根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数的步骤直至细胞培养结束的装置可包括一个或多个装置、仪器、设备,例如控制器、如可编程序控制器。

本发明还提供一种计算机可读存储介质,所述存储介质上存储有指令或计算机程序,当所述指令或计算机程序被处理器执行时,实现下述步骤:

步骤1)从细胞培养开始起,在具有指定间隔的时间点获取参数的测得值,

步骤2)将参数的测得值输入双深度Q网络算法模型得到参数的算得值,

步骤3)根据一个或多个参数的算得值分别调整细胞培养体系的一个或多个参数;

可选地。还包括步骤4)重复步骤1)~步骤3),直至细胞培养结束。

所述存储介质可以是能被计算机访问的任何可用介质。例如,所述计算机可读介质可包括RAM、ROM、EEPROM、CD-ROM或其它光盘存储、磁盘存储或其它磁存储设备、或能被用来携带或存储指令或数据结构形式的合意程序代码且能被计算机访问的任何其它介质。

本方面的细胞培养控制方法和系统能够使用任何合适的生物反应器。例如,所述生物反应器可以包括发酵罐、搅拌罐反应器、贴壁式生物反应器、波型生物反应器、一次性生物反应器等。

所述生物反应器能由各种不同的材料制成。例如,在一些实施方式中,所述生物反应器可由金属(例如,不锈钢)制成。金属生物反应器通常设计为可重复使用。或者,所述生物反应器可包括由刚性聚合物或柔性聚合物膜制成的一次性生物反应器。例如,当由刚性聚合物制成时,所述生物反应器壁能够是独立的。或者,所述生物反应器能够由柔性聚合物膜或形状适应材料制成,该材料能够是液体不可渗透的并且能具有内部亲水性表面。

所述生物反应器可具有任何合适的容积。尤其,在一个实例中,所述生物反应器具有适于实验室小规模生产、中试放大、或实际大型生产的容积。

所述生物反应器可具有各种附加装置,例如,搅拌装置、挡板、鼓泡器、气体供应、热交换器或热循环器端口等,其允许培养和增殖生物细胞。

在一些实施方式中,所述细胞为真核细胞(例如,哺乳动物细胞)或原核细胞。所述哺乳动物细胞能够是例如人或啮齿动物或牛科动物细胞系或细胞株。此类细胞、细胞系或细胞株的实例是例如小鼠骨髓瘤(NSO)-细胞系、中国仓鼠卵巢(CHO)-细胞系、HT1080、H9、HepG2、MCF7、MDBK Jurkat、NIH3T3、PC12、BHK(幼仓鼠肾细胞)、VERO、SP2/0、YB2/0、Y0、C127、L细胞、COS(例如,COS1和COS7)、QC1-3、HEK-293、VERO、PER.C6、HeLA、EBl、EB2、EB3、溶瘤或杂交瘤细胞系。优选地,所述哺乳动物细胞是CHO细胞系。在一些实施方式中,所述细胞是CHO细胞。

在一些实施方式中,所述细胞培养的产物(细胞的表达物或分泌物(例如,重组治疗或诊断产物))。所述细胞培养的产物的实例包括但不限于抗体分子(例如,单克隆抗体、双特异性抗体)、抗体模拟物(与抗原特异性结合但与抗体在结构上无关的多肽分子(例如,DARPin、亲合体、adnectin或IgNAR))、融合蛋白(例如,Fc融合蛋白、嵌合细胞因子)、其他重组蛋白(例如,糖基化蛋白、酶、激素)、病毒治疗剂(例如,抗癌溶瘤病毒、用于基因治疗和病毒免疫治疗的病毒载体)、细胞治疗剂(例如,多能干细胞、间充质干细胞和成体干细胞)、疫苗或脂质包封的颗粒(例如,外泌体、病毒样颗粒)、RNA(例如,siRNA)或DNA(例如,质粒DNA)、抗生素或氨基酸。在一些实施方式中,所述装置、设备和方法能用于生产生物仿制药。

为了验证本发明的细胞培养控制方法的实际效果,在实施例中给出了将其应用于实际生产工艺控制的实施例(湿实验论证)。在该实施例中,为了在培养的指定间隔中获得相应的数据,在指定间隔的时间点获取最终产物参数。在细胞培养结束后,对湿实验论证与对照的经过三个多月的多轮实验人工筛选出来的最优工艺组合进行比较。

实施例

取细胞培养过程中第10、12、14天的1mL细胞液14000g离心5min,将上清保存于-80℃冰箱中,用于HPLC培养物产量(Titer)的测试。取第14天的10mL细胞液3000g离心5min,将上清用0.1微米的滤头过滤后,一步ProA纯化,用于产品纯度和质量(毛细管等电聚焦(cIEF),空间排阻色谱法(SEC),、非还原性SDS Caliper(Caliper SDS_NR),还原性SDSCaliper(Caliper SDS_R),N-聚糖(N-glycan))的测试。

作为传统工艺,选择已通过2个多月的多轮细胞培养工艺开发和优化后的最终15L锁定工艺作为对照工艺。此工艺可认为是人工筛选出来的最优工艺组合(对照)。

作为本发明的控制方法,首先选择CHO-K1细胞株用于生产单克隆抗体,整个细胞培养工艺为14天。设置接种密度为(1±0.1)×10

在接种当天取样、测试,得到模型算得值(模型),将参数pH和温度调整到模型算得值。

开始细胞培养,并根据本发明的细胞培养控制方法对状态参数进行调整,以使实际状态参数尽可能与本发明的控制方法给出的一致。对于只能够上调但不能下调的参数,若测得值(湿实验)低于算得值(模型),则通过添加相应化合物的形式,将该参数调整到算得值。若测得值高于算得值,则不做调整。调节结束后,再进行一次取样、测试,确认当前测得值是否已趋近算得值。最后再将算得值返回到模型中,预测下一天的各参数算得值。如此类推,完成14天的取样、测试、调整、测试、返回模型预测。该过程示意于图2。

以下分别示出模型预测、湿实验论证、对照中每天的各个状态参数。

pH和温度是能够上调也能够下调的参数。在接种当天通过通入CO

温度未作调控,如图4所示。

葡萄糖是只能够上调但不能下调的参数。在Day2、Day4和Day9,通过加入葡萄糖来达到模型的预测值。在Day11通过加入额外2%的补料使葡萄糖浓度达到模型预测值,如图5所示。

钠是只能够上调但不能下调的参数。在Day4、Day9、Day10和Day13,通过添加额外的氯化钠来满足模型的预测值,如图6所示。

谷氨酰胺是只能够上调但不能下调的参数。在Day4和Day9,通过添加额外的谷氨酰胺来满足模型的预测值。在Day11通过加入额外2%的补料使谷氨酰胺浓度达到模型预测值,如图7所示。

在Day4和Day9,通过添加额外的谷氨酸盐来满足模型的预测值。在Day11通过加入额外2%的补料使谷氨酸盐浓度达到模型预测值,如图8所示。

铵是只能够上调但不能下调的参数。在Day2和Day4,通过添加额外的铵来满足模型的预测值,如图9所示。

在本发明实施例中,未对渗透压进行调控,如图10所示。

在本发明实施例中,未对pCO

图12示出进行以上调控后的细胞生长的结果对比。如图12可知,在前期,湿实验论证中的细胞生长与对照相当,后期则低于对照组。

湿实验论证的细胞活率从Day11开始低于对照组(图13),可能是因为额外加入的化合物使细胞代谢增加,补料量不够导致。

图14示出了细胞代谢的结果。本发明中,用乳酸指示细胞代谢。湿实验论证组在Day14出现乳酸堆积的情况(图14),可能是由于后期活率下降引起的。

蛋白表达的结果对比

湿实验论证组Day14的HPLC Titer为3.19g/L,由于培养过程中葡萄糖、NH

对照组Day14的HPLC Titer为3.96g/L,湿实验论证组与对照组的Titer相差7.8%,低于10%。说明该模型足以指导细胞培养工艺,以满足对细胞培养蛋白表达量的要求。

以上蛋白的质量结果汇总于表1。

表1

湿实验论证组Day14的SEC、SDS Caliper_NR&R、N-Glycan_LC以及cIEF的主峰与对照组相当,cIEF酸峰比对照组低。说明该模型在满足细胞培养蛋白表达量要求的同时,不会影响产品质量。

- 培养器装置、细胞培养环境控制系统以及细胞培养环境控制方法

- 一种细胞培养控制方法以及系统