基于自适应随机游走的属性网络表示学习方法

文献发布时间:2023-06-19 09:38:30

技术领域

本发明属于网络表示学习技术领域,涉及到一种基于自适应随机游走的属性网络表示学习方法。

背景技术

网络表示学习算法负责学习网络中每个节点的向量表示,学习到的节点表示可以作为节点的特征应用于后续的网络应用任务,例如节点分类、链接预测任务等。现实生活中网络无处不在,在论文引用关系、万维网、在线社交网络等领域中实体之间的关系都可以建模为网络。然而,在真实系统中,节点通常与大量的属性数据相关联,这些属性通常是对网络的补充。例如,在带有论文摘要的学术网络中,研究方法相似的论文往往会在摘要中多次提到相同的关键词,这些关键词可以作为论文的属性。这些关键词可以在引文网络中给没有引用关系的论文实体建立联系,潜在的显示了实体键的隐式关系。

到目前为止,现有研究方法主要集中关注网络的结构信息,同时忽略了多样的属性内容。比如,经典的网络嵌入方法DEEPWALK通过在同构网络中进行随机游走获得节点序列,并最大化随机游走路径的似然概率来获得节点表示。这一基本思想在很多方面都获得了扩展与应用,但该思想在嵌入属性网络时仍存在一些不足。首先,现有工作主要关注拓扑结构信息中节点的显式关系,忽略了属性网络中由属性引入的隐式关系。其次,采用该思想直接在属性图上进行随机游走不能很好地保留原始属性网络中顶点的长尾分布。最后,由于传统方法在欧氏空间中学习节点间的交互关系,因此其难以学习到属性引入的网络层次信息。因此,如何解决传统方法的不足并有效学习属性网络节点嵌入成为一个至关重要的问题。

发明内容

针对传统方法忽略属性网络中隐式关系和层次结构信息等不足,本文提出新的属性网络嵌入框架——基于自适应随机游走的属性网络表示学习。通过有目的地执行偏向随机游走,生成的顶点序列可以很好地保留属性网络中顶点的分布特性。同时,采用双曲化skipgram模型同时对显式关系和隐式关系进行优化,以实现更低的维数表达属性网络的复杂层次关系。

本发明的技术方案:

一种基于自适应随机游走的属性网络表示学习方法,包括以下步骤:

定义1属性网络G=(V,E,A,E

定义2结构图G

定义3属性-节点二分网络G

定义4结构同构网络G

第一步,根据属性网络结构信息对显式关系采样

为了保留属性网络中的结构相似性,对网络的显式关系(蕴含于结构节点间的直连边E)进行采样;具体的:

构造结构图G

生成显式关系的随机游走序列:通过对网络进行随机游走将网络转换为顶点序列语料库,可有效的捕获高相似度节点的上下文;采用有偏的随机游走算法获取顶点的结构上下文,一定程度上保留节点重要性;

第二步,根据属性网络属性信息对隐式关系采样

现实网络中的节点通常具有丰富的属性信息,这些信息反映了节点间的一些语义关系。因此,保护网络的隐式关系(隐含于节点-属性间的连接Ea)也可以在一定程度上保留节点间的语义相似性。为了对这种高阶隐性关系进行采样,本发明从属性网络中抽离出属性-节点二部图并采用有偏的自适应随机游走算法对二部图网络进行采样。

构造属性-结构节点二分网络G

生成隐式关系的随机游走序列:由于直接在二分网络进行游走生成的节点序列不能很好地保留原始二分网络中定点的长尾分布。为了解决这个问题,本发明将属性-节点二分网络转换为包含结构节点二阶邻近性的同构网络,并在该同构网络上进行有偏随机游走。

构造结构节点同构网络Gv:保留原二分网络中所有的结构节点并根据原二分网络的权值确定新网络中结构节点连边的权值。具体的,

采用有偏自适应随机游走策略对Gv采样:首先,根据每个顶点的中心性来设置从每个顶点开始的随机游走数量。其次,生成具有可变长度的节点序列最终生成不同长度的随机游走序列,更好的保留二分网络的节点分布特征。

第三步,应用双曲化skip-gram模型对采样得到的节点序列进行优化

传统的skip-gram算法可以从大量文本语料中以无监督的方式学习语义知识的,现有研究也将其广泛的应用于网络表示学习中。该模型将网络节点映射到一个新的多维空间,使得在原始网络中相近的节点在该空间内的距离也相近。但传统skip-gram模型在欧氏空间中学习节点间的交互关系,忽略了属性网络中的隶属关系。双曲空间具有表达层次结构的能力,并可以显著降低最终节点表示维度。因此,针对欧式空间中表示学习的不足,本发明采用双曲化skip-gram模型对采样进行优化。

基于网络节点数据建立双曲化skip-gram的神经网络模型:

输入层:从原始网络中建立一个结构节点集,并将每一个结构节点都表示为一个one-hot向量。令该向量作为神经网络的输入向量,并将神经网络输入层单元数量设定为结构节点个数|V|。在隐藏层的计算中,不采用任何激活函数;

隐藏层:令节点表示维度为dim,输入向量维度为|V|。本发明将隐藏层单元数量设为dim,因此隐藏层权值矩阵为|V|*dim。在隐藏层的计算过程中不采用任何激活函数,最终隐藏层权值矩阵为最终节点的表示矩阵;

输出层:输出层是一个softmax回归分类器(softmax regression classifier),包含|V|个输出单位。每个输出神经元都代表网络中的某特定节点,经过计算后每个单元都将产出一个[0,1]之间的数字,表示该单元代表节点与输入节点的共现概率;

根据采样得到的节点序列对模型进行训练:

生成训练样本节点对:选择节点序列中的一个节点作为输入节点input vertex,并定义采样窗口大小为win_size,它代表着从当前input node的两侧选取节点的数量。

通过负采样的方式对神经网络模型进行优化:当用训练样本来训练神经网络时,本发明将输入向量input vertex输入到模型中,期望对应output vertex的神经元结点输出1,其余输出神经元输出0。在这里,期望输出为0的神经元结点所对应的节点被称为负例,期望输出为1的节点被称为正例。根据节点在采样序列中出现的频次选择负例,出现的频次越高,该节点被选为负例的概率越大。通过最大化正例和输入节点的共现概率,最小化负例和输入节点的共现概率对模型进行优化。

本发明的有益效果:针对现有表示学习算法的不足提出了一种新的学习框架,从网络的结构、属性、层次信息中生成网络表示。通过捕获节点-属性二部图网络的高阶相关来保留网络的语义相似性,解决了传统方法忽略网络隐式关系的问题。并针对节点-属性二部图的性质设计有偏自适应随机游走策略,保护了原始二部图定点的分布特性。接着,我们采用双曲化的skip-gram算法学习双曲空间表示,也显著的改善了现有工作忽略属性网络层次信息的缺陷。

附图说明

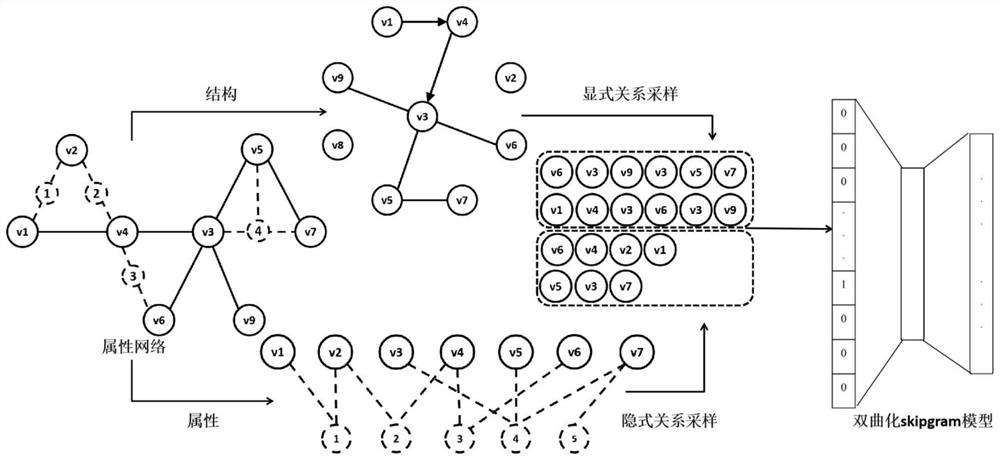

图1是本方法的概念框架。

图2是属性网络G示例图。

图3是结构图G

图4是结构-属性二分网络G

图5是属性-结构节点二分网络G

具体实施方式

为使本发明实施例的目的、技术方案及其优点更加清楚,下面结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚完整的描述。

整体模型概念框架如图1所示,大致流程为:首先对属性网络在结构和属性两个方面进行处理,得到相应的网络结构,再在两网络上进行有偏自适应随机游走,生成的节序列输入双曲化的skip-gram模型中,学习得到节点表示。

第一步,根据属性网络结构信息对显式关系采样

在构造构造结构图G

生成显式关系的随机游走序列:通过对网络进行随机游走将网络转换为顶点序列语料库可以有效的捕获高结构相似度节点的上下文。本发明采用有偏的随机游走算法获取顶点的结构上下文,节点中心性越大,起始于该节点的随机游走数量越多。

第二步,根据属性网络属性信息对隐式关系采样

构造属性-结构节点二分网络G

构造结构节点同构网络Gv:保留原二分网络中所有的结构节点并根据原二分网络的权值确定新网络中结构节点连边的权值。将结构节点连边权值

其中,|A|代表属性网络中属性的数量,

采用有偏自适应随机游走策略对Gv采样:首先,根据每个顶点的中心性来设置从每个顶点开始的随机游走数量。节点中心性越大,起始于该节点的随机游走数量越多。其次,生成具有可变长度的节点序列。设置随机游走停止概率,当随机数超过该概率值时就停止随机游走。最终生成不同长度的随机游走序列。

第三步,应用双曲化skip-gram模型对采样得到的节点序列进行优化

基于网络节点数据建立双曲化skip-gram的神经网络模型,具体的:输入层:从原始网络中建立一个结构节点集,并将每一个结构节点都表示为一个one-hot向量。令该向量作为神经网络的输入向量,并将神经网络输入层单元数量设定为结构节点个数|V|。在隐藏层的计算中,不采用任何激活函数。隐藏层:令节点表示维度为dim,输入向量维度为|V|。本发明将隐藏层单元数量设为dim,因此隐藏层权值矩阵为|V|*dim。在隐藏层的计算过程中不采用任何激活函数,最终隐藏层权值矩阵为最终节点的表示矩阵。输出层:输出层是一个softmax回归分类器(softmax regression classifier),包含|V|个输出单位。每个输出神经元都代表网络中的某特定节点,经过计算后每个单元都将产出一个[0,1]之间的数字,表示该单元代表节点与输入节点的共现概率。

根据采样得到的节点序列对模型进行训练,具体步骤如下:

基于采样序列生成训练样本节点对:选择节点序列中的一个节点作为输入节点input vertex,并定义采样窗口大小为win_size。win_size=4代表着选取input vertex左侧的2个节点和右侧的2个节点作为输出节点output vertex,即最终得到4组(inputvertex,output vertex)形式的节点对作为训练数据。

通过负采样的方式对神经网络模型进行优化:

本发明采用双区空间的hyperboloid模型来学习节点表示。n维双曲几何的hyperboloid模型位于n+1维的闵氏时空。n+1维闵氏时空中的节点由n维欧式空间坐标θ

d

其中,

传统skip-gram模型通过最小化输入节点和上下文节点的共现概率P(v|c

其中,s(c

相应的,一个输入节点c

本发明通过最大化这个概率对节点的表示进行优化,并采用负采样来对优化过程加速。具体的,我们通过以下目标函数来进行优化:

其中,D代表一系列正例节点对,P(c

- 基于自适应随机游走的属性网络表示学习方法

- 一种基于类型与节点约束随机游走的异构网络表示学习方法