一种基于识别技术的无障碍跨平台交流的助残系统

文献发布时间:2023-06-19 19:18:24

技术领域

本发明属于人工智能的技术领域。更具体地,本发明涉及一种基于识别技术的无障碍跨平台交流的助残系统。

背景技术

社会上的残障人士,包括视觉障碍人士、听力障碍人士、语言障碍人士,他们当中有些听不到声音,也无法用口语表达,只能生活在无声的世界里;还有一些视障人士,无法正常地与他人进行交流沟通,造成他们工作、学习、娱乐、就医、维权等生活各方面的困难;使他们在日益激烈的社会竞争中处于严重的劣势中。

现在,有些场合已经出现智能服务系统,给这一部分部分人士提供便利,但是,由于没有考虑到各类人士不同的需求,不能全面提供智能服务,其推广应用受到限制,仍有大部分群众无法享受智能服务带来的便利。

比如,助听器技术能提高听力障碍人士的听觉,但是其效果并不是特别理想,特别当声音发生畸变时,就无法理解语言的含义。又如,视听正常人士就很难理解手语的含义,需要专门配备手语翻译,反之亦然;再比如,听觉障碍人士到电影院看电影,就存在很大困难,因为字幕不一定就是听障人士能够所能理解的文字。

发明内容

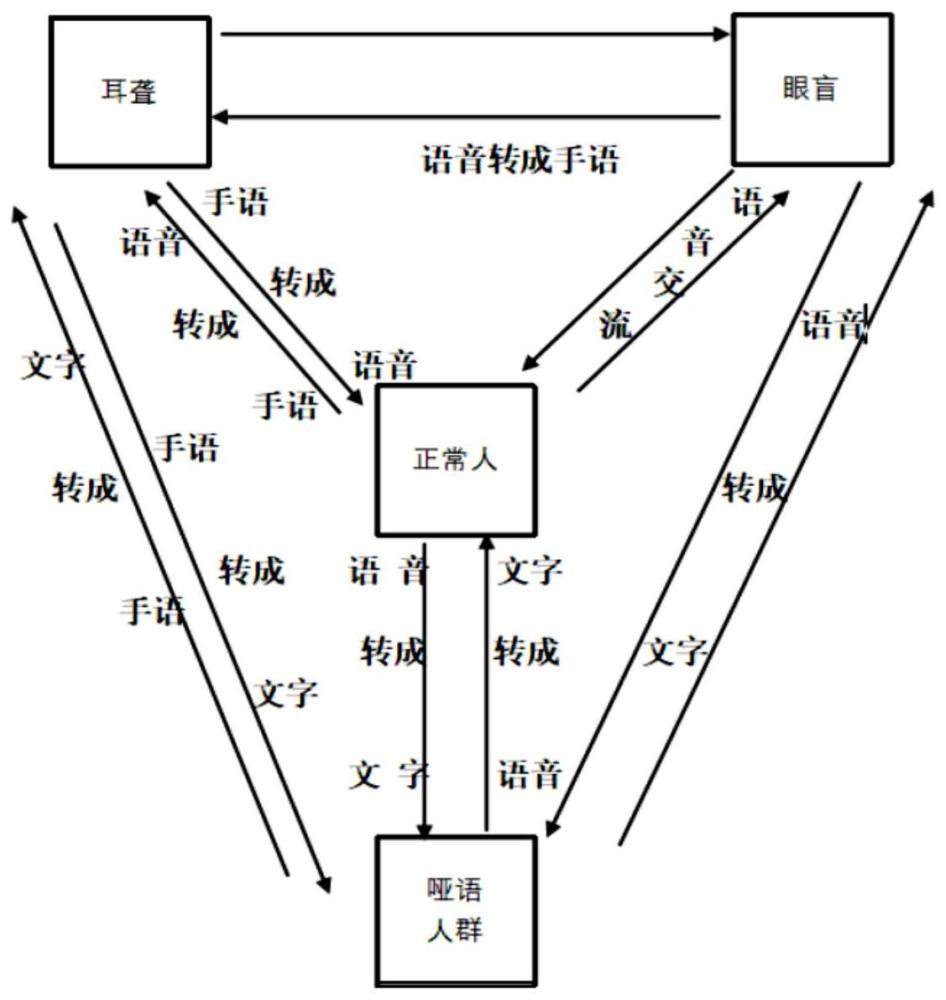

本发明提供一种基于识别技术的无障碍跨平台交流的助残系统,其目的是帮助残障特殊群体与视听正常人之间、残障特殊群体互相之间快捷无障碍交流。

为了实现上述目的,本发明采取的技术方案为:

本发明的基于识别技术的无障碍跨平台交流的助残系统,应用于视觉障碍人士、听力障碍人士、语言障碍人士以及视听正常人士互相之间的交流;所述的助残系统包括以下模块:手语视觉和传感器识别模块、语音转换手语动画技术模块、手语转换文字模块、文字转换语音模块、语音转文字模块、Unity引擎跨平台集成开发技术模块以及机器学习信息处理模块。

所述的助残系统将从设备收集到行为信息、手语信息、文字信息以及语音信息,通过大数据的处理,准确转述为使用者所需要的不同形式信息,使得相应所需要的人可以无障碍的接收信息,进而可以进行无障碍的实时交流;同时,相应的有需要的人群可以将自己向外界传递的信息,通过助残系统转述、翻译成相应可以接收的信息,实现相互的交流,构建不同人群之间无障碍交流的平台。

所述的手语视觉和传感器识别模块基于视觉的识别和基于传感器的识别两类,分别包括摩擦电传感手套、深度学习模块和用户界面,为视听正常人士、听力障碍人士与语言障碍人士的交流提供服务。

所述的语音转换手语动画技术模块采用手语合成技术,将语言转化生成手语动画,即自动翻译自然语言文本句子,并由计算机生成的虚拟“手势”来呈现,以3D虚拟化为听力障碍人士提供可视化服务。

所述的手语转换文字模块将手语直接翻译成语音,其语音运用在智能终端上,语言障碍人士在摄像头前通过手语进行表达,然后系统采用图像识别技术,分析手指和手臂等身体多个部位的肢体运动,将手语翻译成语音,显示在智能终端上。

所述的文字转换语音模块通过识别文字信息,并将其转换成语音信息,并通过智能终端将信息传递信息接收人员。

所述的语音转文字模块采用语音识别技术,支持多种语言识别,实现语音交流,接收语音信息,并翻译成文字,为听力障碍人士提供服务。

所述的Unity引擎跨平台集成开发技术模块借助了MONO实现跨平台交流,Unity的底层是C++,核心是.NET Framework;在Unity中可以使用.NET提供的相关工具。

所述的Unity选用C#作为主要开发语言;Unity还支持Unity Script语言和Boo语言。

所述的机器学习信息处理模块通过大数据的记录、手语图形库的更新,手语识别将会有更多的进展;语音作为声波信息,文字信息、手语作为动态图像信息,实现不同信息的轻松转化。

本发明采用上述技术方案,形成视听残障人士之间以及与视听正常人之间快捷、无障碍跨平台交流的智能服务体系,能够更大程度上方便视听残障人的学习、生活和工作;综合采用现有的语音识别技术、手语识别技术、文字识别技术、Unity引擎跨平台集成开发技术,以及机器深度学习信息处理翻译技术,相互结合,力求达到更精准、更全面、更有效率的智能化服务,更好地为各类人群之间的交流服务。

附图说明

附图所示内容简要说明如下:

图1是本发明的方法流程示意图;

图2是本发明的助残系统功能结构示意图。

具体实施方式

下面对照附图,通过对实施例的描述,对本发明的具体实施方式作进一步详细的说明,以帮助本领域的技术人员对本发明的发明构思、技术方案有更完整、准确和深入的理解。

如图2所示本发明的结构,为一种基于识别技术的无障碍跨平台交流的助残系统。

本发明涉及到关于聋哑人、盲人以及因其他原因而导致无法进行语言沟通的小众群体,是一种高度智能的服务体系,目的是帮助残障特殊群体与正常人之间、残障特殊群体互相之间快捷无障碍交流,以解决在现有系统平台中不能全面提供智能服务问题,以便于更好的为残疾人服务;特别是可以使残障人士能够更好地与正常人交流,提高残障人士的社会参与度。

为了解决现有技术存在的问题并克服其缺陷,实现帮助残障特殊群体与视听正常人之间、残障特殊群体互相之间快捷无障碍交流的发明目的,本发明采取的技术方案为:

所述的助残系统会将从设备收集到的行为信息、手语信息、文字信息以及语音信息等相关信息,通过大数据的处理,准确转述为使用者所需要的不同形式信息,使得相应所需要的人可以无障碍的接收信息,进而可以进行无障碍的实时交流;同时,相应有需要的人群可以将自己向外界所传递的信息通过该系统转述翻译成相应可以接收的信息,实现相互的交流,构建人与人之间无障碍交流的桥梁。

如图1所示,本发明的助残系统主要由软件、硬件组成,二者相辅相成,使其具有以下功能特点:

1、翻译效率和准确率高,以及传递信息及时高效等一系列具有鲜明特色,将行为信息类似手语信息;

2、文字信息、语音信息等相关信息通过本发明的助残系统中大数据的识别记录学习,可准确转述成为另外不同形式信息,并表达给相应残障人士可以无障碍接收信息;

3、残障人士可通过自己的方式向外界传递信息,然后通过本发明的助残系统转述翻译成相应对话者,其包括视听正常人士;不同障碍人士;相同障碍人士。

4、用户使用本发明的助残系统自带的眼镜、即可将所有传递出来的信息进行收集,然后将信息通过云端计算与转换,传入手机中的插件、软件,最后在手机上显示出翻译后的结果,从而实现无障碍交流。

下面对本发明的助残系统的组成模块进行详细分析:

1、手语视觉和传感器识别技术模块:

手语识别在健听人与聋人交流方面发挥了重要的作用。

根据获取手语信息方式的不同,手语识别可分为基于视觉的识别和基于传感器的识别两大类。

目前两类有着很长的研究历程,经过科研人员的不断努力,取得了丰富的科研成果,手语识别技术不断地进步、不断地被优化。

2021年10月份,新加坡国立大学苏州研究院智慧医疗技术卓越研究中心高级研究员李正国团队在国际顶尖学术期刊《自然通讯》(Nature Communications)上发表科研成果,李正国团队成功研发了一种基干摩擦电手套的手语识别和交流系统,该系统收藏成功智能的辅助下,不仅实现了普遍的多个手语单词识别,还能对句子特别是未经人工智能训练的新句子进行解析与翻译,满足了语言、听觉障碍者高频率使用句子的日常交流需求,提高了手语识别系统的实用性。

本发明的助残系统包括摩擦电传感手套、深度学习模块和用户界面。

作为演示,系统实现了对50个单词和20个句子的独立识别,在非分割框架内,其准确率分别高达91.3%和95%。此外,为了克服无法识别未经训练的新句子的局限,分割法将数据集内的句子信号划分为单词片段,深度学习模型则负责记忆所有出现过的单词单元。

得益于单字与句子间的某种关联,单层分类器和多层分类器能够重建并识别数据库内已经存在的句子。同时,分割法还提供了识别未经人工智能训练的新句子的可能性,这些句子中的单词单元都存在于数据库中,但以一种全新的顺序排列。

虚拟现实界面是手语使用者与非使用者的沟通桥梁。在此界面上,语言/听力障碍者可以直接使用手语与非手语使用者进行互动,非手语使用者则能直接打字参与交流。

2、语音转化成手语动画技术模块:

手语合成是指将语言转化生成手语动画,即自动翻译自然语言文本句子,并由计算机生成的虚拟“手势”来呈现,以3D虚拟化为聋人提供可视化支持。

手语合成的研究由来已久,最早可追溯到1982年Shantz和Poizner开发合成美国手语的计算机程序,随后日本、德国、西班牙、中国等也开始了基于本国语言的手语合成研究。

基于中国手语,研究者开展了文本驱动的聋哑人手语合成系统研究、基于虚拟人合成技术的合成方法研究、基于机器学习的语音驱动人脸动画方法研究和多模式行为协同韵律模型、特定内容动画开发手语实践等研究。

近几年来手语合成技术的发展同手语识别一样取得很大进展。例如,华为开发者大会2021(Together)正式发布全新的HMS Core 6,首次采用数字人全程实时手语直播,数字人基于即时听到的语言,通过华为手语服务,实时生成连贯、自然的手语。同时,华为宣布将此能力通过华为手语服务(SignPal Kit)开放出来,让智能惠及全世界的听障群体,让沟通无障碍。

HMS Core 6全新开放的华为手语服务,基于华为自研预训练语言大模型、机器翻译算法、多模态数字人动作生成算法,同时携手信息无障碍研究会、北京师范大学教育学部等权威机构,实现连贯、自然的手语身体姿态,手势动作和表情的生成。华为手语服务词汇量覆盖广,目前已涵盖超10,000个手语词汇,满足生活交流、教育学习、社会资讯获取等众多应用场景。

例如在儿童教育场景,可将特定书籍中的文本翻译成手语,帮助聋哑儿童阅读和学习。

3、手语转化成文字技术模块:

日本电气大学与软银公司联合,通过人工智能AI技术,能将手语直接翻译成日语,并预计在2024年实现普及。届时可帮助日本30多万聋哑人与正常人无碍沟通。

目前该系统只能用于柜台设备上,市政当局希望其终将在智能手机上得到普及。这项技术若是运用在智能手机等终端上,最短可在1秒内完成翻译。

2017年,日本软银公司与日本电气通信大学联合发起这项研究,并与美国谷歌公司出资的日本AI初创企业ABEJA合作。

聋哑人士将能在摄像头前通过手语进行沟通,然后系统用图像识别技术,分析手指和手臂等身体几个部位的骨骼运动,将手势翻译成日文,显示在工作人员的电脑屏幕上,随后口头回复以文本的形式将出现在听障人士面前的屏幕上,使得交流更加顺畅。

4、文字转语音技术模块:

完全成熟化的技术,机器识别成功率和准确率最高的技术,重要的是识别文字信息转换成其他信息,并通过相应的方式将信息转述给其他人。

5、语音转文字技术模块:

通过依托现今比较成熟的语音技术公司的语音技术,例如科大讯飞语音技术,百度语音技术等开发出更为成熟的语音识别技术。不仅支持普通话,还支持国内如粤语,客家话,维吾尔语,藏语,河南话,东北话,同时还支持英语,日语,俄语,西班牙语,葡萄牙等几大国际语言。先适配国内普通话,英语,俄语。在逐步推广到其他小语种,最终成为一个完整的语言体系,实现语音交流接收翻译文字以及的互通有无。

6、Unity引擎跨平台集成开发技术模块:

Unity建立一个简单、易用且跨平台的游戏开发引擎。而当时市面上最好的开发平台就是微软的.NET Framework,由于**.NET只能应用于Windows体系**,所以Unity又借助了MONO来实现了跨平台。Unity的底层是C++,但核心却是.NET Framework,在Unity中是可以使用.NET提供的相关工具的。

.NET Framework:.NET是微软开发的跨语言开发平台,支持二三十种开发语言,用于构建和运行应用程序。这些应用程序只能在Windows体系内使用。

C#(C Sharp):微软专门为.NET推出的高级编程语言。从语言技术、风格、严谨性等特点上来说,C#可称为诸多编程语言中最优秀的一款,甚至由它引发出计算机语言界中的多种新规范和新特征。C#首先发布于2002年,当时公认为C#是.NET大家庭中前景最好的语言,所以Unity选用了C#作为主要开发语言,实际上Unity还支持Unity Script和Boo语言。

MONO:Novell公司支持在其他操作系统下开发.NET程序的框架。Unity借助MONO实现跨平台,核心是.NET Framework框架。

.NET Framework的作用是跨语言开发,MONO的作用的跨平台运行,Unity通过MONO实现了跨平台的发布。实际上Unity只是在早期使用了MONO作为一种工具,而并不是通常所理解的构建于MONO之上。因为基于MONO的层并没有处理很多重要的游戏任务,比如音频、渲染、物理以及时间的跟踪。Unity出于速度的考虑构建了本地C++后端,允许他的用户将MONO作为脚本编写界面,控制该游戏引擎。因此,MONO只是底层Unity引擎的一个组成部分。

具体实现方式

早期的Unity跨平台是基于MONO运行时的,又通过CLS实现了跨语言。MONO是一个开源工程,其中包含C#编译器,CLR运行时,以及一组类库。该工程常见了一系列符合ECMA标准的.NET工具,MONO使得开发者可以使用任何平台开发C#,也可以让C#在不同平台运行。其基本思路是将各个版本的语言统一编译成CIL语言,在不同平台运行时使用CLR进行解释。

总结起来就是1种通用语法、1套固定语句、1种编译器、1套运行时,具体如下:

1种通用语法:通用语言规范(CLS,Common Language System):CLS是一种规范,类似于schema,当文件被指定遵守CLS规范后,在某语言中写出不符合通用规范的代码后将被警告或报错。

1套固定语句:通用中间语言(CIL,Common Intermediate Language):CIL是一种代码指令集,可在任何支持CLI的环境运行。CIL是基于堆栈的,又是面向对象的。

1种编译器:C#编译器:通过编译器将C#代码编译为CIL代码,以供CLR使用。

1套运行时:MONO版通用语言运行库(CLR,Common Language Runtime):由于.NET只能在Windows体系内运行,MONO就提供了一套能够运行在各个平台下的CLR运行时。MONO版本的运行时也就是MONO VM(MONO虚拟机),其提供了即时编译器(JIT)、静态编译器、库加载器、垃圾回收器等功能。

Unity c#编译细节如下:

整个过程一共两次编译:

第一次把多种语言编译为中间语言;

第二次把中间语言结合运行环境生成原生机器码,而在CLR的编译过程中又分为即时编译、静态编译及完全静态编译,分别是:

即时编译(JIT,Just-in-time):程序运行时将IL(中间语言)转为对应平台原生代码,并将原生代码映射到虚拟内存执行。

静态编译(AOT,Ahead-of-time):程序运行之前将.exe火.dll文件中部分转译为目标平台原生码存储。

完全静态编译(Full-AOT,Full-ahead-of-time):程序运行之前,所有代码完全编译为目标平台原生码。完全静态编译(Full-AOT,Full-ahead-of-time):程序运行之前,所有代码完全编译为目标平台原生码。

JIT是运行时编译的,解释一条执行一条,解释过的语句会缓存,不重复解释,效率较低。

IOS不允许JIT动态编译,所以MONO只能以Full-AOT模式运行(即将程序集所有CIL代码进行AOT编译生成本地机器码),Full-AOT模式下,泛型、反射空类型等功能可能会有问题,不允许动态生成代码,不允许动态创建类型,无法使用DLR(Dynamic Language Runtime动态语言运行时)。

AOT与JIT并非对立,AOT同样采用JIT编译,只不过是运行前就编译好了。

CLR涉及概念:

CLI(Common Language Infrastructure)通用语言基础结构:CLI是CLR的子集,主要包括类加载器、实时编译器以及GC垃圾回收,CLI是CLR的灵魂,是CIL的摇篮。

CTS(Common Type System)通用类型系统,CTS是CLI的一部分,描述了各种类型应该具有怎样的行为以及可以拥有什么样的成员,CTS是一种规范,是CLR实现的依据。CLS是CTS的一部分,描述了一个框架语言需要拥有的最小集功能。

VES(虚拟执行系统)负责为某种语言在执行时提供一切必须的上下文和内存、线程管理、字符串驻留、垃圾回收、即时编译等服务,CLR是VES的一个实现,可以用运行时(Runtime)代称,一个VES可以提供上述所有服务,也可以只提供部分服务。

7、机器学习信息处理翻译技术模块:

通过大数据的记录,手语图形库的更新,手语识别将会有更多的进展,三种信息,语音作为声波信息,文字信息,手语作为动态图像信息,三种技术都有一定的不同程度的发展,相信他们三种技术的交汇融合也并非难事。终究会实现信息的轻松转化。

本发明就是这三种技术融合发展在一起便利三类常见残疾人,拉近他们之间和他们与普通人的距离。本发明的助残系统配合硬件,跨越信息差障碍,实现无碍交流。

上面结合附图对本发明进行了示例性描述,显然本发明具体实现并不受上述方式的限制,只要采用了本发明的方法构思和技术方案进行的各种非实质性的改进,或未经改进将本发明的构思和技术方案直接应用于其它场合的,均在本发明的保护范围之内。

- 一种基于大数据的交流方身份反欺诈识别方法及其系统

- 一种基于图像识别技术的菜品识别系统和方法

- 一种基于模式识别技术的助残无障碍交流系统

- 一种基于模式识别技术的助残无障碍交流系统