一种基于BERT的违规文本识别算法及装置

文献发布时间:2023-06-19 11:32:36

技术领域

本申请设计人工智能领域,具体设计大数据和深度学习技术领域,提供一种基于BERT的违规文本识别算法及装置。

背景技术

互联网作为人们获取信息的重要工具,随着互联网的发展,在互联网上发布信息的门槛越来越低,从而导致互联网上充斥着大量不适合展示给用户的违规文本,违规文本识别就是在海量的文本中找出那些违规文本。

现有技术中,一般采用关键词匹配算法识别互联网上的违规文本,采用关键词匹配算法需要预设一些敏感词,然后再通过关键词匹配算法提取出包含敏感词的句子,作为敏感文本。但是,采用关键词匹配算法识别敏感文本时,只是简单筛选出敏感文本,由于敏感词所处的上下文不同,敏感文本未必是违规文本,所以关键词匹配算法的识别结果会包含大量的非违规文本,误报数量较大。

为了减少违规文本的误报数量,现有技术中,还会在关键词匹配算法的基础上使用的情感分析方法,通过判断敏感文本的正负情感倾向,进一步判断关键词匹配算法识别的敏感文本是否为违规文本。情感分析模型通过对文本进行情感分析,识别出违规的文本,虽然能够大幅度减少误报句子的数量,但是,情感分析模型的鲁棒性较强,需要收集大量含有违规词的句子(包括正向和负向句子),才能训练出情感分析模型,因此,数据收集和标注的时间成本较高。

发明内容

本申请提供一种基于BERT的违规文本识别算法及装置,以提供一种准确性更高,识别效率更高的文本识别方法及装置。

本申请第一方面提供一种基于BERT的违规文本识别算法,所述一种基于BERT的违规文本识别算法包括:

获取待识别文本;

利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本,敏感文本是指包含至少一个预设关键词的待识别文本;

将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布,所述概率分布包括非违规概率和至少一项违规概率;

若所述敏感文本对应的概率分布中存在处于预设的违规区间且大于非违规概率的违规概率,则将所述敏感文本标记为违规文本;

若所述敏感文本对应的概率分布中存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,则将所述敏感文本标记为待定文本;所述判定阈值为预设的违规区间的区间下限;

提取所述待定文本的特征向量,并对所述特征向量进行非违规基准运算和至少一项违规基准运算,获得非违规相似度和至少一项违规相似度;

判断非违规相似度的数值是否大于任意一项违规相似度的数值,若非违规相似度的数值大于任意一项违规相似度的数值,则将所述待定文本标记为非违规文本;若非违规相似度的数值小于或等于任意一项违规相似度的数值,则将所述待定文本标记为违规文本。

可选的,所述非违规基准运算为对所述特征向量和非违规基准向量进行相似度计算,所述非违规基准向量为

所述违规基准运算为对所述特征向量和违规基准向量进行相似度计算,所述违规基准向量为

可选的,所述BERT文本识别模型通过以下步骤建立:

获取待识别文本,将所述待识别文本标记为违规文本或非违规文本;

将违规文本随机分为两个集合,以及将非违规文本随机分为两个集合;

利用一个集合的违规文本和一个集合的非违规文本,建立训练集;利用另一个集合的违规文本和另一个集合的非违规文本,建立测试集;

利用训练集,并采用标签反向传播和梯度下降法,对神经网络模型进行训练;

利用测试集测试训练后的神经网络模型精度,获得BERT文本识别模型。

可选的,在所述将敏感文本输入到预先建立的BERT文本识别模型的步骤之前,还包括:对所述敏感文本预处理;

所述预处理为:

去除所述敏感文本的标点符号和英文字符,获得纯汉字文本;

将所述纯汉字文本中的繁体中文转换成简体中文,获得简体中文文本;

对所述简体中文文本进行向量化,获得预处理后的敏感文本。

本申请第二方面提供一种基于BERT的违规文本识别装置,所述一种基于BERT的违规文本识别装置用于执行权利要求1-4任一项所述的一种基于BERT的违规文本识别算法,包括:

数据获取模块,用于获取待识别文本;

关键词匹配模块,用于利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本;

初步分类模块,存储有预先建立的BERT文本识别模型,用于将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布;

违规文本标记模块,用于判断所述敏感文本对应的概率分布中是否存在处于预设的违规区间且大于非违规概率的违规概率,若所述敏感文本对应的概率分布中存在处于预设的违规区间且大于非违规概率的违规概率,则将所述敏感文本标记为初步违规文本;以及,还用于判断所述敏感文本对应的概率分布中是否存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,若所述敏感文本对应的概率分布中存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,则将所述敏感文本标记为待定文本;

相似度过滤模块,用于提取所述待定文本的特征向量,并对所述特征向量进行非违规基准运算和至少一项违规基准运算,获得非违规相似度和至少一项违规相似度;还用于判断非违规相似度的数值是否大于任意一项违规相似度的数值,若非违规分布相似度的数值大于所有的违规相似度的数值,则将所述待定文本标记为违规文本;若非违规分布相似度的数值小于或等于任意一项违规相似度的数值,则将所述待定文本标记为非违规文本。

可选的,还包括BERT模型建立模块,用于生成所述预先建立的BERT文本识别模型。

本申请第三方面提供一种计算机设备,包括:

存储器,用于存储计算机程序;

处理器,用于执行所述计算机程序时实现本申请第一方面提供的一种基于BERT的违规文本识别算法的步骤。

本申请第四方面提供一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理执行时实现本申请第一方面提供的一种基于BERT的违规文本识别算法的步骤。

本申请提供的一种基于BERT的违规文本识别算法及装置,所述一种基于BERT的违规文本识别装置用于执行所述一种基于BERT的违规文本识别算法的步骤,在利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本;将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布;对所述敏感文本进行概率分布分析及阈值过滤,获得一部分的违规文本;以及对敏感文本进行概率分布分析,获得待定文本,即通过BERT文本识别模型也无法准确分类的文本,通过对所述待定文本进行相似度过滤,确定所述待定文本标记是否为违规文本。

本申请实施例提供的违规文本识别算法,结合关键词匹配算法,通过概率分布的分析与阈值过滤,以及相似度过滤的纠错,有效提高了违规文本识别的准确性,与单一情感分类方法相比,所花费的人力成本和时间成本更低,具有更高的文本识别效率。

附图说明

为了更清楚地说明本申请的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

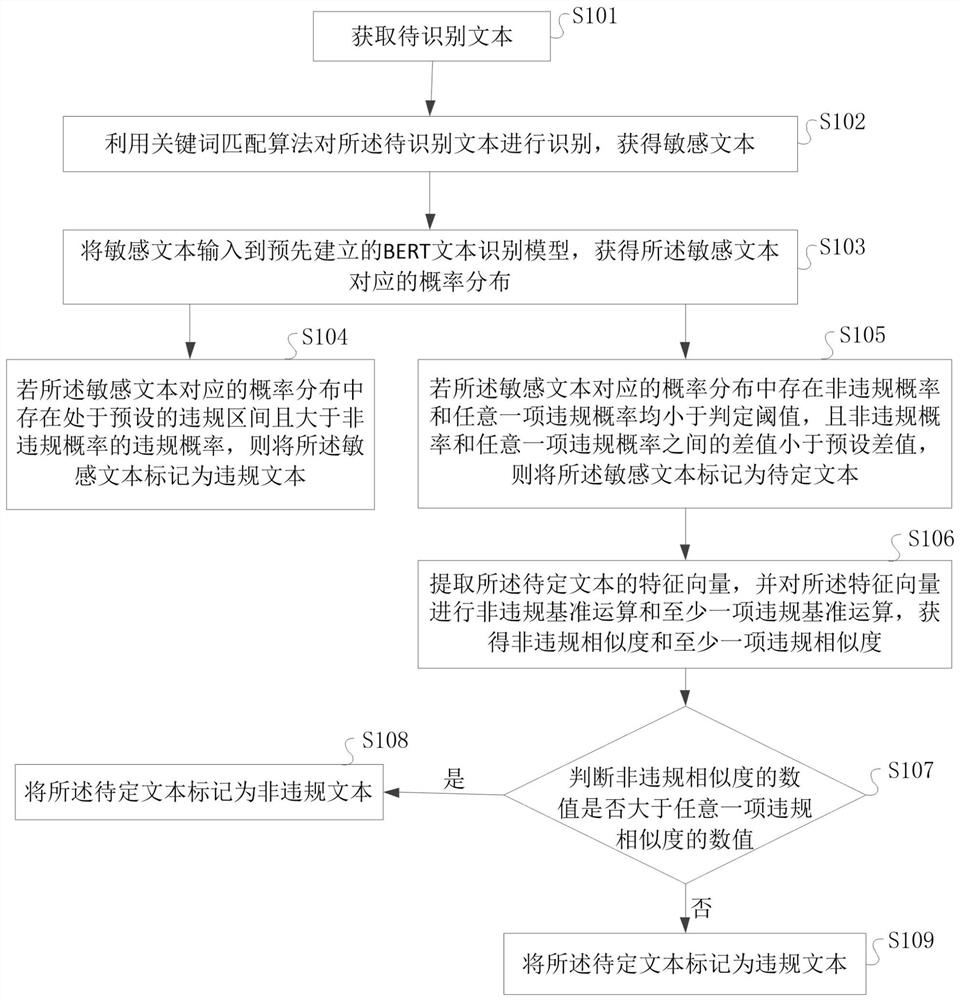

图1为本申请实施例提供的一种基于BERT的违规文本识别算法的流程示意图;

图2为本申请实施例提供的所述BERT文本识别模型建立流程示意图;

图3为本申请实施例提供的一种基于BERT的违规文本识别装置的结构示意图。

具体实施方式

如图1所示,为本申请实施例提供的一种基于BERT的违规文本识别算法的流程示意图,所述一种基于BERT的违规文本识别算法包括步骤S101至步骤S109。

步骤S101,获取待识别文本。

所述待识别文本为从互联网上爬取的文本数据,包括违规文本和非违规文本,本申请实施例的目的是从待识别文本中找出违规文本。

步骤S102,利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本。

其中,所述敏感文本是指包含至少一个预设关键词的待识别文本。

步骤S103,将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布。

其中,所述概率分布包括非违规概率和至少一项违规概率,所述BERT文本识别模型可以根据敏感文本输出敏感文本对应的概率分布,所述非违规概率表示敏感文本为非违规文本的概率值,所述违规概率表示敏感文本为违规文本的概率值,需要说明的是,违规文本可以根据需要设置多个类别,相对应的违规概率也可以存在多个类别。例如,在一种场景下,将违规文本细分为A文本和B文本,则相对应的,违规概率也细分为A文本概率和B文本概率。

如图2所示,为本申请实施例提供的所述BERT文本识别模型建立流程示意图;所述BERT 文本识别模型通过步骤S201至步骤S205建立:

步骤S201,获取待识别文本,将所述待识别文本标记为违规文本或非违规文本。

例如,将待识别文本中的A文本标记为0、B文本标记为1、非违规文本标记为2,

步骤S202,将违规文本随机分为两个集合,以及将非违规文本随机分为两个集合。

在违规文本细分为A文本和B文本的情况下,对用的需要将A文本随机分为两个集合,例如集合1和集合2,以及将B文本随机分为两个集合,例如集合3和集合4。然后将集合1和集合3合并,组成一个违规文本集合,将集合2和集合4合并,组成另一个违规文本集合。

步骤S203,利用一个集合的违规文本和一个集合的非违规文本,建立训练集;利用另一个集合的违规文本和另一个集合的非违规文本,建立测试集。

步骤S204,利用训练集,并采用标签反向传播和梯度下降法,对神经网络模型进行训练。

神经网络模型在训练时会将训练集数据转化成向量,然后通过神经网络参数计算,对每条数据给出一个概率分布,而概率分布的正确与否依靠标签(0,1,2)来判断,接着神经网络模型根据标签进行反向传播并使用梯度下降法来调整神经网络的的参数,使神经网络模型下一次的预测结果更加准确。

步骤S205,利用测试集测试训练后的神经网络模型精度,获得BERT文本识别模型。

训练完成后,神经网络模型模型能够对训练集的数据做出很精准的预测,即A文本对应输出的概率分布中,A文本概率的数值最大,非违规文本对应输出的概率分布中非违规概率的数值最大,B文本对应输出的概率分布中B文本概率最大。然后为了评估神经网络模型模型的泛化能力,用测试集中数据进行预测(此时神经网络模型模型不再训练),其目的是为了验证模型对未见过的数据预测效果如何,由此来判断模型的优劣,在满足神经网络模型精度的情况下,获得BERT文本识别模型。

步骤S104,若所述敏感文本对应的概率分布中存在处于预设的违规区间且大于非违规概率的违规概率,则将所述敏感文本标记为违规文本。

为了更清楚的说明本申请实施例保护的技术方案,现举例进行说明,违规文本细分为A 文本和B文本,输出概率分布为(A文本概率、B文本概率、非违规概率),违规区间细分为 A文本区间[0.40,0.934]和B文本区间[0.40,0.952]。

例如,敏感文本对应的概率分布为(0.12,0.51,0.37),其中存在一项违规概率(B文本概率)处于预设的违规区间(B文本区间)且大于非违规概率的违规概率,所以将敏感文本标记为违规文本。

又例如,敏感文本对应的概率分布为(0.35,0.49,0.16),存在违规概率处于预设的违规区间且大于非违规概率的违规概率,所以将敏感文本标记为违规文本。

又例如,敏感文本对应的概率分布为(0.94,0.0.02,0.04),存在一项违规概率(B文本概率)大于非违规概率的违规概率,但是超出预设的违规区间(B文本区间),所以将敏感文本标记为非违规文本。需要说明的是,这里设置的违规区间的区间上限,为阈值过滤方法,例如,在本例中,A文本阈值过滤的阈值为0.934,B文本阈值过滤的阈值为0.952。

又例如,敏感文本对应的概率分布为(0.14,0.0.41,0.45),不存在违规概率处于预设的违规区间且大于非违规概率的违规概率,所以将敏感文本标记为非违规文本。

本申请实施例中,主要目的是识别出违规文本,当确定敏感文本为非违规文本后,也可以不对敏感文本进行标记,直接将其在互联网上对应的数据放行。

步骤S105,若所述敏感文本对应的概率分布中存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,则将所述敏感文本标记为待定文本。

其中,所述判定阈值为预设的违规区间的区间下限,在本申请实施例中,违规区间的区间下限为0.40,预设差值为0.5。

为了更清楚的说明本申请实施例保护的技术方案,现举例进行说明,违规文本细分为A 文本和B文本,输出概率分布为(A文本概率、B文本概率、非违规概率),违规区间细分为 A文本区间[0.40,0.934]和B文本区间[0.40,0.952]。

例如,敏感文本对应的概率分布为(0.32,0.35,0.33),非违规概率和违规概率均小于 0.4,且非违规概率与违规概率较为接近,非违规概率和任意一项违规概率之间的差值均小于 0.5,则将所述敏感文本标记为待定文本。

步骤S106,提取所述待定文本的特征向量,并对所述特征向量进行非违规基准运算和至少一项违规基准运算,获得非违规相似度和至少一项违规相似度。

其中,所述非违规基准运算为对所述特征向量和非违规基准向量进行相似度计算;所述违规基准运算为对所述特征向量和违规基准向量进行相似度计算。

具体的,在BERT文本识别模型训练前,会将待识别文本(标记为违规文本和非违规文本) 转换为向量进行模型训练,通过对所有非违规本文对应的向量求和取平均,获得非违规基准向量,并采用相同的方法获得违规基准向量,具体表现形式如下:

所述非违规基准向量为

步骤S107,判断非违规相似度的数值是否大于任意一项违规相似度的数值。

步骤S108,若非违规相似度的数值大于任意一项违规相似度的数值,则将所述待定文本标记为非违规文本。

步骤S109,若非违规相似度的数值小于或等于任意一项违规相似度的数值,则将所述待定文本标记为违规文本。

通过比较非违规相似度的数值与任意一项违规相似度的数值大小,如果所述非违规相似度的数值最大,则将所述待定文本标记为非违规文本,如果所述非违规相似度的数值不是最大的,即至少存在一项违规文本的相似度数值大于非违规相似度的数值,则将所述待定文本标记为违规文本。

进一步的,在所述将敏感文本输入到预先建立的BERT文本识别模型的步骤之前,还包括:对所述敏感文本预处理;具体为:去除所述敏感文本的标点符号和英文字符,获得纯汉字文本;将所述纯汉字文本中的繁体中文转换成简体中文,获得简体中文文本;对所述简体中文文本进行向量化,获得预处理后的敏感文本。

本申请实施例第二方面提供一种基于BERT的违规文本识别装置,用于执行本申请实施例第一方面提供的一种基于BERT的违规文本识别算法,对于本申请实施例第二方面提供的识别装置中为公开的细节,请参见本申请实施例第一方面提供的违规文本识别算法。

如图3所示,为本申请实施例提供的一种基于BERT的违规文本识别装置的结构示意图。所述一种基于BERT的违规文本识别装置包括数据获取模块、关键词匹配模块、初步分类模块、违规文本标记模块和相似度过滤模块。

数据获取模块,用于获取待识别文本。

关键词匹配模块,用于利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本。

初步分类模块,存储有预先建立的BERT文本识别模型,用于将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布。

违规文本标记模块,用于判断所述敏感文本对应的概率分布中是否存在处于预设的违规区间且大于非违规概率的违规概率,若所述敏感文本对应的概率分布中存在处于预设的违规区间且大于非违规概率的违规概率,则将所述敏感文本标记为初步违规文本;以及,还用于判断所述敏感文本对应的概率分布中是否存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,若所述敏感文本对应的概率分布中存在非违规概率和任意一项违规概率均小于判定阈值,且非违规概率和任意一项违规概率之间的差值小于预设差值,则将所述敏感文本标记为待定文本。

相似度过滤模块,用于提取所述待定文本的特征向量,并对所述特征向量进行非违规基准运算和至少一项违规基准运算,获得非违规相似度和至少一项违规相似度;还用于判断非违规相似度的数值是否大于任意一项违规相似度的数值,若非违规分布相似度的数值大于所有的违规相似度的数值,则将所述待定文本标记为违规文本;若非违规分布相似度的数值小于或等于任意一项违规相似度的数值,则将所述待定文本标记为非违规文本。

进一步的,所述一种基于BERT的违规文本识别装置还包括BERT模型建立模块,用于生成所述预先建立的BERT文本识别模型。

进一步的,所述一种基于BERT的违规文本识别装置还包括预处理模块,所述预处理模块用于对所述敏感文本进行预处理,获得预处理后的敏感文本。

本申请实施例第三方面提供一种计算机设备,包括:存储器,用于存储计算机程序;处理器,用于执行所述计算机程序时实现本申请实施例第一方面提供的一种基于BERT的违规文本识别算法的步骤。

本申请实施例第四方面提供一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理执行时实现本申请实施例第一方面提供的一种基于 BERT的违规文本识别算法的步骤。

本申请实施例提供的一种基于BERT的违规文本识别算法及装置,所述一种基于BERT的违规文本识别装置用于执行所述一种基于BERT的违规文本识别算法的步骤,在利用关键词匹配算法对所述待识别文本进行识别,获得敏感文本;将敏感文本输入到预先建立的BERT文本识别模型,获得所述敏感文本对应的概率分布;对所述敏感文本进行概率分布分析及阈值过滤,获得一部分的违规文本;以及对敏感文本进行概率分布分析,获得待定文本,即通过BERT 文本识别模型也无法准确分类的文本,通过对所述待定文本进行相似度过滤,确定所述待定文本标记是否为违规文本。

本申请实施例提供的违规文本识别算法,结合关键词匹配算法,通过概率分布的分析与阈值过滤,以及相似度过滤的纠错,有效提高了违规文本识别的准确性,与单一情感分类方法相比,所花费的人力成本和时间成本更低,具有更高的文本识别效率。

以上结合具体实施方式和范例性实例对本申请进行了详细说明,不过这些说明并不能理解为对本申请的限制。本领域技术人员理解,在不偏离本申请精神和范围的情况下,可以对本申请技术方案及其实施方式进行多种等价替换、修饰或改进,这些均落入本申请的范围内。本申请的保护范围以所附权利要求为准。

- 一种基于BERT的违规文本识别算法及装置

- 一种基于BERT的短文本匹配方法及装置