一种结合联邦学习与用户画像的个性化模型训练方法及系统

文献发布时间:2023-06-19 09:49:27

技术领域

本发明涉及计算机技术领域,特别是涉及一种机器学习中结合联邦学习与用户画像的个性化模型训练方法及系统。

背景技术

随着计算机技术的发展,以机器学习为主导的人工智能方法迅速统治了算法领域。然而数据作为机器学习算法研究的直接驱动,来源常为多方,不同数据源之间存在数据孤岛效应。为有效利用多方数据,联邦学习成为一种新的解决方案。

联邦学习作为分布式机器学习领域的一个分支,是在保护用户隐私的前提下进行模型训练的有效方案,主要思想是仅仅在参与方和服务器间传输模型参数,而不进行参与方数据的共享,同时在模型参数传输中加入差分隐私、同态加密等方法,实现了对数据隐私的保护。然而一般的联邦学习方法,在参数聚合过程中直接进行参数的平均,难以评估每个参与方参数对模型的贡献,同时训练结果为各个参与方通用的公有模型,难以利用参与方的个性化数据,很难满足有针对性的用户个性化需求。

发明内容

本发明提供了机器学习中一种结合联邦学习与用户画像的个性化模型训练方法及系统,以解决现有技术中对用户隐私保护和个性化模型设置不能兼顾的问题。

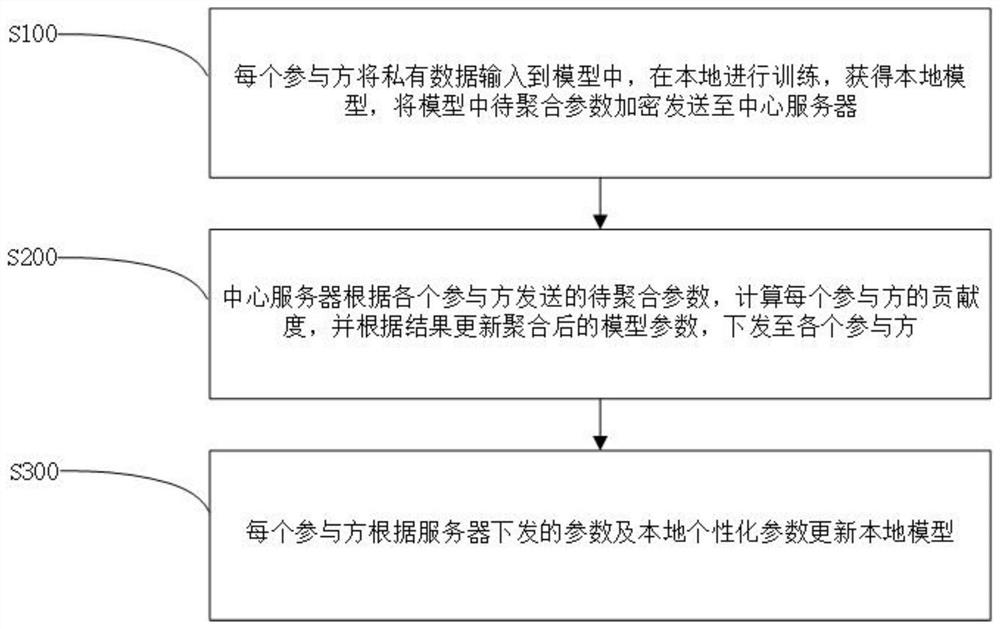

第一方面,本发明实施例提供了一种结合联邦学习与用户画像的个性化模型训练方法,所述方法包括:每个参与方将私有数据输入到模型中,在本地进行训练,获得本地模型,将模型中待聚合参数加密发送至中心服务器;中心服务器根据各个参与方发送的待聚合参数,计算每个参与方的贡献度,并根据结果更新聚合后的模型参数,下发至各个参与方;每个参与方根据服务器下发的参数及本地个性化参数更新本地模型。

可选地,所述参与方包括每个参与联邦机器学习模型训练的用户,所述私有数据包括但不限于储存在所述参与方用户端上的主任务训练数据、用户行为特征数据、用户身份特征数据,

可选地,所述每个参与方将私有数据输入到模型中,在本地进行训练,获得本地模型,将模型中待聚合参数加密发送至中心服务器的步骤包括:每个参与方将私有数据输入到模型中,在本地进行模型训练,获得本地模型;基于在本地训练得到的输出,将待聚合参数加密并发送至联邦学习中心服务器,

可选地,所述每个参与方将私有数据输入到模型中,在本地进行模型训练,获得本地模型的步骤包括:将参与方本地模型分为用户画像模块和主任务模块,参与方用户端将用户行为特征数据、用户身份特征数据输入到不参与联邦学习的用户画像模块,本地训练并得到本地个性化参数;将主任务训练数据输入到主任务模块,本地训练并得到主任务参数;将用户画像模块与主任务模块得到的输出输入到整合输出模块,其输出与主任务参数共同作为待聚合参数;

可选地,所述中心服务器根据各个参与方发送的待聚合参数,计算每个参与方的贡献度,并根据结果更新聚合后的模型参数,下发至各个参与方的步骤包括:中心服务器接收每个参与方发送的待聚合参数,根据每个参与方待聚合参数与全局参数的差异,计算每个参与方对全局模型的贡献度;中心服务器根据每个参与方对全局模型的贡献度,加权聚合所述待聚合参数,并将聚合后参数下发至各个参与方,

可选地,所述主任务模块包括但不限于点击预测模块、推荐模块,所述主任务训练数据包括但不限于点击记录数据、浏览记录数据、使用记录数据。

第二方面,本发明提供了一种机器学习中个性化模型训练系统,所述个性化模型训练系统包括参与方用户端和中心服务器端:

所述参与方用户端包括:用户画像模块,用于处理用户身份特征数据、用户行为特征数据,本地训练并生成用户画像;主任务模块,用于处理主任务训练数据,训练并生成本地待聚合模型,管理参与联邦学习的参数收发;整合输出模块,用于整合主任务模块和用户画像模块的输出,输入主任务参数和本地个性化参数,实现本地个性化模型的更新;

所述中心服务器端包括:联邦控制模块,用于管理联邦学习的相关配置,参数收发;贡献计算模块,用于计算每个参与方对全局模型的贡献度;参数聚合模块,用于生成全局模型,根据贡献计算模块输出结果,加权聚合联邦参数;

本发明有益效果如下:

本发明通过在联邦机器学习模型训练的过程中,将参与方本地模型划分为参与联邦学习的主任务模块和不参与联邦学习的用户画像模块,参与方本地独立训练用户画像模型,同时基于联邦学习的方法联合各个参与方,在不上传私有数据,仅仅发送加密后的联邦参数的前提下,共同训练机器学习的主任务模型,解决现有技术中对于用户隐私数据的保护和个性化的模型设置不能兼顾的问题。

上述说明仅是本发明技术方案的概述,为了能够更清楚了解本发明的技术手段,而可依照说明书的内容予以实施,并且为了让本发明的上述和其它目的、特征和优点能够更明显易懂,以下特举本发明的具体实施方式。

附图说明

通过阅读下文优选实施方式的详细描述,各种其他的优点和益处对于本领域普通技术人员将变得清楚明了。附图仅用于示出优选实施方式的目的,而并不认为是对本发明的限制。而且在整个附图中,用相同的参考符号表示相同的部件。在附图中:

图1是本发明实施例一的一种结合联邦学习与用户画像的个性化模型训练方法的流程图;

图2是本发明的联邦学习示意图;

图3是本发明实施例二的一种结合联邦学习与用户画像的个性化模型训练系统的具体结构框图;

具体实施方式

本发明实施例针对现有技术中对于用户隐私数据的保护和个性化的模型设置不能兼顾的问题,提出一种结合联邦学习与用户画像的个性化模型训练方法和系统。参照图1,图1是本发明实施例一的一种结合联邦学习与用户画像的个性化模型训练方法的流程图。在由若干个参与方共同参与的联邦学习模型训练过程中,每一个参与方在本地使用其私有数据进行本地模型训练并得到本地模型,并将所述本地模型中的待聚合参数加密发送到中心服务器。由中心服务器计算每个参与方的贡献度,并根据结果更新聚合后的模型参数,重新下发至各个参与方。每个参与方利用中心服务器下发的聚合后参数和本地的个性化参数更新本地模型。以下结合附图以及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不限定本发明。

参照图2,图2是本发明的联邦学习示意图。

如图2所示,该结合联邦学习与用户画像的个性化模型设备可以包括:中心服务器与多个参与方,以及实现中心服务器与各参与方之间稳定通信的通信线路。

需要注意的是,在本发明实施例中,各参与方之间的数据与模型参数均不共享,即仅有参与方和中心服务器之间存在通信,因此通信线路仅存在于参与方和中心服务器之间。

本发明实施例所述的参与方用户端的联邦设备可以但不限于个人电脑(PC)、平板电脑、智能手机、家用智能电器、智能汽车、路由器等,所述联邦设备的特点在于保留了参与用户的用户画像以及具有特定的个性化推荐、预测等机器学习训练任务需求。

可选地,该结合联邦学习与用户画像的个性化模型训练设备还可以包括矩形用户接口、网络接口、摄像头、RF(Radio Frequency,射频)电路,传感器、音频电路、WiFi模块等等。矩形用户接口可以包括显示屏(Display)、输入子模块比如键盘(Keyboard),可选矩形用户接口还可以包括标准的有线接口、无线接口。网络接口可选的可以包括标准的有线接口、无线接口(如WIFI接口)。

本领域技术人员可以理解,图2中示出的结合联邦学习与用户画像的个性化模型训练方法及系统的设备结构并不构成对本发明设备的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。具体地,中心服务器可以作为参与方之一,共同完成该发明流程,参与方中也可以有部分公开数据,即本发明可以适应不同的参与方与中心服务器特性组合。

本发明第一实施例提供了一种结合联邦学习与用户画像的个性化模型训练方法,该方法具体步骤包括:

S100、每个参与方将私有数据输入到模型中,在本地进行训练,获得本地模型,将模型中待聚合参数加密发送至中心服务器;

其中,所述参与方包括每个参与联邦机器学习模型训练的用户,所述私有数据包括但不限于储存在所述参与方用户端上的主任务训练数据、用户行为特征数据、用户身份特征数据,所述本地模型包括用户画像模块、主任务模块和整合输出模块,所述待聚合参数包含本地训练后得到的主任务模块参数和整合输出模块参数。

S101、在所述参与方内,将每个参与方的私有数据输入到本地模型中,得到本地的模型参数;

其中,本发明实施例中,参与方将本地收集的用户行为特征数据、用户身份特征数据输入到本地待训练机器学习模型的用户画像模块,得到本地个性化参数。将主任务训练数据输入主任务模块,得到主任务参数;将用户画像模块与主任务模块得到的输出输入到整合输出模块,其输出与主任务参数共同作为待聚合参数;模型本地训练过程的目标为实现模型收敛,需设定第一预设值作为主任务模块的损失函数目标、第二预设值作为整合输出模块的损失函数目标。

需要说明的是,本发明实施例中的所述主任务各参与方均相同,且所述主任务模型是由主任务来确定的,各参与方的主任务模型相同。本发明实施例中所述主任务类型包括但不限于:推荐任务、键盘预测任务、点击预测任务等等,所述主任务训练数据包括但不限于点击记录数据、浏览记录数据、输入记录数据、使用记录数据。具体实施时,本领域技术人员可以根据实际需要进行设置,本发明对此不作具体限定。

其中,所述参与方私有数据为参与方用户端的联邦设备在用户日常使用过程中收集并处理所得。所述主任务训练数据和用户行为特征数据为用户端在参与方用户正常使用联邦设备过程中以日志等形式记录获取,用户身份特征数据为参与方用户端在任务开始前向参与方询问获得。例如,在浏览器网页个性化推荐的机器学习任务中,参与方私有数据收集可以包含:在用户日常使用浏览器过程中,记录用户经常访问的站点、通常访问站点的习惯顺序、访问站点的时间偏好等,作为主任务训练数据和用户行为特征数据;询问用户的性别、年龄、地区、职业、爱好、联邦设备型号等数据作为用户身份特征数据。其中,所述用户行为特征数据、用户身份特征数据、主任务训练数据等依据主任务类型而定,可重复使用。需要说明的是,为保证对参与方隐私的充分尊重,在私有数据收集时,需保证用户的知情权。

具体实施时,本发明实施例中的预设规则也可以根据实际需要进行设置。

S102、当得到待聚合参数时,对其执行加密操作,并利用联邦学习方法将加密后的参数上传至中心服务器,以用于对各参与方模型的聚合。

需要说明的是,所述待聚合参数包括但不限于模型权重、偏置、梯度以及其他机器学习参数等。

具体实施时,本发明实施例是在得到待聚合参数时,为避免参与方数据受到逆向工程攻击,使用隐私保护方法对参数进行加密,并将加密后的参数发送至中心服务器。

在本实施例中,需要说明的是,所述联邦学习包括横向联邦学习与纵向联邦学习,所述参与方之间存在通信连接,所述参与方为两个或两个以上。所述隐私保护方法包括但不限于差分隐私、同态加密等等,具体地,将随机化机制应用到联邦学习中,在参与方的参数中加入一个白噪声,进而保护私有数据。

S200、中心服务器根据各个参与方发送的待聚合参数,计算每个参与方的贡献度,并根据结果更新聚合后的模型参数,下发至各个参与方;

S201、中心服务器接收每个参与方发送的待聚合参数,根据每个参与方待聚合参数与全局参数的差异,计算每个参与方对全局模型的贡献度;

具体实施时,中心服务器首先应用联邦控制模块管理联邦学习的相关配置,完成参与方参数的收集,再使用贡献计算模块来计算每个参与方对全局模型的贡献度。所述参与方贡献度的计算方法主要是计算当前参与方模型参数与上一轮中心服务器聚合后的相应模型参数之间的差异,参数差异大的参与方拥有对全局模型更高的贡献度。

具体地,在每一轮的训练中,中心服务器接收来自各参与方的待聚合参数,并计算当前待聚合参数与上一轮训练结果中的聚合后参数之间的距离。中心服务器首先随机初始化各参与方的贡献度参数,计算相应模型中,聚合后参数与每一参与方该待聚合参数的差异,具体表示为两个矩阵差的范数,包括欧几里得距离等。完成对所有参与方的计算后,再使用softmax计算每一个参与方的贡献度评分。

S202、中心服务器根据每个参与方对全局模型的贡献度,加权聚合所述待聚合参数,并将聚合后参数下发至各个参与方;

具体实施时,每一个参与方的贡献度评分作为模型聚合中该参与方的权重,聚合模型的整体优化目标是各待聚合参数与聚合后参数的距离加权和最小,在训练过程中,使用梯度下降策略来更新参数聚合模块的模型参数,更新后的模型参数作为下一轮训练的输入。

在本实施例中,该机器学习训练方法可以充分利用来自不同参与方的信息,训练得到一个各个参与方通用的主任务模型,以及一个整合输出模型。这个过程无需上传参与方私有数据,但可以克服数据孤岛问题,同时结合参与方的用户画像信息形成具有充分有效性和鲁棒性的全局模型。

S300、每个参与方根据服务器下发的参数及本地个性化参数更新本地模型;

S301、每个参与方接收服务器下发的聚合后参数,结合本地的个性化参数,生成适应于当前参与方的个性化模型,并重新进行本地训练,将训练得到的待聚合参数重新上传到中心服务器,以进行下一轮的训练。

需要说明的是,所述聚合后参数包括主任务模块参数和整合输出模块参数,所述本地的个性化参数包括用户画像模块包含的各项参数,训练数据来源包括但不限于用户身份特征数据、用户行为特征数据等等。

具体实施时,每个参与方收到中心服务器下发的聚合后模型参数,使用主任务模块参数更新本地的主任务模块,使用整合输出模块参数更新本地的整合输出模块。由未参与更新的用户画像模块、更新后的主任务模块、更新后的整合输出模块共同组成本地模型。

在得到新的本地模型之后,首先确定新的本地模型是否收敛,具体地,确定其主任务模块的损失是否小于第一预设值,整合输出模块的损失是否小于第二预设值,如上述判断准则均满足,确定新的本地模型收敛,保存本地模型作为最终结果,如不满足上述判断准则,则本地模型未收敛,需要新一轮的训练。具体地,参与方的本地训练数据输入组合形成的新模型,再次进行各本地模型与优化,完成新一轮的本地训练后,使用与前述一致的方式再次向中心服务器回传待聚合参数,重复执行前述训练过程,直至模型收敛。

需要说明的是,由于主任务模块与整合输出模块存在差异性,两个模块的参数存在不同时收敛的可能,且整合输出模块由于各参与方的特异性,收敛速度可能低于主任务模块,且各参与方不同。已完成收敛的参与方在完成最佳模型参数的加密上传后,保存本地模型,不再从中心服务器获取新的模型参数及本地训练。尚未收敛的参与方则继续迭代训练。中心服务器在参数聚合过程中使用已收敛参与方的最佳模型参数和未收敛模型每轮上传的待聚合参数,直到所有参与方模型实现收敛。

其中,在本实施例中,应当理解,主任务模块最终形成一个主任务模型,该模型不融合用户信息,因此所有参与方最终共享完全一致的模型参数。由于整合输出模块结合用户画像信息,最终在各参与方本地形成同质但参数不同的多个版本模型。

模型训练结束后,保留最优模型参数组合,组合形成的新模型可以实现对参与方的个性化推荐。具体地,主任务预测数据在参与方本地输入主任务模块,将用户画像模块的输出结果与主任务模块的输出共同输入整合输出模块,整合输出模块的输出即对主任务数据的个性化响应。

需要说明的是,主任务预测数据包括但不限于点击记录数据、浏览记录数据、输入记录数据、使用记录数据。主任务预测数据应与主任务训练数据类别和目标一致。

此外,本发明第二实施例提供一种结合联邦学习与用户画像的个性化模型训练系统,参照图3,图3是本发明提供的一种结合联邦学习与用户画像的个性化模型训练系统的具体结构框图。

如图3所示,以包含两个参与方的训练系统为例,所述结合联邦学习与用户画像的个性化模型训练系统300包括参与方1用户端310,参与方2用户端310’,中心服务器端320:

所述参与方用户端310包括:用户画像模块311,用于处理用户身份特征数据、用户行为特征数据,本地训练并生成用户画像;主任务模块312,用于处理主任务训练数据,训练并生成本地待聚合模型,管理参与联邦学习的参数收发;整合输出模块313,用于整合主任务模块和用户画像模块的输出,输入主任务参数和本地个性化参数,实现本地个性化模型的更新。其中,所述每个参与方用户端结构相同。

所述中心服务器端320包括:联邦控制模块321,用于管理联邦学习的相关配置,参数收发;贡献计算模块322,用于计算每个参与方对全局模型的贡献度;参数聚合模块323,用于生成全局模型,根据贡献计算模块输出结果,加权聚合联邦参数。

上面结合附图对本发明的实施例进行了描述,但是本发明并不局限于上述的具体实施方式,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本发明的启示下,在不脱离本发明宗旨和权利要求所保护的范围情况下,还可做出很多形式,这些均属于本发明的保护之内。

- 一种结合联邦学习与用户画像的个性化模型训练方法及系统

- 一种联邦学习模型训练方法、装置及联邦学习系统