一种基于语谱图合成的语音转换方法

文献发布时间:2023-06-19 09:38:30

技术领域

本发明涉及语音转换技术领域,尤其涉及一种基于语谱图合成的语音转换方法。

背景技术

语音转换技术是指将源说话人的身份信息转换为目标说话人的身份信息,同时保持语音内容不变,简单地说就是将一个说话人(称之为源)的声音,通过某种手段进行变换,使其听起来仿佛是另一个说话人(称之为目标)说的话。语音转换属于交叉性的学科分支,其内容既涉及到语音学、语义学及心理声学等领域的知识,又涵盖语音信号处理领域的各个方面,如语音的分析与合成、说话人识别、语音编码和增强等。现阶段,语音转换技术在医疗服务、保密通信及生活娱乐的方面有着非常重要的应用。目前,语音转换可以大致分为两类,一类是受监督的,另一类是无监督的。受监督的语音转换已经取得了较好的成果,但是需要源语音与目标语音之间相应语音帧对齐,如果源语音与目标语音之间有巨大差异,就无法达到较好的转换效果,这也限制了其应用推广。

因此,本发明提出一种基于语谱图合成的语音转换方法。

发明内容

本发明的目的是针对现有技术的缺陷,提供了一种基于语谱图合成的语音转换方法。

为了实现以上目的,本发明采用以下技术方案:

一种基于语谱图合成的语音转换方法,包括:

S1.将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

S2.将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图;

S3.将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配HdaIN层中进行匹配,得到目标特征矩阵;

S4.基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

S5.将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

进一步的,所述步骤S1具体为:

将源语音的语谱图C和目标语音的语谱图S分别作为内容语谱图和说话人语谱图输入超深度卷积神经VGG网络中,超深度卷积神经VGG网络从源语音的语谱图C中提取语义内容信息,从目标语音的语谱图S中提取说话人身份信息,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

进一步的,所述步骤S2具体为:

分别对语义内容信息和说话人身份信息进行编码,得到与语义内容信息和说话人身份信息对应的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)。

进一步的,所述步骤S3具体为:

将得到的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)馈送到通过直方图匹配的HdaIN层,HdaIN层将语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)进行匹配,从而获得目标特征矩阵,表示为:

y=HadIN(f(c),f(s))

其中,y表示目标特征矩阵。

进一步的,所述步骤S4具体为:

通过生成框架镜像处理得到的目标特征矩阵,对随机的生成函数g进行训练,将目标特征矩阵转为目标语谱图,表示为:

O=g(y)

其中,O表示生成的目标语谱图;g(y)表示目标特征矩的函数。

进一步的,所述步骤S4中生成框架具体为:

使用预训练的超深度卷积神经VGG网络计算出重建的语义内容信息损失与说话人身份信息损失,并训练生成框架。

进一步的,所述内容损失与说话人损失具体为:

使用生成的目标语谱图处理目标特征矩阵,并计算HdaIN层输出语义内容信息损失函数,表示为:

L

其中,L

通过匹配常规的实例统计信息获得说话人身份信息损失函数,表示为:

L

其中,L

进一步的,所述步骤S4还包括:

将逐层输出目标特征矩阵重新映射为具有梯度的特殊特征图,将特殊特征图与生成的目标语谱图进行匹配得到直方图损失函数,表示为:

其中,L

进一步的,所述步骤S4中还包括:

计算目标语谱图的总损失函数,表示为:

L=L

其中,L表示总损失函数。

进一步的,所述步骤S5中将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出,表示为:

x=G(g(y))

其中,x表示语音波形。

与现有技术相比,本发明具有以下优点:

(1)通过HdaIN层的应用,可以将语谱图的内容信息与身份信息分开进行处理,并且可以实现无监督的语音转换,从而解决了需要大量并行数据的弊端,使语音转换的应用范围更加广泛与灵活。

(2)本发明的方法基于语谱图进行语音转换,语音波形不参与直接转换,使得数据收集十分容易。

(3)通过GAN模型进行语谱图与语音之间的转换,可以得到质量更高的语音,并且用时更短。

附图说明

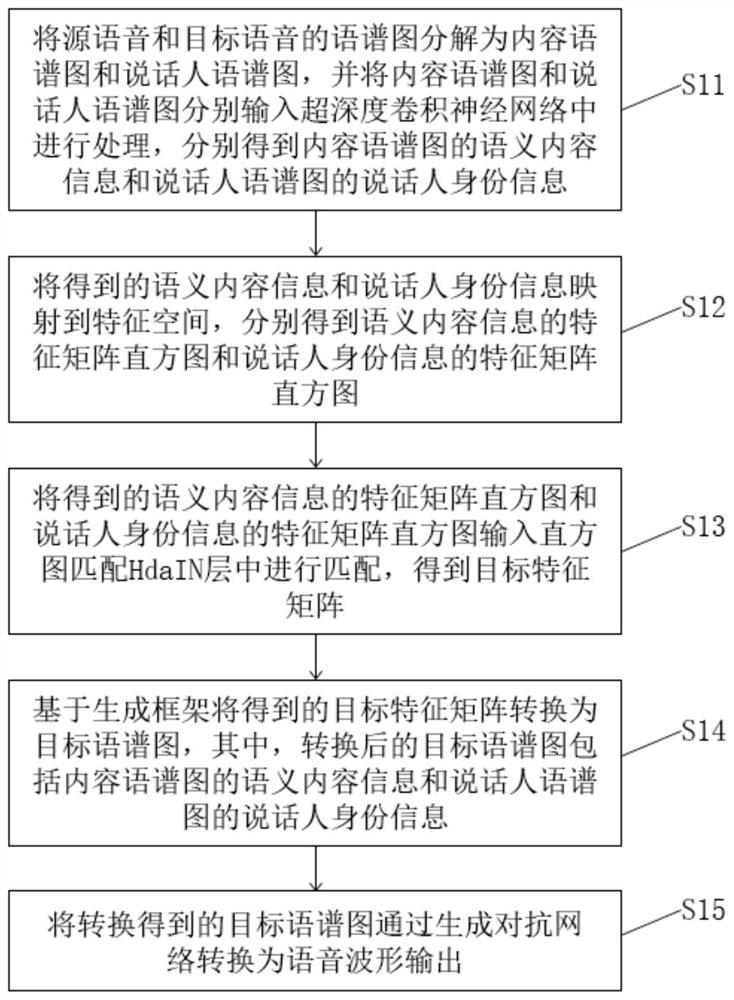

图1是实施例一提供的一种基于语谱图合成的语音转换方法流程图;

图2是实施例一提供的基于语谱图合成的语音转换系统框架结构图;

图3是实施例一提供的GAN模型生成器结构图;

图4是实施例一提供的GAN模型鉴别器结构图。

具体实施方式

以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需说明的是,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。

本发明的目的是针对现有技术的缺陷,提供了一种基于语谱图合成的语音转换方法。

本发明提出通过直方图匹配的实例归一化(Histogram-matched InstanceNormalization,HdaIN)将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图分别处理,无需对齐语音。

实施例一

本实施例提供一种基于语谱图合成的语音转换方法,如图1-2所示,包括步骤:

S11.将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

S12.将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图;

S13.将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配HdaIN层中进行匹配,得到目标特征矩阵;

S14.基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

S15.将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

本实施例将源语音和目标语音的语谱图作为输入,采用超深度卷积神经网络——视觉几何小组(Visual Geometry Group 19,VGG-19)对其进行处理,从内容语谱图中提取语义内容信息,从说话人语谱图中提取说话人身份信息,并将其映射到特征空间。随后将内容特征矩阵的直方图与说话人信息特征矩阵的直方图在HdaIN层进行匹配得到目标特征矩阵,再通过生成框架将目标特征矩阵转换为目标语谱图,转换后的语谱图具有内容语谱图的语义内容和目标说话人语谱图的身份信息,并将生成的目标语谱图通过生成对抗网络(Generative Adversarial Network,GAN)转换为语音波形输出。

本实施例通过计算目标语谱图的特征分别与内容语谱图的特征、说话人语谱图的特征之间的欧氏距离得到内容损失L

语义内容信息具体为:

本实施例使用了19层VGG网络的16个卷积层和5个池化层的规范化版本提供的特征空间,通过缩放权重来对网络进行归一化,以使每个卷积滤波器在图像和位置上的平均激活次数等于1。

通常,网络中的每一层都定义了一个非线性滤波器组,其复杂度随网络中该层位置的升高而增加。因此,给定的内容输入语谱图通过对该图像的滤波器响应在卷积神经网络的每一层中进行编码,具有N

通过计算内容损失的导数确定层t中的激活,内容损失的导数为:

从中可以使用标准误差反向传播来计算相对于图像O的梯度。因此,我们可以更改初始随机图像O,直到它在卷积神经网络的特定层中生成与原始图像C相同的响应为止。

当对卷积神经网络进行内容识别训练时,它们会形成图像表示,从而使内容信息沿处理层次的升高越来越清晰。因此,网络中的高层根据对象及其在输入图像中的排列来捕获高级内容,但并不会很大程度地限制重建的精确像素值。相比之下,从较低层进行的重建只是简单地复制了原始图像的精确像素值。因此,我们将网络高层中的特征响应称为内容表示f(c)。

说话人身份信息具体为:

为了获得输入语谱图的说话人表示,本实施例使用了一个特征空间来捕获说话人身份信息。可以在VGG网络任何层的滤波器响应上构建此特征空间,它由不同滤波器响应之间的相关关系组成,其中对特征图的空间范围求期望。这些特征相关性由Gram矩阵

因为包括多层的特征相关性,所以可以获得输入图像平稳、多尺度的表示,该表示捕获了图像包含的说话人信息,但不捕获全局信息。因此可以通过构建与给定输入说话人语谱图的说话人表示相匹配的图像,来可视化这些在VGG网络不同层上构建的说话人特征空间所捕获的信息。这是通过使用白噪声图像的梯度下降来最小化原始图像的Gram矩阵与要生成的图像的Gram矩阵之间的均方距离来实现的。

令S和O为原始目标说话人语谱图和生成的语谱图,而S

总损失为:

其中,w

使用标准误差反向传播可以很容易地计算出E

因此将可视化后的说话人信息称之为说话人表示f(s)。

生成对抗网络GAN模型具体为:

本实施例采用GAN模型将语谱图转化为原始语音波形。该模型中的生成器是一个完全卷积的前馈网络,由于语谱图位于较低的256倍时间分辨率,所以使用了一系列转置的卷积层来对输入序列进行上采样。每个上采样层是一个转置卷积,内核大小是步幅的两倍。256x上采样分4个阶段进行,分别是8x,8x,2x和2x上采样。每个转置的卷积层后面是一堆带有膨胀卷积的剩余块,每个剩余块都具有三层,其扩散层1、3和9的核大小为3,总接收场为27个时间步长。其结构如图3所示。

本实施例采用具有3个鉴别器(D

语谱图转换方法具体为:

本实施例通过提取内容语谱图的语义内容和说话人语谱图的身份信息,对其特征图进行映射并用直方图匹配,从而合成高质量的转换后语谱图,最后用GAN模型将语谱图转化为原始语音波形,得到转换后的语音,即具有目标说话人的身份信息但不改变源说话人的内容。算法的具体过程如下。

在步骤S11中,将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

将源说话人的语谱图C和目标说话人的语谱图S分别作为内容语谱图和说话人语谱图输入VGG网络。VGG网络从源说话人的语谱图C中提取语义内容,同时从目标语音的语谱图S中提取说话人身份信息,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

在步骤S12中,将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图。

分别对语义内容信息和说话人身份信息进行编码,得到与语义内容信息和说话人身份信息对应的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)。

在步骤S13中,将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配HdaIN层中进行匹配,得到目标特征矩阵。

将获得的特征矩阵f(c)和f(s)馈送到通过直方图匹配的HdaIN层,该层将内容特征矩阵的直方图与样式特征矩阵的直方图进行匹配,从而获得目标特征矩阵:

y=HadIN(f(c),f(s)) (7)

其中,y表示目标特征矩阵。

在步骤S14中,基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

通过生成框架镜像处理目标特征矩阵,对随机的生成函数g进行训练,以将目标矩阵转为目标语谱图,即:

O=g(y) (8)

使用预训练的VGG-19网络计算出重建的内容损失与说话人损失,从而训练生成框架。关于内容损失函数L

L

我们通过匹配常规的实例统计信息来获得说话人信息损失函数L

L

此处,t表示VGG-19中relu1_1,relu2_1,relu3_1,relu4_1层中的一层。

根据值从原始输出激活中找出

首先将逐层输出特征图重新映射为具有梯度的特殊特征图。然后我们将它们与生成的图像进行匹配以获得直方图损失函数L

其中,t表示VGG-19中relu1_1,relu4_1层中的一层。

在步骤S15中,将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

得到高质量的目标语谱图后,通过GAN网络将语谱图转化为原始语音波形x,即:

x=G(g(y)) (16)

其中,x表示语音波形。

与现有技术相比,本实施例具有以下优点:

(1)通过HdaIN层的应用,可以将语谱图的内容信息与身份信息分开进行处理,并且可以实现无监督的语音转换,从而解决了需要大量并行数据的弊端,使语音转换的应用范围更加广泛与灵活。

(2)本实施例的方法基于语谱图进行语音转换,语音波形不参与直接转换,使得数据收集十分容易。

(3)通过GAN模型进行语谱图与语音之间的转换,可以得到质量更高的语音,并且用时更短。

注意,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里所述的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

- 一种基于语谱图合成的语音转换方法

- 一种基于二维语谱图和条件生成对抗网络的语音增强方法