用于多个对象跟踪的成像和雷达融合

文献发布时间:2023-06-19 12:13:22

相关申请的交叉引用

本申请根据35U.S.C.119(e)要求于2020年1月28日提交的美国临时申请第62/966,604号的权益,该申请的公开内容通过引用以其整体并入本文。

背景技术

跟踪多个对象可使安全系统预测对象的路径,并且对于提高交通工具的安全性和自主性至关重要。多个对象跟踪的目的在于在场景的连续帧中发现多个对象并恢复这些在连续帧中对象的身份信息。相机系统、光检测和测距(LiDAR)系统和雷达系统被广泛用于完成这些任务。这些系统继续经历使多个对象跟踪变得复杂的关键问题,包括频繁的遮挡、踪迹的初始化和终止、对象外观的变化以及多个对象之间的交互。改善多个对象跟踪的挑战在于,在连续帧中可靠地标识相同对象的能力以克服这些关键问题。

发明内容

本文档描述了涉及多个对象跟踪的成像传感器和雷达融合的方法和系统。使用按检测跟踪,首先在由成像传感器捕获的帧中检测对象,然后通过成像传感器和雷达系统在若干连续的帧中跟踪该对象。通过分配在一帧中标识的对象是在连续帧中标识的同一对象的概率来跟踪对象。通过监督学习神经网络模型使用从传感器收集的数据来计算与每个传感器相关联的概率。然后,将与每个传感器相关联的概率融合为精确的概率。与单独使用传感器数据来跟踪对象相比,通过将由成像传感器和雷达系统收集的数据融合在连续的帧中,安全系统可以更准确且更可靠地跟踪多个对象。

在一个示例中,一种方法包括基于由成像传感器捕获的第一帧来确定第一帧内的第一对象。方法进一步包括基于由成像传感器捕获的第二帧来确定第二帧内的第二对象,该第二帧在捕获第一帧后被连续捕获。方法进一步包括基于在第一时间接收的第一雷达信号来确定第三对象的位置,该第一时间与第一帧的捕获相对应,第一雷达信号被反射自该第三对象。方法进一步包括基于在第二时间接收的第二雷达信号来确定第四对象的位置,该第二时间与第二帧的捕获相对应,第二雷达信号被反射自该第四对象。方法进一步包括确定第一对象与第二对象是同一对象的第一概率。方法进一步包括确定第三对象与第四对象是同一对象的第二概率。方法进一步包括通过组合第一概率和第二概率确定精确的概率,该精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

在另一示例中,一种系统包括成像传感器、雷达系统、以及一个或多个处理器,该一个或多个处理器被配置成基于由成像传感器捕获的第一帧来确定该第一帧内的第一对象。该一个或多个处理器被进一步配置成基于由成像传感器捕获的第二帧来确定第二帧内的第二对象,该第二帧在捕获第一帧后被连续捕获。该一个或多个处理器被进一步配置成基于在第一时间接收的第一雷达信号来确定第三对象的位置,该第一时间与第一帧的捕获相对应,第一雷达信号被反射自该第三对象。该一个或多个处理器被进一步配置成基于在第二时间接收的第二雷达信号来确定第四对象的位置,该第二时间与第二帧的捕获相对应,第二雷达信号被反射自该第四对象。该一个或多个处理器被进一步配置成确定第一对象与第二对象是同一对象的第一概率。该一个或多个处理器被进一步配置成确定第三对象与第四对象是同一对象的第二概率。该一个或多个处理器被进一步配置成通过组合第一概率和第二概率确定精确的概率,该精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

在另一个示例中,描述了一种系统,该系统包括用于基于由成像传感器捕获的第一帧来确定第一帧内的第一对象的装置。系统进一步包括基于用于由成像传感器捕获的第二帧来确定第二帧内的第二对象的装置,该第二帧在捕获第一帧后被连续捕获。系统进一步包括用于基于在第一时间接收的第一雷达信号来确定第三对象的位置的装置,该第一时间与第一帧的捕获相对应,第一雷达信号被反射自该第三对象。系统进一步包括用于基于在第二时间接收的第二雷达信号来确定第四对象的位置的装置,该第二时间与第二帧的捕获相对应,第二雷达信号被反射自该第四对象。系统进一步包括用于确定第一对象与第二对象是同一对象的第一概率的装置。系统进一步包括用于确定第三对象与第四对象是同一对象的第二概率的装置。系统进一步包括用于通过组合第一概率和第二概率确定精确的概率的装置,该精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

除了描述配置成执行以上概述的方法和本文所阐述的其他方法的系统之外,本文档还描述了一种计算机可读存储介质,其包括指令,该指令在被执行时配置一个或多个处理器以执行以上概述的方法和本文所阐述的其他方法。

本发明内容介绍了使用机器学习来改进多个对象跟踪系统的简化概念,下面将在具体实施方式和附图中对其进行进一步描述。本发明内容并非旨在标识出要求保护的主题的必要特征,亦非旨在用于确定要求保护的主题的范围。

附图说明

本文档参考以下附图描述了用于多个对象跟踪的成像和雷达融合的一个或多个方面的细节。贯穿附图通常使用相同的数字来引用相似的特征和组件。

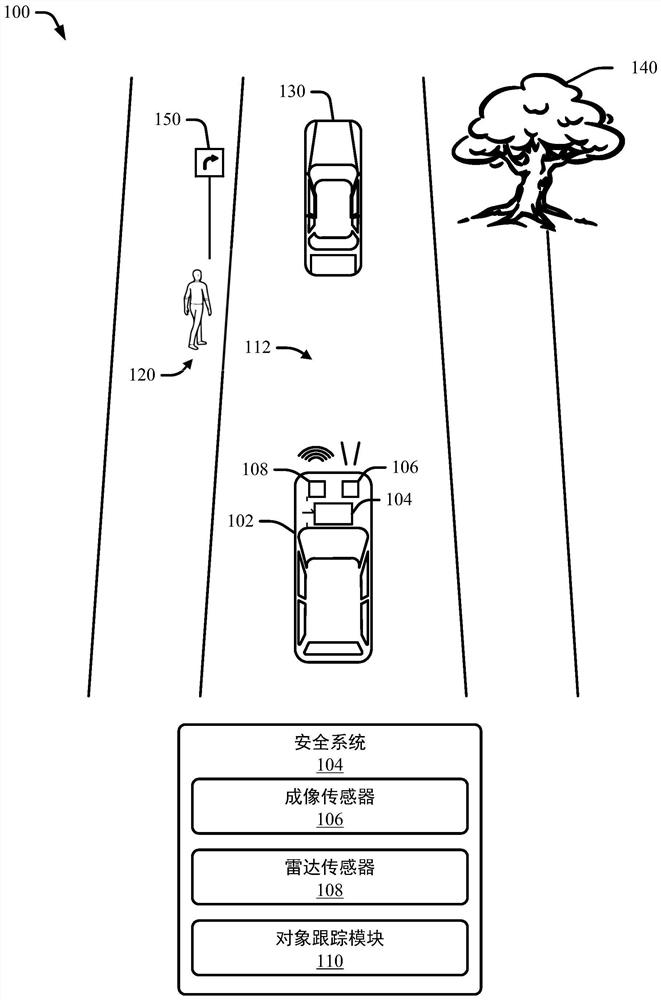

图1示出了根据本公开的技术的示例环境,在该示例环境中,系统被配置成执行用于多个对象跟踪的成像和雷达融合。

图2示出了根据本公开的技术的汽车系统的示例,该汽车系统被配置成执行用于多个对象跟踪的成像和雷达融合。

图3示出了示例操作环境由成像传感器捕获的连续帧。

图4示出了示例数据关联矩阵。

图5示出了输出数据关联矩阵的示例成像模块。

图6示出了示例雷达模块,该示例雷达模块通过用于雷达系统的监督学习神经网络输出数据关联矩阵。

图7示出了通过融合基于成像传感器数据的对象关联矩阵和基于雷达数据的对象关联矩阵而生成的精确的对象关联矩阵的示例。

图8-1和图8-2示出了用于多个对象跟踪的成像和雷达融合的示例方法。

具体实施方式

概述

跟踪系统广泛使用成像传感器来跟踪传感器正在成像的场景中的对象。通过使用感兴趣对象的外观特征,基于由成像传感器捕获的图像来跟踪对象。这些特征包括对象的颜色以及对象图像中像素的关系。

仅使用成像传感器有许多限制。许多进入或离开场景的对象、频繁的遮挡以及多个对象之间的交互使可靠地跟踪这些对象的能力变得复杂。不利的天气(诸如雾天或雨天)可能使传感器捕获的图像降级,从而使对象标识更加困难。

为了提高这些跟踪系统的性能,现在正在结合成像传感器实现雷达系统。雷达系统通常使用卡尔曼滤波器或其他类似的滤波算法来改进对对象的跟踪。尽管实现这些滤波算法的雷达系统已经帮助成像系统跟踪对象,但是如本公开中所描述的其他方法提供了更可靠的对象跟踪。

一种称为按检测跟踪的技术提供了更高的可靠性。通过检测在由成像传感器捕获的两个连续帧中的对象来实现检测步骤。跟踪步骤涉及通过机器学习将第一帧中的对象与连续的第二帧中的对象相关联。表示为概率的该关联是从由成像传感器提供的数据和由雷达提供的数据中得出的,并且产生基于成像的关联和基于雷达的关联。然后将这两个关联融合为一个更准确、更精确的关联。

示例环境

图1示出了根据本公开的技术的示例环境100,在该示例环境100中,交通工具102被配置成执行用于多个对象跟踪的成像和雷达融合。在所描绘的环境100中,安全系统104被安装到交通工具102上或被集成在交通工具102内。尽管示出为汽车,交通工具102可以表示其他类型的交通工具和机械(例如,摩托车、公共汽车、拖拉机、半挂车、水运工具、飞行器或其他重型装备),包括可以用于各种目的的有人和无人系统。交通工具102可以在道路112上行驶,道路112可以衬有植被140、路牌150或其他静止的对象(未示出),包括建筑物和停放的交通工具。移动的对象(例如,行人120和移动的交通工具130)也可以在道路112中或在道路112附近。在图1中,交通工具102正在沿着道路112行驶,并且交通工具102的安全系统104具有除了行人120、移动的交通工具130、植被140和路牌150之外还包含道路112的视场(FOV)。

安全系统104可以基于从交通工具102的多个传感器获得的传感器数据来跟踪FOV中的对象。标识多个传感器之间的对象并将来自这些传感器的数据融合在一起,使安全系统更准确、更可靠地跟踪那些当交通工具102行驶在道路112上时可能需要避免的对象。

通常,安全系统104包括安装在交通工具102上的具有在远离交通工具102的任何方向上的FOV的多个传感器(例如,光学相机、LiDAR、雷达)和对象跟踪模块110。在图1中,成像传感器106和雷达传感器108安装到交通工具102,其中FOV面向交通工具102的前方。成像传感器106和雷达传感器108可以捕获关于该FOV内的任何对象(包括行人120、移动的交通工具130、植被140和路牌150)的数据。

在图1中,对象跟踪模块110安装在交通工具102的发动机舱中或发动机舱附近,但是交通工具制造商可以将对象跟踪模块110集成到交通工具中的任何位置。例如,对象跟踪模块110可以位于交通工具102的仪表板后面、座椅下方或后备箱附近。对象跟踪模块110与成像传感器106和雷达传感器108对接以接收数据。安装在交通工具102上或以其他方式集成到交通工具102中的传感器连续地捕获数据,要么作为由本示例中成像传感器106捕获的连续帧,要么作为在连续时间接收的由本示例中雷达传感器108捕获的雷达信号,该连续时间与由成像传感器106捕获的连续帧相对应。

对于每个传感器,对象跟踪模块110接收数据,并且基于从该数据中检测的对象,来分配第二组接收数据中标识的对象与在第一组接收数据中标识的对象相同的概率。第一组接收数据和第二组接收数据可以是从成像传感器106、雷达传感器108或两者中接收的数据。然后,对象跟踪模块将与来自成像传感器106的数据有关的概率和与来自雷达传感器108的数据有关的概率相融合,从而得到精确的概率。

图2示出了根据本公开的技术的汽车系统200的示例,该汽车系统200被配置成执行用于多个对象跟踪的成像和雷达融合。系统200可以集成在交通工具102内。例如,汽车系统200包括控制器202和安全系统104-1,该安全系统104-1是安全系统104的示例。安全系统104-1可以集成在汽车或其他交通工具环境内。安全系统104-1可以通过链路212与控制器202通信,诸如当标识出FOV中的对象踪迹时从安全系统104-1输出的数据。

控制器202包括处理器204-1和计算机可读存储介质(CRM)206-1(例如,存储器、长期存储、短期存储),该CRM 206-1存储用于汽车模块208的指令。除了成像传感器106之外,安全系统104-1还包括雷达传感器108。同样可以使用任何数量的其他传感器。安全系统104-1可包括处理硬件,该处理硬件包括处理器204-2和计算机可读存储介质(CRM)206-2,该CRM 206-2存储与对象跟踪模块110-1相关联的指令。作为对象跟踪模块110的示例的对象跟踪模块110-1包括成像子模块210-1、雷达子模块210-2和融合子模块210-3。

处理器204-1和204-2可以是两个单独的微处理器或单个微处理器或计算设备、控制器或控制单元的一对片上系统或单个片上系统。处理器204-1和204-2执行存储在CRM206-1和206-2内的计算机可执行指令。作为示例,处理器204-1可以执行汽车模块208以进行汽车系统200的驾驶功能或其他操作。类似地,处理器204-2可以基于从多个不同传感器(诸如成像传感器106和雷达传感器108)中获得的传感器数据来执行对象跟踪模块110-1以推断出FOV中的对象。汽车模块208在处理器204-1上执行时,可以响应于对象跟踪模块110-1组合并分析在传感器(例如,成像传感器106和雷达传感器108)中的每个传感器处生成的传感器数据而接收由对象跟踪模块110-1跟踪的一个或多个对象的指示。

对象跟踪模块110从成像传感器106和雷达传感器108接收数据。由成像传感器106接收的数据(在本示例中表示为两个连续帧)被输入到成像子模块210-1中。成像子模块210-1标识两个连续帧内的对象并且输出第二帧中的对象与第一帧中的对象一致的概率。类似地,由雷达传感器108接收的数据(表示为自对象反射两次之后接收的且与成像传感器106对两个帧的捕获相对应的雷达信号)被输入到雷达子模块210-2中。雷达子模块210-2输出两个反射的雷达信号被反射自同一对象的概率。融合子模块210-3接收由成像子模块210-1输出的概率和由雷达子模块210-2输出的概率,将这两个概率融合,并输出精确的概率。当在捕获的帧和接收的雷达信号中标识出多个对象时,子模块210输出的多个概率被呈现为数据关联矩阵。数据关联矩阵的每一行表示在第一帧中或通过在与第一帧相对应的第一时间接收到的反射雷达信号找到的对象。数据关联矩阵的每一列表示在第二帧中或通过在与第二帧相对应的第二时间接收到的反射雷达信号找到的对象。数据关联矩阵中的每个元素是在第二帧中或通过在与第二帧相对应的第二时间接收到的反射雷达信号标识的对象与在第一帧中或通过在与第一帧相对应的第一时间接收到的反射雷达信号标识的对象是同一对象的概率。

图3示出了示例环境100由成像传感器106捕获的两个连续帧。帧300-1是由成像传感器106捕获的第一帧,而帧300-2是由成像传感器106捕获的连续的第二帧。在帧300-1中,检测并标识对象,包括行人120-1、交通工具130-1、植被140-1和路牌150-1。行人120-1的雷达信号320-1、交通工具130-1的雷达信号330-1、植被140-1的雷达信号340-1和路牌150-1的雷达信号350-1由雷达传感器108在与被捕获的时间帧300-1相对应的时间接收。同样,在帧300-2中,检测并标识对象,包括行人120-2、交通工具130-2、植被140-2和路牌150-2。行人120-2的雷达信号320-2、交通工具130-2的雷达信号330-2、植被140-2的雷达信号340-2和路牌150-2的雷达信号350-2由雷达传感器108在与被捕获的时间帧300-2相对应的时间接收。

通常,汽车系统200执行汽车模块208以进行功能。例如,汽车模块208可以提供自动巡航控制并监测道路112中或道路112附近的对象的存在。在此类示例中,对象跟踪模块110-1提供从由融合子模块210-3输出到汽车模块208的对象概率得出的对象踪迹。当从对象跟踪模块110-1获得的数据指示一个或多个对象正穿过交通工具102前方时,汽车模块208可提供警报。

在一个场景中,在帧300-1中,行人120-1和路牌150-1彼此紧邻。由于示例环境100中的大雾天气条件,成像子模块210-1将行人120-1误标识为第二路牌。在帧2中,成像子模块正确标识行人120-2,但是计算出行人120-1和行人120-2是同一对象的低概率。然而,在另外考虑雷达信号320-1和雷达信号320-2的情况下,雷达子模块210-2产生这两个雷达信号被反射自同一对象的高概率。融合子模块210-3计算从由成像子模块210-1输出的概率和由雷达子模块210-2输出的概率融合的精确的概率,该精确的概率更精准地预测行人120-1和行人120-2是同一对象。对象跟踪模块110-1将该融合概率输出到汽车模块208,汽车模块208向汽车系统200指示:正在跟踪的对象在汽车系统200前面移动。

示例架构

图4示出了示例数据关联矩阵400。数据关联矩阵400是在捕获数据的一帧中标识的对象与在捕获数据的连续的第二帧中标识的对象是相同对象的一组概率。数据关联矩阵400的行表示在捕获的第一帧中标识的对象。数据关联矩阵400的列表示在捕获的第二帧中标识的对象。数据关联矩阵400中的每个元素(诸如元素402)是来自该元素行的对象和该元素列的对象一致的概率。元素的数量取决于每个帧中标识出多少个对象。数据关联矩阵400可以将由成像传感器数据标识的对象关联。同样,数据关联矩阵400可以将与由成像传感器数据标识的对象有关的雷达数据关联。成像子模块210-1、雷达子模块210-2和融合子模块210-3输出与数据关联矩阵400类似的数据关联矩阵。

图5示出了与成像子模块210-1类似的示例成像模块500。在该示例中,成像传感器是相机,但是成像传感器可以是能够捕获其中可以唯一地标识一个或多个对象的数据的任何类型的传感器。帧502-1和帧502-2是由成像传感器106连续捕获的两个帧。帧502-1是第一帧,而帧502-2是第二帧。特征提取器504通过提取特征来标识每个帧中的对象并标记在两个帧中找到的每个对象。特征提取器504是通过机器学习来实现的,该机器学习可包括神经网络、卷积神经网络、递归神经网络或其任意组合。神经网络可以是已知模型(诸如视觉几何组(VGG)或ResNet50),或者神经网络可以是其他设计的模型。使用大型数据集(诸如ImageNet图像数据库)训练模型。亲和力估计器506接收在第一帧中被标识并标记的对象列表以及在第二帧中被标识并标记的对象列表,并计算第二帧中的每个对象与在第一帧中是同一对象的概率。然后将该概率作为集合输出,呈现为数据关联矩阵510。

图6示出了与雷达子模块210-2类似的示例雷达模块600。在该示例中,雷达模块600使用监督学习神经网络模型602来输出数据关联矩阵。示例神经网络602包括输入层604、隐藏层606和输出层608。尽管在神经网络602中示出了两个隐藏层,但是可以使用任何数量的隐藏层。与在帧502-1和502-2中标识的对象有关的雷达信号被连接并被输入到输入层604中。神经网络602计算与成像模块500的第一帧相对应的每个雷达信号和与成像模块500的第二帧相对应的每个雷达信号与由成像模块500标识的同一对象相关联的概率。输出层将该概率作为呈现为数据关联矩阵610的集合输出。

图7是与融合子模块210-3类似的示例融合模块700。由成像模块500输出的数据关联矩阵510和由雷达模块600输出的数据关联矩阵610被输入到融合模块700中。通过平均、加权平均,通过机器学习或通过任何其他得出融合数据的计算方式,融合模块700可以将数据关联矩阵510的元素与数据关联矩阵610的元素进行融合。融合模块700将该概率作为呈现为数据关联矩阵710的集合输出。

示例方法

图8-1和图8-2示出了根据本公开的技术的用于多个对象跟踪的成像和雷达融合的示例方法。方法800被示为以但不限于示出或描述操作的顺序或组合执行的一组操作(或动作)。此外,操作中的任一者可以被重复、被组合或被重组以提供其他方法。在以下讨论的部分中,在描述方法800的一些非限制性示例时,可以参考先前介绍的附图。

在802处,确定在由成像传感器捕获的第一帧内的第一对象。成像传感器可以是光学相机、LiDAR、或者能够捕获从中可以标识对象的图像的任何传感器。在804处,确定在由成像传感器捕获的第二帧内的第二对象,该第二帧在第一帧之后被连续捕获。

在806处,基于在第一时间接收的第一雷达信号来确定第三对象的位置,该第一时间与第一帧的捕获相对应,该第一雷达信号反射自第三对象。雷达信号可包含有关对象的大量数据,包括但不限于距主机系统的距离、速度和方位角。在808处,基于在第二时间接收的第二雷达信号来确定第四对象的位置,该第二时间与第二帧的捕获相对应,该第二雷达信号反射自第四对象。

在810处,确定第一对象与第二对象是同一对象的第一概率。在812处,确定第三对象与第四对象是同一对象的第二概率。在814处,通过组合第一概率和第二概率确定精确的概率,该精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。通过机器学习确定第一概率、第二概率或第三概率中的至少一者或多者。机器学习可以使用监督学习神经网络模型来标识第一对象、第二对象、第三对象和第四对象中的至少两者或多者之间的关联。第一概率、第二概率和精确的概率可以呈现为数据关联矩阵。

根据本公开的技术,通过将来自两个或更多传感器的数据融合为精确的数据,该精确的数据可用于更可靠和准确地跟踪场景中多个对象。此外,通过由监督学习神经网络模型实现的机器学习,进一步提高了精确的数据的可靠性和准确性。

附加示例

在以下部分中,提供了用于多个对象跟踪系统的成像和雷达融合的附加示例。

示例1。一种由对象跟踪系统执行的方法,所述方法包括:基于由成像传感器捕获的第一帧,来确定第一帧内的第一对象;基于由成像传感器捕获的第二帧,来确定第二帧内的第二对象,第二帧在捕获第一帧后被连续捕获;基于在第一时间接收的第一雷达信号,来确定第三对象的位置,第一时间与第一帧的捕获相对应,第一雷达信号被反射自第三对象;基于在第二时间接收的第二雷达信号,来确定第四对象的位置,第二时间与第二帧的捕获相对应,第二雷达信号被反射自第四对象;确定第一对象与第二对象是同一对象的第一概率;确定第三对象与第四对象是同一对象的第二概率;以及通过组合第一概率和第二概率确定精确的概率,该精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

示例2。示例1的方法,进一步包括:通过机器学习确定第一概率、第二概率或精确的概率中的至少一者或多者。

示例3。如前述示例中任一项的方法,进一步包括:通过使用监督学习神经网络模型的机器学习来确定第一概率、第二概率或精确的概率中的至少一者或多者,以标识第一对象、第二对象、第三对象和第四对象中的至少两者或多者之间的关联。

示例4。如前述示例中任一项的方法,进一步包括:确定第一概率,该第一概率被呈现为第一对象关联矩阵;确定第二概率,该第二概率被呈现为第二对象关联矩阵;以及确定精确的概率,该精确的概率基于通过机器学习对第一对象关联矩阵和第二对象关联矩阵进行组合而被呈现为精确的对象关联矩阵。

示例5。如前述示例中任一项的方法,进一步包括:利用成像传感器捕获第一帧和第二帧,成像传感器是能够捕获可见光谱中的图像的光学相机。

示例6。如前述示例中任一项的方法,进一步包括:利用成像传感器捕获第一帧和第二帧,成像传感器是光检测和测距系统。

示例7。一种对象跟踪系统,该系统包括:成像传感器;雷达系统;以及一个或多个处理器,该一个或多个处理器被配置成用于:基于由成像传感器捕获的第一帧,来确定第一帧内的第一对象;基于由成像传感器捕获的第二帧,来确定第二帧内的第二对象,第二帧在捕获第一帧后被连续捕获;基于在第一时间接收的第一雷达信号,来确定第三对象的位置,第一时间与第一帧的捕获相对应,第一雷达信号被反射自第三对象;基于在第二时间接收的第二雷达信号,来确定第四对象的位置,第二时间与第二帧的捕获相对应,第二雷达信号被反射自第四对象;确定第一对象与第二对象是同一对象的第一概率;确定第三对象与第四对象是同一对象的第二概率;以及通过组合第一概率和第二概率确定精确的概率,精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

示例8。示例7的对象跟踪系统,其特征在于,一个或多个处理器被进一步配置成用于通过机器学习确定第一概率、第二概率或精确的概率中的至少一者或多者。

示例9。如前述示例中任一项的对象跟踪系统,其特征在于,一个或多个处理器被进一步配置成用于通过使用监督学习神经网络模型的机器学习来确定第一概率、第二概率或精确的概率中的至少一者或多者,以标识第一对象、第二对象、第三对象和第四对象中的至少两者或多者之间的关联。

示例10。如前述示例中任一项的对象跟踪系统,其特征在于,一个或多个处理器被进一步配置成用于:确定第一概率,第一概率被呈现为第一对象关联矩阵;确定第二概率,第二概率被呈现为第二对象关联矩阵;以及确定精确的概率,精确的概率基于通过机器学习对第一对象关联矩阵和第二对象关联矩阵进行组合而被呈现为精确的对象关联矩阵。

示例11。如前述示例中任一项的对象跟踪系统,其特征在于:成像传感器是能够捕获可见光谱中的图像的光学相机。

示例12。如前述示例中任一项的对象跟踪系统,其特征在于:成像传感器是光检测和测距系统。

示例13。如前述示例中任一项的对象跟踪系统,其特征在于,系统作为安装在机动交通工具上的安全系统的一部分进行操作。

示例14。一种对象跟踪系统,该系统包括:用于基于由成像传感器捕获的第一帧来确定第一帧内的第一对象的装置;用于基于由成像传感器捕获的第二帧来确定第二帧内的第二对象的装置,第二帧在捕获第一帧后连续捕获;用于基于在第一时间接收的第一雷达信号来确定第三对象的位置的装置,第一时间与第一帧的捕获相对应,第一雷达信号被反射自第三对象;用于基于在第二时间接收的第二雷达信号来确定第四对象的位置的装置,第二时间与第二帧的捕获相对应,第二雷达信号被反射自第四对象;用于确定第一对象与第二对象是同一对象的第一概率的装置;用于确定第三对象与第四对象是同一对象的第二概率的装置;以及用于通过组合第一概率和第二概率确定精确的概率的装置,精确的概率是第一对象、第二对象、第三对象和第四对象是同一对象的概率。

示例15。示例14的对象跟踪系统,该系统进一步包括:用于通过机器学习确定第一概率、第二概率或精确的概率中的至少一者或多者的装置。

示例16。如前述示例中任一项的对象跟踪系统,该系统进一步包括:用于通过使用监督学习神经网络模型的机器学习来确定第一概率、第二概率或精确的概率中的至少一者或多者的装置,以标识第一对象、第二对象、第三对象和第四对象中的至少两者或多者之间的关联。

示例17。如前述示例中任一项的对象跟踪系统,该系统进一步包括:用于确定第一概率的装置,第一概率被呈现为第一对象关联矩阵;用于确定第二概率的装置,第二概率被呈现为第二对象关联矩阵;以及用于确定精确的概率的装置,精确的概率基于通过机器学习对第一对象关联矩阵和第二对象关联矩阵进行组合而被呈现为精确的对象关联矩阵。

示例18。如前述示例中任一项的对象跟踪系统,其特征在于:成像传感器是能够捕获可见光谱中的图像的光学相机。

示例19。如前述示例中任一项的对象跟踪系统,其特征在于:成像传感器是光检测和测距系统。

示例20。如前述示例中任一项的对象跟踪系统,其特征在于,系统作为安装在机动交通工具上的安全系统的一部分进行操作。

结论

虽然本公开的各种实施例在前述描述中进行了描述并且在附图中示出,但是应当理解,本公开不限于此,而是可以在接下来的权利要求的范围内以各种方式实施为实践。从前述描述中,将显而易见的是,可以在不偏离由接下来的权利要求所限定的本公开的精神和范围的情况下做出各种更改。与多个对象跟踪相关联的问题会出现在解决分配问题的其他系统中,其中代理或任务的数量很大。因此,尽管被描述为改进基于交通工具的对象跟踪技术的一种方式,上述说明书的技术可以应用于其他分配问题,以减少任务与代理之间的分配总数。

除非上下文另有明确规定,否则“或”和语法相关术语的使用表示无限制的非排他性替代物。如本文中所使用的,引述一列项目“中的至少一者”的短语是指这些项目的任何组合,包括单个成员。作为示例,“a、b或c中的至少一者”旨在涵盖:a、b、c、a-b、a-c、b-c、和a-b-c,以及具有多个相同元素的任何组合(例如,a-a、a-a-a、a-a-b、a-a-c、a-b-b、a-c-c、b-b、b-b-b、b-b-c、c-c、和c-c-c,或者a、b和c的任何其他排序)。

- 用于多个对象跟踪的成像和雷达融合

- 多雷达成像传感器的对象融合系统