一种用于远程遥控驾驶监测视频的抬头显示技术

文献发布时间:2023-06-19 12:24:27

技术领域

本发明属于图像识别与距离测绘领域,具体涉及一种用于远程遥控监测视频的抬头显示技术。

背景技术

在遥控驾驶的受控车辆的监测信息中,车辆周围的视频信息是其中最为重要的部分,其作用是让遥控驾驶员直观的掌握车辆周边的场景信息以及车辆自身的位姿信息。但摄像机采集的图像信息受其自身成像方式和整体显示布局的限制,与人类肉眼直接获取的视觉信息有着多方面的差异,造成信息判断的困难,尤其是对距离和方位的判断。此外,在驾驶员远程驾驶受控车辆的过程当中,摄像机的视频应是其主要的注意力集中范围。在当前主流的将视频窗口嵌入图形用户界面的方法中,除视频外的其他信息,大部分是以图形用户界面控件的方式放置在视频范围以外的地方,这样的方式迫使驾驶员在观测此类信息时需要将视觉焦点转移到视频以外的地方,对驾驶安全造成了一定的影响。因此,将场景中对象的相关信息,以增强现实的方式对应显示在监测视频中对象所在位置上,可以显著减少驾驶员视觉焦点的转移,提高驾驶安全。

因此,在远程遥控驾驶作业的过程当中,存在以下两个问题。

(1)视频成像方式与人眼的差异,造成远程驾驶员对车辆周围环境,尤其是交通参与者的碰撞信息的判断易产生误差。

(2)车辆行驶中的其他参数化信息在视频窗口以外的部分进行提示,远程驾驶员在观测该类信息时视线焦点离开视频区域,存在安全隐患。

鉴于此,目前亟待提出一种用于远程遥控驾驶监测的增强现实抬头显示方法,以减少远程遥控驾驶过程中的驾驶判断误差及安全隐患。

发明内容

为此,本发明提供一种用于远程遥控驾驶监测的增强现实抬头显示方法,以减少驾驶判断误差及安全隐患。

本发明的用于远程遥控驾驶监测的增强现实抬头显示方法,包括如下步骤:S1、在受控车辆的监测视频中标志出障碍物目标在视频中的位置;

S2、判断受控车辆的当前作业情况;

S3、根据受控车辆的当前作业情况,将作业路径以增强现实的方式叠加在视频中。

进一步的,步骤S1具体包括,

S101、获取目标包围盒信息;

S102、获取目标深度信息;

S103、将目标的包围盒信息和深度信息叠加至监测视频中。

进一步的,步骤S101包括,

S101a,抓取监测视频中的每一帧;

S101b,对每一帧图像中的障碍物目标进行检测,同时,创建轴对齐包围盒;

S101c,计算轴对齐包围盒的几何信息,并将轴对齐包围盒与障碍物目标对应。

进一步的,步骤S102包括,

S102a,通过与监测视频融合的点云数据,读取车端深度图像并进行降采样;

S102b,将降采样后的车端深度信息发送至遥控驾驶端;

S103c,对障碍物目标进行时间和位置的匹配,并将深度信息合并至轴对齐包围盒上。

进一步的,步骤S2中的当前作业情况包括处于作业路径内和远离作业路径内。

进一步的,当目标远离作业路径内时,步骤S3包括如下步骤,

S301a,计算当前车辆的位置与所有作业路径的端点之间的距离,并确定距离当前车辆最近的作业路径;

S301b,对距离最近的作业路径中的各路径点进行降采样;

S301c,选取距离最近的作业路径中的最近的点作为目标点,然后,计算当前车辆与目标点之间的角度差;

S301d,根据步骤S301c中计算的角度差,将指示图像叠加至视频中。

进一步的,当目标位于作业路径内时,步骤S3包括如下步骤,

S302a,选取当前车辆前方的多个路径点,依次计算各路径点与车辆正前方中心点的相对位置;

S302b,生成于顶视角方向的路径线条图像;

S302c,将路径线条图像叠加至视频中。

进一步的,步骤S301d和步骤S302c中的叠加至视频中这一过程均通过透视变换矩阵计算,然后将相应的指示图像或路径线条图像投影至视频中地面所在的平面上。

本发明的上述技术方案,相比现有技术具有以下优点:

(1)本发明所述的方法,在视频中以增强现实的方式提示交通参与者的碰撞信息,并给出碰撞距离,避免传统方法中因视频成像方式与人眼不同带来的判断误差。

(2)本发明所述的方法,将路径以增强现实的方式在视频中显示,并将其他重要信息以抬头显示的方式在视频中整合,远程驾驶员在整个驾驶过程中的视线焦点不需要离开视频区域,提高远程驾驶的安全性。

附图说明

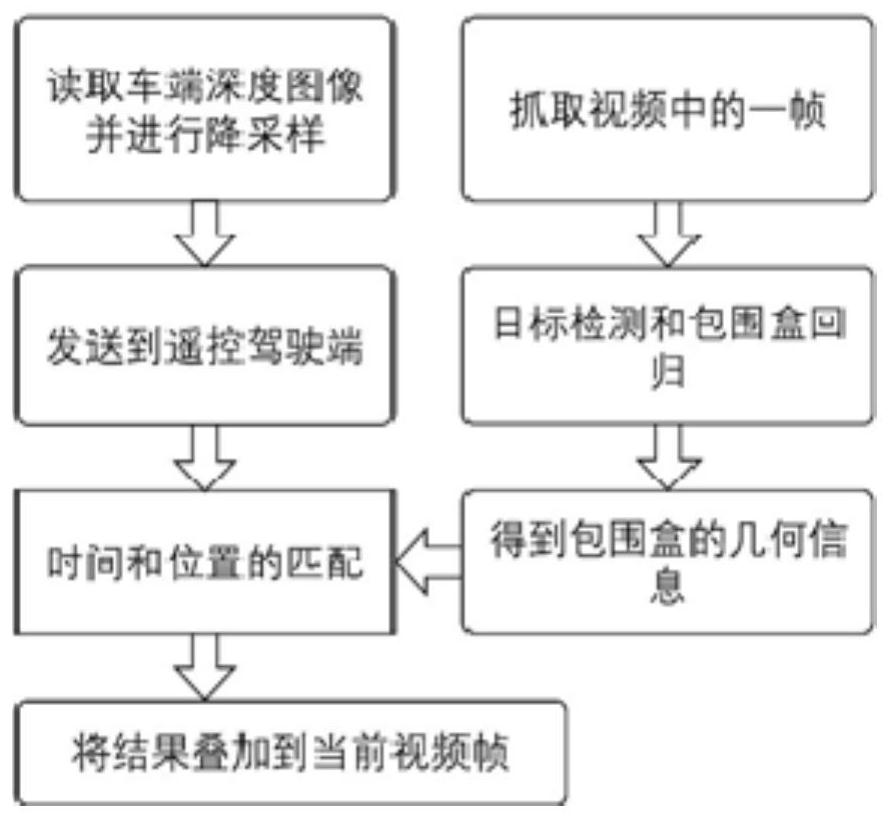

图1是本发明实施例提供的步骤S1的流程示意图;

图2是本发明实施例提供的步骤S3的流程示意图;

图3是本发明实施例提供的透视变换矩形的示意图。

具体实施方式

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

本实施例的用于远程遥控驾驶监测视频的增强现实抬头显示方法,如图1-2所示,包括如下步骤:

S1、在受控车辆的监测视频中标志出障碍物目标在视频中的位置;

S2、判断受控车辆的当前作业情况;

S3、根据受控车辆的当前作业情况,将作业路径以增强现实的方式叠加在视频中。

步骤S1具体包括,

S101、获取目标包围盒信息;

S102、获取目标深度信息。

本实施例中获取目标深度信息的具体过程为,通过相机与激光雷达的外部参数以及相机的内部参数,将点云数据与图像进行匹配,进而确定目标包围盒对应的点云信息,从而得到被检测目标的深度信息。之后,将每个匹配结果中的最小值即最近的距离作为检测目标的距离信息,并标注在目标包围盒外。

S103、将目标的包围盒信息和深度信息叠加至监测视频中。

步骤S101包括,

S101a,抓取监测视频中的每一帧;

S101b,对每一帧图像中的障碍物目标进行检测,同时,创建轴对齐包围盒;

S101c,计算轴对齐包围盒的几何信息,并将轴对齐包围盒与障碍物目标对应。

步骤S102包括,

S102a,通过与监测视频融合的点云数据,读取车端深度图像并进行降采样;

S102b,将降采样后的车端深度信息发送至遥控驾驶端;

S103c,对障碍物目标进行时间和位置的匹配,并将深度信息合并至轴对齐包围盒上。

通过步骤S1中的数个步骤,在车辆监测视频中显示障碍物的位置和大小以及障碍物的深度信息,对驾驶员提供驾驶参考。值得说明的是,如果车辆不具备深度相机,则不进行该步骤,也不标注深度信息。

步骤S2中的当前作业情况包括处于作业路径内和远离作业路径内。受控车辆在作业路径内时,远程驾驶员需要参考作业路径来驾驶车辆;当车辆远离作业路径时,远程驾驶员需要得到作业区域方向的提示,为了实现这一功能,本实施例中对于两种情况采用不同的处理方法。

当目标远离作业路径内时,步骤S3包括如下步骤,

S301a,计算当前车辆的位置与所有作业路径的端点之间的距离,并确定距离当前车辆最近的作业路径。

S301b,对距离最近的作业路径中的各路径点进行降采样。

S301c,选取距离最近的作业路径中的最近的点作为目标点,然后,计算当前车辆与目标点之间的角度差。

S301d,根据步骤S301c中计算的角度差,将指示图像叠加至视频中。具体地,根据该角度差对事先准备的圆盘图片进行旋转,这样就准备好了投影显示之前的图像数据。

当目标位于作业路径内时,步骤S3包括如下步骤。

S302a,选取当前车辆前方的多个路径点,依次计算各路径点与车辆正前方中心点的相对位置。

S302b,生成于顶视角方向的路径线条图像。

S302c,将路径线条图像叠加至视频中。

步骤S301d和步骤S302c中的叠加至视频中这一过程均通过透视变换矩阵计算,然后将相应的指示图像或路径线条图像投影至视频中地面所在的平面上。

透视变换矩阵计算的具体过程如下,通过OpenCV中的接口实现透视矩阵的计算,该接口需要提供投影变换中两个平面对应的4个点的位置作为输入参数,进而得到一个3乘3的单应性变换矩阵。该变换矩阵包含了平移、旋转、缩放、裁剪变换的内容,以及投影变换参数。在提供给该接口8个参考点位置后,该接口输出的透视变换矩阵,可以直接应用在OpenCV用于生成投影变换图像的接口进而得到变换后的结果。

为了得到用于生成透视变换矩阵的参考点,如图3所示。具体方式是在车辆两侧视频可见范围的边缘开始向正前方向延伸,每隔1米在地面做标记,从而得到位于车辆前方的长方形。取该长方形中任意延伸1米范围的矩形作为参考物,将其4个端点在视频中的位置进行标记,作为投影目标平面的参考点,而被投影面的参考点,首先取该矩形靠近车辆的边的两个端点,然后在图像平面上,根据车宽比例将该边向上平移对应的距离(如车宽为3米,则向上平移的距离为该边长的三分之一),其2个端点作为投影目标平面远端的对应点。这样我们就得到了所有需要的8个参考点,将所有参考点输入到OpenCV计算透视矩阵的接口中,即可得到透视矩阵。

在通过标定得出透视矩阵后,还可以根据实际的效果对透视矩阵进行微调。该方法的优点是操作简单,可以在短时间内完成,适应工程车辆摄像机随时可能因震动和碰撞改变位姿的情况。

通过步骤S3中的流程,利用增强现实的方式在车辆的监测视频中显示出作业路径,辅助驾驶员驾驶。

显然,上述实施例仅仅是为清楚地说明所作的举例,而并非对实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。而由此所引伸出的显而易见的变化或变动仍处于本发明创造的保护范围之中。

- 一种用于远程遥控驾驶监测视频的抬头显示技术

- 一种应用于无人驾驶的视频监测技术