一种非结构化环境的机器人灵活抓取检测方法

文献发布时间:2023-06-19 13:46:35

技术领域

本发明涉及机械臂灵活抓取的技术领域,尤其涉及一种非结构化环境的机器人灵活抓取检测方法。

背景技术

基于点云的抓取姿态估计算法(PointNet-grasp pose detection,PointNer-GPD),使用3D神经网络PointNet进行抓取姿态估计,这种方法依赖于物体的点云信息,相比之下,基于Faster RCNN(faster region based convolutional neural networks)网络的多物体抓取模型,就有较好的泛化能力和检测精度;Asif等从图像的不同层级来预测抓取区域,克服了只能从单个层级预测图像抓取区域的局限性,就准确度而言,该方法优于Cornell抓取数据集上的最新方法。陈丹等通过两日目标检测框与物体的最小包围矩形,计算出目标物体的抓取区域。金欢利用目标检测算法识别目标物体,将原始图像分割为多个仅包含单个物体的小块,再利用基于深度学习的抓取检测网络完成抓取任务。

现有的技术在实际应用中容易因为目标物体密集造成的抓取碰撞影响;并且没有考虑物体的最优抓取区域,对于不规则物体的抓取有一定的局限性;对物体的抓取准确率较低;无法高效准确的识别高分辨下的小物体。

发明内容

本部分的目的在于概述本发明的实施例的一些方面以及简要介绍一些较佳实施例。在本部分以及本申请的说明书摘要和发明名称中可能会做些简化或省略以避免使本部分、说明书摘要和发明名称的目的模糊,而这种简化或省略不能用于限制本发明的范围。

鉴于上述现有存在的问题,提出了本发明。

因此,本发明解决的技术问题是:一、容易因为目标物体密集造成的抓取碰撞影响,且没有考虑物体的最优抓取区域;二、对于不规则物体的抓取有一定的局限性;三、对物体的抓取准确率较低,无法高效准确的识别高分辨下的小物体。

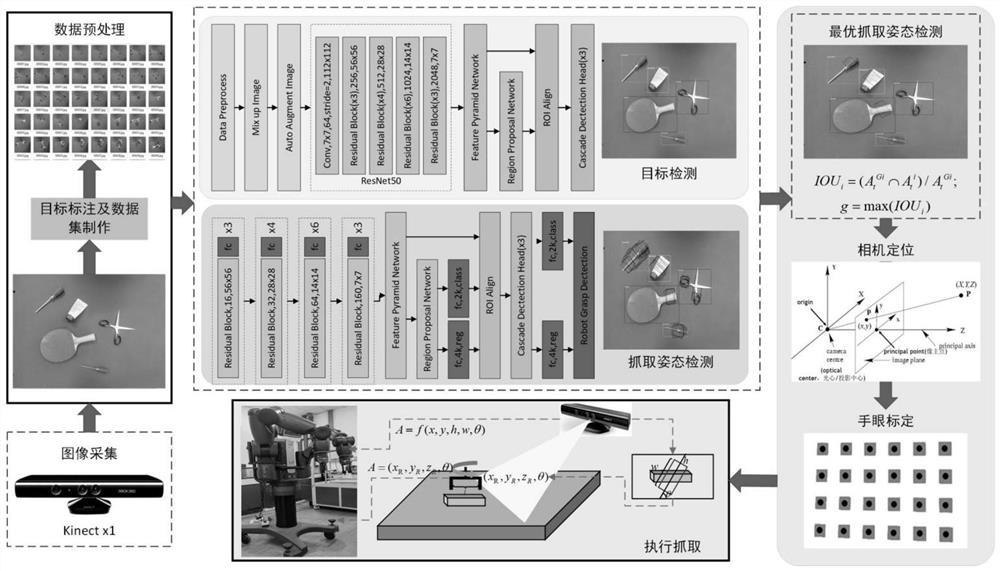

为解决上述技术问题,本发明提供如下技术方案:包括,利用Kinect x1相机采集抓取场景中的彩色图,并制作目标检测数据集,通过目标检测网络架构识别出场景中的各个目标;根据识别出的所述各个目标,结合多目标抓取姿态生成网络生成各目标的抓取位姿;以目标检测结果中的对象区域和抓取检测结果中的位姿信息为基准,筛选最优的抓取位姿,控制机械臂完成抓取任务。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:机器人抓取检测问题不仅需要预测出待抓取目标的回归边界,同时还需要筛选出机械臂最优的抓取姿态,为了对图像信息中抓取目标的最优抓取姿态进行预测,定义一种机械臂5D抓取姿态表示方法,包括,

A=f(x,y,h,w,θ)

其中,A表示输入图像中的最优抓取区域,(x,y)表示图像抓取矩形左上角点坐标;(h,w)表示抓取矩形的高度和宽度;θ表示抓取矩形框相对于图像水平方向的夹角,利用三维成像模型确定矩形对应的机器人最优抓取姿态。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:包括,数据增强、多尺度特征融合、区域特征聚集和连级检测头。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:所述数据增强包括,像素混合增光策略、基于自动机器学习的图像数据增光方法和图像信息删除策略。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:所述多尺度特征融合包括,将特征图集输入一个1X1的卷积层,以减少特征图的数量,生成低分辨率特征映射C

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:所述区域特征聚集包括,在区域内均匀的选取N个点,找到特征图上距离每个点最近的4个点;通过双线性插值的方式,得到点的输出值;对N个点取平均值得到区域的输出。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:所述联级检测头采用一种联级回归的网络框架,以实现IOU阈值的动态选取,包括,

其中,T表示总共使用的联级个数,f

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:抓取最优位姿区域预测包括,选用ResNet50作为特征提取的骨干网络,并在残差结构中添加SE模块;通过Squeeze和Excitation这两个关键操作以学习的方式自动获取到每个特征通道的重要程度;依照所述重要程度提升有用的特征并抑制对当前任务用处不大的特征。

作为本发明所述的非结构化环境的机器人灵活抓取检测方法的一种优选方案,其中:在非结构化抓取检测任务中,利用目标检测识别出待抓取目标,通过抓取检测生成目标物体的可行抓取区域,结合多目标IOU混合区域姿态评估算法筛选出目标物体可行抓取区域中的最优抓取姿态。

本发明的有益效果:本发明方法在非结构化环境下,以多目标物体识别边界信息为参考,对图像中生成的多个可行抓取区域进行筛选,得出最优抓取位姿,提高了目标物体最优抓取区域的检测精度,并避免了机械臂抓取时对其他目标的干扰,最终增强了机械臂在抓取任务中对非结构化场景下多目标物体抓取的鲁棒性和适应性。

附图说明

为了更清楚地说明本发明实施例的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其它的附图。其中:

图1为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的总体框架示意图;

图2为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的多尺度特征融合示意图;

图3为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的联级结构示意图;

图4为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的SENet示意图;

图5为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的多目标抓取姿态生成网络结构示意图;

图6为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的多目标IOU区域评估算法示意图;

图7为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的目标检测实验对比示意图;

图8为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的抓取姿态生成结果示意图;

图9为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的多目标IOU区域评估算法对比示意图;

图10为本发明一个实施例所述的非结构化环境的机器人灵活抓取检测方法的抓取实验平台示意图。

具体实施方式

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合说明书附图对本发明的具体实施方式做详细的说明,显然所描述的实施例是本发明的一部分实施例,而不是全部实施例。基于本发明中的实施例,本领域普通人员在没有做出创造性劳动前提下所获得的所有其他实施例,都应当属于本发明的保护的范围。

在下面的描述中阐述了很多具体细节以便于充分理解本发明,但是本发明还可以采用其他不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本发明内涵的情况下做类似推广,因此本发明不受下面公开的具体实施例的限制。

其次,此处所称的“一个实施例”或“实施例”是指可包含于本发明至少一个实现方式中的特定特征、结构或特性。在本说明书中不同地方出现的“在一个实施例中”并非均指同一个实施例,也不是单独的或选择性的与其他实施例互相排斥的实施例。

本发明结合示意图进行详细描述,在详述本发明实施例时,为便于说明,表示器件结构的剖面图会不依一般比例作局部放大,而且所述示意图只是示例,其在此不应限制本发明保护的范围。此外,在实际制作中应包含长度、宽度及深度的三维空间尺寸。

同时在本发明的描述中,需要说明的是,术语中的“上、下、内和外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,术语“第一、第二或第三”仅用于描述目的,而不能理解为指示或暗示相对重要性。

本发明中除非另有明确的规定和限定,术语“安装、相连、连接”应做广义理解,例如:可以是固定连接、可拆卸连接或一体式连接;同样可以是机械连接、电连接或直接连接,也可以通过中间媒介间接相连,也可以是两个元件内部的连通。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

实施例1

参照图1~图6,为本发明的第一个实施例,提供了一种非结构化环境的机器人灵活抓取检测方法,具体包括:

S1:利用Kinect x1相机采集抓取场景中的彩色图,制作目标检测数据集,通过目标检测网络架构识别出场景中的各个目标。

S2:根据识别出的各个目标,结合多目标抓取姿态生成网络生成各目标的抓取位姿。

S3:以目标检测结果中的对象区域和抓取检测结果中的位姿信息为基准,筛选最优的抓取位姿,控制机械臂完成抓取任务。

不难理解的是,与常规目标检测问题中需要预测的回归边界任务不同,机器人抓取检测问题不仅需要预测出待抓取目标的回归边界,同时还需要筛选出机械臂最优的抓取姿态,为了对图像信息中抓取目标的最优抓取姿态进行预测,本实施例定义了一种机械臂5D抓取姿态表示方法:

A=f(x,y,h,w,θ)

其中,A表示输入图像中的最优抓取区域,(x,y)表示图像抓取矩形左上角点坐标;(h,w)表示抓取矩形的高度和宽度;θ表示抓取矩形框相对于图像水平方向的夹角,利用三维成像模型确定矩形对应的机器人最优抓取姿态。

进一步的,本实施例还需要详细说明的是,利用改进的Faster RCNN目标检测网络模型技术实现,传统Faster RCNN网络使用由13个卷积层、13个激活层和4个池化层构成的VGG16网络架构作为其特征提取网络;由于经过多层池化后输入图像的像素变成原始图像的1/256,导致原始图中的小目标物体的特征信息在多次特征提取的过程中丢失,因此Faster RCNN对小目标物件的检测率较差;本实施例针对Faster RCNN的四个部分做出相应的改进,以提升网络对多尺度目标进行检测时的精准性。

(1)数据增强

数据集的好坏直接影响特征提取的质量、模型的检测精度和泛化能力,因此本实施例在特征提取网络前添加了一个数据预处理模块,通过MixupImage、AutoAugmentImage和GirdMask三种数据增强的手段,提高输入数据集的质量。

MixupImage是一种数据增强的像素混合增广策略,该策略基于经验风险和临近风险最小化原则,通过将传统图像标签的单热向量编码加权得到多热向量编码,具体操作是将任意两个样本及对应的语义标签通过权重参数λ进行加权相加,公式如下:

其中,I

AutoAugmentImage是一种基于自动机器学习的图像数据增广方法,其工作流程如下:首先预设图像增广策略集合

GirdMaskImage是一种图像信息删除策略,通过随机在图像上丢弃一块区域如图,相当于在网络上增加一个正则项,可以避免网络过拟合,GirdMask对应(r,d,α

(2)多尺度特征融合

参照图2,传统Faster RCNN网络仅使用特征提取网络的最后一层特征图作为RPN模块的输入,但是由于深层特征图的语义信息较为丰富,导致大量细节特征被忽略,检测小目标的能力较差,因此本实施例使用一种基于相同深度整合的平衡语义特征来识别多层次的语义特征,以提高模型检测小目标物件的能力。

具体的,该模块由规模调整、整合、细化和加强四个步骤组成,将特征提取网络结构中不同层级l的特征图为定义为F

将F

为了整合多层级特征并同时保留原有语义特征,通过双线性插值和最大池化的方法重新调整各层级特征图{C

通过嵌入式高斯函数对得到的平衡后的特征图进行非局部操作得到进一步细化和提炼后的特征图,具体操作公式如下:

将得到的平衡语义特征图使用相同但是相反的方法重新缩放获得新的特征图集{P

将特征图集{P

其中,参数224表示的是输入数据的尺寸大小;k

本实施例采用的多尺度融合特征图包含由底层至顶层不同程度的语义信息与细节特征,具有较强的泛化性,在保留深层语义的基础上,提取了较多的浅层特征,有助于对小目标的识别。

(3)ROI Align

传统Faster RCNN通过ROI Pooling来使RPN产生的候选框共享特征图特征,并保持输出大小一致在,但RoI Pooling在进行候选框的位置取整和提取特征时取整这两个步骤时会做近似处理,导致检测信息和提取的特征不匹配,并最终影响对小目标的检测,因此本实施例采用ROI Align方法来替换ROI Pooling。

RoiAlign采用一种区域特征聚集的方式,在区域内均匀的选取N个点,找到特征图上距离每个点最近的4个点,再通过双线性插值的方式,得到点的输出值,最后对N个点取平均值得到区域的输出,公式如下:

其中,d(.)表示两点之间的距离,Δh和Δw表示i与i*(r,j)横纵坐标的差值。

(4)联级检测头

本实施例针对单一回归架构无法有效的解决多尺度目标的ROI选取问题,采用一种联级回归的网络框架,以实现IoU阈值的动态选取,具体公式如下:

其中,T表示总共使用的联级个数,f

其中,B

将B

将得到的特征信息输入全连接层H

将微调后的候选框作为新的输入,输入下一个联级结构;

重复上述步骤,直到输出结果。

通过上述方法,候选框的质量得到逐步提升,能显著提高边界框的定位精准度。

优选地,本实施例还需要再一次说明的是,将抓取检测任务划分为抓取角度分类与抓取框的回归,通过使用卷积神经网络,利用大型卷积的泛化能力对输入图形进行全局的抓取预测。

参照图4,为了提高检测结果的准确性,基于区域提取的抓取检测网络结构设计了更加精准的抓取检测模型,首先选用ResNet50作为特征提取的骨干网络,并在残差结构中添加SE模块,通过Squeeze和Excitation这两个关键操作以学习的方式来自动获取到每个特征通道的重要程度,然后依照这个重要程度去提升有用的特征并抑制对当前任务用处不大的特征。

具体的,SE模块主要包括Squeeze和Excitation两个操作,可以适用于任何映射:假定卷积核为V=[v

其中,*表示卷积操作,

在特征提取网络后添加FPN层网络,用于混合多尺度特征图信息,RPN在生成的特征图上预测获选区域位姿(锚框),并将生成的特征向量(锚框参数)分别送入到两个全连接层中,即分类层与回归层,添加cascade联级结构用于得到每个锚框的评价得分与回归坐标。

锚框的评价得分和回归坐标由S表示

S=(α,β,x,y,w,h)

其中,(α,β)为用于判断锚框是否为抓取区域的两个分数;(x,y,w,h)为锚框回归坐标的4个物理值,x,y表示锚框的中心点坐标,w,h表示锚框的宽高,在对输出图像中可能产生的预测信息时,引入损失函数如下:

其中,L

通过公式定义的抓取区域预测损失函数,对输入的锚框信息进行抓取框角度的分类和坐标位置的回归。

其中,I表示角度的类别个数;ρ

L

参照图5,借鉴区域提取二阶目标检测算法的思想,首先判断RPN候选区域生成网络推荐的各个抓取矩形框是否包含可抓取物体;其次,通过预测抓取框所属于的角度类别确定最终的抓取角度并调整预测框的边界参数。

优选的是,在非结构化抓取检测任务中,多抓取目标之间存在互相干扰的情形,抓取目标区域是目标识别背景的子集,其是包含关系,因此只有以目标物体为背景计算出的抓取区域,通过分析各目标背景及抓取区域之间的区域关系,才能最终确定多目标场景下的最优抓取姿态。

综上,本实施例提出了一种多阶段网络架构的机器人最优抓取姿态检测算法,该算法首先通过目标检测识别出待抓取目标,再通过抓取检测生成目标物体的可行抓取区域,最后通过多目标IoU混合区域姿态评估算法筛选出目标物体可行抓取区域中的最优抓取姿态。

参照图6,使用改进的Faster RCNN对图像中的目标物件进行识别和定位,并生成定位矩形,通过抓取检测模型生成抓取矩形,获取图像中的抓取区域,以图像中识别出的各目标检测边界框为背景,计算生成抓取矩形与目标边界框的IOU,筛选出候选抓取区域,再计算候选抓取区域与其他目标边界框的IOU,最终得出目标物体的最优抓取姿态。

计算待抓取目标的所有抓取区域与抓取目标边界的IOU,当IOU>0.7或

实施例2

参照图7~图10,为本发明的第二个实施例,提供了一种非结构化环境的机器人灵活抓取检测方法的实验对比测试,具体包括:

(1)改进的Faster Rcnn目标检测实验

进行改进的Faster rcnn网络模型训练时,设置动量momentum=0.9,迭代次数为max_iter=10000,初始学习率base_lr=0.00125,学习率采用LinearWa mup的更新方式。

在训练开始时,调低学习率从非常小的数值线性增加到预设值之后,然后再线性减小。

本实施例所制作的数据集取材于实验室抓取情景,采集了乒乓球拍、订书机、眼镜、螺丝刀、剪刀和洗面奶共计6种物体做目标数据集,共计1000张图片。

在GTX2080ti上对模型进行训练,并将改进后的Faster rcnn与原网络进行对比,采集多张4096x3072像素大小的图片进行测试,部分实验结果对比如图7所示。

图7中的(a)、(b)、(c)、(d)为原Faster rcnn模型。图7中的(e)、(f)、(d)、(h)为改进后的Faster rcnn模型,经过分析可得,虽然改进后的Faster rcnn少量增加了模型的计算量,但是通过对特征提取网络进行扩充,使该模型能够更有效的捕获图像细节信息,从而使网络在处理高分辨率图像中识别小目标物体的结果更加精确。具体结果如表1所示。

表1:目标检测网络性能对比表。

由表1可得,本实施例改进后的Faster rcnn模型相比较原Faster rcnn模型,精度与交并比有显著提升。

(2)多目标抓取检测实验

本实施例在训练过程中所采用的数据集是专门为机器人抓取设计的康奈尔抓取数据集,该数据集共有240个不同样本的885图像,每个图像都有多个抓取矩形标签,标记为抓取区域预测的正负样本,训练前,将康奈尔数据集的图像随机划分,划分比例为5:1:1。

本实施例采用矩形抓取度量作为网络精度评估的方法,并与其他抓取检测模型作对比,矩形度量用抓取矩形作为抓取评价指标,如果同时满足以下两点,则认为该抓取矩形可用于抓取物体;1、预测框的抓取角度与真值标签的角度相差小于30°;2、预测的Jacard相似系数大于25%;Jaccard相似系数预测抓取区域与真值标签之间的相似性定义为:

其中,G

将本实施例改进的模型与其他抓取检测模型进行比较,从Cornell抓取数据集中与真实物理场景中挑选6种不同类型的物体对模型进行评测,在Cornell抓取数据集与真实物理场景的测试结果如表2所示:

表1:抓取检测网络对比实验表。

实验结果表明,本实施例所设计的抓取检测模型在保证模型运算时间的同时,能大幅度提高模型的抓取精度,满足机器人抓取的精准性。

参照图8,为本发明的多目标抓取检测算法输出结果,可以看出在多目标抓取检测场景下,模型预测出的抓取区域表现优异。

参照图9,本实施例所提的机器人最优抓起指套生成算法以目标物体的检测边界框为基准,以可抓取区域与各目标物体的混合IOU为判定,生成该目标物体的最优抓取姿态,将本实施例算法与目标检测抓取检测直接输出的记过作对比。

图9中的左侧是无多目标IOU混合区域评估算法的抓取检测与目标检测结果,抓取检测不能以抓取目标确认抓取位姿,且抓取检测会受到目标检测框的干扰。

图9中的右侧是基于多目标IOU混合区域评估算法的结果,通过对比可知,本发明提出的多目标IOU混合区域评估算法能有效实现多目标场景下的最优抓取姿态生成,并能有效避免了背景对抓取检测的干扰,适用于非结构化场景。

(3)机器人最优抓取实验

参照图10,配有双臂协作式机器人baxter和kinect x1深度相机,抓取对象包括6种常见的生活物品洗面奶、眼镜、订书机、剪刀、乒乓球拍和螺丝刀。

实验中,首先使用Kinect x1采集图像,将采集到的深度图像配准到彩色图像,逐像素获取深度值,其次,将融合后的图像利用本文提出的多目标IOU区域评估算法在图像中筛选出最优抓取矩形,最后计算出抓取矩形中心点对应的机器人坐标系下空间点的三维坐标值,即为机器人的最优抓取点,并以抓取矩形相对于图像中轴的夹角作为机器人末端执行器的旋转角,最终得到最优抓取姿态。

将物体按照不同的摆放方式分别配置并在抓取成功率与检测速度上进行对比如表3所示。

表2:最优抓取姿态检测与抓取实验结果。

参照表3,能够直观的看出本发明所提出的机器人最优抓取姿态检测算法抓具有较高的抓取成功率和准确率,可满足多目标抓取任务的实际需求,原因在于抓取检测算法融合了图像中多目标物体的目标检测结果和姿态生成结果,生成最优的抓取姿态,极大地避免了对其中一个物体进行抓取时对其他目标可能造成的影响,极大地降低了抓取失败的概率。

应说明的是,以上实施例仅用以说明本发明的技术方案而非限制,尽管参照较佳实施例对本发明进行了详细说明,本领域的普通技术人员应当理解,可以对本发明的技术方案进行修改或者等同替换,而不脱离本发明技术方案的精神和范围,其均应涵盖在本发明的权利要求范围当中。